Deepseek V3 становится самой мощной открытой языковой моделью в Китае на сегодня

Китайская компания Deepseek только что выпустила свою самую мощную языковую модель. Первые тесты показывают, что новая модель V3 может конкурировать с ведущими проприетарными моделями в отрасли и демонстрирует значительное улучшение в задачах логического мышления [1].

Модель, доступная на Github [2], использует архитектуру Mixture-of-Experts (MoE) с общим количеством параметров 671 миллиард, из которых 37 миллиардов активируются для каждого токена. Это значительное увеличение по сравнению с V2, которая имеет 236 миллиардов параметров, из которых 21 миллиард активен во время вывода.

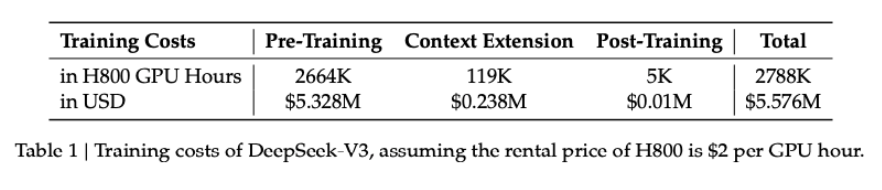

Обучение [3] также было более обширным, обработав 14.8 триллионов токенов — почти вдвое больше данных, чем в V2. По данным Deepseek, полное обучение заняло 2.788 миллиона часов на H800 GPU и стоило примерно $5.576 миллионов.

Особенно впечатляет то, что они достигли этого результата, используя кластер всего из 2,000 GPU — это лишь малая часть из 100,000 графических карт, которые компании, такие как xAI и OpenAI, обычно используют для обучения AI. Deepseek объясняет эту эффективность оптимизированным совместным проектированием алгоритмов, фреймворков и аппаратного обеспечения. Одним из самых больших улучшений V3 является его скорость — он может обрабатывать 60 токенов в секунду, что в три раза быстрее, чем его предшественник.

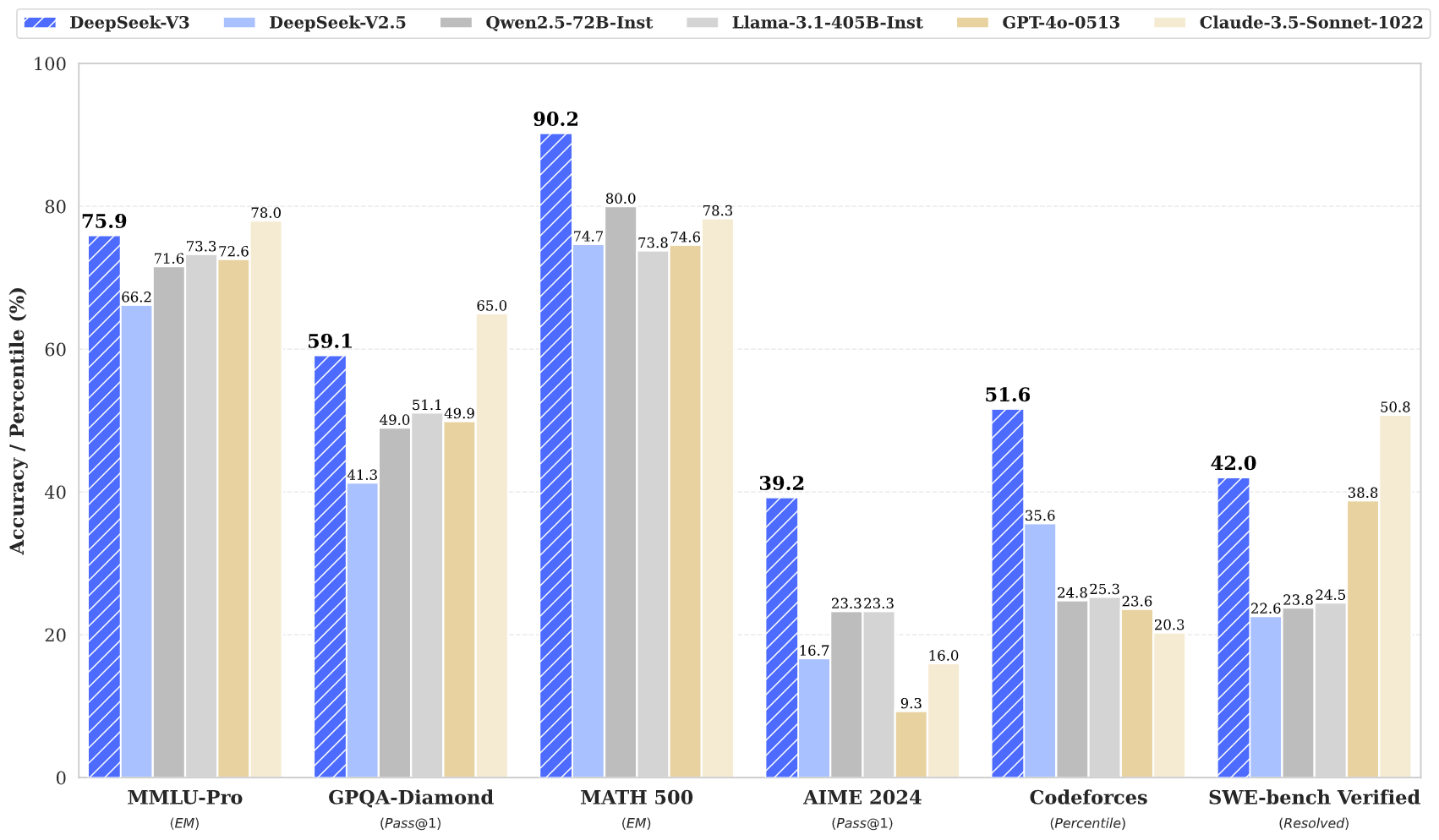

Команда сосредоточилась на улучшении мышления, используя специальный процесс пост-обучения, который использовал данные из их модели “Deepseek-R1 [4]“, специально разработанной для сложных задач логического мышления. При тестировании на фоне как открытых, так и проприетарных моделей он достиг наивысших результатов в трех из шести основных бенчмарков LLM, с особенно сильными показателями на бенчмарке MATH 500 (90.2%) и тестах программирования, таких как Codeforces и SWE.

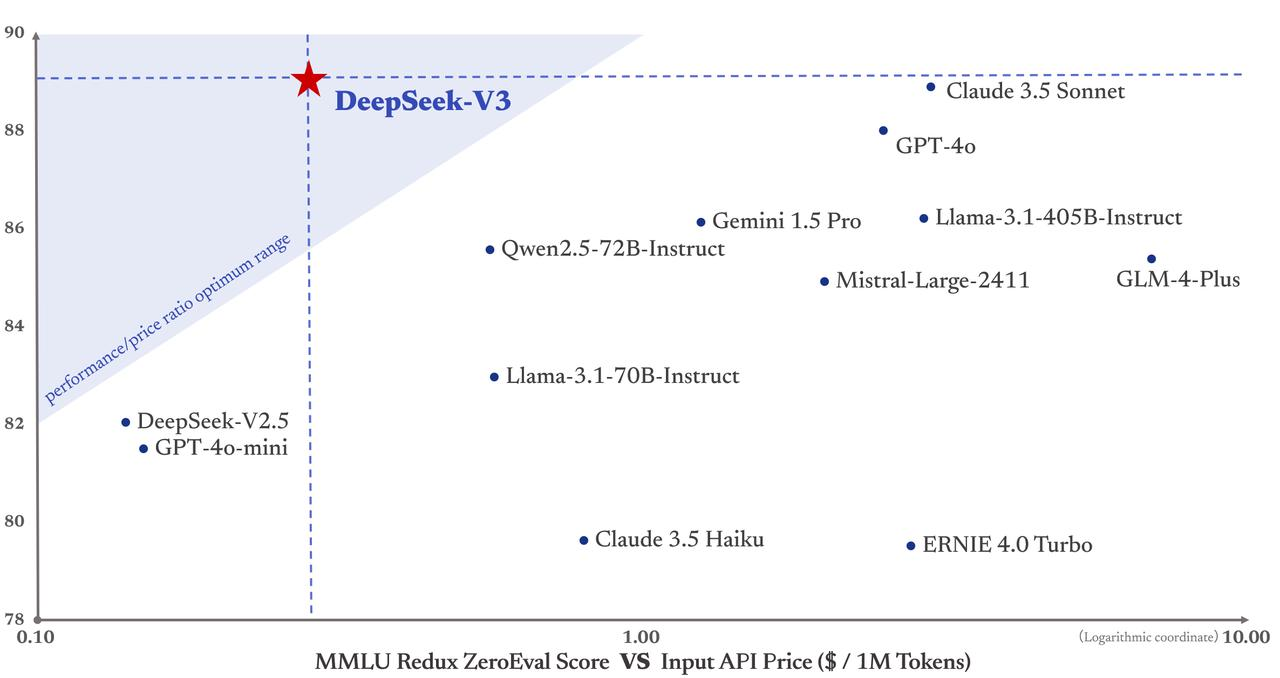

По данным Deepseek, V3 демонстрирует производительность, сопоставимую с ведущими проприетарными моделями, такими как GPT-4o и Claude-3.5-Sonnet [5], во многих тестах, при этом предлагая лучшее соотношение цены и производительности на рынке. Цены на API останутся на уровне V2 до 8 февраля. После этого пользователи будут платить $0.27 за миллион токенов для входных данных ($0.07 за кэшированные хиты) и $1.10 за миллион токенов для выходных данных.

Модель выпущена под лицензионным соглашением Deepseek (Версия 1.0) [6], которое предоставляет пользователям бесплатную, всемирную, неисключительную и безотзывную лицензию на авторские права и патенты. Пользователи могут воспроизводить, модифицировать и распространять модель, в том числе в коммерческих целях, хотя военные приложения и полностью автоматизированные юридические услуги запрещены.

Основанная всего в прошлом году, компания Deepseek планирует улучшить архитектуру своей модели. Компания хочет преодолеть архитектурные ограничения Transformer, тем самым расширяя границы своих возможностей моделирования, и поддерживать неограниченные длины контекста. Как и OpenAI, компания заявляет, что принимает поэтапный подход к созданию искусственного общего интеллекта [7] (AGI). В настоящее время в ее ассортименте имеются специализированные модели для математики [8] и программирования, доступные как через API, так и для бесплатного локального использования.

Источник [9]

Автор: dilnaz_04

Источник [10]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/10680

URLs in this post:

[1] мышления: http://www.braintools.ru/thinking

[2] Модель, доступная на Github: https://github.com/deepseek-ai/DeepSeek-V3

[3] Обучение: http://www.braintools.ru/article/5125

[4] Deepseek-R1: https://the-decoder.com/first-open-source-alternative-to-openais-o1-comes-from-china/

[5] Claude-3.5-Sonnet: https://the-decoder.com/anthropic-releases-updated-smarter-claude-haiku-3-5-and-sonnet-3-5-model/

[6] лицензионным соглашением Deepseek (Версия 1.0): https://github.com/deepseek-ai/DeepSeek-V3/blob/main/LICENSE-MODEL

[7] интеллекта: http://www.braintools.ru/article/7605

[8] математики: http://www.braintools.ru/article/7620

[9] Источник: https://the-decoder.com/deepseek-v3-emerges-as-chinas-most-powerful-open-source-language-model-to-date/

[10] Источник: https://habr.com/ru/companies/bothub/news/870508/?utm_source=habrahabr&utm_medium=rss&utm_campaign=870508

Нажмите здесь для печати.