Думающие модели o1-3: краткий обзор и чего программистам ждать дальше

Когда LLM впервые появились, они были немного похожи на детей – говорили первое, что приходило им в голову, и не особо заботились о логике [1]. Им нужно было напоминать: «Подумай, прежде чем отвечать». Но, как и с детьми, даже тогда это не означало, что они действительно будут думать.

Многие утверждали, что из-за этого у моделей нет настоящего интеллекта [2] и что их необходимо дополнять либо человеческой помощью, либо каким-то внешним каркасом поверх самой LLM, например Chain of Thought.

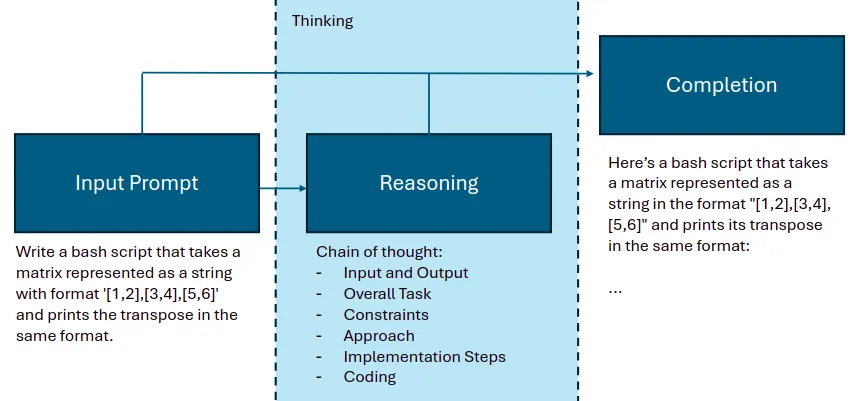

Было лишь вопросом времени, когда крупные разработчики LLM, такие как OpenAI, решат воспроизвести этот внешний этап мышления [3] (см. рисунок ниже) внутри самой модели. Ведь всё довольно просто: создать датасет, содержащий не только пары «вопрос–ответ», но и пошаговую логику размышлений, и обучить на нём. Кроме того, при выполнении инференса потребуются более серьёзные вычислительные ресурсы, поскольку модель будет проходить тот же пошаговый процесс мышления, определяя ответ.

Добавленный этап размышлений

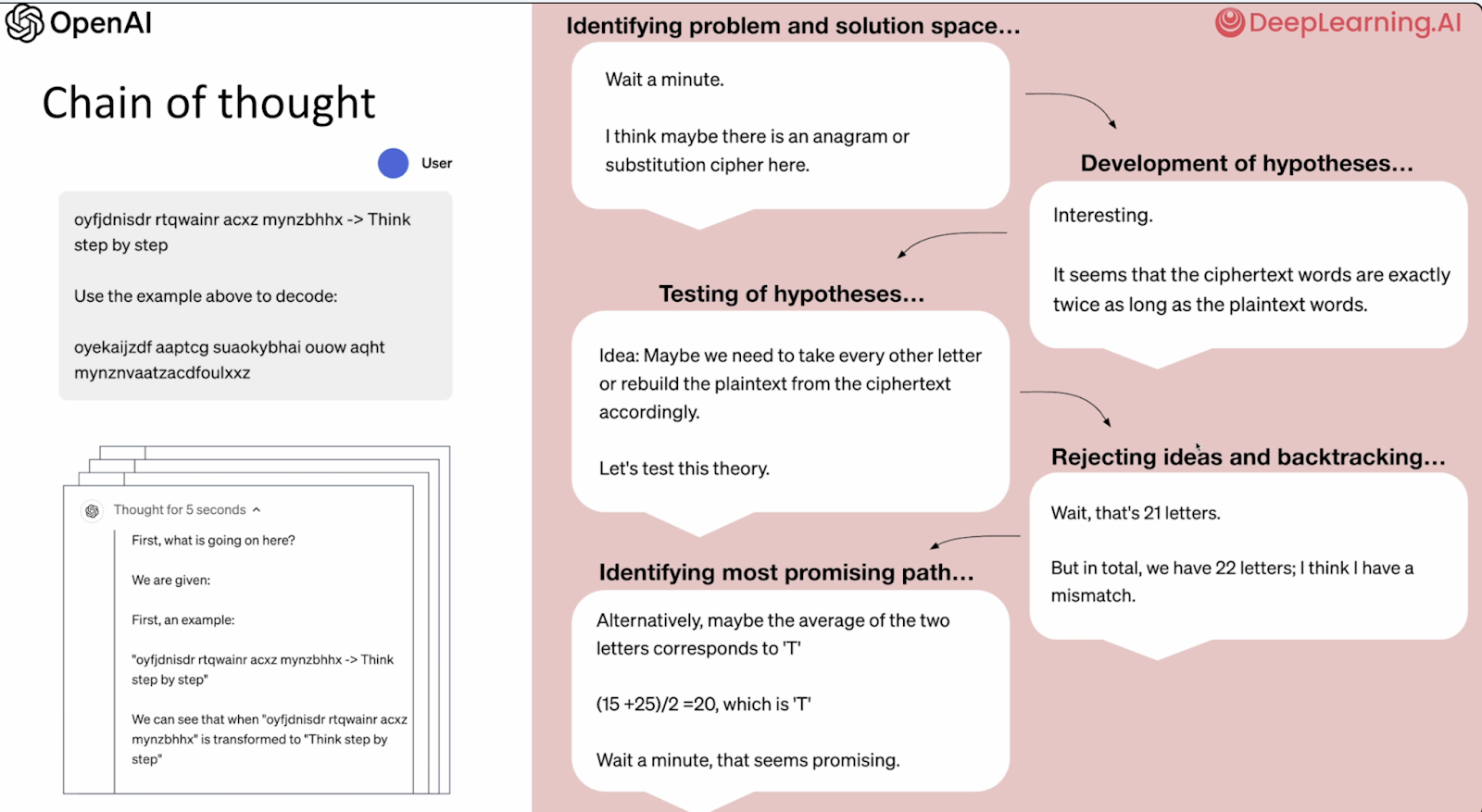

Reasoning LLMs естественным образом разбивают проблемы на мелкие части и используют подход «цепочки рассуждений», исправление ошибок и пробуют несколько стратегий перед ответом.

O1 тратит больше времени на ответ (в 30 раз медленнее, чем Gpt4o), и большее время на размышления приводит к лучшим результатам! (кто бы мог подумать)

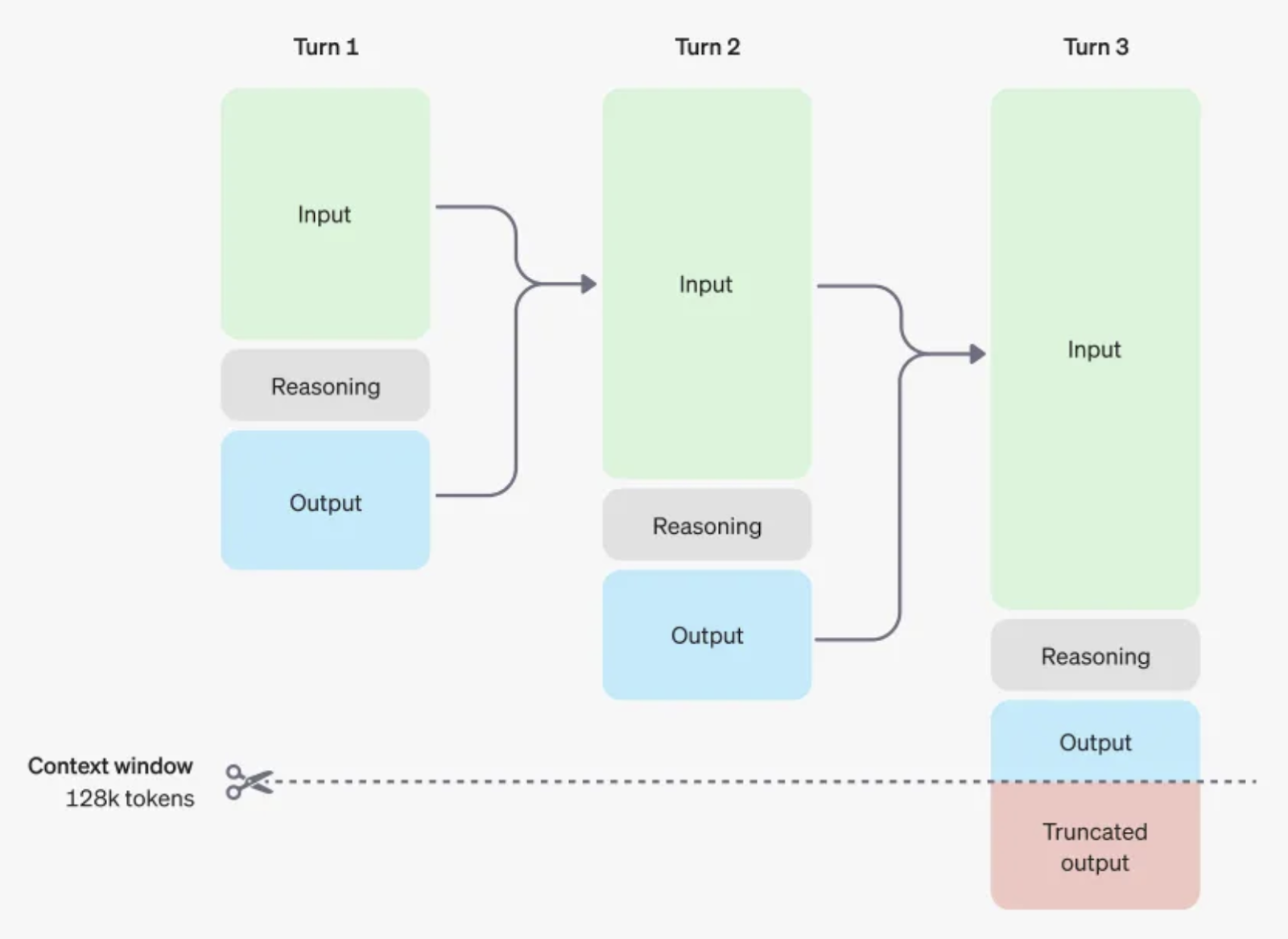

Токены рассуждений не передаются с одного шага к следующему. Передается только результат.

Кроме того, решение проверяется путем генерации нескольких вариантов ответов и выбора лучшего через консенсус — подход, который мы раньше реализовывали вручную. Вот общий процесс:

Одним из важных выводов является то, что требования к вычислительным ресурсам (GPU) будут расти, поскольку очевидно, что более длительное «размышление» (больше токенов на размышление) приводит к лучшим ответам. Значит, можно повышать качество модели просто выделяя ей больше вычислительной мощности — тогда как раньше это в основном касалось только фазы обучения [4]. Таким образом, требования к GPU для современных моделей будут существенно возрастать.

Эти модели принципиально отличаются от старых, и прежние подходы уже не работают.

Как работать с моделями, использующими рассуждения

Интересно, что это во многом похоже на работу с умным человеком:

-

Будьте проще и говорите прямо. Чётко сформулируйте свой вопрос.

-

Не давайте Chain of Thought в явном виде. Модель выполнит его внутренне.

-

Соблюдайте структуру: разбивайте запрос на логичные секции, используйте чёткую разметку.

-

Показывайте вместо объяснений: лучше привести пример хорошего ответа или поведения [5], чем описывать его на тысячи слов.

-

Не нужно больше уговаривать, запугивать или пытаться подкупать модель бессмысленными приёмами.

Можно свести это к одному пункту: знайте, что хотите спросить, и ясно это формулируйте

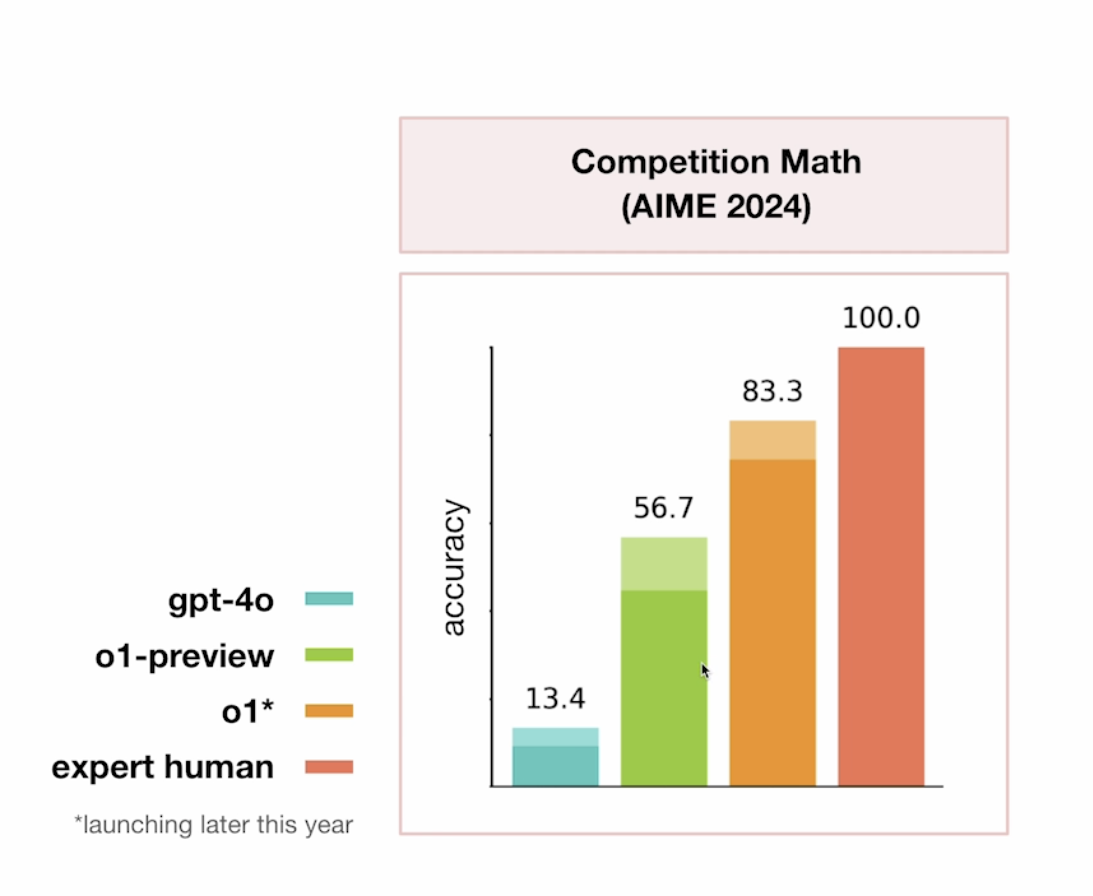

Мини-модели и полноценные модели

Поскольку модели рассуждения (например, o3) потребляют много токенов во время инференса, их использование для всего подряд оказывается слишком затратным, да и время отклика получается большим. Поэтому возникла идея делегировать самую сложную задачу — высокоуровневое мышление и планирование — «большой» модели, а для выполнения плана использовать более быстрые и дешёвые мини-модели. Их можно применять для решения таких задач, как программирование, математика [6] и наука [7].

Это «агентный» подход, который сочетает лучшее из обоих миров: «умные, но дорогие» модели плюс «маленькие и быстрые» исполнители.

Насколько эти модели лучше?

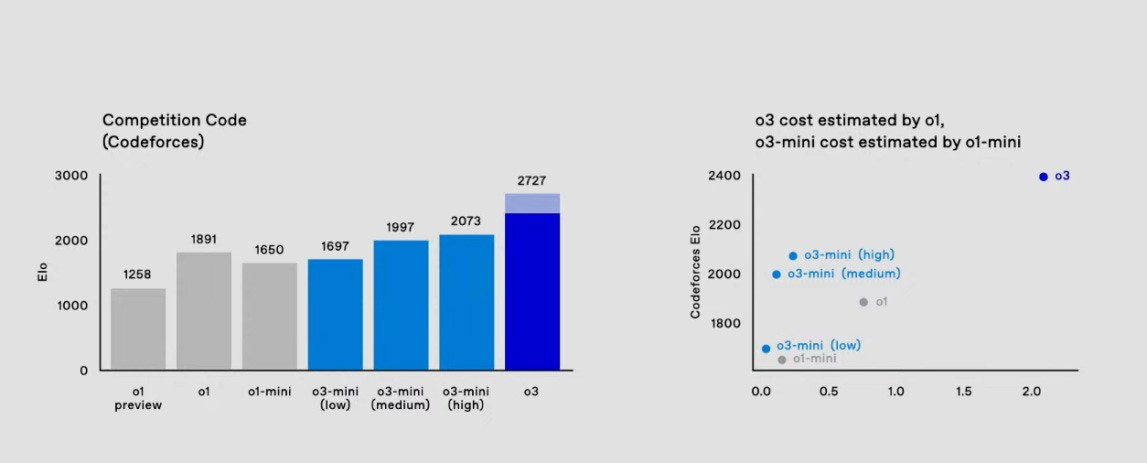

Они значительно лучше, и в ближайшее время станут ещё лучше. Например, o1-3 уже приближаются к уровню эксперта в математике и программировании (см. ниже).

Математика

Код

ELO 2727 ставит o3 в число 200 лучших программистов в мире. Если вы ещё не беспокоитесь о своей работе как разработчика, то пора начать это делать. Именно эта сфера масштабируется отлично за счёт увеличения вычислительной мощности, и текущие темпы прогресса не демонстрируют никаких признаков замедления.

Что дальше

Я могу лишь строить догадки, но, на мой взгляд, в ближайший год-два можно будет значительно повысить качество моделей, просто добавляя больше вычислительных ресурсов на этапе инференса и улучшая обучающие датасеты. Добавление какого-то вида «памяти» за пределами контекстного окна тоже выглядит логичным шагом, хоть и чрезвычайно дорогим при реализации в больших масштабах.

Я считаю, что следующим крупным шагом станет реализация многоагентной архитектуры на уровне LLM, чтобы модель могла вести несколько внутренних «сотрудничающих» диалогов, разделяющих единую память [8] и контекст. Это соответствует нынешнему тренду по внедрению внешних инструментов для «размышлений» непосредственно в модель и также даёт выгоду за счёт линейного масштабирования вычислительных ресурсов на этапах обучения и инференса. Думаю, что к концу этого года или в следующем году мы уже увидим LMM (Large Multiagent Model) или что-то похожее. Главное чтобы у них не началась шизофренияю

Автор: Squirrelfm

Источник [9]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/11208

URLs in this post:

[1] логике: http://www.braintools.ru/article/7640

[2] интеллекта: http://www.braintools.ru/article/7605

[3] мышления: http://www.braintools.ru/thinking

[4] обучения: http://www.braintools.ru/article/5125

[5] поведения: http://www.braintools.ru/article/9372

[6] математика: http://www.braintools.ru/article/7620

[7] наука: http://www.braintools.ru/article/7634

[8] память: http://www.braintools.ru/article/4140

[9] Источник: https://habr.com/ru/companies/raft/articles/873372/?utm_source=habrahabr&utm_medium=rss&utm_campaign=873372

Нажмите здесь для печати.