Moonshot AI представляет Kimi k1.5, следующего китайского конкурента o1

После выпуска DeepSeek-R1 в Китае появилась ещё одна модель логического мышления [1]. Новая мультимодальная модель Kimi k1.5 от Moonshot AI показывает впечатляющие результаты в сравнении с признанными моделями AI в сложных задачах логического мышления.

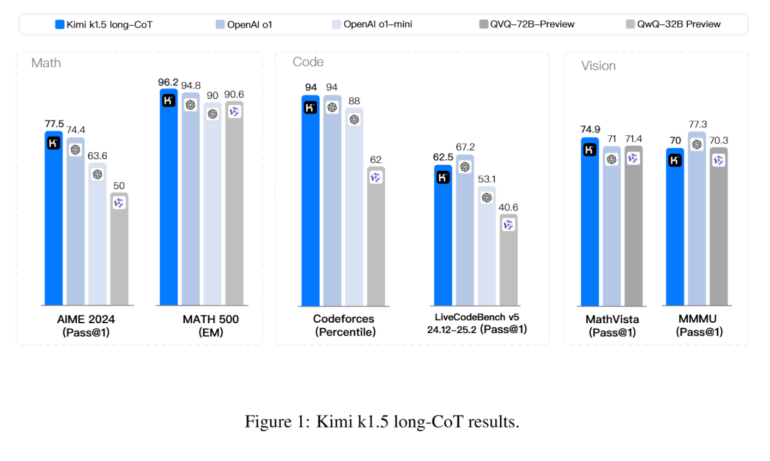

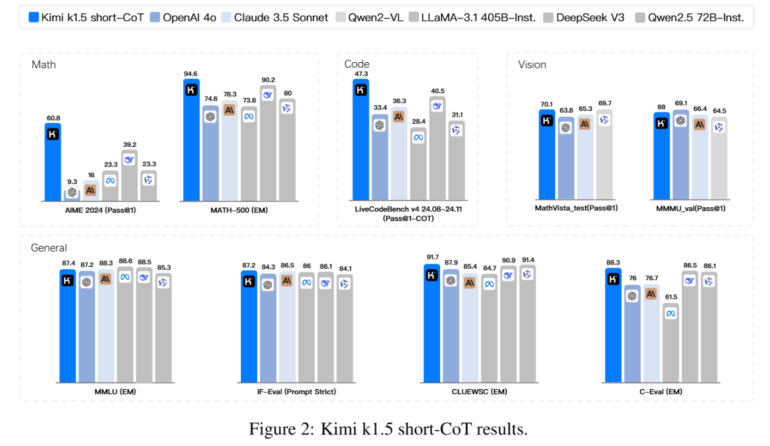

Компания Moonshot AI разработала две версии Kimi k1.5 – одну для подробных рассуждений (long-CoT [2]), а другую для кратких ответов (short-CoT). Согласно техническому отчёту компании, обе версии соответствуют или превосходят по производительности ведущие модели, такие как o1 и DeepSeek-R1 от OpenAI. Версия long-CoT шаг за шагом описывает ход своих мыслей, а версия short-CoT стремится к краткости. В нескольких тестах он показал такие же или более высокие результаты, чем GPT-4o и Claude 3.5 Sonnet.

В отличие от DeepSeek-R1 [3], Kimi k1.5 может обрабатывать как текст, так и изображения, что позволяет ему делать выводы на основе различных типов входных данных. Модель особенно хорошо справляется с мультимодальными тестами, такими как MathVista и MMMU. Однако, как и в случае со всеми AI-моделями, реальная производительность может отличаться от результатов тестов.

Однако, как и всегда, ещё предстоит выяснить, насколько эта модель полезна на практике за пределами контрольных показателей.

Разработка началась с предварительного обучения [4] модели на обширных текстовых и графических данных для создания базового понимания языка и изображений. Затем команда произвела тонкую настройку, используя тщательно отобранные небольшие наборы данных. Для задач с ясными ответами, как в математике [5], они применяли метод «отсеивающей выборки», оставляя только правильные ответы. Также были созданы обучающие материалы с подробными пошаговыми объяснениями.

На заключительном этапе использовалось обучение с подкреплением [6] с фокусом на конечный результат, что дало модели больше свободы в поиске решений. Чтобы сделать ответы эффективными, вводился штраф за излишнюю длину.

Этот метод отличается от моделей R-1 и R-1-Zero компании DeepSeek. R-1 использует базовое обучение с подкреплением и обратной связью, а R-1-Zero – минималистичный подход без дополнительных данных.

Для повышения эффективности рассуждений команда нашла способы передавать знания моделям, генерирующим более короткие ответы, комбинируя модели и используя метод «кратчайшей выборки с отклонением». Они также выяснили, что увеличение длины контекста до 128 тысяч токенов улучшает производительность без необходимости сложных компонентов, таких как поиск по дереву Монте-Карло.

Moonshot AI, основанная в 2023 году, быстро выросла, получив более 1 миллиарда долларов инвестиций от Alibaba к февралю 2024 года и оценку в 2,5 миллиарда долларов. К августу оценка достигла 3,3 миллиарда долларов благодаря инвестициям от Tencent и Gaorong Capital. Хотя Kimi k1.5 планируется как конкурент ChatGPT, компания пока не сделала модель доступной для широкой публики.

Источник [7]

Автор: mefdayy

Источник [8]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/11419

URLs in this post:

[1] мышления: http://www.braintools.ru/thinking

[2] CoT: https://the-decoder.com/deeper-insights-for-ai-language-models-chain-of-thought-prompting-as-a-key-factor/

[3] DeepSeek-R1: https://the-decoder.com/deepseeks-latest-r1-zero-model-matches-openais-o1-in-reasoning-benchmarks/

[4] обучения: http://www.braintools.ru/article/5125

[5] математике: http://www.braintools.ru/article/7620

[6] подкреплением: http://www.braintools.ru/article/5528

[7] Источник: https://the-decoder.com/moonshot-ai-unveils-kimi-k1-5-chinas-next-o1-competitor/

[8] Источник: https://habr.com/ru/companies/bothub/news/875556/?utm_source=habrahabr&utm_medium=rss&utm_campaign=875556

Нажмите здесь для печати.