Почему DeepSeek Janus-7B — это нечто действительно невероятное

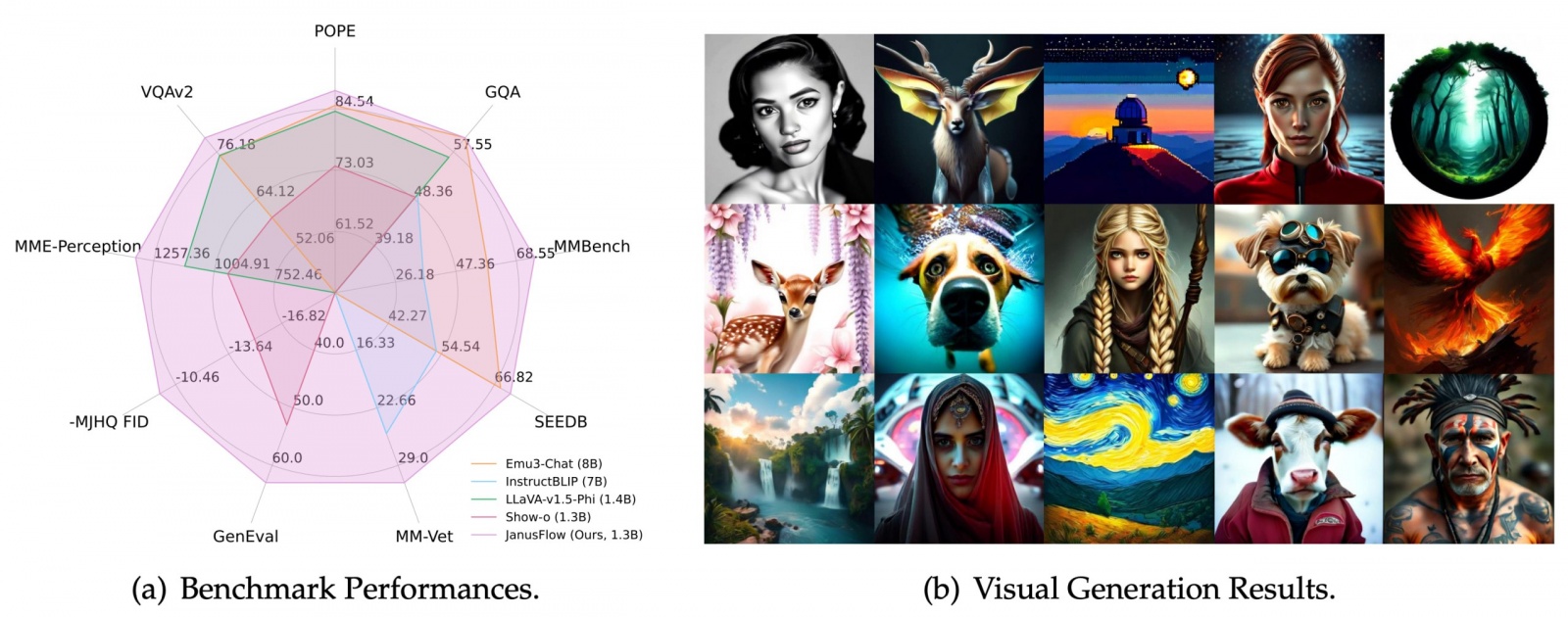

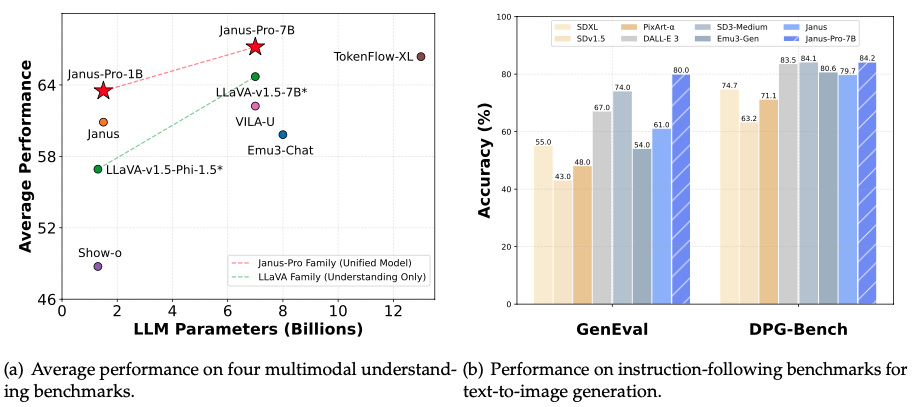

Полчаса назад вышла новость [1] о выходе DeepSeek Janus-7B – новой мультимодальной модели от DeepSeek, которая, по заявлениям авторов, рвёт DALL-E 3, Stable Diffusion XL и Stable Diffusion 3 (Medium) в бенчмарках [2].

В этой статье я не буду дублировать новость, а хочу подробнее рассмотреть, что именно в этой модели такого уникального, из-за чего многие связанные с AI медиа сегодня захлебываются от восторга.

Кратко про модель

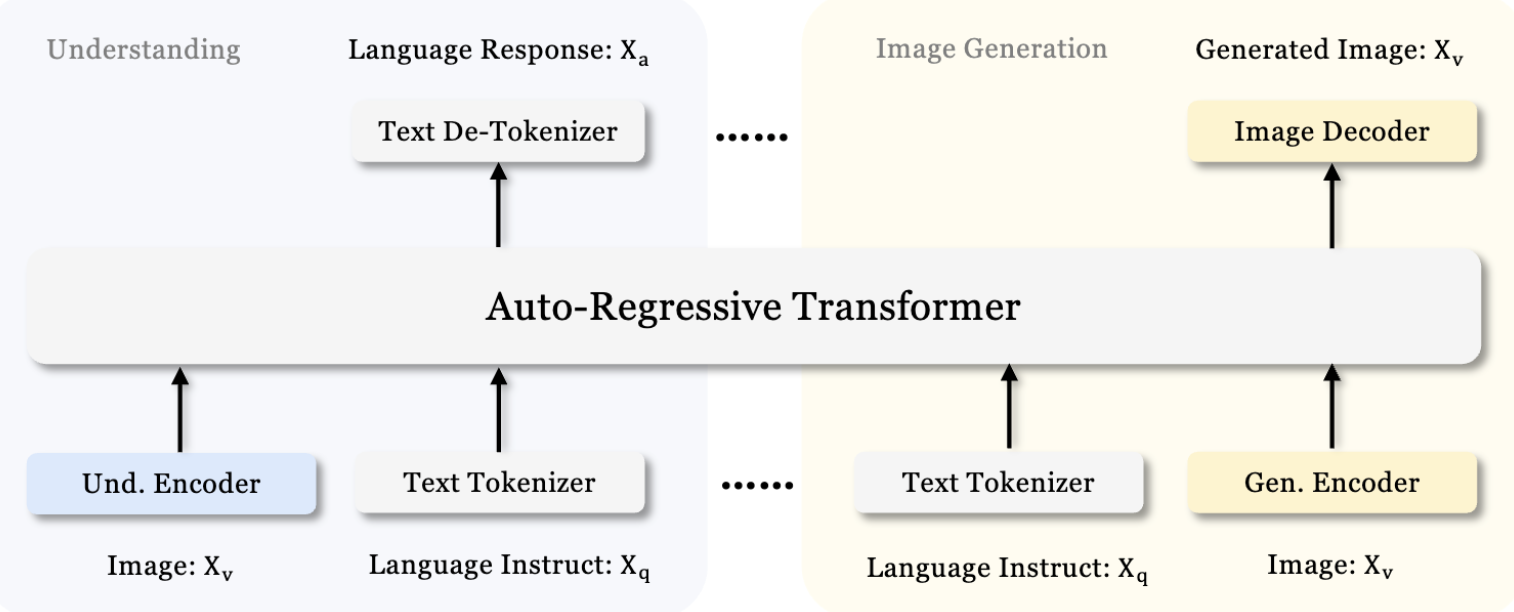

Модель мультимодальна, any-to-any, то есть умеет принимать на вход как изображения, так и текст, и на выходе генерировать также и текстовые данные, и картинки.

В целом, Janus-Pro – это новый подход к архитектуре трансформеров. Исследовали стараются сохранить единую архитектуру трансформера для обработки информации, но при этом сама визуальная генерация и распознавание изображений разделены и построены на базе других подходов, о чём в следующем разделе.

Такое разделение позволяет устранить конфликты между энкодерами для генерации и распознавания, и при этом сохраняет высокий уровень гибкости в настройке каждой из частей.

Главная инновация – LlamaGen

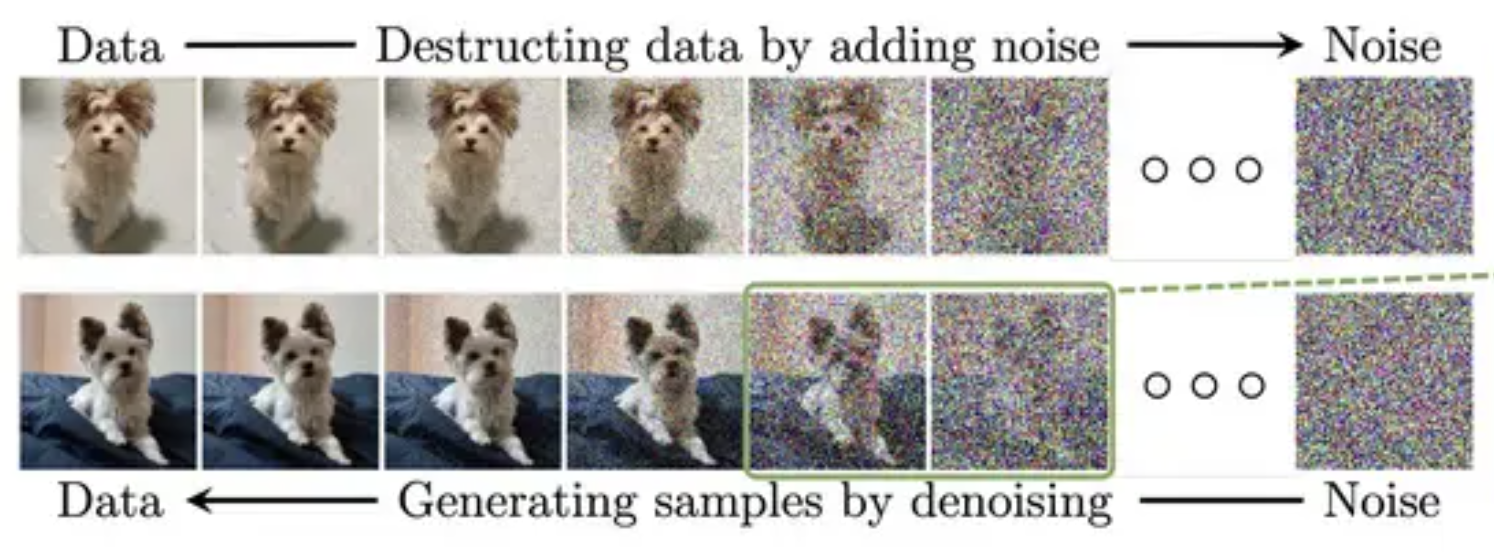

В генерации изображений последние несколько лет доминировали диффузионные модели (отсюда, к примеру, и название Stable Diffusion). На этой архитектуре построены такие известные имена как Glide, Dalle-2/3, Imagen и Stable Diffusion. Диффузионные модели, если очень упрощенно, устроены следующим образом.

Мы берём картинку, и планомерно превращаем её в шум, поэтапно. После чего записываем результат в обратном порядке – превращаем шум в картинку. После чего, каждый из этапов превращения шума в картинку поступает на обучение [4] (вместе с закодированным промптом) в нейросеть, чтобы она “поняла” принципы, как превращать шум в финальное изображение. В последствие, именно этим и занимаются диффузеры – используя текстовый промп в качестве параметра поэтапно превращают рандомный шум в финальное изображение (те, кто руками игрался со Stable Diffusion в Automatic1111 хорошо представляют этот процесс и как этим количеством этапов можно управлять).

Не будем долго тянуть, и перейдём к самому интересному.

В Janus-7B используется новая архитектура для генерации изображение – LlamaGen от ByteDance [5]. Её инновация в том, что она применяет те же принципы, что и в LLM, а именно: предсказание следующего токена, на основе предыдущих, но в контексте изображений, токенами кодируются именно визуальные, а не текстовые данные.

Эта архитектура очень свежая – релиз состоялся всего 7 месяцев назад, а Janus-7B, это её первое серьёзное применение на практике.

Отвечая на вопрос из названия статьи: в чем же здесь революция?

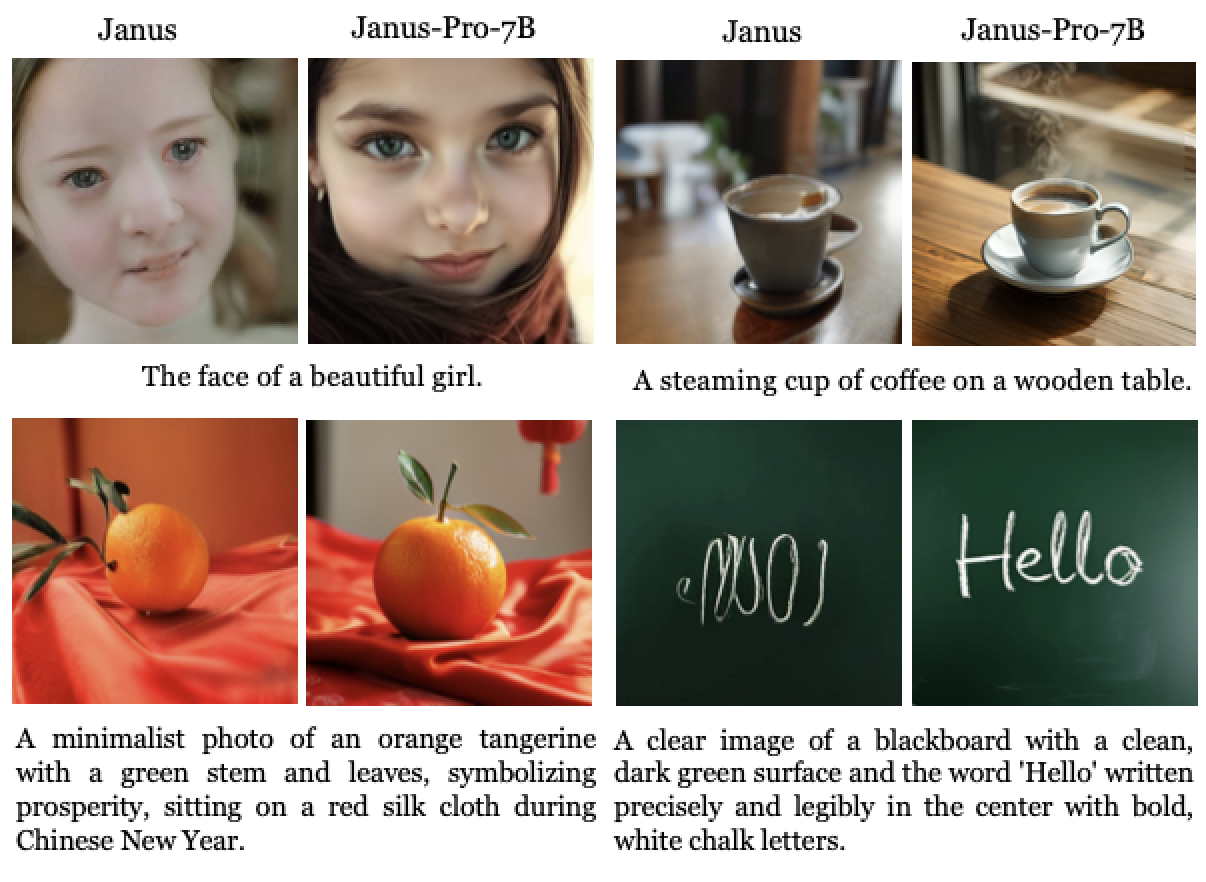

Ответ прост: главная особенность таких архитектур заключается в том, что они очень хорошо увеличивают качество генерации в зависимости от роста параметров в модели. Это именно то, как в своё время достиг революционного качества GPT-3, GPT-4, и подобные: просто увеличивая количество параметров, даже без изменения архитектуры.

И если в случае текстовых моделей мы приближаемся к пределу по количеству параметров, которые мы можем обучать и выполнять в современных дата-центрах, то для LlamaGen – мы находимся в самом начале этого пути, то качество генерации (а я напомню – выше, чем у DALL-E 3 и Stable Diffusion XL), которое выдаёт LlamaGen в Janus-7B – это только начало.

Дадим слово самим ребятам из DeepSeek, которые в Janus как раз перешли от тестовой модели с 1.5 миллиардами параметров до 7 миллиардов:

В предыдущей версии Janus (1.5B) мы просто проверяли эффективность нашей новой архитектуры – отделения визуальных энкодеров, с сохранением общего трансформера, это была LLM на 1.5 миллиарда параметров.

В данной работе мы увеличили модель до 7 миллиардов параметров. Мы увидели, что используя LLM большего размера скорость сходимости потерь как для мультимодального понимания (способность модели “понимать” данные разного типа), так и для генерации изображений заметно улучшилась, по сравнению с меньшей моделью. Это подтверждает, что новая архитектура обладает серьёзным потенциалом для масштабирования в дальнейшем.

Самая большая доступная сейчас LlamaGen использует всего 3 миллиарда параметров. Для сравнения, старушка GPT-3.5 использует 175 миллиардов (в 58 раз больше!), а GPT-4 по примерным данным (OpenAI перестали выкладывать модели в open-source начиная с этой версии) использует 1.7 триллионов (в 566 раз больше!) параметров на сходной архитектуре.

Вы представляете, какие изображения LlamaGen сможет генерировать, если количество её параметров увеличится в 566 раз?

Немного про распознавание изображений

В этом плане всё довольно консервативно, используется энкодер SigLIP [6], на базе архитектуры CLIP [7] (которой уже, с ума сойти, почти 4 года). Изображения сжимаются до 384х384 пикселей, после чего идут на вход энкодера, и дальше поступают в общий пайплаин-обработчик модели-трансформера.

Жалко, что здесь без особых инноваций, но с другой стороны – это на текущий момент самая передавая архитектура для распознавания изображений, так что можно просто порадоваться, что инновация с одной стороны не стала причиной “потерь” с другой.

Послесловие

Забавно, что модель, которая сама по себе не является предназначенной исключительно для генерации изображений все равно воспринимается всеми именно так.

И это неудивительно – мы уже видели много потрясающих текстовых моделей, reasoning-моделей, распознавания изображений, но применение архитектуры LlamaGen на практике, да ещё и в рамках одной мультимодальной модели, да ещё и с таким количеством параметров, ранее не бывало.

Кажется, 2025 год будет богат на события в AI, и, кажется, многие из них будут переводиться на английский (и русский) с китайского, а не наоборот.

P.S. 2025 год на дворе, неужели вы думали я не бахну ссылку на свой Телеграм канал [8] в конце статьи? Я там регулярно пишу по ИИ/агентов, даю более глубокую аналитику по новостям, и рассказываю как сделать компанию, в которой все сотрудники — AI-агенты. Велком!

Автор: ElKornacio

Источник [9]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/11592

URLs in this post:

[1] вышла новость: https://habr.com/ru/news/877094/

[2] в бенчмарках: https://huggingface.co/deepseek-ai/Janus-Pro-7B/resolve/main/janus_pro_teaser1.png

[3] Ссылка на HuggingFace: https://huggingface.co/deepseek-ai/Janus-Pro-7B

[4] обучение: http://www.braintools.ru/article/5125

[5] LlamaGen от ByteDance: https://github.com/FoundationVision/LlamaGen

[6] используется энкодер SigLIP: https://huggingface.co/timm/ViT-L-16-SigLIP-384

[7] архитектуры CLIP: https://openai.com/index/clip/

[8] ссылку на свой Телеграм канал: https://t.me/elkornacio

[9] Источник: https://habr.com/ru/articles/877110/?utm_source=habrahabr&utm_medium=rss&utm_campaign=877110

Нажмите здесь для печати.