Alibaba выпустила модель Qwen с открытым исходным кодом, которая обрабатывает 1 миллион входных токенов

Команда Qwen от Alibaba только что добавила в семейство Qwen2.5 два новых элемента: Qwen2.5-7B-Instruct-1M и Qwen2.5-14B-Instruct-1M. Эти модели с открытым исходным кодом способны обрабатывать контекстные окна длиной до миллиона токенов, что делает их уникальными среди общедоступных моделей с подобными возможностями.

Модели используют редкое внимание [1], фокусируясь только на наиболее важных частях контекста. Такой подход позволяет обрабатывать входные данные объёмом в миллион токенов в три-семь раз быстрее, чем традиционные методы, а выходные данные могут содержать до 8000 токенов. Однако для этого моделям необходимо выявлять ключевые отрывки в контекстных документах — задача, с которой часто не справляются современные языковые модели [2].

В процессе тестирования обе модели — 14B и Qwen2.5-Turbo — продемонстрировали безупречные результаты в обнаружении скрытых чисел в объёмных текстовых массивах. Модель 7B также показала хорошие результаты, лишь с незначительными ошибками. Однако эти тесты в основном тестируют поиск информации [3] – аналогично дорогостоящему нажатию Ctrl + F – а не более глубокое понимание контента.

Преимущества больших контекстных окон перед системами RAG неочевидны. Длинные контекстные окна проще в использовании и более гибкие, но архитектуры RAG, которые извлекают информацию из внешних баз данных во время логического вывода, часто работают более точно и эффективно с гораздо меньшими контекстными окнами, содержащими около 128 000 токенов.

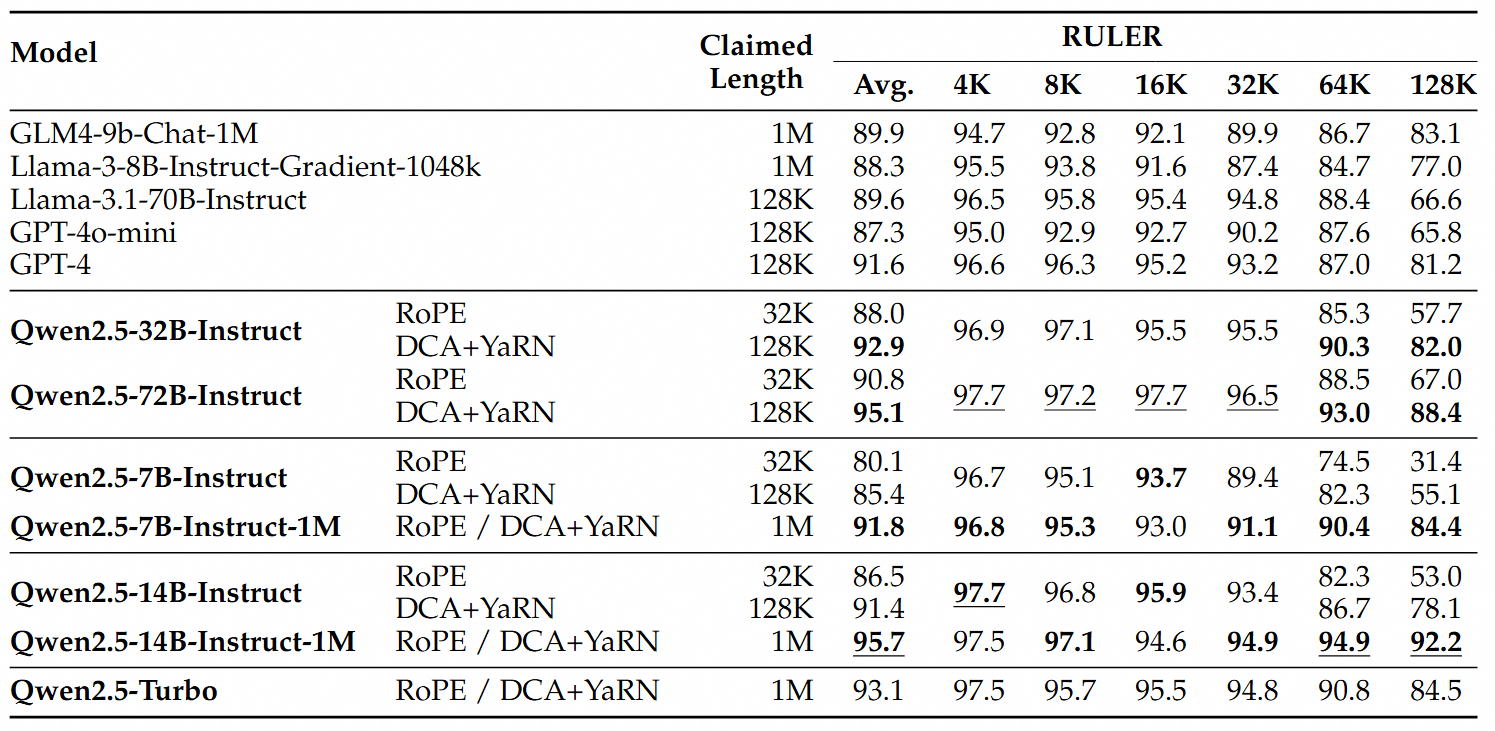

В более сложных тестах, таких как RULER [5], LV-Eval [6] и LongbenchChat [7], модели с миллионом токенов превзошли своих аналогов с 128 000 токенов, особенно в последовательностях длиной более 64 000 токенов. Модель 14B даже набрала более 90 баллов в RULER — впервые для серии Qwen — стабильно опережая GPT-4o mini в нескольких наборах данных.

Для более коротких текстов модели с миллионом токенов показали такую же производительность, как и модели с 128 тысячами токенов, без каких-либо компромиссов при работе с кратким контентом.

Пользователи могут попробовать эту и другие модели Alibaba с помощью Qwen Chat [8], интерфейса Alibaba, похожего на ChatGPT [9], или с помощью демонстрации на Hugging Face [10]. Наряду с моделями с открытым исходным кодом от китайской компании Deepseek, Qwen бросает вызов признанным американским провайдерам, предлагая аналогичные возможности по более низкой цене.

Источник [11]

Автор: mefdayy

Источник [12]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/11613

URLs in this post:

[1] внимание: http://www.braintools.ru/article/7595

[2] задача, с которой часто не справляются современные языковые модели: https://the-decoder.com/large-language-models-and-the-lost-middle-phenomenon/

[3] Однако эти тесты в основном тестируют поиск информации: https://the-decoder.com/llms-hit-a-wall-when-processing-complex-information-from-lengthy-texts/

[4] обучением: http://www.braintools.ru/article/5125

[5] RULER: https://arxiv.org/abs/2404.06654

[6] LV-Eval: https://arxiv.org/abs/2402.05136

[7] LongbenchChat: https://arxiv.org/abs/2308.14508

[8] Qwen Chat: https://the-decoder.com/alibaba-launches-free-web-interface-qwen-chat-for-qwen-ai-models/

[9] ChatGPT: https://the-decoder.com/chatgpt-is-a-gpt-3-chatbot-from-openai-that-you-can-test-now/

[10] демонстрации на Hugging Face: https://huggingface.co/spaces/Qwen/Qwen2.5-1M-Demo

[11] Источник: https://the-decoder.com/alibabas-qwen-releases-open-source-model-that-handles-1-million-input-tokens/

[12] Источник: https://habr.com/ru/companies/bothub/news/877272/?utm_source=habrahabr&utm_medium=rss&utm_campaign=877272

Нажмите здесь для печати.