«Вспомнить всё»: исследователи предложили архитектуру языковых моделей с большой памятью

9 февраля на arXiv была опубликована [1] новая научная работа “LM2: Large Memory Models”, в которой исследователи описали обновление классической архитектуры LLM на базе трансформеров. LM2 превосходит как модель RMT с дополненной памятью [2] на 37.1%, так и базовую модель Llama-3.2 на 86,3% в среднем по задачам.

В чем суть?

Исследователи из Convergence Labs представили Large Memory Model (LM2) – новую архитектуру языковых моделей, которая преодолевает ограничения традиционных трансформеров в обработке длинного контекста.

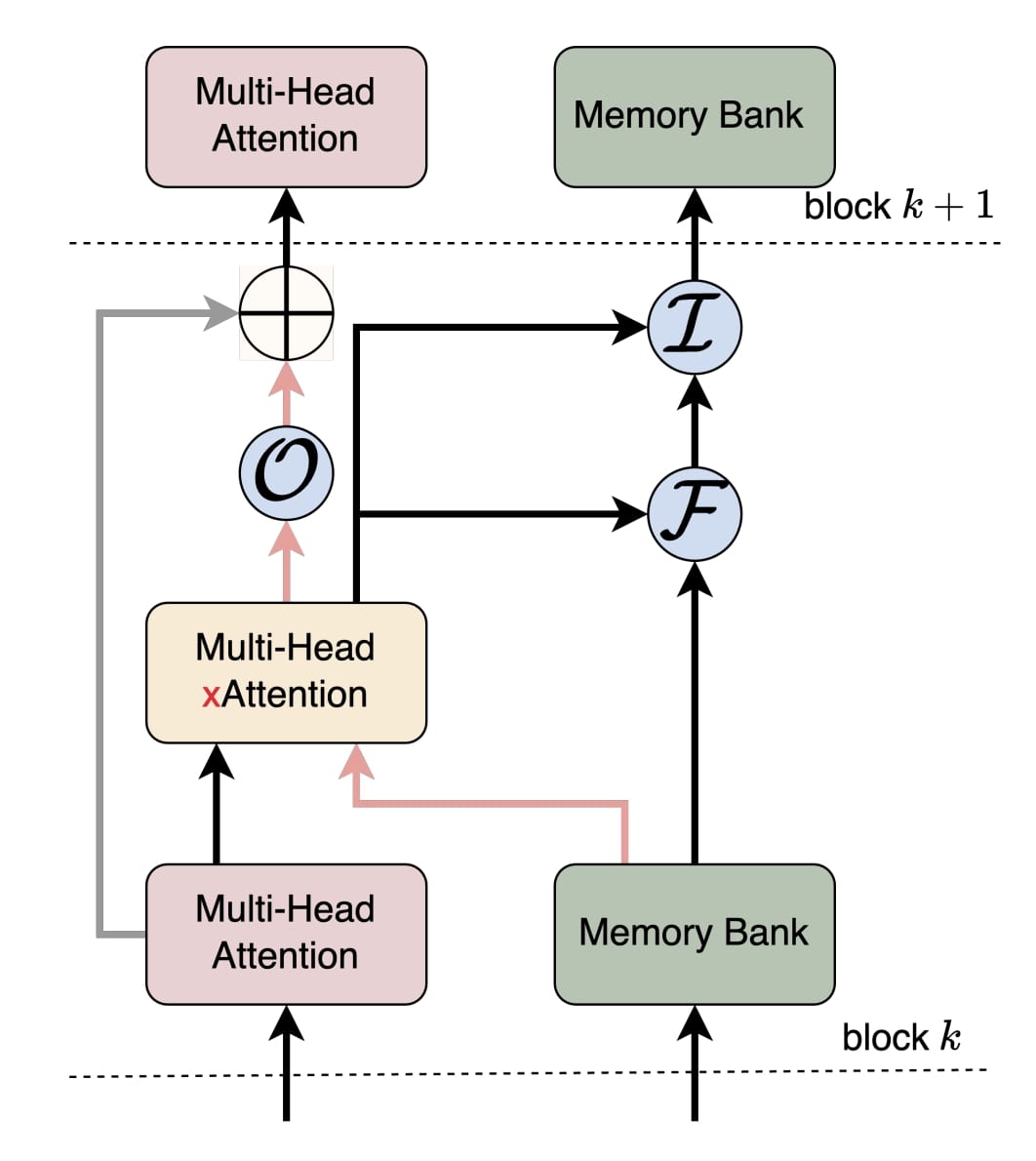

LM2 дополняет стандартный механизм внимания [3] отдельным модулем памяти, который взаимодействует с входными данными, отбирает важную информацию и обновляется по мере работы модели.

В чем новизна?

Ключевое отличие LM2 – дополнительный поток памяти, который дополняет стандартный поток внимания в трансформерах. Этот механизм включает:

-

Кросс-аттеншен между модулем памяти и входными данными.

-

Гейты управления (запись, забывание [4] и извлечение данных), позволяющие динамически обновлять хранимую информацию.

-

Разделение процессов обработки и хранения информации, что делает модель устойчивой к длинным контекстам.

Модель тестировалась на двух ключевых наборах данных:

-

BABILong – сложный бенчмарк для многоступенчатых рассуждений. LM2 показала прирост точности на 37,1% по сравнению с предыдущими архитектурами с улучшенной памятью.

-

MMLU – тест на общие знания. LM2 улучшила результаты на 5%, демонстрируя, что модуль памяти не мешает базовой работоспособности модели на универсальных задачах.

Заключение

LM2 – очередной шаг вперед в развитии ИИ. Сейчас большое количество инвестиций идёт как раз в новые архитектуры – многие ожидают, что следующие грандиозные прорывы будут следствие не просто масштабирования (увеличения кол-ва параметров), а именно смены самой архитектурной парадигмы в LLM (что мы и видим на последних стрельнувших моделях).

Дополнительно к этому, один из главных трендов этого года – обучение ИИ без участия человека [5] (на синтетических данных). Интересно, какие ещё открытия ждут нас в этом году на пересечении этих подходов – архитектурных изменений с одной стороны, и ускорение за счет исключения ручного труда – с другой.

—-

P.S. Все громкие новости про ИИ, которые попадают в заголовки медиа обычно вырастают из таких “тихих” революционных исследований. Чтобы узнавать о них раньше всех надо регулярно мониторить HuggingFace Daily papers [6]/arXiv recents [7]/GitHub Trending [8]/прочие исследовательские площадки.

Я делаю это на ежедневной основе, и если нахожу такие алмазы – пишу про них у себя в Телеграм канале [9], вместе с глубокой аналитикой по тому, как это всё влияет на бизнес.

Автор: ElKornacio

Источник [10]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/12111

URLs in this post:

[1] была опубликована: https://arxiv.org/abs/2502.06049

[2] памятью: http://www.braintools.ru/article/4140

[3] внимания: http://www.braintools.ru/article/7595

[4] забывание: http://www.braintools.ru/article/3931

[5] обучение ИИ без участия человека: https://t.me/elkornacio/137

[6] HuggingFace Daily papers: https://huggingface.co/papers

[7] arXiv recents: https://arxiv.org/list/cs/recent

[8] GitHub Trending: https://github.com/trending

[9] у себя в Телеграм канале: https://t.me/+D3rczrDV9w40N2Zi

[10] Источник: https://habr.com/ru/news/881548/?utm_source=habrahabr&utm_medium=rss&utm_campaign=881548

Нажмите здесь для печати.