Лгал ли xAI о тестах Grok 3?

Дискуссии по поводу тестов AI и того, как их результаты представляются лабораториями AI, выплескиваются на общественное обозрение.

На этой неделе сотрудник OpenAI обвинил [1] компанию Илона Маска xAI, занимающуюся разработкой искусственного интеллекта [2], в публикации вводящих в заблуждение результатов тестов для ее последней модели искусственного интеллекта Grok 3. Один из соучредителей xAI, Игорь Бабушкин, настаивал [3] на том, что компания права.

В сообщении в блоге xAI [4] компания опубликовала график, показывающий производительность Grok 3 на AIME 2025, наборе сложных математических вопросов из недавнего пригласительного экзамена по математике [5]. Некоторые эксперты сомневаются в валидности AIME как эталона ИИ [6]. Тем не менее, AIME 2025 и более ранние версии теста обычно используются для проверки математических способностей модели.

График xAI показал два варианта Grok 3, Grok 3 Reasoning Beta и Grok 3 mini Reasoning, которые превзошли самую эффективную из доступных моделей OpenAI, o3-mini-high [7] , на AIME 2025. Но сотрудники OpenAI в X поспешили указать, что график xAI не включает оценку o3-mini-high на AIME 2025 в «cons@64».

Что такое cons@64, вы можете спросить? Ну, это сокращение от «consensus@64», и по сути это дает модели 64 попытки ответить на каждую проблему в бенчмарке и берет ответы, сгенерированные чаще всего, в качестве окончательных ответов. Как вы можете себе представить, cons@64 имеет тенденцию значительно повышать результаты бенчмарков моделей, и исключение его из графика может создать впечатление [8], что одна модель превосходит другую, хотя на самом деле это не так.

Оценки Grok 3 Reasoning Beta и Grok 3 mini Reasoning для AIME 2025 на уровне «@1» — то есть первая оценка, которую модели получили в бенчмарке — ниже оценки o3-mini-high. Grok 3 Reasoning Beta также немного отстает от модели OpenAI o1, [9] настроенной на «средние» вычисления. Тем не менее, xAI рекламирует Grok 3 [10] как «самый умный ИИ в мире».

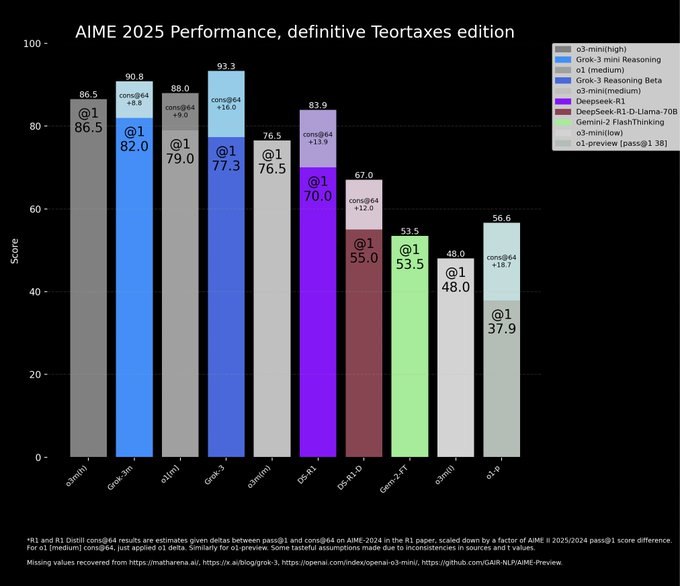

Бабушкин утверждал на X [3] , что OpenAI публиковала подобные вводящие в заблуждение графики бенчмарков в прошлом — хотя это были графики, сравнивающие производительность ее собственных моделей. Более нейтральная сторона в дебатах составила более «точный» график, показывающий производительность почти каждой модели при cons@64:

Но как указал [11] исследователь AI Натан Ламберт в посте , возможно, самая важная метрика остается загадкой: вычислительные (и денежные) затраты, необходимые для того, чтобы каждая модель достигла наилучшего результата. Это просто показывает, как мало большинство тестов AI сообщают об ограничениях моделей — и их сильных сторонах.

Источник [12]

Автор: dilnaz_04

Источник [13]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/12471

URLs in this post:

[1] обвинил: https://x.com/BorisMPower/status/1892407015038996740

[2] интеллекта: http://www.braintools.ru/article/7605

[3] настаивал: https://x.com/ibab/status/1892418351084732654

[4] сообщении в блоге xAI: https://x.ai/blog/grok-3

[5] математике: http://www.braintools.ru/article/7620

[6] сомневаются в валидности AIME как эталона ИИ: https://x.com/DimitrisPapail/status/1888325914603516214

[7] o3-mini-high: https://techcrunch.com/2025/01/31/openai-launches-o3-mini-its-latest-reasoning-model/

[8] впечатление: http://www.braintools.ru/article/2012

[9] модели OpenAI o1,: https://techcrunch.com/2024/09/12/openai-unveils-a-model-that-can-fact-check-itself/

[10] рекламирует Grok 3: https://x.com/xai/status/1892400129719611567

[11] Но как указал: https://x.com/natolambert/status/1892675458166382687

[12] Источник: https://techcrunch.com/2025/02/22/did-xai-lie-about-grok-3s-benchmarks/

[13] Источник: https://habr.com/ru/companies/bothub/news/885002/?utm_source=habrahabr&utm_medium=rss&utm_campaign=885002

Нажмите здесь для печати.