Генеративный ИИ в работе дизайнера

Меня зовут Иосиф.

Как продуктовый дизайнер и магистрант AI Talent Hub, я всё чаще использую инструменты ИИ в своей работе, поэтому решил разобраться, как они функционируют. Это нужно не только для собственного понимания, но и для того, чтобы объяснять заинтересованным в этой теме коллегам. Данная статья не претендует на глубокий анализ — я постарался изложить материал простым языком и в сжатой форме.

Искусственный интеллект [1] (ИИ) в последние годы стал одним из основных драйверов инноваций в сфере цифрового дизайна. Одним из наиболее перспективных направлений являются генеративные модели (Generative Models) — алгоритмы, которые способны создавать новый контент: изображения, тексты, 3D-объекты, музыку и многое другое. Эти технологии предоставляют дизайнерам новые возможности для ускорения процессов, поиска вдохновения и автоматизации рутинных задач.

В этой статье я объясню принципы работы генеративных моделей и рассмотрю их применение в дизайне. Основное внимание [2] будет уделено двум наиболее востребованным технологиям — генеративно-состязательным сетям (GAN) и диффузионным моделям (Diffusion Models).

1. Что такое генеративные модели?

В машинном обучении [3] принято делить модели на две большие категории: дискриминативные и генеративные.

-

Дискриминативные модели (Discriminative Models) отвечают на вопрос: к какому классу принадлежит объект? Например, они классифицируют, изображена ли на фотографии кошка или собака.

-

Генеративные модели (Generative Models) учатся понимать распределение данных, чтобы создавать новые объекты, которые «выглядят как» оригинальные, но при этом не копируют их.

Генеративные модели подразделяются на несколько типов в зависимости от подхода:

-

Генеративно-состязательные сети (GAN) — работают по принципу состязания двух нейронных сетей: генератора и дискриминатора. Генератор учится создавать данные, которые дискриминатор не сможет отличить от реальных.

-

Диффузионные модели (Diffusion Models) — обучаются пошагово добавлять и удалять шум, чтобы научиться создавать изображения из случайного шума. Они популярны благодаря таким системам, как Stable Diffusion и DALL-E.

-

Другие подходы, например автокодировщики (Autoencoders) и трансформеры (Transformers). В рамках данной статьи мы не будем их подробно рассматривать, так как они имеют более специфичные области применения и менее популярны в дизайне.

Для дизайнеров генеративные модели особенно интересны тем, что позволяют создавать новые образы, стили и структуры. В этой статье мы сосредоточимся на двух самых востребованных технологиях: GAN и Diffusion Models. Их использование даёт не только креативные, но и практичные результаты — от генерации концепт-артов до автоматизации рутинных задач.

2. Генеративно-состязательные сети (GAN)

2.1 Как работает GAN

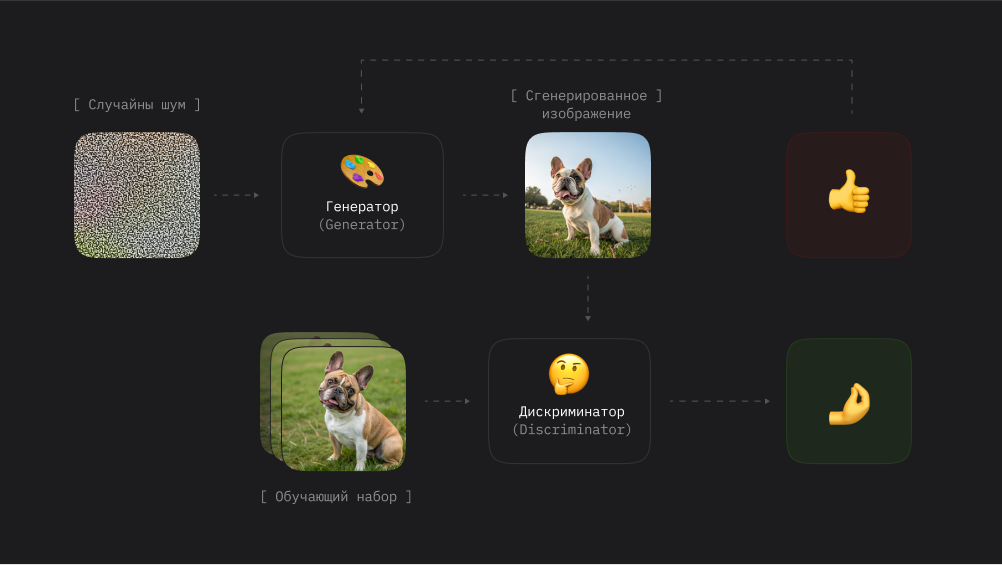

Генеративно-состязательная сеть (Generative Adversarial Network), предложенная Иэном Гудфеллоу в 2014 году, включает две взаимосвязанные модели:

-

Генератор (Generator): принимает на вход случайный шум (обычно вектор) и пытается создать правдоподобные данные (например, изображения).

-

Дискриминатор (Discriminator): принимает как сгенерированные, так и реальные данные из обучающего набора, стараясь определить, какие из них подлинные.

Обучение происходит как своеобразная игра: генератор стремится обмануть дискриминатор, выдавая всё более реалистичные результаты, а дискриминатор учится лучше распознавать подделки. Процесс продолжается до тех пор, пока не достигается баланс. Упрощенно его можно описать поэтапно:

-

Изначальное состояние. Генератор получает на вход случайный шум и создаёт данные (картинка, текст и т. д.).

-

Работа генератора. Генератор формирует синтетические данные, стараясь сделать их максимально реалистичными.

-

Оценка дискриминатором. Дискриминатор принимает данные от генератора и обучающего набора, пытаясь определить, какие из них реальные.

-

Обучение генератора и дискриминатора. Генератор нацелен на обман дискриминатора, а дискриминатор стремится распознавать подделки. Процесс повторяется многократно, пока не достигается оптимальный баланс.

-

Итерации и результаты. После достаточного числа итераций генератор научается создавать данные, которые трудно отличить от реальных.

2.2 Где можно попробовать

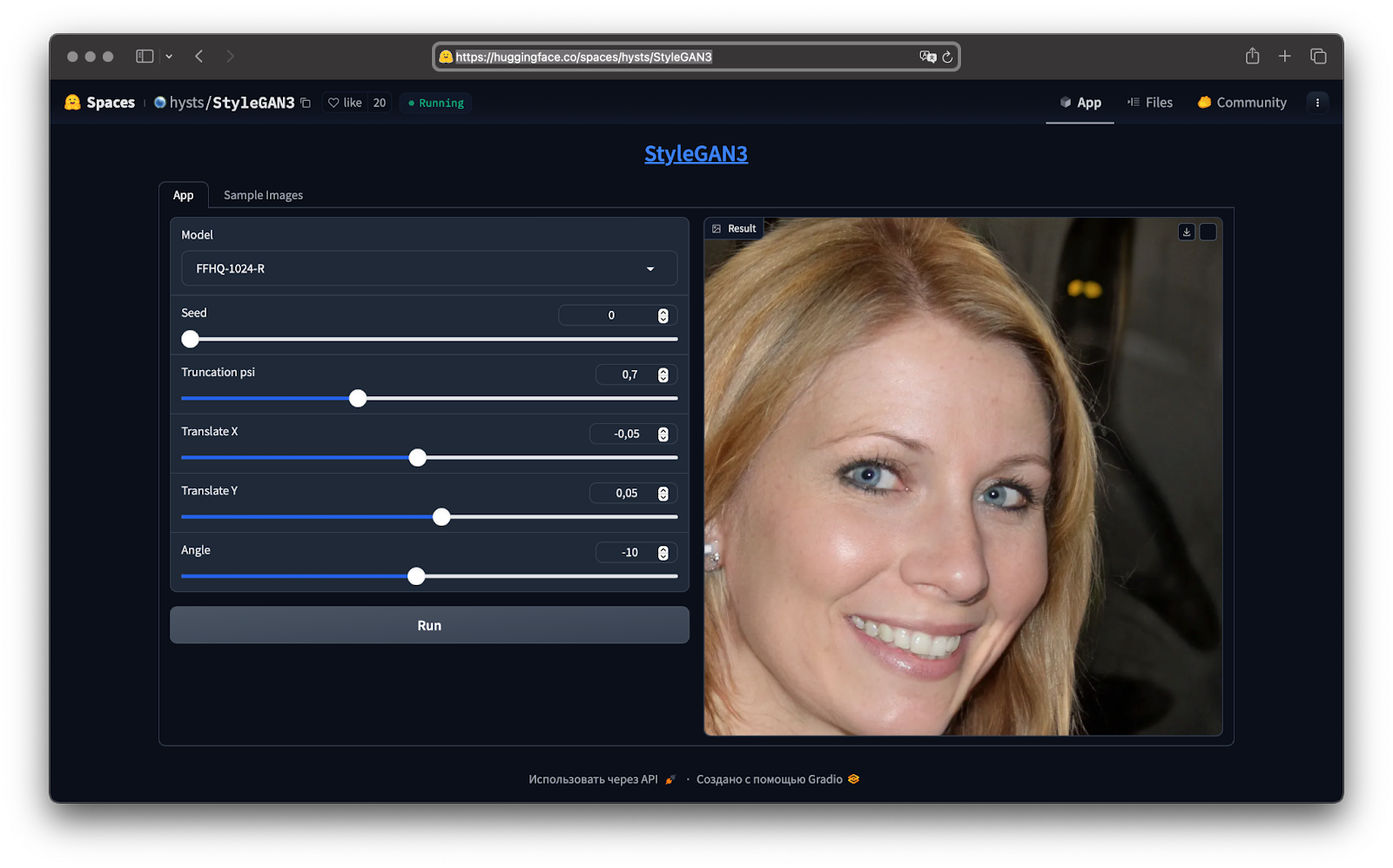

Если хотите попробовать GAN в действии, можете ознакомиться с демонстрацией StyleGAN3 на Hugging Face [5]. Там можно увидеть, как сеть генерирует изображения высокого качества.

StyleGAN3 — это усовершенствованная версия GAN, разработанная компанией NVIDIA. Основное улучшение заключается в устранении артефактов, связанных с привязкой текстур к определенным координатам, что обеспечивает более плавную и реалистичную генерацию изображений.

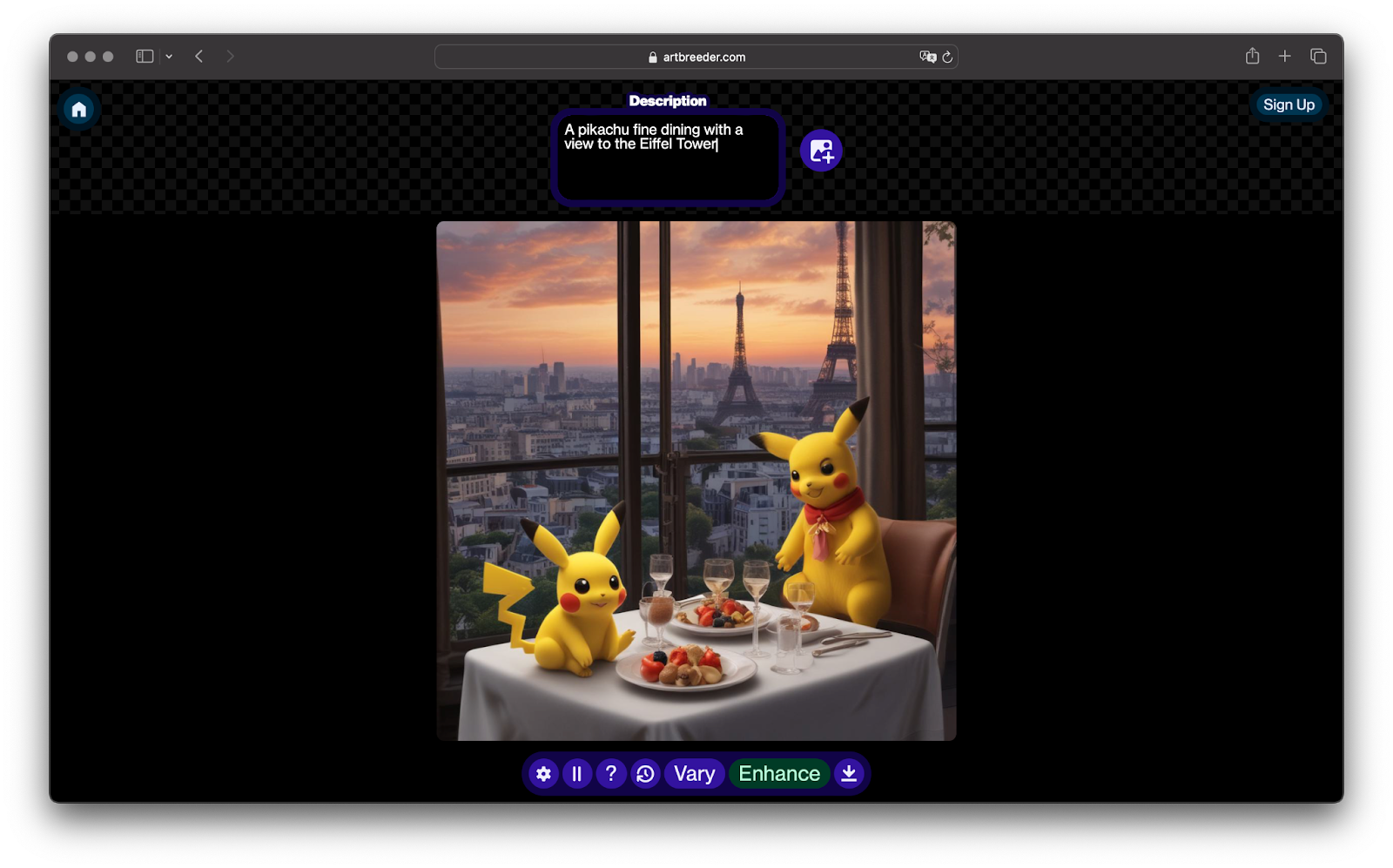

Artbreeder [6] — это платформа, где можно смешивать и редактировать изображения, создавая новые уникальные визуальные работы с помощью GAN.

2.3 Актуальные модификации, если вы захотите углубиться в данную тему

-

BigGAN: генерация детализированных изображений для множества классов объектов. GitHub [7]

-

CycleGAN и UGATIT: перенос стиля между доменами (например, «зима-лето», «день-ночь», «фото-картина»). UGATIT-PyTorch [8]

-

CreativeGAN: модификация, позволяющая создавать уникальные и инновационные дизайны, адаптируя генеративные модели к творческим задачам. GitHub [9]

-

PaDGAN: разработан для генерации разнообразных и высококачественных дизайнов с учётом определённых параметров производительности (полезно в инженерном и промышленном дизайне). GitHub [10]

-

Omni-GAN: улучшает качество и разнообразие генерируемых изображений, обеспечивает более стабильное обучение и избегает эффекта «сужения разнообразия» (mode collapse). GitHub [11]

2.4 Применение в дизайне

-

Генерация концепт-арта и иллюстраций: быстрое создание множества вариантов для дальнейшей доработки.

-

Создание текстур и паттернов: генерация бесшовных узоров и сложных текстур для графического дизайна, интерьеров и игр.

-

Стилизация изображений: перенос стиля одного изображения на другое, например, превращение фото в картину «в стиле Ван Гога».

3. Диффузионные модели (Diffusion Models)

3.1 Принцип работы

Диффузионные модели произвели революцию в генерации изображений. Технологии вроде Stable Diffusion, DALL-E и Midjourney демонстрируют не только высокую реалистичность, но и креативность, создавая уникальные изображения.

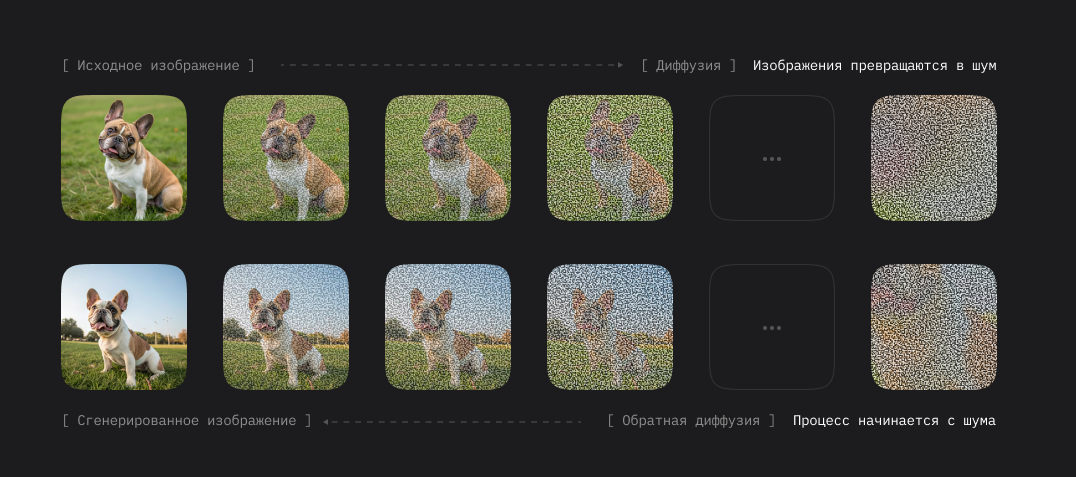

Механизм работы:

-

Прямой процесс (Forward Diffusion): оригинальное изображение постепенно превращается в белый шум путём добавления случайных помех.

-

Обратный процесс (Reverse Diffusion): модель обучается поэтапно удалять шум и восстанавливать исходное изображение или создавать новое.

Если разбирать покомпонентно:

-

Изначальное изображение. Модель начинает с исходной картинки (например, пейзаж), которая в ходе прямого процесса искажается шумом.

-

Прямой процесс. На каждом шаге изображение всё больше теряет исходные черты, пока не становится «белым шумом».

-

Обратный процесс. Обученная модель восстанавливает изображение из шума, шаг за шагом удаляя помехи и добавляя детали, «запомненные» в ходе обучения.

-

Генерация новых изображений. Модель может сочетать формы, цвета и текстуры из различных обучающих образов, создавая нечто совершенно новое.

-

Итерации и точность. Процесс требует множества итераций, где каждая «прорисовывает» детали всё точнее.

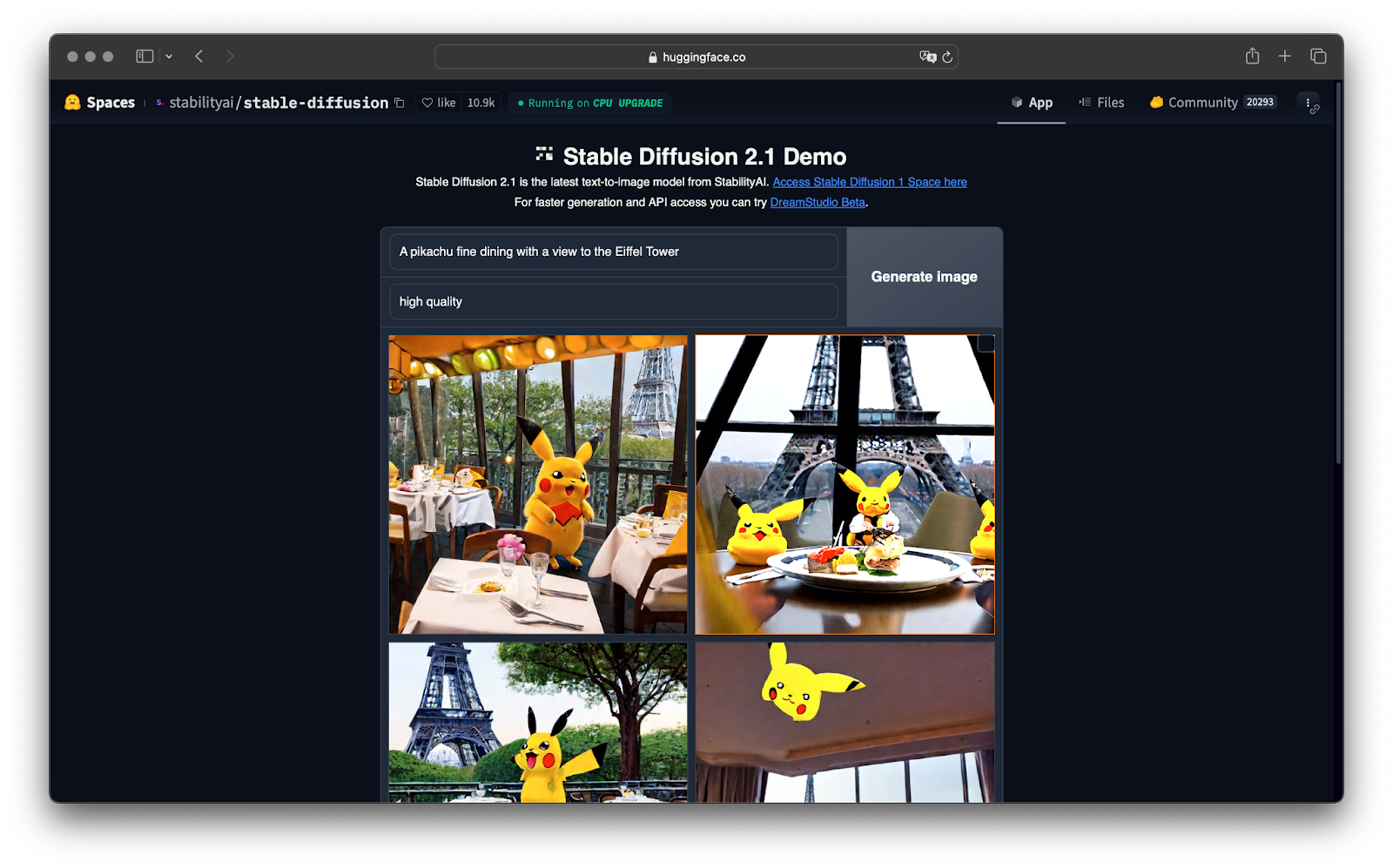

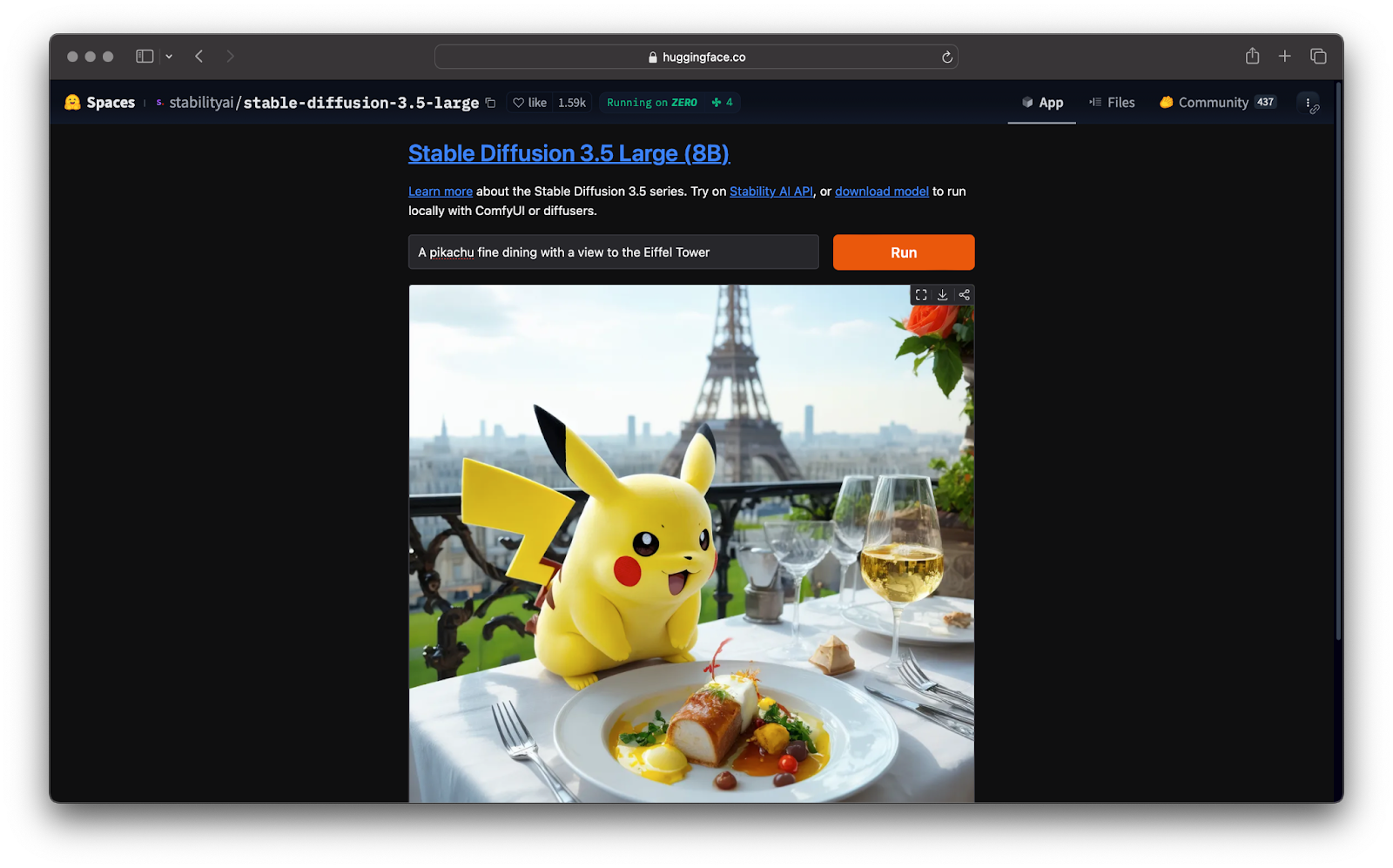

На платформе Hugging Face можно опробовать диффузионные модели (Stable Diffusion и другие) через веб-приложения (Spaces). Библиотека Diffusers [13] от Hugging Face предоставляет предобученные модели для генерации изображений, аудио и даже 3D-структур.

Чтобы попробовать Stable Diffusion без установки программного обеспечения, воспользуйтесь демонстрацией [15] на Hugging Face. Вы вводите текстовое описание и получаете результат.

3.2 Где можно попробовать

-

Stable Diffusion XL: генерирует изображения высокого разрешения с проработкой мелких деталей.

-

DALL-E 3: улучшенное понимание текстовых запросов и точная генерация изображений.

-

Midjourney: упор на фотореализм и сложные световые эффекты.

-

Яндекс Шедеврум и Kandinsky 3.0: также используют диффузионные модели для генерации изображений по тексту.

-

Recraft AI: это инструмент дизайна, основанный на собственных диффузионных моделях, таких как Recraft V3 и Red Panda

3.3 Применение в дизайне

-

Создание концепт-артов: вводим идею («ночной лес в стиле импрессионизма») и получаем несколько вариантов.

-

Интерактивное редактирование: добавление или изменение элементов на уже существующих изображениях.

-

Прототипирование и анимация: такие модели, как Runway Gen, позволяют создавать короткие видеоролики по текстовым запросам.

4. Сравнение GAN и Diffusion Models (коротко)

|

|

GAN |

Diffusion Models |

|

Качество |

Высокая детализация, возможны артефакты |

Высокая детализация, более стабильные результаты |

|

Сложность |

Трудно достичь баланса |

Стабильный, но ресурсозатратный процесс |

|

Скорость |

Быстрая, одношаговый процесс |

Медленная из-за многошагового восстановления |

|

Детализация |

Реалистичность в одном шаге |

Лучшая проработка сложных текстур и деталей |

|

Зачем |

Стилизация, дипфейки |

Концепт-арты |

5. Как правильно формулировать «промпты» (Prompt Engineering)

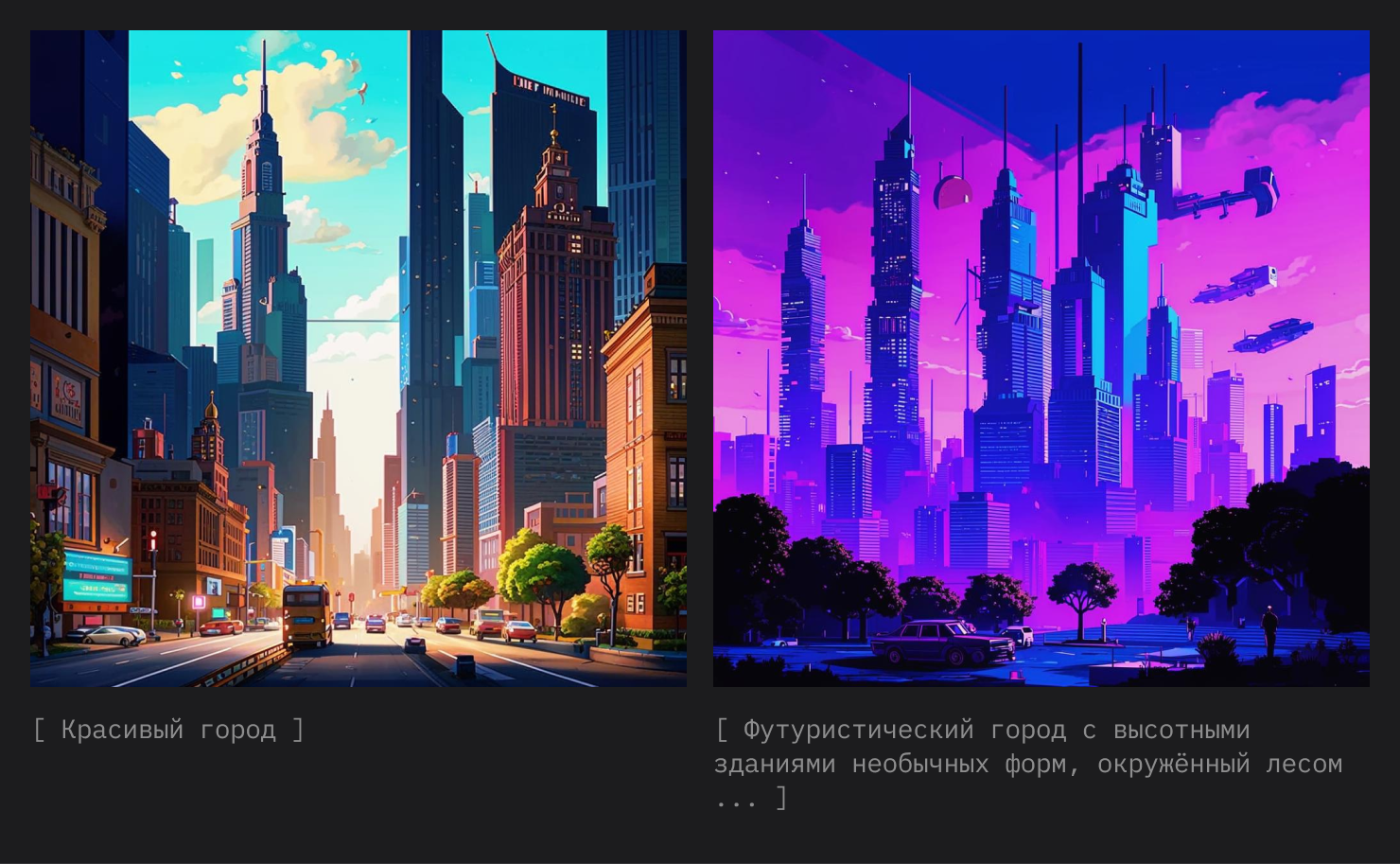

Одной из основных сложностей при работе с генеративными моделями является правильная формулировка запросов или «промптов». Неправильно составленный запрос может дать неожиданный или некачественный результат.

-

Детализируйте описание

-

Объект: подробно опишите объект и его детали — чем больше, тем лучше. На удивление, если вы сами не знаете, что должно быть на изображении, то вы, скорее всего, получите неудовлетворительный результат.

-

Фон: окружение заслуживает не меньше деталей. Укажите время суток (например, «сумерки»), настроение (например, «сказочная атмосфера»), конкретные элементы (например, «светлячки»).

-

Стиль: художественный стиль обычно можно выбрать в параметрах. Если такой возможности нет, укажите его словами.

-

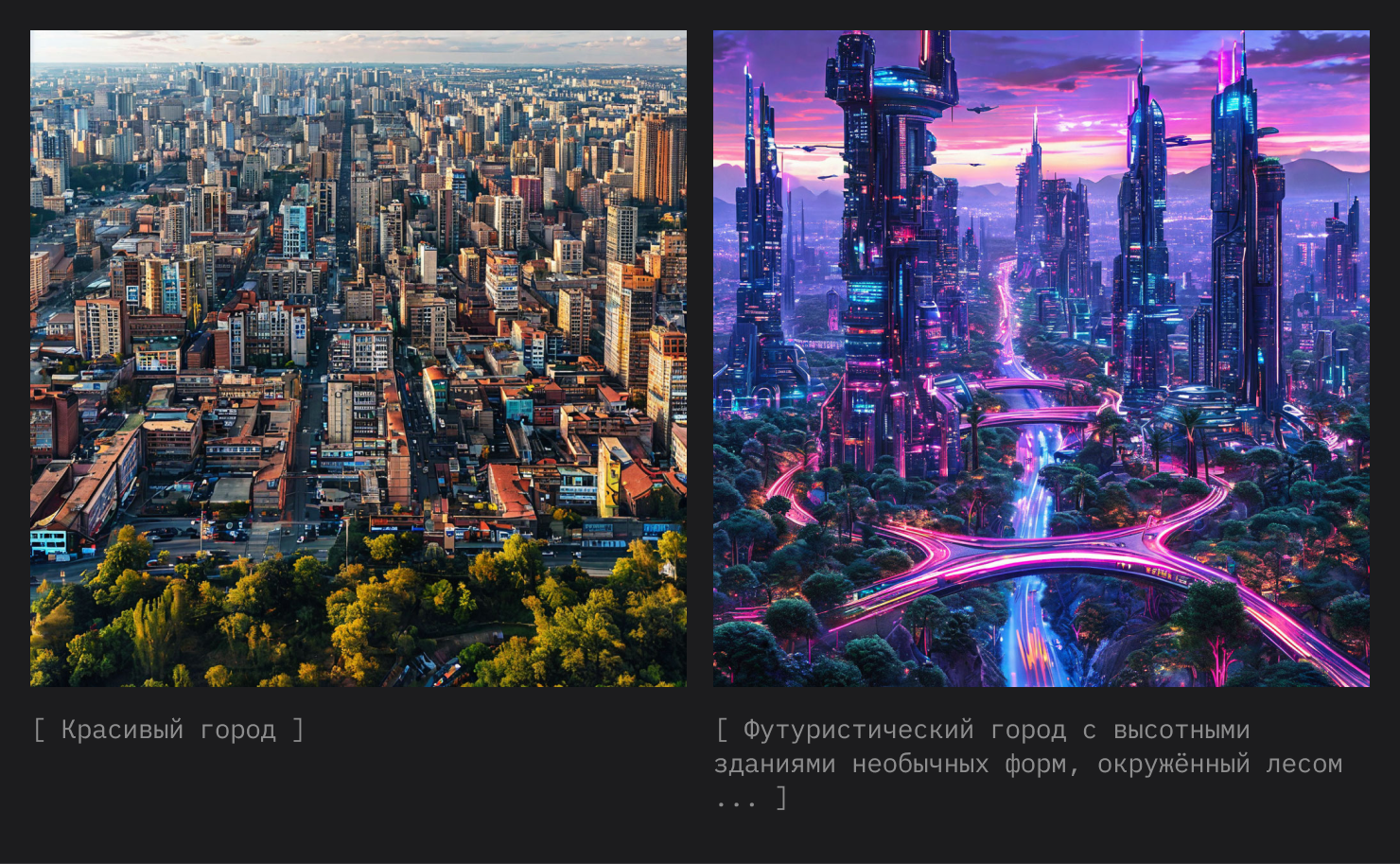

Пример плохого промпта: «Красивый город», «Телефон на столе»

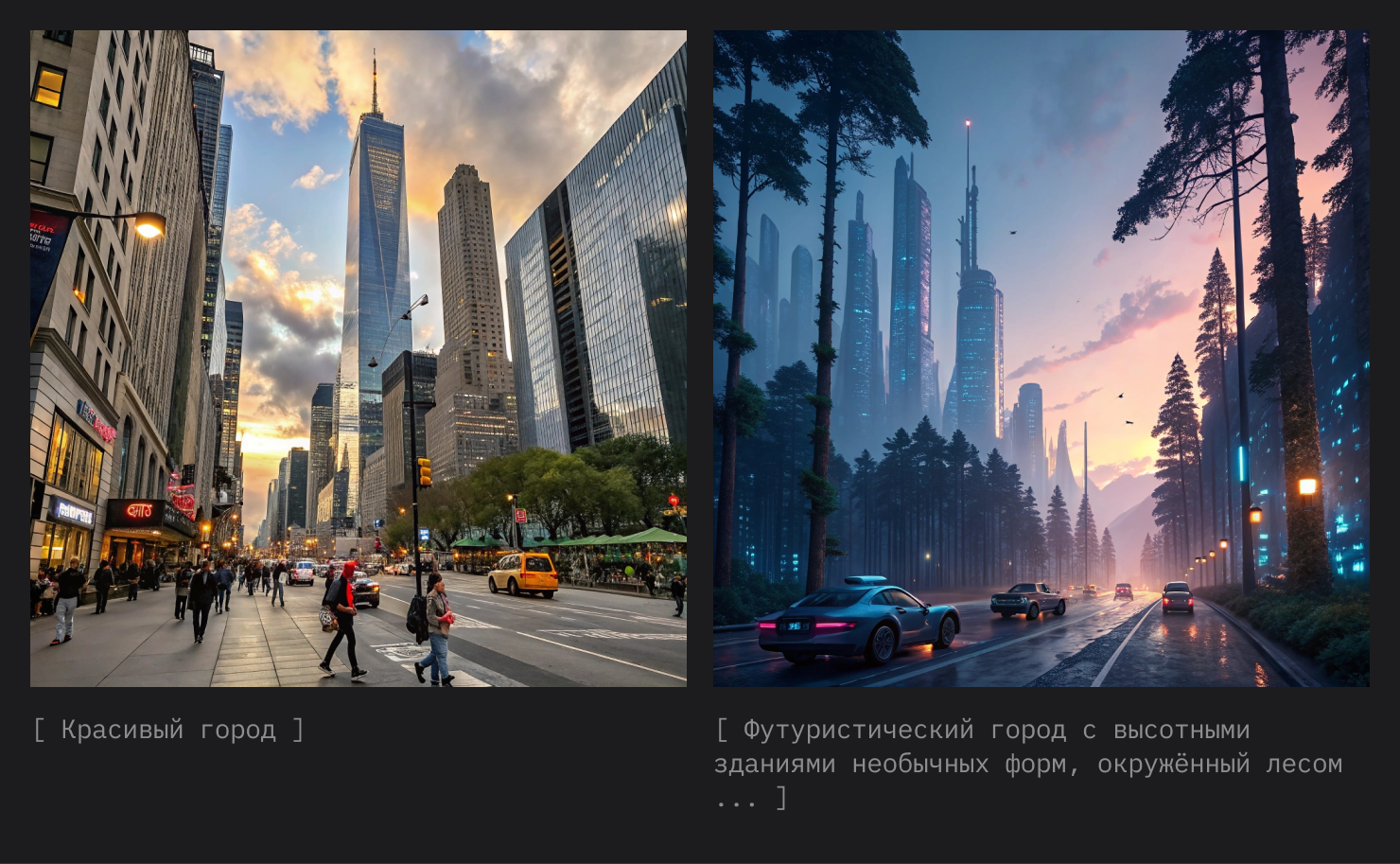

Пример хорошего промпта: «Футуристический город с высотными зданиями необычных форм, окруженный лесом из гигантских деревьев. Улицы освещены неоновыми огнями, в небе летают машины. Город изображён в стиле киберпанк, с акцентом на холодные синие и фиолетовые тона, закатное освещение».

-

Используйте начальные изображения (seed). Прикрепляйте примеры или референсы, это поможет быстрее получить требуемый результат.

-

Работайте итеративно. Генерируйте несколько вариантов, анализируйте результаты и дорабатывайте промпт, чтобы добиться лучшего качества. По моему опыту [16], очень редко удается получить идеальный результат с первого раза. Но вы и сами это узнаете, когда приступите.

-

Готовьтесь к тому, что композицию придётся дорабатывать. Когда вы хотите совместить нужный фон с нужным объектом, будьте готовы потратить время на генерацию фона и отдельно — объекта, а затем средствами графических инструментов самостоятельно объединять их с корректировкой цветов и деталей.

Полезные ресурсы, которые помогут углубиться в данную тему:

-

GigaChat [17]: каталог готовых промптов;

-

Kandinsky [18]: руководства по составлению промпто;

-

Яндекс Шедеврум [19]: советы по формулировке запросов.

Давайте разберём на реальных примерах, как сейчас работают самые доступные в России нейросети. Для примера возьмём: Яндекс Шедеврум, Кандинский и (для сравнения) рассмотрим результат работы Recraft (он недоступен в России, но я чаще всего использую его в своей работе).

По результатам заметно, что современные нейросети уже неплохо справляются с генерацией изображений как по простому промпту, так и по детальному. Однако у них нередко возникают сложности с корректным отображением текста (например, на плакатах и обложках книг), цифр (например, на часах). Кроме того, важно проверять количество пальцев у персонажей на руках и ногах. При этом звери, природа и города, как правило, получаются очень хорошо.

Заключение

Модели, описанные в статье, стали ключевыми инструментами для генерации иллюстраций, текстур, логотипов и персонажей. Их популярность стремительно растёт, а порог входа становится всё ниже благодаря доступным платформам и инструментам. Это даёт возможность даже начинающим дизайнерам легко использовать генеративные алгоритмы в работе.

Однако не стоит забывать [21], что ИИ — помощник, а не замена креативности. Дизайнер остается главным автором, задающим направление и финализирующим результат. Освоение генеративных моделей, знание их возможностей и правильное использование промптов помогут не только добиться впечатляющих результатов, но и сделать каждый проект уникальным.

В будущем мы увидим ещё больше инноваций, где ИИ станет полноценным соавтором, помогающим реализовывать самые смелые идеи.

Материал подготовил магистрант AI Talent Hub [22], Иосиф Ясюкевич.

Автор: ai-talent

Источник [23]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/12630

URLs in this post:

[1] интеллект: http://www.braintools.ru/article/7605

[2] внимание: http://www.braintools.ru/article/7595

[3] обучении: http://www.braintools.ru/article/5125

[4] https://www.nature.com/articles/s41598-024-84186-6: https://www.nature.com/articles/s41598-024-84186-6

[5] Hugging Face: https://huggingface.co/spaces/hysts/StyleGAN3

[6] https://www.artbreeder.com/: https://www.artbreeder.com/

[7] GitHub: https://github.com/ajbrock/BigGAN-PyTorch

[8] UGATIT-PyTorch: https://github.com/Lornatang/UGATIT-PyTorch

[9] GitHub: https://github.com/mfrashad/creativegan

[10] GitHub: https://github.com/wchen459/PaDGAN

[11] GitHub: https://github.com/PeterouZh/Omni-GAN-PyTorch

[12] https://arxiv.org/pdf/2209.00796: https://arxiv.org/pdf/2209.00796

[13] Diffusers: https://github.com/huggingface/diffusers

[14] https://huggingface.co/spaces/stabilityai/stable-diffusion: https://huggingface.co/spaces/stabilityai/stable-diffusion

[15] демонстрацией: https://huggingface.co/spaces/stabilityai/stable-diffusion-3.5-large

[16] опыту: http://www.braintools.ru/article/6952

[17] GigaChat: https://giga.chat/help/articles/prompt-examples

[18] Kandinsky: https://courses.sberuniversity.ru/llm-gigachat/1/3/1

[19] Яндекс Шедеврум: https://yandex.ru/support2/shedevrum/ru/text/how

[20] Recraft.ai: http://Recraft.ai

[21] забывать: http://www.braintools.ru/article/333

[22] AI Talent Hub: https://ai.itmo.ru/?utm_source=habr&utm_medium=iosif_jasukevich&utm_campaign=pedpraktika&utm_content=statya1&utm_term=llm_nlp

[23] Источник: https://habr.com/ru/articles/885814/?utm_campaign=885814&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.