OpenAI o3 демонстрирует почти идеальную производительность в тесте с длинным контекстом

Один из самых убедительных результатов недавних тестов o3 — его производительность при выполнении задач с длительным контекстом.

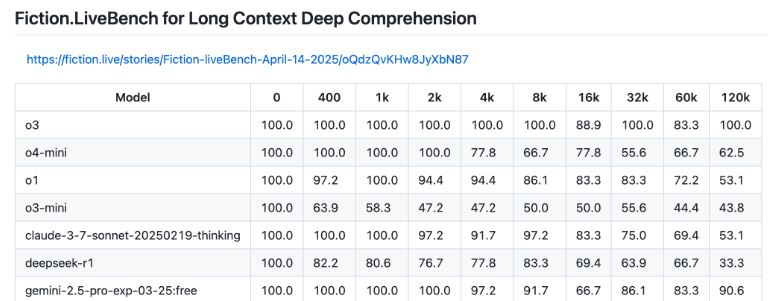

Поддерживая до 200 000 токенов, o3 является первой моделью, которая достигла 100-процентного результата на тесте [1]Fiction.live [2] с использованием 128 000 токенов — это примерно 96 000 слов. Для любой языковой модели, работающей с обширными повествованиями или большими документами, это значительный шаг вперёд. Единственная модель, которая близка к этому показателю, — Google Gemini 2.5 Pro [3], набравшая 90,6 процента, в то время как o3-mini и o4-mini значительно отстают.

Тест Fiction.LiveBench разработан для оценки способности моделей полностью осознавать и точно передавать смысл длинных и сложных текстов, включая контекст.

Например, Llama 4 от Meta* рекламирует контекстное окно размером до десяти миллионов токенов [4] — на бумаге это число кажется впечатляющим. Но на практике оно едва ли полезно для чего-то, кроме простого поиска слов, и не справляется с осмысленным пониманием длинных текстов.

Дело не только в Llama 4 [5]. В целом, многие модели плохо справляются с пониманием контекста, превращая эти огромные контекстные окна скорее в маркетинговый трюк, чем в реальную возможность. В худшем случае они создают у пользователей иллюзию, что модель обрабатывает весь документ, хотя на самом деле большая часть текста остаётся без внимания [6] — недостаток, отмеченный во многих исследованиях [7].

Для тех, кто сталкивается с реальными задачами, требующими стабильной и эффективной работы с большими объёмами данных, o3 теперь является явным лидером.

*Meta и ее продукты (Instagram, Facebook) запрещены на территории Российской Федерации

Источник [8]

Автор: mefdayy

Источник [9]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/14465

URLs in this post:

[1] тесте : https://fiction.live/stories/Fiction-liveBench-April-6-2025/oQdzQvKHw8JyXbN87

[2] Fiction.live: http://Fiction.live

[3] Google Gemini 2.5 Pro: https://the-decoder.com/gemini-2-5-pro-google-has-finally-caught-up/

[4] рекламирует контекстное окно размером до десяти миллионов токенов: https://the-decoder.com/metas-llama-4-models-show-promise-on-standard-tests-but-struggle-with-long-context-tasks/#long-context-performance-falls-short

[5] Llama 4: https://the-decoder.com/metas-llama-4-models-show-promise-on-standard-tests-but-struggle-with-long-context-tasks/

[6] внимания: http://www.braintools.ru/article/7595

[7] недостаток, отмеченный во многих исследованиях: https://the-decoder.com/ai-language-models-struggle-to-connect-the-dots-in-long-texts-study-finds/

[8] Источник: https://the-decoder.com/openais-o3-achieves-near-perfect-performance-on-long-context-benchmark/

[9] Источник: https://habr.com/ru/companies/bothub/news/902852/?utm_source=habrahabr&utm_medium=rss&utm_campaign=902852

Нажмите здесь для печати.