Квантование моделей: запуск новейших моделей Google на локальном оборудовании

Обучение [1] с учётом квантования позволяет запускать новейшие модели Google на локальных графических процессорах и даже на мобильных устройствах.

Благодаря специализированному подходу к обучению эти новые варианты Gemma 3 теперь могут эффективно работать на потребительском оборудовании — например, на игровых графических процессорах или даже на мобильных устройствах — без существенной потери качества. Для сравнения, оригинальные модели Gemma 3 [2] были созданы для высокопроизводительных систем с использованием NVIDIA H100 и точностью BFloat16, что делало их недоступными для обычных пользователей.

Ключом к этому сдвигу является квантование — процесс, который значительно сокращает использование памяти [3]. Обе модели и их контрольные точки теперь доступны на Hugging Face [4] и Kaggle [5].

Квантование означает хранение весовых коэффициентов и значений активации с меньшим количеством бит — часто 8, 4 или даже всего 2 — вместо обычных 16 или 32. Это позволяет создавать более компактные модели, которые работают быстрее, поскольку числа с меньшей точностью быстрее перемещаются и обрабатываются.

В Gemma 3 Google применяет обучение с учётом квантования (QAT) — метод, который вводит условия пониженной точности во время обучения. Моделируя с самого начала меньшую разрядность, модель учится адаптироваться к этим ограничениям, сводя к минимуму обычное снижение производительности при работе с пониженной точностью.

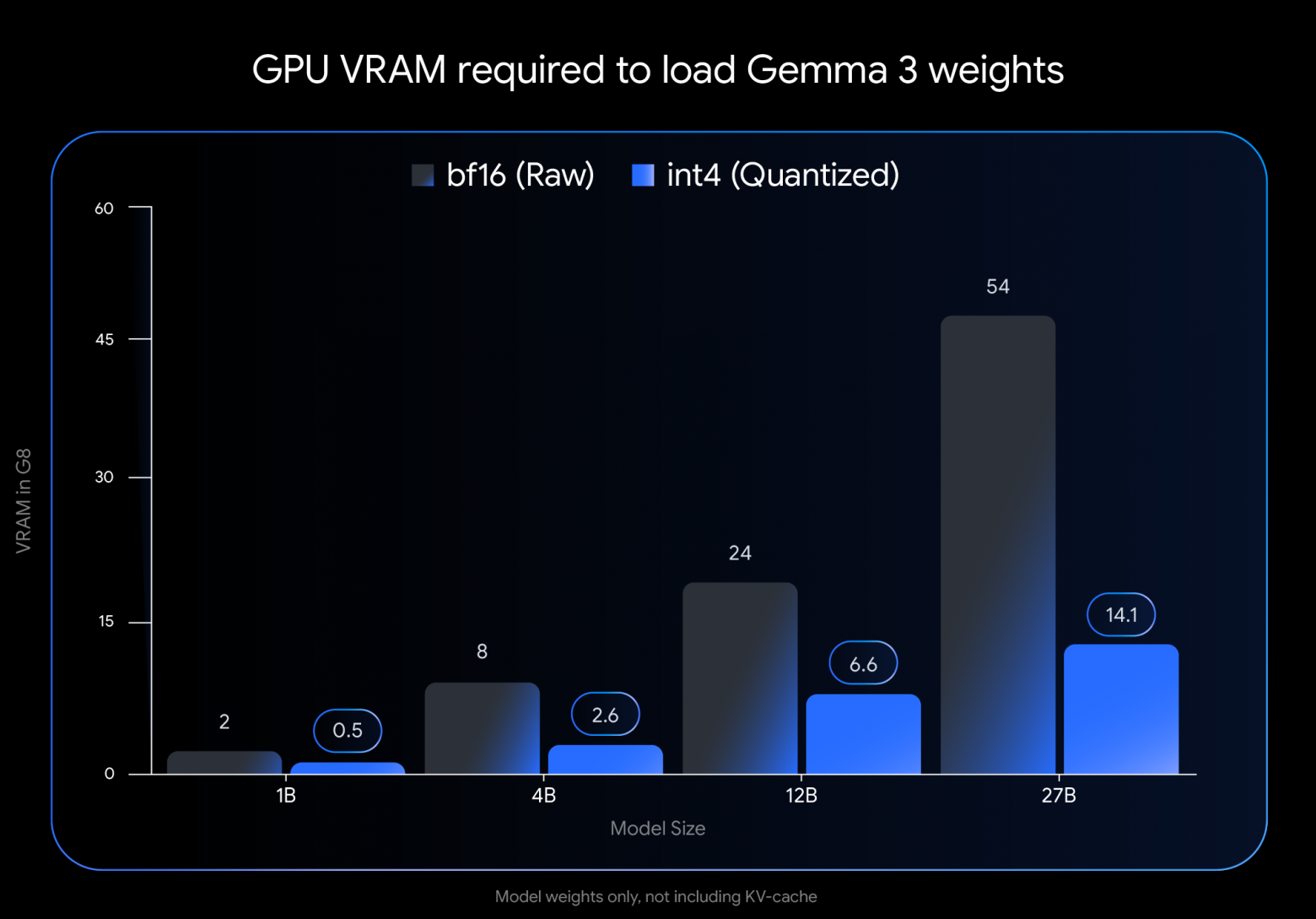

Экономия памяти существенная. Например, модель 27B сокращает объём видеопамяти с 54 ГБ до 14,1 ГБ в формате int4. Вариант 12B сокращает объём с 24 ГБ до 6,6 ГБ. Даже более компактные модели выигрывают: версия 4B занимает 2,6 ГБ, а модели 1B требуется всего 0,5 ГБ.

Google утверждает, что благодаря QAT модели «устойчивы к квантованию» — условию, которое обычно приводит к некоторой потере качества модели. Однако компания не опубликовала обновлённые результаты тестов, подтверждающие это утверждение.

Модели совместимы с распространёнными механизмами логического вывода для интеграции в существующие рабочие процессы. Встроенная поддержка доступна для Ollama [6], LM Studio [7] и MLX [8] (для Apple Silicon) и других. Такие инструменты, как llama.cpp [9] и gemma.cpp [10], также поддерживают квантованные модели Gemma в формате GGUF [11].

Источник [12]

Автор: mefdayy

Источник [13]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/14467

URLs in this post:

[1] Обучение: http://www.braintools.ru/article/5125

[2] оригинальные модели Gemma 3: https://the-decoder.com/google-releases-new-gemma-3-open-model-family/

[3] памяти: http://www.braintools.ru/article/4140

[4] Hugging Face: https://huggingface.co/models?search=gemma+3+qat

[5] Kaggle: https://www.kaggle.com/models/google/gemma

[6] Ollama: https://ollama.com/

[7] LM Studio: https://lmstudio.ai/

[8] MLX: https://github.com/ml-explore/mlx

[9] llama.cpp: https://github.com/ggerganov/llama.cpp

[10] gemma.cpp: https://github.com/google-deepmind/gemma.cpp

[11] формате GGUF: https://github.com/ggerganov/ggml/blob/master/docs/gguf.md

[12] Источник: https://the-decoder.com/gemma-3-27b-it-qat-q4_0-gguf-sounds-like-a-wi-fi-password-but-its-googles-leanest-ai-yet/

[13] Источник: https://habr.com/ru/companies/bothub/news/902876/?utm_source=habrahabr&utm_medium=rss&utm_campaign=902876

Нажмите здесь для печати.