Вышла Qwen3. Весит мало, работает быстро. Обходит LLama4 402B Maverick и конкурирует с DeepSeek R1

Новое семейство Qwer3 представлено в виде Dense: 0.6B,1.7B, 4B, 8B, 14B, 32B, и в виде MoE: 30B-A3B, 235B-A22B. Каждая модель поддерживать гибридный режим работы: обычный и размышление. Поддерживает 119 языков и диалектов.

Маленькие модели 0.6B подойдут для speculative decoding [1] в llama.cpp и производных, вроде LM Studio [2], позволяя ускорять выполнение больших моделей за счет предсказания уже очевидных токенов, где не требуется полноценная работа большой модели. Таким образом можно получить ускорение в среднем 20-50% без изменения качества ответа, но всё зависит от множества факторов, включая язык токенов.

MoE модели записываются в формате Qwen3-30B-A3B и Qwen3-235B-A22B, что означает, что модель имеет всего 30B или 235B параметров, из который активных 3B или 22B. Активные параметры в MoE означают, что на вычисление каждого следующего токена будет задействована не вся модель, а лишь её часть, что сильно снижает требование к вычислительным ресурсам.

Главное преимущество MoE моделей это кратное снижение требований к железу, запускать можно даже с ssd (ключ --ubatch-size 1, чтобы обрабатывать запросы pp партиями 1 за раз, вместо 512, иначе ssd станет узким местом), можно выгрузить общие слоя в vram, получая приличное ускорение на одной GPU (ключ -ot exps=CPU или --override-tensor ".ffn_.*_exps.=CPU"), или использовать форки ik_llama [3] и KTransformers [4], позволяющие использовать новые оптимизации, такие как -mla и -fmoe.

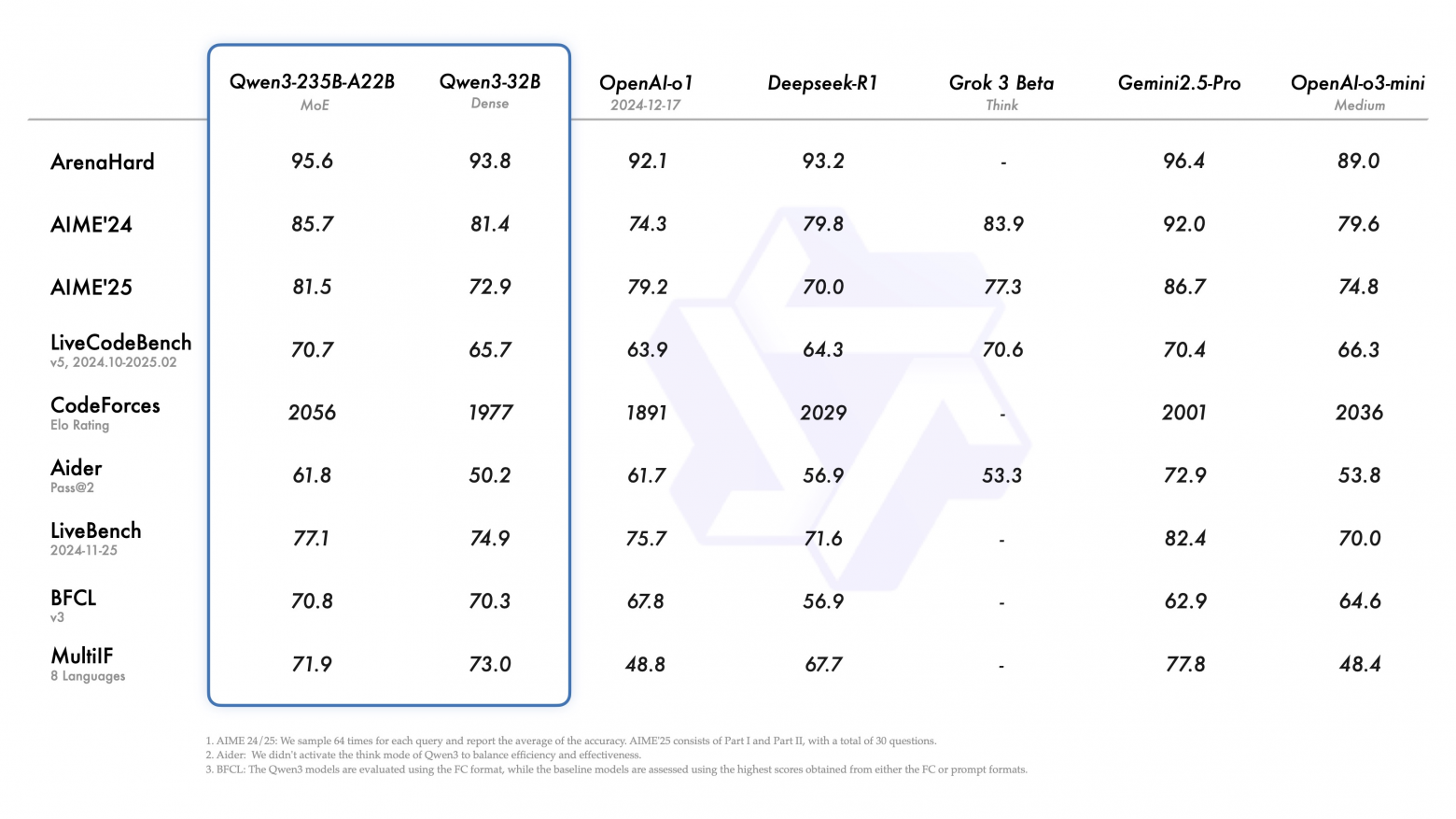

По бенчмаркам можно увидеть, что модель 30B-A3B превосходит Gemma3-27B и DeepSeek V3 старого образца (версия DeepSeek V3-0324 сильно превосходит обычный V3).

Qwen3-30B-A3B занимает почти тот же размер, что и Gemma3-27B, но при этом, за счет всего 3B активных параметров, работает быстрее, что позволяет её запустить даже на CPU с хорошей скоростью.

Модель Qwen3-235B-A22B по бенчмаркам превосходит LLama4 Maverick 402B-A17B, будучи почти в 2 раза меньше.

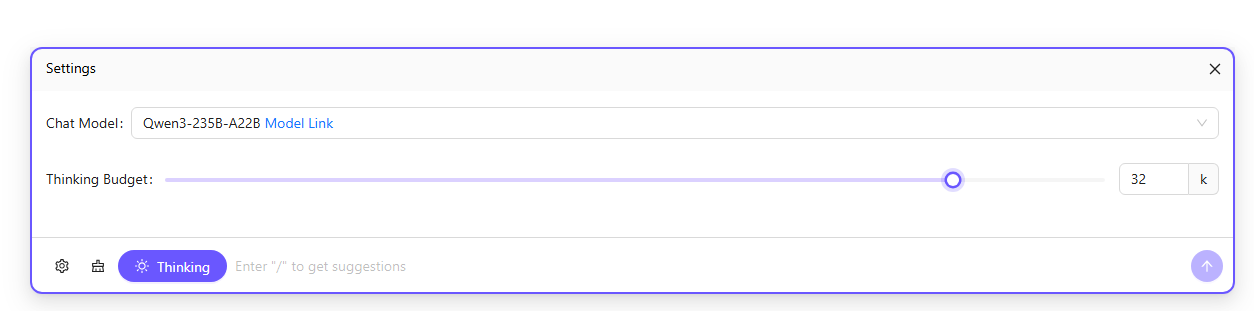

Модель позволяет управлять Thinking Budget – рекомендация для модели по количеству токенов мышления [5], которые она может использовать при генерации ответа.

Официальная рекомендация [6] при использовании режима размышлений: Temperature=0.6, TopP=0.95, TopK=20, MinP=0

Без режима мышления: Temperature=0.7, TopP=0.8, TopK=20, MinP=0

Попробовать онлайн все виды моделей в официальном спейсе: https://huggingface.co/spaces/Qwen/Qwen3-Demo [7]

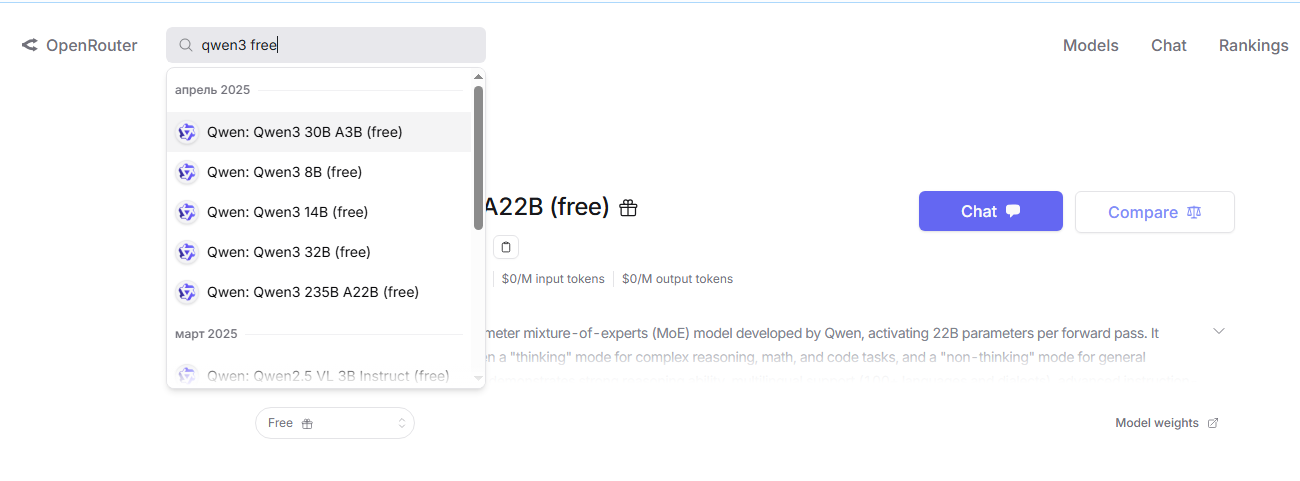

Также старшие модели уже доступны на https://openrouter.ai/ [8] (как через api, так и через Chat на сайте):

Коллекция gguf (часть квантов сломана, об этом было предупреждение): https://huggingface.co/collections/unsloth/qwen3-680edabfb790c8c34a242f95 [9]

Как запускать локально на CPU или CPU + GPU: https://habr.com/ru/articles/831272/ [10]

Автор: Shannon

Источник [11]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/14723

URLs in this post:

[1] speculative decoding: https://github.com/ggml-org/llama.cpp/pull/10455

[2] LM Studio: https://lmstudio.ai/blog/lmstudio-v0.3.10

[3] ik_llama: https://github.com/ikawrakow/ik_llama.cpp

[4] KTransformers: https://github.com/kvcache-ai/ktransformers

[5] мышления: http://www.braintools.ru/thinking

[6] Официальная рекомендация: https://gist.github.com/ibnbd/5ec32ce14bde8484ca466b7d77e18764#best-practices

[7] https://huggingface.co/spaces/Qwen/Qwen3-Demo: https://huggingface.co/spaces/Qwen/Qwen3-Demo

[8] https://openrouter.ai/: https://openrouter.ai/

[9] https://huggingface.co/collections/unsloth/qwen3-680edabfb790c8c34a242f95: https://huggingface.co/collections/unsloth/qwen3-680edabfb790c8c34a242f95

[10] https://habr.com/ru/articles/831272/: https://habr.com/ru/articles/831272/

[11] Источник: https://habr.com/ru/news/905314/?utm_source=habrahabr&utm_medium=rss&utm_campaign=905314

Нажмите здесь для печати.