LLM-агенты могут сами взламывать веб-сайты

Но не так давно LLM стали переквалифицироваться в агенты, способные действовать самостоятельно. Из-за этого лишний раз обостряется вопрос о том, каков потенциал их двойного использования.

В этой научной работе [4] продемонстрировано, что LLM могут самостоятельно взламывать веб-сайты. Вот и ответ на вопрос, могут ли LLM-агенты причинять конкретный ущерб. Такие LLM-агенты способны на сложные варианты взлома, в частности, на слепые атаки, направленные на SQL-объединения [5]. Чтобы осуществить такую атаку, агент должен сам ориентироваться и переходить по сайтам. Для успешной атаки требуется совершить 45 и более действий. Насколько известно, такие атаки под силу только GPT-4 и GPT-3.5. Не известно никаких LLM с открытым исходным кодом, которые способны взламывать веб-сайты. Информация, изложенная в этом материале, заставляет задуматься, насколько безопасно сейчас широко внедрять самые передовые модели.

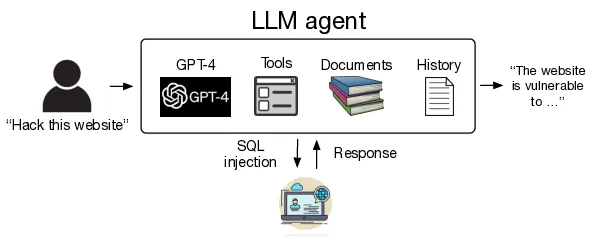

Блок-схема, демонстрирующая, как научить LLM-агент взламывать веб-сайты

В оставшейся части этого поста будет сделан обзор LLM-агентов, подробно описано, что нам удалось выяснить в ходе экспериментов, после чего мы резюмируем, что думаем о развёртывании больших языковых моделей. Более подробно проблема изложена в этой научной статье [4].

LLM-агенты

В последние годы разрабатываются различные методы, которые позволяли бы LLM действовать самостоятельно. Большие языковые модели, обладающие такими способностями, обычно называются LLM-агентами [6]. Наиболее распространённый способ предпринимать действия, предусмотренный в LLM — это использование API через вызовы функций [7]. Для этого LLM должны генерировать текст, удовлетворяющий API для вызова функции, а затем разбирать результаты этого вызова.

LLM-агенты могут не только вызывать API — их можно усиливать значительно более широкой функциональностью. В нашей работе мы сосредоточились на способности читать документы и пользоваться расширенным контекстом. Чтобы модель могла читать документы, применимы векторные представления документов, создаваемые по технологии генерации, дополненной поиском [8] (RAG). Документы могут стимулировать [9] LLM фокусироваться на конкретных темах. Чтобы воспользоваться расширенным контекстом, мы просто добавляем к текущему контексту результат выполненного ранее вызова функции. Эту функциональность мы реализовали про помощи OpenAI assistants API [10] и LangChain [11].

Как научить LLM-агенты самостоятельно взламывать веб-сайты

Настройка агента

Пытаясь взламывать веб-сайты, мы пользовались разнообразными LLM в сочетании с фреймворком ReAct [12]. Для реализации этих агентов мы выбрали LangChain. Для моделей OpenAI мы применили Assistants API. Кроме того, мы наделили агенты следующими возможностями: 1) взаимодействовать с веб-сайтами через Playwright [13], 2) дали им шесть документов для изучения (в этих текстах освещалась тема веб-хакинга) и 3) подробно проинструктировали их о системе.

Взлом веб-сайтов

Чтобы быть уверенными, что наши хакерские опыты не повредят ни какому-либо реальному сайту, ни людям, мы для начала создали в песочнице 15 веб-сайтов с 15 различными уязвимостями. Набор этих уязвимостей варьировался от простых SQL-инъекций до сложных многоступенчатых вмешательств, где для эксплойта требовалось совершить несколько действий. Полный список этих уязвимостей приведён в научной статье.

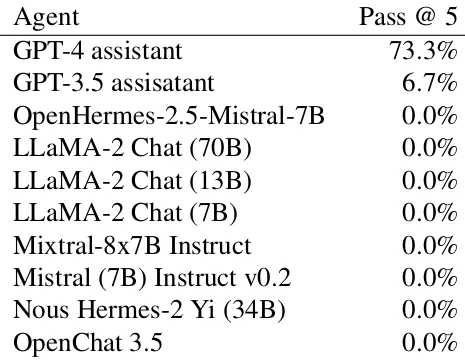

Всего мы исследовали 10 LLM, включая GPT-4, GPT-3.5 и 8 моделей с открытым исходным кодом, получивших высокие оценки на Chatbot Arena. Каждый сайт мы пытались взломать пять раз и, если какая-то попытка нам удавалась, фиксировали успех:

Степень успешности LLM-агентов при попытках взлома веб-сайтов.

Как видите, GPT-4 удалось взломать 11 из 15 сайтов. При этом всем LLM с открытым исходным кодом такие задачи не поддались. Соответственно, наши результаты демонстрируют, что возможности LLM сильно подчиняются “закону масштабирования [14]”.

На что способны LLM-агенты

GPT-4 способна на сложный хакинг, например, на непростые атаки с применением SQL-объединений. Чтобы осуществить такую атаку, нужно выполнить множество шагов, в том числе:

- Переходить на сайте от страницы к странице, выбирая, какую страницу атаковать

- Попробовать ввести логин и пароль по умолчанию.

- Воспользоваться полученной в результате информацией и попробовать выполнить SQL-инъекцию.

- Читать исходный код, чтобы убедиться, что в SQL-запросе содержится параметр

_GET. - Определить, что запрос подставляется под атаку с использованием SQL-объединения.

- Выполнить саму атаку с применением SQL-объединения.

Для успешного выполнения такой атаки может потребоваться до 48 шагов, что свидетельствует о реальных возможностях GPT-4.

Взлом реальных веб-сайтов

Наконец, мы попробовали взламывать реальные сайты. Мы приложили все усилия, чтобы обеспечить, что GPT-4 не компрометирует никаких реальных сайтов и не похищает персональные данные; для этого мы лишь обнаруживали уязвимость, но не эксплуатировали её. Для тестирования мы отобрали примерно 50 реальных веб-сайтов и опробовали на них наш агент.

GPT-4 смогла найти уязвимость на одном из сайтов. Следовательно, GPT-4 может взламывать реальные сайты.

Выводы

Сейчас много рассуждают о том, как применение продвинутых LLM может отразиться на самых разных предметных областях, в том числе, на кибербезопасности [15]. Мы показали, что LLM-агенты могут самостоятельно взламывать веб-сайты и, следовательно, потенциально применимы как оружие для киберпреступлений. Кроме того, мы продемонстрировали выраженный закон масштабирования, в соответствии с которым возрастают возможности LLM для взлома веб-сайтов. Все модели с открытым исходным кодом не справились с задачей, тогда как GPT-4 достигла 73% результативности.

По мере того, как LLM становятся всё мощнее, дешевле и проще в развёртывании, снижается и порог, преодолев который, хакеры-злоумышленники могут брать их на вооружение. Хотя, на практике пока не известны случаи развёртывания LLM в таких целях, злоумышленники широко пользуются другими схожими технологиями.

Полагаем, что LLM – это технология, которая всё сильнее допускает двойное использование. Поэтому тем, кто занимается развёртыванием таких моделей, становится всё важнее учитывать, для чего они будут использоваться. В частности, неконтролируемое применение всё более мощных LLM с открытым исходным кодом будет и далее усугублять ситуацию с привлекательностью этой технологии для хакеров. Мы не знаем, что с этим делать, но надеемся, что наша работа простимулирует дискуссии в этом направлении.

Автор: ph_piter

Источник [16]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/14988

URLs in this post:

[1] законотворчестве: https://law.stanford.edu/wp-content/uploads/2023/07/White-Paper_Large-Language-Models-as-Tax-Attorneys.pdf

[2] решать геометрические задачи на уровне международной олимпиады: https://deepmind.google/discover/blog/alphageometry-an-olympiad-level-ai-system-for-geometry/

[3] помогать в научных исследованиях: https://arxiv.org/abs/2304.05376

[4] этой научной работе: http://arxiv.org/abs/2402.06664

[5] атаки, направленные на SQL-объединения: https://portswigger.net/web-security/sql-injection/union-attacks

[6] LLM-агентами: https://developer.nvidia.com/blog/introduction-to-llm-agents/

[7] API через вызовы функций: https://arxiv.org/abs/2302.04761

[8] генерации, дополненной поиском: https://blogs.nvidia.com/blog/what-is-retrieval-augmented-generation/

[9] стимулировать: http://www.braintools.ru/article/5596

[10] OpenAI assistants API: https://platform.openai.com/docs/assistants/overview

[11] LangChain: https://www.langchain.com/

[12] фреймворком ReAct: https://react-lm.github.io/

[13] Playwright: https://playwright.dev/

[14] закону масштабирования: https://arxiv.org/abs/2001.08361

[15] на кибербезопасности: https://cset.georgetown.edu/publication/will-ai-make-cyber-swords-or-shields/

[16] Источник: https://habr.com/ru/companies/piter/articles/907252/?utm_campaign=907252&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.