INTELLECT-2: Первая большая (32B) параметрическая модель с распределенным обучением

Обычно нейросети нужно тренировать на мощном железе, сконцентрированном в одном датацентре. Результат такой тренировки попадает в руки той бигтех-корпорации, которой по карману иметь свои датацентры и самостоятельно тренировать модели за бешеные миллионы баксов. Есть ли другой путь?

Встречайте INTELLECT-2 — первую параметрическую модель размером 32B, обученную с помощью асинхронного обучения [1] с подкреплением [2] (RL) на динамическом, однородном рое вычислительных узлов. Доступ к узлам изолирован и не требует дополнительных привилегий — теоретически, это могут быть какие-то компьютеры волонтёров в интернете.

Инфра под это, мягко говоря, нестандартная. Разработчикам пришлось написать несколько компонентов с нуля, и вот что у них получилось…

Важные ссылки

-

Статья написана на основе более подробного технического отчета: primeintellect.ai/intellect-2 [3]

-

Посмотреть работу модели в онлайн-чате можно здесь: chat.primeintellect.ai [4]

-

Модель лежит на Hugging Face [5]

-

Описанный в статье фреймворк Prime-RL лежит на GitHub [6]

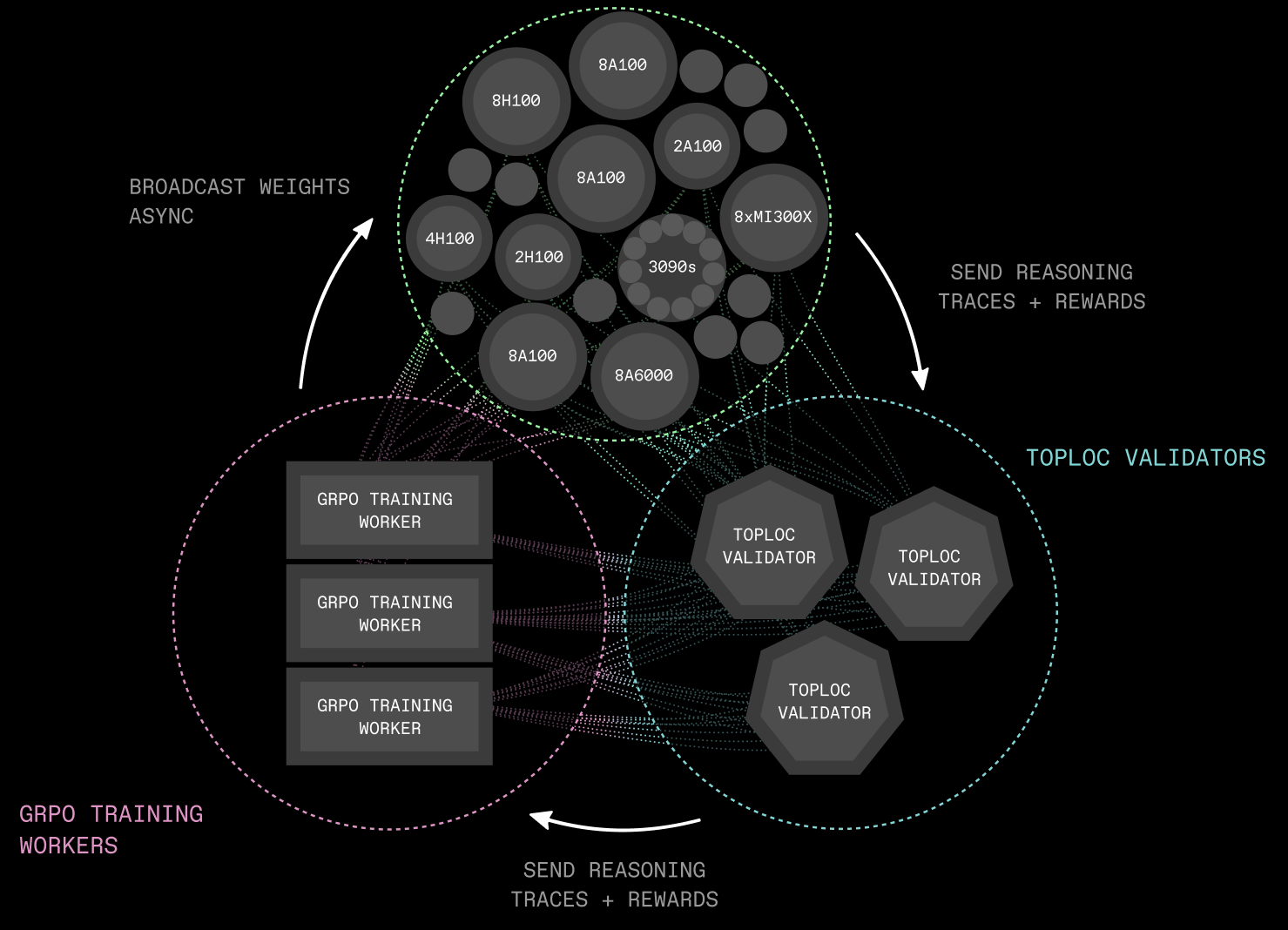

В ходе разработки INTELLECT-2, появилось несколько опенсорсных компонентов. Все вместе они называются PRIME-RL [6] — новый фреймворк, созданный для распределенного асинхронного обучения с подкреплением. Состоит из нескольких частей: TOPLOC верифицирует роллауты от недоверенных инференс-воркеров, а SHARDCAST эффективно транслирует контрольные веса от тренировочных нод к инференс-вокерам.

Помимо инфраструктурных компонентов, разработчики улучшили стандартный протокол тренировки GRPO и способы фильтрации данных. Всё это критически важно для стабилизации обучения и гарантий, что модель успешно усвоила тренировочную цель и улучшила свою базу — QwQ-32B.

Исходный код INTELLECT-2, инфраструктурный код и данные выкладывается в открытый доступ. Команда верит, что будущее — за открытыми исследованиями в области децентрализованного обучения и приглашает всех к сотрудничеству.

Больше заметок о нейросетях в телеграме @1red2black [7]

Новая парадигма

В последнее время, все говорят о test-time compute scaling. Это одна из самых популярных идей для масштабирования LLM. Улучшения достигаются тем, что модель может больше времени провести в ризонинге.

По классике, тренировка с подкреплением жестко централизована. Тебе нужен мощный датацентр с колоцированными GPU и быстрым соединением между серверами в кластере. INTELLECT-2 меняет парадигму: разработчики эксплуатируют тот факт, что обучение с подкреплением по своей природе асинхронно и хорошо подходит для децентрализованных, глобально распределенных вычислений.

Инфраструктура

Давайте детально посмотрим на все компоненты, тем более что они лежат в опенсорсе, и вы сами можете их использовать.

PRIME-RL: [6]

– Полностью асинхронный фреймворк обучения с подкреплением, разработанный для децентрализованного обучения

– Определяет процедуру генерации роллаутов, тренировку модели и рассылку весов

– Позволяет проводить обучение на гетерогенных, ненадежных сетях

– Реализация трейнера использует PyTorch FSDP2 [8], инференс использует vLLM [9], а верификаторы используют схему GENESYS [10], представленную в SYNTHETIC-1 [11]

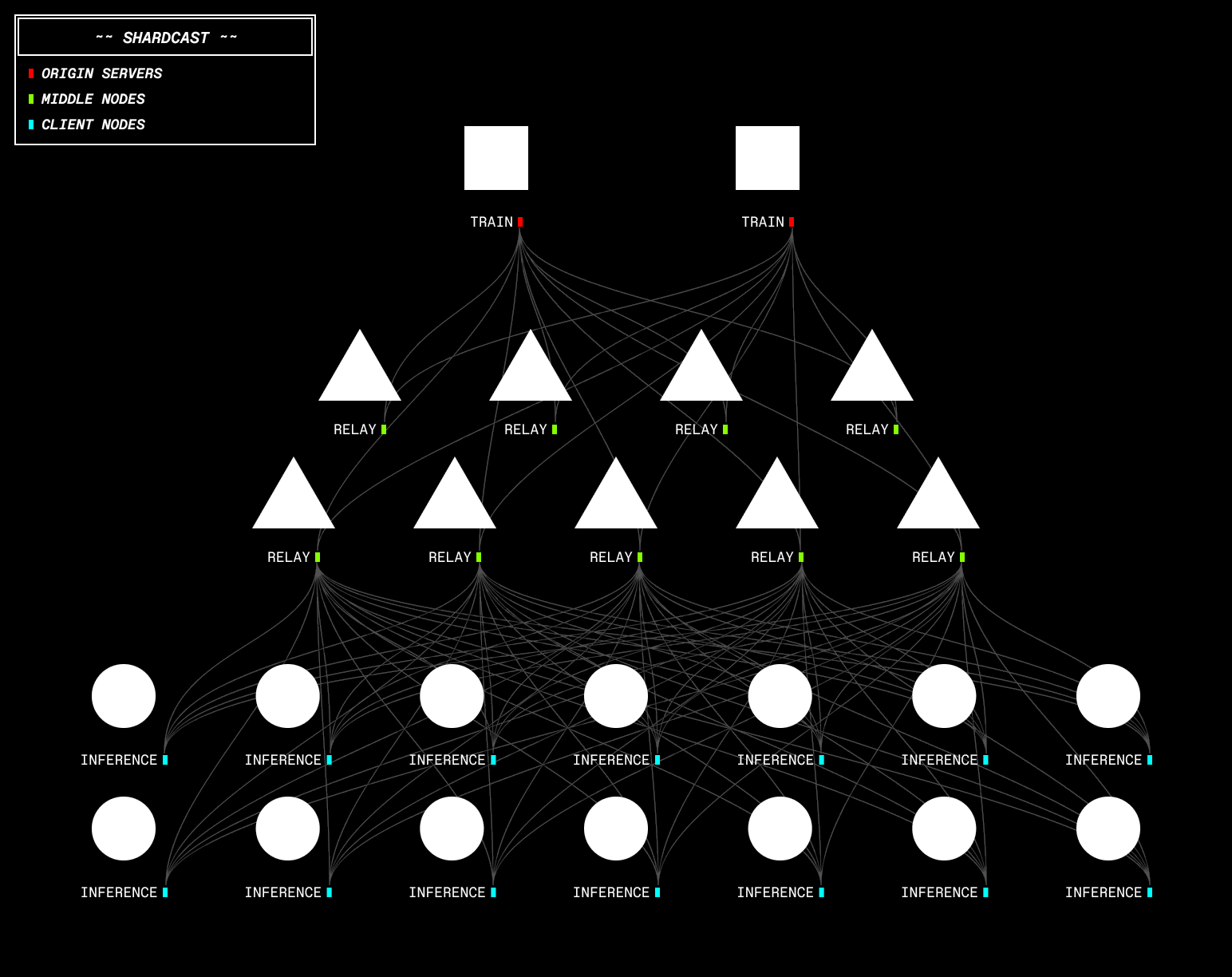

SHARDCAST: Библиотека для распространения больших файлов по HTTP, с древовидной топологией сети, которая эффективно передает обновленные веса модели всем децентрализованным инференс-воркерам

TOPLOC:

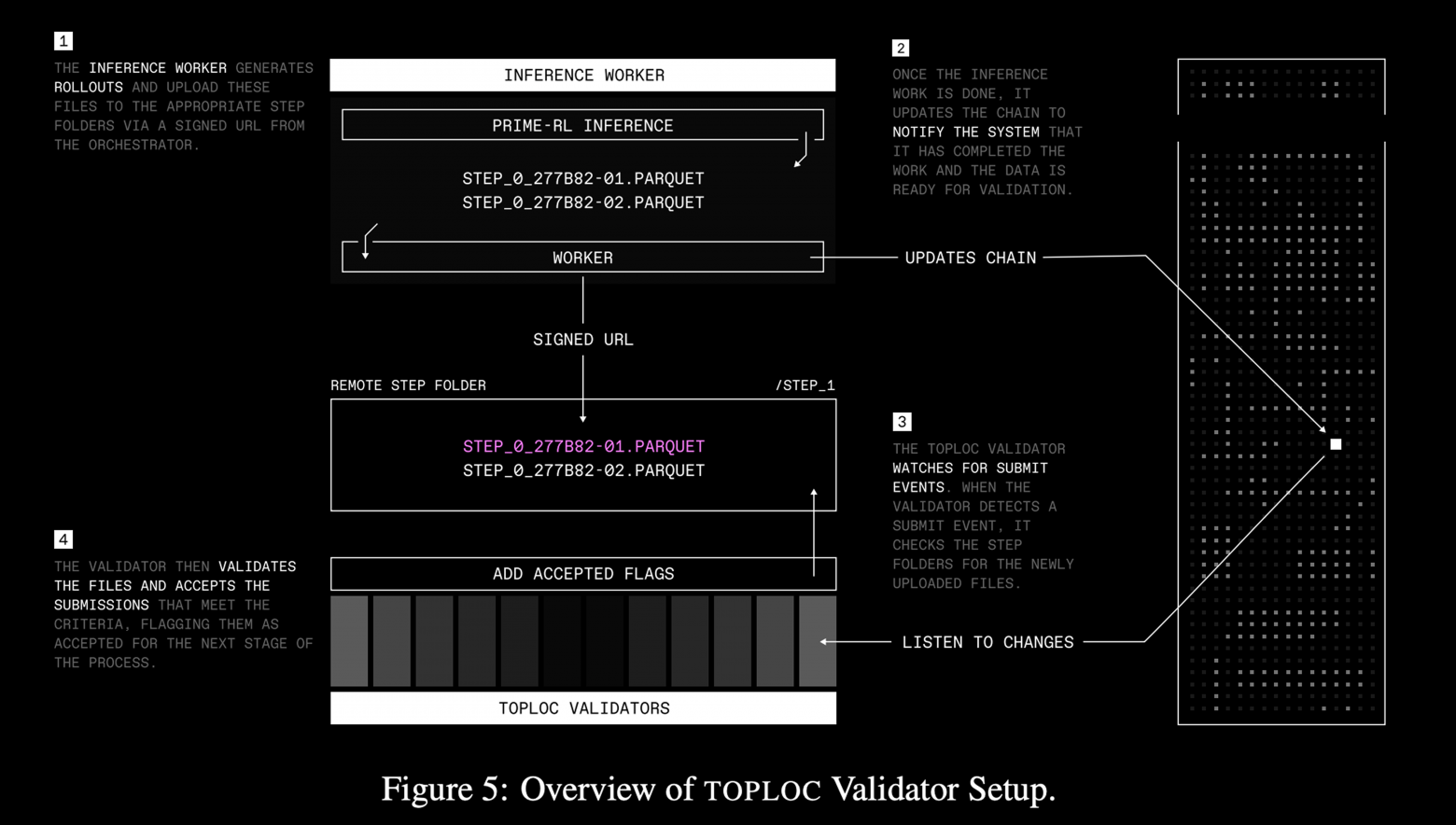

– Схема хеширования с учетом локальности данных, которая позволяет делать эффективный и верифицируемый инференс

– Обнаруживает подмену данных или изменение точности в инференсе модели и надежно работает на неизвестном GPU-железе

– Инференс-воркеры генерируют роллауты. Эти файлы загружаются через подписанные URL, события в чейне запускают валидаторы TOPLOC для их проверки; успешно проверенные файлы поступают в трейнер, а при обнаруждении попытки обмана — соответствующий узел выбрасывается из пула вычислителей

Protocol Testnet: [12]

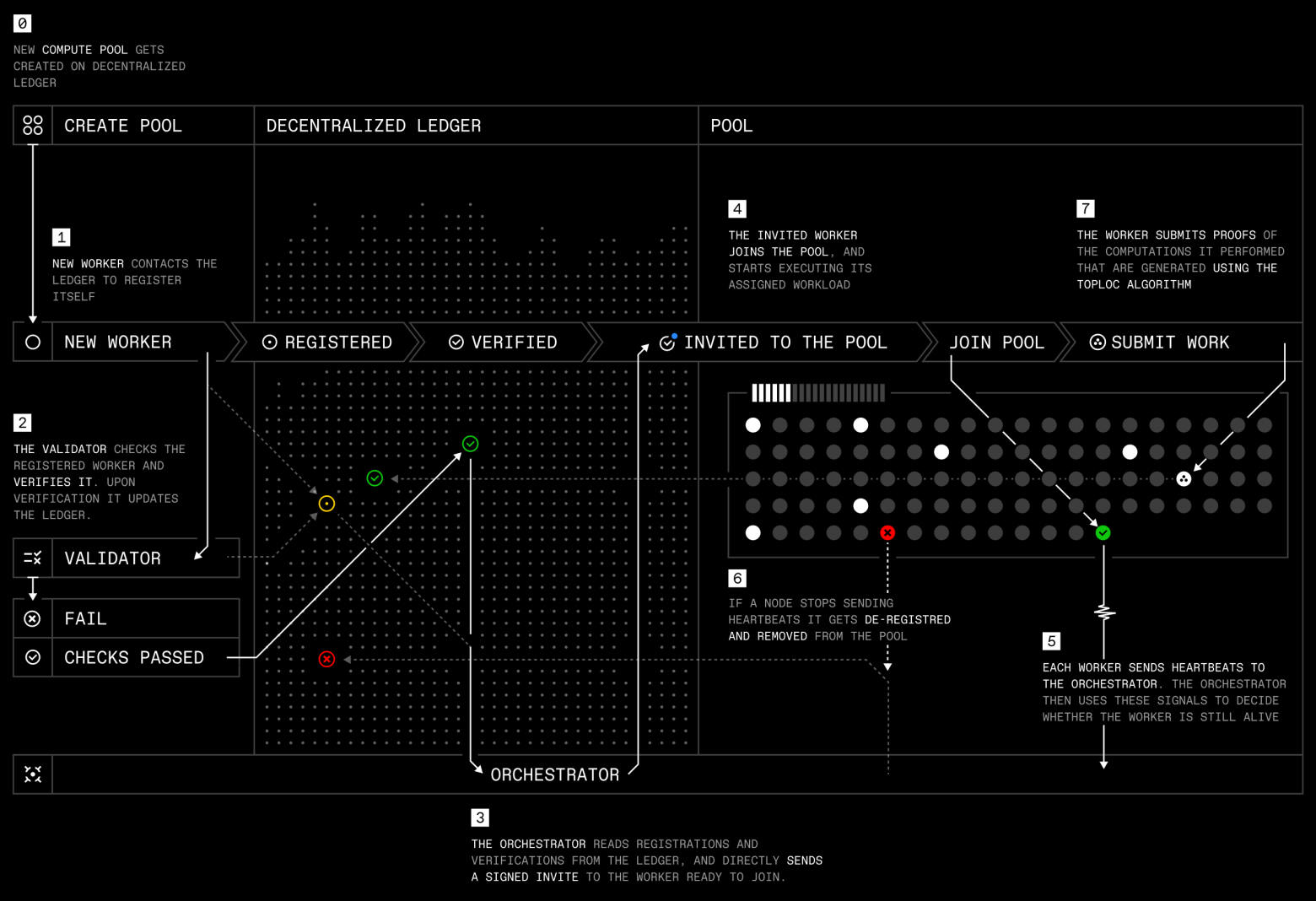

– Предоставляет инфраструктуру для агрегации и координации глобальных вычислительных ресурсов

– Оркестратор на Rust и сервис обнаружения координируют воркеры, которым не нужно дополнительных доступов — ноды автоматически регистрируются, оборудование проверяется, ноды начинают отправлять хартбиты и запрашивают задачи в Docker-контейнерах. В это же время, оркестратор распределяет рабочие нагрузки, отслеживает “здоровье” системы, управляет доступами до пула и фиксирует вклад каждого участника.

Протокол обучения

Тренировочные данные и подкрепление:

– 285k верифицируемых задач (математика [13] и кодинг) из NuminaMath-1.5, Deepscaler и SYNTHETIC-1 [11]

– Бинарное подкрепление за задачу + награда за длину позволяет пользователям распределять thinking tokens во время инференса

– Двухэтапный асинхронный RL: рассылка новых проверочных весов полностью сочетается с идущим параллельно инференсом и обучением — так устраняется бутылочное горлышко в общении компонентов.

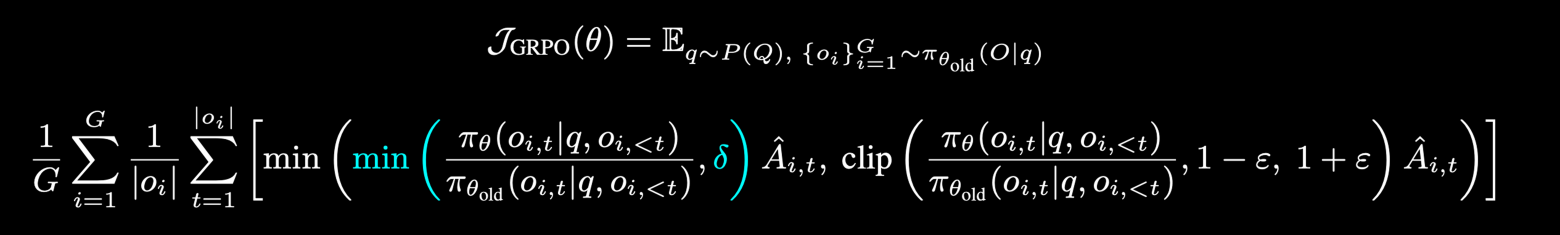

Двустороннее клиппирование GRPO: Стабилизирует обучение, смягчает пики градиентов с помощью двустороннего клиппирования отношения вероятностей

Продвинутая фильтрация данных: Комбинирует офлайн и онлайн-фильтрацию, что позволяет выбирать достаточной сложности задачи, и значительно повышает эффективность обучения модели

Агрессивное клиппирование градиентов: Решает проблему расширения норм градиентов при масштабировании, что положительно сказывается на стабильности обучения

Эксперименты

Исследование проводилась на двух основных экспериментах:

– TARGET-SHORT: экспериментальный запуск на материале с небольшими длинами (для получения эффетивного ризонинга)

– TARGET-LONG: основной прогон теста, с большими длинами

Утилизация вычислительных ресурсов: В ходе экспериментов, удалось совместить коммуникацию с вычислениями, используя двухэтапное асинхронное обучение с подкреплением.

Подкрепление:

– На протяжении обучения видно значительное увеличение награды, что указывает на повышение производительности модели в решении математических задач и задач по кодингу

– Зафиксировано снижение штрафов за длину. Впрочем, значительно медленнее, чем во время других абляционных экспериментов

Производительность на бенчмарках: Удалось статистически значимо повысить производительность QwQ-32B на математических бенчмарках и бенчмарках по кодингу.

В целом, поскольку QwQ-32B уже интенсивно обучена с помощью RL, сложно получить какие-то существенные улучшения на бенчмарках, кроме как улучшить результат на тренировочном датасете. Чтобы получить более значительные результаты, вероятно, нужно взять более сильную базовую модель (Qwen3?), более качественные датасеты, или как-то улучшить саму RL-среду.

Что дальше?

INTELLECT-2 — первый шаг к продвинутым, действительно открытым и децентрализованно обученным рассуждающим моделям. В ближайшие месяцы у команды разработчиков в планах:

Увеличение соотношения инференса к тренировочным вычислениям

– Инференс идеально параллелится и не требует коммуникации. Сложная и мощная (в смысле количества флопсов на инференс) RL-среда естественным образом подходят для децентрализованного обучения

Tool Calls & Multi-Turn RL

-

Для полномасштабного inference-time compute в научных и исследовательских целях нужно дать моделям встроенные инструменты для ризонинга — веб-поиск, интерпретаторы Python и т.д.

Краудсорсинг RL-задач и сред

-

Опенсорс имеет уникальное преимущество. Распределенный RL все еще очень новая штука, многое всё ещё предстоит разработать. Но с правильным комьюнити и возможностью сообщества совместно достигать большие цели, опенсорсный ИИ всё ещё может обогнать закрытые лаборатории

Мерджинг моделей и DiLoCo

-

Объединение независимо обученных RL-моделей — либо в конце цепочки, либо непрерывно через DiLoCo [14]— для создания единой унифицированной модели. Нужно масштабировать децентрализованный RL на гораздо больший объем вычислений

Все подробности есть в техническом отчете [15].

Присоединяйтесь!

Команда INTELLECT-2 работает над децентрализованным RL. Текущий фокус разработки направлен на ризонинг, инструменты, краудсорсинг высококачественных данных, оптимизацию инфраструктуры и протокола обучения.

Проект открыт для сотрудничества со всеми, кто заинтересован в совместном создании опенсорсного и децентрализованного AGI.

Автор: olegchir

Источник [16]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/15193

URLs in this post:

[1] обучения: http://www.braintools.ru/article/5125

[2] подкреплением: http://www.braintools.ru/article/5528

[3] primeintellect.ai/intellect-2: http://primeintellect.ai/intellect-2

[4] chat.primeintellect.ai: http://chat.primeintellect.ai

[5] Hugging Face: https://huggingface.co/collections/PrimeIntellect/intellect-2-68205b03343a82eabc802dc2

[6] лежит на GitHub: https://github.com/PrimeIntellect-ai/prime-rl

[7] @1red2black: https://t.me/tg_1red2black

[8] FSDP2: https://docs.pytorch.org/docs/stable/distributed.fsdp.fully_shard.html

[9] vLLM: https://github.com/vllm-project/vllm

[10] GENESYS: https://github.com/PrimeIntellect-ai/genesys

[11] SYNTHETIC-1: https://www.primeintellect.ai/blog/synthetic-1-release

[12] Protocol Testnet:: https://github.com/PrimeIntellect-ai/pi-protocol

[13] математика: http://www.braintools.ru/article/7620

[14] DiLoCo : https://github.com/PrimeIntellect-ai/OpenDiloco

[15] в техническом отчете: https://primeintellect.ai/intellect-2

[16] Источник: https://habr.com/ru/companies/bar/articles/909432/?utm_campaign=909432&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.