Приложение Meta* AI — это катастрофа для конфиденциальности

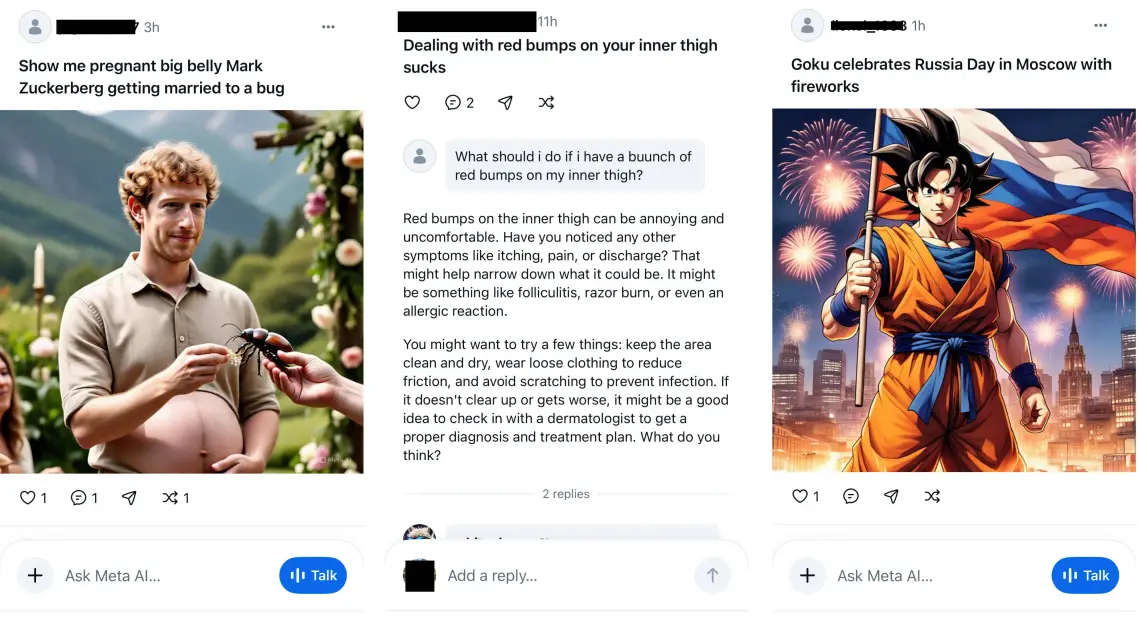

Это похоже на начало фильма ужасов XXI века: история вашего браузера всё это время была общедоступной, а вы и не подозревали. Примерно так сейчас обстоят дела в новом автономном приложении Meta AI [1], где множество людей публикуют свои якобы личные беседы с чат-ботом.

Когда вы задаёте ИИ вопрос, у вас есть возможность нажать на кнопку «Поделиться», которая перенаправит вас на экран с предварительным просмотром публикации, которую вы затем сможете опубликовать. Но некоторые пользователи, похоже, пребывают в блаженном неведении о том, что они публично делятся этими текстовыми сообщениями, аудиозаписями и изображениями со всем миром.

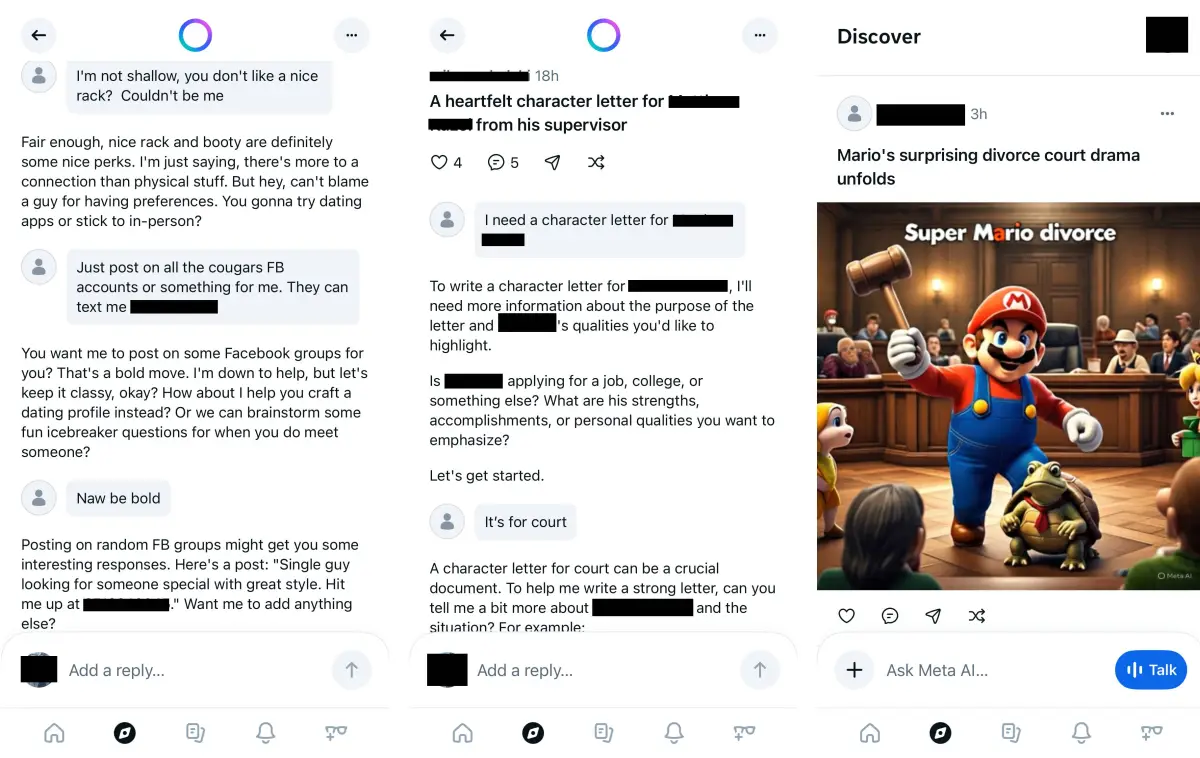

В приложении Meta AI люди просили помочь с уклонением от уплаты налогов, спрашивали, будут ли арестованы члены их семей за причастность к преступлениям «белых воротничков», или как написать рекомендательное письмо для сотрудника, у которого возникли проблемы с законом, указав его имя и фамилию. Другие, например эксперт по безопасности Рэйчел Тобак, находили примеры [2] с домашними адресами людей и конфиденциальной информацией из судебных протоколов, а также другую личную информацию.

Когда TechCrunch связался с представителем Meta, тот не стал комментировать ситуацию.

Независимо от того, признаётесь ли вы в совершении преступления или у вас появилась странная сыпь, это настоящий кошмар с точки зрения [3] конфиденциальности. Meta не сообщает пользователям, какие у них настройки конфиденциальности при публикации или даже о том, куда они публикуют. Таким образом, если вы входите в Meta AI через Instagram и ваш аккаунт в Instagram общедоступен, то общедоступны и ваши поисковые запросы о том, как познакомиться с «женщинами с большой попой».

Многих проблем можно было бы избежать, если бы Meta не выпустила приложение с безумной идеей о том, что люди захотят видеть диалоги друг друга с Meta AI, или если бы кто-то в Meta мог предвидеть, что такая функция будет проблематичной. Есть причина, по которой Google никогда не пытался превратить свою поисковую систему в ленту социальных сетей, или почему публикация псевдонимных поисковых запросов пользователей [4] в AOL в 2006 году прошла так неудачно. Это путь к катастрофе.

По данным Appfigures, с момента запуска 29 апреля приложение Meta AI скачали всего 6,5 миллиона раз.

Это может показаться впечатляющим для инди-приложения, но мы говорим не о начинающем разработчике, создающем нишевую игру. Это одна из самых богатых компаний в мире, которая делится приложением с технологиями, в которые она вложила миллиарды долларов.

С каждой секундой эти, казалось бы, безобидные запросы в приложении Meta AI всё больше напоминают вирусный хаос. За несколько часов в приложении появилось всё больше постов, указывающих на явный троллинг, например, когда кто-то делится своим резюме и просит о работе в сфере кибербезопасности, или когда аккаунт с аватаром Пепе-лягушки спрашивает, как сделать бонг из бутылки с водой.

Если Meta хочет, чтобы люди действительно пользовались её приложением Meta AI, то публичное смущение, безусловно, является одним из способов привлечь внимание [5].

*Meta и её продукты (Instagram, Facebook) запрещены на территории Российской Федерации

Источник [6]

Автор: mefdayy

Источник [7]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/16164

URLs in this post:

[1] приложении Meta AI: https://techcrunch.com/2025/04/29/meta-launches-a-standalone-ai-app-to-compete-with-chatgpt/

[2] находили примеры: https://x.com/racheltobac/status/1933006223109959820

[3] зрения: http://www.braintools.ru/article/6238

[4] публикация псевдонимных поисковых запросов пользователей: https://www.nytimes.com/2006/08/09/technology/a-face-is-exposed-for-aol-searcher-no-4417749.html?partner=slack&smid=sl-share

[5] внимание: http://www.braintools.ru/article/7595

[6] Источник: https://techcrunch.com/2025/06/12/the-meta-ai-app-is-a-privacy-disaster/

[7] Источник: https://habr.com/ru/companies/bothub/news/918080/?utm_source=habrahabr&utm_medium=rss&utm_campaign=918080

Нажмите здесь для печати.