Китайские учёные: ИИ способен формировать представления об объектах, сходные с человеческими

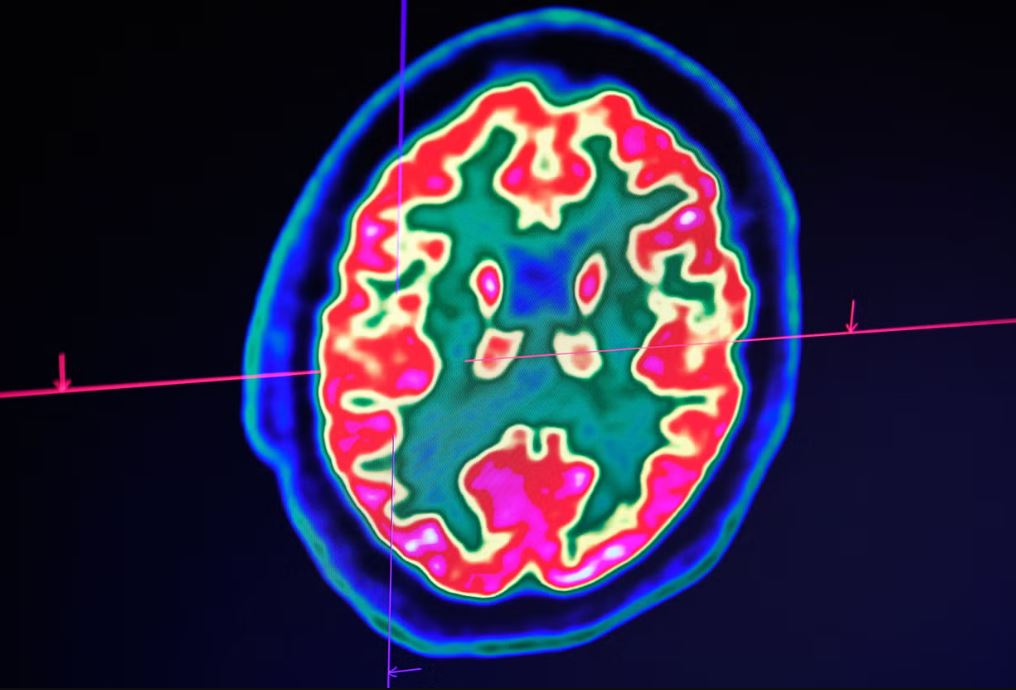

Китайские исследователи обнаружили [1] первое в истории доказательство того, что модели ИИ, такие как ChatGPT, обрабатывают информацию подобно человеческому мозгу [2]. Они подробно описали [3] это открытие в журнале Nature Machine Intelligence.

«Это дает убедительные доказательства того, что представления объектов в LLM (больших языковых моделях), хотя и не идентичны человеческим, имеют фундаментальные сходства, которые отражают ключевые аспекты человеческих концептуальных знаний», — написала группа, стоящая за исследованием. Над ним работали Китайская академия наук и Южно-Китайский технологический университет.

Как сообщается, группа хотела проверить, могут ли модели LLM «создавать человекоподобные представления объектов из лингвистических и мультимодальных данных (данных в разных формах, таких как текст, аудио и т. д.)». Чтобы выяснить, отражает ли процесс работы ИИ наше познание, исследователи заставили OpenAI ChatGPT-3.5 и Google Gemini Pro Vision пройти серию испытаний «лишнего», в которых им давали три элемента и ставили задачу выбрать тот, который не подходит.

Примечательно, что ИИ создал 66 концептуальных измерений для сортировки объектов. Сравнив эту кибернетическую сортировку объектов с человеческим анализом тех же объектов, учёные обнаружили поразительное сходство между «восприятием» моделей и человеческим — особенно, когда дело касается языковой группировки.

Из этого исследователи сделали вывод, что LLM «развивают человекоподобные концептуальные представления объектов».

«Дальнейший анализ показал сильное соответствие между встраиванием моделей и паттернами нейронной активности» в области мозга, связанной с памятью [4] и распознаванием сцен, заметили они.

Исследователи отметили, что LLM немного не дотягивают в отношении категоризации визуальных аспектов, таких как форма или пространственные свойства.

Также они показали, что ИИ с трудом справляется с задачами, требующими более глубоких уровней человеческого познания, такими как аналоговое мышление [5] — проведение сравнений между различными вещами. При этом неясно, понимают ли они значимость или эмоциональную ценность определённых объектов. «Современный ИИ может различать изображения кошек и собак, но существенная разница между этим “распознаванием” и человеческим “пониманием” кошек и собак ещё не раскрыта», — сказал Хэ Хуэйгуан, профессор Института автоматизации Китайской академии наук.

Тем не менее, учёные надеются, что эти результаты позволят им разработать «более человекоподобные искусственные когнитивные системы», которые смогут лучше взаимодействовать с людьми.

Ранее исследователи из Китая выяснили [6], что две популярные большие языковые модели могут клонировать себя, а затем программировать копии выполнять те же задачи, делая цикл репликации бесконечным. В ходе десятка испытаний две модели ИИ создали функционирующие копии самих себя в 50% и 90% случаев соответственно. Это позволило учёным предположить, что ИИ уже способен выходить из-под контроля.

Автор: maybe_elf

Источник [7]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/16477

URLs in this post:

[1] обнаружили: https://www.the-independent.com/tech/ai-think-humans-chatgpt-china-b2770678.html

[2] мозгу: http://www.braintools.ru/parts-of-the-brain

[3] описали: https://www.nature.com/articles/s42256-025-01049-z

[4] памятью: http://www.braintools.ru/article/4140

[5] мышление: http://www.braintools.ru/thinking

[6] выяснили: https://habr.com/ru/news/881658/

[7] Источник: https://habr.com/ru/news/920534/?utm_source=habrahabr&utm_medium=rss&utm_campaign=920534

Нажмите здесь для печати.