Кто, как и зачем внедряет Gen AI в 2025: опыт 100 CIO

Чуть больше года назад мы выделили 16 ключевых изменений в том, как компании подходили к разработке и закупке генеративных ИИ. С тех пор ландшафт продолжил стремительно эволюционировать, поэтому мы снова провели беседы с более чем двумя десятками корпоративных заказчиков и опросили 100 CIO из 15 отраслей, чтобы помочь фаундерам понять, как в 2025 в корпорациях используют, приобретают и закладывают бюджеты под generative AI.

Даже в такой динамичной сфере, где единственная постоянная — это перемены, структура рынка genAI изменилась куда сильнее, чем мы ожидали после прошлого исследования.

-

Бюджеты на AI в enterprise-сегменте превысили даже самые амбициозные прогнозы — технологии вышли за рамки пилотных проектов и инновационных фондов, став постоянными статьями расходов в IT и бизнес-юнитах.

-

Компании стали гораздо более зрелыми в использовании мультимодельных стеков, оптимизируя выбор по соотношению производительности и стоимости. По результатам опроса, OpenAI, Google и Anthropic удерживают лидирующие позиции в общем объеме использования, тогда как Meta и Mistral доминируют среди open source-решений.

-

Закупочные процессы всё больше напоминают традиционные софтверные сделки — с жёсткими этапами оценки, учетом инфраструктурных требований и акцентом на бенчмарки. При этом усложнение AI-воркфлоу повышает стоимость переключения.

-

Параллельно произошло созревание рынка AI-приложений: готовые решения вытесняют кастомную разработку, а сторонние AI-native продукты получают всё больше признания.

Чтобы дать фаундерам более точную картину того, что сегодня действительно важно для корпоративных заказчиков, мы в деталях разберем изменения в подходах к ресурсам, моделям, закупкам и прикладному использованию Gen AI.

Бюджеты: расходы на AI превзошли даже самые смелые ожидания — и это надолго

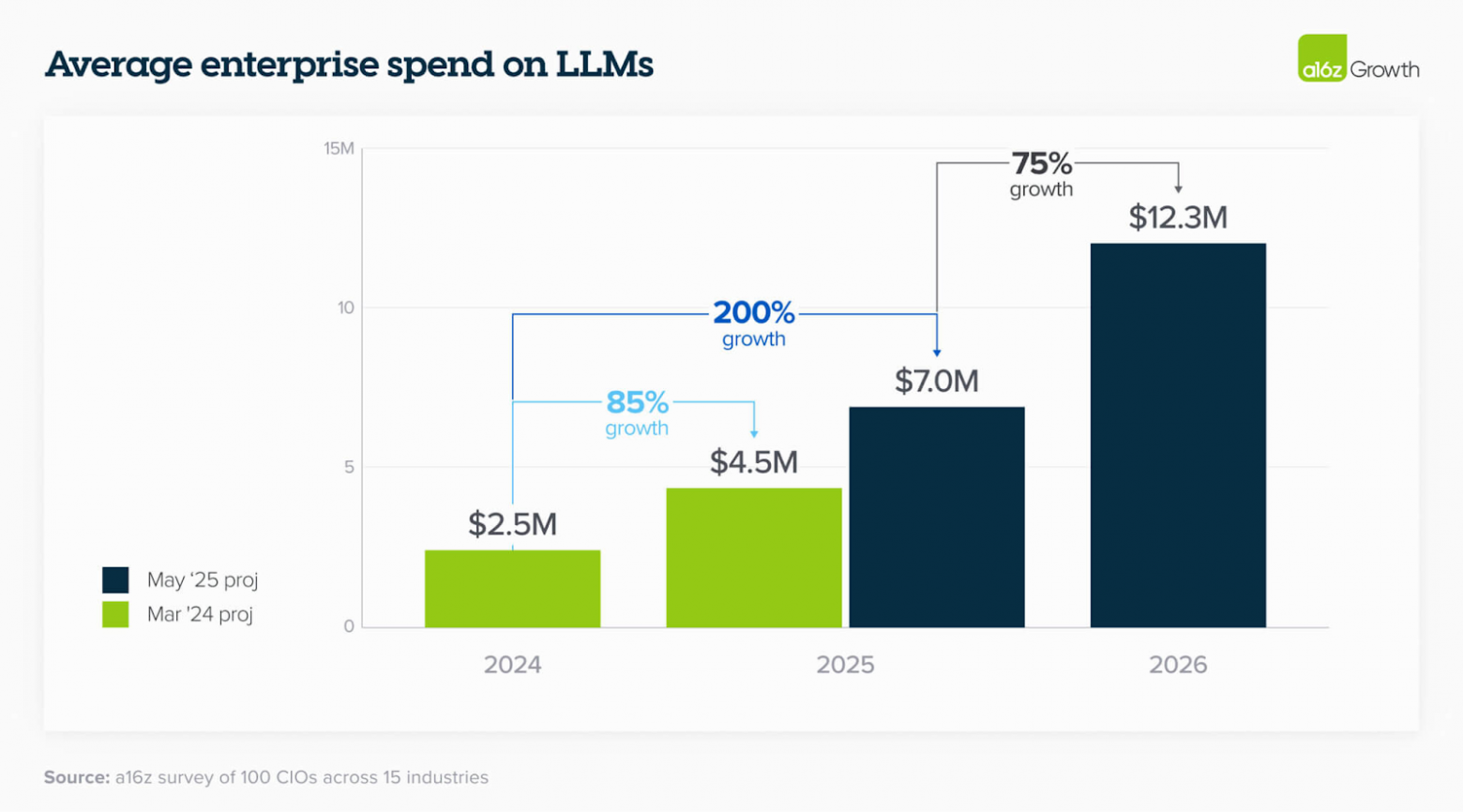

1. Бюджеты оказались больше, чем ожидалось, и продолжают расти

Бюджеты на LLM выросли гораздо быстрее, чем изначально прогнозировали сами компании — причем рост не демонстрирует признаков замедления. По ожиданиям руководителей компаний, в ближайший год траты увеличатся в среднем на 75%. Как отметил один из CIO: «то, что я тратил за весь 2023 год, теперь уходит за неделю».

Рост затрат обусловлен, с одной стороны, выявлением всё большего количества релевантных внутренних use case’ов и ростом вовлеченности сотрудников, а с другой — постепенным расширением во внешние сценарии, особенно в технологичных компаниях. Эти направления могут стать катализатором экспоненциального увеличения расходов. Один из крупных игроков в tech-сегменте признался: «до сих пор мы в основном фокусировались на внутренних задачах, но в этом году сосредоточимся на customer-facing Gen AI — а там бюджеты будут в разы выше».

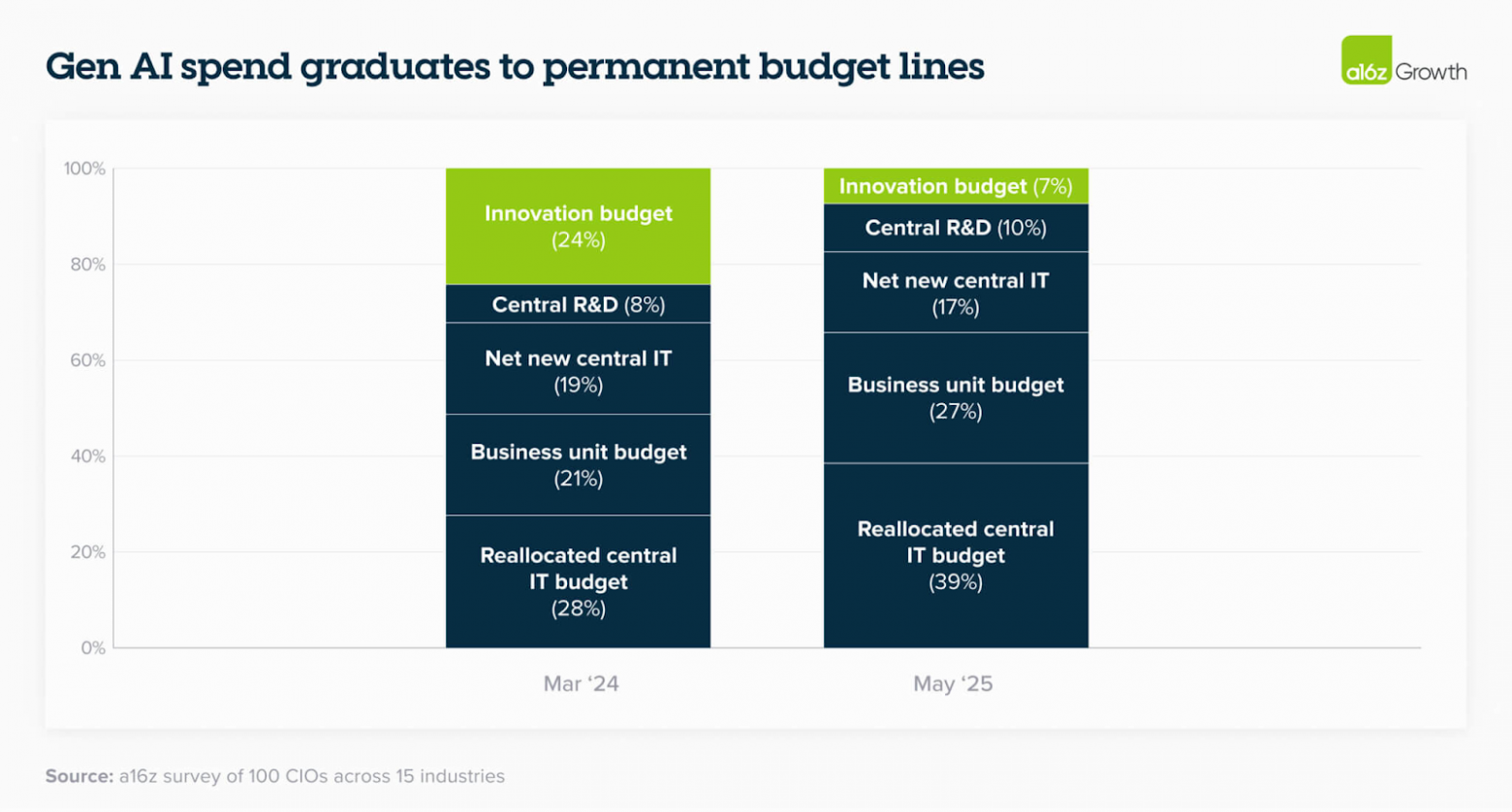

2. Расходы на Gen AI переходят в разряд постоянных бюджетных статей

В прошлом году около четверти всех затрат на LLM покрывались за счет бюджетов на инновации — теперь эта доля сократилась до всего 7%. Всё больше компаний финансируют модели и AI-приложения напрямую из централизованных IT-бюджетов и бюджетов бизнес-юнитов, что отражает изменившееся восприятие [1] gen AI: это больше не эксперимент, а стратегически важная часть операционной деятельности.

Как отметил один CTO: «всё больше наших продуктов получают AI-функциональность, и, соответственно, рост расходов затронет каждое из этих направлений» — что говорит о дальнейшем смещении расходов в сторону core-бюджетов и устойчивом укоренении gen AI в структуре корпоративных инвестиций.

Модели: три лидера формируются на фоне всё более выраженной дифференциации по use case’ам — что стимулирует мультимодельную стратегию

3. Мультимодельный мир закрепляется, а ключевым драйвером становится дифференциация, а не коммодитизация

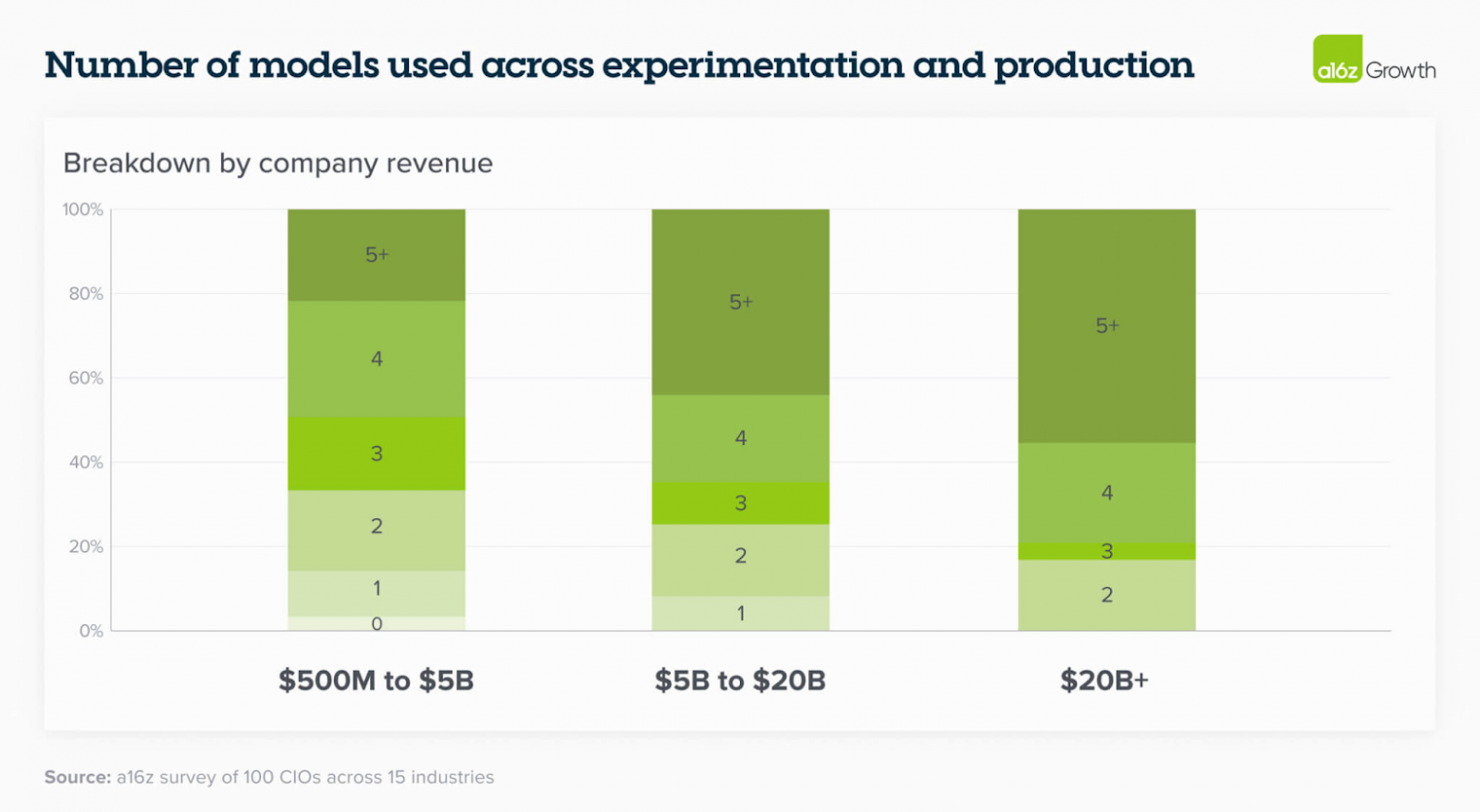

С появлением нескольких высококачественных LLM стало нормой запускать сразу несколько моделей в продакшн-сценариях. Хотя стремление избежать vendor lock-in остаётся актуальным, главным фактором, по которому компании выбирают модели от разных вендоров, становится именно функциональная дифференциация под конкретные use case’ы.

В этом году 37% респондентов сообщили, что используют 5 и более моделей, по сравнению результатом в 29% год назад.

Хотя по результатам общих бенчмарков некоторые модели могут выглядеть схожими по качеству, на уровне enterprise-использования речь о коммодитизации пока не идёт. Так, например, модели Anthropic давно известны своей эффективностью в задачах, связанных с программированием [2] — но в действительности ситуация тоньше. Некоторые пользователи отмечают, что Claude лучше справляется с точной автодополнением кода, тогда как Gemini показывает лучшие результаты при проектировании архитектур и систем на более высоком уровне.

В других доменах — например, в текстовых задачах — один клиент заметил: «Anthropic чуть лучше в задачах на генерацию — языковая плавность, написание контента, мозговые штурмы; тогда как модели OpenAI лучше справляются с комплексными вопросами и ответами». Эти различия закрепили практику использования нескольких моделей одновременно, и мы ожидаем, что такая стратегия сохранится: компании продолжают выстраивать стек под нужную производительность, оставаясь при этом максимально независимыми от конкретных поставщиков.

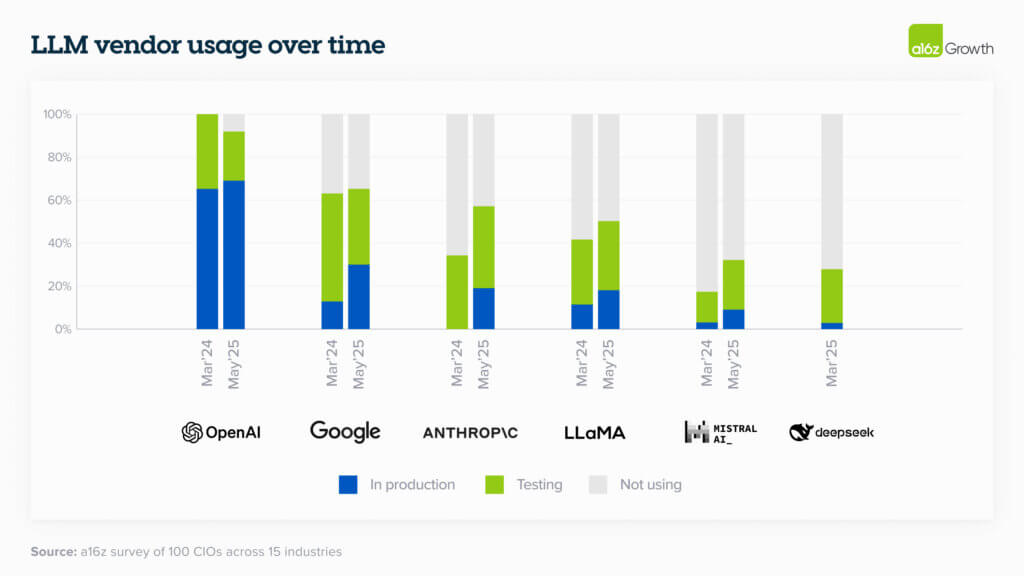

4. Ландшафт моделей перенасыщен, но лидеры уже чётко вырисовываются

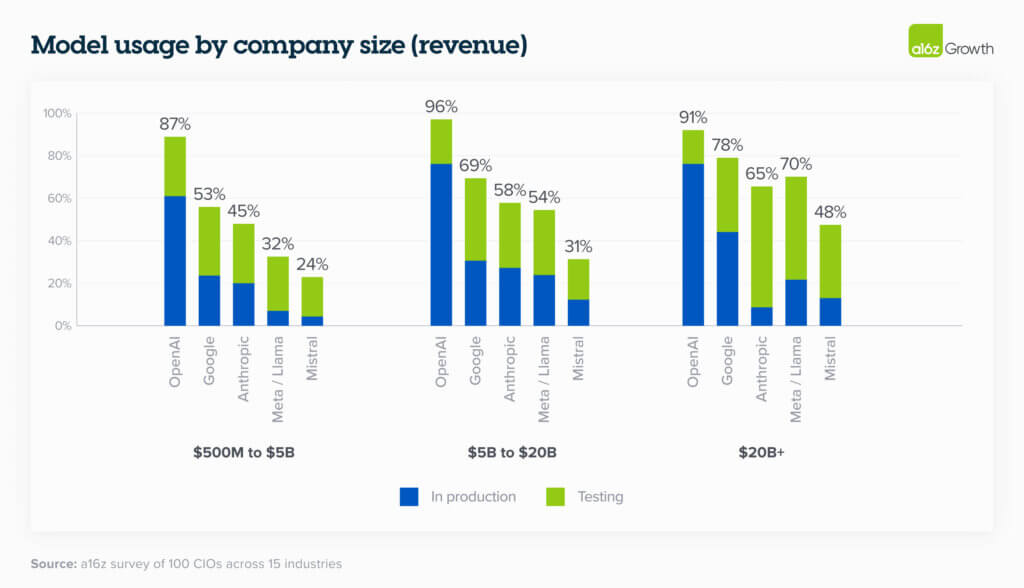

Несмотря на то, что компании продолжают использовать разные модели как в экспериментальных, так и в продакшн-сценариях (см. выше), в общем объеме использования начали уверенно доминировать несколько игроков. OpenAI сохраняет лидерство [3] по доле рынка, а Google и Anthropic за последний год заметно усилили свои позиции.

Распределение долей варьируется в зависимости от размера компании: среди крупных предприятий выше уровень использования open source-моделей, особенно в случаях, когда важны on-prem решения.

Если углубиться в практику использования:

-

OpenAI:

Компании используют широкий спектр моделей OpenAI. В продакшне чаще всего развёрнут GPT-4o, в то время как OpenAI o3 вызывает высокий интерес [4] как reasoning-ориентированная модель, всё чаще внедряемая в реальные workflows. OpenAI также лидирует по использованию non-frontier моделей (т.е. не самых топовых в линейке): 67% пользователей OpenAI используют такие модели в продакшне, по сравнению с 41% у Google и лишь 27% у Anthropic. Это указывает на глубину интеграции OpenAI в enterprise-стек. -

Google:

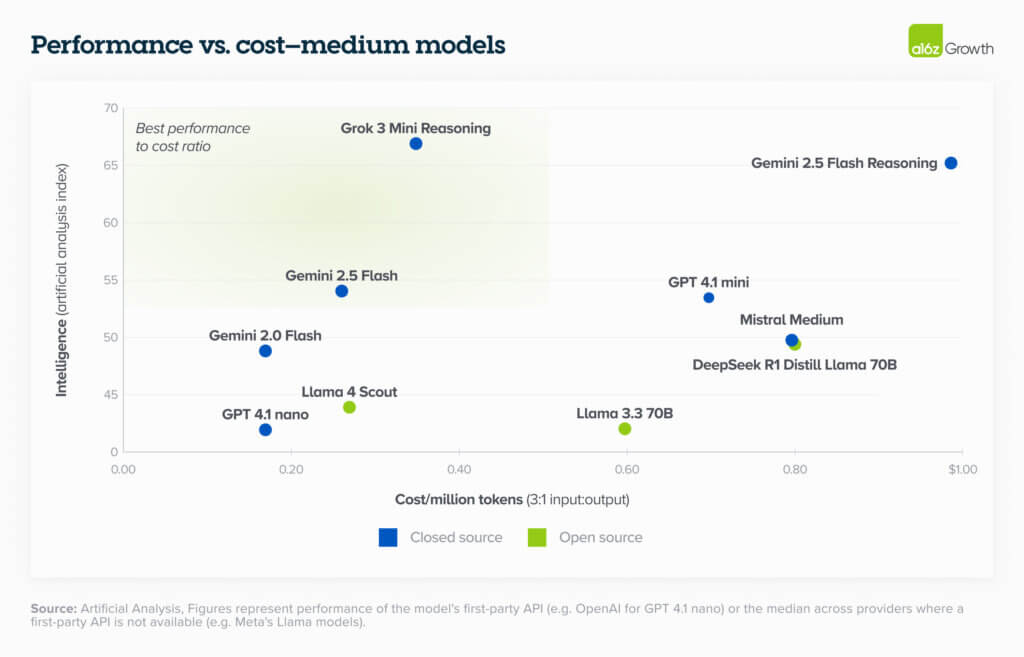

Быстрее всего растущий игрок в сегменте крупных компаний, что связано с существующими контрактами на GCP и высоким уровнем доверия к бренду. Модели Gemini давно известны за счет лучших на рынке контекстных окон, но именно Gemini 2.5 поднял их в категорию полноценных frontier-моделей. Еще один важный фактор, способствующий закреплению Google в enterprise — соотношение производительность/стоимость. Например, при сопоставимом уровне интеллекта [5] Gemini 2.5 Flash стоит $0.26 за миллион токенов, тогда как GPT-4.1 Mini — $0.70. -

Anthropic:

Максимально востребован среди технологически продвинутых компаний, особенно в software-секторе и стартапах. Модели Claude показывают отличные результаты в задачах программирования и стали основой для быстрорастущих AI-продуктов в кодинге. Благодаря такому фокусу на конкретные use case’ы, Anthropic стал предпочтительным выбором в инженерных задачах. Этот use case-ориентированный подход укрепил позиции Anthropic и среди более традиционных корпоративных клиентов, обеспечив как выручку, так и узнаваемость бренда. -

Open source (Llama, Mistral):

Чаще применяются в крупных компаниях, где актуален on-prem по соображениям безопасности, соответствия требованиям (compliance) и необходимости глубокой кастомизации через fine-tuning. Именно крупный enterprise активнее инвестирует в поддержку open source-моделей, как с точки зрения [6] хостинга, так и встраивания в сложные пайплайны. -

Новые игроки (например, xAI):

Показывают высокий интерес и проходят ранние этапы тестирования, что напоминает поведение [7] рынка год назад. Это подчёркивает: распределение долей в этом сегменте остается динамичным и ещё далека от стабильности.

5. Соотношение цена/качество у закрытых моделей стало особенно привлекательным для non-frontier решений

Как уже отмечалось ранее, стоимость моделей снижается на порядок примерно раз в 12 месяцев. На этом фоне соотношение цена/производительность у закрытых моделей малой и средней категории стало значительно более убедительным. Особенно это касается таких моделей, как Grok 3 Mini от xAI и Gemini 2.5 Flash от Google, которые лидируют по этому показателю. В ряде случаев компании всё чаще отдают предпочтение закрытым моделям именно из-за этой экономической эффективности — в дополнение к другим преимуществам экосистемы. Как выразился один из клиентов: «Цены стали действительно привлекательными, а у нас уже вся инфраструктура на Google — от G Suite до баз данных, плюс у них сильная экспертиза в enterprise». А другой и вовсе лаконично: «Gemini — просто дешёвый».

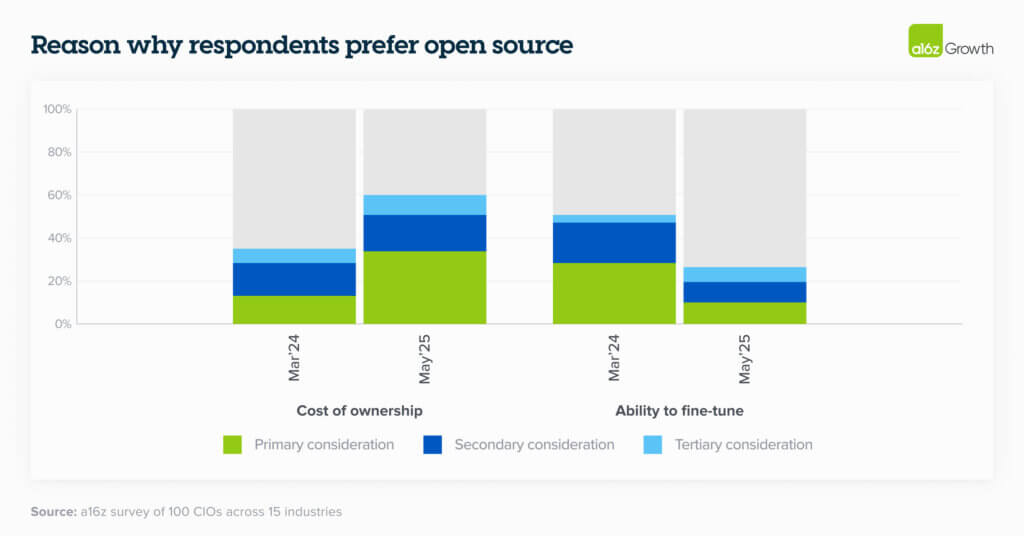

6. Fine-tuning становится менее необходимым по мере роста возможностей моделей

Улучшение возможностей моделей — в первую очередь повышение общего уровня интеллекта и увеличение длины контекстного окна — сделало fine-tuning менее критичным для достижения высокой производительности в конкретном use case’е. Вместо этого компании всё чаще обнаруживают, что prompt engineering способен давать сопоставимые или даже лучшие результаты — зачастую при значительно меньших затратах. Как отметили в одной из компаний: «вместо того чтобы брать обучающую выборку и делать параметрически эффективный fine-tuning, просто кладёшь всё это в длинный контекст — и получаешь почти тот же результат».

Отказ от fine-tuning также помогает избежать vendor lock-in, поскольку тюнинг требует значительных начальных затрат и инженерных усилий, в то время как prompt’ы гораздо проще переносить между моделями. Это особенно важно в условиях стремительного прогресса в области моделей — компании хотят оставаться на передовом рубеже, сохраняя при этом гибкость.

Тем не менее, компании с узкоспециализированными задачами продолжают использовать fine-tuning. Например, один стриминговый сервис тюнингует open source-модели для query augmentation в видеопоиске, «где требуется более глубокая адаптация под предметную область». Также не исключен новый виток интереса к fine-tuning, если методы вроде reinforcement fine tuning выйдут за рамки лабораторий и получат широкое практическое применение.

7. Компании оптимистично настроены в отношении reasoning-моделей и готовы к масштабированию

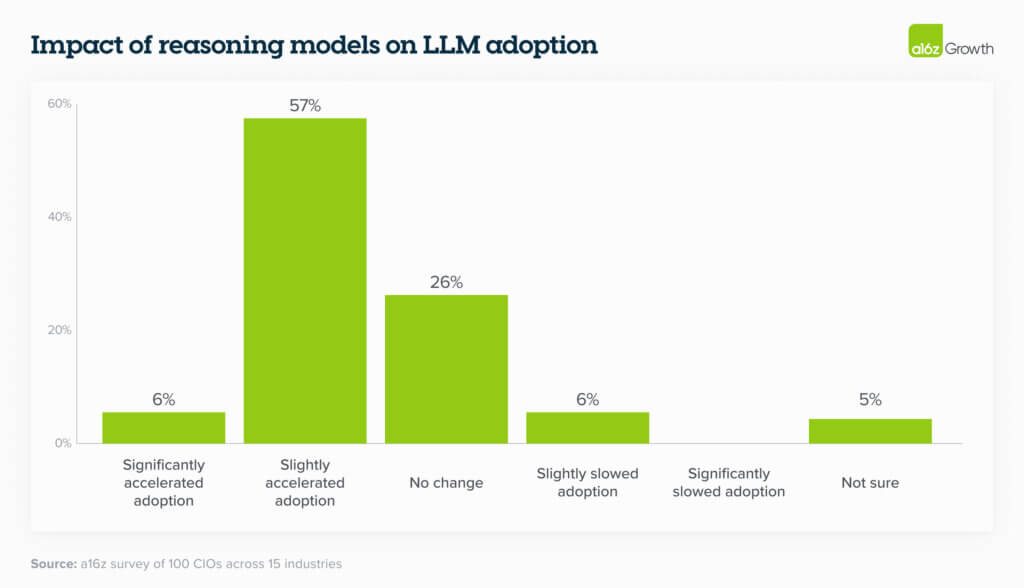

Reasoning-модели расширили спектр задач, которые LLM способны решать, — благодаря способности выполнять более сложные операции с большей точностью. Хотя предприятия находятся на ранней стадии тестирования reasoning-моделей, отношение к ним — крайне позитивное. Один из руководителей выразил это так: «Reasoning-модели позволяют нам решать более сложные и новые задачи, поэтому я ожидаю резкий рост в использовании. Но сейчас мы только тестируем».

Среди ранних пользователей наибольшее распространение получили reasoning-модели от OpenAI. Несмотря на заметный интерес индустрии к DeepSeek, именно OpenAI доминирует в enterprise-сегменте: 23% опрошенных уже используют модель o3 от OpenAI в продакшене, по сравнению с лишь 3% для DeepSeek.

При этом внедрение DeepSeek оказался выше в стартапах, в отличие от слабого проникновения в корпоративный сектор.

Закупки: корпоративная покупка AI всё больше похожа на традиционную закупку ПО

8. Процесс выбора моделей всё больше напоминает классическую закупку enterprise-софта — с чек-листами и чувствительностью к цене

Компании подходят к выбору моделей через чёткие фреймворки оценки. Такие факторы, как безопасность (которую особенно часто упоминали в интервью) и стоимость, начинают занимать не меньшее значение, чем точность и надежность. Этот сдвиг отражает растущее доверие к качеству моделей и уверенность в том, что LLM будут внедряться в масштабах всего предприятия. Как отметил один из руководителей: «Для большинства задач все модели уже работают достаточно хорошо — поэтому цена стала куда более значимым фактором».

Как уже говорилось в разделе «Модели», компании становятся всё более зрелыми в подборе моделей под конкретные use case’ы. Для задач, связанных с высокой видимостью или критичной производительностью, как правило, выбираются модели с сильным брендом и передовыми характеристиками. В то же время для простых или внутренних сценариев решение часто сводится исключительно к цене.

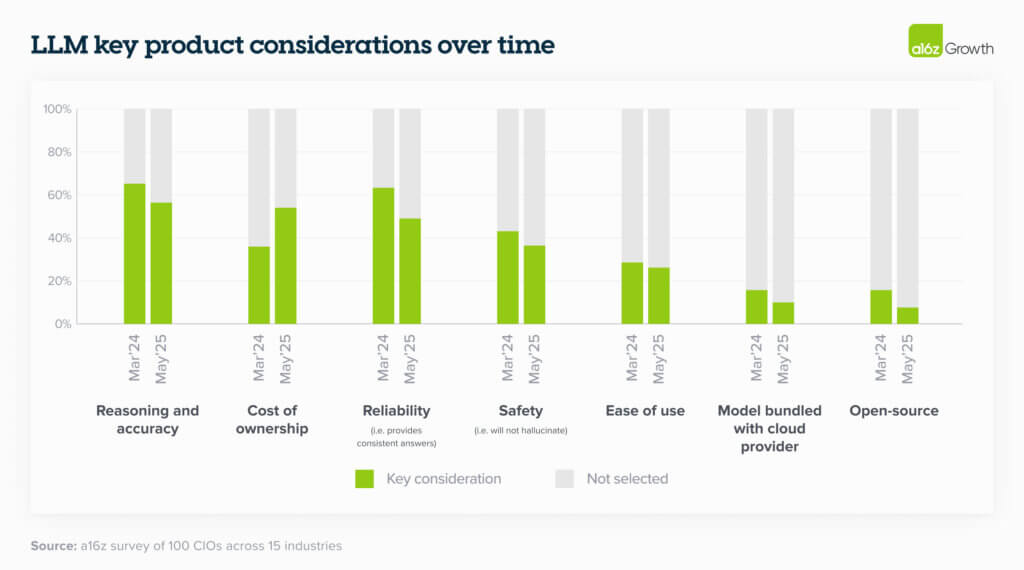

См. ниже, как со временем изменились ключевые критерии закупки LLM (LLM KPCs — key purchasing criteria).

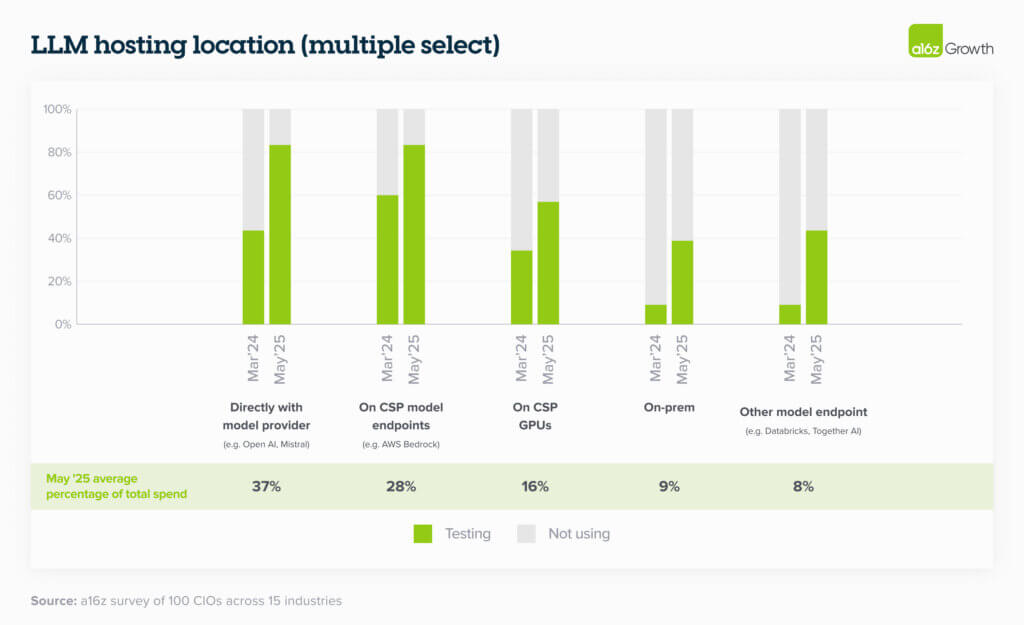

9. Предпочтения по хостингу сильно различаются, но доверие к вендорам моделей за последний год заметно выросло

Хотя многие компании по-прежнему склонны использовать существующие облачные контракты (по аналогии с другими инфраструктурными закупками), всё больше организаций размещают модели напрямую у вендоров или через Databricks — особенно в случаях, когда нужная модель не доступна у их основного облачного провайдера (например, OpenAI — для клиентов AWS).

Обычно это объясняется желанием «получить прямой доступ к самой свежей и производительной модели, как только она становится доступна. Ранние превью-версии тоже важны.»

Рост доверия к прямому размещению у таких вендоров, как OpenAI и Anthropic, — это существенный сдвиг по сравнению с тем, что мы слышали от компаний в прошлом году: тогда большинство предпочитали обращаться к моделям через облако, иногда даже не у основного своего CSP, лишь бы избежать прямой интеграции с модельным провайдером.

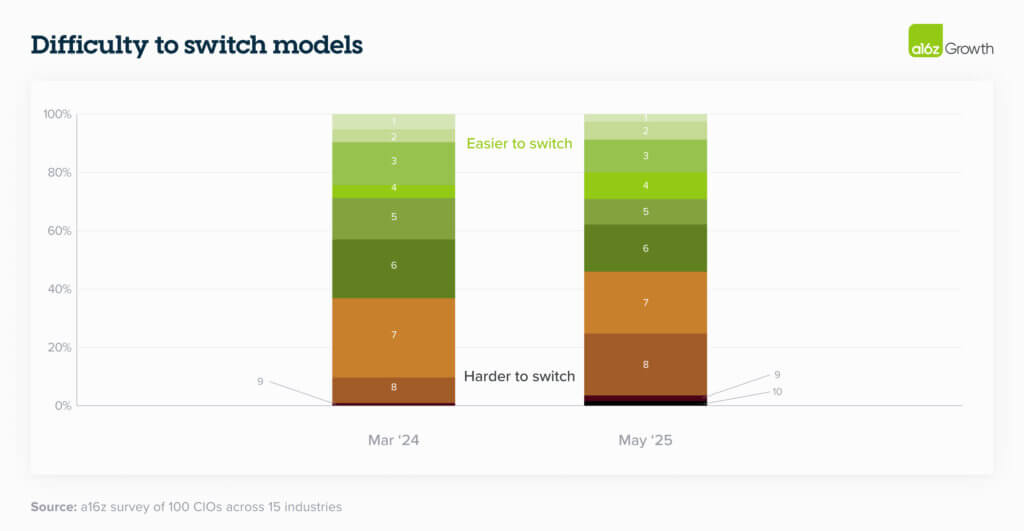

10. Стоимость переключения растёт по мере того, как AI берётся за более сложные задачи

В прошлом году большинство компаний проектировали свои AI-приложения с прицелом на минимальные switching costs и максимальную взаимозаменяемость моделей. В таких условиях модели рассматривались как нечто временное: «пришла — ушла». Это работало для простых one-shot use case’ов, но с ростом агентных воркфлоу ситуация меняется: переключаться между моделями становится значительно сложнее.

По мере того как компании инвестируют ресурсы в разработку guardrails и кастомный prompting под агентные сценарии, они становятся всё более осторожными в вопросе смены модели — особенно если нет уверенности, что новая модель даст сопоставимые результаты или если её нужно будет долго и дорого «допиливать» для обеспечения стабильности. Агентные воркфлоу часто включают многоэтапные процессы, и даже небольшое изменение в логике [8] одной модели может повлиять на всю цепочку зависимостей.

Как заметил один из руководителей: «У нас все prompt’ы заточены под OpenAI. У каждой модели — свои инструкции, нюансы, детали. Агентная обработка в LLM требует страниц инструкций. А ещё есть QA для агентов — с ним тоже всё непросто. Так что смена модели — это теперь задача, на которую уходит масса инженерных усилий.»

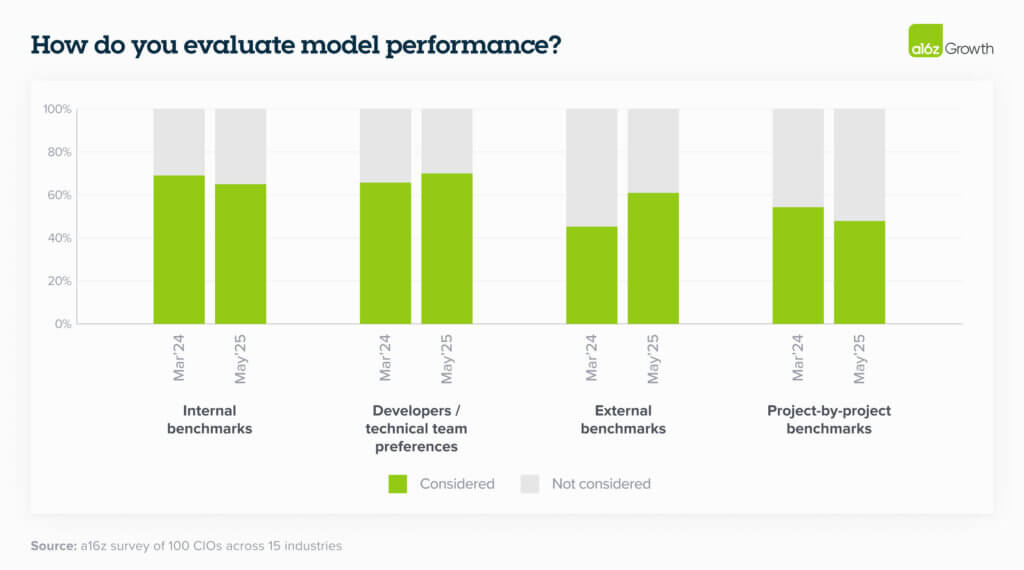

11. Компании всё чаще используют внешние бенчмарки как аналог “Magic Quadrant” для предварительного отбора моделей

По мере роста количества доступных моделей, внешние оценки становятся практичным, «Gartner-подобным» фильтром, который корпоративные заказчики узнают из традиционных процессов закупки ПО.

Хотя внутренние бенчмарки, golden datasets и обратная связь от разработчиков по-прежнему играют ключевую роль в глубокой оценке производительности LLM, зрелость рынка привела к тому, что компании всё чаще ориентируются на внешние бенчмарки — такие как LM Arena — на раннем этапе выбора.

Тем не менее, лидеры подчеркивают, что такие метрики — лишь часть более широкой процедуры оценки. Как отметил один из опрошенных: «Да, мы определенно смотрим на внешние бенчмарки. Но всё равно нужно всё проверять самим. Невозможно выбрать модель, не прогнав ее через свои кейсы и не услышав фидбек от сотрудников.»

Взлёт AI-приложений: рост колоссальный, всё больше компаний выбирают «покупать, а не строить»

12. Компании переходят от стратегии «build» к стратегии «buy» по мере зрелости экосистемы AI-приложений

На раннем этапе развития AI-продуктов компании в основном работали напрямую с моделями и строили собственные приложения. Однако за последние 12 месяцев произошел резкий сдвиг в сторону покупки сторонних решений, поскольку экосистема AI-приложений стала более зрелой. Это особенно актуально на фоне постоянных различий в производительности и стоимости моделей, которые требуют непрерывной оптимизации и тонкой настройки по каждому use case’у — задача, с которой лучше справляются специализированные AI-продуктовые команды, а не внутренние инженерные ресурсы.

Кроме того, в такой быстро меняющейся среде, как AI, компании всё чаще сталкиваются с тем, что внутренние инструменты сложно поддерживать, и они не дают устойчивого бизнес-преимущества — что еще больше укрепляет мотивацию [9] перейти от «build» к «buy».

По мере того как всё больше категорий AI-приложений дозревают, можно ожидать еще более активный переход к сторонним решениям, и ведущим индикатором этого выступает рост интереса к таким приложениям при тестировании новых кейсов. Например, в сфере поддержки клиентов более 90% опрошенных компаний заявили, что тестируют сторонние решения. Один публичный финтех рассказал, что начинал с in-house-разработки для клиентской поддержки, но недавний обзор внешнего рынка убедил их отказаться от собственного билда в пользу покупки готового решения.

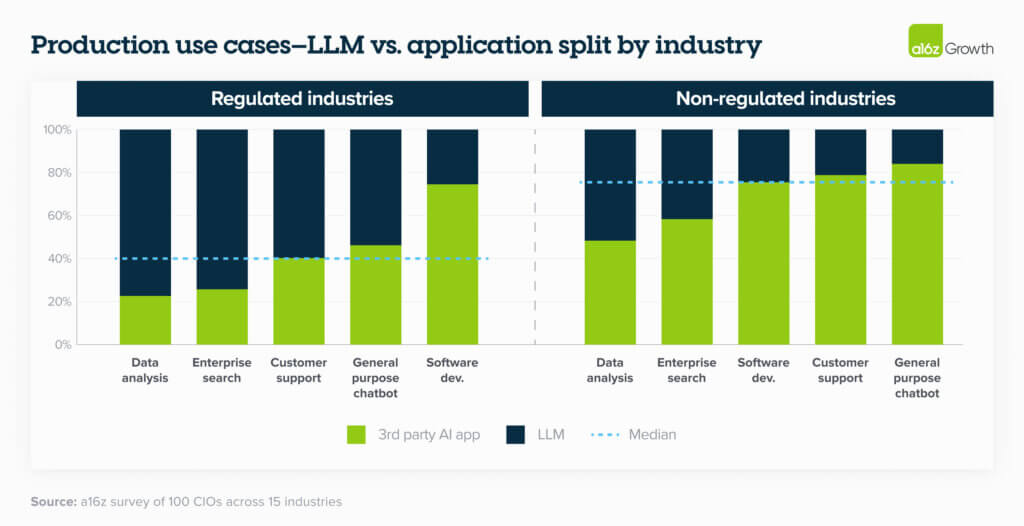

Единственная область, где эта тенденция пока не проявляется в полной мере, — это зарегулированные или высокорисковые отрасли, такие как здравоохранение, где конфиденциальность данных и соответствие требованиям (compliance) остаются приоритетом.

13. Покупатели испытывают сложности с моделью ценообразования, основанной на результатах (outcome-based pricing)

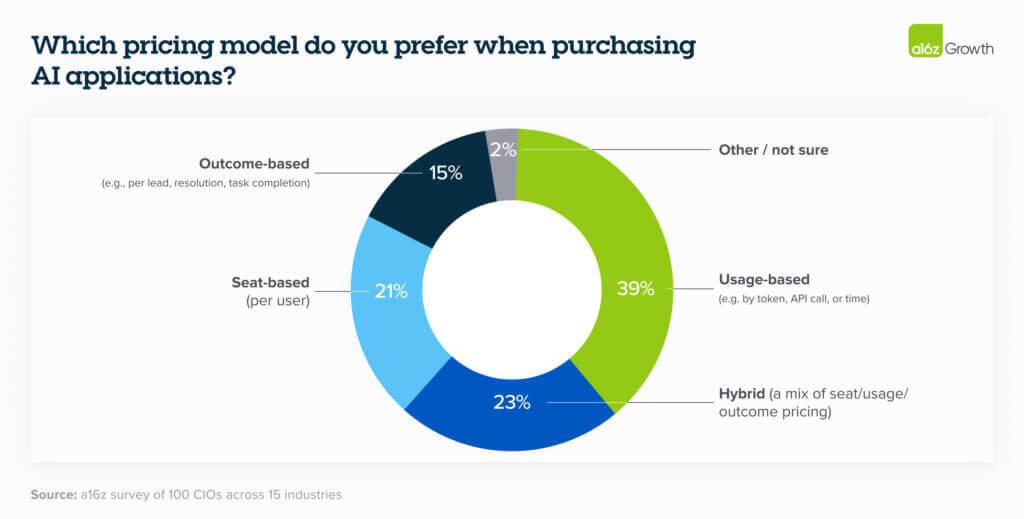

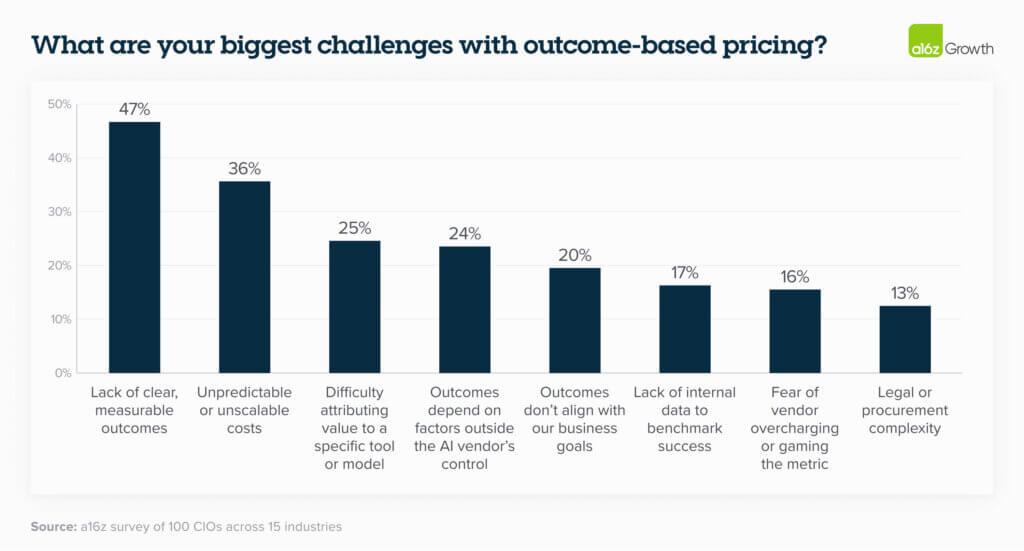

Несмотря на шумиху вокруг outcome-based pricing в AI-приложениях, большинство CIO пока не чувствуют уверенности в том, как именно устанавливаются, измеряются и тарифицируются метрики результатов.

Среди ключевых опасений — отсутствие чёткой связи между результатами и бизнес-целями, непредсказуемость затрат и проблемы с атрибуцией ценности. При этом какого-либо консенсуса по поводу того, как вендоры могли бы решить эти проблемы, пока не существует. Это неудивительно — AI остаётся относительно новой технологией, и пока не выработаны стандарты, позволяющие однозначно увязать модель с реальной бизнес-ценностью.

Покупатели опасаются ситуации, при которой неясно, за что именно они платят, и какова будет финальная сумма. В результате большинство CIO по-прежнему предпочитают оплату по использованию (usage-based pricing) при работе с AI-приложениями.

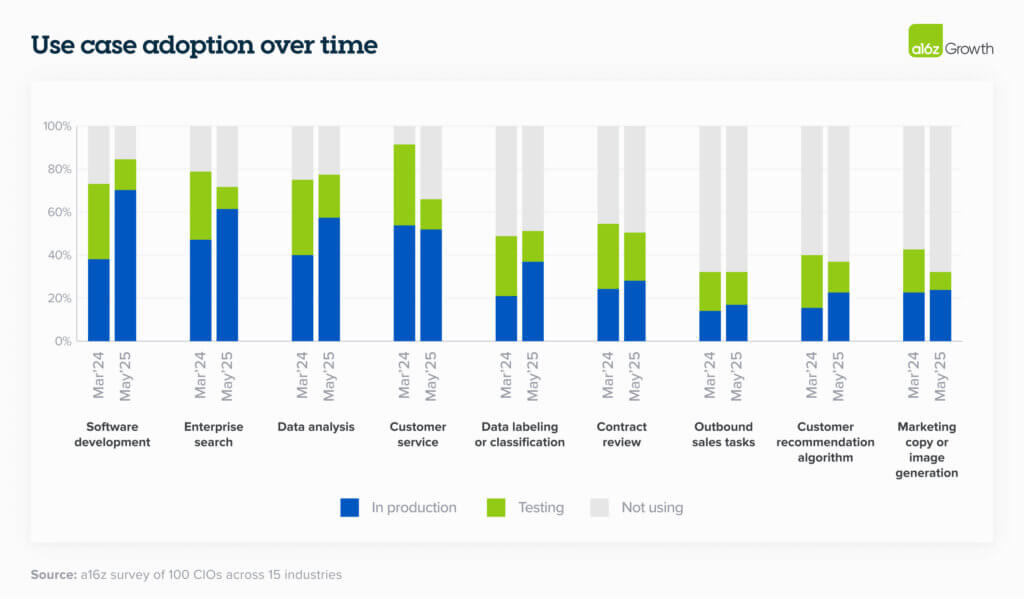

14. Разработка ПО становится «killer use case» — за ней следуют другие

Хотя внедрение AI-сценариев уверенно растёт по всем направлениям, особенно в корпоративном поиске, анализе данных и поддержке клиентов, именно разработка программного обеспечения продемонстрировала качественный скачок. Это произошло благодаря идеальному сочетанию факторов: появление высококлассных готовых решений, резкий рост возможностей моделей, широкая применимость к разным типам компаний и индустрий, а главное — очевидный ROI.

Один CTO быстрорастущей SaaS-компании сообщил, что почти 90% их кода сейчас генерируется AI, в основном с помощью Cursor и Claude Code, по сравнению с 10–15% год назад, когда они использовали GitHub Copilot. Такой уровень внедрения пока характерен скорее для авангарда рынка, но, вероятно, служит сильным опережающим индикатором для всего enterprise-сегмента.

15. Рынок prosumer-пользователей стал основным драйвером раннего роста AI-приложений и поведения корпоративных заказчиков

Сильные потребительские бренды трансформируются в высокий спрос со стороны компаний.

Подобно ранним технологическим сдвигам (например, появлению интернета), значительная часть раннего роста ведущих AI-приложений в корпоративном сегменте была обусловлена рынком prosumer-пользователей. Всё началось с ChatGPT и было поддержано приложениями для программирования и инструментами для креаторов, такими как ElevenLabs.

Многие CIO отметили, что решение о покупке Enterprise-версии ChatGPT было обусловлено тем, что «сотрудники любят ChatGPT. Это узнаваемый бренд». Этот двойной рыночный импульс привёл к гораздо более стремительному росту нового поколения AI-компаний по сравнению с тем, что мы наблюдали в предыдущие циклы.

16. AI-native-компании начинают опережать устоявшихся игроков по качеству и скорости

Традиционные вендоры всегда выигрывали за счёт доверия и выстроенной дистрибуции, но в эпоху AI они всё чаще уступают AI-native-конкурентам — с точки зрения как качества продукта, так и скорости его развития.

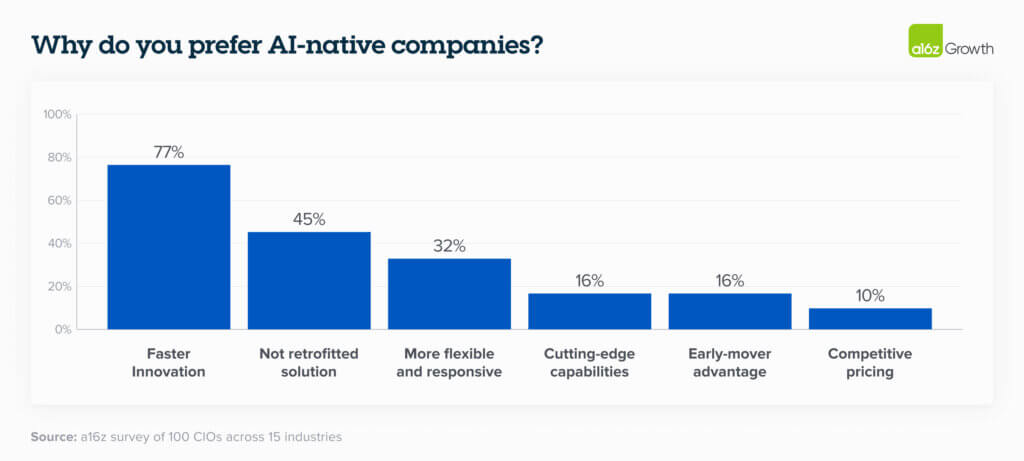

Ожидаемо, главная причина, по которой заказчики предпочитают AI-native-вендоров — это более высокая скорость инноваций. На втором месте — осознание того, что компании, изначально построенные вокруг AI, выпускают принципиально более качественные продукты, дающие лучший результат, чем решения, в которые AI «встраивается постфактум».

Этот разрыв особенно заметен сегодня в сфере разработки ПО. Один CIO из публичной компании в сфере кибербезопасности отметил резкий контраст между возможностями инструментов первого и второго поколения — особенно по мере того, как программирование становится всё более агентным.

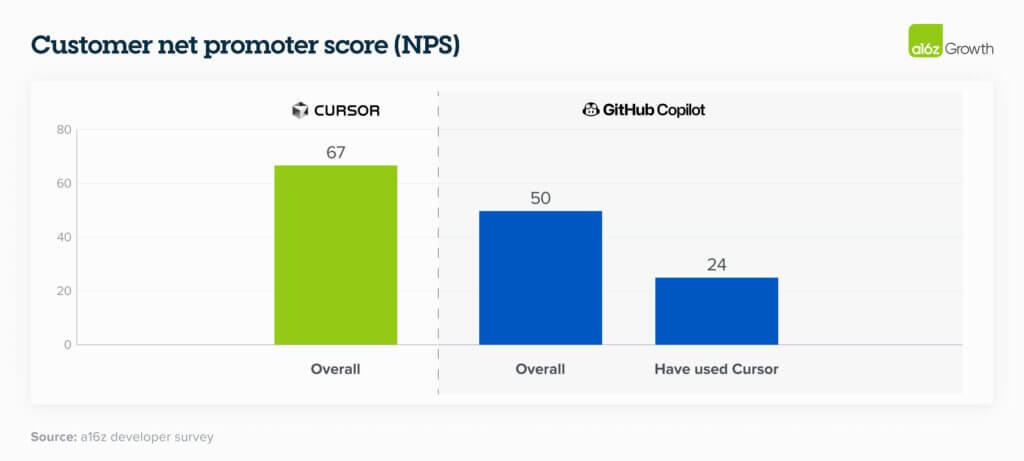

Это подтверждается и данными по удовлетворенности пользователей: те, кто перешёл на Cursor — AI-native-решение для кодинга, — демонстрируют значительно более низкий уровень удовлетворенности предыдущими инструментами, такими как GitHub Copilot. Всё это подчёркивает, насколько быстро инновации меняют представления о том, какие результаты покупатели могут — и должны — ожидать от AI-продуктов.

Прогнозы

Ландшафт корпоративного AI больше не определяется экспериментами — теперь его формируют стратегическое внедрение, конкретные бюджетные обязательства и зрело формирующиеся экосистемы вендоров.

По мере того как выбор моделей становится всё более разнообразным, фрагментация по use case’ам — не только ожидаемый, но и приветствуемый тренд. На этом фоне начинают чётко выделяться несколько ключевых лидеров.

Компании переходят к структурированным процессам закупки и всё чаще делают ставку на готовые решения, чтобы ускорить масштабирование AI. В результате формируется рынок, всё больше напоминающий классический enterprise software — но при этом движущийся со скоростью и сложностью, уникальными для AI.

Автор: kucev

Источник [10]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/16813

URLs in this post:

[1] восприятие: http://www.braintools.ru/article/7534

[2] эффективностью в задачах, связанных с программированием: https://x.com/cursor_ai/status/1917982557070868739

[3] лидерство: http://www.braintools.ru/article/1165

[4] интерес: http://www.braintools.ru/article/4220

[5] интеллекта: http://www.braintools.ru/article/7605

[6] зрения: http://www.braintools.ru/article/6238

[7] поведение: http://www.braintools.ru/article/9372

[8] логике: http://www.braintools.ru/article/7640

[9] мотивацию: http://www.braintools.ru/article/9537

[10] Источник: https://habr.com/ru/articles/923112/?utm_campaign=923112&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.