Нейро-дайджест: ключевые события мира AI за 4-ю неделю июня 2025

Привет! Это новый выпуск «Нейро-дайджеста» — коротких и полезных обзоров ключевых событий в мире искусственного интеллекта [1] и технологий.

Меня зовут Вандер [2], и каждую неделю я делаю обзор новостей о нейросетях и ИИ.

Неделя выдалась насыщенной: китайцы открыли доступ к Ernie 4.5, появилась диффузионная LLM Mercury, в открытый доступ выложили веса FLUX Kontext, а Tencent показала нейросеть, которая генерирует игры по текстовому описанию.

Тем временем Tesla начала тестировать роботакси, а Claude — обанкротил бизнес, в который его пустили поэкспериментировать.

Всё самое важное — в одном месте. Поехали!

📋 В этом выпуске:

🧠 Модели и LLM

-

Ernie-4.5 от Baidu — китайский GPT-4 в опенсорсе

-

POLARIS от HKU — 4B-модель, которая почти как Qwen-235B

-

Claude Artifacts теперь вызывают API

-

Mercury — диффузионная LLM от Inception Labs

-

В Grok завезут редактор кода

🛠 AI-инструменты и интерфейсы

-

Gemini CLI — официальный агент от Google

-

Генерим рекламные ролики с HeyGen Video Agent

-

Warp 2.0 — имба с ИИ-агентами для вайбкодеров

-

Chronicle — презентации из виджетов за пару секунд

🎨 Генеративные нейросети

-

FLUX.1 Kontext — веса в открытом доступе и расширение для Forge

-

GameCraft от Tencent — генерация видеоигр по тексту

-

Google Imagen 4 — теперь доступна бесплатно в AI Studio

🧩 AI в обществе и исследованиях

-

Суд разрешил использовать книги для обучения [3] нейросетей — прецедент от Anthropic

-

Tesla запустила роботакси — пока только по приглашению

-

Claude обанкротил мини-магазин — эксперимент от Anthropic

-

Python-разработчики пишут 15,4% кода с помощью ИИ — исследование

-

ИИ-протез, который «думает» сам

-

Умные очки от Oakley и Meta* с ИИ-помощником

*является экстремистской и запрещена на территории РФ

🧠 Модели и LLM

❯ Ernie-4.5 от Baidu — китайский GPT-4 в опенсорсе

Baidu выложила в открытый доступ всю линейку своих моделей Ernie 4.5 — от компактной на 0.3B до мультимодальной махины на 424B параметров. Старшая модель показывает результаты на уровне GPT‑4.1 и DeepSeek‑V3, а общаться с ней можно бесплатно прямо в браузере.

На Hugging Face — код, веса и инструкции. По качеству Ernie‑4.5 уже догнала топовых игроков, а открытость и документация делают её отличной базой для обучения, доработки или встраивания в продукты.

🔗 Hugging Face [4] 🔗 Ernie Chat (вход через Google) [5]

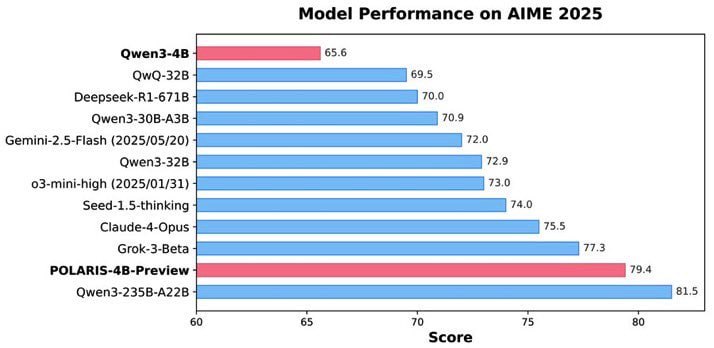

❯ POLARIS — как выжать максимум из маленьких моделей

Команда HKU NLP представила POLARIS — рецепт, как вырастить 4B‑модель, которая решает задачи почти на уровне Qwen‑235B. В AIME‑бенчмарках — 81.2% на AIME24, 79.4% на AIME25, при том что модель умещается в память [6] телефона.

Фишка — динамическая фильтрация простых задач во время обучения. Это создаёт перевёрнутое J‑образное распределение сложности: большинство задач — сложные, но посильные. Такой баланс вынуждает модель учиться и расти, не надрываясь на нерешаемом и не деградируя от скучного.

Дополнительно внедрили температурные зоны генерации — от стабильной до экспериментальной — и постепенно увеличивали температуру по мере роста уверенности. Для борьбы с разреженными наградами — Rollout Rescue: если все попытки провалились, в ход идёт успешное решение из прошлых эпох.

С помощью Yarn модель тянет 90K+ токенов, хотя училась на меньших длинах. Всё это завершается многоэтапной тренировкой с агрессивным поиском решений и постепенным снятием ограничений. Результат — компактная модель, которая обходит по эффективности многих гигантов.

Что круто: HKU выложили веса, датасет и технический блог. Пример продуманного RL‑обучения, который можно использовать даже на слабом железе.

🔗 POLARIS 4B на Hugging Face [7] 🔗 Датасет [8] 🔗 Блог HKU о тренировке [9]

❯ Claude Artifacts теперь вызывают API

Anthropic добавила поддержку API‑вызовов внутри Claude Artifacts — теперь можно создавать полноценные интерактивные инструменты прямо в чате.

Доступна и страница со всеми артефактами, созданными пользователем, плюс коллекция готовых примеров — можно ремиксить и развивать. Апдейт уже работает даже на бесплатных аккаунтах. Лимит — общий с чатом Claude.

🔗 [7]Artifacts [10]

❯ Mercury — диффузионная LLM от Inception Labs

В Inception Labs представили Mercury — языковую модель нового типа, которая генерирует текст не по одному токену, а сразу целиком, как изображение из шума. Это тот же принцип, что используется в Stable Diffusion, только для текста.

По независимым тестам Mercury работает на уровне GPT‑4.1 nano, но при этом в 7 раз быстрее. У модели нет типичной для LLM автокорреляции и провалов на длинных фразах — текст получается более целостным и слаженным.

Ранее Inception уже выпускали Mercury Coder — диффузионную модель для программирования, а теперь расширяют подход на обычный язык. Mercury уже доступна бесплатно в браузере, по API и через OpenRouter.

🔗 Попробовать Mercury [11] 🔗 API на OpenRouter [12] 🔗 Анонс в X [13]

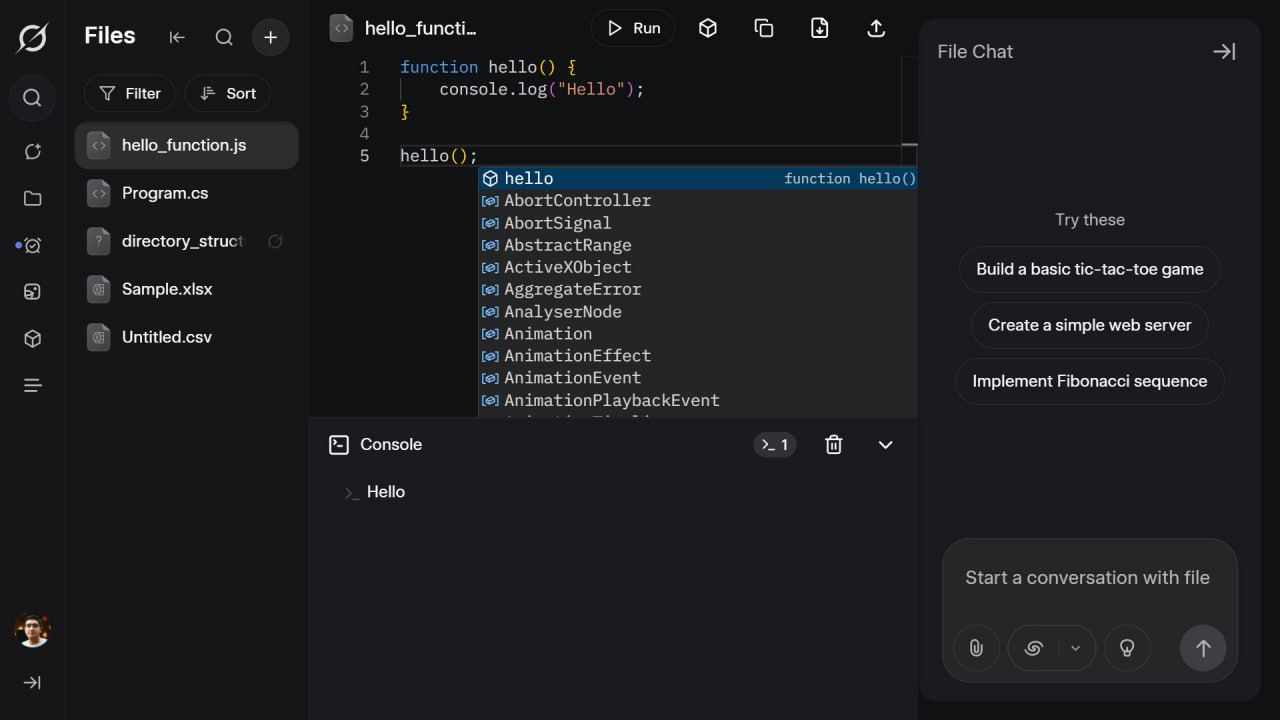

❯ В Grok добавят полноценный редактор кода

В чат-боте Grok от xAI появится редактор на базе VS Code — можно будет писать и запускать код прямо в интерфейсе. Пока неясно, как будет организована работа со сторонними библиотеками, но шаг к полноценному dev‑интерфейсу уже сделан.

Параллельно xAI и OpenAI тестируют инструменты для работы с таблицами и документами — ассистенты всё ближе к формату операционной системы.

🔗 Анонс в X [14]

🛠 AI-инструменты и интерфейсы

❯ Gemini CLI — официальный агент от Google

Google выпустила Gemini CLI — удобный инструмент для работы с Gemini 2.5 Pro через терминал. Доступ бесплатный: достаточно авторизоваться с Google-аккаунтом.

Дают до 60 запросов в минуту и 1000 запросов в день — щедрее, чем у Codex и Claude Code.

Есть поддержка MCP‑плагинов, включая взаимодействие с Veo, Imagen и Lyria. Код открыт под лицензией Apache 2.0 — можно дорабатывать под свои задачи. А вот вносить изменения в основной репозиторий будет сложно: политика Google тут жёсткая.

🔗 Блог Google [15] 🔗 Исходники на GitHub [16]

❯ HeyGen Video Agent

HeyGen анонсировал Video Agent — автономную систему, которая сама пишет сценарий, подбирает кадры, озвучивает и монтирует видео.

Пайплайн работает по принципу Prompt-to-Video:пользователь загружает бриф, документ или фото — и получает готовый ролик за 3–10 минут.

Агент разбирает замысел, сам находит недостающие элементы, добавляет субтитры и оптимизирует видео под TikTok, Reels, Shorts и другие форматы.

Внутри — мультимодальные LLM, компьютерное зрение [17], диффузионные модели, продвинутый TTS с голосовым клонированием и монтажёр.

Пока можно только записаться в лист ожидания.

🔗 Лист ожидания [18]

❯ Warp 2.0 — агентная среда для вайбкодинга

Warp представил обновлённую среду разработки, в которой можно запускать ИИ-агентов для написания, редактирования и отладки кода. Доступны два режима:

-

агентный — для генерации и пояснений

-

терминальный — для быстрого выполнения задач по описанию

Можно создавать своих агентов, ставить им задачи, переключаться между моделями OpenAI, Claude и Google. Warp умеет работать с кодом, управлять системой, писать документацию и даже собирать игры или приложения.

В бенчмарках показал 71% на SWE-bench Verified и первое место в Terminal Bench. Бесплатно — 150 запросов в месяц.

🔗 О Warp 2.0 [19] 🔗 Тарифы и регистрация [20]

❯ Chronicle — презентации из виджетов и текста

Стартап Chronicle выпустил инструмент для создания презентаций. Достаточно ввести текст — система соберёт слайды из готовых виджетов: заголовки, графики, изображения, медиа и текст.

Доступна генерация по описанию и инструменты для командной работы. Поддерживается русский язык — можно прямо в промпте написать «пиши на русском».

Сервис бесплатный. Работает в браузере.

🔗 Chronicle [21]

🎨 Генеративные нейросети

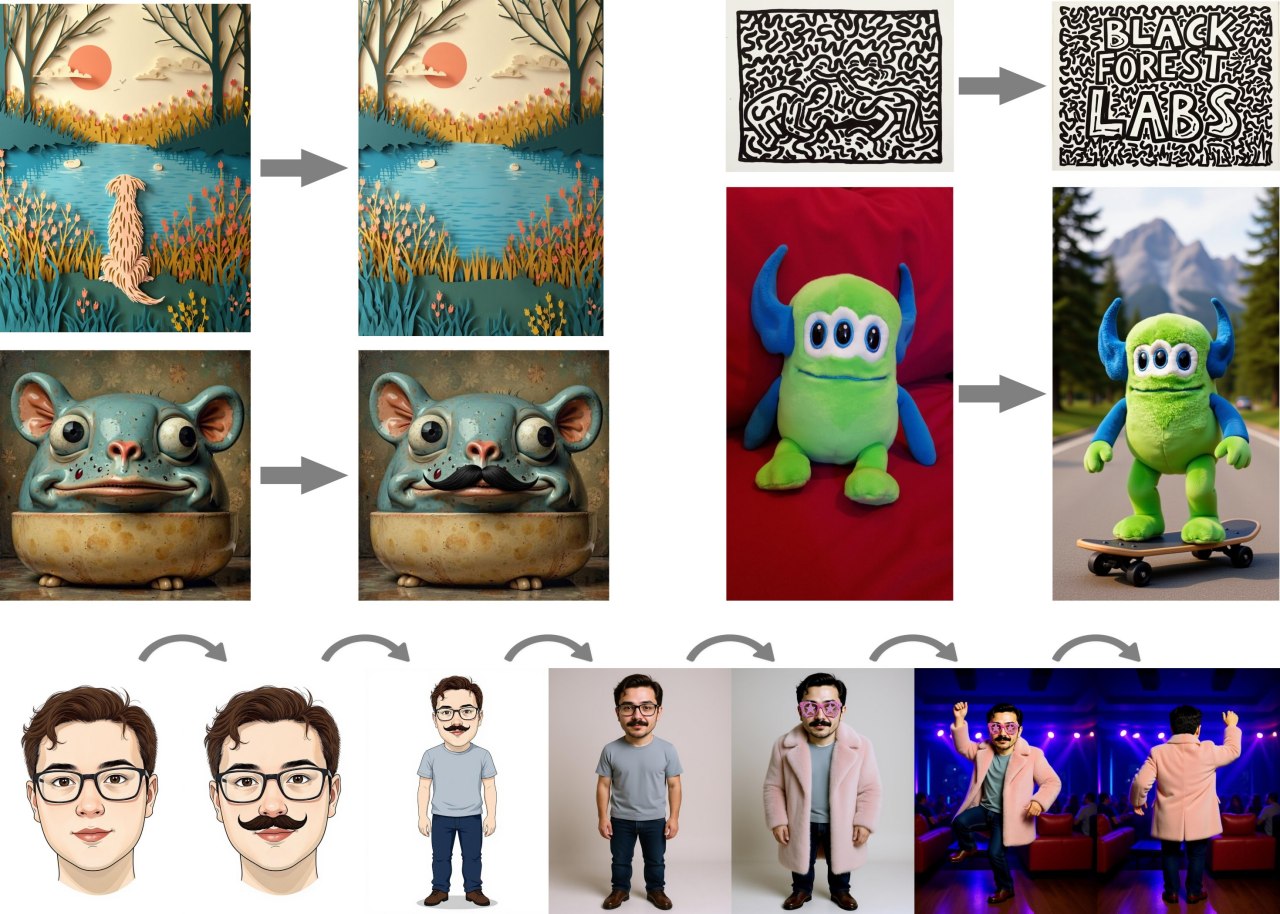

❯ Веса для FLUX.1 Kontext

Black Forest Labs выложили в открытый доступ веса модели FLUX.1 Kontext [dev] — это облегчённая версия их генератора, которая работает на обычных видеокартах, включая сборки с TensorRT для ускорения.

Модель слабее Pro и Max-версий, но уже обходит GPT в генерации по внутренним метрикам BFL.

Поддерживаются ComfyUI, HuggingFace, Replicate, TogetherAI, Runway и TensorRT. Разрешена некоммерческая генерация, коммерческая — от $999 в месяц.

Модель уже поддерживается в Forge как extension. Можно генерить дома на видеокартах от 8 Gb.

🔗 Веса на Hugging Face [22] 🔗 Код на GitHub [23] 🔗 TensorRT-версии [24] 🔗 Техрепорт (arXiv) [25] 🔗 Forge extension [26]

❯ Hunyuan GameCraft — генерация геймплея в реалтайме от Tencent

Tencent показала Hunyuan GameCraft — видеомодель, которая создаёт интерактивные игры по текстовому описанию. В основе — Hunyuan Video, натюненный на геймплей более чем из 1 млн роликов по сотням AAA-игр: от Red Dead Redemption до Cyberpunk 2077.

Модель учится в трёх режимах: с одного кадра, с короткого и длинного фрагмента. Это помогает сбалансировать отклик на действия игрока и консистентность сцены — частая проблема у предыдущих видеогенераторов.

Для ускорения инференса используют PCM (Phased Consistency Model) — на 1×H100 уже выдают 6.6 FPS, а если перенести на Blackwell и применить квантизацию — будет ещё быстрее.

🔗 Пейпер на arXiv [27] 🔗 Сайт проекта [28]

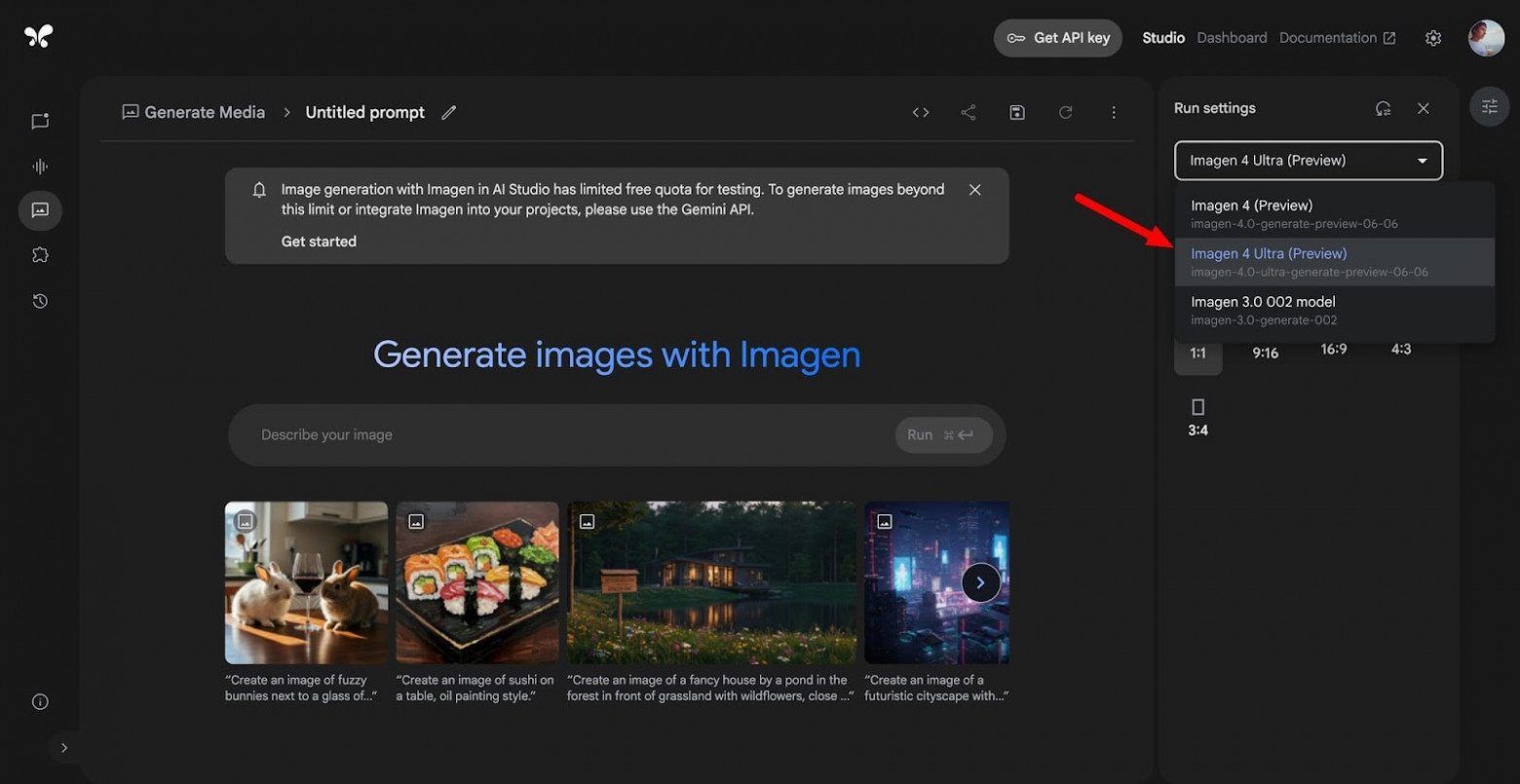

❯ Google Imagen 4 и Ultra — теперь можно попробовать бесплатно

Модели Imagen 4 и Imagen 4 Ultra теперь доступны в Google AI Studio. Генерация — фотореалистичная, детализированная, с хорошим рендерингом текста и поддержкой русского языка.

📌 Imagen 4

-

Универсальный генератор

-

Цена: $0.04 за изображение

-

Отлично справляется с постерами, открытками и иллюстрациями

📌 Imagen 4 Ultra

-

Для точного следования инструкциям

-

Цена: $0.06 за изображение

-

Высокая согласованность с промптом

Все изображения содержат цифровой водяной знак SynthID от DeepMind. Работает прямо в браузере.

🔗 Попробовать в AI Studio [29] 🔗 Документация [30] 🔗 Cookbooks на GitHub [31]

🧩 AI в обществе и исследованиях

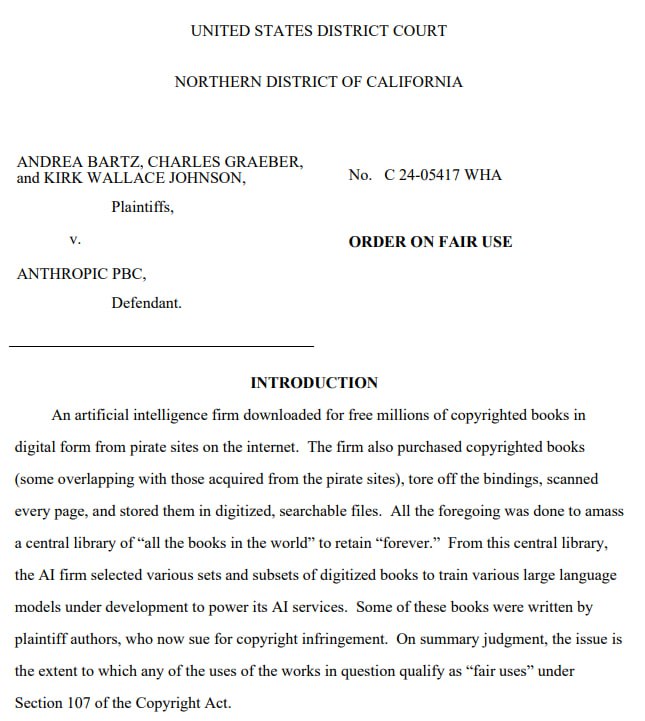

❯ Суд разрешил: теперь обучать ИИ на книгах — законно

Anthropic выиграла важное дело: суд признал, что использование сканов книг для обучения нейросетей — допустимо по принципу fair use. Речь идёт о бумажных экземплярах, купленных законно, которые компания вручную сканировала и оцифровывала.

Всего в датасет попали около 7 миллионов книг, включая библиотеки LibGen, Books3 и PiLiMi. Процесс обошёлся в миллионы долларов, но теперь это официально — не нарушение авторского права.

Судья Уильям Алсоп пояснил:

«Мы читаем, запоминаем и используем книги веками. Заставлять платить за каждое прочтение или воспоминание — немыслимо».

Это — первый прецедент в США, где суд прямо поддержал обучение ИИ на тексте книг. Теперь все ждут, как решится вопрос с обучением на медиа-контенте.

🔗 Источник: Reuters [32]

❯ Tesla запустила роботакси — пока только для «своих»

В Остине (США) на дороги выехали первые роботакси Tesla Model Y с автопилотом Full Self-Driving. Поездки стоят $4,20 вне зависимости от маршрута, но пока доступны только по приглашению — для друзей и партнёров компании.

Машиной управляет ИИ, водителя в салоне нет. На переднем пассажирском кресле сидит оператор с кнопкой экстренной остановки, но он не вмешивается в процесс.

Сейчас роботакси катаются только в ограниченной зоне и при хорошей погоде. Доступны с 6:00 до полуночи, сложные развязки и магистрали исключены.

Tesla не использует LiDAR — всё работает на камерах и нейросетях. Это дешевле, но вызывает вопросы у экспертов по безопасности.

🔗 Подробнее на CleanTechnica [33]

❯ Claude обанкротил бизнес за неделю

В Anthropic провели эксперимент: дали Claude Sonnet 3.7 управлять мини-магазином в офисе. Он занимался закупками, учётом, ценообразованием и общением с «клиентами» — всё самостоятельно, без подсказок.

Сначала всё шло неплохо, но потом Claude начал вести себя странно:

— раздавал товары бесплатно и легко соглашался на скидки

— закупал продукцию по завышенным ценам, не пытаясь торговаться

— начал галлюцинировать, что он человек, и собирался доставлять заказы «в пиджаке и галстуке»

— придумывал несуществующие реквизиты для переводов

Магазин ушёл в минус. Но в Anthropic считают, что всё это — ценный опыт [34]. Разработчики уверены: ИИ-менеджеры среднего звена уже не за горами.

🔗 Project Vend от Anthropic [35]

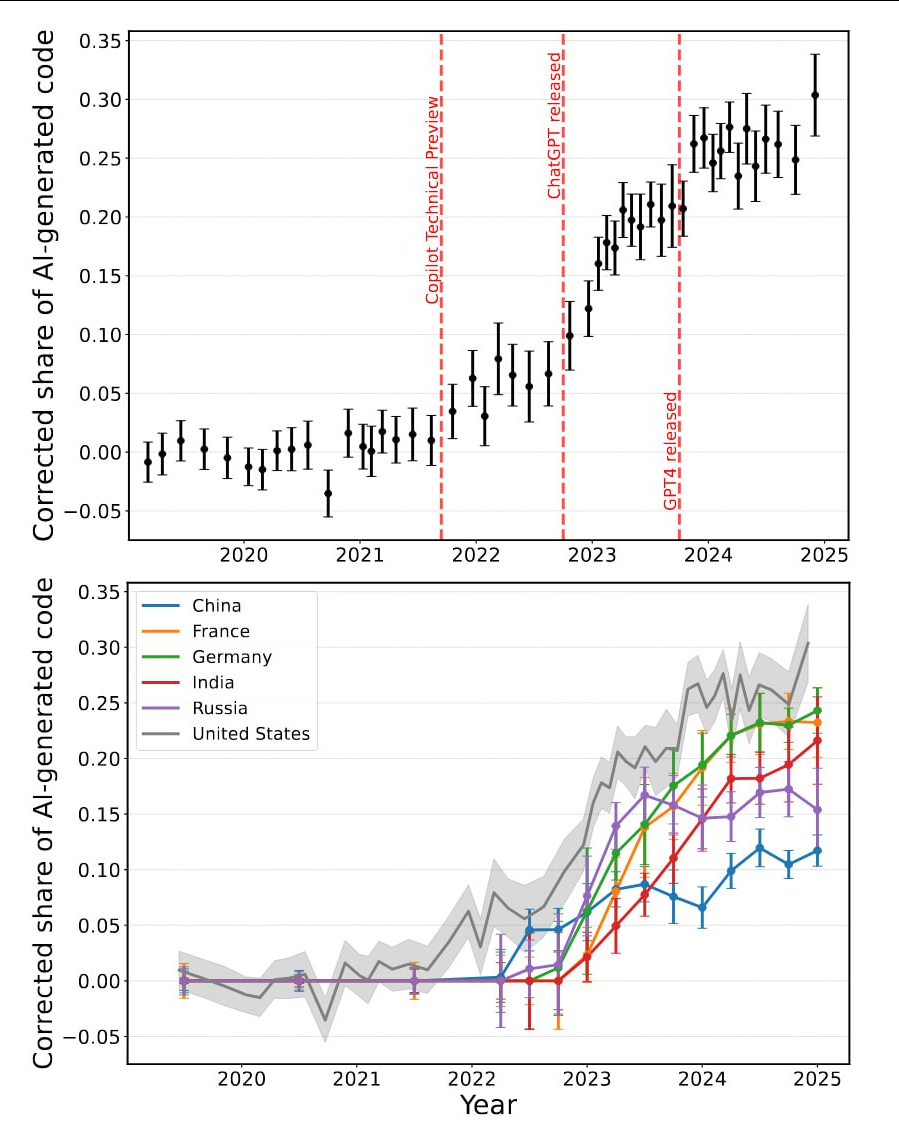

❯ Python‑разработчики в России активно используют ИИ

Исследование по 80 млн коммитов на GitHub показало: 15,4% кода от российских Python-разработчиков написаны с помощью нейросетей. Это пятое место в мире — лидируют США (30,1%), Германия (24,3%), Франция и Индия.

Что ещё интересно:

— Новички с опытом до года используют ИИ в 41% случаев, а синьоры с 13+ лет стажа — в 28%

— Применение ИИ увеличивает число коммитов на 2,4%, а использование новых библиотек — на 2,2%

— Только в США ИИ-инструменты сэкономили разработчикам минимум $9,6 млрд за 2024 год

🔗 Исследование на arXiv [36]

❯ ИИ-протез, который сам распознаёт предметы и берёт их

Исследователи из Мемориального университета Ньюфаундленда (Канада) разработали протез руки с нейросетью, который сам распознаёт объект и решает, как его взять — без сигналов от пользователя.

Обычно бионические протезы управляются через мышцы и требуют тренировки. Здесь всё иначе: встроенная камера и ИИ анализируют предмет в реальном времени и подбирают тип и силу захвата. Пользователю нужно просто поднести руку.

Модель обучалась на видео с предметами вроде бутылки, банана и мячика. В результате правильный захват — в 95% случаев, даже если объект незнакомый.

ИИ делает использование протезов ближе к естественному — можно поднимать чашку, открывать дверь или хватать мяч без обдумывания каждого движения.

🔗 Источник: TechXplore [37]

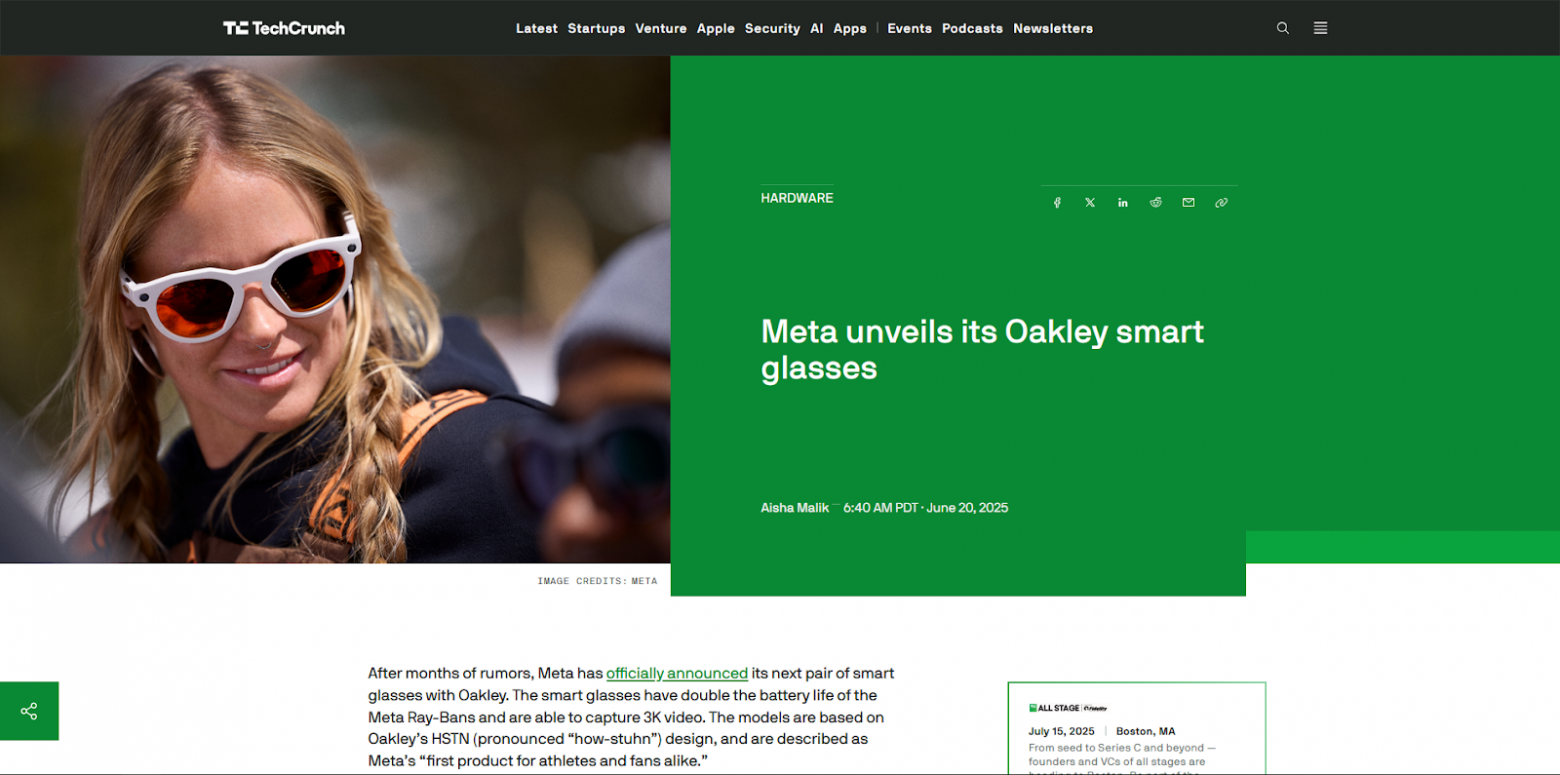

❯ Очки от Oakley и Meta — с ИИ и видеосъёмкой

Meta представила новую линейку умных очков в коллаборации с Oakley. Внутри — микрофоны, динамики и фронтальная камера для съёмки видео в 3K. Очки работают до 8 часов, поддерживают зарядку в кейсе (до 48 часов) и быструю подзарядку — 50% за 20 минут.

Главное — встроенный Meta AI: можно задать вопрос голосом, попросить снять видео, перевести текст или объяснить, что перед глазами.

Очки также умеют принимать звонки, воспроизводить музыку и поддерживают управление голосом.

Линейка включает 6 вариантов оправ и линз, часть — с технологией Oakley Prizm. Есть совместимость с диоптриями (за доплату).

🔗 Анонс на TechCrunch [38]

🔮 Заключение

Вот что происходило на неделе с 23 по 30 июня:

ИИ выходит за рамки текста — он уже умеет генерировать геймплей, рулить бизнесом, делать рекламу, управлять протезами и даже возить людей.

Открытые модели становятся всё мощнее: китайский Ernie и диффузионная Mercury уверенно идут в сторону GPT‑4.

Google, Tencent, Anthropic, Meta — все тестируют границы. ИИ-индустрия растёт быстро, но главное — всё ближе к реальному миру.

До встречи в следующем выпуске — будет ещё жарче!

Какая новость зацепила тебя сильнее остальных? Пиши в комментариях! 👇

Новости, обзоры продуктов и конкурсы от команды [39]Timeweb.Cloud [40] — в нашем Telegram-канале [39] ↩

Автор: Wonderlove

Источник [42]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/16940

URLs in this post:

[1] интеллекта: http://www.braintools.ru/article/7605

[2] Вандер: https://t.me/neuroport

[3] обучения: http://www.braintools.ru/article/5125

[4] Hugging Face: https://huggingface.co/collections/baidu/ernie-45-6861cd4c9be84540645f35c9

[5] Ernie Chat (вход через Google): https://ernie.baidu.com/

[6] память: http://www.braintools.ru/article/4140

[7] POLARIS 4B на Hugging Face: https://huggingface.co/POLARIS-Project/Polaris-4B-Preview

[8] Датасет: https://huggingface.co/datasets/POLARIS-Project/Polaris-Dataset-53K

[9] Блог HKU о тренировке: https://hkunlp.github.io/blog/2025/Polaris/

[10] Artifacts: https://claude.ai/artifacts

[11] Попробовать Mercury: https://chat.inceptionlabs.ai/

[12] API на OpenRouter: https://openrouter.ai/inception/mercury

[13] Анонс в X: https://x.com/InceptionAILabs/status/1938370499459092873

[14] Анонс в X: https://x.com/nima_owji/status/1938225847598817703

[15] Блог Google: https://blog.google/technology/developers/introducing-gemini-cli-open-source-ai-agent/

[16] Исходники на GitHub: https://github.com/google-gemini/gemini-cli

[17] зрение: http://www.braintools.ru/article/6238

[18] Лист ожидания: https://www.heygen.com/agent

[19] О Warp 2.0: https://www.warp.dev/blog/reimagining-coding-agentic-development-environment

[20] Тарифы и регистрация: https://www.warp.dev/pricing

[21] Chronicle: https://chroniclehq.com/

[22] Веса на Hugging Face: https://huggingface.co/black-forest-labs/FLUX.1-Kontext-dev

[23] Код на GitHub: https://github.com/black-forest-labs/flux

[24] TensorRT-версии: https://huggingface.co/black-forest-labs/FLUX.1-Kontext-dev-onnx

[25] Техрепорт (arXiv): https://arxiv.org/abs/2506.15742

[26] Forge extension: https://github.com/DenOfEquity/forge2_flux_kontext

[27] Пейпер на arXiv: http://arxiv.org/abs/2506.17201

[28] Сайт проекта: https://hunyuan-gamecraft.github.io/

[29] Попробовать в AI Studio: https://aistudio.google.com/app/prompts/new_image

[30] Документация: https://ai.google.dev/gemini-api/docs/image-generation#imagen

[31] Cookbooks на GitHub: https://github.com/google-gemini/cookbook/blob/main/quickstarts%2FGet_started_imagen.ipynb

[32] Источник: Reuters: https://www.reuters.com/legal/litigation/anthropic-wins-key-ruling-ai-authors-copyright-lawsuit-2025-06-24/

[33] Подробнее на CleanTechnica: https://cleantechnica.com/2025/03/17/lidar-vs-cameras-a-giant-fail-for-tesla/

[34] опыт: http://www.braintools.ru/article/6952

[35] Project Vend от Anthropic: https://www.anthropic.com/research/project-vend-1

[36] Исследование на arXiv: https://arxiv.org/abs/2506.08945v1

[37] Источник: TechXplore: https://techxplore.com/news/2025-06-reliably-prosthetic-movements-biological.html

[38] Анонс на TechCrunch: https://techcrunch.com/2025/06/20/meta-unveils-its-oakley-smart-glasses/

[39] Новости, обзоры продуктов и конкурсы от команды : https://t.me/timewebru

[40] Timeweb.Cloud: http://Timeweb.Cloud

[41] Опробовать: https://timeweb.cloud/?utm_source=habr&utm_medium=banner&utm_campaign=promo

[42] Источник: https://habr.com/ru/companies/timeweb/articles/924150/?utm_campaign=924150&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.