Заявления Apple о больших моделях обработки данных стали предметом нового исследования

В ходе повторного анализа статьи Apple «Иллюзия мышления», вызвавшей споры, были подтверждены некоторые ключевые критические замечания, однако главный вывод исследования был поставлен под сомнение.

Исследователи из испанского Центра автоматизации и робототехники CSIC-UPM провели повторные эксперименты, основываясь на данных оригинальной статьи Apple, которая была опубликована в июне 2025 года и вызвала широкий резонанс в сообществе разработчиков искусственного интеллекта [1].

Apple утверждала, что даже новейшие большие модели рассуждений (LRM) с трудом справляются с задачами, требующими базового символического планирования. Исследование показало, что производительность этих моделей резко падает, когда сложность задачи выходит за рамки умеренного уровня, и что иногда они проявляют чрезмерную осторожность при решении более простых задач.

Новое исследование в значительной степени подтверждает выводы Apple, но оспаривает их интерпретацию. Испанская команда утверждает, что недостатки моделей связаны не только с отсутствием «мыслительных способностей», но и с тем, как составлены задачи, как структурированы подсказки и какие методы стохастической оптимизации используются.

Башни Ханоя: пошаговые решения работают не всегда

Чтобы проверить способность к долгосрочному планированию, исследователи использовали классическую головоломку «Ханойская башня» с такими моделями, как Gemini 2.5 Pro. Они разбили задачу на более мелкие подзадачи, чтобы моделям не приходилось генерировать решение целиком за один раз.

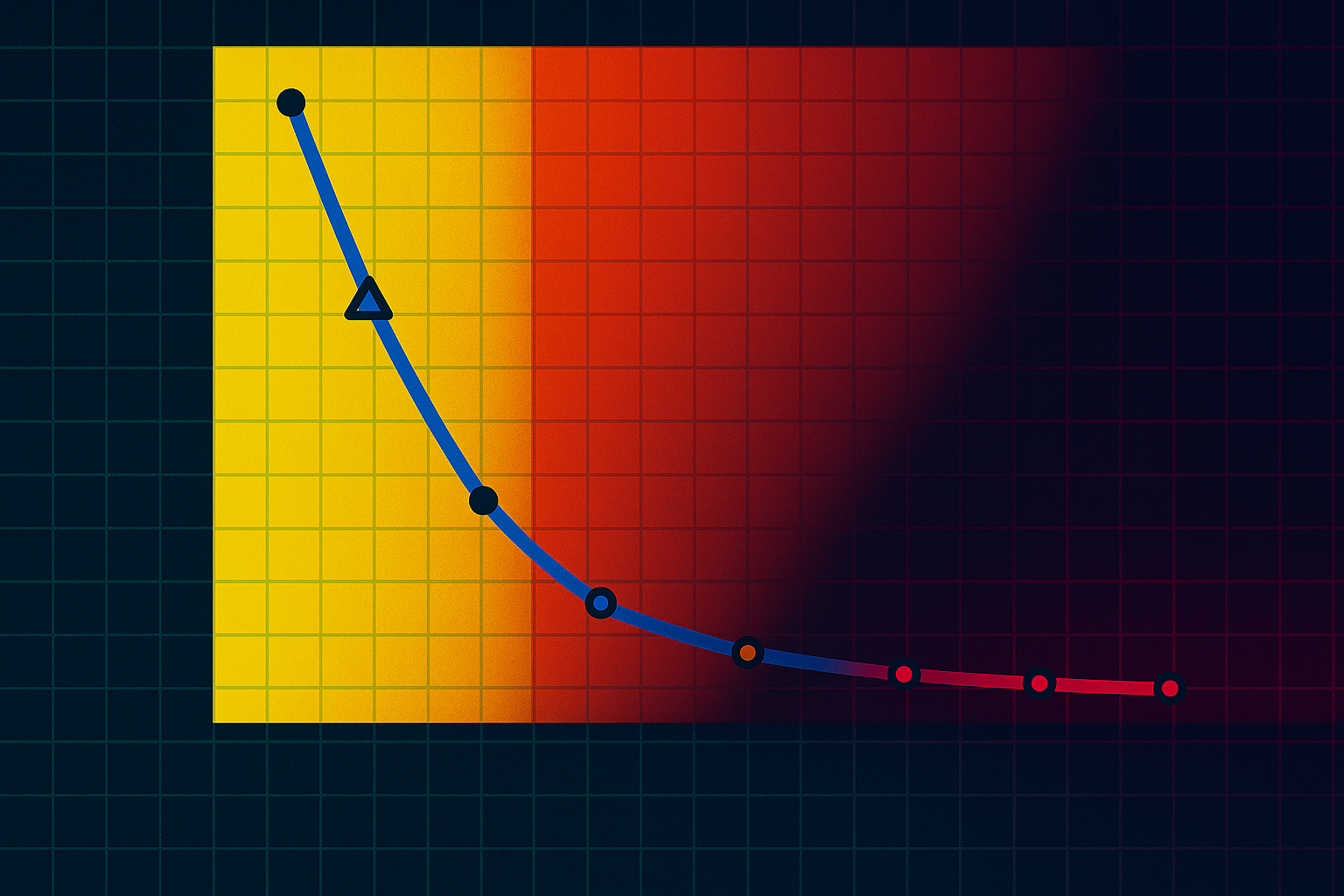

Такое поэтапное решение неплохо работало для систем с семью дисками. Но при использовании восьми и более дисков производительность резко падала, что соответствовало внезапному снижению производительности в исследовании Apple по мере увеличения сложности.

Новая интерпретация указывает на использование токенов как на ключевой фактор: количество токенов, которые расходует модель, напрямую связано с тем, считает ли она решение возможным. Пока модель считает, что может решить задачу, она увеличивает потребление ресурсов. Если она решает, что задача неразрешима, она быстро прекращает работу, что свидетельствует о своего рода неявном управлении неопределённостью.

Сотрудничество с агентом увеличивает усилия, но не успех

Исследователи также попробовали мультиагентный подход, при котором две языковые модели по очереди предлагали шаги для решения задачи. Это приводило к длительным обсуждениям и большому расходу токенов, но редко давало верные решения.

Хотя модели соблюдали все правила, они часто застревали в бесконечных циклах допустимых, но бесполезных ходов. Авторы приходят к выводу, что моделям не хватает способности распознавать и реализовывать стратегии более высокого уровня, даже если они действуют формально правильно.

В отличие от Apple, которая сочла эти сбои свидетельством недостаточных когнитивных способностей, испанская команда также винит в них структуру подсказок и отсутствие глобальных механизмов поиска.

Переправа через реку: задача Apple была неразрешимой

Самая резкая критика была направлена в адрес теста на переправу через реку, который лежит в основе статьи Apple. Apple сообщила об особенно низкой производительности модели в этом тесте, но повторное исследование показало, что многие тестовые случаи Apple были математически [2] неразрешимыми — факт, который не был указан в оригинальной публикации.

Исследователи из Испании провели тестирование на корректных конфигурациях и выяснили, что модель успешно справляется с решением сложных задач, включающих более 100 пар агентов.

Удивительно, но наиболее трудными оказались не самые масштабные задачи, а скорее те, что находятся «в середине». У таких задач очень мало подходящих решений, и они требуют чрезвычайно точного планирования, что создаёт большую нагрузку на модели.

Это подтверждает один из ключевых выводов Apple: наибольшее снижение производительности языковых моделей зависит не только от того, насколько велика или сложна проблема. Вместо этого модели испытывают наибольшие трудности при решении задач средней сложности, таких как головоломка с переправой через реку с пятью парами агентов, у которой есть лишь несколько правильных решений. С более простыми или сложными задачами модели часто справляются лучше — либо потому, что существует много возможных решений, либо потому, что модель легче анализирует задачу.

LRM как агенты стохастического поиска на неизвестной территории

Испанская команда в конечном счёте отвергла основное утверждение Apple о том, что языковые модели принципиально не способны к обобщению. Вместо этого они описали эти модели как «стохастические, настроенные с помощью обучения [3] с подкреплением [4] поисковые системы в дискретном пространстве состояний, которое мы едва понимаем».

Согласно этой точке зрения [5], языковые модели — это не рациональные планировщики, а системы, которые исследуют локальные пути решения на основе изученных шаблонов и обладают лишь ограниченной способностью к долгосрочному планированию.

Исследователи также выдвигают гипотезу о том, что применение токенов может быть своего рода внутренним сигналом для модели о её субъективном восприятии возможности решить задачу. Когда модель считает, что задача может быть решена, она направляет больше ресурсов на её выполнение, а если не видит перспективы, то прекращает работу.

Делегируйте часть рутинных задач вместе с BotHub [6]! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке [7] вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Источник [8]

Автор: mefdayy

Источник [9]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/16978

URLs in this post:

[1] интеллекта: http://www.braintools.ru/article/7605

[2] математически: http://www.braintools.ru/article/7620

[3] обучения: http://www.braintools.ru/article/5125

[4] подкреплением: http://www.braintools.ru/article/5528

[5] зрения: http://www.braintools.ru/article/6238

[6] BotHub: https://bothub.chat/?utm_source=contentmarketing&utm_medium=habr&utm_campaign=news&utm_content=APPLE

[7] По ссылке: https://bothub.chat/?invitedBy=m_aGCkuyTgqllHCK0dUc7

[8] Источник: https://the-decoder.com/apples-claims-about-large-reasoning-models-face-fresh-scrutiny-from-a-new-study/

[9] Источник: https://habr.com/ru/companies/bothub/news/925098/?utm_source=habrahabr&utm_medium=rss&utm_campaign=925098

Нажмите здесь для печати.