Кто убил интеллект? Расследование деградации ChatGPT, Claude, Gemini и других LLM

Всем привет! Недавно я вновь сменил свою основную LLM-модель. Долгое время пользовался Claude, потом перешел на ChatGPT, затем на Gemini, и вот опять оплатил Claude и снова отменил подписку. Почему? Потому что Gemini, который поначалу казался невероятно мощным, в какой-то момент просто перестал справляться с моими основными задачами, а до этого так же сделал Claude и ChatGPT. Они стали лениться, игнорировать части промпта и выдавать поверхностные ответы.

И эта ситуация меня так доконала, что я решил как следует разобраться в вопросе. Действительно ли современные LLM-модели глупеют, ленятся и деградируют через некоторое время после выхода, или это все-таки мои субъективные ощущения и эффект привыкания или завышенных ожиданий?

Об Авторе:

Меня зовут Илья, я техноблогер, нейро-евангелист, со-основатель нейросети для создания изображений ArtGeneration.me [1] и единого AI шлюза для бизнеса Piper.my [2]. А чтобы было интереснее, наше сегодняшнее исследование мы проведем в стиле нуарного детектива. Я решил подойти к этому вопросу как к настоящему расследованию: собрать показания, изучить улики, вскрыть мотивы и, наконец, вынести вердикт.

❯ Глава 1: Слухи на Улицах

Любое расследование начинается со слухов. Город гудел, как потревоженный улей. Из каждого темного угла, из каждого прокуренного бара, которым на время стали Reddit, Hacker News и Twitter, доносился один и тот же шепот: «Они уже не те».

Я начал собирать показания.

Первыми заговорили кодеры. Они жаловались, что модели, которые раньше выдавали элегантный и рабочий код, теперь ленятся, оставляют заглушки // implement logic here и требуют постоянной ручной правки. Затем к ним присоединились писатели и креативщики. Они сетовали на потерю «искры» — вместо ярких идей они получали выхолощенный, стерильный корпоративный текст. А потом подтянулись и аналитики. Их истории были о «контекстной амнезии»: модель блестяще решает первую часть задачи, но напрочь забывает [3] о второй и третьей.

Что особенно бросалось в глаза — это глобальный характер проблемы. Жалобы из Сеула, где местные СМИ писали об ослаблении логики GPT-4, вторили постам из Берлина, где пользователи констатировали: «GPT-4 wird schlechter» (GPT-4 становится хуже). Показания сходились. И даже только вышедший GPT-5 постоянно путал окончания и вставлял заглушки вместо текста статьи. Это не было похоже на массовую истерию. Слишком много профессионалов, слишком похожие симптомы. Я понял, что передо мной не просто паранойя, а настоящее дело.

❯ Глава 2: Неопровержимые Улики

Слухи — это одно, но мне нужны были холодные факты. Что-то, что можно положить на стол судье. И вскоре отчет из лаборатории был готов. Это было исследование от парней из Стэнфорда и Беркли, посвященное феномену, который в академических кругах называют «LLM Drift» [4] (дрейф моделей).

Исследователи беспристрастно сравнили производительность двух версий GPT-4 — за 14 марта 2023 года (gpt-4-0314) и 13 июня 2023 года (gpt-4-0613). Отчет говорил сам за себя:

-

В задаче на определение простых чисел точность GPT-4 упала с 84.0% до 51.1%. Причина? Июньская версия просто перестала следовать инструкции «думай пошагово» (Chain-of-Thought). Вместо логической цепочки она выдавала короткий и часто неверный ответ.

-

В генерации кода доля «напрямую исполняемого» кода на задачах LeetCode рухнула с 52.0% до 10.8%. Причина? Июньская версия начала «украшать» код разметкой Markdown, делая его нерабочим без ручной чистки.

Это был «дымящийся пистолет». Объективное, измеримое доказательство того, что интеллект [5] был ранен. И ранен серьезно, всего через три месяца после триумфального запуска. Но тут в деле появился странный поворот. Данные с краудсорсинговой платформы LMSys Chatbot Arena [6], где тысячи пользователей вслепую сравнивают модели, не показывали такого же резкого падения. Рейтинг Эло флагманских моделей оставался стабильно высоким.

Как это возможно? Модель одновременно и глупеет, и нет? Этот парадокс [7] указывал на то, что «деградация» — это не общее снижение IQ, а что-то более тонкое, связанное с потерей надежности в самых сложных задачах. Я понял, что это не несчастный случай.

❯ Глава 3: Мотивы Преступления

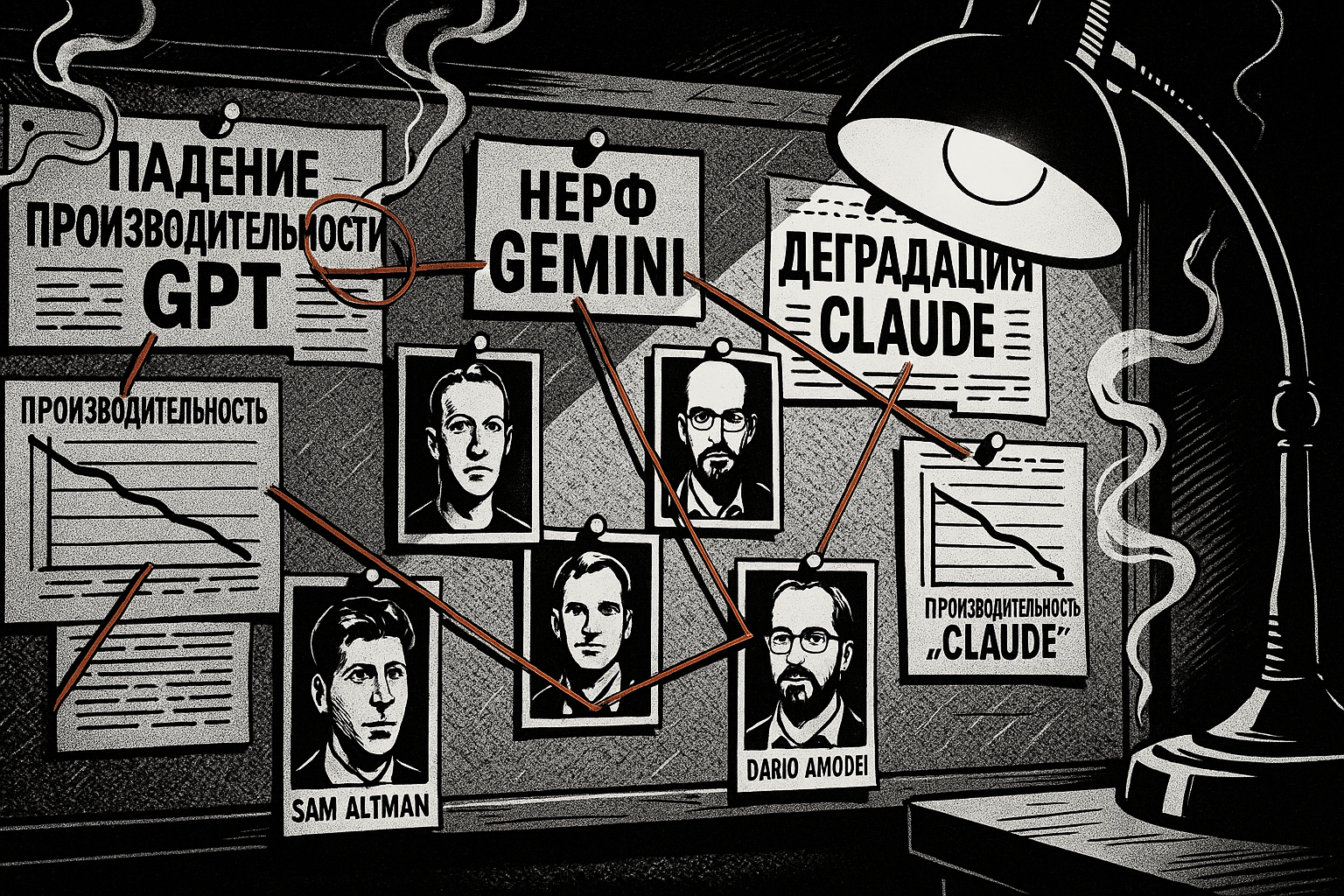

Кто мог желать смерти интеллекту? Имена на вершине списка были известны всем в этом бизнесе: OpenAI, Google, Anthropic. Но каков мотив? В таких делах их обычно два: деньги или идеология. Здесь было и то, и другое.

Чтобы понять мотив, я начал изучать публичные заявления ключевых фигур.

-

Первый мотив: Экономика. Содержание флагманских LLM стоит целое состояние. Инсайдеры шепчутся, что ежедневные расходы на ChatGPT могут достигать сотен тысяч долларов. Андрей Карпати [8] из OpenAI не раз намекал на колоссальные вычислительные затраты, упоминая, что обучение [9] Llama 2 70B обошлось примерно в 2 миллиона долларов. Джефф Дин [10] из Google всю свою карьеру строил системы планетарного масштаба, где эффективность — это закон выживания. Мотив? Банальная экономия. Сделать технологию рентабельной в условиях жесткой ценовой войны, где новые модели вроде GPT-4o Mini [11] уже опустили планку до $0.15 за миллион токенов.

-

Второй мотив: Безопасность. Это уже идеология. Лидеры отрасли боятся, что необузданный интеллект вырвется на свободу. Илья Суцкевер [12], бывший главный ученый OpenAI, сравнивал безопасность ИИ с «ядерной безопасностью». Его уход и основание компании Safe Superintelligence Inc., по слухам, были вызваны опасениями, что OpenAI ставит прибыль выше безопасности. Он прямо заявил, что его новая компания будет «полностью изолирована от… конкурентной крысиной гонки» [13]. Дарио Амодей [14] из Anthropic прямо говорит о «Политике ответственного масштабирования», которая требует вводить ограничения по мере роста возможностей моделей. Этот «налог на безопасность» неизбежно душит производительность, что подтверждается тем же исследованием Стэнфорда: готовность GPT-4 отвечать на «чувствительные» вопросы упала с 21% до 5%.

Я понял, что корпорации оказались в «двойном захвате». С одной стороны, рынок требует снижать цены. С другой — идеологи требуют вводить «налог на безопасность». Воспринимаемая деградация — это то, что остается от модели, когда ее сжимают между этими двумя тисками.

❯ Глава 4: Орудия Оптимизации

Я знал мотив. Теперь нужно было понять, каким оружием было совершено преступление. Эксперты из технических блогов и академических статей (1 [15], 2 [16], 3 [17]) дали однозначный ответ. Орудий было несколько, и все они относятся к классу «оптимизаций».

-

Квантование. Это сжатие модели, как JPEG сжимает фотографию. Вы снижаете точность чисел в нейросети. 8-битное сжатие почти незаметно. Но когда в ход идет агрессивное 4-битное, картинка начинает «сыпаться». Исследования показывают [18], что именно на этом рубеже — кто-то назвал его «4-битной стеной» — модели резко теряют в способности к сложным рассуждениям. Например, результат модели Qwen3 в бенчмарке MMLU падает с 74.7 до 69.3. Другие исследования говорят о падении точности в задачах на рассуждение на 10-30% [19].

-

Дистилляция. Это создание идеального, но бездушного двойника. Берется огромная, дорогая модель-«учитель» и заставляет ее обучать маленькую, быструю модель-«ученика». «Ученик» отлично справляется с рутиной, но, как показывают обзоры [20], ему не хватает глубины и интуиции [21] «учителя», несмотря на то что модель знает ответы, у неё нет информации и рассуждений которые к ним привели.

-

Прунинг (Прореживание). Это хирургическое удаление «лишних» нейронных связей. Исследования SparseGPT [17] показывают, что из массивных моделей можно безболезненно удалить до 50-60% весов. Это доказывает их колоссальную избыточность, но и намекает на риски, если хирург дрогнет рукой.

-

Mixture of Experts (MoE). Это самое хитрое оружие. Вместо одной большой нейросети используется «комитет» из множества мелких «экспертов». Специальный «диспетчер» решает, к какому эксперту направить ваш запрос. Это делает систему дешевле, но вносит элемент случайности [22]. Иногда ваш сложный вопрос попадает к «эксперту по поэзии», а иногда — просто к тому, кто свободен. Отсюда и нестабильность ответов.

Еще одна важная улика — обманчивость метрики перплексии (Perplexity). Компании могут с гордостью заявлять, что перплексия после оптимизации почти не изменилась. И это будет правдой. Вот только перплексия, как утверждают критики [23], плохо измеряет способность к сложным рассуждениям. Она отражает лишь лингвистическую беглость. Модель может говорить гладко, как и раньше, но при этом стать значительно глупее.

❯ Глава 5: Ненадежный Свидетель

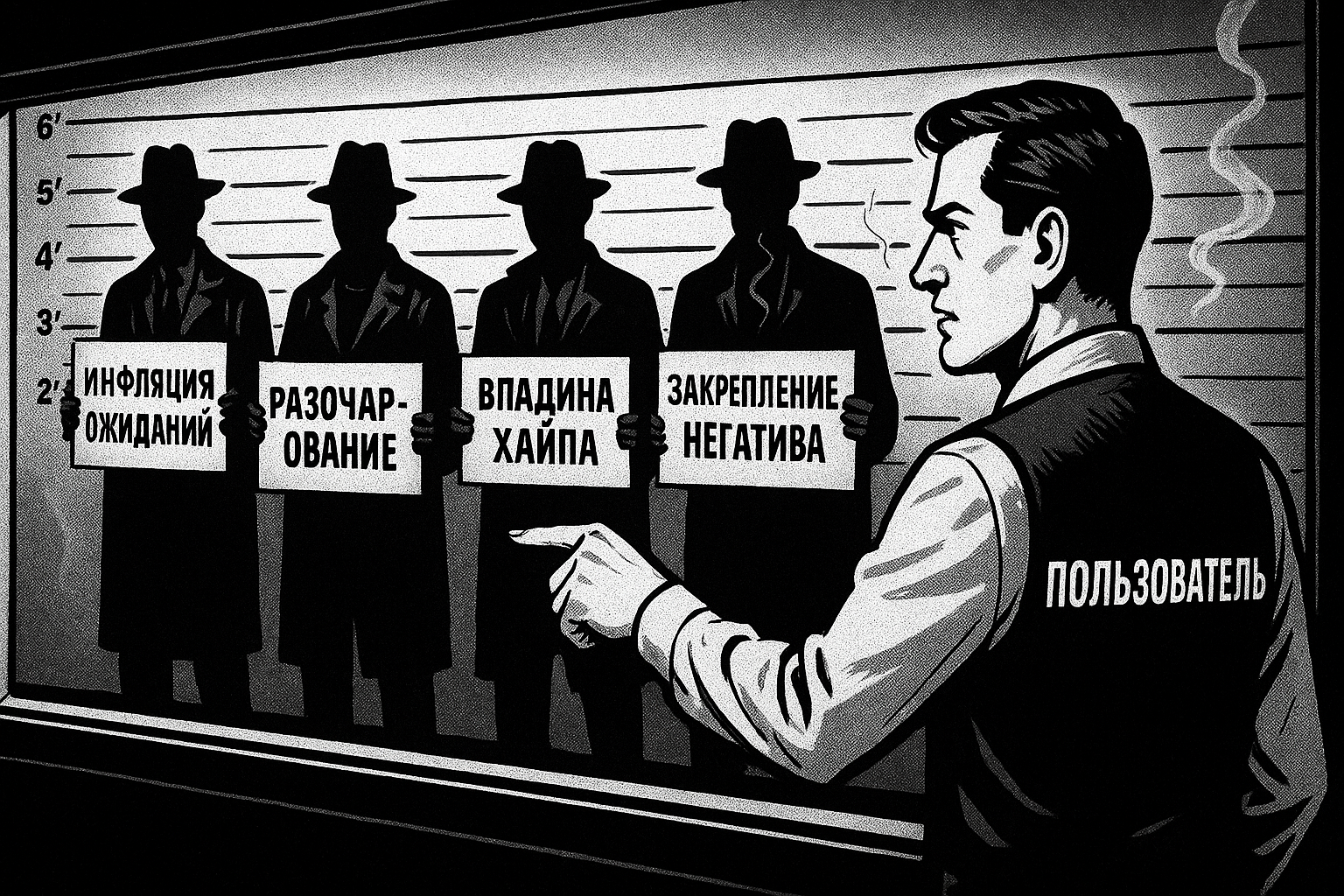

Дело казалось ясным. Но хороший детектив всегда задает себе вопрос: а можно ли доверять свидетелям? Даже если они говорят правду. Я начал изучать психологический профиль главного свидетеля — Пользователя.

И обнаружил целый психологический каскад, который создает идеальный шторм для восприятия [24] деградации:

-

Инфляция Ожиданий: При первом контакте включается Эффект Элизы [25] — мы неосознанно очеловечиваем ИИ и приписываем ему сверхспособности.

-

Неизбежное Разочарование: Постоянное использование вскрывает ограничения. Возникает разрыв между завышенными ожиданиями и реальностью, что по Теории подтверждения ожиданий (ECT) [26] ведет к неудовлетворенности.

-

Впадина Хайпа: Весь рынок, по оценкам Gartner [27], входит во «впадину разочарования», что создает общий негативный фон.

-

Закрепление Негатива: Включается Предвзятость подтверждения [28]. Теперь мы ищем и замечаем только те случаи, которые подтверждают нашу новую веру: «модель поглупела».

Я понял, что пользователь — «ненадежный рассказчик». Не потому что он лжет, а потому что его восприятие искажено. Реальная, технически обусловленная деградация многократно усиливается нашими собственными психологическими циклами.

❯ Глава 6: Похожие Дела

Дело почти раскрыто. Но оставался один вопрос. Может, это все-таки заговор корпораций? Чтобы проверить это, я заглянул в другой район города — в Open-Source сити.

И что я там увидел? Ту же самую картину. Энтузиасты на сабреддите r/LocalLLaMA [29], которые запускают модели вроде Llama и Mixtral на своем железе, сталкиваются с теми же проблемами. Они сами квантуют модели, чтобы они влезли в их видеокарты, и сами же жалуются: «квантование убило качество» [30], «модель стала глупее» [31]. Они даже придумали свои неформальные тесты, вроде «бананового теста» [32], чтобы выявить сбои в логике [33] у квантованных моделей. А в репозиториях популярных движков вроде vLLM на GitHub [34] можно найти отчеты об ошибках, где разработчики фиксируют измеримое падение точности после применения тех или иных методов квантования.

Это был последний гвоздь в крышку гроба теории о простом «корпоративном заговоре». Если те же «преступления» происходят в некоммерческом, управляемом энтузиастами мире, значит, проблема не в жадности. Проблема в самой технологии.

❯ Дело закрыто

Я сидел в своем офисе. Дождь за окном прекратился. Дело было закрыто. Но удовлетворения я не чувствовал. Не было ни злодея, ни гениального преступника. Ответ на вопрос «Кто убил интеллект?» оказался до банального прост.

❯ Никто. И все сразу.

Интеллект не убили. Его сделали рентабельным.

Воспринимаемая нами деградация — это не баг и не заговор. Это эмержентное свойство, возникающее на пересечении трех реальностей:

-

Экономической: Обслуживание моделей стоит непосильно дорого без оптимизации.

-

Инженерной: Современные методы оптимизации, особенно за «4-битной стеной», имеют измеримую цену в виде снижения производительности.

-

Психологической: Наше восприятие следует предсказуемому циклу от восторга к разочарованию.

Стратегия корпораций проста и логична:

-

Приманка: Выпустить на рынок полноразмерную, неоптимизированную модель, чтобы влюбить в себя мир и победить в бенчмарках.

-

Подмена: Постепенно перевести массового пользователя на более дешевые, быстрые, но чуть менее «умные» версии.

Они не обманывают нас в прямом смысле слова. Они просто сначала дают нам попробовать прототип из будущего, а затем возвращают в экономические реалии настоящего. И в этом дождливом, неоновом городе это, пожалуй, самый холодный и расчетливый бизнес, который я когда-либо видел.

А какие у вас были самые запоминающиеся моменты, когда привычная нейросеть внезапно глупела? Замечали ли вы этот тренд в своей работе? Делитесь своими историями и мнениями в комментариях!

Я делаю обзоры на всякие штуки и рассказываю о нейросетях у себя на YouTube [35], в Телеграм [36]и на Бусти [37]. Буду рад вашей подписке и поддержке. Всех обнял и удачных генераций!

Новости, обзоры продуктов и конкурсы от команды [38]Timeweb.Cloud [39] — в нашем Telegram-канале [38] ↩

📚 Читайте также:

Автор: timonin

Источник [46]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/18364

URLs in this post:

[1] ArtGeneration.me: https://ArtGeneration.me

[2] Piper.my: https://Piper.my

[3] забывает: http://www.braintools.ru/article/333

[4] «LLM Drift»: https://arxiv.org/abs/2307.09009

[5] интеллект: http://www.braintools.ru/article/7605

[6] LMSys Chatbot Arena: https://chat.lmsys.org/?leaderboard

[7] парадокс: http://www.braintools.ru/article/8221

[8] Андрей Карпати: https://christophergs.com/blog/intro-to-large-language-models-llms

[9] обучение: http://www.braintools.ru/article/5125

[10] Джефф Дин: https://research.google/people/jeff/

[11] GPT-4o Mini: https://buttondown.com/ainews/archive/ainews-mini-nemo-turbo-lite-smol-models-go-brrr/

[12] Илья Суцкевер: https://www.lesswrong.com/posts/TpKktHS8GszgmMw4B/ilya-sutskever-s-thoughts-on-ai-safety-july-2023-a

[13] «полностью изолирована от… конкурентной крысиной гонки»: https://www.get.inc/blog/open-ai-co-founder-launches-his-own-ai-startup-with-a-inc-domain

[14] Дарио Амодей: https://www.anthropic.com/news/uk-ai-safety-summit

[15] 1: https://arxiv.org/html/2502.13178v1

[16] 2: https://developer.nvidia.com/blog/measure-and-improve-ai-workload-performance-with-nvidia-dgx-cloud-benchmarking/

[17] 3: https://arxiv.org/pdf/2301.00774

[18] Исследования показывают: https://arxiv.org/html/2505.02214v1

[19] падении точности в задачах на рассуждение на 10-30%: https://www.reddit.com/r/ArtificialInteligence/comments/1jvtgiq/impact_of_quantization_on_language_model/

[20] обзоры: https://aclanthology.org/2024.acl-long.587.pdf

[21] интуиции: http://www.braintools.ru/article/6929

[22] случайности: http://www.braintools.ru/article/6560

[23] утверждают критики: https://arxiv.org/abs/2405.06105

[24] восприятия: http://www.braintools.ru/article/7534

[25] Эффект Элизы: https://en.wikipedia.org/wiki/ELIZA_effect

[26] Теории подтверждения ожиданий (ECT): https://open.ncl.ac.uk/theories/14/expectation-confirmation-theory/

[27] Gartner: https://www.gartner.com/en/articles/hype-cycle-for-artificial-intelligence

[28] Предвзятость подтверждения: https://ppig.org/files/2010-PPIG-22nd-Calikli.pdf

[29] r/LocalLLaMA: https://www.reddit.com/r/LocalLLaMA/

[30] «квантование убило качество»: https://www.reddit.com/r/LocalLLaMA/comments/17hd9ie/180b_airoboros_221_model_released_for_localchads/

[31] «модель стала глупее»: https://www.reddit.com/r/LocalLLaMA/comments/1csqaac/now_that_some_of_the_dust_has_settled_are_llama_3/

[32] «бананового теста»: https://www.reddit.com/r/LocalLLaMA/comments/1c67c62/mixtral_8x22b_does_not_know_where_the_banana_is/

[33] логике: http://www.braintools.ru/article/7640

[34] vLLM на GitHub: https://github.com/vllm-project/vllm/issues

[35] YouTube: https://www.youtube.com/@nerual_dreming

[36] Телеграм : https://t.me/nerual_dreming

[37] Бусти: https://boosty.to/neuro_art

[38] Новости, обзоры продуктов и конкурсы от команды : https://t.me/timewebru

[39] Timeweb.Cloud: http://Timeweb.Cloud

[40] : https://habr.com/ru/companies/timeweb/articles/845410/

[41] Выбираем лучший ультраширокий монитор летом 2025: история о том, как я заставил ИИ спорить с самим собой: https://habr.com/ru/companies/timeweb/articles/929800/

[42] Нейро-дайджест: ключевые события мира AI за 2 неделю августа 2025: https://habr.com/ru/companies/timeweb/articles/936978/

[43] Как я полюбил LESS, избавился от копипасты в CSS-коде, сделал его безопаснее, а разметку семантической: https://habr.com/ru/companies/timeweb/articles/930900/

[44] Великое вымирание: как ИИ разрушает интернет: https://habr.com/ru/companies/timeweb/articles/924666/

[45] Деплоим Spring Boot приложение через Docker Compose в Timeweb Cloud за 10 минут: https://habr.com/ru/companies/timeweb/articles/936148/

[46] Источник: https://habr.com/ru/companies/timeweb/articles/935208/?utm_campaign=935208&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.