GPT-OSS-20B – 120B: Сухие цифры после реальных тестов

OpenAI выпустила GPT-OSS модели (https://huggingface.co/openai/gpt-oss-20b [1] и https://huggingface.co/openai/gpt-oss-120b [2]) , и сообщество немедленно начало экспериментировать. Но реальные бенчмарки производительности найти сложно. В этой статье представлены результаты нашего практического тестирования на арендованном железе через RunPod с использованием Ollama.

Ремарка: Тесты проводились на Ollama для быстрого деплоя. Если будете использовать vLLM, то производительность будет примерно +30%, но он слабо адаптирован под консьюмерские GPU, за исключением RTX 5090.

Что тестировалось:

-

GPT-OSS-20B на RTX 4090 и RTX 5090

-

GPT-OSS-120B на H100 PCIe (80GB)

-

6 различных типов промптов для оценки производительности

Методология тестирования

Железо и конфигурация

|

Модель |

GPU |

VRAM |

|---|---|---|

|

GPT-OSS-20B |

RTX 4090 |

24 GB |

|

GPT-OSS-20B |

RTX 5090 |

32 GB |

|

GPT-OSS-120B |

H100 PCIe |

80 GB |

Набор тестовых промптов

Для тестирования использовалось 6 промптов разной сложности и назначения:

-

Логические загадки — серия связанных загадок с объяснением логики

-

Быстрый Q&A — короткий философский вопрос о дедлайнах и черных дырах

-

Алгоритмическая задача — классическая задача с 8 шарами и весами

-

Генерация кода — Game of Life на Python с дополнительными фичами

-

Творческий текст — гайд по выживанию джуниора в IT

-

Философский поток сознания — самосознание нейросети

Пример одного из промтов:

На собеседовании в FAANG компанию тебе задали вопрос:

У тебя есть 8 шаров. Один из них тяжелее остальных. У тебя есть весы, которые показывают только какая чаша тяжелее (без веса). Какое минимальное количество взвешиваний нужно, чтобы гарантированно найти тяжелый шар?

Объясни алгоритм поиска пошагов

Подготовка и загрузка моделей

1) Для начала скачиваем контейнер Docker для Ollama [3]

2) Затем, скачиваем наши с вами модели. Ссылаться буду на официальную инструкцию (https://gpt-oss.com [4]):

ollama pull gpt-oss:20b

ollama run gpt-oss:20b

3) После этого, по Endpoint обращаемся к нашей с вами модели.

curl -X POST http:/<ВАШ IP / ДОМЕН>/api/generate

-H "Content-Type: application/json"

-d '{

"model": "gpt-oss:20b",

"prompt": "Привет, как дела?",

"stream": false

}'

Результаты тестирования

Ниже приведу числа, какой TPS (tokens / seconds) на разном железе по двум моделям:

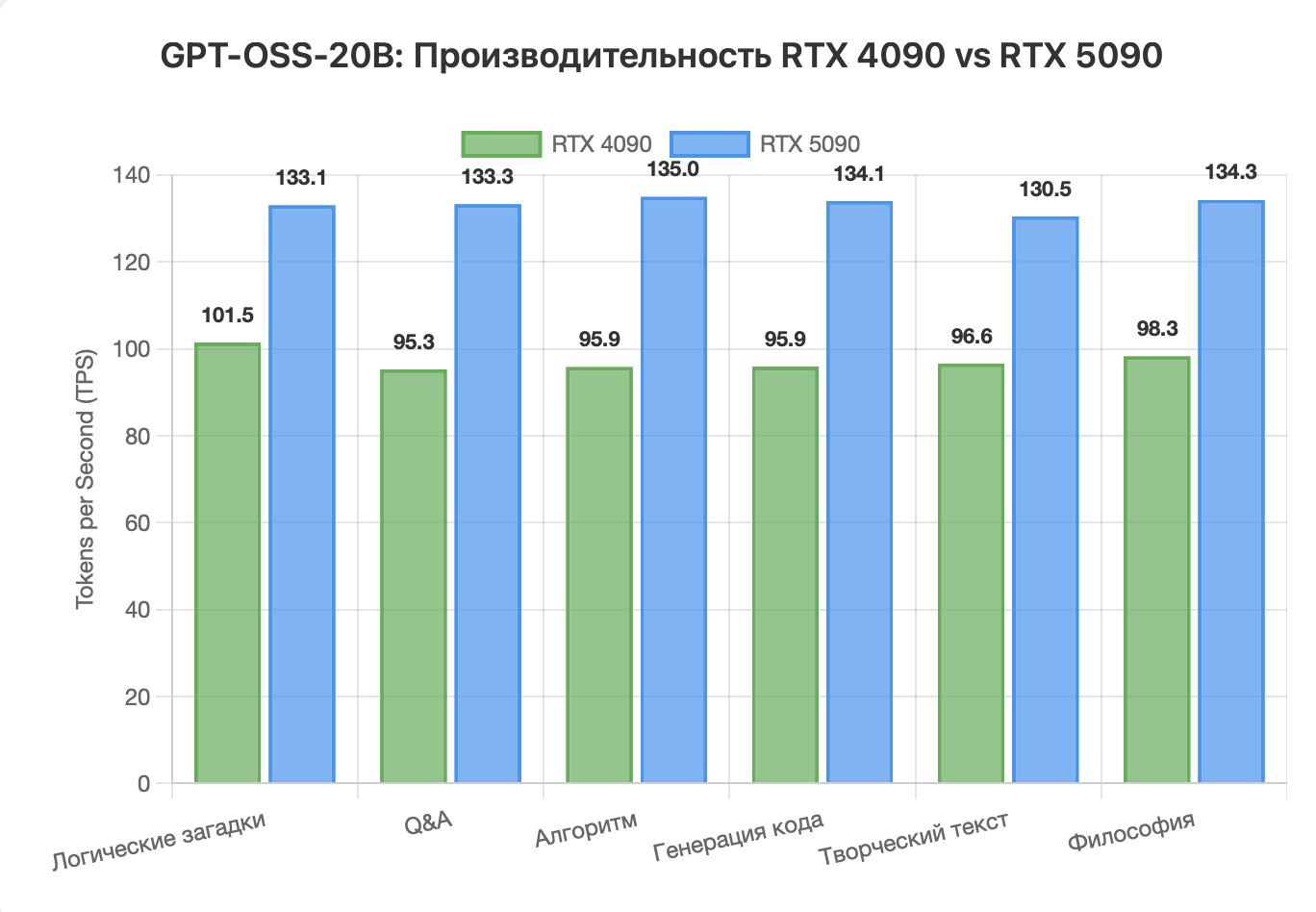

GPT-OSS-20B

|

Тест |

RTX 4090 TPS |

RTX 5090 TPS |

Прирост |

|---|---|---|---|

|

Логические загадки |

101.49 |

133.09 |

+31.1% |

|

Q&A |

95.32 |

133.33 |

+39.9% |

|

Алгоритм |

95.86 |

135.03 |

+40.8% |

|

Генерация кода |

95.94 |

134.05 |

+39.7% |

|

Творческий текст |

96.64 |

130.52 |

+35.1% |

|

Философия |

98.32 |

134.33 |

+36.6% |

|

Средний TPS |

97.26 |

133.39 |

+37.2% |

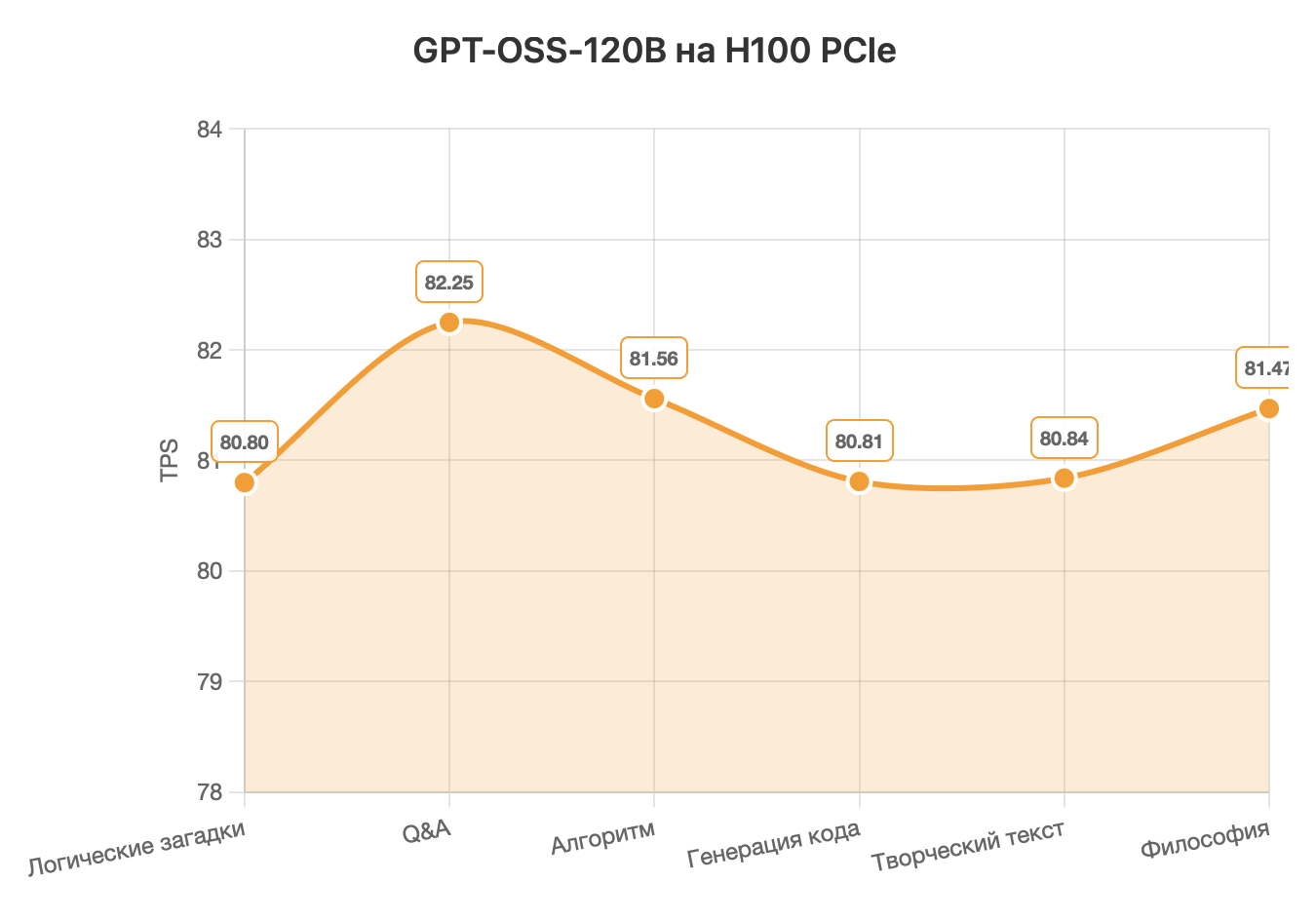

GPT-OSS-120B на H100 PCIe

|

Тест |

TPS |

Токенов сгенерировано |

Время генерации |

|---|---|---|---|

|

Логические загадки |

80.80 |

2048 |

25.35 сек |

|

Q&A |

82.25 |

653 |

7.94 сек |

|

Алгоритм |

81.56 |

1024 |

12.56 сек |

|

Генерация кода |

80.81 |

3146 |

38.92 сек |

|

Творческий текст |

80.84 |

3421 |

42.66 сек |

|

Философия |

81.47 |

1536 |

18.85 сек |

|

Средний TPS |

81.29 |

– |

– |

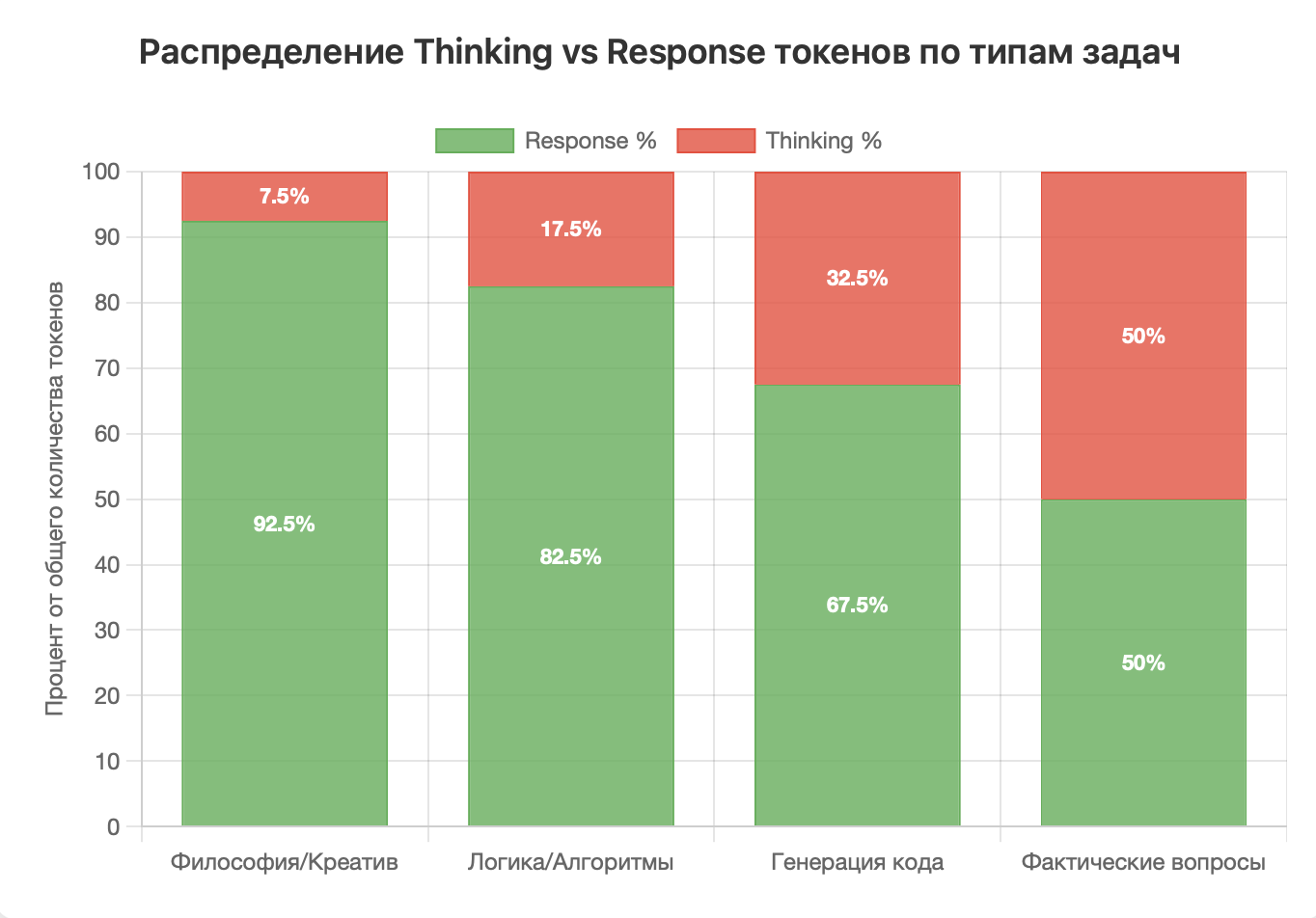

Особенность: “Thinking” токены

GPT-OSS использует встроенный Chain-of-Thought механизм. Модель генерирует невидимые пользователю “thinking” токены перед основным ответом. И важная деталь заключается в том, что они тоже являются частью output токенов.

Условно, у вас стоит num_predict 2048. И перед тем как ответить, модель использовала 700 токенов “на подумать” и в реальный ответ у вас останется 1348.

Интересное наблюдение, которое можете увидеть сверху — gpt‑oss-20b/120b тратит кратно больше токенов output на thinking, когда речь идет об анализе каких‑либо фактов, но совсем «не парится», когда запрос от пользователя поступил по теме «Креатив», по типу «напиши мне статью» и т. д.

Примеры ответов модели

GPT-OSS-120B: Дедлайн vs Черная дыра

Запрос:

{

"model": "gpt-oss:120b",

"prompt": "Быстрый вопрос: что общего между дедлайном и горизонтом событий черной дыры?",

"stream": false,

"options": {

"num_predict": 2048,

"temperature": 0.7

}

}

Ответ:

{

"model": "gpt-oss:120b",

"created_at": "2025-08-12T12:34:49.409905913Z",

"response": "Дедлайн и горизонт событий черной дыры – это два разных явления, но они разделяют одну фундаментальную черту: это «границы нулевого возврата».nn| Что такое | Дедлайн | Горизонт событий |n|-----------|---------|------------------|n| Определение | Конечный срок, после которого выполнение задачи считается недопустимым. | Предел, за которым никакой сигнал, даже свет, не может покинуть черную дыру. |n| Ключевая черта | После него «победить» уже невозможно: задача считается пропущенной. | После него любой объект, даже свет, «потерян» – он не может выйти наружу. |n| Время | Часовой «пульс» – вы видите, как время истекает. | Время «застревает» – для внешнего наблюдателя объект замедляется и исчезает. |n| Каскадные последствия | Задержки приводят к штрафам, конфликтам, потере репутации. | Внутри горизонта всё, включая информацию, исчезает из наблюдаемой Вселенной. |n| Эмоциональный отклик | Тревога, стресс, ощущение «потерянности» в работе. | Фантастическое чувство «потерянности» в космосе, страх перед неизбежностью. |nnИтак, общность в том, что оба представляют собой точку, после которой «возврат» невозможен – будь то возвращение к сроку или к внешнему миру. Это граница, за которой всё становится недоступным, и она определяет наши действия и решения.",

"thinking": "We need to answer in Russian. The question: "Быстрый вопрос: что общего между дедлайном и горизонтом событий черной дыры?" They ask: "What is common between a deadline and the event horizon of a black hole?" We should answer conceptually: both represent boundaries beyond which you cannot escape or return, both involve time constraints, both have a point of no return, both are defined by limits of causality, etc. The answer can be humorous or philosophical: both are "point of no return", both involve time, both are something that once crossed you cannot get back, etc. Provide a concise answer. The user asked "Быстрый вопрос" so we should keep it short. But we can give a thoughtful explanation. We'll respond in Russian.",

"done": true,

"done_reason": "stop",

...

Технические находки

1. VRAM использование

-

GPT-OSS-20B на RTX 4090: ~15 GB (67% от доступных 24 GB)

-

GPT-OSS-20B на RTX 5090: ~15 GB (62% от доступных 32 GB)

-

GPT-OSS-120B на H100 PCIe: ~70-75 GB (88-94% от доступных 80 GB)

2. Стабильность производительности

Разброс TPS в пределах одного GPU:

-

RTX 4090: ±3.1% от среднего

-

RTX 5090: ±2.3% от среднего

-

H100 PCIe: ±1.2% от среднего

3. Латентность

Среднее время на токен:

-

RTX 4090: 10.31 ms

-

RTX 5090: 7.48 ms

-

H100 PCIe (120B): 12.30 ms

Выводы

В статье я не указывал результаты всех ответов, иначе статья превратилась бы в полотно сырого JSON. Однако, мой вердикт следующий — мне очень понравилась модель GPT‑OSS-20B. Помимо того, что она маленькая, так еще и внутри нее стоит неплохой трехуровневый reasoning (Low, Medium, High), который сильно влияет на финальный ответ. Так еще и объективно ресурсов мало требует, а скорость ответов, как в пользовательском интерфейсе обычного ChatGPT.

Если вы рассматриваете вариант развернуть модель ИИ локально, то 20B — это золотая середина, между качеством и скоростью. Хотя качеством она меня пока еще и не обижала.

Что же до 120B, то я не сомневаюсь в том, что она умная и сообразительная. Но для бизнес кейсов, или для ежедневных рутинных задач, малой модели GPT‑OSS хватит спокойно.

Автор: Dmitrii-Chashchin

Источник [5]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/18529

URLs in this post:

[1] https://huggingface.co/openai/gpt-oss-20b: https://huggingface.co/openai/gpt-oss-20b

[2] https://huggingface.co/openai/gpt-oss-120b: https://huggingface.co/openai/gpt-oss-120b

[3] контейнер Docker для Ollama: https://hub.docker.com/r/ollama/ollama

[4] https://gpt-oss.com: https://gpt-oss.com

[5] Источник: https://habr.com/ru/articles/938960/?utm_source=habrahabr&utm_medium=rss&utm_campaign=938960

Нажмите здесь для печати.