Я был дизайнером 6 лет, делал картинки для новостей, а потом пришла нейросеть

Эту историю для моего блога рассказал Алексей Перминов

В 2022 году я был простым дизайнером в пиар-отделе — оформлял социальные сети, делал картинки к новостям. Думал, что так и буду всю жизнь постики клепать.

Сейчас работаю полноценно на внешних заказчиков нашей компании. У меня теперь, помимо графического дизайна для SMM, и интерфейсы, и 3D, и моушен.

В этой статье расскажу, как нейросети превратили меня из узкого SMM-специалиста в многопрофильного креатора, покажу реальные кейсы и поделюсь работающими техниками, которые использую каждый день.

Как создавали концепцию сайта для грузоперевозчиков

Задача: В концепте для фирмы грузоперевозок показать, что мы вообще что угодно доставить можем. Даже AI Стартап с Индусами доставим, куда надо

тап 1: От идеи к визуалу

Недавно у нас появился клиент — фирма грузоперевозок с маяком на логотипе. Хотели оригинальный сайт с забавной идеей. На созвоне родилась концепция: маяк-ракета. Скроллим сайт, везде маяк, а в конце оказывается, что это ракета.

Пошли в GPT, потому что он делает хорошо понимает промпт и быстро генерирует, сгенерировали маяк с ракетой, чтобы показать заказчику концепт:

Описал трансформацию маяка в ракету, добавил драматичное раскрытие – dramatic reveal, plot twist visual, то есть объяснил нейросети сюжет и настроение: не просто статичную картинку маяка-ракеты, а именно момент превращения с кинематографическим эффектом неожиданности.

Нейросеть должна была передать эмоцию [1] удивления и динамику трансформации, а не просто нарисовать гибрид маяка и ракеты.

Еще был запрос про мини-игру — скинул референс Flappy Bird и сказал: птицу замени на корабль, добавь море на фон:

Клиент хотел интерактив на сайте, предложили игровое заполнение посадочного талона для груза, тут отправляем додж из Парижа в Рим. С географией у нейронок плохо, но для концепта это не столь важно:

Дополнительно клиенты хотели сторителлинг.

Главное, я не говорил нейросети, что это для концепта сайта. У нас была идея в голове, и просил сгенерировать. Сосредоточился только на визуальном результате.

Получили 10-12 концептуальных изображений в разных стилях. Заказчику показали — всё понравилось. Выбрали маяк-ракету как основную концепцию. Правда, потом пришлось приземлять — клиенты поняли, что слишком в абсурдность уходим. Финал — 8 стилистически единых слайдов концепции для 3D-реализации.

Раньше схема была: концепция → иллюстратор → арт-директор → правки → я → 3D-художник. Сейчас всё делал я и одобрял арт-директор. Вместо недели работы с иллюстратором получили готовую концепцию за день. Сократили цепочки согласований и сэкономили бюджет.

Этап 2: Создание набросков от руки

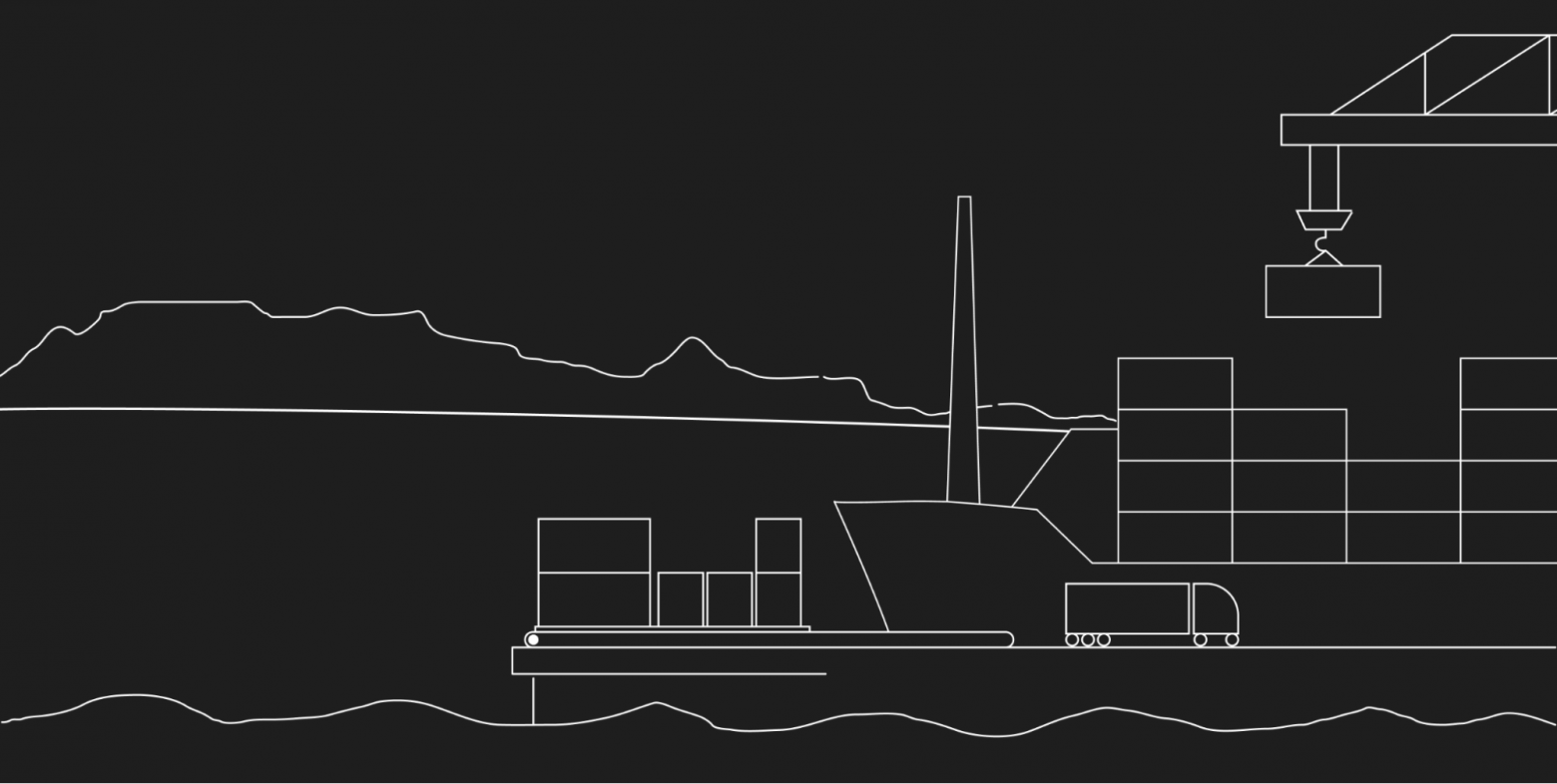

После того, как клиент одобрил базовую идею маяк-ракеты, нужно было создать детальную раскадровку всего сайта. Делал я, одобрял арт директор, но на этапе с 3D подключили нашего 3D и VFX специалиста, чтобы она помогала с шейдерами и оптимизацией сцены.

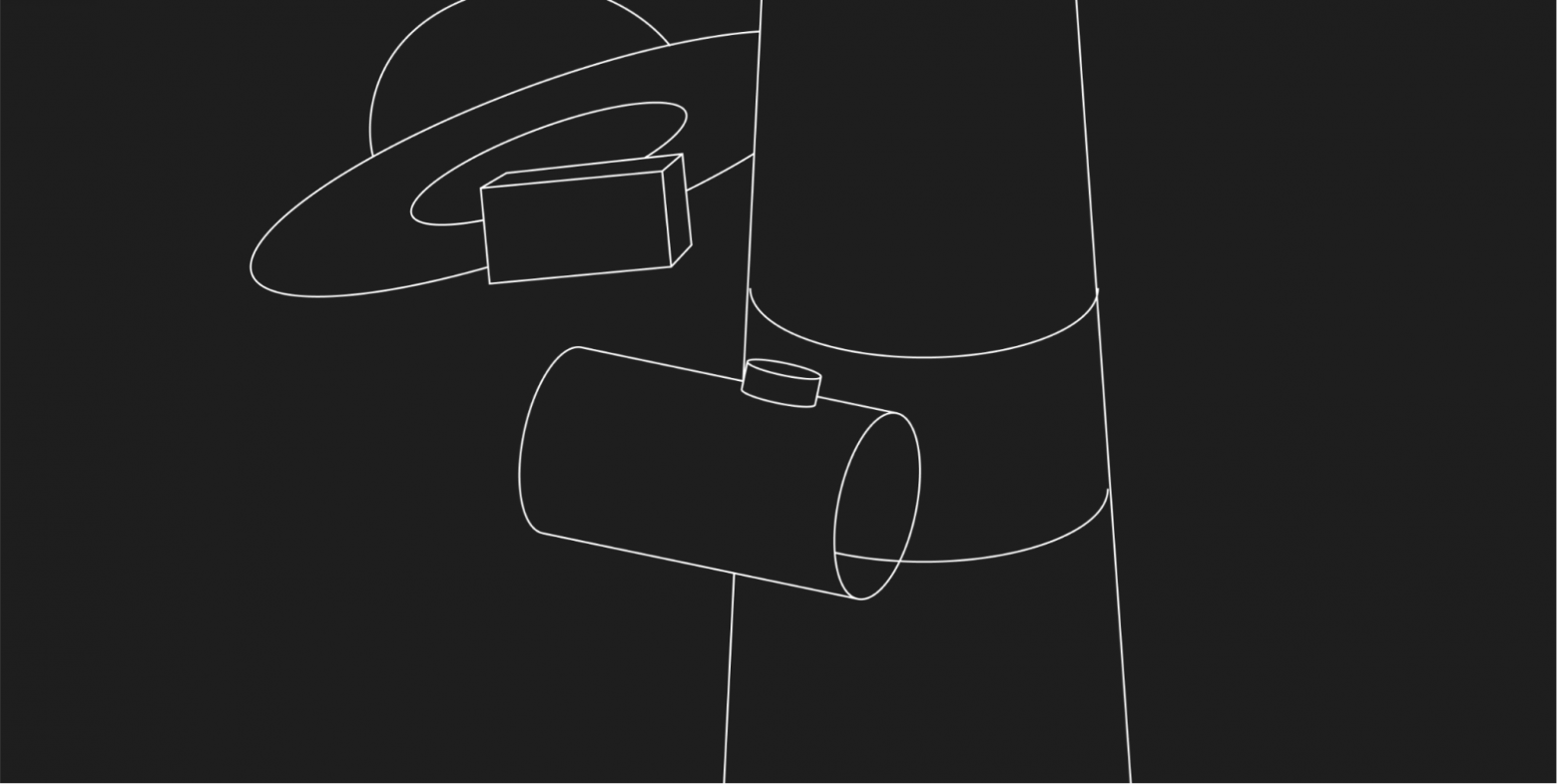

Начал делать более подробные наработки, эскизы, сначала аутлайны в Figma.

Забавно, как мое неумение рисовать руками компенсируется умением в 3D — затридэшил базовую сцену в Blender, а потом руками обводишь контур, и вот у тебя красивый 2D-эскиз. Этот гибридный подход позволяет создавать технически правильную перспективу и композицию даже без навыков академического рисунка.

Схема работы:

-

Blender — создание базовой 3D-сцены с правильными пропорциями

-

Ручная обводка — превращение 3D в 2D-эскиз с нужными деталями

Создавал грубые контуры как раскадровку того, как на каждый скролл что будет происходить — по сути, покадровую анимацию будущего сайта, где при прокрутке страницы маяк постепенно трансформируется в ракету.

Это были совсем простые наброски: палочки вместо людей, прямоугольники вместо зданий, круги вместо кораблей. Цель — показать композицию и движение, а не красоту. Эти контуры станут основой для нейросети, которая превратит их в стилизованные концепты.

Первая проблема возникла сразу — когда отправил простые контуры в нейросеть, она не поняла, что изображено.

Поэтому иногда приходилось делать более детальные скетчи и коллажи, чтобы нейронка лучше поняла, где какой объект находится. Вот такие:

В итоге получили детальные наброски с четко читаемыми объектами, готовые для подачи в нейросеть.

Этап 3: Стилизация

Генерация

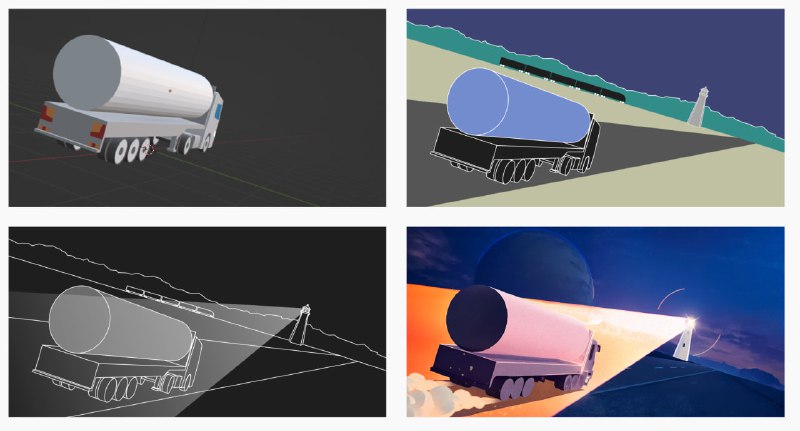

Прямо эти картинки отправлял в Midjourney — у него есть функция retexturing. По сути, он контуры, которые у картинок есть, сохраняет, но поверх них накатывает художественный стиль и что в промте напишешь.

Алгоритм простой:

-

Загружаю аутлайн из Figma

-

Включаю режим retexturing

-

Пишу промт: “cinematic lighting, blue and orange color scheme, industrial maritime atmosphere”

-

Нейросеть сохраняет мою композицию, но делает всё красиво

Когда генерировали следующие, давал ему как стилевой референс первую картинку, чтобы он из неё брал цвета и стиль. Понятное дело, что это не везде получалось, а если и получалось, то не всегда с первого раза, но в целом как вариант — генерируешь сначала одну картинку, а все остальные на её основе — вполне работает.

Пришлось переключаться между инструментами прямо по ходу работы. Часть слайдов делал в Stable Diffusion — он дает больше контроля над стилизацией, когда Midjourney уходит в излишнюю детализацию или мультяшность.

Stable Diffusion — разрабатывали программисты для программистов, а Midjourney — программисты для дизайнеров. Midjourney более артистичный, у него больше художественного вкуса [2], он более казуальный — когда нужно что-то красивое, эскизы приятные и гармоничные. Если человек никогда не работал в нейронках и спрашивает, в какой нейронке лучше что-то поделать, всегда говорю — иди в Midjourney.

Stable Diffusion — более продвинутый уровень, его сложнее устанавливать, но при этом его можно локально использовать. Не зависит от серверов, можно поставить на свой компьютер. Stable Diffusion более управляемый — больше следует промпту, у него больше различных функций для управления генерациями. Например, можно поставить плагин, в котором можно выставить позу, в какой позе будет стоять персонаж. В Midjourney такого нет. Функция retexturing появилась недавно, может, полгода-год назад, и то работает не всегда, и её нельзя настраивать более тонко.

Решили достичь максимально близкого результата, чтобы не запутать клиента, поэтому важно было передать максимально близкие ощущения финального результата. Midjourney с этим не справлялся — либо слишком детально рисовал, либо наоборот, в мультяшность уходил. Поэтому некоторые слайды приходилось делать в Stable Diffusion. Там то же самое — отдаешь скетч, через функцию ControlNet, сохраняя контуры объектов, он просто перекрашивает их и накатывает стиля.

Stable Diffusion также выручает, когда нужна детализация, доработка. Если в Midjourney получилась картинка, но нужно часть изображения где-то замазать, где-то что-то перегенерировать, то здесь уже иду в Stable Diffusion.

Поэтому стратегия такая: начинаю с Midjourney для общей красоты, но если результат не подходит клиенту — переключаюсь на Stable Diffusion для точной настройки.

Таким образом, для каждого слайда определили оптимальный инструмент, получили стилизованные концепты с сохраненной композицией.

Для видео-контента использую другую схему:

-

Midjourney + Recraft — генерация ключевых кадров

-

Photoshop — композитинг элементов

-

Immersity (бывший Leiapix) — создание псевдо-3D эффекта для объема

-

Hailuo (Minimax) и klingAI — анимация статичных изображений

-

After Effects — финальная сборка с звуком и эффектами

Такой пайплайн позволяет создавать динамичные презентации концептов, которые производят на клиентов гораздо больше впечатления [3], чем статичные слайды.

Этап 4: Доработка и постобработка

Очень много было работы с цветокоррекцией.

Сочетания синего и желтовато-оранжевого не получались — нейросеть либо слишком желтый делала, либо слишком оранжевый, либо окрашивала не то, что нужно.

Поэтому много работы с Photoshop было именно в плане цветового. Селективная коррекция, маски, тонкая настройка баланса. По времени столько же, сколько ушло на генерацию, но без этого концепты выглядели бы как поделка студента.

Получили серию из 8 стилистически единых слайдов с единой цветовой палитрой в корпоративных цветах клиента, кинематографическим освещением с правильными тенями, сохраненной композицией из исходных набросков и техничным, но не холодным стилем.

Раньше на такую серию концептов ушло бы недели 2-3 работы иллюстратора плюс несколько итераций согласований. Теперь получил готовые концепты за 4 дня работы. А если бы я был бывшим иллюстратором и быстрее мог что-то править руками, то такое уже реально сделать за день.

Но это точно не волшебная кнопка — половину времени потратил на итерации и цветокоррекцию весли бы я был бывшим иллюстратором и быстрее мог что-то править руками то “традиционный арт + нейросети” и такое можно было бы уже реально за день сделать Photoshop. Экономия не времени, а человеческих ресурсов и головной боли [4] с согласованиями.

Этап 5: 3D-реализация

После одобрения концептов пошли в 3D — полностью ручной труд в Blender. Единственное, что делал через ИИ — генерил текстуры для гор на заднем плане, которые потом использовались в 3D.

GPT помогает писать скрипты для Blender и After Effects — описываешь задачу, получаешь Python-код для автоматизации. Это не про визуал, а про техническую сторону.

Периодически тестирую новые 3D-нейронки — Luma AI, Rodin, Tripo.

3D-навыки развивались не благодаря нейронкам — ИИ просто ускорил некоторые процессы. Раньше часы тратил на поиск готовых материалов, сейчас за минуты генерю нужную текстуру.

В остальном всё делается руками уже. Но время от времени слежу за развитием генеративного 3D AI — понимаю, что это будущее, просто пока не наступило.

Эмоциональная правда работы с нейросетями

Сначала честно про боль. Чем работа с нейросетями отличается от работы в других инструментах? Увлекательно? Вполне. Быстрее? Раз на раз не приходится. Эмоционально трудно? Стопроцентно.

Как происходит процесс работы в традиционных инструментах — Photoshop, After Effects, Blender: есть задача, которую раньше не решал, нет опыта [5], навыков, но задачу решить нужно. Идешь смотреть обучающие ролики на YouTube, читаешь статьи, тратишь несколько утомительных часов, чтобы потыкать самостоятельно, по пути открывая новые функции.

И вот потратил достаточно времени, в результате чего наконец решил поставленную задачу — “Фух! Круто! Я 3D волчара и Моушен ниндзя, я супер крут, я удовлетворен собой и тем, что получил новый опыт и навыки”.

Как происходит процесс работы в Midjourney: садишься и пишешь промты. Много промтов. Промты длинные, промты короткие. Если промты не работают, то нет объективной и понятной причины, почему. То ли у нейросети недостаточно возможностей, то ли глуп и неправильно пишешь промт, то ли просто сила рандома сегодня не на твоей стороне.

Не можешь пойти за обучением [6] на YouTube, а все эти Telegram-каналы по “промт-инжинирингу”, которые якобы узнали все секреты и сейчас ими поделятся — мусор, который на деле не работает или работает рандомно.

И вот сидишь и не понимаешь, на кого злиться — на себя или на робота? А что происходит, когда задача решена? Не испытываешь ничего, разве что желание больше никогда не решать задачи нейросетями, потому что так и не понял — то ли ты крутой спец, который смог подобрать нужный промт, то ли у робота заглючили нейромедиаторы, и он решил сделать одолжение и выдать то, что хотел.

Но есть и другая сторона. Благодаря нейронкам я теперь и концепции делаю, и в 3D пошел, и в моушен пошел. ИИ дает больше многофункциональности, больше ответвлений как специалисту. Раньше, если нужно было делать концепты, шли к художнику. Сейчас могу сам этим заниматься.

Главный вывод: ИИ как переход с лошадей на автомобили, а не конец транспорта

ИИ не уничтожает индустрию дизайна — он предлагает пересесть с лошадей на автомобили. Перевозки никуда не пропали, они все так же существуют, просто все пересели с лошадей на машины и делают это быстрее. Точно так же ИИ не заменяет дизайнера, а расширяет его возможности, позволяя одному специалисту решать задачи целой команды при сохранении качества и креативного контроля.

Нейронки дали мне больше многофункциональности. Раньше я был дизайнером в пиар-отделе на внутренних задачах, а благодаря нейронкам теперь и концепции делаю, и в 3D пошёл, и в Motion пошёл. Чувствую свою важность — есть мышца не только интерфейсы делать, но ещё и красоту в нейронках генерировать.

Но работа с ИИ требует осознанного подхода. Два ключевых принципа:

1. Всегда спрашивай “зачем?

Правило: если можно решить не нейронками, давайте решать не нейронками. Нейросетью решаем только если это быстрее, дешевле, или результат будет красивее и лучше.

2. Это никогда не волшебная кнопка

Люди, не знакомые с нейронками, часто видят красивые картинки и думают — промпт дали нейронке, одну кнопку нажали, она что-то сгенерировала. Зачастую с котиками и красивыми портретами нейросети действительно одной кнопкой справляются. Но если делаешь что-то сложное — концепции сайта — неделю делаем только концепции, и только потом переходим в 3D. Это не волшебная кнопка, и не за два-три часа сделаешь.

ИИ в дизайне — это не революция, это эволюция [7]. И как любая эволюция, она требует времени, терпения и понимания того, что инструмент всегда остается инструментом. Важен тот, кто им управляет.

В телеграм-канале [8] я выложил полный список-шпаргалку из восьми нейросетей для дизайнера. Подпишись, чтобы не пропустить новые статьи!

Автор: neuroAnn

Источник [9]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/18833

URLs in this post:

[1] эмоцию: http://www.braintools.ru/article/9540

[2] вкуса: http://www.braintools.ru/article/6291

[3] впечатления: http://www.braintools.ru/article/2012

[4] боли: http://www.braintools.ru/article/9901

[5] опыта: http://www.braintools.ru/article/6952

[6] обучением: http://www.braintools.ru/article/5125

[7] эволюция: http://www.braintools.ru/article/7702

[8] телеграм-канале: https://t.me/+QsC_R7pQTrwyZGQy

[9] Источник: https://habr.com/ru/articles/941568/?utm_source=habrahabr&utm_medium=rss&utm_campaign=941568

Нажмите здесь для печати.