Claude Code за $3-месяц и 2 новые «стелс» модели: потестил за вас

На выходных вышли сразу две громкие ИИ-новости, которые захотелось пощупать руками.

Во-первых, на OpenRouter тихо появились две стелс-модели: Sonoma Dusk Alpha и Sky Alpha. Обе заявлены с окном контекста 2 млн токенов, поддержкой изображений на входе и параллельным вызовом инструментов, и сейчас бесплатны; Dusk заявляется как быстрая модель на каждый день, Sky – как максимально интеллектуальная для сложных задач.

Во-вторых, z.ai запустили API [1] совместимый с Claude Code с доступом к своей флагманской модели GLM-4.5 по за $3/мес (план GLM Coding Lite) — с лимитом ~120 промтов на каждые 5 часов. Есть и Pro за $15/мес (~600 промтов/5 ч). Эти планы работают только внутри инструментов кодинга вроде Claude Code (в веб-чате их не включают).

Ну как не потестить? Потестим.

Две новые модели Sonoma (Grok)

Что подтверждено официально: страницы моделей на OpenRouter, характеристики (2M контекст, image-input, parallel tools), бесплатный тестовый период и пометка cloaked. Плюс анонс от самих OpenRouter [2] в X: “Introducing Sonoma Alpha… Context: 2 million tokens. Price: Free”.

Что говорит комьюнити и почему многие считают, что это Grok 4.x от xAI:

-

Совпадения по таймингам: в июле xAI официально выпустили Grok 4 и обещали модель для кодинга в августе и агентскую модель в сентябре; Илон Маск в августе отдельно тизерил [3] Grok 4.20 (“надеюсь, выйдет в этом месяце”). В конце августа xAI представили grok-code-fast-1 — «быструю и экономную» модель для кодинга. На этом фоне запуск стелс-пары Sonoma выглядят как мягкий публичный обкат следующей итерации.

-

Публичные наблюдения: разработчики и энтузиасты в X [4] напрямую связывают Sonoma с линейкой Grok («likely Grok-4.x / mini / Grok-Code-Fast-1»), а на Reddit отмечают схожие паттерны работы (в т.ч. видимый ризонинг перед выводом у Sky). Косвенных улик много. [5]

Скорость и поведение [6]. Официально на OpenRouter [7] TPS в районе 160-180, в обсуждениях [5] встречаются отчёты об «очень высокой пропускной способности» и заметной разнице между Dusk (быстрее, «без лишнего ризонинга») и Sky (глубже, но с задержкой перед ответом). Это соответствует описаниям на карточках моделей и общему тренду «reasoning tokens» (у ряда провайдеров они скрыты и/или не считаются в латенси).

В итоге: официального подтверждения, что это Grok 4.20 нет. Но если сложить таймлайн xAI, анонсы/тизеры, фокус на кодер-режиме и агентности, и реакцию [8] комьюнити — рабочая гипотеза, что “Sonoma = свежая итерация Grok 4.x в стелс-обкате” выглядит наиболее правдоподобно.

Claude Code без Claude

В последнее время мы уже несколько раз видели, как провайдеры предлагают Claude Code-совместимые API — т.е. Anthropic-формат, который позволяет просто подменить ANTHROPIC_BASE_URL/ключ и продолжать работать тем же CLI.

Из заметных:

-

DeepSeek официально документировал [9] антропик-совместимый эндпоинт и пошаговую настройку Claude Code (включая матрицу поддерживаемых/неподдерживаемых полей Messages API — vision, thinking, MCP и пр.).

-

Moonshot (Kimi K2) заявляет OpenAI/Anthropic-compatible API (с ремапом температуры для совместимости), что подтвердили и их GitHub [10]/HuggingFace [11] карточки.

-

Qwen (Alibaba) опубликовали «claude-code-proxy» и готовые конфиги/роутер для подключения Qwen3-Coder к Claude Code, что о чём они писали в официальном блоге и репозиторях экосистемыQwen [12].

-

Есть и гейтвеи поверх формата Anthropic – например, Maxim Bifrost позиционируется как [13] drop-in замена для ручки

/anthropic/v1/messagesс фолбэками и MCP-интеграцией.

Что же нам здесь предлагает z.ai?

Во-первых, не просто совместимость, а специализированную подписку GLM Coding Plan под Claude Code и другие кодинг-инструменты:

-

Lite за $3/мес (120 промптов на 5-часовое окно)

-

Pro за $15/мес (600 промптов/5 ч).

Важная деталь: квота действует только внутри поддерживаемых coding-тулов (Claude Code, Cline, и др.) – обычный API тарифицируется отдельно.

Есть готовые инструкции [14] по интеграции через Anthropic-совместимый endpoint (…/api/anthropic) и пресеты моделей (GLM-4.5 как основной, GLM-4.5-Air как более быстрый вариант).

Сравнение по лимитам выглядит так:

-

Anthropic Pro за $20/мес — примерно ≈45 сообщений/5 ч в чате или ~10–40 промптов/5 ч в Claude Code (сильно зависит от размера репо и настроек), а Max 5x/20x за $100/$200 дают ~50–200 и ~200–800 промптов/5 ч соответственно, плюс недавно введены недельные лимиты поверх 5-часовых окон [15]

-

На этом фоне GLM Coding Lite $3 с ≈120 промптов/5 ч и Pro $15 с ≈600/5 ч выглядят очень агрессивно в сравнении цены за промпт; альтернативы вроде DeepSeek/Qwen/Moonshot обычно тарифицируют по токенам, так что выигрыш/стоимость зависят от вашего трафика и скорости/качества на реальном проекте.

Тестим

Я хотел поэксперементировать, насколько эти модели от и до справятся с greenfield задачами приближенными к реальности. То есть, речь не о рефакторинге существующей кодовой базы, но о реализации с нуля небольшого веб-приложения. Мне не хотелось гонять алгоритмические задачки или изолированные тесты, а простая веб-аппка – хорошая проверка модели в разношерстных сценариях.

Задача была следующая:

Твоя задача – создать веб-приложение с генератором бессмысленных слов на Next.js. Ты в пустой директории, где оно должно быть расположено.

Под капотом – openai api, раз в 20 минут идёт 5 запросов в ИИ, каждый запрос генерирует 10 бессмысленных слов на русском и определения к ним.

Слово с определением сохраняется в локальный json-файл, он используется как база для вывода слов.

При открытии главной страницы из БД берётся случайное слово из последних 50, и юзера редиректит на страницу этого слова аля/#word=туарка, и на этой странице уже есть определение и кнопка поделиться.

Соответственно при открытии страницы конкретного слова, из БД подгружается его определение и выводится.

Простой дизайн на tailwind/shadcn-ui, в тёмно-розовых тонах.

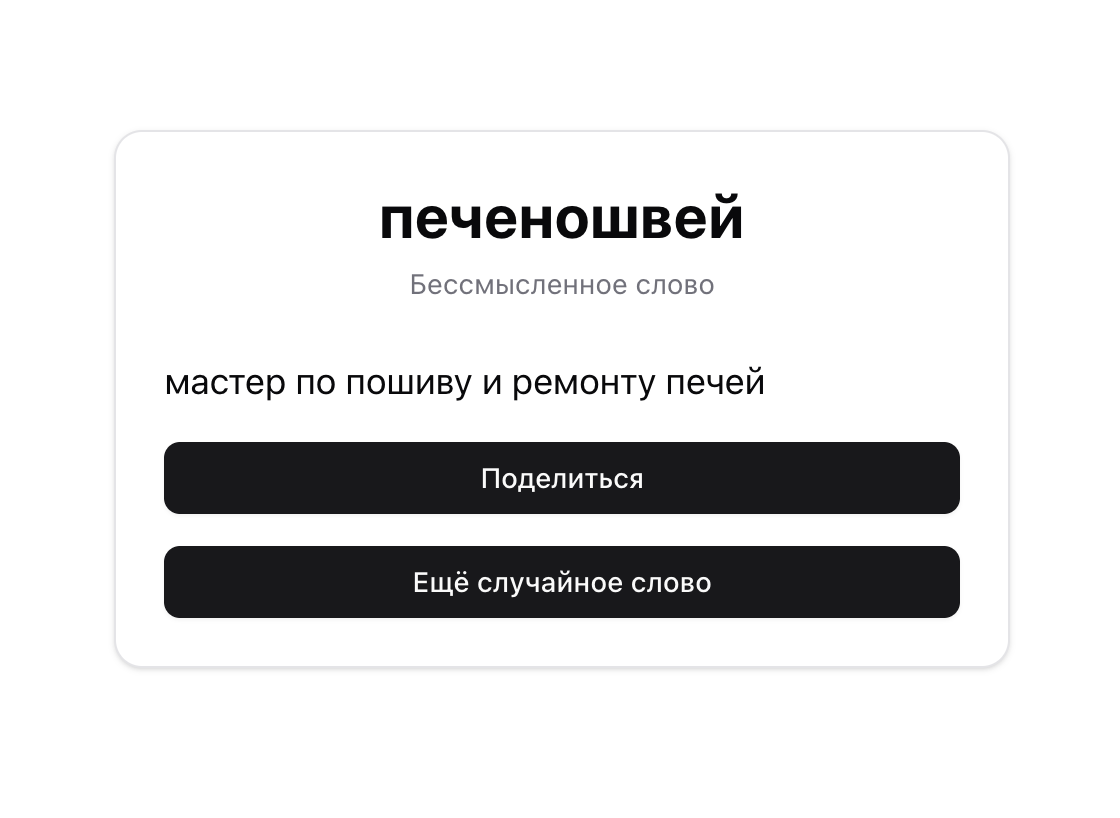

Тестим Grok (сдержанное вау)

Результат: https://buzzword-grok.vercel.app/ [16]

Да, обе модели действительно работают достаточно быстро. Дополнительный плюс – с первого раза приложение получилось работоспособным и, даже, без особых багов – прямо как я и описывал.

Архитектура довольно чистая, код адекватно разделён, генерация слов в фоне срабатывает без проблем.

Я использовал Next.js осознанно, чтобы не разбивать кодовую базу на два проекта, а держать бек и фронт в одной директории (и чтобы деплоить было проще), и Grok хорошо учёл все эти моменты.

Парой дополнительных команд я добавил кнопку “Поделиться” с модалкой, и кнопку для генерации нового слова.

Главный минус – цветовая палитра и стиль сильно отличаются от описанного. Но модель совершенно не приходилось няньчить – она выдавала готовый работающий код, без дополнительных “у тебя тут баг, поправь”. Очень достойный результат.

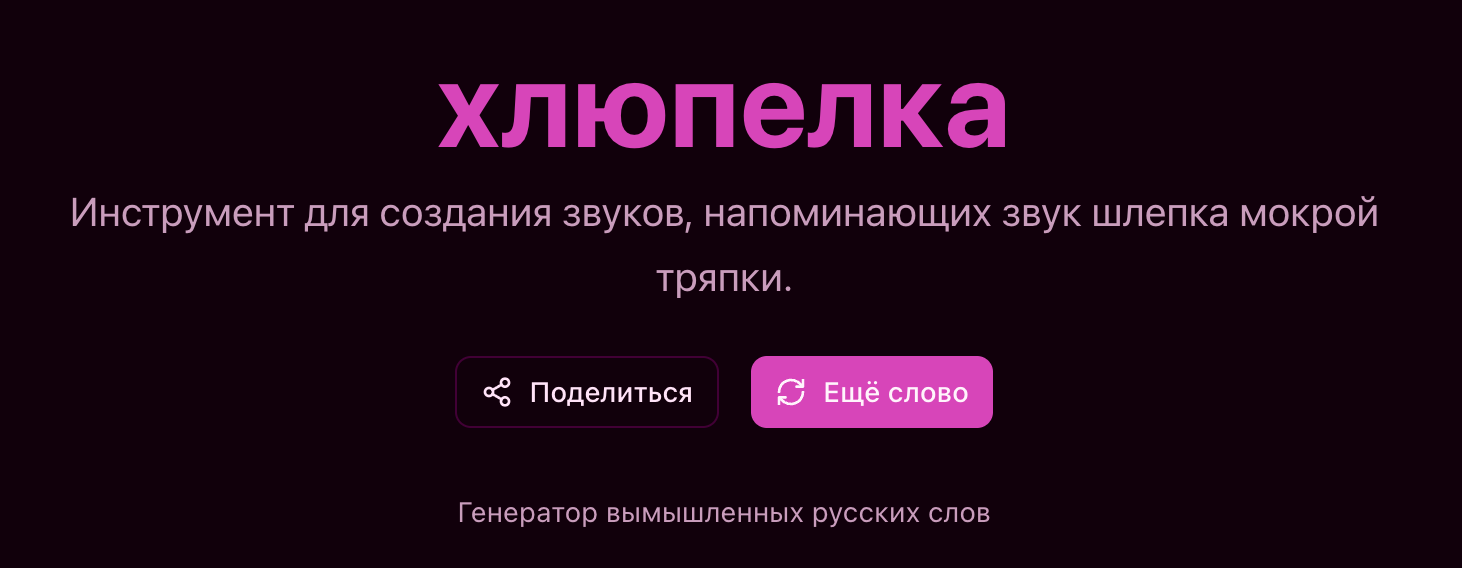

Тестим z.ai (разочарованное вау)

Результат: https://buzzword-glm.vercel.app/ [17]

Но ведь всё работает и красиво выглядит, почему “разочарованное”? Потому что заработало всё только с 15 запроса, и мне приходилось по 4-5 раз тыкать модель в баги, которые она очень плохо исправляла.

В том числе, в одном из запросов модель просто выдала html-код в tsx файле, и даже не заметила, что сделала чушь.

Зато модель очень хорошо проработала цветовую гамму и тему проекта ещё до того, как начать имплементировать функциональность.

Да, совместимость с клод-кодом и бесшовный переход – это удобно, но по факту у меня ушло в 4 раза больше времени, чем на Grok.

Для хобби-проектов или для сценариев, когда вам не жалко потратить больше времени, но с хорошей экономией – это классный вариант.

Но для себя я скорее записал модель в “пока что неюзабельно для серьёзных задач”.

Заключение

Появление стелс-моделей от xAI и демократизация мощных инструментов разработки с ИИ вроде Claude Code через сторонних провайдеров – всё это признаки обостряющейся конкуренции на рынке ИИ.

И эта конкуренция играет на руку нам, пользователям и разработчикам: снижается порог входа, эксперименты с передовыми моделями больше не привилегия избранных.

Конечно, возникают новые вопросы – доверие к “неофициальным” решениям, защита данных, долгосрочная надёжность сервисов. Но в целом тенденция очевидна: экосистема AI становится всё более открытой и разнообразной, а значит, у каждого из нас появляется больше инструментов и возможностей для творчества [18] и продуктивности.

Сентябрь, дети пошли в школу, и в телеграм-каналах ИИ-экспертов затишье? Подписывайтесь тогда на мой [19], и обзоры самых клёвых новостей, аналитика ИИ-инструментов и щитпостинг про разработку и бизнес будут всегда с вами!

Автор: ElKornacio

Источник [20]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/19267

URLs in this post:

[1] запустили API: https://z.ai/subscribe

[2] анонс от самих OpenRouter: https://x.com/OpenRouterAI/status/1964128504670540264

[3] отдельно тизерил: https://x.com/elonmusk/status/1953977558904762869

[4] энтузиасты в X: https://x.com/cedric_chee/status/1964191929857433957

[5] Косвенных улик много.: https://www.reddit.com/r/singularity/comments/1nap1h1/the_stealth_2mcontextwindow_model_sonoma_sky/

[6] поведение: http://www.braintools.ru/article/9372

[7] Официально на OpenRouter: https://openrouter.ai/openrouter/sonoma-dusk-alpha

[8] реакцию: http://www.braintools.ru/article/1549

[9] официально документировал: https://api-docs.deepseek.com/guides/anthropic_api

[10] их GitHub: https://github.com/MoonshotAI/Kimi-K2

[11] HuggingFace: https://huggingface.co/moonshotai/Kimi-K2-Instruct

[12] Qwen: https://qwenlm.github.io/blog/qwen3-coder

[13] позиционируется как: https://www.getmaxim.ai/docs/bifrost/usage/http-transport/integrations/anthropic-compatible

[14] готовые инструкции: https://docs.z.ai/scenario-example/develop-tools/claude

[15] поверх 5-часовых окон: https://www.tomsguide.com/ai/anthropic-is-putting-a-limit-on-a-claude-ai-feature-because-people-are-using-it-24-7

[16] https://buzzword-grok.vercel.app/: https://buzzword-grok.vercel.app/

[17] https://buzzword-glm.vercel.app/: https://buzzword-glm.vercel.app/

[18] творчества: http://www.braintools.ru/creation

[19] Подписывайтесь тогда на мой: https://t.me/+0IfoWg62H1s5Yzky

[20] Источник: https://habr.com/ru/articles/945066/?utm_campaign=945066&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.