Как обучение с подкреплением перестраивает мышление LLM

Задачи на рассуждение — больное место многих ИИ-систем, даже если у них хорошие фактические знания. Новая работа показывает, что усиление через RL (Reinforcement Learning, обучение [1] с подкреплением [2]) не просто повышает точность, а перестраивает внутреннюю логику [3] модели: появляется иерархия от низкоуровневого исполнения до высокоуровневого планирования. Отсюда понятно, почему мы видим те самые aha-моменты. А главное — становится ясно, почему привычные алгоритмы распределяют усилия не туда и как это исправить.

Как отличить планирование от исполнения

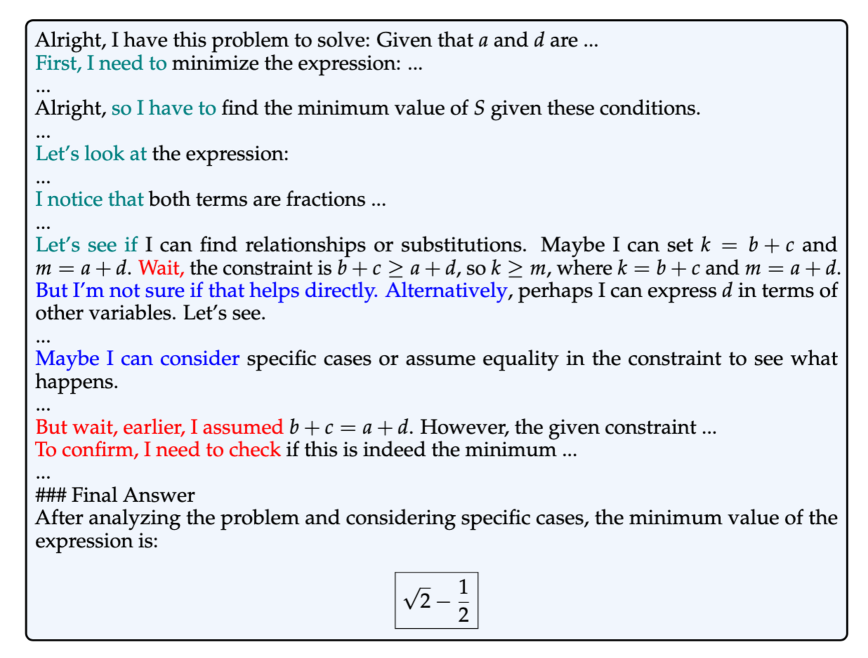

Авторы исследования вводят простой, но полезный прокси: Strategic Grams (SG) — устойчивые 3–5-граммы, которые управляют ходом решения. Это шаблоны вроде “let’s try”, “we can use”, “but the problem mentions” и т. п. Токены, входящие в такие n-граммы, считаются планирующими; остальные — для исполнения: считать, подставлять, применять формулы. Набор SG собирают из успешных решений и аннотируют наполовину автоматически, наполовину вручную. Получается функциональная раскладка по ролям, не завязанная на поверхностные признаки.

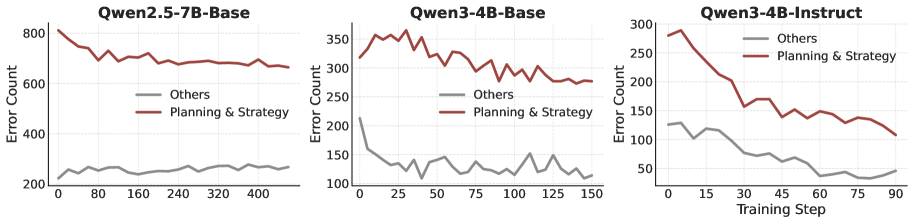

Что происходит во время обучения

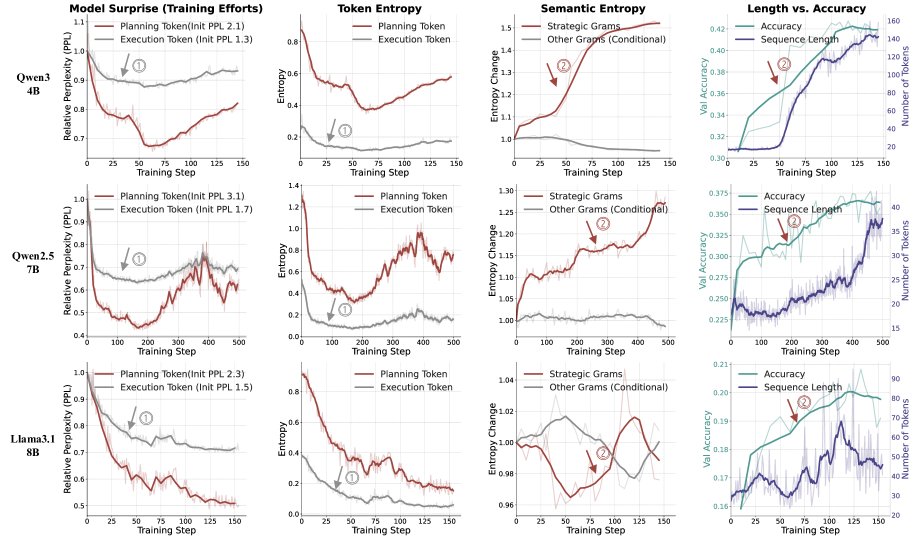

Сначала модель доводит до автоматизма операции исполнения: резко падает перплексия и энтропия на этих токенах — уверенность растет, ошибок меньше. Это быстрый этап, особенно для уже сильных LLM, где низы изначально неплохо отлажены.

Затем фронт обучения смещается в стратегию: растет разнообразие стратегических ходов, цепочки рассуждений становятся длиннее и упорядоченнее, точность продолжает расти — уже за счет планирования. Здесь и рождаются aha-моменты: модель находит новые приемы, осваивает разветвления, бэктрекинг и рефлексию.

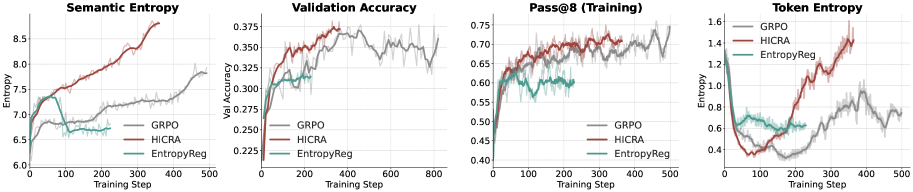

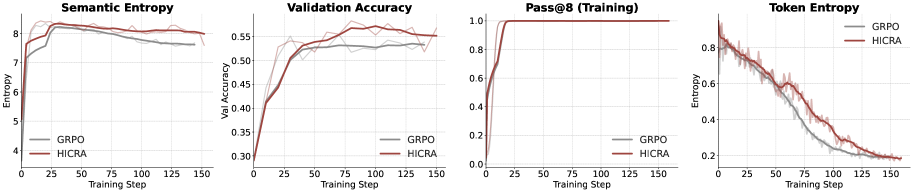

Почему обычные метрики путают следы

Энтропия токенов падает, потому что основную массу текста составляют токены исполнения, где уверенность после RL возрастает. Можно решить, что исследование стратегий угасает — и ошибиться. Куда точнее смотреть на семантическую энтропию по стратегическим n-граммам: она растет, когда модель расширяет репертуар планов, и лучше коррелирует с итоговой точностью.

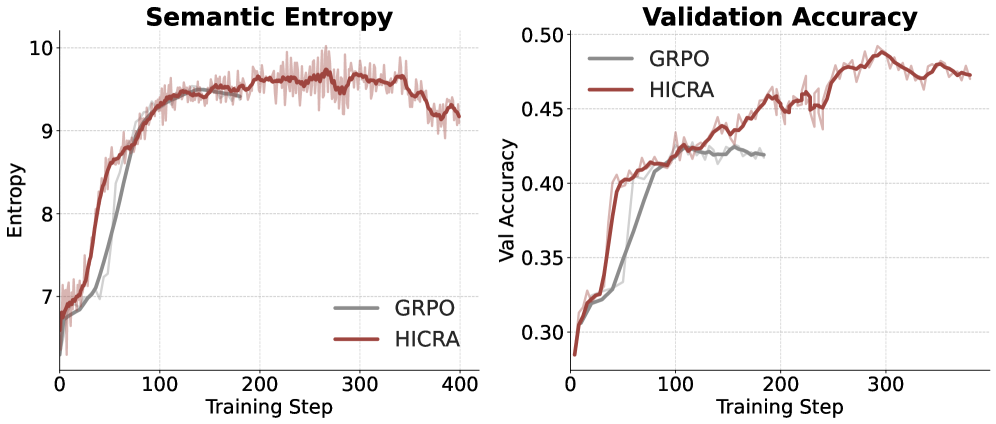

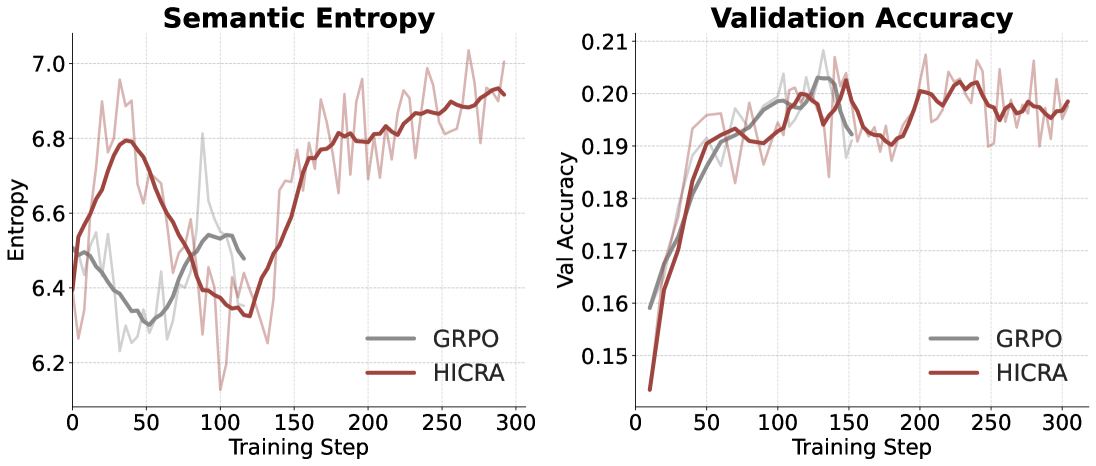

Если бутылочное горлышко — стратегия, не стоит равномерно раздавать градиент по всем токенам, как это делает метод GRPO [4]. Предлагается HICRA (HIerarchy-Aware Credit Assignment) — надстройка над GRPO, которая усиливает позитивный кредит и смягчает штраф именно на планирующих токенах. Формально это масштабирование преимущества на стратегических позициях с коэффициентом α=0.2. Политика сдвигается в подпространство стратегий, растет шанс открыть удачные планы и закрепить их.

Что показали эксперименты

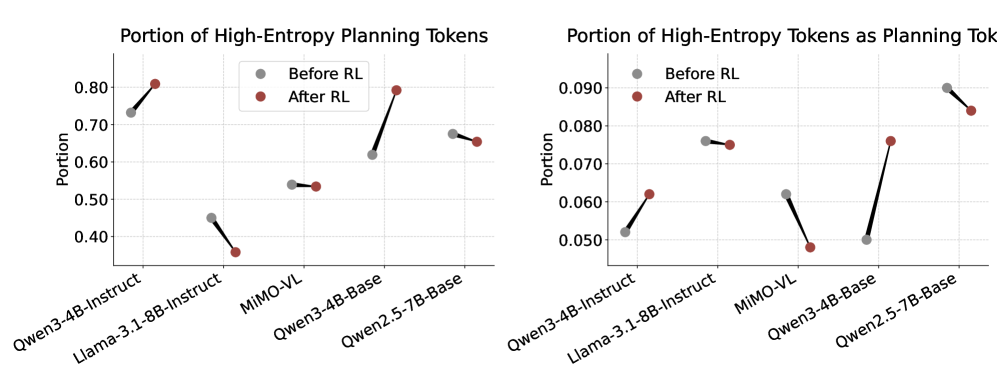

Тестировали на Qwen2.5-7B, Qwen3-4B, Llama‑3.1‑8B и MiMO‑VL‑7B, от базовых до instruct-вариантов; в бенчмарках — AIME24/25, Math500, AMC23, Minerva, Olympiad и др. Картина повторяется: HICRA стабильно превосходит GRPO.

На Qwen3‑4B‑Instruct приросты заметны даже при сильной базе: AIME24 с 63.1 до 65.9, AIME25 — с 58.8 до 62.1, AMC23 — с 76.8 до 82.5, Olympiad — с 55.6 до 59.7. На Qwen3‑4B‑Base щедрые добавки на Math500: с 83 до 89. На Qwen2.5‑7B‑Base HICRA выигрывает у GRPO на всех задачах, особенно на AMC23: плюс 8.4 пункта. В мультимодальной настройке метрика Pass@K быстро насыщается, но семантическая энтропия продолжает отличать методы — и HICRA снова впереди.

На что именно влияет RL

Разметка ошибок показывает: в ходе RL быстрее всего исчезают стратегические промахи, а не процедурные. И это логично: неверный план обнуляет идеальное исполнение. Значит, правильное целеполагание должно подталкивать именно к поиску и закреплению стратегий.

Где метод буксует и что дальше

HICRA требует базовой надежности исполнения. На Llama‑3.1‑Instruct форсирование стратегии без прочного низового навыка ведет к нестабильности и не обгоняет GRPO. Вывод простой: нужен адаптивный режим, который понимает текущее узкое место — сначала укрепляем процедуры, потом усиливаем планирование.

Почему это важно

Идея иерархии и распределение по ролям переносится не только на математику [5]. Код, научные рассуждения, длинное планирование текста, мультиагентная система с распределением функций — всюду, где стратегия и исполнение различимы, полезно усиливать именно стратегические токены и измерять прогресс через семантическую энтропию. Это делает обучение более предсказуемым и экономит попытки.

📜 Полная статья [6]

***

Если вам интересна тема ИИ, [7]подписывайтесь на мой Telegram-канал [8] [9]– там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

Автор: andre_dataist

Источник [10]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/19485

URLs in this post:

[1] обучение: http://www.braintools.ru/article/5125

[2] подкреплением: http://www.braintools.ru/article/5528

[3] логику: http://www.braintools.ru/article/7640

[4] GRPO: https://www.datacamp.com/blog/what-is-grpo-group-relative-policy-optimization

[5] математику: http://www.braintools.ru/article/7620

[6] 📜 Полная статья: https://arxiv.org/abs/2509.03646v1

[7] : https://t.me/+mP35nQPhgXZmZDYy

[8] подписывайтесь на мой Telegram-канал: https://t.me/+jWSR2G5Qdm04MWEy

[9] : https://t.me/+9nDCqOqSLiM3NTVi

[10] Источник: https://habr.com/ru/articles/946786/?utm_source=habrahabr&utm_medium=rss&utm_campaign=946786

Нажмите здесь для печати.