Агенты, которые не теряют цель: как научить ИИ решать многошаговые задачи

Автоматизация интерфейсов на экране — мечта многих: открыть приложение, найти нужную кнопку, выполнить серию шагов и довести задачу до конца. Сегодня это делают агенты на базе больших языковых моделей, которые умеют видеть скриншоты, рассуждать и действовать. Но когда дело доходит до многошаговых сценариев, прогресс нередко упирается в то, как мы учим такие системы.

Почему агенты застревают в многошаговых задачах

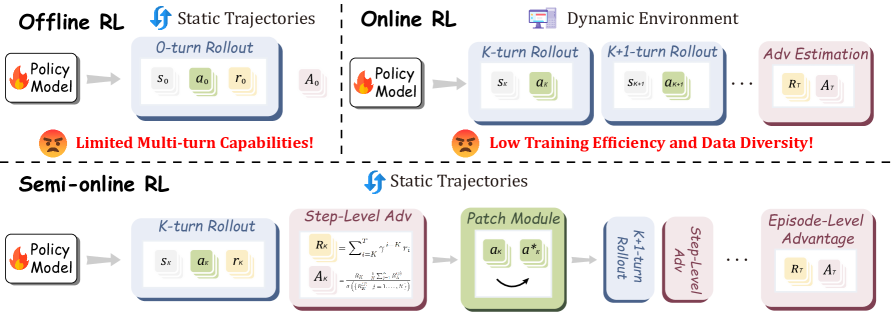

Традиционно есть два пути. Офлайн обучение [1] с подкреплением [2] берёт готовые траектории экспертов: стабильно, дёшево, но модель учится на чужой истории и не видит собственных ошибок. Отсюда переоптимизация отдельных шагов и слабая память [3] о целях. Онлайн обучение выглядит привлекательнее: агент сам взаимодействует со средой, получает обратную связь на уровне эпизода, учится учитывать контекст. Но в GUI-навигации вознаграждения редки и запаздывают, инфраструктура дорогая, а покрыть много приложений и сайтов — отдельная боль [4].

Авторы UI-S1 предлагают срединный путь — Semi-online RL. Идея проста: имитировать онлайн-динамику, не заходя в реальную среду. Мы остаёмся в офлайне, но заставляем модель проживать собственную историю, а потом аккуратно «склеиваем» её с эталонной траекторией, чтобы не терять полезные хвосты.

Как это устроено на практике

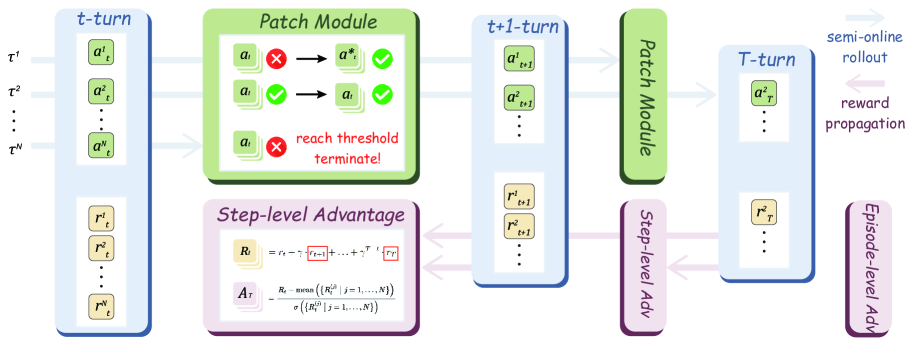

Полуонлайн роллаут: по каждой экспертной траектории агент генерирует свои действия и мысли на каждом шаге, опираясь на уже накопленную историю. Если предсказанное действие совпадает с экспертным — продолжаем. Если нет — без помощи дальнейший прогон оборвётся, и мы потеряем информацию о финале эпизода.

Здесь и появляется патч‑модуль. При расхождении он подставляет экспертное действие и, по настройке, синтетическую мысль — например, без размышлений (самый дешёвый режим), с посторонним помощником или от самой текущей политики. История при этом остаётся собственной, а траектория продолжается до конца. В итоге модель учится на «живом» контексте, но не лишается полезных сигналов из эталона.

Поверх этого авторы оптимизируют политику сразу по двум сигналам: пошаговому (точность формата, типа и корректности действия) и эпизодному (успех всей задачи). Вознаграждения распространяются вперёд с дисконтом, чтобы подталкивать модель видеть цель, а не только ближайшую кнопку. Итоговая функция похожа на PPO с клиппингом и мягким KL‑штрафом, плюс контроль за разнообразием преимуществ, чтобы не застрять в узкой политике.

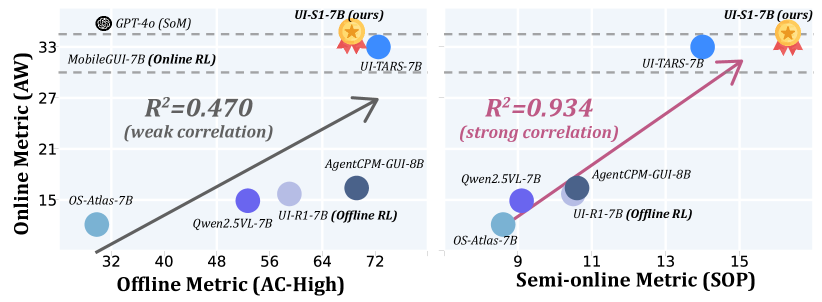

Что мерить: SOP вместо гадания по звёздам

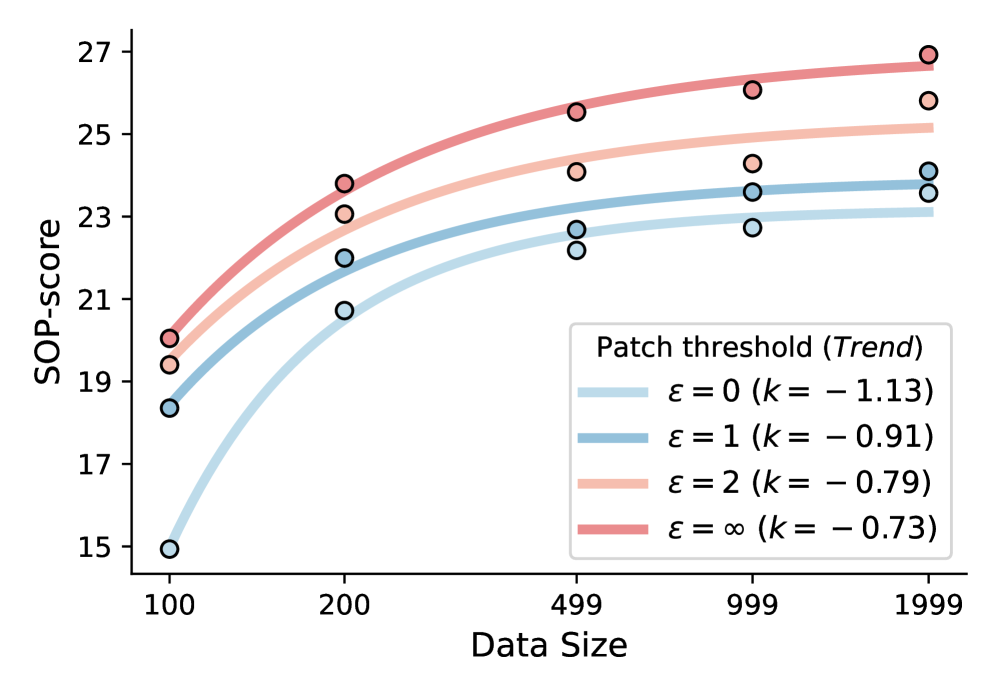

Одна из скрытых проблем в GUI‑исследованиях — оценка. Популярные офлайн метрики часто не предсказывают, как агент поведёт себя «вживую». Авторы вводят Semi‑Online Performance (SOP) — дешёвый прокси, который учитывает собственную историю модели и оценивает прогресс и успех по шагам задачи. В экспериментах SOP гораздо лучше коррелирует с реальной онлайн‑производительностью, чем привычные офлайн метрики.

Что получилось на бенчмарках

Модель UI‑S1‑7B достигает уровня лучших открытых 7B систем на динамических бенчмарках. На AndroidWorld прибавка относительно сильной базы — до +12 процентных пунктов; на AITW‑Gen — до +23.8. Итоговая точка 34% на AndroidWorld сравнима с куда более тяжёлыми системами и близка к закрытым решениям. При этом одношаговые навыки не страдают: на AndroidControl‑High и GUI Odyssey наблюдается рост. В отличие от классического офлайн RL, который местами даже проседает, полуонлайн обучение устойчиво подтягивает именно многошаговое поведение [5].

Что важнее: патчить как

Абляции показывают, что Thought‑free Patch даёт почти максимум качества при минимальных затратах — его и берут в финальной конфигурации. Чем выше порог допущенных патчей, тем больше модель видит поздние шаги и тем лучше использует данные. Оптимальный дисконт для дальних целей оказался средним (γ≈0.5): игнор будущего ухудшает результаты, а слишком длинный горизонт добавляет шума.

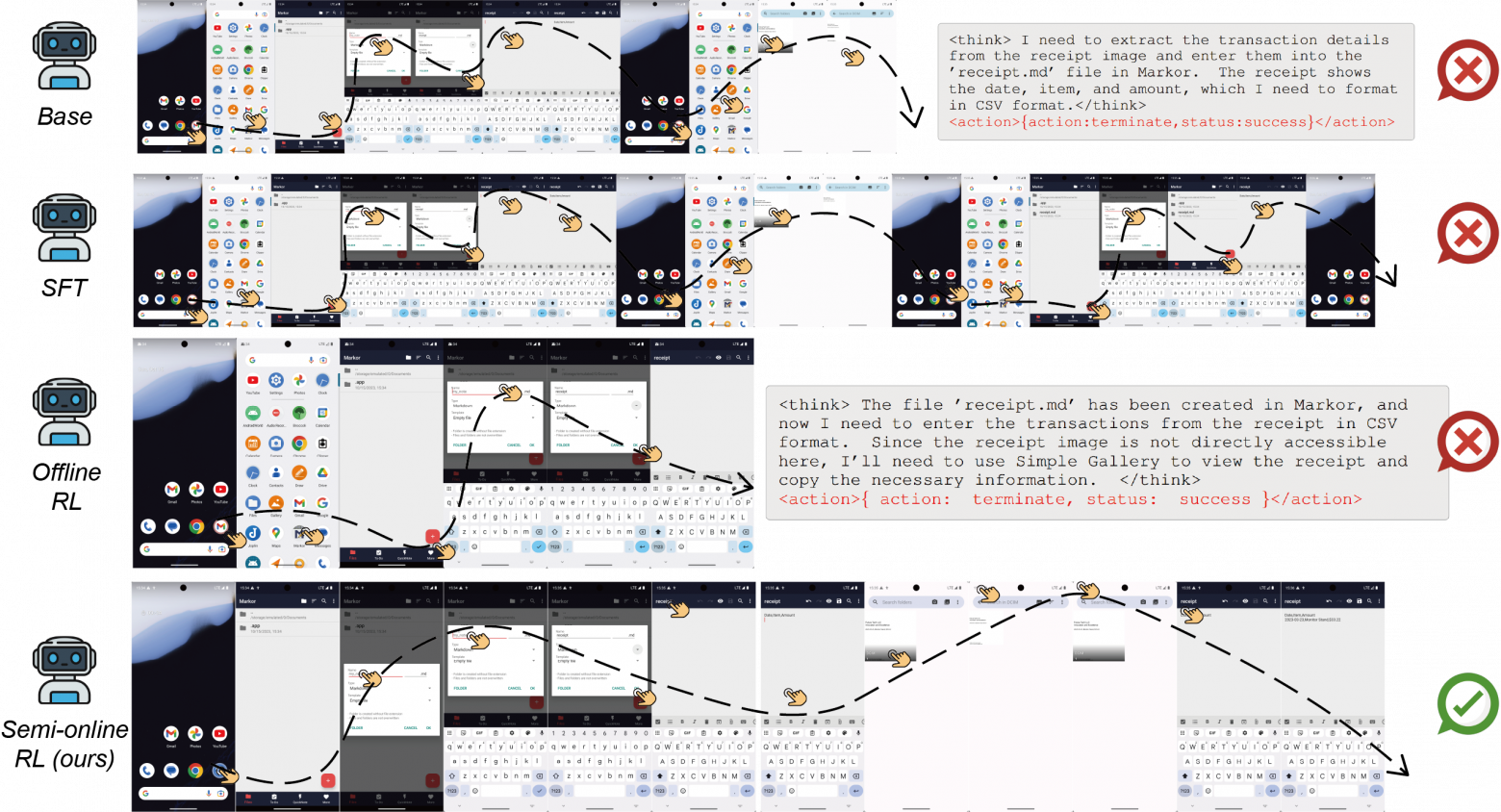

Кейс: память, контекст и аккуратность

На реальных задачах наподобие «извлечь данные из галереи и создать файл в заметках» полуонлайн‑обученная модель удерживает замысел до конца эпизода, не путает поля и не теряет контекст между приложениями. База и чистый офлайн RL чаще сбиваются или преждевременно останавливаются — как раз из‑за рассогласования истории и финальной цели.

Почему это важно и что дальше

Полуонлайн парадигма соединяет простоту офлайна и целевую направленность онлайна. Мы получаем обучение, которое масштабируется по данным, не требует дорогих инфраструктурных циклов, но при этом раскрывает именно многошаговые способности агента. Плюс — практичная метрика SOP, позволяющая быстро ранжировать модели перед реальными запусками.

Интересно расширить патч мыслей от самой политики, но без сдвига распределений; научиться более умно выбирать, где патчить, а где позволять агенту ошибаться; добавить лёгкую модель мира для аппроксимации переходов между экранами без опоры на эксперта. Всё это может ещё сильнее удешевить обучение и улучшить перенос на новые приложения.

📜 Полная статья [6]

💾 Код [7]

***

Если вам интересна тема ИИ, [8]подписывайтесь на мой Telegram‑канал [9] [10]— там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

Автор: andre_dataist

Источник [11]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/19648

URLs in this post:

[1] обучение: http://www.braintools.ru/article/5125

[2] подкреплением: http://www.braintools.ru/article/5528

[3] память: http://www.braintools.ru/article/4140

[4] боль: http://www.braintools.ru/article/9901

[5] поведение: http://www.braintools.ru/article/9372

[6] 📜 Полная статья: https://arxiv.org/html/2509.11543v1

[7] 💾 Код: https://github.com/X-PLUG/MobileAgent/tree/main/UI-S1

[8] : https://t.me/+mP35nQPhgXZmZDYy

[9] подписывайтесь на мой Telegram‑канал: https://t.me/+kpdt-GNEE-tjOWUy

[10] : https://t.me/+9nDCqOqSLiM3NTVi

[11] Источник: https://habr.com/ru/articles/948248/?utm_source=habrahabr&utm_medium=rss&utm_campaign=948248

Нажмите здесь для печати.