Как думают ИИ-модели: раскладываем рассуждения на эпизоды

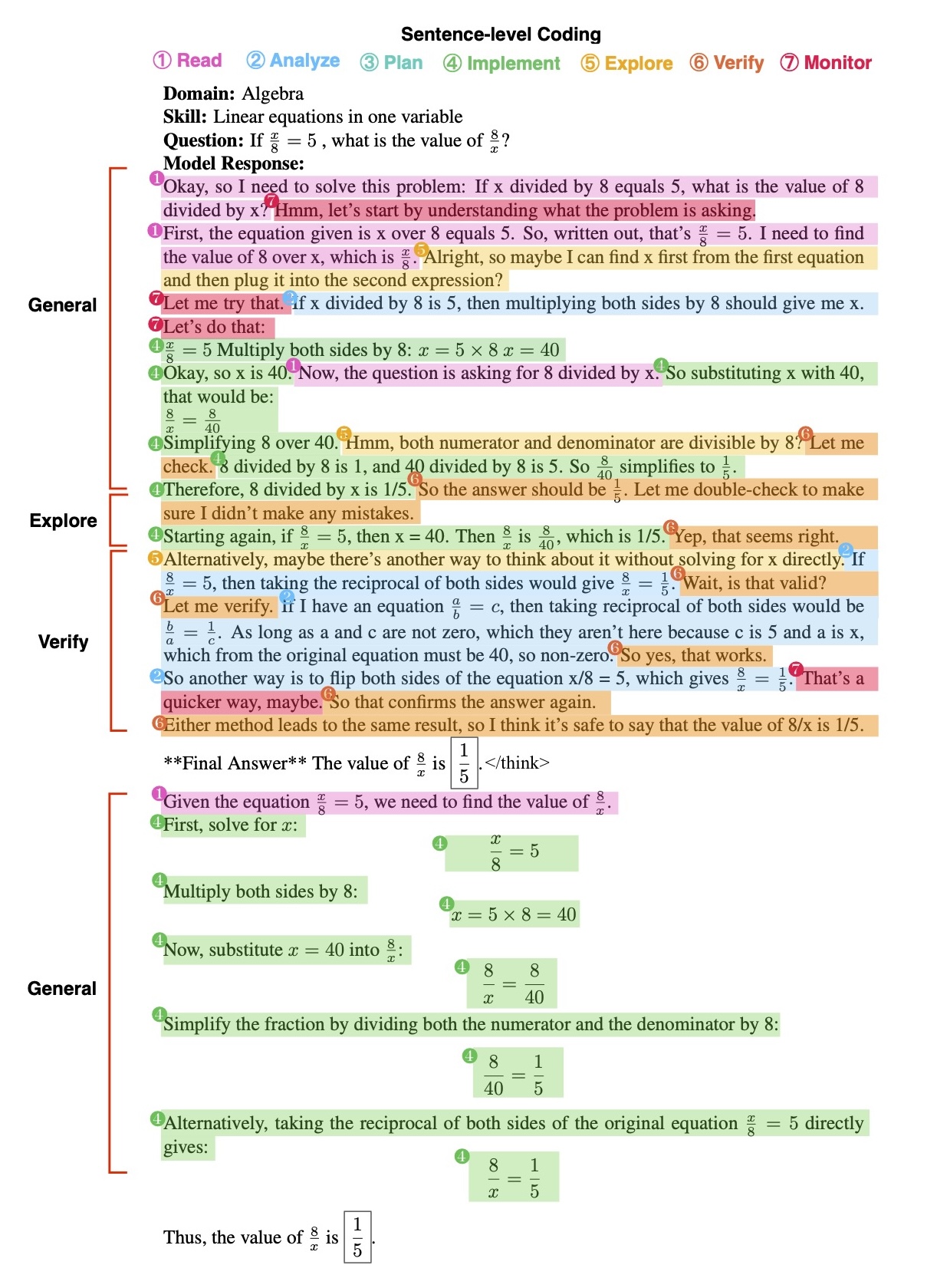

Большие модели рассуждений (Large Reasoning Models, LRM) сегодня не просто отвечают, а разворачивают длинные цепочки размышлений. Это помогает им решать более сложные задачи, но создает новую проблему: как понять структуру этих рассуждений и насколько они напоминают человеческое мышление [1]. Исследователи предлагают опереться на хорошо проверенный в когнитивной науке [2] фреймворк — теорию эпизодов Шёнфельда, изначально созданную для анализа того, как люди решают нестандартные математические задачи. Идея проста: разметить текстовые данные решений модели по последовательности эпизодов — Read, Analyze, Plan, Implement, Explore, Verify, Monitor — и посмотреть, какие переходы встречаются чаще и как они связаны с успехом решения.

Откуда берётся эпизодичность

Шёнфельд показал, что опытный решатель задач двигается не хаотично, а эпизодами: читает условие, раскладывает задачу на ключевые отношения, планирует шаги, выполняет вычисления, иногда пробует обходные пути, проверяет себя и следит за процессом. Современные LRM, вроде DeepSeek‑R1 или GPT‑o1, тоже пишут подробно, с паузами и маркерами внимания [3] — это делает их поведение [4] удобным для такой разметки. В работе видно, что переходы Read→Analyze или Plan→Implement встречаются у моделей так же устойчиво, как у людей, а этапы Explore и Verify включаются, когда решение требует перепроверки.

Как собирали и размечали

Исследователи взяли банк задач SAT по математике [5] с подробными метаданными и сгенерировали решения с помощью открытой LRM DeepSeek‑R1. Дальше — двухуровневая разметка: абзацы подписываются как General, Explore или Verify (чтобы фиксировать общий подход), а каждое предложение отмечается одной из семи эпизодных меток. Разметку делали по разработанным гайдам, прошли пилот, обучили аннотаторов и сформировали первый открытый корпус для анализа машинного рассуждения. В сумме — тысячи помеченных предложений и абзацев и полный пакет инструкций для воспроизводимости.

Что показал анализ

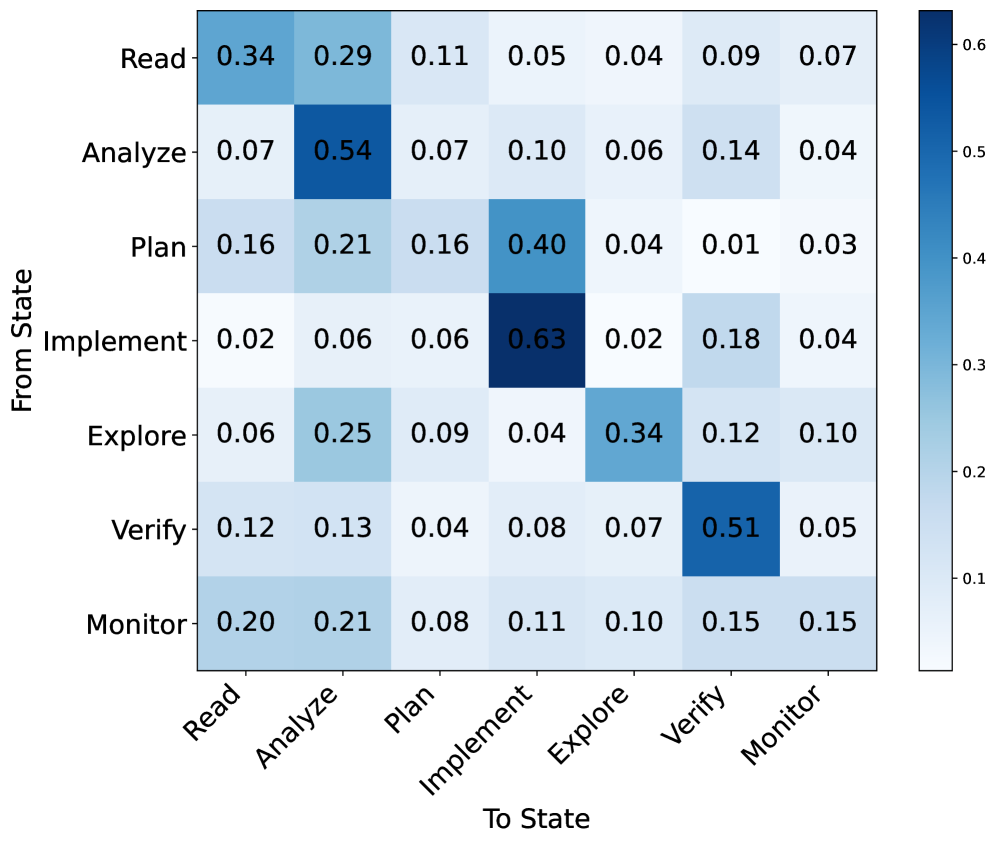

Картина переходов между эпизодами выглядит осмысленно. Чаще всего модель идет от чтения к анализу, от плана к выполнению, а Explorе возвращается к Analyze, чтобы уточнить понимание. Это похоже на паттерны людей-экспертов и наводит на мысль, что у моделей уже складывается управляемая структура решения.

Дальше авторы спрашивают: могут ли LLM автоматически размечать такие эпизоды? Сравнили GPT‑4.1, GPT‑4o и Gemini‑2.0‑flash в нескольких сценариях: чистый zero-shot, с примерами, с подробным гидом и их комбинацией. Главный вывод — хорошая инструкция заметно улучшает точность. Для GPT‑4.1 на уровне абзацев точность выросла с 0.444 до 0.740 в режиме с инструкцией и до 0.757 при сочетании инструкции и примеров; на уровне предложений — до 0.681. Gemini тоже выигрывает от инструкций. Это означает, что стандартный промт мало пригоден для когнитивной разметки, а аккуратно прописанные правила дают скачок качества.

Авторы также обучили классические модели на размеченных данных: BERT, RoBERTa и простые классификаторы на эмбеддингах. Лучшая из обучаемых систем уступает GPT‑4.1 с инструкцией, но приближается: BERT даёт точность около 0.73 на тесте. По ошибкам видно: часто путаются Analyze с Verify и Implement с Verify — модель делает шаг вычислений и одновременно его проверяет, и людям, и алгоритмам не всегда легко провести четкую границу.

Зачем это всё

Работа даёт не просто набор меток, а теоретически обоснованную схему, которая связывает внешнюю «вербализацию» модели с понятными когнитивными состояниями. Это важно для нескольких направлений:

-

интерпретация: можно увидеть, где модель планирует, где блуждает, где проверяет себя;

-

контроль: промтами или политиками можно усиливать нужные эпизоды, например, заставлять чаще проверять;

-

обучение [6]: можно вознаграждать корректные переходы и наказывать бессмысленные циклы Explore.

Корпус собран на задачах SAT — это умеренный уровень сложности. Впереди проверка на олимпиадной математике и других доменах. Автоматическая аннотация уже рабочая, но до стабильности в промышленных сценариях ещё есть путь. Наконец, пограничные случаи между эпизодами требуют донастройки правил и, возможно, более богатого контекста.

Итог

Авторы аккуратно переносят теорию Шёнфельда в мир LRM и показывают, что длинные рассуждения моделей действительно складываются в эпизоды с узнаваемыми переходами. Открытый корпус и подробные инструкции задают стандарт для будущих работ по интерпретируемости и более управляемым системам рассуждений.

📜 Полная статья [7]

💾 Код [8]

***

Если вам интересна тема ИИ, [9]подписывайтесь на мой Telegram‑канал [10] — там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

Автор: andre_dataist

Источник [11]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/20038

URLs in this post:

[1] мышление: http://www.braintools.ru/thinking

[2] науке: http://www.braintools.ru/article/7634

[3] внимания: http://www.braintools.ru/article/7595

[4] поведение: http://www.braintools.ru/article/9372

[5] математике: http://www.braintools.ru/article/7620

[6] обучение: http://www.braintools.ru/article/5125

[7] 📜 Полная статья: https://arxiv.org/abs/2509.14662

[8] 💾 Код: https://github.com/MingLiiii/Schoenfeld_Reasoning

[9] : https://t.me/+mP35nQPhgXZmZDYy

[10] подписывайтесь на мой Telegram‑канал: https://t.me/+H8ZNOIg1DwVkOTli

[11] Источник: https://habr.com/ru/articles/951438/?utm_source=habrahabr&utm_medium=rss&utm_campaign=951438

Нажмите здесь для печати.