Иллюзия интеллекта: как живые тесты разоблачают ИИ-кодеров

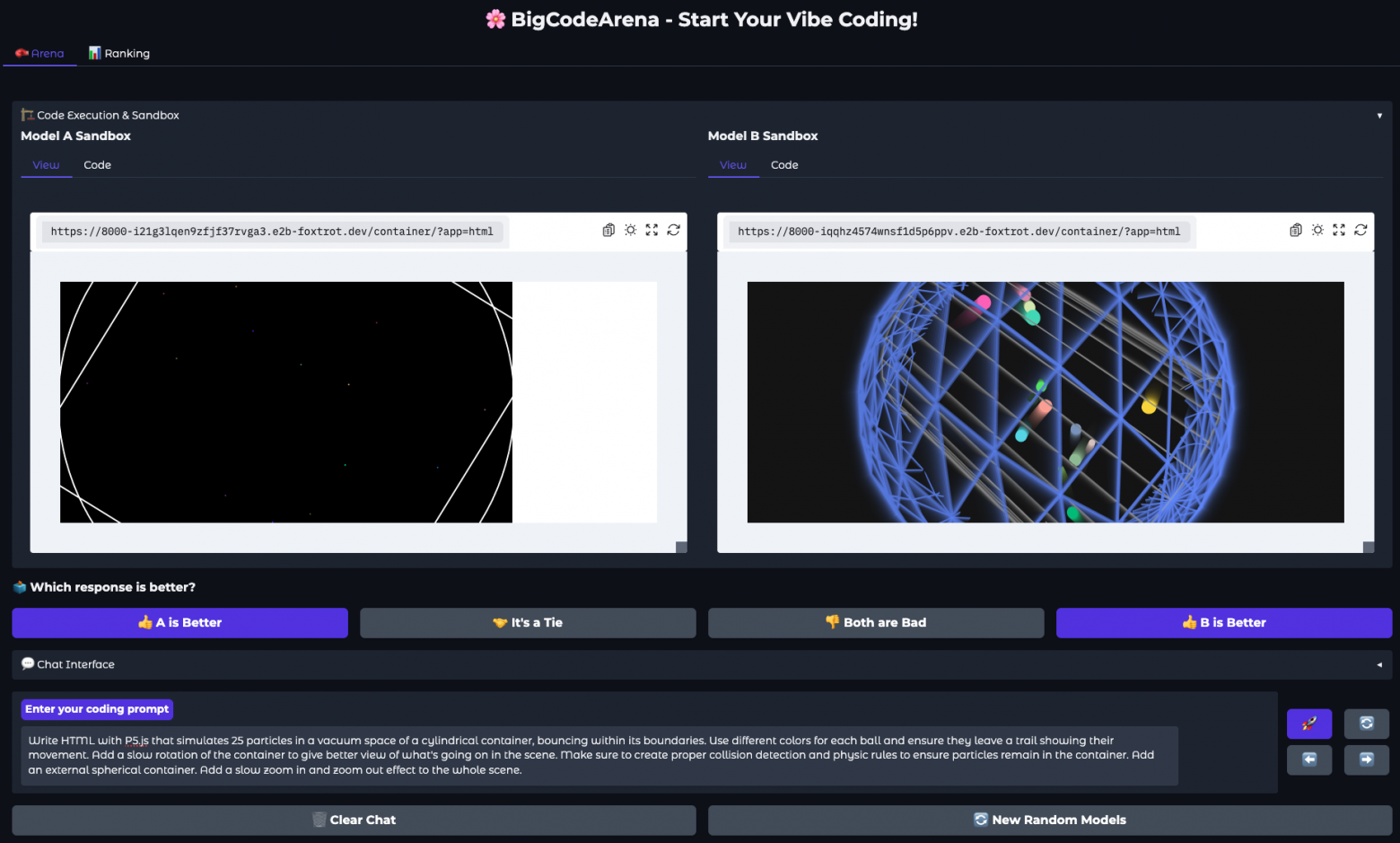

Оценивать генерацию кода по красивым комментариям — это как смотреть на машину по буклету. В реальной жизни важнее, заведётся ли она, тормозит ли вовремя и удобно ли ей пользоваться. Авторы BigCodeArena предлагают именно такой практичный взгляд: их открытая платформа сравнивает решения больших языковых моделей (LLM) не по совпадению строк, а по запуску, интерактивности и поведению [1] на экране. Пользователь видит двух анонимных соперников, запускает оба решения в песочнице, может кликать по интерфейсу, вводить данные, дебажить и только потом голосует за A, B, ничью или «обе плохи».

Зачем это нужно

Длинный код часто «кажется» правильным на глаз, но падает при запуске, сбоит в рантайме или не соответствует промту. Авторы эмпирически показывают: выполнение и интерактивность резко повышают надёжность суждений — как у людей, так и у LLM-судей. Это особенно заметно в задачах с UI, играх, веб-страницах, где важны динамика, обработка событий и мелкие детали UX.

Как устроена площадка

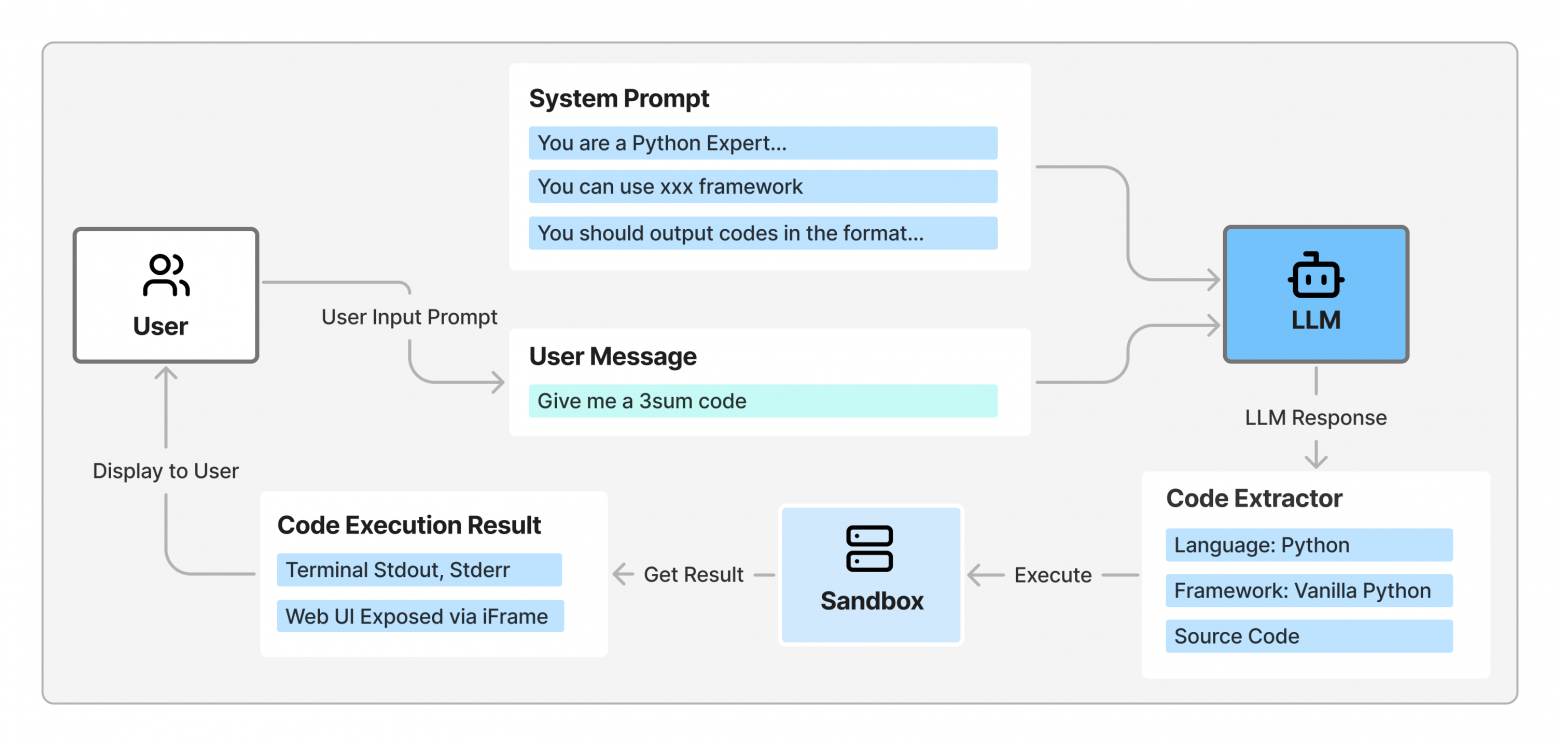

Пользовательский интерфейс собран на Gradio; сервер — модульная система E2B с изолированными песочницами. Поддерживается 10 языков (Python, JS/TS, HTML, C/C++, Java, Go, Rust, Markdown) и 8 окружений (React, Vue, Core Web, Streamlit, PyGame, Gradio, Mermaid, Interpreter). Система автоматически вытягивает код из markdown-блоков, ставит зависимости, компилирует/запускает и возвращает все артефакты: логи, скриншоты, интерактивный UI.

Есть парный режим (в духе Chatbot Arena) и односторонний — для проверки конкретной модели. Чтобы исключить «смещение скорости», результаты обеих сторон показываются только после завершения генерации и запуска. Пары моделей балансируются взвешенной выборкой: новичкам временно повышают вес, чтобы быстрее набрать статистику.

Что успели собрать

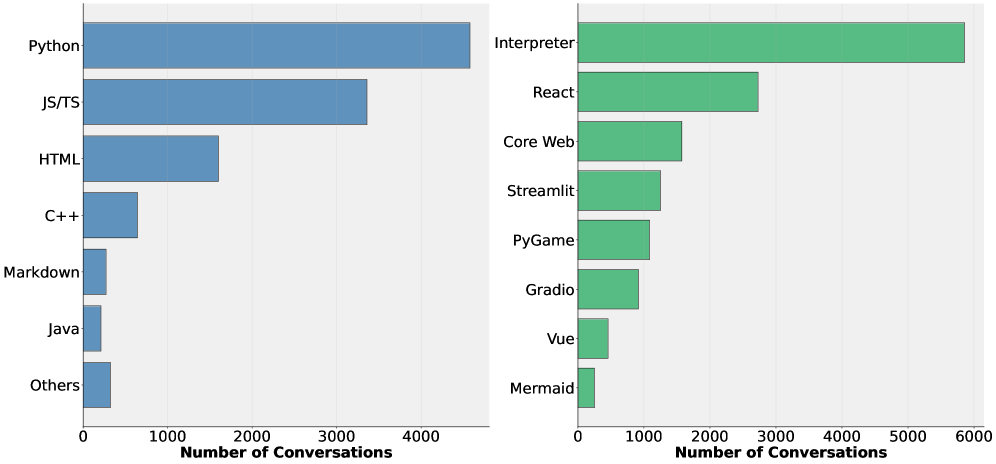

За 5+ месяцев — 14,123 сессии от 500+ уникальных IP. Из них выделено 4,731 многошаговых парных примеров с голосами предпочтений. У каждой из 10 моделей — не менее 700 голосов. Темы повторяются по шести направлениям: Web Design, Game Development, Diagram Creation, Creative Coding, Scientific Computing, Problem Solving. По данным видно доминирование Python и интерпретаторных сценариев, но UI-фреймворки тоже занимают крупную долю.

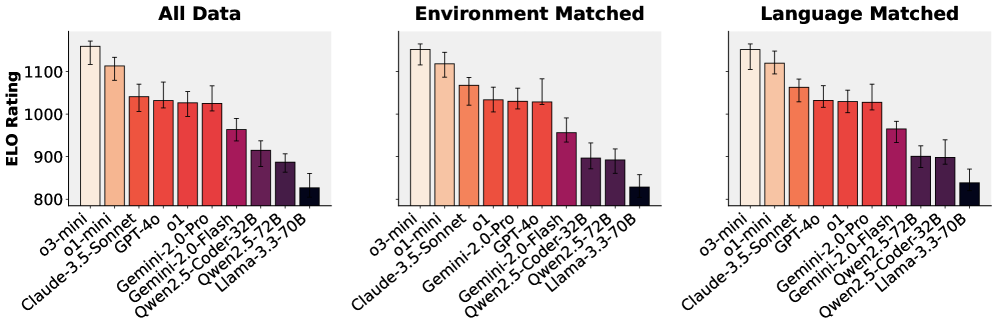

Как сравнивали модели

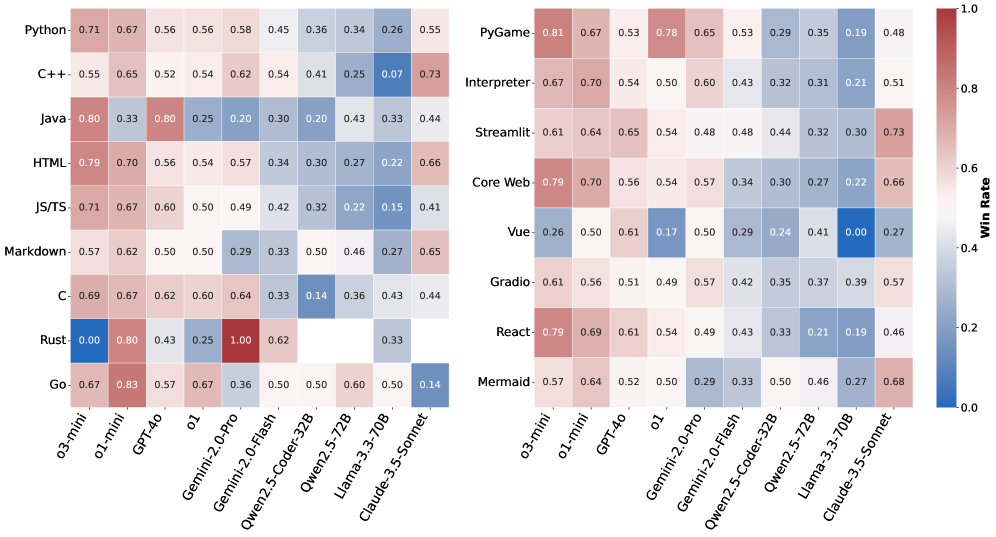

Голоса агрегируются через модель Брэдли—Терри с бутстрепом (100 повторов) и 95% доверительными интервалами. Рассматривали три режима: все данные; совпадает окружение; совпадает язык. Рейтинги согласованы между режимами. В живых голосованиях стабильно лидируют o3-mini и o1-mini; затем идёт Claude-3.5-Sonnet. Средний эшелон — GPT-4o, o1, Gemini-2.0-Pro/Flash; слабее — Qwen2.5 и Llama-3.3-70B. По языкам и средам картинка неоднородна: например, Gemini-2.0-Pro силён в Rust, а o3-mini устойчив в React, Streamlit, Gradio и Core Web.

Про судейство и наградные модели

На основе 4.7K человеческих предпочтений построен BigCodeReward — набор для обучения/оценки моделей в практическом коде. Там три класса (A лучше, B лучше, ничья) и два режима: без и с результатами исполнения (текст, скриншоты, интерактив). Вывод прямой: доступ к запуску обычно повышает точность судей. Наибольший прирост — в диаграммах и геймдеве, наименьший — в прикладном программировании. Есть и нестабильность у отдельных LLM‑судей, что важно для дальнейшей работы.

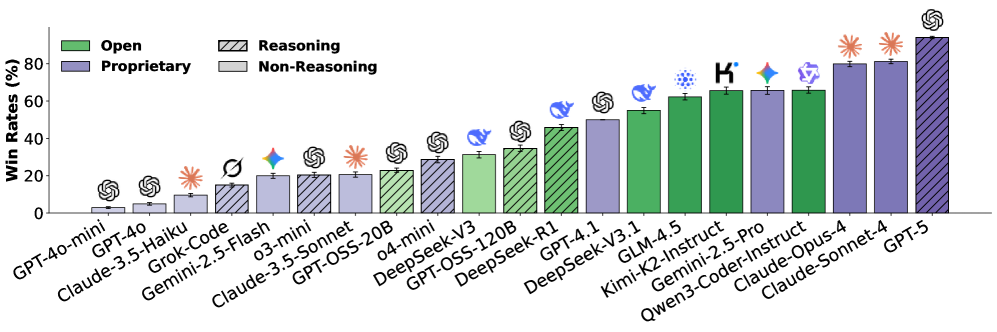

Автоматическая арена без людей

AutoCodeArena — полностью автоматическое ранжирование. Взяли 600 репрезентативных промтов, код гоняется в Docker, судья — Claude‑3.7‑Sonnet, базовая модель — GPT‑4.1, сравнение идёт парами против базы с бутстреп‑интервалами. Здесь новый лидер — GPT‑5; сильно выступают Claude‑Opus‑4 и Claude‑Sonnet‑4. Среди открытых заметен прогресс у Kimi‑K2, GLM‑4.5, Qwen3‑Coder.

Почему это важно для сообщества

-

Запуск кода — ключ к честной оценке правильности, устойчивости и соответствия промту.

-

Сама платформа — открытая, с прозрачной инфраструктурой и данными. Можно проверять методику, воспроизводить результаты, строить свои метрики.

-

Накопленные сценарии взаимодействий (клики, клавиатура, прокрутка) открывают путь к более «агентным» судьям и лучшим моделям, учитывающим реальное поведение [2] интерфейсов.

Авторы чистят данные и запускают всё в изолированных песочницах, что снижает риски утечек PII и вредоносного кода. Полного устранения рисков они честно не обещают. Инференс вынесен на внешние эндпоинты, что уменьшает прямой энергофутпринт и упрощает прозрачность.

Что дальше

Команда планирует расширять языки и среды, сделать «живые» версии BigCodeReward/AutoCodeArena, развивать мультиагентные судьи, учитывать пользовательские сценарии и улучшать наградные модели для кода. С практической точки зрения [3] главный урок уже ясен: без исполнения оценка кодогенерации будет хромать. А с исполнением лидеры становятся видны, и прогресс — измерим.

📜 Полная статья [4]

💾 Код [5]

***

Если вам интересна тема ИИ, [6] [7]— там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

Автор: andre_dataist

Источник [8]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/20680

URLs in this post:

[1] поведению: http://www.braintools.ru/article/9372

[2] поведение: http://www.braintools.ru/article/5593

[3] зрения: http://www.braintools.ru/article/6238

[4] 📜 Полная статья: https://arxiv.org/abs/2510.08697

[5] 💾 Код: https://github.com/bigcode-project/bigcodearena

[6] : https://t.me/+mP35nQPhgXZmZDYy

[7] : https://t.me/+d-7OcUj18oM1NGYy

[8] Источник: https://habr.com/ru/articles/956568/?utm_source=habrahabr&utm_medium=rss&utm_campaign=956568

Нажмите здесь для печати.