Облачная vs локальная LLM: что выбрать для своего проекта

Привет! На связи София Филиппова, AI-engineer at Innova и спикер курса «AI в DevOps» [1]от Слёрма. Сегодня хочу поговорить о том, как сделать выбор между облачной и локальной LLM.

Почему вообще возникает такой вопрос? LLM стремительно врываются в мир DevOps. Уже сегодня они умеют:

-

анализировать огромные объемы логов и прочей информации;

-

генерировать готовые скрипты и код на приличном уровне;

-

автоматически комментировать PR’ы и предлагать фиксы;

-

помогать в root-cause анализе и даже предсказывать сбои до того, как они произойдут.

И если пару лет назад это казалось экспериментами энтузиастов, то в сегодня LLM стали полноправными участниками разработки. Но чем активнее мы их внедряем, тем чаще возникает стратегический вопрос: строить всё на облачном API от OpenAI, Anthropic или Yandex, или разворачивать локальную LLM в своем контуре?

Этот выбор влияет буквально на всё: на бюджет и экономику проекта, на безопасность и комплаенс, на то, как будет эволюционировать инфраструктура спустя время. И как бы банально это ни звучало, здесь нет универсального ответа. У каждого подхода есть свои особенности. Понять, что подойдет конкретно для вашего проекта – наша задача на сегодня!

В этой статье мы разложим по полочкам ключевые отличия облачных и локальных языковых моделей, посмотрим, где они выигрывают и где показывают недостатки, и как DevOps-инженеру принять решение не “на глаз”, а на основе реальных потребностей [2].

Архитектурные различия: API vs локальная LLM

Облачная LLM – это модель, к которой вы обращаетесь через HTTP-запрос. Далее просто получаете ответ и дальше используете в своём пайплайне. Всё тяжёлое: вычисления, хранение параметров, оптимизация – происходит на стороне провайдера. Вам остается только платить за токены.

Локальная LLM – это модель, которую вы разворачиваете на своем железе: на сервачке, в контейнере, иногда даже на ноутбуке (через Ollama или LM Studio). Тут уже железо, оптимизация, дообучение – ваша зона ответственности.

Главное различие (и вместе с тем риск) сразу бросается в глаза. При использовании API-решения вы полностью доверяете данные, которые гоняете по сети, провайдеру. В случае с локальной LLM контролируете процесс сами на всех этапах.

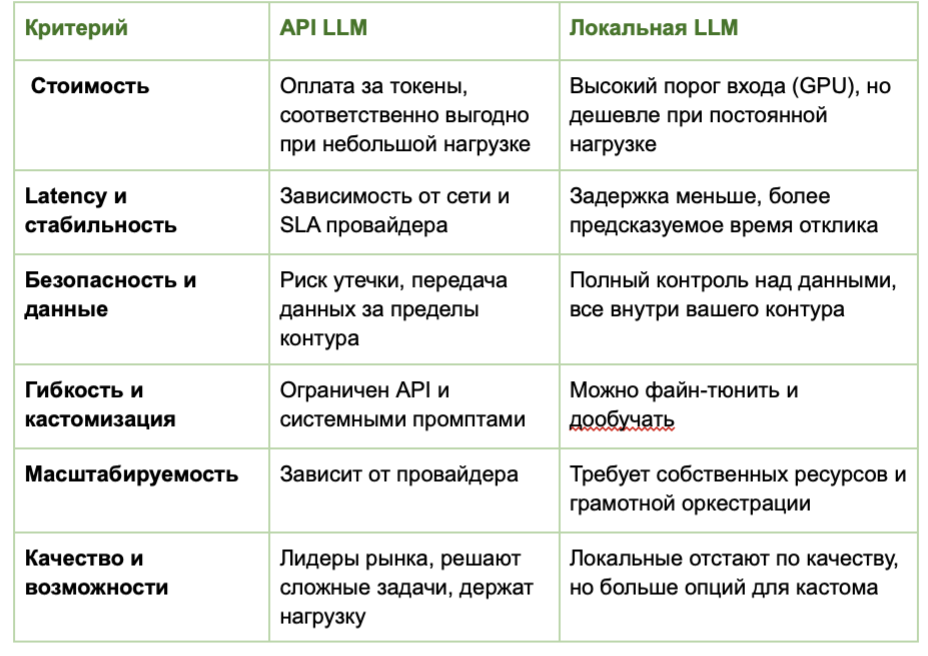

Но больше разницы проявляется в деталях, разберем по критериям:

Соответственно, облачные решения подойдут лучше, когда нет строгих требований к безопасности, важна скорость разработки и быстрый доступ к топовым моделям. Локальный путь подойдет для вашего проекта лучше, если есть требования к данным и их контролю, а также требуется какой-либо кастом.

Экономика и безопасность

Предлагаю рассмотреть эти два пункта вместе, поскольку они всегда идут рука об руку. От выбора подхода будет зависеть вся ваша стратегия. Так где же окупаемость выше?

На старте API-решение почти всегда выигрывает: не нужно думать о GPU и оркестрации, можно быстро проверить гипотезу и собрать MVP, а масштабирование и обновления – забота провайдера.

Но чем больше нагрузка и чем глубже интеграция, тем ощутимее становится цена токенов. Регулярный поток логов, постоянные запросы CI/CD, автогенерация кода… и внезапно счетчик на API вырастает на тысячи долларов в месяц.

Например, стартап с 5 млн токенов в месяц платит ~2к долларов провайдеру. Та же нагрузка на собственной модели может стоить меньше раза в 4 в месяц после первоначальных инвестиций.

Ведь локальная LLM наоборот требует вложений наперед: железо, кластеризация, MLOps-компоненты. Такие модели сложнее в запуске и поддержке, зато в долгую окупается: после точки насыщения стоимость инференса снижается, а ROI начинает подрастать.

Именно поэтому крупные компании часто идут по пути гибридной архитектуры: облачный API используют для reasoning-задач, где важна глубина понимания, а локальную модель для рутинных и массовых запросов. Но об этом подробнее чуть позже.

Второй аспект – безопасность. Здесь за актуальным знанием можно обратиться к OWASP, ежегодно они обновляют свой топ угроз для больших языковых моделей. Для облачных и локальных моделей будут более или менее актуальны разные аспекты безопасности:

-

При использовании API-моделей данные уходят за периметр. Если вы работаете с чувствительной корпоративной информацией, это может стать проблемой.

-

При работе с локальной моделью вы берете полный контроль над данными и изоляцией. Однако локальное развертывание несет и свои риски: все пункты безопасности, затрагивающие supply-chain атаки, для локальных моделей будут более актуальны.

Однако присутствует общая тенденция: чем больше компания, тем выше вероятность того, что LLM будет задеплоена локально.

А что если смешать?

На сегодняшний день набирает популярность гибридный подход, где каждая часть задач ложится на тот подход, который справляется лучше. Приведу пример применения такого сценария:

-

Локальная модель (gatekeeper) получает на вход необработанные данные, а потом их чистит, фильтрует, прячет чувствительное, проверяет формат.

-

Проприетарная LLM используется для тяжеловесного ризонинга, генерации кода, сложных запросов, которые выгоднее делегировать внешнему провайдеру.

-

После этого API-ответ может вернуться к локальной LLM для валидации, фильтров и постобработки.

Такой подход пока чаще встречается в AI-разработке, но есть тенденция распространения и на другие смежные сферы. Такой подход уменьшает риски утечек, снижает стоимость API, и при этом вы не жертвуете качеством ризонинга, если это требуется в вашем проекте.

Почитать про gatekeepers можно вот в этой статье [3], возможно именно такой подход поможет вам наиболее оптимально решить задачу.

Выбор между облачной и локальной LLM – это инженерное решение, которое должно рождаться на уровне контекста, ограничений и целей команды. И как любой инструмент, языковая модель раскрывает свой потенциал только тогда, когда встроена в систему осознанно, с учетом возможных рисков и будущего развитие инфраструктуры.

В 2025 году у нас есть уникальная возможность строить DevOps-пайплайны с использованием развивающихся мощных технологий, поэтому вопрос “API или локальная модель?” – не дилемма, а приглашение подумать шире и спроектировать систему, в которой оба подхода работают на вас.

«AI в DevOps» — практический курс в живом формате, с безопасным контуром и измеримым ROI.

На курсе вы не просто изучите теорию, а соберёте готовые инструменты под ключ:

– Подключите LLM локально (on-prem/VPC) или в облаке

– Внедрите автоматизации на n8n

– Соберёте приватного AI-бота с кастомным RAG для вашей документации

– Создадите 3+ рабочих AI-воркфлоу для реальных DevOps-задач

Старт потока 20 октября. Подробности — на сайте [1]

Автор: Hedgehog_art

Источник [4]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/20775

URLs in this post:

[1] «AI в DevOps» : https://to.slurm.io/Mj7Esw

[2] потребностей: http://www.braintools.ru/article/9534

[3] статье: https://arxiv.org/abs/2508.16765

[4] Источник: https://habr.com/ru/companies/slurm/articles/957308/?utm_source=habrahabr&utm_medium=rss&utm_campaign=957308

Нажмите здесь для печати.