Что «под капотом» у DeepSeek-V3.2-Exp? Китайцы нашли способ удешевить нейросети

У китайцев вышла новинка — DeepSeek-V3.2-Exp, экспериментальная версия последней модели DeepSeek-V3.1-Terminus. Цели и задачи у них вполне определенные: сделать архитектуру трансформеров еще более эффективной. Причем на сайте Hugging Face говорится, что особый акцент стартап делает на повышение вычислительной эффективности при обработке длинных текстовых последовательностей.

Китай снова выпустил кое-что интересное, так что давайте разбираться.

Что там интересного

DeepSeek-V3.2-Exp — экспериментальная версия, которую сами же разработчики называют «промежуточным шагом» в сторону архитектуры нового поколения. Она основана на модели V3.1-Terminus с существенным изменением — добавлением DeepSeek Sparse Attention. Это механизм разреженного внимания [1], разработанный для исследования и проверки оптимизаций, повышающих эффективность обучения [2] и инференса в задачах с длинным контекстом.

Если упростить, Sparse Attention нужен, чтобы модель могла быстрее и экономичнее работать с очень длинными текстами. Идея в том, чтобы не тратить вычислительные ресурсы на обработку каждой мелочи, а фокусироваться только на действительно важных частях текста.

Иными словами, цель эксперимента — проверить, можно ли сделать обучение и работу модели с большими объемами текста более легкими и эффективными.

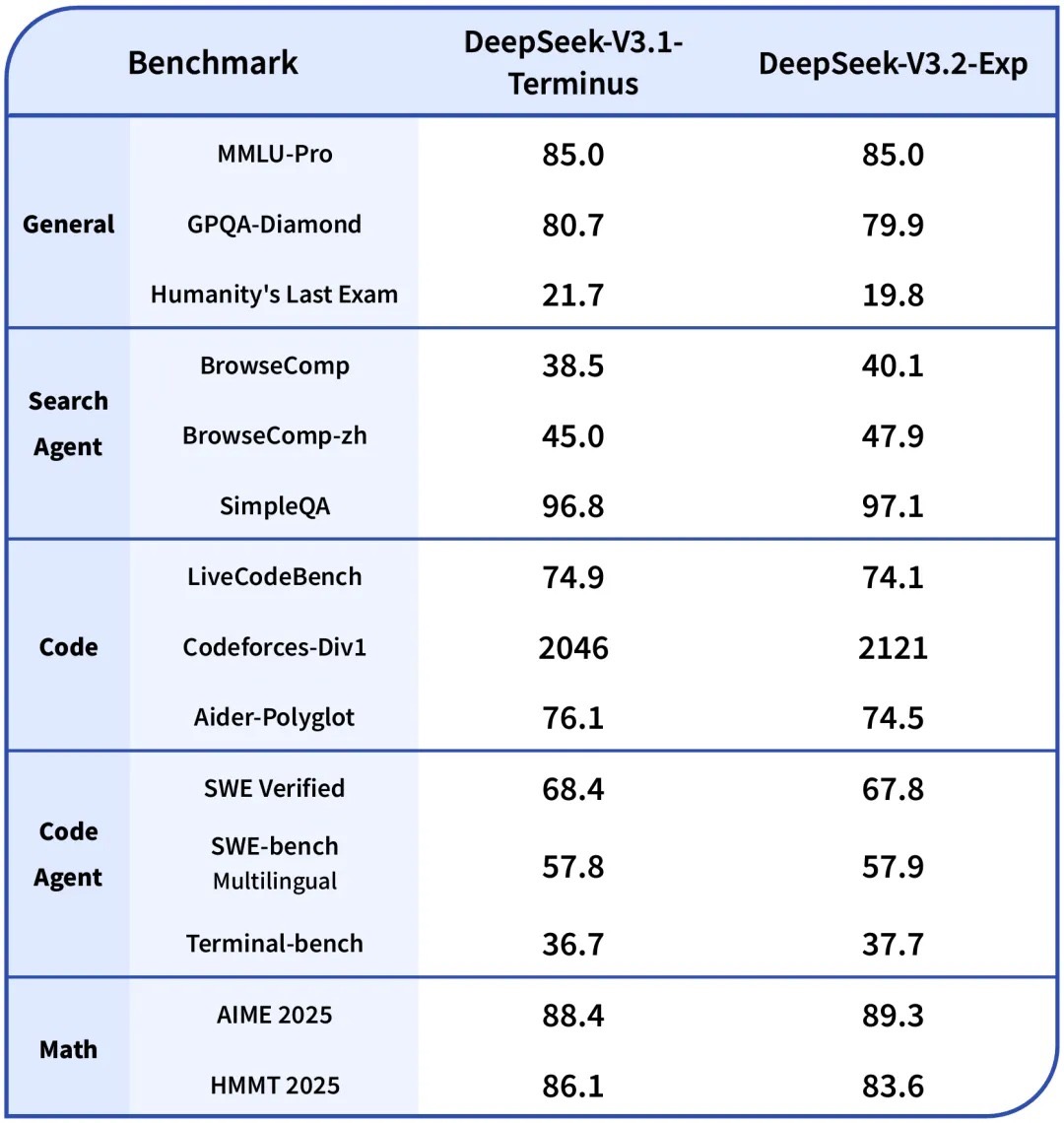

Что там по бенчмаркам

Интересный результат показали испытания на бенчмарках. Никакого резкого всплеска, который можно было бы ожидать от громких заявлений, даже больше — в некоторых ситуациях DeepSeek-V3.2-Exp уступает своей «материнской» модели V3.1-Terminus. Например, кодить новинке удается явно хуже, и результаты проверки на бенчмарке Humanity’s Last Exam тоже оказались посредственными в сравнению с V3.1-Terminus.

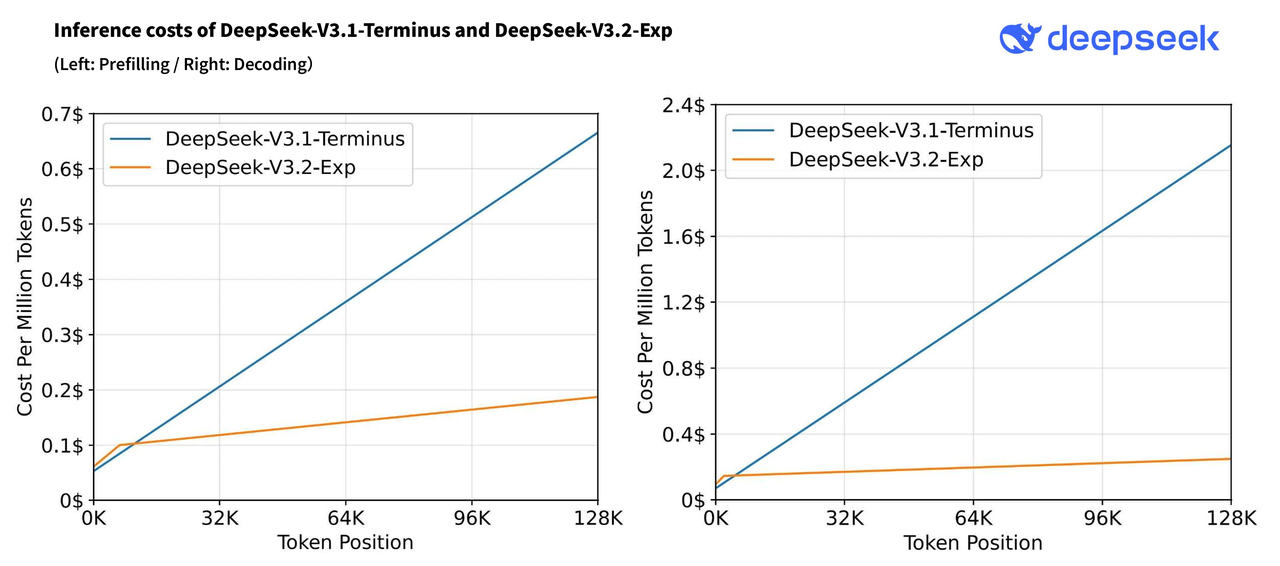

Важно другое — стоимость запроса стала сильно меньше.

На иллюстрации сверху видно, что DeepSeek-V3.2-Exp тратит гораздо меньше за миллион токенов, чем основная модель, и это может стать решающим фактором для китайских разработчиков. Невольно вспоминаются слова Сэма Альтмана, которые он написал в одном из своих постов [3]: «Стоимость использования определенного уровня ИИ снижается примерно в 10 раз каждые 12 месяцев, а более низкие цены приводят к значительно более широкому применению». Так что разработчики действительно ищут способы удешевить стоимость нейросетей, и DeepSeek тому пример. Зачем? Чтобы DeepSeek применялась шире, конечно же.

И все благодаря механизму Sparse Attention.

Что такое Sparse Attention

Можно представить работу нейросети как поиск авиакомпанией наилучшего маршрута из одной точки в другую. Вместо того, чтобы летать по всем возможным маршрутам, авиакомпания просто отсекает те варианты, которые невыгодны, дорого стоят, приводят к сильным затратам топлива или просто невозможны: вот это и есть Sparse Attention. Вместо того, чтобы обрабатывать абсолютно все данные, оснащенная этим механизмом нейросеть просто отсекает те, которые кажутся ей лишними. Таким образом, она тратит значительно меньше вычислительных мощностей и обходится пользователям дешевле.

При этом есть и минусы. Абсолютно непонятно, что именно отсекает нейросеть. Это своего рода «черный ящик», в который невозможно заглянуть. В этом смысле ИИ оперирует только своей внутренней логикой [4], а значит, может не учесть какие-то важные нюансы.

Нельзя сказать, что сам механизм разреженного внимания какой-то сверхновый. Более того, он — опенсорс, а значит, DeepSeek не удастся его запатентовать.

Однако важно, на мой взгляд, не это. Важно то, что DeepSeek продолжает пробовать новое — и даже называет DeepSeek-V3.2-Exp «промежуточным шагом к архитектуре нового поколения», как я уже писал выше. При этом разработчики понимают, что людям интересно новое, эффективное и дешевое, именно в такой комбинации. Учитывая, какую яростную борьбу ведут нейросети Китая и США, для Поднебесной достижение искомого результата может стать серьезной картой в игре. В которую, похоже, китайцы играют «в долгую».

Хотя сегодня DeepSeek-V3.2-Exp — лишь промежуточный шаг, завтра он может оказаться фундаментом для следующего большого скачка.

Автор: kpshinnik

Источник [5]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/20881

URLs in this post:

[1] внимания: http://www.braintools.ru/article/7595

[2] обучения: http://www.braintools.ru/article/5125

[3] постов: https://blog.samaltman.com/three-observations

[4] логикой: http://www.braintools.ru/article/7640

[5] Источник: https://habr.com/ru/articles/957252/?utm_source=habrahabr&utm_medium=rss&utm_campaign=957252

Нажмите здесь для печати.