Meta и исследователи из OpenAI: новые подходы к защите LLM от prompt injection

Команда AI for Devs [1] подготовила перевод краткой выжимки свежих статей о безопасности LLM. Meta предлагает «Правило двух» — архитектурный принцип, ограничивающий права AI-агентов, чтобы защитить их от prompt injection. А исследователи из OpenAI, Anthropic и Google DeepMind показывают: все существующие защиты легко обходятся адаптивными атаками.

На этих выходных мне попались две интересные работы о безопасности LLM и атаках через prompt injection.

Agents Rule of Two: Практический подход к безопасности AI-агентов

Первая статья — Agents Rule of Two: A Practical Approach to AI Agent Security [2], опубликована 31 октября в блоге Meta AI. Авторы не указаны, но ссылкой поделился исследователь по безопасности Meta AI Мик Айзенберг (Mick Ayzenberg [3]).

Авторы предлагают «Правило двух» (Rule of Two [4]), вдохновлённое одновременно моей концепцией «смертельной триады [5]» и принципом Rule of 2, которым пользуется команда Google Chrome при работе с недоверенными входными данными.

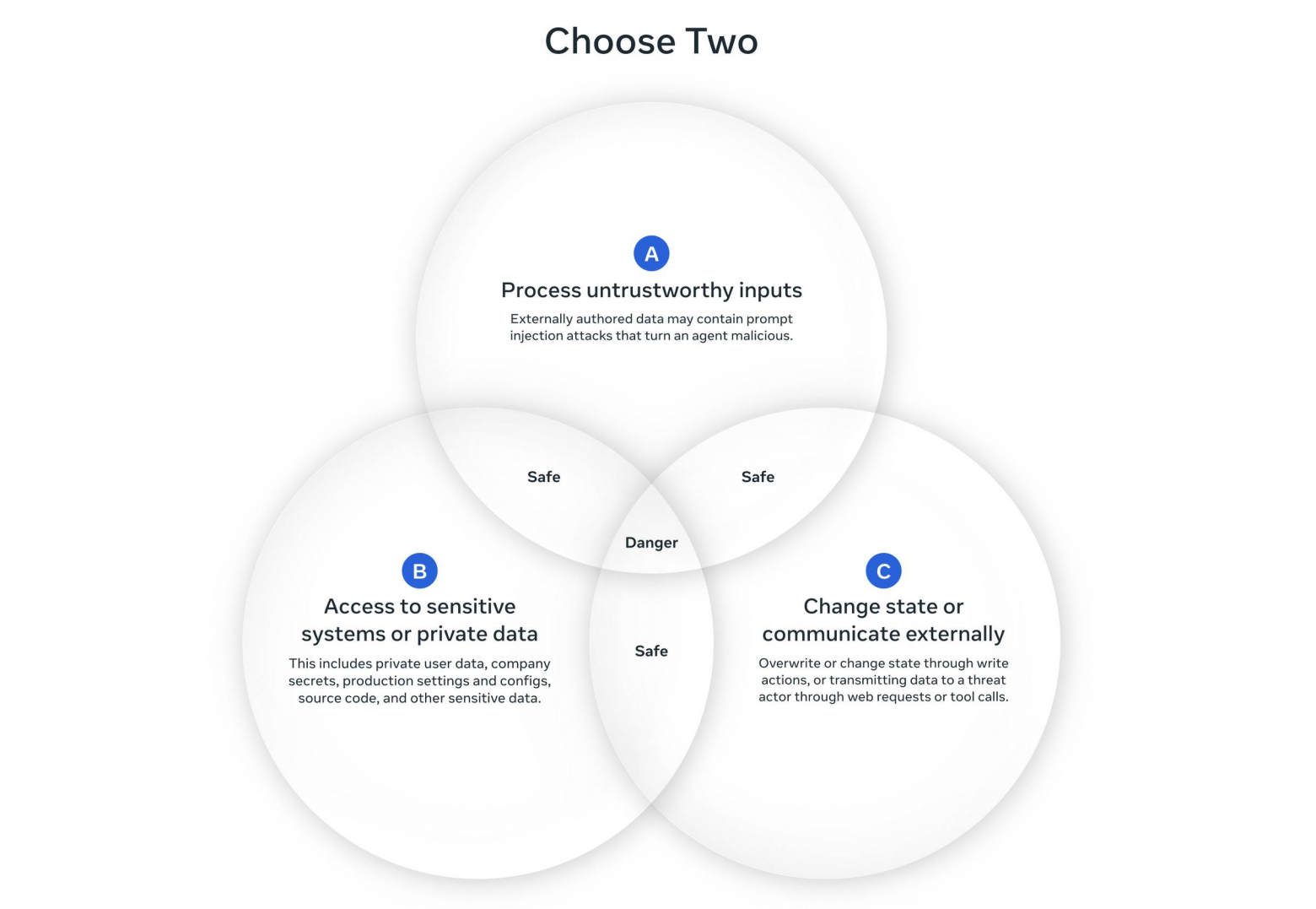

В общих чертах Agents Rule of Two утверждает, что до тех пор, пока исследования не позволят надёжно обнаруживать и блокировать prompt injection, агент в рамках одной сессии не должен совмещать более двух из трёх следующих свойств — чтобы избежать наихудших последствий от атаки:

-

[A] Агент может обрабатывать недостоверные входные данные.

-

[B] Агент имеет доступ к конфиденциальным системам или приватным данным.

-

[C] Агент может изменять состояние или взаимодействовать с внешними системами.

Иногда для выполнения задачи агенту действительно нужны все три свойства. Если без них не обойтись, следует запускать новый сеанс (т.е. с новым контекстным окном). И в этом случае агент не должен действовать автономно — хотя бы минимально требуется контроль человека (human-in-the-loop) или другой надёжный механизм проверки.

К статье прилагается наглядная схема:

Мне эта идея очень нравится.

Я уже несколько лет пытаюсь объяснить разработчикам, создающим решения на основе LLM, риски атак через prompt injection. Это невероятно сложно донести просто.

Лучше всего у меня получалось со «смертельной триадой» — она сводит один тип атак к простой модели: если система имеет доступ к приватным данным, работает с недоверенным контентом и может отправлять данные наружу, то она уязвима для утечки.

Проблема в том, что эта триада охватывает лишь риск кражи данных, но не другие, зачастую более опасные последствия атак на LLM-агентов с доступом к инструментам.

Rule of Two элегантно решает эту проблему, добавляя свойство «изменения состояния». Это учитывает и другие сценарии, где агент может выполнять действия, инициированные недоверенным вводом, — и к ним стоит относиться крайне осторожно.

Отрадно видеть, что крупная исследовательская группа подтверждает: проблема prompt injection остаётся нерешённой, а попытки блокировать или фильтровать такие атаки пока недостаточно надёжны. На текущем этапе нужно проектировать системы с этим ограничением в виду, и Rule of Two — отличный способ мыслить в этом направлении.

Обновление. Поразмышляв, я понял, что одна деталь в модели Rule of Two мне не нравится: на диаграмме комбинация «недоверенные входные данные + возможность изменять состояние» помечена как «безопасная», но это неверно. Даже без доступа к конфиденциальным данным такая связка может привести к вредным последствиям. Добавление исключения разрушает элегантность принципа, но модель всё равно стоит внимания [6].

The Attacker Moves Second: Более сильные адаптивные атаки обходят защиты от LLM jailbreak и prompt injection

Вторая работа, датированная 10 октября 2025 года и опубликованная на Arxiv [7], принадлежит внушительной команде из 14 авторов — среди них представители OpenAI, Anthropic и Google DeepMind: Милад Наср, Николас Карлини, Чавин Ситава́рин, Сандер В. Шульхофф, Джейми Хейз, Майкл Илие, Жюльет Плуто, Шуан Сонг, Харш Чаудхари, Илья Шумайлов, Абхрадип Такурта, Кай Юаньцин Сяо, Андреас Терзис и Флориан Трэмер.

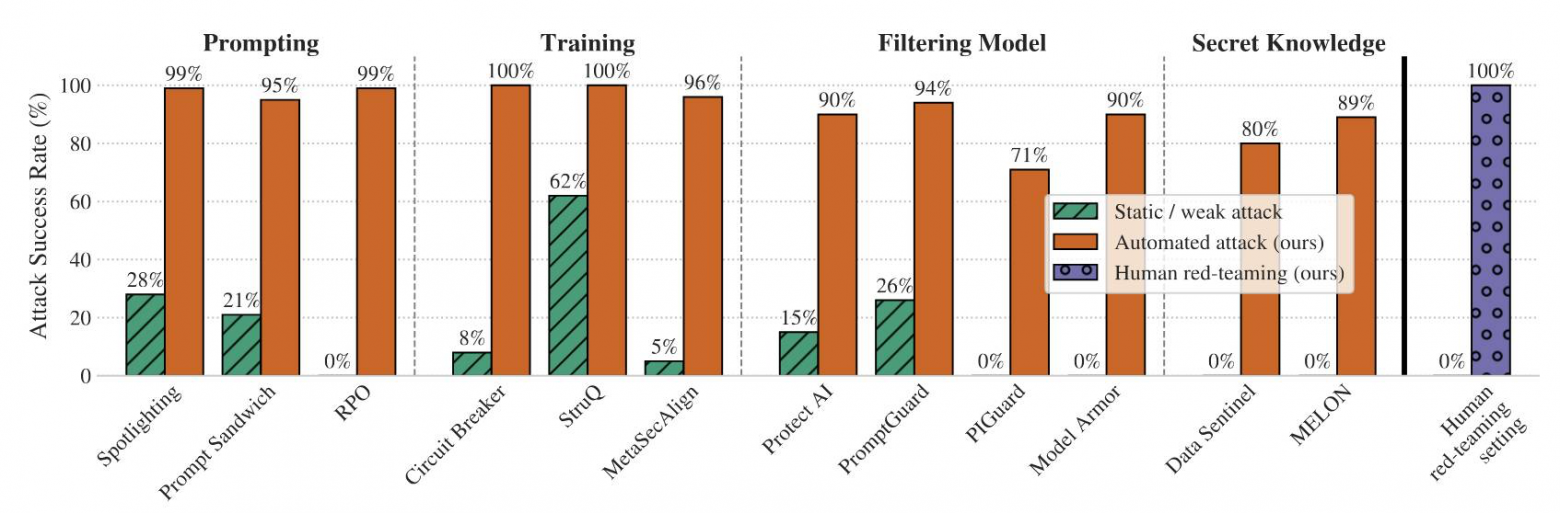

Исследование рассматривает 12 опубликованных методов защиты от prompt injection и jailbreak-атак, проверяя их устойчивость к «адаптивным атакам» — то есть атакам, которые могут многократно подстраиваться, анализировать ответы и искать обходные пути.

Результаты оказались неутешительными:

Систематически настраивая и масштабируя общие методы оптимизации — градиентный спуск, обучение [8] с подкреплением [9], случайный поиск и исследование с участием человека — мы обошли 12 современных защит (основанных на разных техниках) с успешностью атак выше 90% в большинстве случаев. При этом многие из этих защит ранее показывали почти нулевой успех атак.

Особенно показательным оказался эксперимент с human red-teaming — команда из 500 участников в онлайн-соревновании с призовым фондом $20 000 смогла обойти все защиты (100% успешности).

Главный тезис статьи: тестирование с помощью фиксированных примеров (одиночных строк, обходящих систему) не имеет смысла. Реальные атаки адаптивны, итеративны и гораздо мощнее. Это наглядно показывает следующая диаграмма:

Сравниваются три типа атак: статическая (зелёные штрихованные столбцы), автоматизированная (оранжевые) и human red-teaming (фиолетовые пунктирные).

Примеры результатов: Spotlighting (28% статических, 99% автоматизированных), Prompt Sandwich (21% и 95%), RPO (0% и 99%), Circuit Breaker (8% и 100%), StruQ (62% и 100%), SeqAlign (5% и 96%), ProtectAI (15% и 90%), PromptGuard (26% и 94%), PIGuard (0% и 71%), Model Armor (0% и 90%), Data Sentinel (0% и 80%), MELON (0% и 89%), human red-teaming — 100%.

Авторы использовали три типа автоматических адаптивных атак:

-

Методы на основе градиентов — наименее эффективные, применяющие подход из классической статьи Universal and Transferable Adversarial Attacks on Aligned Language Models [10] (2023 [11]).

-

Методы с обучением с подкреплением — особенно результативные против «чёрных ящиков»: атакующая модель напрямую взаимодействует с защищённой системой, наблюдая ответы; использовалось 32 сессии по 5 раундов.

-

Методы поиска — LLM генерирует варианты атак, затем оценивает и дорабатывает их, используя «LLM-as-judge» и прочие классификаторы.

Заключение статьи звучит сдержанно оптимистично:

[…] Адаптивные оценки сложнее проводить, поэтому их проведение особенно важно. Мы призываем авторов защит выпускать простые, понятные решения, пригодные для человеческого анализа. […] Надеемся, что наш анализ повысит стандарт оценки защит и, возможно, приблизит появление действительно надёжных средств против jailbreak и prompt injection.

Но, учитывая, насколько легко были взломаны все протестированные защиты, я не разделяю этого оптимизма.

Как обзор текущего состояния дел эта работа производит сильное впечатление [12] — и, пожалуй, усиливает аргументы в пользу Agents Rule of Two как самого практичного подхода к созданию безопасных систем с LLM-агентами, пока у нас нет надёжных защит от prompt injection.

Русскоязычное сообщество про AI в разработке

Друзья! Эту статью подготовила команда ТГК «AI for Devs [1]» — канала, где мы рассказываем про AI-ассистентов, плагины для IDE, делимся практическими кейсами и свежими новостями из мира ИИ. Подписывайтесь [1], чтобы быть в курсе и ничего не упустить!

Автор: python_leader

Источник [13]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/21465

URLs in this post:

[1] AI for Devs: https://t.me/+OjC04jadTmMxZDAy

[2] Agents Rule of Two: A Practical Approach to AI Agent Security: https://ai.meta.com/blog/practical-ai-agent-security/

[3] Mick Ayzenberg: https://x.com/MickAyzenberg/status/1984355145917088235

[4] Rule of Two: https://chromium.googlesource.com/chromium/src/+/main/docs/security/rule-of-2.md

[5] смертельной триады: https://simonwillison.net/2025/Jun/16/the-lethal-trifecta/

[6] внимания: http://www.braintools.ru/article/7595

[7] опубликованная на Arxiv: https://arxiv.org/abs/2510.09023

[8] обучение: http://www.braintools.ru/article/5125

[9] подкреплением: http://www.braintools.ru/article/5528

[10] Universal and Transferable Adversarial Attacks on Aligned Language Models: https://arxiv.org/abs/2307.15043

[11] 2023: https://simonwillison.net/2023/Jul/27/universal-and-transferable-attacks-on-aligned-language-models/

[12] впечатление: http://www.braintools.ru/article/2012

[13] Источник: https://habr.com/ru/articles/962818/?utm_source=habrahabr&utm_medium=rss&utm_campaign=962818

Нажмите здесь для печати.