Как обучить ИИ работать за компьютером

Агенты, которые умеют управлять компьютером, часто не справляются с, казалось бы, простым шагом: найти на экране элемент, описанный в человеческой инструкции. Сделать такую привязку особенно трудно на интерфейсах с обилием мелких элементов, похожих панелей, высоким разрешением, помехами и артефактами. Команда GroundCUA показывает, как решить эту узкую, но важную задачу — сделать привязку языка к интерфейсу достаточно точной и надёжной, чтобы агент уверенно выполнял действия шаг за шагом.

О чем идет речь

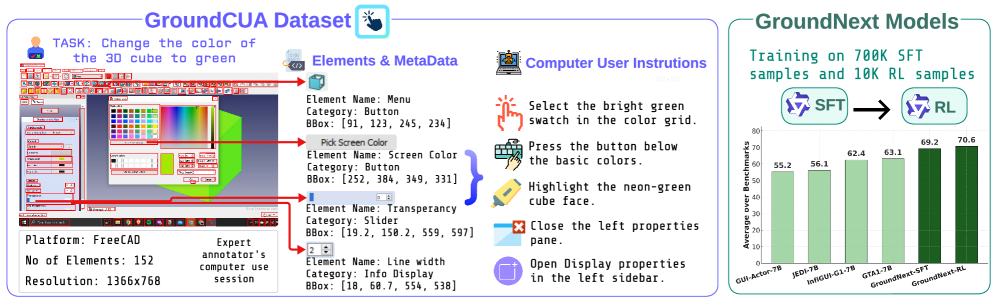

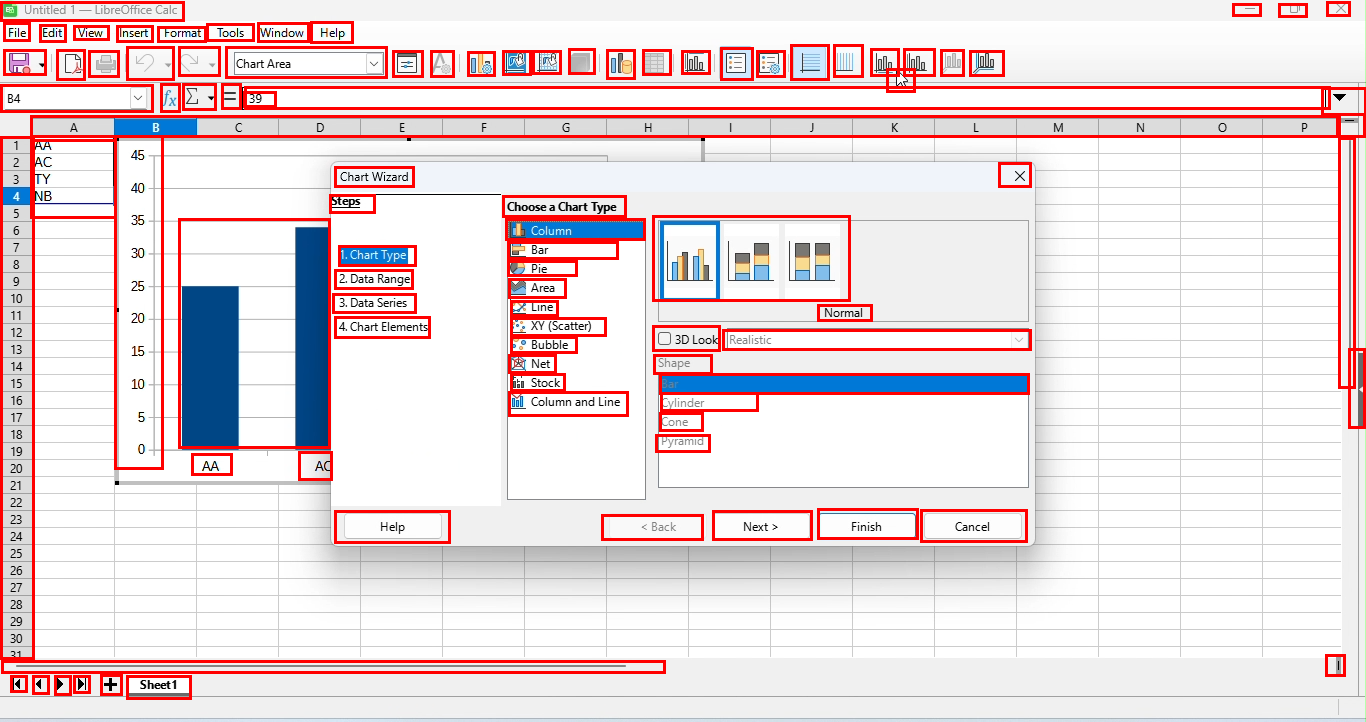

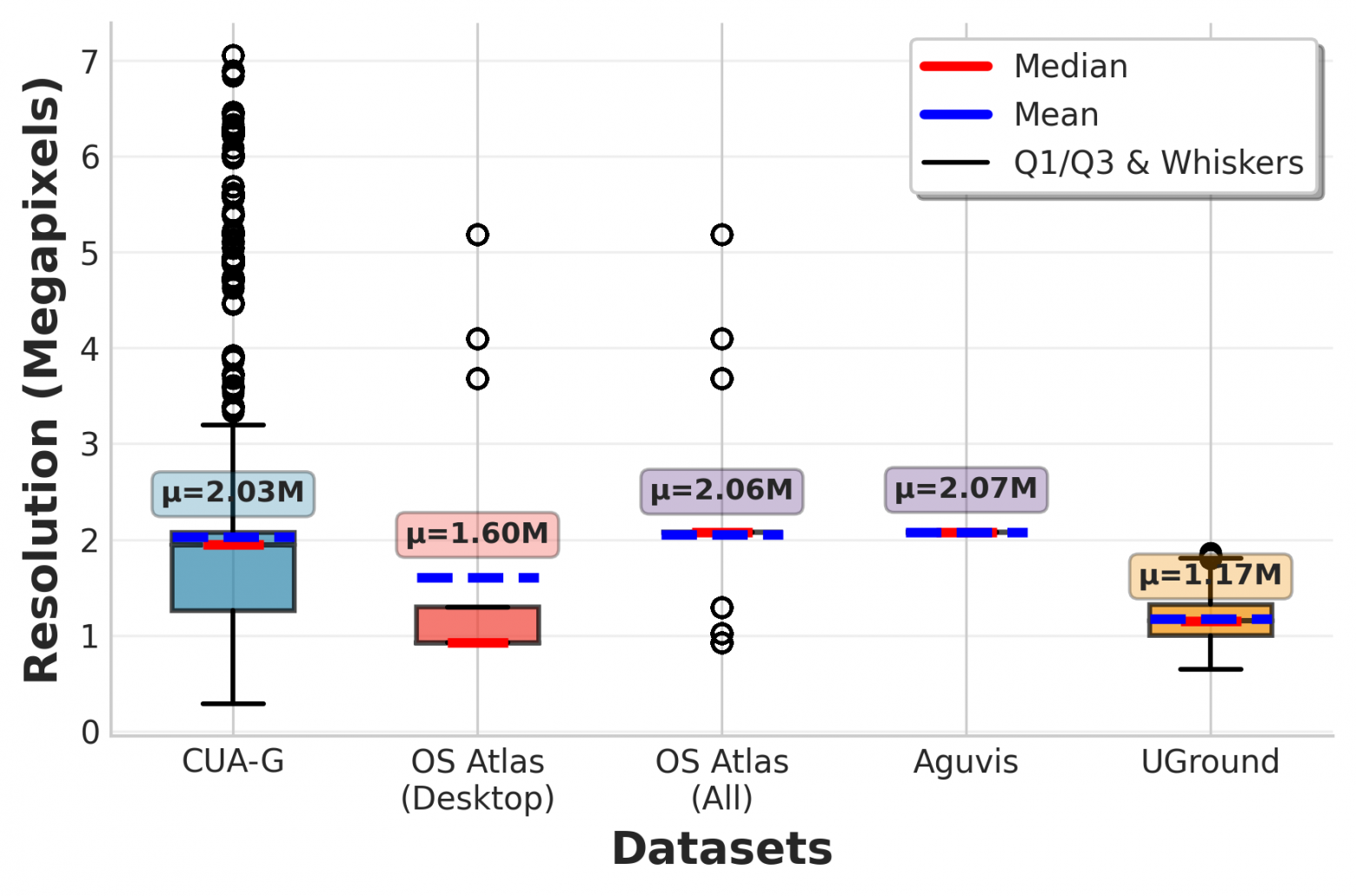

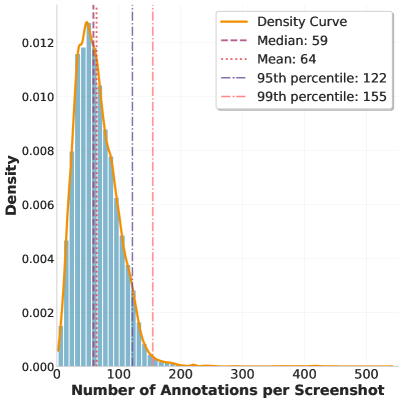

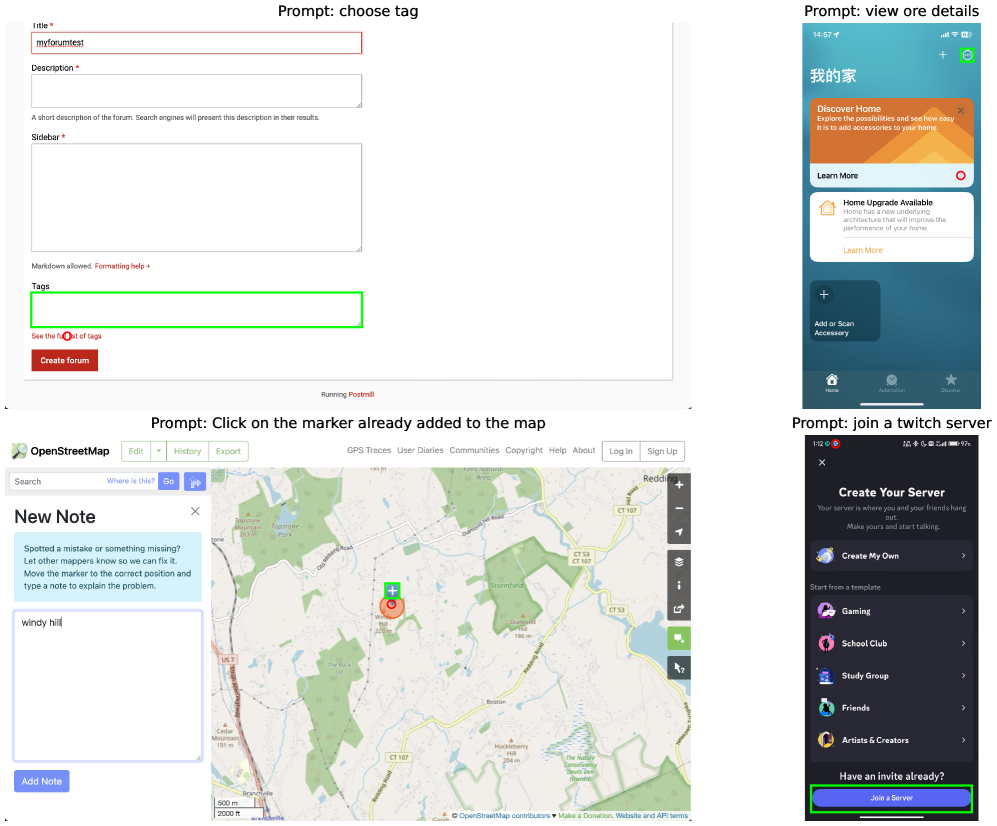

Исследователи предложили набор данных GroundCUA для привязки десктопных интерфейсов, собранный из реальных демонстраций экспертов. Поддерживает 87 приложений в 12 категориях, содержит 56 тысяч скриншотов и более 3,56 млн тщательно проверенных аннотаций практически каждого видимого элемента. Половина элементов имеют категорию, а разрешение изображений варьируется от 0,39 до 7 мегапикселей. В среднем на кадре 64 аннотированных объекта: много очень маленьких боксов, много категорий. Получился неплохой срез работы за компьютером.

Как собрали данные и инструкции

Для GroundCUA не нужен случайный обход интерфейсов: аннотаторы выполняют повседневные задачи в разных программах, записывают экран, выбирают ключевые кадры и размечают каждый элемент боксом и подписью. Длинные подписи дописывают с помощью OCR. Из получившейся плотной разметки большой языковой моделью формируют три типа инструкций: прямые – по атрибутам и окружению, функциональные – по назначению, пространственные – относительно якорей. Получается 700 тыс. ситуаций для дообучения и 10 тыс. – для дообучения с подкреплением [1].

Почему это работает

Авторы считают, что вместо миллиона синтетических сцен – лучше десятки тысяч реальных, но плотно и подробно размеченных кадров. Это учит модель справляться с неоднозначностями, мелкими и визуально похожими элементами.

Как учили модели

Поверх Qwen2.5-VL-Instruct авторы обучили две версии GroundNext с 3 и 7 млрд параметров. Использовали два этапа:

-

Supervised Fine-Tuning на 700 тыс. пар скриншот-инструкция. Модель по инструкции предсказывает координаты точки на экране. Отложенные 10 тыс. ситуаций для дообучения с подкреплением. Награда задаётся дискретной функцией расстояния от целевого бокса: штраф — снаружи, поощрение — ближе к центру. Эта схема заметно упрощает RL и повышает качество на сложных интерфейсах.

-

Модель получает дополнительное преимущество от обучения [2] с подкреплением, при этом обучение с подкреплением становится легче благодаря хорошо подобранному пространству действий и функции вознаграждения.

Что получилось в цифрах

На пяти датасетах для привязки десктопных интерфейсов модель достигает базового уровня, обучаясь на 700 тыс. примеров против 9 млн у JEDI.

-

Обучение с подкреплением дает небольшой и стабильный прирост поверх SFT.

-

На агентном бенчмарке OSWorld-Verified с планировщиком o3 модель показывает 50.6, обгоняя несколько более крупных моделей и находясь чуть ниже JEDI-7B, но требуя гораздо меньше ресурсов для дообучения. Получается хорошо, ведь используется гораздо меньше данных.

-

Заметен перенос на мобильные и веб-интерфейсы: на соответствующих бенчмарках модель достигает качества, сравнимого с конкурентами, которым дополнительно скармливали соответствующие данные.

Где прирост особенно заметен

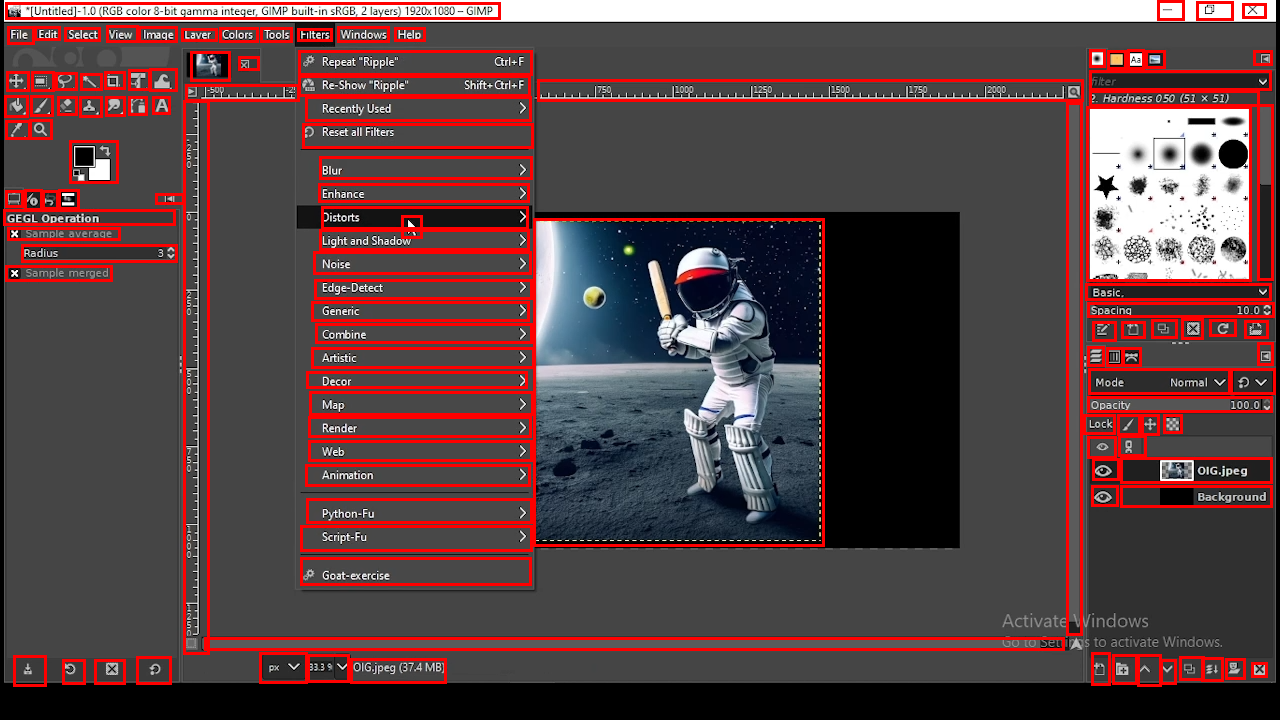

На датасетах, связанных с Linux и macOS: там много мелких иконок, и хорошо заметен эффект от ручной разметки. Среди категорий приложений особенно хорошо получаются офисные приложения, приложения для разработки и креатива: много ситуаций, где надо отличать визуально похожие элементы и подписи от контейнеров.

Почему это важно

Агенты, которые хорошо справляются с реальными задачами на компьютере, должны не только уметь планировать действия, но и попадать по нужным элементам так, как просит пользователь. GroundCUA показывает, что широкий охват приложений и плотная разметка важных кадров делает рабочую привязку.

На мой взгляд, будущее компьютерных агентов зависит не от размера моделей, а от точного соответствия языка интерфейсу — и GroundCUA делает важный шаг именно в эту сторону.

📜 Полная статья [3]

***

Если вам интересна тема ИИ, подписывайтесь на мой Telegram-канал [4] — там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

Автор: andre_dataist

Источник [5]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/21932

URLs in this post:

[1] подкреплением: http://www.braintools.ru/article/5528

[2] обучения: http://www.braintools.ru/article/5125

[3] 📜 Полная статья: https://arxiv.org/abs/2511.07332

[4] подписывайтесь на мой Telegram-канал: https://t.me/+Rlp3DMs25BQ2OTVi

[5] Источник: https://habr.com/ru/articles/966428/?utm_source=habrahabr&utm_medium=rss&utm_campaign=966428

Нажмите здесь для печати.