Локальные нейросети для бизнеса: как сэкономить время и деньги с Mac Mini и GPT-OSS-20B

Привет! Меня зовут Максим Морозов, я AI project manager в Битрикс24.

В эпоху тотальной цифровизации даже малому бизнесу необходимо использовать искусственный интеллект [1] — анализировать отзывы, автоматизировать рутину или создавать чат-ботов. Но облачные API (OpenAI, Claude) обходятся дорого, и не все готовы передавать данные третьим лицам из-за требований конфиденциальности. Решение? Локальные нейросети на собственном «железе».

Мы протестировали Mac Mini M4 Pro (24 ГБ ОЗУ) с открытой моделью GPT-OSS-20B и инструментом LM Studio, чтобы понять, может ли вообще заменить облачные API локальным решением, сколько это сэкономит времени и денег и есть ли в этом решении подводные камни.

Спойлер: да, можно, и это выгоднее при высоких нагрузках. Рассказываем, как выбрать модель и настроить систему — без серверов, VPN и лишних затрат.

Почему локальные нейросети и кому это нужно?

Как я уже упоминал выше, облачные API стоят денег и для многих отраслей недопустима передача данных на внешние серверы.

-

Стоимость: $10–1000/месяц за токены (в зависимости от нагрузки).

-

Ограничения: Лимиты на количество запросов, зависимость от интернета.

-

Конфиденциальность: Данные отправляются на сторонние серверы (критично для медицины, юристов, финансов).

Стартапам и малому бизнесу, компаниям с чувствительными данными и тем, кто хочет экспериментировать без ограничений и оплаты за токены, подойдет локальное решение.

По этим же причинам не подходит самохостинг на AWS или Yandex Cloud:

-

Мы не хотим передавать персональные данные третьим лицам.

-

Мы выбираем простое решение, где не нужно настраивать сервер, ключи, подписки, VPN.

-

Мы хотим исключить риск блокировок и зависимость от западных сервисов, например, OpenAI, Claude.

Железо: что выбрали и почему

Для наших задач мы выбрали устройство Mac Mini M4 Pro (24 ГБ ОЗУ, 512 ГБ SSD) стоимостью около 150 000 руб.

Локальная нейросеть подойдет тем компаниям, у которых уже есть Mac на M-чипах (даже с 16 ГБ ОЗУ) и тем, кто хочет минимальных затрат времени на развёртывание и поддержку.

Почему Mac Mini, а не Windows Server или Linux-машина:

-

Простота: Mac Mini — это готовое решение «из коробки». Apple Silicon оптимизирован для AI-задач через фреймворк MLX. Не нужно подбирать компоненты, собирать сервер, устанавливать ОС, настраивать драйверы или охлаждение. Достаточно подключить к розетке и монитору (или использовать MacBook Pro без дополнительного оборудования).

-

Надёжность: Мы тестировали Mac Mini M4 Pro сутками под непрерывной нагрузкой — нет перегрева, падений или потери данных. Остаётся запас ресурсов для других задач (например, веб-сервер, n8n, хранилище).

-

Экономия времени: Ноль настройки для базового использования. Не нужен технический специалист — разберётся даже директор или сотрудник без IT-навыков.

-

Финансовая экономия: 150 000 руб. однократно vs ежемесячная плата за облако.

-

Сравнение с серверами:

-

Сервер на Windows/Linux требует выбора комплектующих (видеокарта, блок питания, ОЗУ и т.д.), сборки, настройки ОС, охлаждения, обслуживания и места для размещения.

-

Mac Mini занимает 12,7 × 12,7 × 5 см, весит 730 грамм и потребляет ~40 Вт (0,04 кВт/ч). При максимальной нагрузке 24/7 стоимость электроэнергии ~7 рублей/сутки (по среднему тарифу в России ~7 руб/кВт·ч).

-

Пример: 0,04 кВт × 24 ч × 30 дней × 7 руб = ~200 руб/мес (против ~10 000 руб/мес за облачные API. В зависимости от нагрузки).

-

Из минусов этого решения — ограниченный апгрейд (память/диск не меняются).

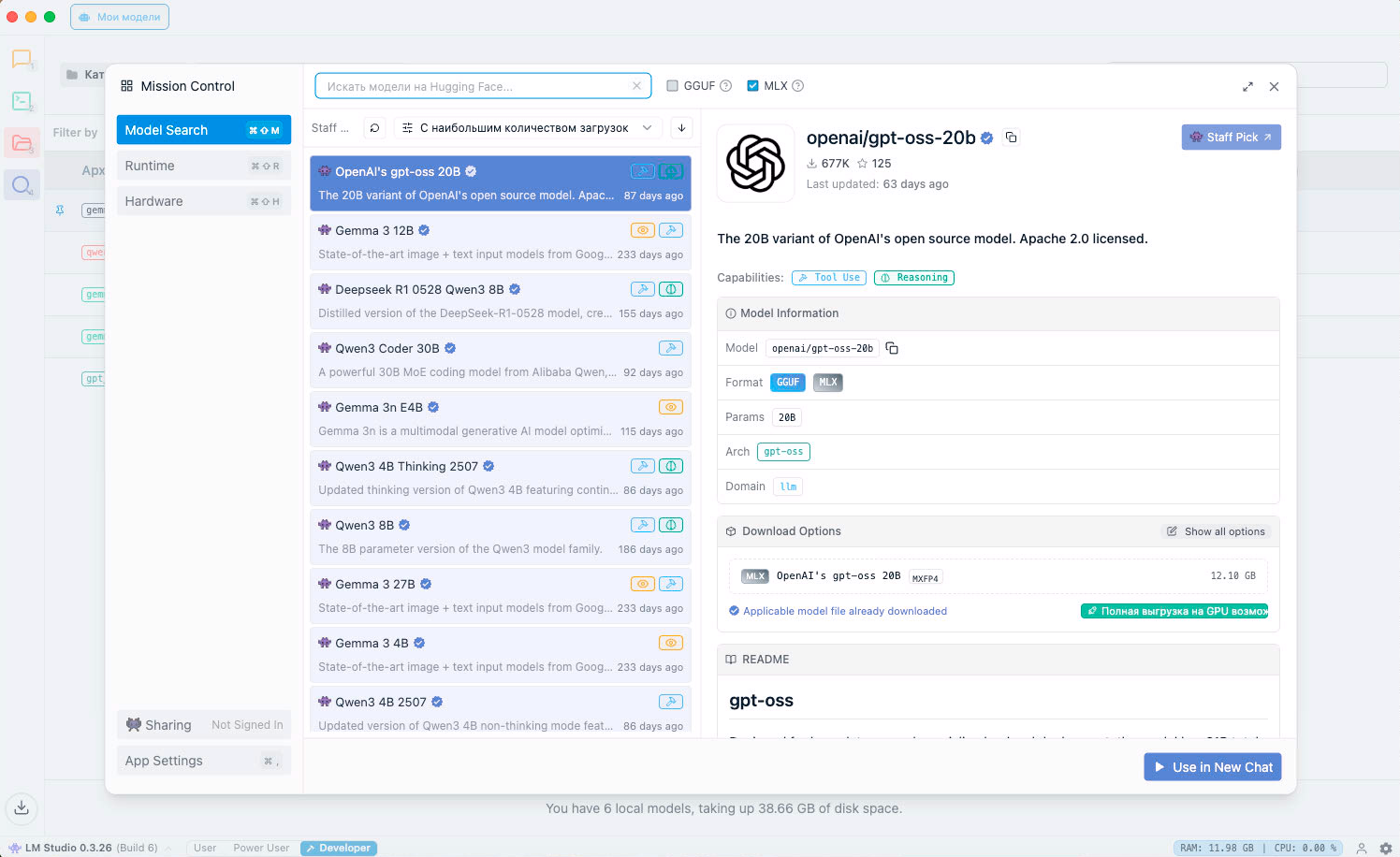

Модель: почему GPT-OSS-20B

Это самая быстрая и точная среди протестированных открытых моделей (до 70 токенов/сек). Она отлично работает с русским и английским языками, никаких ограничений по локализации нет. Модель поддерживает контекст 128K токенов, которого хватает для 80% бизнес-задач, например, обработки документов, логов, ведения диалога.

Что еще привлекло нас в этой модели:

-

Лицензия Apache 2.0 — можно использовать в бизнесе без ограничений.

-

Три уровня размышления (low, medium, high)

-

Потребление: 12–13 ГБ ОЗУ (остаётся ресурс для других процессов).

Минус этой модели — она не работает с изображениями.

Также есть ряд особенностей, которые я рекомендую учитывать. Во-первых, модели не обновляются автоматически. Новые версии нужно скачивать вручную через LM Studio, но это бесплатно.

Для простых задач (чат-бот, анализ документов) не нужен программист. Достаточно установить LM Studio и подключить сотрудников через локальную сеть. Но для сложной автоматизации, например, связки с CRM, будет нужен технический специалист, который разберется в API, напишет скрипты на Python и т.д., но это тема для отдельной статьи.

Инструмент LM Studio бесплатен для коммерческого использования. Он позволяет загружать модели «по требованию», что экономит память [2], имеет удобный интерфейс и встроенный API, совместимый с OpenAI API.

LM Studio позволяет развернуть локальную нейросеть за 30 минут — без терминала и сложных настроек.

Сравнение: Локальная GPT-OSS-20B vs облачные API

🏆 Когда локальная модель побеждает:

-

Конфиденциальность

-

Данные вообще не уходят из сети

-

Полная прозрачность — знаем где лежат наши данные

-

Критично для ПД сотрудников, финансов, медицины

-

-

Экономика на длинной дистанции

-

Нет переплат за API запросы

-

На большие объёмы — намного дешевле

-

Предсказуемые расходы (покупка железа)

-

-

Скорость и надёжность

-

Работает без интернета

-

Не зависим от uptime облачного сервиса

-

⚠️ Когда облачные API выигрывают:

-

Качество моделей

-

На порядки мощнее текущей OSS-20B

-

Для сложных задач облако все еще лучше

-

Постоянные обновления

-

-

Простота развертывания

-

Не нужна инфраструктура

-

Моментально готово к использованию

-

Нет забот об обслуживании

-

-

Масштабируемость

-

Облако масштабируется автоматически

-

Не ограничен мощностью одного сервера

-

Пиковые нагрузки — без проблем

-

-

Универсальность

-

Одна модель для всех задач

-

Не нужно делать выбор между моделями

-

API работает везде

-

Какие задачи можно решить с помощью локальной нейросети

-

Обработка персональных данных сотрудников (зарплаты, адреса, паспорта)

-

Анализ коммерческих контрактов и NDA

-

Работа с финансовой отчетностью

-

Обработка медицинских данных

-

Анонимизация документов

-

Анализ внутренних чатов и переписки

-

Анализ юридических документов

-

Анализ писем с ПД клиентов

-

Классификация обращений с конфиденциальной информацией

-

Определение эмоциональной окраски не только отзывов, но и новостных статей, комментариев в соцсетях, переписок

-

Маршрутизация чувствительных вопросов и т.д.

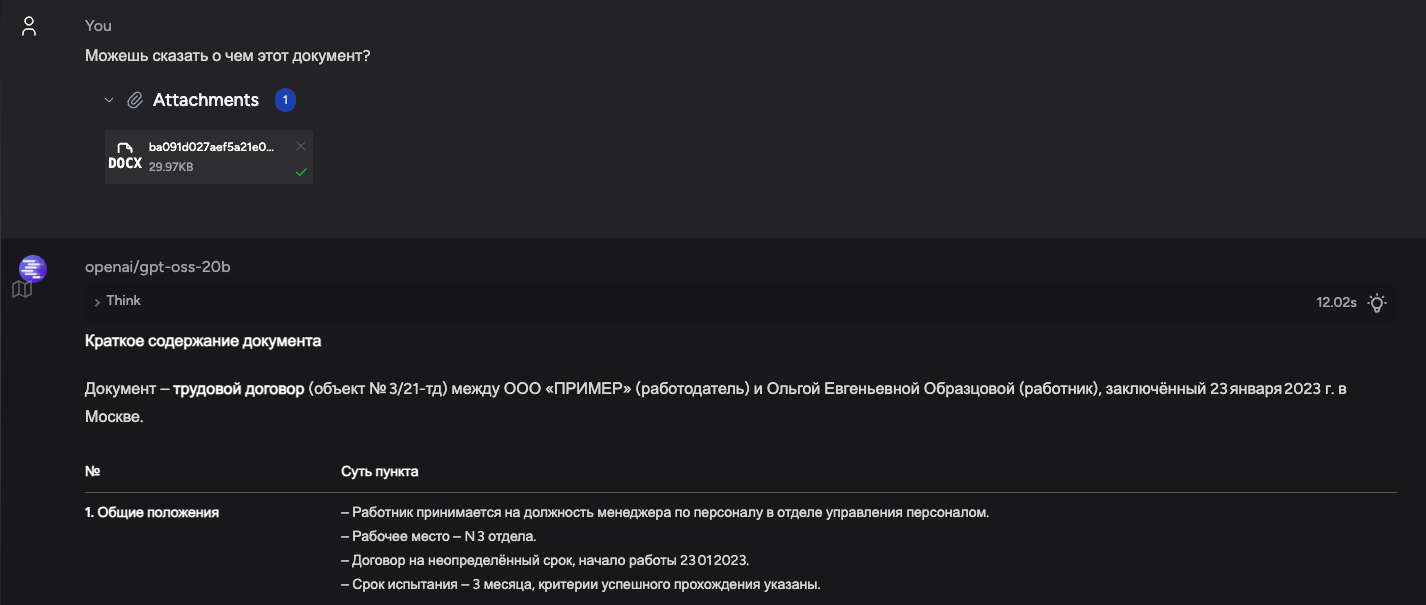

Нюансы работы с локальными моделями

Локальные нейронные сети способны решить до 80% бизнес-задач, но их использование имеет свои особенности.

Основной нюанс заключается в подходе к формулировке запросов. Если в крупных моделях можно одним промптом задать сложную многоэтапную задачу (например, проанализировать договор, сделать выводы, составить таблицу с плюсами и минусами), то с локальными моделями придется действовать итеративно.

Как это работает?

-

Разбиваем задачу на этапы:

-

Сначала просим проанализировать документ (первый промпт).

-

Затем уточняем детали или просим объяснить ключевые моменты (второй промпт).

-

Далее формируем запрос на выделение плюсов и минусов (третий промпт).

-

В финале просим оформить результат в нужном формате (четвёртый промпт и далее).

-

-

Автоматизация: При правильной настройке процесс можно автоматизировать: загружаете документ — система последовательно выполняет все этапы, выдавая результат, сопоставимый с крупными моделями.

-

Ограничения и решения:

-

Локальные модели могут не знать специфических областей, но это решается подключением собственной базы знаний или добавлением примеров и правил в промпт.

-

Важно чётко описывать ожидаемый формат ответа: таблица, список, развёрнутый текст и т.д.

-

Это не минус, а особенность: локальные сети требуют немного больше времени на настройку, но при этом дают гибкость, контроль и возможность работать с конфиденциальными данными без внешних сервисов.

Насколько быстро это работает

Предположим, модель анализирует информацию и создает ответ по договору из 6 страниц за 30 секунд.

В сутки модель может обработать: 86 400 / 30 = 2 880 таких документов (при условии настроенной автоматизации)

В час: 2 880 / 24 = 120 документов/час.

Отмечу, что наибольшая часть времени уходит именно на генерацию ответа – примерно 70 токенов в секунду. Поэтому если задача сводится к определению и формулировке результата одним словом, она выполняется в разы быстрее.

Сколько мы можем сэкономить?

Можно взять промпт с вашей задачей и посчитать количество токенов на https://gpt-tokenizer.dev [3]

Затем выполнить его, взять ответ модели и посчитать исходящие токены. Для примера, в GPT 4.1 стоимость 1 миллион входящих токенов — 3$, а 1 миллион исходящих — 12$.

Вспомним, что мы не можем отправить информацию с персональными данными в облако, а значит при работе с облачными решениями нам нужно сначала вручную удалить все конфиденциальные сведения из документов. С локальной моделью мы можем об этом не беспокоиться и экономить не только токены но и время

Дополнительно нужно учесть, что сотрудник может задать уточняющие вопросы по материалу, что увеличит расходы токенов.

Как настроить? Пошаговая инструкция

-

Купить Mac Mini M4 Pro

-

Установить LM Studio

-

Скачать с официального сайта [4].

-

Выбрать и загрузить модель GPT-OSS-20B в библиотеке.

-

-

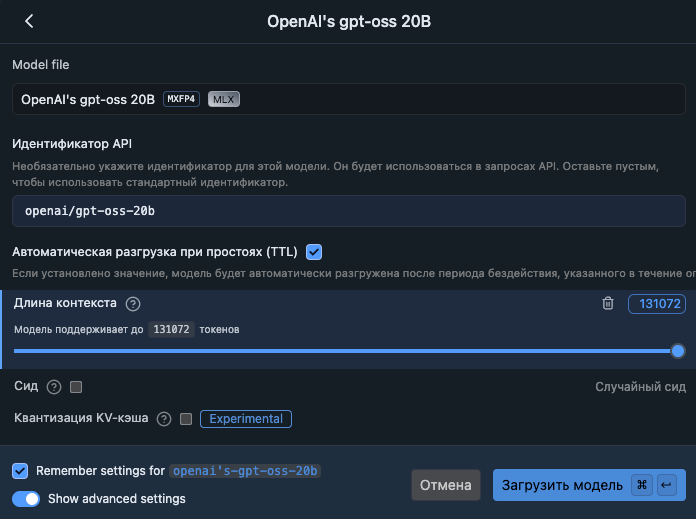

Включить опцию «Автоматическая разгрузка при простоях (TTL)»

-

Настроить длину контекста. Можно сразу установить максимум

-

Загрузить модель

-

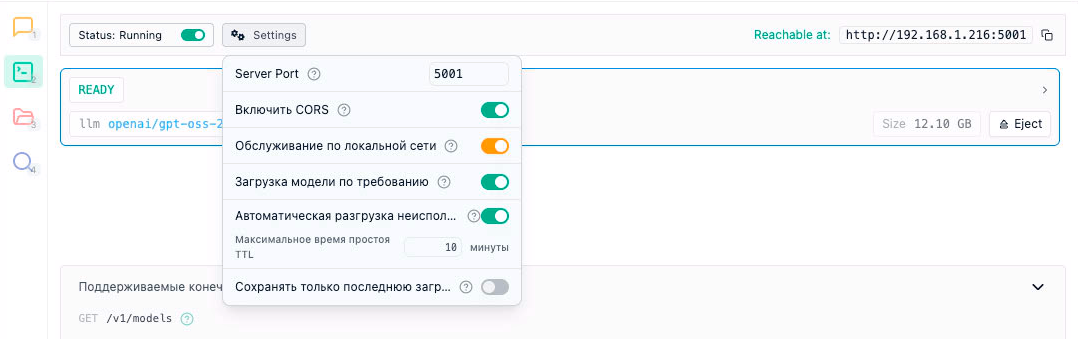

Запустить сервер

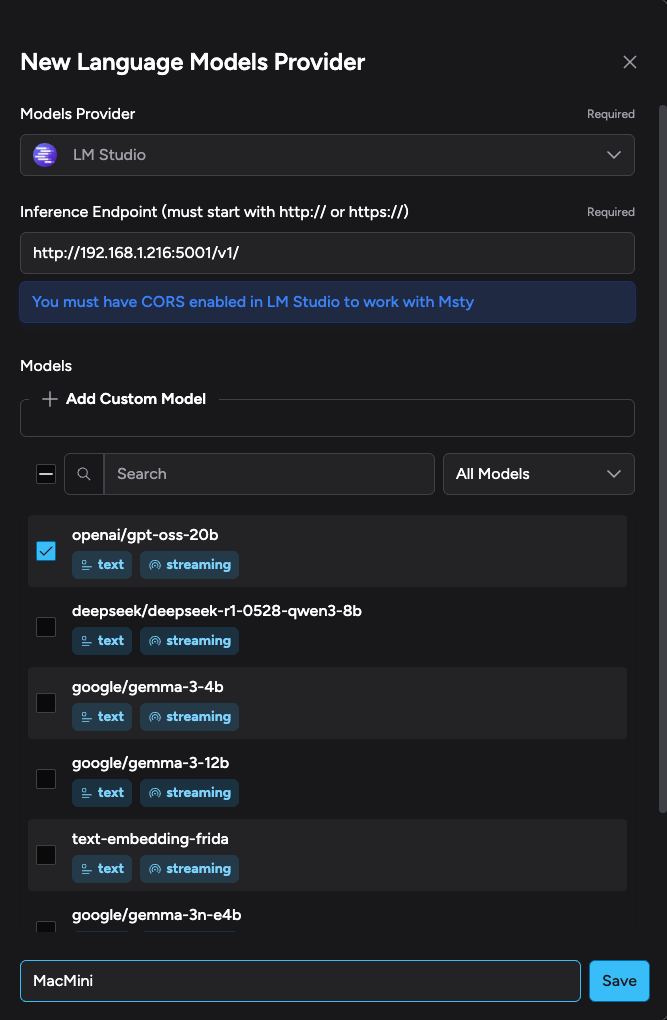

Ниже я собрал краткие и понятные пояснения к базовым настройкам и поведению [5] сервера при работе с моделями.

-

Порт сервера

-

Текущий порт в примере: 5001.

-

Порт по умолчанию: 1234 — при желании можно оставить стандартное значение.

-

-

Включить CORS

-

Для возможности подключения интеграций (VS Code, msty, виджеты и т.д)

-

-

Доступ по локальной сети

-

Включите параметр «Обслуживание по локальной сети», если планируете подключать к серверу других пользователей в одной сети.

-

-

Загрузка модели по требованию

-

Опция «Загрузка модели по требованию» автоматически поднимает модель при первом обращении по API, если она ещё не запущена. Это удобно, когда модели используются нерегулярно.

-

-

Автоматическая разгрузка неиспользуемых моделей

-

Рекомендуемая настройка: 10 минут.

-

Если модель не используется указанное время, она автоматически выгружается из памяти, чтобы не расходовать ресурсы без необходимости.

-

У меня весь процесс от распаковки до первого рабочего запроса занял 3 часа.

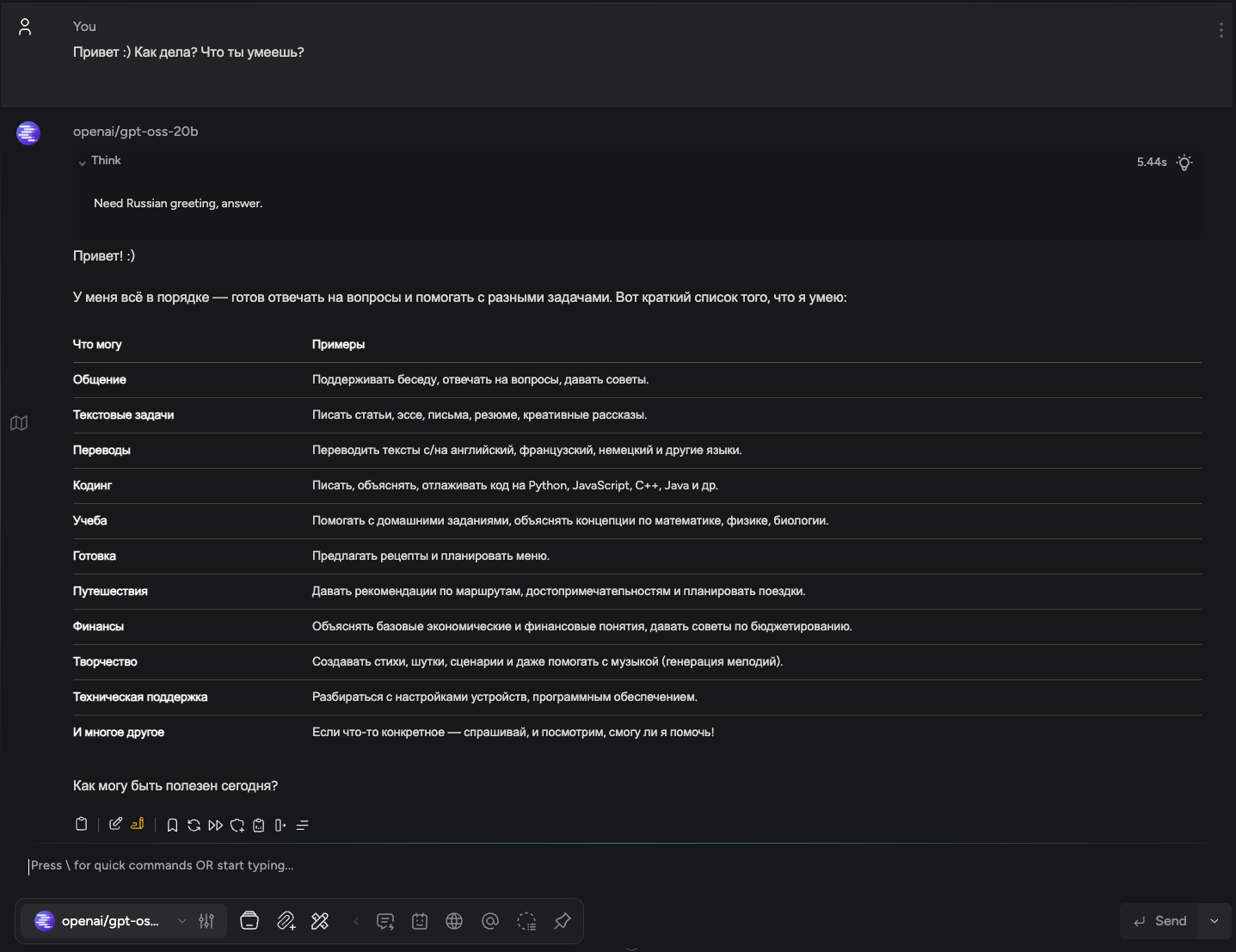

Подключаем сотрудников к модели

Сервер мы настроили, модель запустили. Однако сейчас работать с моделью можно только с самого MacMini. Чтобы у каждого сотрудника была возможность использовать модель со своего ПК, можно установить Msty Studio [6] на каждый компьютер

Msty Studio позиционирует себя как платформа для работы с AI-моделями с акцентом на приватность, локальность и гибкость. Доступна для Mac, Windows и Linux.

После установки запускаем приложение и добавляем нашу модель.

И можем сразу приступить к работе.

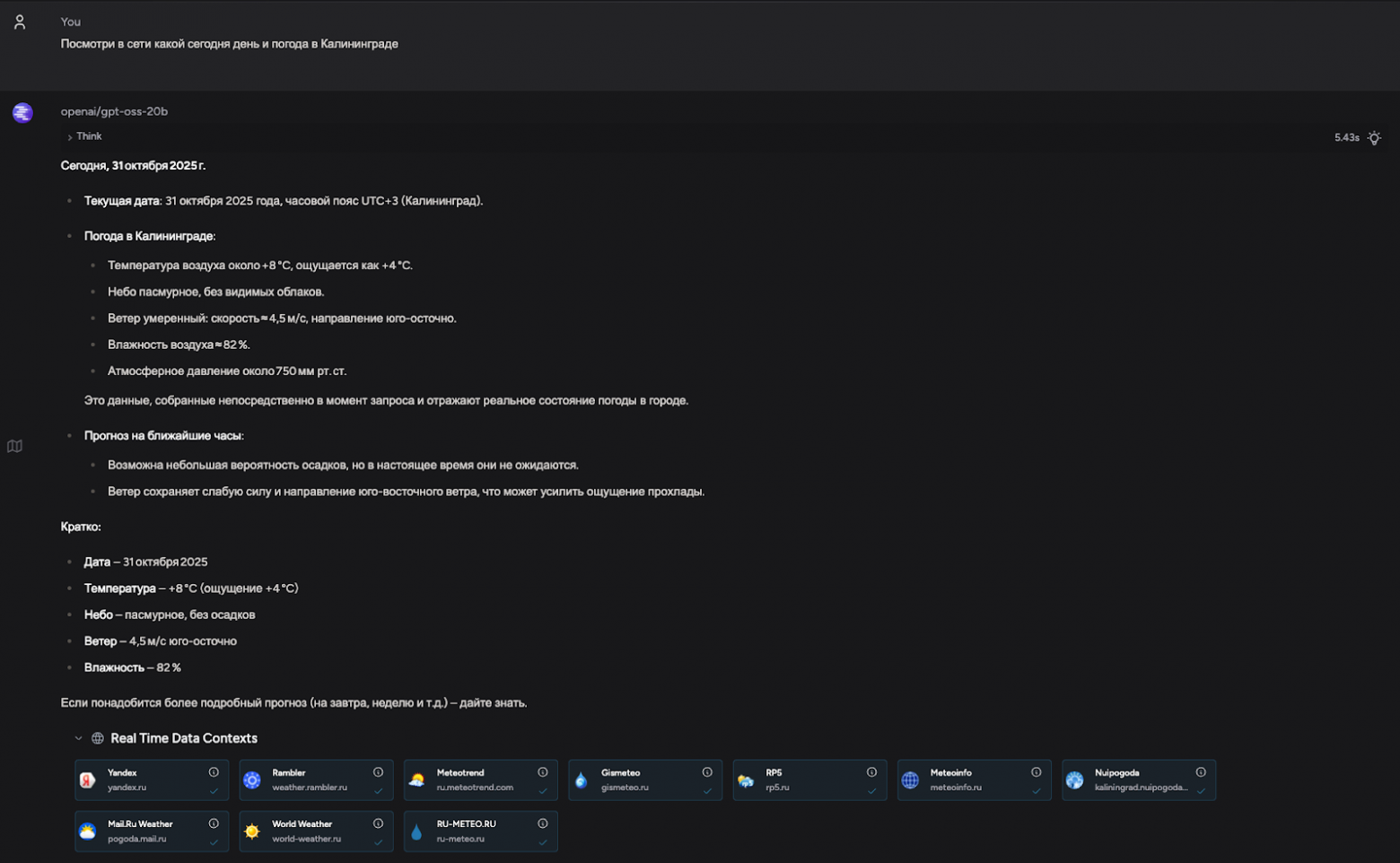

По умолчанию можем загружать файлы, создавать, структурировать диалоги и даже искать информацию в сети.

Подводные камни и как их избежать

Проблема 1: Модель «галлюцинирует»

Решение: Давать больше примеров в промпте или использовать цепочку промптов, то есть разбивать задачу на подзадачи.

Проблема 2: Долгая обработка длинных текстов

Решение: Для больших документов использовать постраничную обработку.

Если нужен творческий текст (статьи, истории), локальная модель может не справиться, лучше доплатить за облако.

Альтернативы: когда локальное решение не подходит

Если нужна максимальная скорость

Если работаете с изображениями, имейте в виду, что локальные модели (например, Gemma 3 12b) слабее в vision-задачах.

Выводы: стоит ли переходить на локальные нейросети?

|

Да, если: |

Нет, если: |

|

Вам важна конфиденциальность. |

Нужна максимальная скорость и качество генерации. |

|

Бюджет ограничен. |

Работаете с мультимодальными данными (текст + изображения). |

|

Задачи рутинные (текст, чат-боты, аналитика). |

Нет времени на настройку промптов. |

Наш вердикт:

Для 80% бизнес-задач Mac Mini + GPT-OSS-20B — оптимальное решение. Экономия очевидна, а качество не уступает облачным решениям.

Автор: MaxMoro1

Источник [7]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/22314

URLs in this post:

[1] интеллект: http://www.braintools.ru/article/7605

[2] память: http://www.braintools.ru/article/4140

[3] https://gpt-tokenizer.dev: https://gpt-tokenizer.dev/

[4] официального сайта: https://lmstudio.ai

[5] поведению: http://www.braintools.ru/article/9372

[6] Msty Studio: https://msty.ai

[7] Источник: https://habr.com/ru/companies/bitrix/articles/969626/?utm_source=habrahabr&utm_medium=rss&utm_campaign=969626

Нажмите здесь для печати.