Мы заглянули в «мозг» нейросети и поняли, почему она не способна предсказывать будущее

Недавние исследования намекают, что большие языковые модели (LLM) становятся всё лучше в предсказании будущего. И хотя меня это не удивляет, я скептически отношусь к тому, что их успехи смогут превзойти лучшие человеческие прогнозы. Я уж точно не ожидаю, что LLM смогут предсказать траекторию человеческой истории с точностью физика.

Причина в том, что наблюдения LLM фундаментально ограничены анализом языка. И, как я покажу, этого недостаточно для надёжного долгосрочного прогнозирования.

Мы все знаем, что значения слов со временем меняются. Язык – это не какая-то метафизическая данность. Просто почитайте Чосера или Шекспира, если не верите мне. И всё же, подобно стоимости доллара, значение слова обсуждается и пересматривается в миллиардах транзакций каждый день, что придаёт ему своего рода стабильность.

Именно эта стабильность и делает возможным существование LLM. В конце концов, невозможно предсказать следующее слово в предложении, если нельзя сформировать надёжные ожидания о том, какие слова обычно идут вместе. Эти связи существуют потому, что слова имеют в целом устойчивые значения.

Но так же, как бывали времена, когда стоимость валюты резко менялась – вспомните инфляцию в Веймарской Германии, – бывают и моменты, когда значение слова претерпевает быструю и непредсказуемую трансформацию. Многие ли из тех, кто жил в 1990-х, могли предсказать, что будет означать слово «телефон» всего двадцать лет спустя?

Такие «семантические виражи» происходят по причинам, связанным с технологическими и культурными тенденциями, которые лишь частично описываются и переживаются через язык. Это означает, что сам по себе язык недоопределяет то, как мы в конечном итоге будем говорить о конкретных плодах этих тенденций.

Иными словами, изменение языка – это запаздывающий, а не опережающий индикатор технологических и культурных перемен. Поэтому, если вы знаете, как работают LLM, вы поймёте, почему они, вероятно, не смогут предвидеть следующий семантический вираж.

Векторные вложения: превращая слова в математику

Чтобы понять, почему LLM не могут опередить этот вираж, нам сначала нужно разобраться в векторных вложениях (vector embeddings), которые позволяют ИИ представлять и извлекать слова и фразы для генерации контента.

Вот как это объясняет инженер IBM Мартин Кин:

Векторные вложения представляют слова в виде чисел, а именно – в виде числовых векторов, таким образом, чтобы уловить их семантические связи и контекстуальную информацию. Это означает, что слова с похожими значениями располагаются близко друг к другу, а расстояние и направление между векторами кодируют степень сходства между словами.

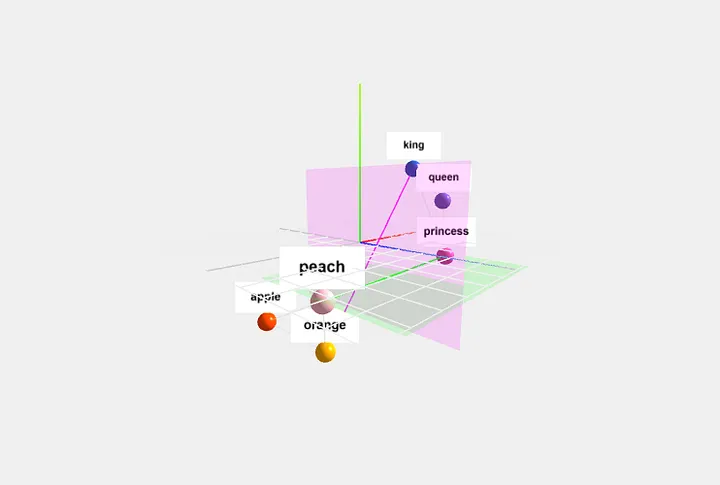

Это довольно хорошее описание, но чтобы по-настоящему прочувствовать, как работают векторные вложения, давайте взглянем на упрощённую визуализацию:

На ней показана связь в векторном пространстве слов «король», «королева», «принцесса», «яблоко», «апельсин» и «персик». Заметьте, что первые три слова образуют свой кластер «королевских особ», а последние три – кластер «фруктов». Тем не менее, существует как минимум одно измерение – зелёная плоскость, – которое связывает «принцессу» и «персик», поскольку эти слова сочетаются как минимум в одном контексте: игра Super Mario Bros.

Как только словам присваиваются числовые значения, позволяющие встроить их таким образом, они могут храниться в так называемой векторной базе данных. Относительное расстояние и направление слов друг к другу – это то, что позволяет нам «искать» в базе данных с помощью запросов на естественном языке и получать ответ от LLM.

Понимание этой механики – не просто техническая деталь. Это ключ к осознанному использованию ИИ. Когда вы понимаете, что нейросеть – это не оракул, а невероятно сложный статистический калькулятор, работающий с прошлым, вы начинаете задавать ей правильные вопросы.

А начать ваши эксперименты вы можете вместе с BotHub.

Вы можете экспериментировать с разными моделями, сравнивать их взгляды на одни и те же данные и оттачивать своё мастерство в составлении промптов. И всё это – без VPN и с удобной оплатой российскими картами.

По ссылке вы можете получить 100 000 бесплатных токенов [1] для первых задач и приступить к работе с нейросетями прямо сейчас!

Миграция смысла

LLM находятся в широком общественном пользовании всего несколько лет. Этого недостаточно, чтобы язык сильно изменился. Но учёные могут использовать технику векторных вложений, чтобы заглянуть в прошлое и увидеть, как языки эволюционировали на протяжении веков.

В своей работе «Диахронические векторные вложения слов раскрывают статистические законы семантических изменений [2]» исследователи проанализировали шесть крупных корпусов текстов на четырёх языках за два столетия. Они смогли создать модели, которые показали, как слова мигрировали по векторному пространству с течением времени, и обнаружили нечто очень интересное.

Слова не меняют свои значения как попало. Чрезвычайно распространённые слова – вроде «и», «в» или «вы» – очень устойчивы. Слова, которые используются реже, с большей вероятностью приобретают новые значения. Исследователи назвали это «законом конформизма».

Кроме того, слова, имеющие несколько значений – лингвисты называют их «полисемичными», – с большей вероятностью меняли смысл, чем слова с одним значением. Это назвали «законом инноваций».

Но если можно проследить изменение языка в прошлое благодаря этим статистическим законам, значит ли это, что можно предсказать, как язык изменится в будущем?

Возможности и случайности

Одним словом – нет. Помните, это статистические законы. Они могут сказать вам, какие слова более вероятно изменят своё значение, но не могут предсказать, какие именно, и в каком направлении произойдёт это изменение.

В 1975 году, за десять лет до выхода Super Mario Bros., можно было бы рассчитать вероятность того, что слова «принцесса» и «персик» изменятся. Но невозможно было предсказать, что их миграция выстроит их идеально вдоль того самого измерения, которое образует персонажа Принцессу Пич.

Это важно, но это не главная моя мысль. Более глубокое прозрение показывает, почему изучение одного лишь языка и его эволюции не может дать достаточно знаний для предсказания будущих событий.

Вернёмся к примеру со словом «телефон». Когда телефоны только изобрели, они существовали исключительно для устной связи на расстоянии. Но дизайн мобильных телефонов позволил вводить буквы, что естественным образом навело на мысль об отправке текстовых сообщений. Затем появились простые игры. По мере совершенствования технологий улучшенная графика и сенсорное управление открыли совершенно новые горизонты приложений, о которых первые пользователи изобретения Александра Грэма Белла и помыслить не могли.

Этот пример иллюстрирует две фундаментальные для моего аргумента концепции. Первая – это идея «возможности» (affordance). Вторая – идея «случайности» (contingency).

Психолог Джеймс Гибсон определил «возможность» как некий аспект среды, который предоставляет индивиду определённые варианты для действия. Например, стул предоставляет возможность сидеть. Самые первые телефоны не были предназначены для того, чтобы на них смотреть, в них говорили. Но создание портативного телефона повлекло за собой дизайн чего-то, что можно держать на расстоянии. Это был первый, маленький шаг от устного к зрительно-моторному способу взаимодействия с нашими телефонами.

Теперь сравним это с тем, что палеонтолог Стивен Джей Гулд назвал «случайностью». Это идея о том, что путь эволюции формируется непредсказуемыми событиями. Если бы вы перемотали историю вселенной и позволили ей разыграться снова, эволюционировали бы совершенно другие формы жизни.

Воплощённые умы, а не просто встроенные слова

Теперь давайте соединим эти две идеи – возможности и случайность [3]. Люди частично понимают наш мир через язык, но на самом деле язык – это лишь верхушка нашего когнитивного айсберга. Мы – то, что некоторые психологи называют «воплощёнными умами» (embodied minds), наши восприятия [4] и мысли формируются нашими телами бесчисленными способами, которые просачиваются в наш язык.

Наше «воплощение» – это каркас, на котором строится язык. Но это означает, что природа и направление эволюции языка лишь частично определяются тем, как язык эволюционировал в прошлом. Они также определяются тем, как наши тела взаимодействуют с миром. Эволюция [5] «телефона» это проиллюстрировала. Она включала в себя возможности и случайности, которые анализ одного лишь языка мог бы выявить только постфактум.

Разговаривать с LLM – это всё равно что смотреть в хрустальный шар и видеть в нём только прошлое. Учитывая их архитектуру, они могут лишь экстраполировать будущие тенденции в эволюции языка на основе прошлой эволюции векторных вложений.

Но возможности, которые породят случайности, которые, в свою очередь, определят человеческую историю – включая эволюцию нашего языка, – не воспринимаются на таком абстрактном уровне анализа. Их слышат, обоняют и осязают на уровне наших тел.

Возможно, однажды ИИ обретут собственные тела и будут черпать из богатого, воплощённого сознания для формулирования своих семантических утверждений о мире. Когда этот день наступит, мне, вероятно, придётся пересмотреть свой тезис. А до тех пор лучше прислушаться к мудрости Йоги Берры:

«Трудно делать предсказания, особенно о будущем».

А теперь ваша очередь. Что вы думаете по этому поводу?

Согласны ли вы с автором, что истинное предвидение невозможно без физического «воплощения» и взаимодействия с миром?

Делитесь своими мыслями и аргументами в комментариях!

Автор: cognitronn

Источник [6]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/22875

URLs in this post:

[1] По ссылке вы можете получить 100 000 бесплатных токенов: https://bothub.chat/?invitedBy=m_aGCkuyTgqllHCK0dUc7

[2] Диахронические векторные вложения слов раскрывают статистические законы семантических изменений: https://arxiv.org/abs/1605.09096

[3] случайность: http://www.braintools.ru/article/6560

[4] восприятия: http://www.braintools.ru/article/7534

[5] Эволюция: http://www.braintools.ru/article/7702

[6] Источник: https://habr.com/ru/companies/bothub/articles/974348/?utm_source=habrahabr&utm_medium=rss&utm_campaign=974348

Нажмите здесь для печати.