Агенты Купер, Смит или Джеймс Бонд: какие виды ИИ-агентов бывают и какой подходит тебе

ИИ-агенты на пике хайпа и обсуждений, пускай многие сомневаются, что этот тренд надолго. Согласно исследованию нашей команды Research & Insights Центра стратегии цифровых продуктов МТС, вкладываться в эту технологию и использовать ее в мире будут всё больше/чаще/активнее/быстрее/мощнее.

В полном тексте исследования [1] проанализировали ситуацию, тренды и возможные сценарии. Разбор основных тезисов мы, Максим Зубарев, Екатерина Лустач, Филипп Шедько и Андрей Осин, уже публиковали [2]. В этой части расскажем про виды агентов — какие они бывают и для чего применяются:

● Simple reflex agents: ничего не помнят [3]

● Model-based reflex agents: знают про Матрицу [4]

● Goal-based agents: видят цель и не видят препятствий. [5]

● Utility-based agents: эффективность и тонкий расчет [6]

● Learning agents: постоянно совершенствуются [7]

● В чем разница [8]

● Бонус: как еще разделять ИИ-агенты [9]

Simple reflex agents

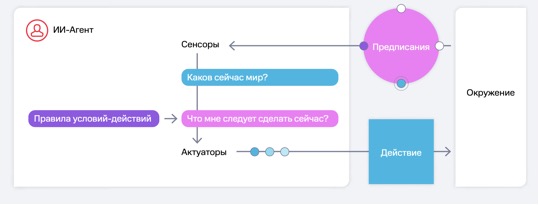

Простые рефлекторные агенты (Simple reflex agents) — базовая и примитивная форма жизни. Этот вид принимает решения на основе текущих данных. Памяти [10] нет, агенты не обучаются и не взаимодействуют с другими, а работают только по заранее заданным правилам — «если X, то Y».

Рефлекторные агенты эффективны в средах с предсказуемым и ограниченным набором правил. А вот незнакомые ситуации ставят их в тупик — не могут перестроиться и отреагировать как нужно. Поэтому никаких сложных сценариев или условий! Эти агенты не учатся на ошибках и не обновляют правила из-за новой информации.

Пример simple reflex agent — выключатель света с датчиком движения или умный термостат, включающий обогрев, если температура ниже заданной.

Model-based reflex agents

Модельно-рефлекторные агенты (Model-based reflex agents) — более продвинутый вариант! Они воспринимают среду, отслеживают ее изменения и обладают памятью. Благодаря этому поддерживают внутреннюю модель мира, имеют о нем представление и принимают обоснованные решения в динамических, изменяемых средах. Когда вводных недостаточно или они неполные, модель восполняет пробелы самостоятельно.

По мере того как агент получает новую информацию, модель обновляется и учитывает историю состояний. То есть предыдущий simple reflex agent эволюционировал: набор правил «если X, то Y» уже не в вакууме, а в модели мира, описывающей изменения среды, в том числе из-за действий агента.

Пример: умный пылесос строит карту помещения, запоминает расположение стен, дверных проемов и мебели. Еще один представитель — автокоррекция запоминает историю ввода пользователя и учитывает ее в рекомендациях.

В общем, model-based reflex agent обновляется на основе как своих действий, так и информации с датчиков. Получаем адаптивность и улучшенные решения.

Goal-based agents

У агентов, ориентированных на цели (Goal-based agents), как и у модельно-рефлекторных, есть внутренняя модель мира. Но не только она! Еще у них появляется, собственно, цель, их так и называют — целевые агенты. Действуют они так: анализируют возможные последовательности действий и выбирают те, что ведут к цели.

Важно! Оценивают выгоду они не «лучше/хуже». Лишь прогнозируют, приведет ли конкретный шаг к цели в текущих обстоятельствах — «да/нет». То есть выбор бинарный, но решение адаптируется. Ставим цель — и агент запускается. Анализирует контекст, окружающую среду — с помощью датчиков или имеющихся данных.

Следующий шаг — спланировать последовательность действий, , алгоритм, чтоб достичь цели эффективнее.

Затем агент выполняет алгоритм, но постоянно адаптируется. То есть корректирует свой маршрут / очередность действий в зависимости от изменений среды и условий.

Показательный пример такого агента: шахматная программа, размышляющая: «Поставлю ли я мат через несколько ходов, если пойду таким образом, — да или нет?». То есть целевые агенты не просто реагируют на ситуацию и опираются на память — они уже способны построить план и адаптировать его под меняющиеся обстоятельства. Но оценивают действия исключительно по критерию того, ведут ли они к цели.

Utility-based agents

Утилитарные агенты (Utility-based agents) принимают решения, оценивая полезность и результативность действий, достигающих цели. Предыдущий тип, Goal-based agents, просто выбирает кратчайший путь к цели с оглядкой на изменения вокруг, а этот уже считает в числах, насколько вариант X выгоднее, чем Y или Z.

Числовая оценка алгоритма зависит не только от его скорости, но и от, например, стоимости, времени, прибыли, энергопотребления и так далее. Ну и неопределенность такой агент просчитывает заранее: прикидывает, какие события смогут повлиять и что с ними надо будет делать.

Пример: торговый бот анализирует биржу и выбирает лучший момент для сделки. Или сервис такси динамически меняет цены. Или бот управляет цепочками поставок. Шахматный утилитарный агент тоже имеет место быть, только победить его сложнее, чем целевой.

В общем, утилитарный агент идеален для задач с распределением ресурсов, балансированием целей и ограничений. Не просто краткий путь, а взвешивание рисков и выгод.

Learning agents

Обучающиеся агенты (Learning agents) улучшают свои действия на основе опыта [11], анализа обратной связи и взаимодействия с миром. Непрерывно учатся на успехах и неудачах, не просто следуют правилам, а постоянно совершенствуются, чтобы справляться с неопределенностью.

Learning agents обычно состоят из четырех компонентов:

-

Производительность — выбирать необходимые действия в текущей среде, исходя из базы знаний.

-

Обучение [12] — совершенствовать знания и возможности агента.

-

Критика — оценивать эффективность агента по стандарту.

-

Генератор проблем — исследовать и открывать стратегии, собирать новую информацию. Благодаря ему агент находит оптимальные решения, а не слепо повторяет прошлые успешные действия.

Пример: рекомендательная система в Netflix анализирует предпочтения пользователя. Еще пример — спам-фильтры обучаются на поведении [13] пользователей, в частности на кликах по кнопке «спам», благодаря чему постоянно улучшают фильтрацию. Сюда же относятся игровой ИИ и чат-боты поддержки.

В чем разница

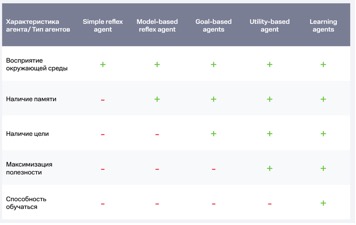

Таблица со сравнением типов ИИ-агентов:

Если резюмировать, то их отличают возможности и функциональность:

-

Simple reflex agents принимают решения по правилу «действие/условие». В Microsoft ИИ-интерфейс собирает упоминания компании в СМИ, подкастах и соцсетях: условие — появилось упоминание, действие — уходит в подборку. Так команда коммуникаций получает инсайты для оперативной реакции [14].

-

Model-based reflex agents принимают решения на основе внутренней модели мира, своего представления о нем. Цифровой помощник операторов атомных станций от Росатома на основе собранных данных предупреждает о возможных отклонениях в работе систем и прогнозирует развитие событий на ближайшие 30 минут.

-

Goal-based agents оценивают не только устройство внешней среды, но и последствия своих действий.

-

Utility agents обычно узкоспециализированные, применяются для конкретных задач. Этим похожи на Goal-based, но решают сообразно контексту. В Wealthfront ИИ-агенты управляют портфелем, оптимизируют налоговые стратегии и корректируют инвестиции в соответствии с целями пользователя.

-

Learning agents — становятся производительнее и адаптируются к новым условиям. Insilico Medicine с помощью своей ИИ‑платформы Pharma AI обнаружила лечение редкой легочной болезни, разработала препарат Rentosertib и вышла на доклинические испытания примерно за 2 млн $ и 18 месяцев вместо обычных 400 млн $ и 3–6 лет.

Бонус: как еще разделять ИИ-агенты

Конечно же, выше — не единственная классификация. Еще агенты различают по сфере применения.

Интересно, что приоритет в инвестициях в агенты у инфраструктурных решений — «технологий для технологий». Более 42% венчурных вливаний, $8,53 млрд $, идут на создание и оптимизацию ИИ-агентов: AI Agent Builders, Software Development & IT Operations и AI Agent Infrastructure. Инфраструктурными ИИ-агентами занимаются 115 компаний.

Лишь 11,5% финансирования или $2,4 млрд привлекли агенты, ориентированные на конкретные отрасли — Healthcare, Finance & Banking, Education, Insurance, Logistics и другие. Почти в 4 раза меньше, хотя число компаний сопоставимо — 106. Дело в том, что специализированные решения пока воспринимаются как незрелые, но именно они станут главными драйверами спроса в ближайшие 3–5 лет.

Устойчивый спрос и зрелость заметили у еще двух направлений развития ИИ-агентов:

-

Customer Service: 32 компании, 1,78 млрд $, 8,5% инвестиций. Это объясняется большими, исторически накопленными датасетами и высокой стоимостью поддержки.

-

Personal Assistant & Productivity: 24 компании, 2,954 млрд $, 14,1% инвестиций. У этого сегмента высокий пользовательский интерес [15] и понятное применение — управлять временем, задачами и коммуникациями.

На этом у меня все. В планах еще две статьи по текущему исследованию: будут еще две части, где мы остановимся на ситуации на иностранных рынках и будущем развития технологии.

Автор: san_andreeeas

Источник [16]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/22885

URLs in this post:

[1] полном тексте исследования: https://disk.yandex.ru/d/Y1PmAKo3j4DsqA

[2] уже публиковали: https://habr.com/ru/companies/ru_mts/articles/965622/

[3] Simple reflex agents: ничего не помнят: #blank

[4] Model-based reflex agents: знают про Матрицу: #context

[5] Goal-based agents: видят цель и не видят препятствий.: #target

[6] Utility-based agents: эффективность и тонкий расчет: #efficiency

[7] Learning agents: постоянно совершенствуются: #evolution

[8] В чем разница: #spectrum

[9] Бонус: как еще разделять ИИ-агенты: #bonus

[10] Памяти: http://www.braintools.ru/article/4140

[11] опыта: http://www.braintools.ru/article/6952

[12] Обучение: http://www.braintools.ru/article/5125

[13] поведении: http://www.braintools.ru/article/9372

[14] реакции: http://www.braintools.ru/article/1549

[15] интерес: http://www.braintools.ru/article/4220

[16] Источник: https://habr.com/ru/companies/ru_mts/articles/973178/?utm_source=habrahabr&utm_medium=rss&utm_campaign=973178

Нажмите здесь для печати.