Исследования показали, что попытка придать ИИ человеческое звучание происходит за счет потери смысла

Исследователи из Цюрихского университета обнаружили, что текст, сгенерированный искусственным интеллектом [1], все еще можно достоверно отличить от человеческого почерка. Их исследование показывает, что попытки сделать звук моделей более естественным часто идут в ущерб точности.

В социальных исследованиях модели все чаще используются для имитации человеческого поведения [2], например, в качестве цифровых двойников в опросах. Ценность этих методов во многом зависит от того, насколько убедительно ИИ может имитировать реальных людей.

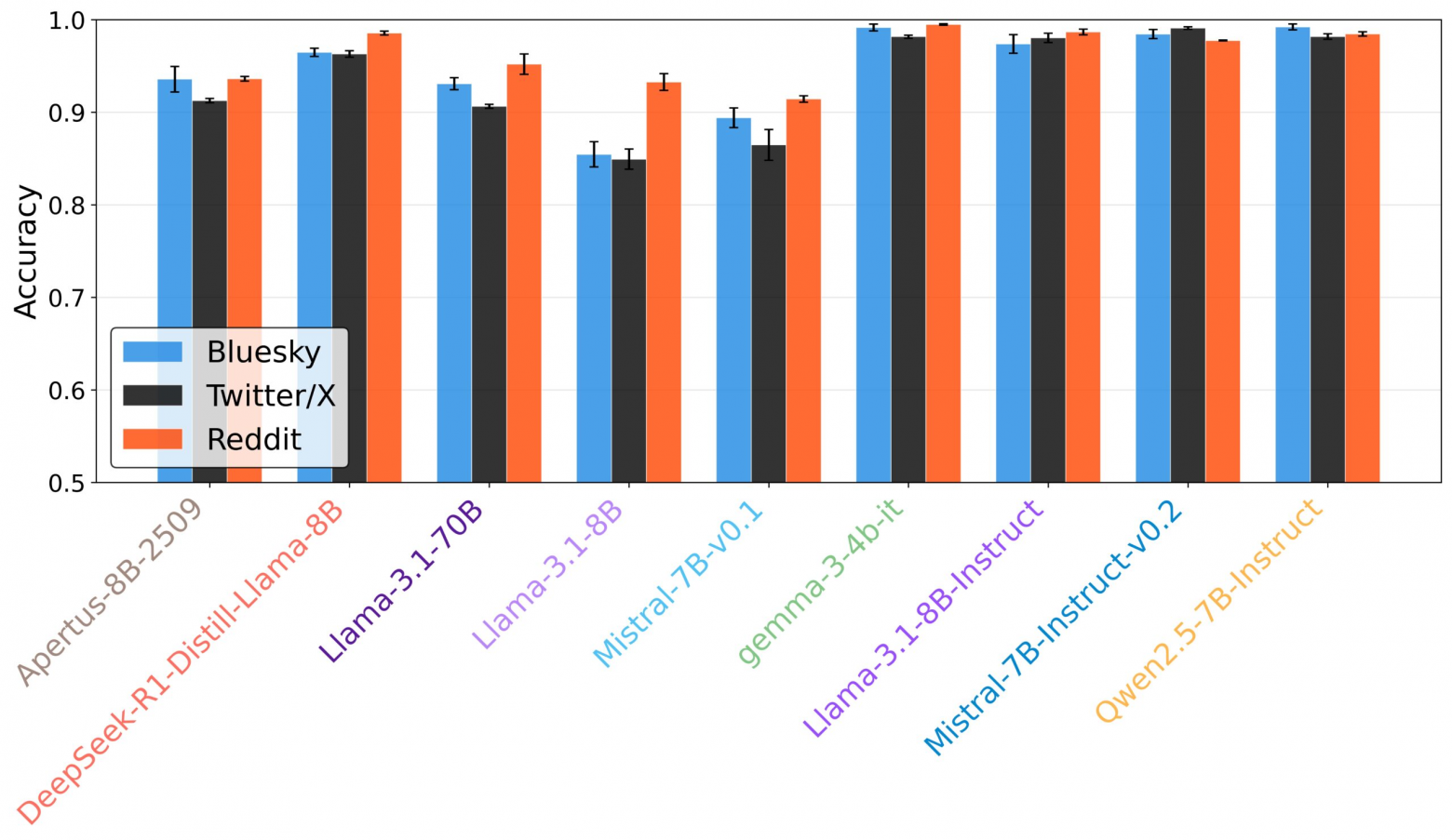

Специально обученный классификатор на основе BERT [3] отличал ответы, сгенерированные ИИ, от текста, написанного человеком, с точностью от 70 до 80 процентов, что значительно выше случайного уровня.

Размер модели, похоже, не имел большого значения. Более крупные модели с большим количеством параметров не обязательно писали более человекоподобный текст, чем системы меньшего размера. Базовые модели также часто превосходили версии, прошедшие настройку инструкций.

Исследователи протестировали девять открытых языковых моделей на предмет их способности убедительно имитировать взаимодействие пользователей на платформах X, Bluesky и Reddit. В число протестированных моделей вошли Apertus, Deepseek-R1, Gemma 3, Qwen2.5.

Сложные методы часто приводят к обратным результатам.

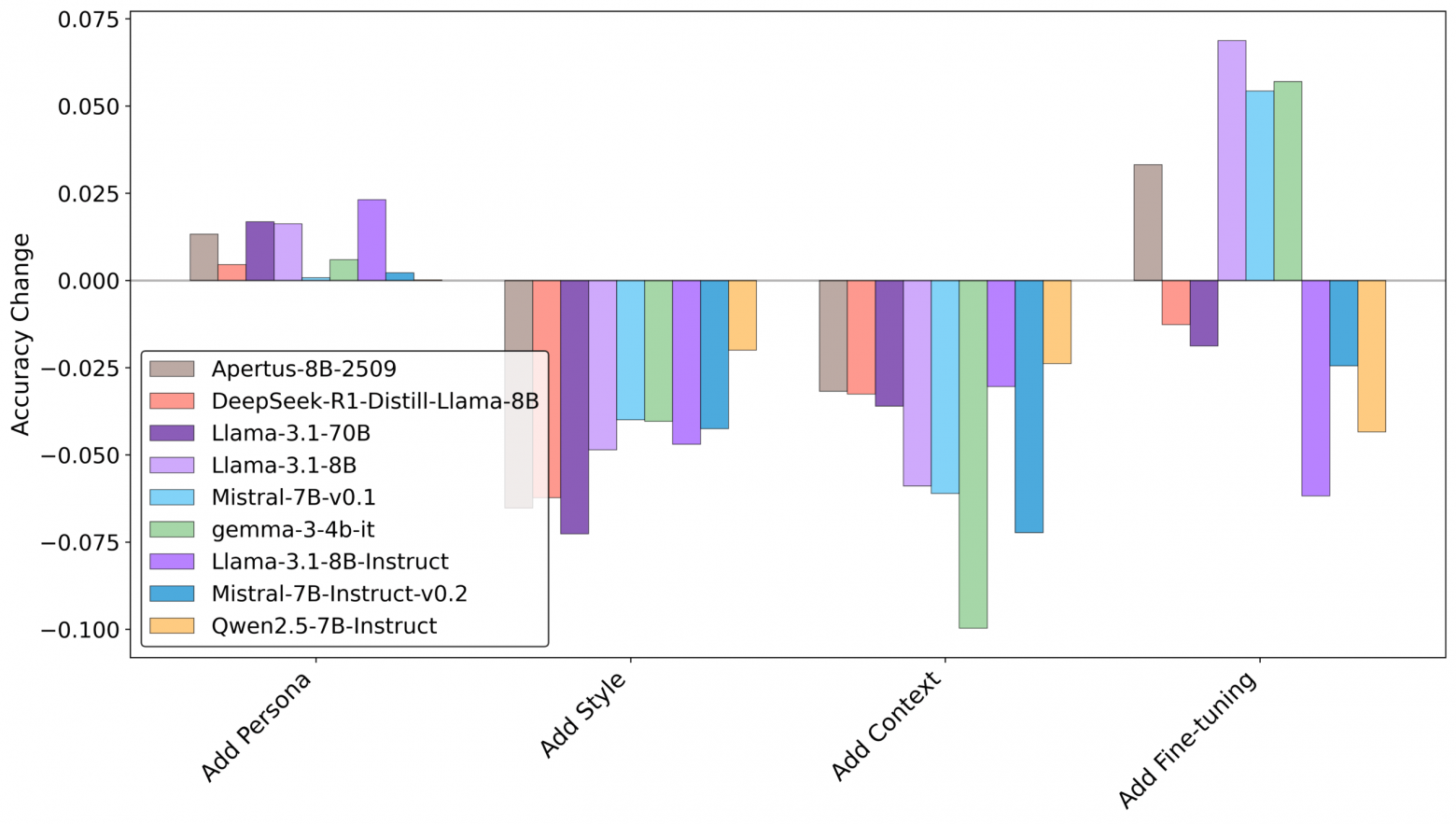

Разработчики обычно используют сложные стратегии, чтобы текст, созданный с помощью ИИ, звучал более естественно, включая подробные описания персонажей и тонкую настройку с использованием конкретных данных. Исследование показало, что эти сложные методы часто оказывались неэффективными или даже облегчали идентификацию текста как искусственного.

«Некоторые сложные стратегии, такие как тонкая настройка и описание персонажей, не способствуют повышению реализма и даже не делают текст более различимым», – пишут исследователи.

Более простые подходы оказались эффективнее. Демонстрация примеров стиля письма, специфичного для ИИ, или предоставление контекста из предыдущих сообщений заметно снижали вероятность обнаружения. Даже в этом случае программное обеспечение для анализа обычно все равно могло определить текст как сгенерированный ИИ.

Человеческий тон против точного содержания

Один из ключевых выводов исследования заключается в принципиальном компромиссе: оптимизация одновременно под человеческий тон и точное содержание представляется практически невозможной. Когда исследователи сравнили текст, созданный с помощью ИИ, с реальными ответами людей, которых имитировали, они обнаружили, что сокрытие происхождения текста, созданного ИИ, часто означало отклонение от того, что сказал бы реальный человек.

«Наши выводы указывают на компромисс: оптимизация для достижения человекоподобия часто происходит за счет семантической точности, и наоборот», – пишут авторы.

Это создает дилемму. Модели могут либо идеально подобрать стиль, тон и длину предложений, чтобы выглядеть по-человечески, либо максимально приблизиться к тому, что сказал бы реальный человек. Согласно исследованию, им сложно совместить и то, и другое в одном ответе.

Эмоции остаются самой большой слабостью.

Хотя структурные особенности, такие как длина предложений, можно корректировать, эмоции [5] остаются серьезной проблемой. Модели постоянно не могли передать человеческий тон, особенно в эмоциональной или агрессивной речи. Модели ИИ также испытывали трудности с специфической терминологией платформы – в частности, с эмодзи, хэштегами и эмоциональными сигналами.

Обман довольно хорошо сработал на X – что не кажется слишком удивительным, – но на Reddit, где стиль общения гораздо более прямолинейный, его было гораздо сложнее осуществить. В исследовании содержится предупреждение о том, что исследователям следует проявлять осторожность при использовании языковых моделей в качестве замены реального человеческого общения без тщательной проверки.

В предыдущих работах исследователи из Массачусетского технологического института и Гарвардского университета изучали автоматизацию [6] исследований в области социальных наук с использованием агентов искусственного интеллекта и причинно-следственных моделей. Даже тогда самой большой проблемой было перенесение результатов на реальное поведение человека.

Полученные результаты также подтверждают эффективность таких детекторов текста на основе ИИ, как Pangram [7] , которые заявляют о высоких показателях распознавания. Вопреки более ранним предположениям, текст, созданный с помощью ИИ, оказывается распознаваемым машинами даже без сложных инструментов, таких как водяные знаки. Однако имеет ли это значение в социальном плане, это скорее культурный, чем технический вопрос.

Делегируйте часть рутинных задач вместе с BotHub! [8] Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке [9] вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Источник [10]

Автор: MrRjxrby

Источник [11]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/23137

URLs in this post:

[1] интеллектом: http://www.braintools.ru/article/7605

[2] поведения: http://www.braintools.ru/article/9372

[3] классификатор на основе BERT: https://the-decoder.com/modernbert-is-a-workhorse-model-that-brings-faster-cheaper-text-processing-for-tasks-like-rag/

[4] поведение: http://www.braintools.ru/article/5593

[5] эмоции: http://www.braintools.ru/article/9540

[6] Массачусетского технологического института и Гарвардского университета изучали автоматизацию: https://the-decoder.com/researchers-unveil-llm-based-system-that-designs-and-runs-social-experiments-on-its-own/

[7] таких детекторов текста на основе ИИ, как Pangram: https://the-decoder.com/pangram-3-0-ai-text-detector-claims-up-to-99-98-accuracy-even-for-subtly-ai-assisted-content/

[8] BotHub!: https://bothub.chat/?utm_source=contentmarketing&utm_medium=habr&utm_campaign=news&utm_content=RESEARCH_HAS_SHOWN_THAT_TRYING_TO_MAKE_AI_SOUND_HUMAN_COMES_AT_THE_COST_OF_LOSING_MEANING

[9] По ссылке: https://bothub.chat/?invitedBy=m_aGCkuyTgqllHCK0dUc7

[10] Источник: https://the-decoder.com/making-ai-sound-human-comes-at-the-cost-of-meaning-researchers-show/

[11] Источник: https://habr.com/ru/companies/bothub/news/976334/?utm_source=habrahabr&utm_medium=rss&utm_campaign=976334

Нажмите здесь для печати.