Pixio от Meta* доказывает, что простая реконструкция пикселей может превзойти сложные модели компьютерного зрения

Исследователи из Meta* AI разработали модель обработки изображений, которая обучается исключительно за счет реконструкции пикселей. Pixio превосходит более сложные методы оценки глубины и 3D-реконструкции, несмотря на меньшее количество параметров и более простой подход к обучению [1].

Распространенный способ обучения моделей ИИ пониманию изображений заключается в том, чтобы скрыть части изображения и позволить модели заполнить недостающие области. Для этого модель должна научиться понимать, что обычно присутствует на изображениях: формы, цвета, объекты и их пространственное расположение.

Этот метод, известный как маскированный автокодировщик (MAE), недавно считался менее эффективным, чем более сложные методы, такие как DINOv2 или DINOv3. Однако исследовательская группа Meta AI в своем исследовании [2] показала, что это не всегда так: их улучшенная модель Pixio превосходит DINOv3 в ряде практических задач.

Более простое обучение приводит к более глубокому пониманию сцены

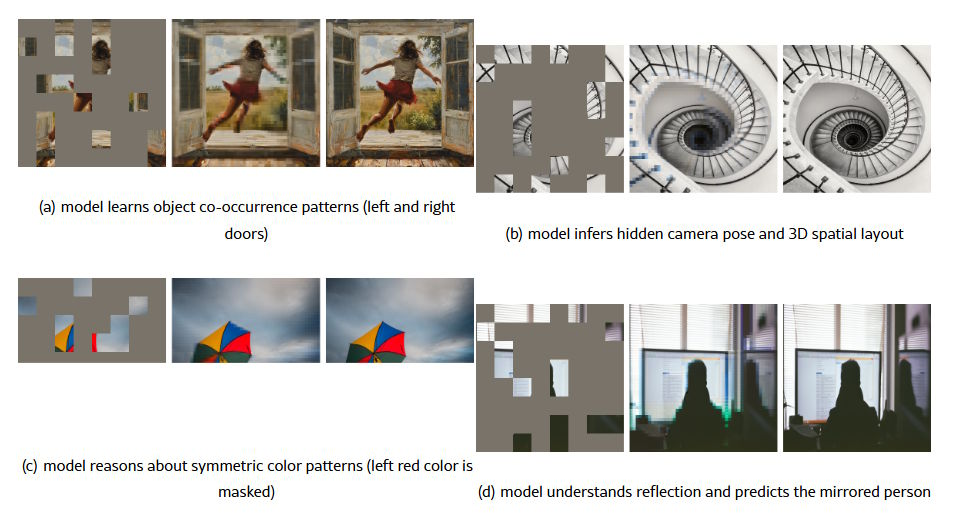

Исследователи демонстрируют возможности Pixio на примерах реконструкции пикселей. При работе с изображениями, сильно замаскированными пикселями, модель выходит за рамки реконструкции текстур и улавливает пространственное расположение сцены. Она распознает симметричные цветовые узоры и понимает отражения, даже предсказывая наличие зеркального отражения человека в окне, даже если эта область была скрыта.

Эти возможности возникают потому, что модели необходимо понимать, что видно, чтобы точно это воссоздать: какие объекты присутствуют, как структурировано пространство и какие закономерности повторяются.

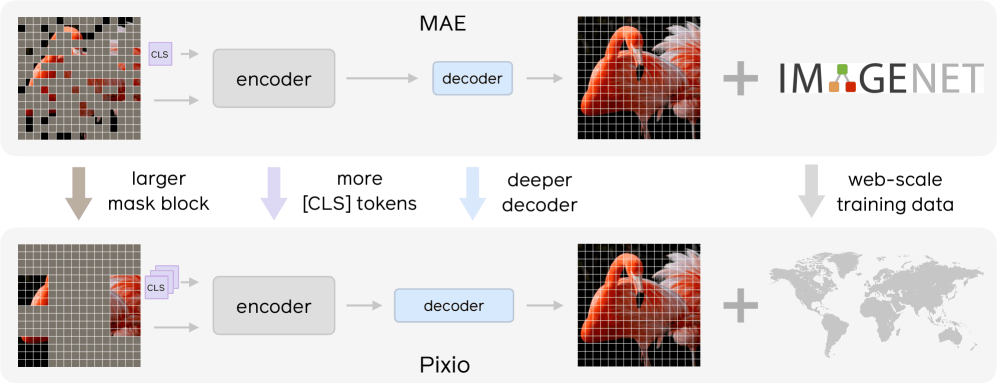

Pixio основана на фреймворке MAE, представленном Meta* в 2021 году [4]. Исследователи выявили недостатки в первоначальной конструкции и внесли три основных изменения. Во-первых, они усилили декодер – часть модели, которая восстанавливает отсутствующие пиксели. В оригинальном MAE декодер был слишком поверхностным и слабым, что вынуждало кодировщик жертвовать качеством представления ради восстановления.

Во-вторых, они увеличили замаскированные области: вместо небольших отдельных квадратов теперь скрыты более крупные смежные блоки. Это предотвращает простое копирование моделью соседних пикселей и заставляет ее фактически понимать изображение.

В-третьих, они добавили несколько токенов [CLS] (токены классов) – специальных токенов, размещенных в начале входных данных, которые объединяют глобальные свойства во время обучения. Каждый токен хранит такую информацию, как тип сцены, угол обзора камеры или освещение, помогая модели изучать более универсальные характеристики изображения.

Пропуск оптимизации бенчмарков приносит свои плоды.

Команда собрала два миллиарда изображений из интернета для обучения. В отличие от DINOv2 и DINOv3, исследователи намеренно избегали оптимизации для конкретных тестовых наборов данных. DINOv3, например, вставляет изображения из известного набора данных ImageNet непосредственно в свои обучающие данные и использует их до 100 раз, что составляет около десяти процентов от общего объема обучающих данных. Это повышает результаты на тестах на основе ImageNet, но может ограничить применимость к другим задачам.

Pixio использует более простой подход: изображения, которые сложнее восстановить, чаще появляются во время обучения. Фотографии товаров, которые легко предсказать, появляются реже, а визуально сложные сцены – чаще.

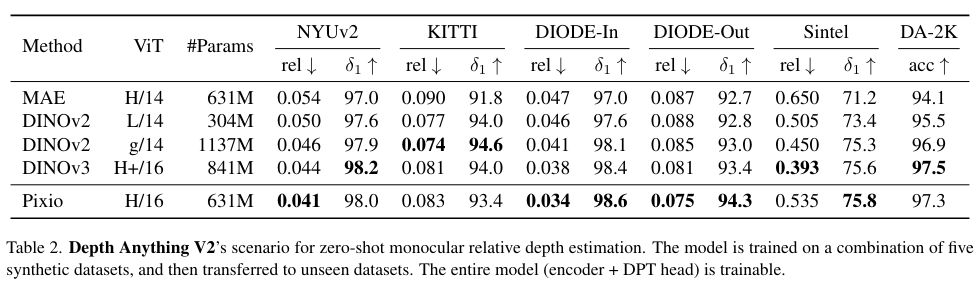

В тестах производительности Pixio с 631 миллионом параметров часто превосходит DINOv3 [5] с 841 миллионом параметров. При оценке монокулярной глубины, вычислении расстояний по одной фотографии, Pixio на 16 процентов точнее, чем DINOv3. Он также превосходит DINOv3 в 3D-реконструкции по фотографиям, даже несмотря на то, что DINOv3 обучался на восьми различных ракурсах для каждой сцены, в то время как Pixio использовал только отдельные изображения.

Pixio также лидирует в области обучения роботов, где роботам необходимо делать выводы о действиях на основе изображений с камер: 78,4% по сравнению с 75,3% у DINOv2.

Маскировка имеет свои пределы

У этого метода обучения есть недостатки. Скрытие частей изображения – это искусственная задача, поскольку в реальном мире мы видим целые сцены, отмечают исследователи. Низкие показатели маскирования делают задачу слишком простой, в то время как высокие показатели оставляют слишком мало контекста для осмысленной реконструкции.

Исследователи предполагают, что следующим шагом может стать обучение на основе видео. Используя видео, модель сможет научиться предсказывать будущие кадры на основе прошлых; это более естественная задача, не требующая искусственного маскирования. Команда опубликовала код на GitHub [6].

Делегируйте часть рутинных задач вместе с BotHub! [7] Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке [8] вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Источник [9]

Автор: MrRjxrby

Источник [10]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/23801

URLs in this post:

[1] обучению: http://www.braintools.ru/article/5125

[2] исследовании: https://arxiv.org/html/2512.15715v1

[3] симметрии: http://www.braintools.ru/article/3088

[4] фреймворке MAE, представленном Meta* в 2021 году: https://arxiv.org/abs/2111.06377

[5] DINOv3: https://the-decoder.com/meta-makes-its-state-of-the-art-dinov3-image-analysis-model-available-for-commercial-projects/

[6] код на GitHub: https://github.com/facebookresearch/pixio

[7] BotHub!: https://bothub.chat/?utm_source=contentmarketing&utm_medium=habr&utm_campaign=news&utm_content=META_PIXIO_PROVES_THAT_SIMPLE_PIXEL_RECONSTRUCTION_CAN_OUTPERFORM_COMPLEX_COMPUTER_VISION_MODELS

[8] По ссылке: https://bothub.chat/?invitedBy=m_aGCkuyTgqllHCK0dUc7

[9] Источник: https://the-decoder.com/metas-pixio-proves-simple-pixel-reconstruction-can-beat-complex-vision-models/

[10] Источник: https://habr.com/ru/companies/bothub/news/981248/?utm_source=habrahabr&utm_medium=rss&utm_campaign=981248

Нажмите здесь для печати.