Компания Lightricks открыла исходный код модели видеоанализа на основе ИИ LTX-2

Израильская компания Lightricks открыла исходный код своей модели LTX-2 с 19 миллиардами параметров. Система генерирует синхронизированный аудио-видеоконтент на основе текстовых описаний и, как утверждается, работает быстрее, чем конкуренты.

Согласно техническому отчету [1], модель генерирует до 20 секунд видео с синхронизированным стереозвуком из одного текстового запроса. Это включает в себя синхронизированную с речью речь, фоновые звуки, звуковые эффекты и музыку, подобранную к каждой сцене. Полная версия LTX-2 достигает разрешения 4K с частотой до 50 кадров в секунду, сообщает Lightricks.

Исследователи утверждают, что существующие подходы к генерации аудиовизуального контента принципиально ошибочны. Многие системы работают последовательно – сначала генерируется видео, затем добавляется звук, или наоборот. Эти разрозненные конвейеры не могут уловить истинное совместное распределение обеих модальностей. Хотя синхронизация губ в основном зависит от звука, акустическая среда формируется визуальным контекстом. Только единая модель может справиться с этими двунаправленными зависимостями.

Почему асимметричная архитектура важна для создания аудио-видеоконтента

LTX-2 работает на основе асимметричного двухпотокового трансформатора с общим количеством параметров 19 миллиардов. Видеопоток получает 14 миллиардов параметров – значительно больше, чем аудиопоток с его 5 миллиардами. По словам исследователей, такое разделение отражает различную плотность информации в каждом из каналов.

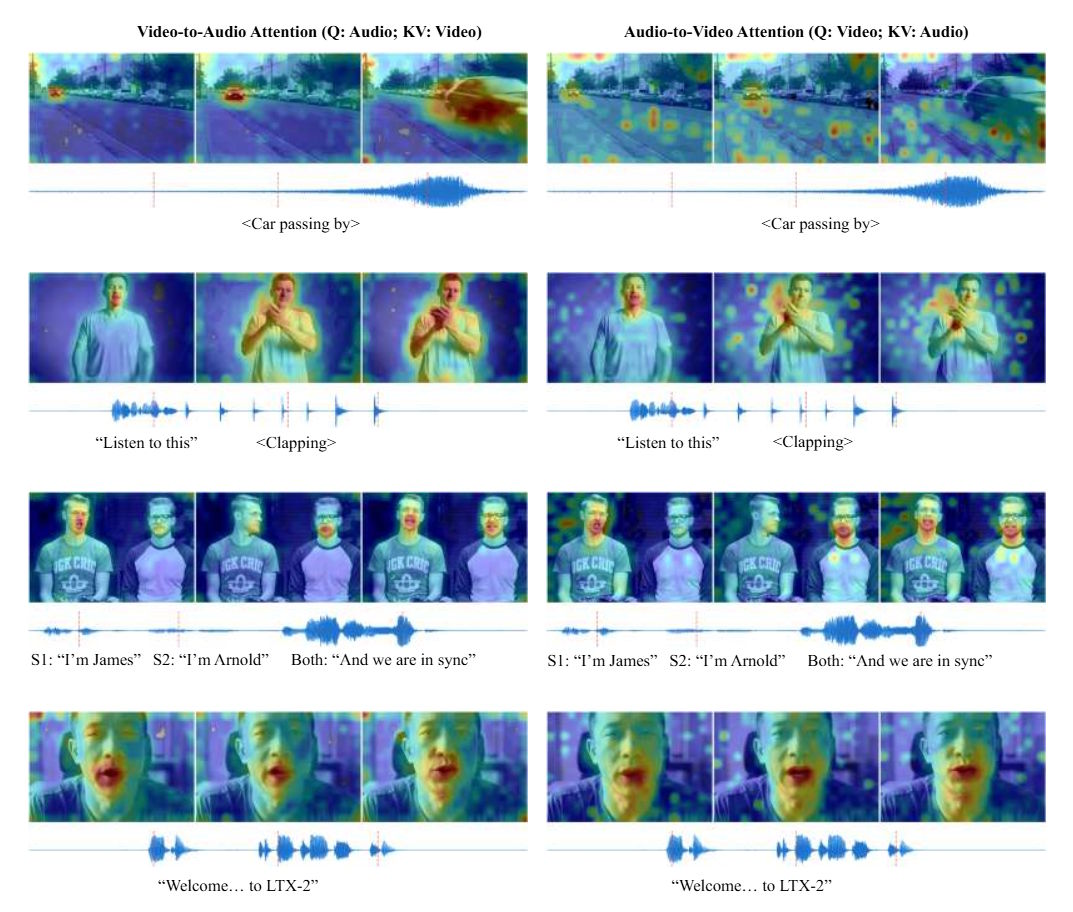

Оба потока используют отдельные вариационные автокодировщики для своих модальностей. Такое разделение позволяет использовать кодирование положения, специфичное для каждой модальности: трехмерные встраивания вращательного положения (RoPE) для пространственно-временной структуры видео и одномерные встраивания для чисто временного измерения звука. Двунаправленные слои перекрестного внимания [2] соединяют оба потока, точно связывая визуальные события, такие как падение объекта на землю, с соответствующими звуками.

Для распознавания текста LTX-2 использует Gemma3-12B [3] в качестве многоязычного кодировщика. Вместо того чтобы обращаться только к последнему слою языковой модели, система задействует все слои декодера и объединяет их информацию. Модель также использует мыслительные токены – дополнительные заполнители во входной последовательности, которые дают ей больше места для обработки сложных запросов до начала генерации.

Увеличение скорости выводит LTX-2 в лидеры среди конкурентов

Согласно результатам бенчмарков, LTX-2 демонстрирует значительные преимущества в скорости обработки данных. На графическом процессоре Nvidia H100 модели требуется 1,22 секунды на шаг для 121 кадра при разрешении 720p. Аналогичный Wan2.2-14B [4], генерирующий только видео без звука, затрачивает 22,30 секунды. Таким образом, по данным Lightricks, LTX-2 работает в 18 раз быстрее.

Максимальная продолжительность видео в 20 секунд также превосходит показатели конкурентов: Veo 3 от Google [5] достигает 12 секунд, Sora 2 от OpenAI [6] – 16 секунд, а модель Ovi с открытым исходным кодом от Character.AI [7] – 10 секунд. В исследованиях предпочтений человека LTX-2 значительно превосходит альтернативы с открытым исходным кодом, такие как Ovi, и показывает результаты, сопоставимые с проприетарными моделями, такими как Veo 3 и Sora 2.

Однако исследователи признают ряд ограничений. Качество варьируется в зависимости от языка – синтез речи может быть менее точным для языков или диалектов, которые недостаточно представлены. В сценах с несколькими говорящими модель иногда присваивает произнесённый текст не тем персонажам. В фрагментах длительностью более 20 секунд могут наблюдаться временной сдвиг и ухудшение синхронизации.

Выпуск открытого исходного кода создает проблемы при использовании закрытого API

Компания Lightricks объясняет свое решение сделать модель с открытым исходным кодом критикой существующего рынка.

«Я просто не понимаю, как этого можно достичь с помощью закрытых API», – говорит основатель Lightricks Зеев Фарбман в анонсирующем видео о перспективах современных моделей генерации видео. Индустрия застряла в тупике: с одной стороны, можно добиться впечатляющих результатов, но с другой – до уровня контроля, необходимого профессионалам, еще далеко.

Компания также занимает четко выраженную этическую позицию.

«Искусственный интеллект [8] может расширить возможности человеческой креативности и интеллекта. Меня беспокоит то, что кто-то другой присвоит себе мои возможности», — продолжает Фарбман.

Цель состоит в том, чтобы запускать ИИ на собственном оборудовании, на собственных условиях, и принимать этические решения в сотрудничестве с широким сообществом разработчиков, а не передавать их на аутсорсинг избранной группе с собственными интересами.

Помимо весов модели, релиз [9] включает в себя упрощенную версию, несколько адаптеров LoRA и модульную структуру обучения [10] с поддержкой нескольких графических процессоров. Модель оптимизирована для экосистемы Nvidia RTX и работает как на потребительских графических процессорах, таких как RTX 5090, так и на корпоративных системах. Веса модели и код доступны на GitHub [11] и Hugging Face [12] , а демо-версия доступна на контент-платформе компании [13] после бесплатной регистрации.

Делегируйте часть рутинных задач вместе с BotHub! [14] Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке [15] вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Источник [16]

Автор: MrRjxrby

Источник [17]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/24187

URLs in this post:

[1] техническому отчету: https://ltx.studio/ltx-2

[2] внимания: http://www.braintools.ru/article/7595

[3] Gemma3-12B: https://the-decoder.com/google-releases-new-gemma-3-open-model-family/

[4] Wan2.2-14B: https://the-decoder.com/alibaba-launches-wan2-2-its-improved-open-source-video-generation-model/

[5] Veo 3 от Google: https://the-decoder.com/google-expands-access-to-veo-3-its-viral-new-video-model-through-the-gemini-app/

[6] Sora 2 от OpenAI: https://the-decoder.com/sora-2-android-app-launches-in-more-countries-introduces-paid-generations/

[7] Character.AI: http://Character.AI

[8] интеллект: http://www.braintools.ru/article/7605

[9] релиз: https://ltx.io/model/model-blog/ltx-2-is-now-open-source

[10] обучения: http://www.braintools.ru/article/5125

[11] GitHub: https://github.com/Lightricks/LTX-2

[12] Hugging Face: https://huggingface.co/Lightricks/LTX-2

[13] на контент-платформе компании: https://app.ltx.studio/ltx-2-playground/i2v

[14] BotHub!: https://bothub.chat/?utm_source=contentmarketing&utm_medium=habr&utm_campaign=news&utm_content=LIGHTRICKS_HAS_OPENED_THE_SOURCE_CODE_OF_THE_LTX_2_AI_BASED_VIDEO_ANALYSIS_MODEL

[15] По ссылке: https://bothub.chat/?invitedBy=m_aGCkuyTgqllHCK0dUc7

[16] Источник: https://the-decoder.com/lightricks-open-sources-ai-video-model-ltx-2-challenges-sora-and-veo/

[17] Источник: https://habr.com/ru/companies/bothub/news/984228/?utm_source=habrahabr&utm_medium=rss&utm_campaign=984228

Нажмите здесь для печати.