Claude Opus 4.6 vs GPT-5.3 Codex

Одновременно с релизом Claude Opus 4.6 и GPT-5.3 Codex стало понятно, что определенно нет одной лучшей модели на все случаи жизни. Они решают разные задачи и по-разному смотрят на роль ИИ в разработке: Opus ближе к архитектору и оркестратору агентов, Codex – к исполнительному техлиду, который упорно может часами биться над задачей до победного.

В статье разбираем, что именно привнесли Opus 4.6 и GPT-5.3 Codex, как они ведут себя в бенчмарках и в реальной работе, и как их разумно совместить в стеке команды.

Две модели – два подхода

-

Claude Opus 4.6 [1]– это флагманская модель от Anthropic с упором на длинный контекст (до 1M токенов в бете), сложное рассуждение и управление агентами/под-агентами. Хорошо держит в голове большие репозитории, базы знаний и многодневные сессии.

-

GPT-5.3 Codex [2] – специализированная версия GPT-5 от OpenAI, заточенная под «agentic coding»: работа в Codex-приложении, CLI и IDE, запуск тестов, чтение логов, кликание по UI и автоматизацию компьютерных задач.

Иными словами, Opus 4.6 скорее руководитель команды агентов: планирует, читает много, держит контекст проекта. Тогда как GPT-5.3 Codex это, своего рода, упертый, надежный исполнитель: быстро, долго и надежно делает работу под тесты.

Давайте последовательно разберемся, что нового в Claude Opus 4.6 и в GPT-5.3 Codex, а затем поймем, для чего каждый инструмент лучше подходит.

Что нового в Claude Opus 4.6

1. 1M токенов контекста и длинные сессии

Главное изменение – контекстное окно до 1 000 000 токенов. Базовый лимит остался 200k, но для запросов, которые выходят за этот предел, включается [3] длинный контекст с повышенным тарифом.

Что же это дает на практике:

-

Можно целиком загружать монорепы, большие библиотеки и документацию.

-

Вести одну длинную стратегическую/ресерч-сессию без постоянного обрезания истории.

-

Гонять сложные legal/finance кейсы с пачкой документов: договоры, политики, переписка.

Во сколько это обойдется:

-

Стандарт: $5 / $25 за 1M input/output токенов (как у Opus 4.5).

-

Для запросов 200k+ токенов – премиум-тариф $10 / $37.5 за 1M токенов.

2. Agent Teams в Claude Code

Вместо одной длинной цепочки действий теперь можно запускать несколько суб-агентов, работающих параллельно в рамках Claude Code:

-

каждый агент отвечает за свою часть задачи (например, фронт, бэкенд, тесты)

-

агенты координируют действия друг с другом

-

разработчик может пересесть в любого суб-агента и вручную вмешаться.

Это особенно полезно, когда задача предполагает много чтения (большой репозиторий, RFC, документация) и когда можно естественно поделить работу, например: агент А делает ревью архитектуры, агент Б – фиксы и тесты, агент В – документация.

3. Интеграция с PowerPoint и усиленный Excel

Opus 4.6 теперь ориентирован не только на кодинг, но и на офис.

-

Если раньше можно было попросить Claude создать презентацию, но файл для редактирования нужно было перенести в PowerPoint. Теперь Claude работает в PowerPoint в качестве боковой панели. Интеграция считывает ваши существующие макеты, шрифты и шаблоны слайдов. Она генерирует слайды, соответствующие вашему бренду, без необходимости создавать их с нуля. Фича доступна в планах Max /Team /Enterprise.

-

Обновленный Excel-режим: модель сначала строит план действий по сложной задаче, плюс, теперь умеет раскладывать неструктурированный импорт. Можно теперь загрузить разрозненные CSV или выгрузки из CRM и привести в нормальные таблицы для дальнейшего анализа – поддерживает многошаговые правки за один проход (фильтрация, формулы, сводные).

Получается хорошая связка: загружаем сырые данные – Excel их обрабатывает и структурирует, а затем, на основе этого визуально их представляет в PowerPoint их на слайдах.

Кстати, интеграция с PowerPoint напомнила мне как это реализовано в Kimi Slides [4] (делала на него видеообзор).

4. Adaptive Thinking и команда /effort

Раньше режим extended thinking (расширенное мышление [5]) было либо включено, либо выключено. Теперь Claude может сам решать, когда более глубокое рассуждение будет полезным – у Opus 4.6 появился режим adaptive thinking:

-

модель сама решает, нужно ли долго рассуждать по конкретному запросу

-

есть 4 уровня effort (сложности): low /medium /high (по умолчанию) /max

-

уровень можно задать прямо в чате или через API.

Пример команды в чат-интерфейсе:

/effort highДля простых задач (юнит-фиксы, небольшой скрипт) лучше ставить medium, чтобы не тратить лишние токены. Для сложных архитектурных/ресерч задач – max, модель будет дольше думать и возвращаться к промежуточным гипотезам.

5. Сжатие контекста (context compaction)

Чтобы не упираться в потолок при длительных сессиях, Opus 4.6 получил автоматическое сжатие контекста:

-

старые участки диалога/документов сворачиваются в компактные саммари

-

эти саммари подставляются вместо сырых данных, когда контекст близок к лимиту.

Идея схожа с RAG-пайплайнами, но встроена в саму модель. Для разработчика это хорошо – меньше ручных

сделай summary, а потом работай с ним.

6. До 128k выходных токенов

Opus 4.6 может выдать до 128 000 токенов ответа одним залпом. Это отлично подходит для больших файлов документации (док, мануалы, туториалы) без разбивки. А еще для длинных код-диффов и автогенерация целых модулей, и для длительных отчетов по ресерчу/анализу.

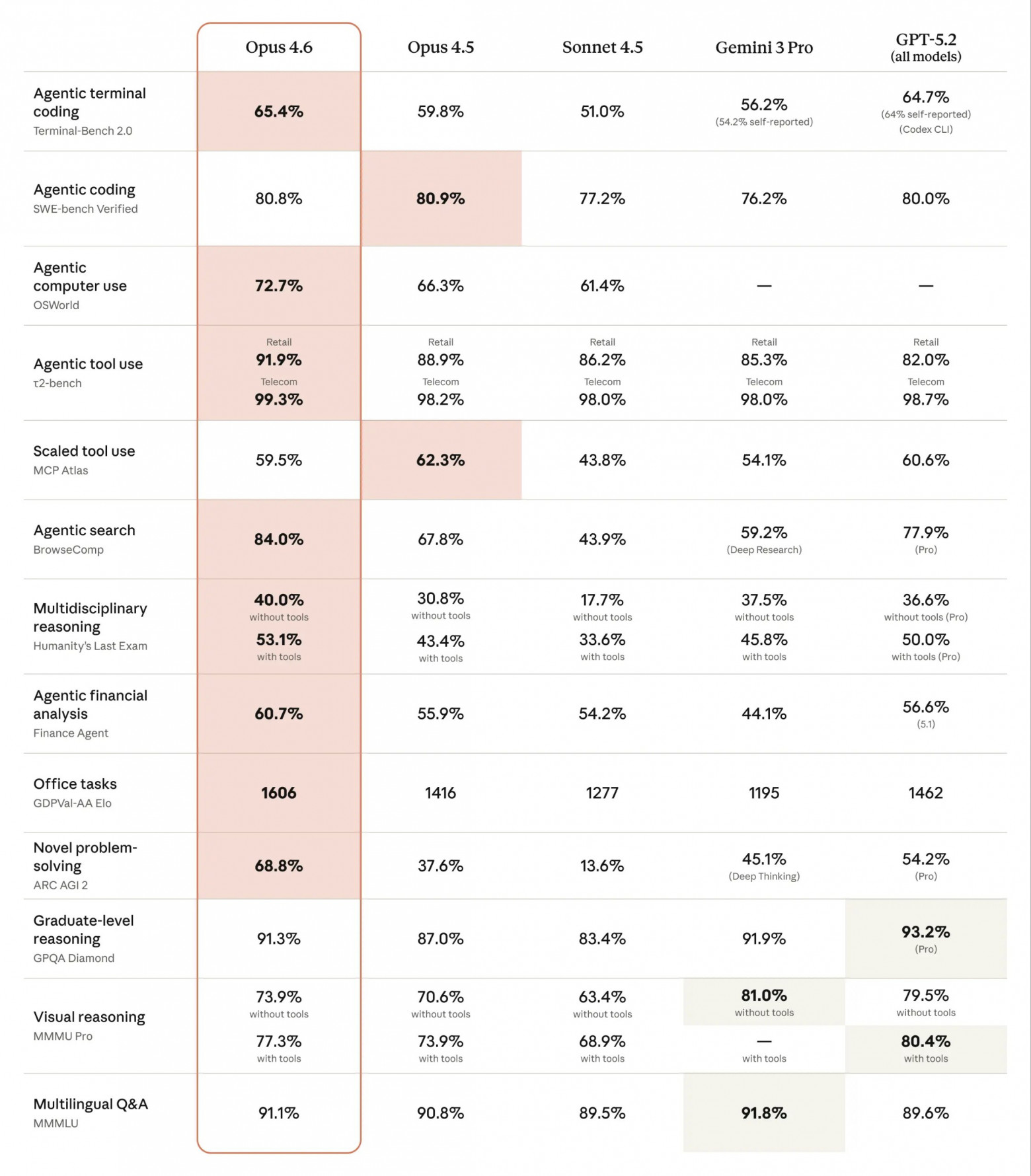

7. Кодинг и бенчмарки

По данным Azure AI Foundry [7] и system card [8], Opus 4.6:

Terminal-Bench 2.0 (агент в терминале): 65.4%

SWE-bench Verified (агентное исправление реальных багов): 80.8%

OSWorld (компьютер-юз, визуальный рабочий стол): 72.7%

BrowseComp (агентный поиск по сети): 84.0%

GDPval-AA (офисное знание-работа): Elo ≈1600, с отрывом от GPT-5.2 по результатам ArtificialAnalysis.

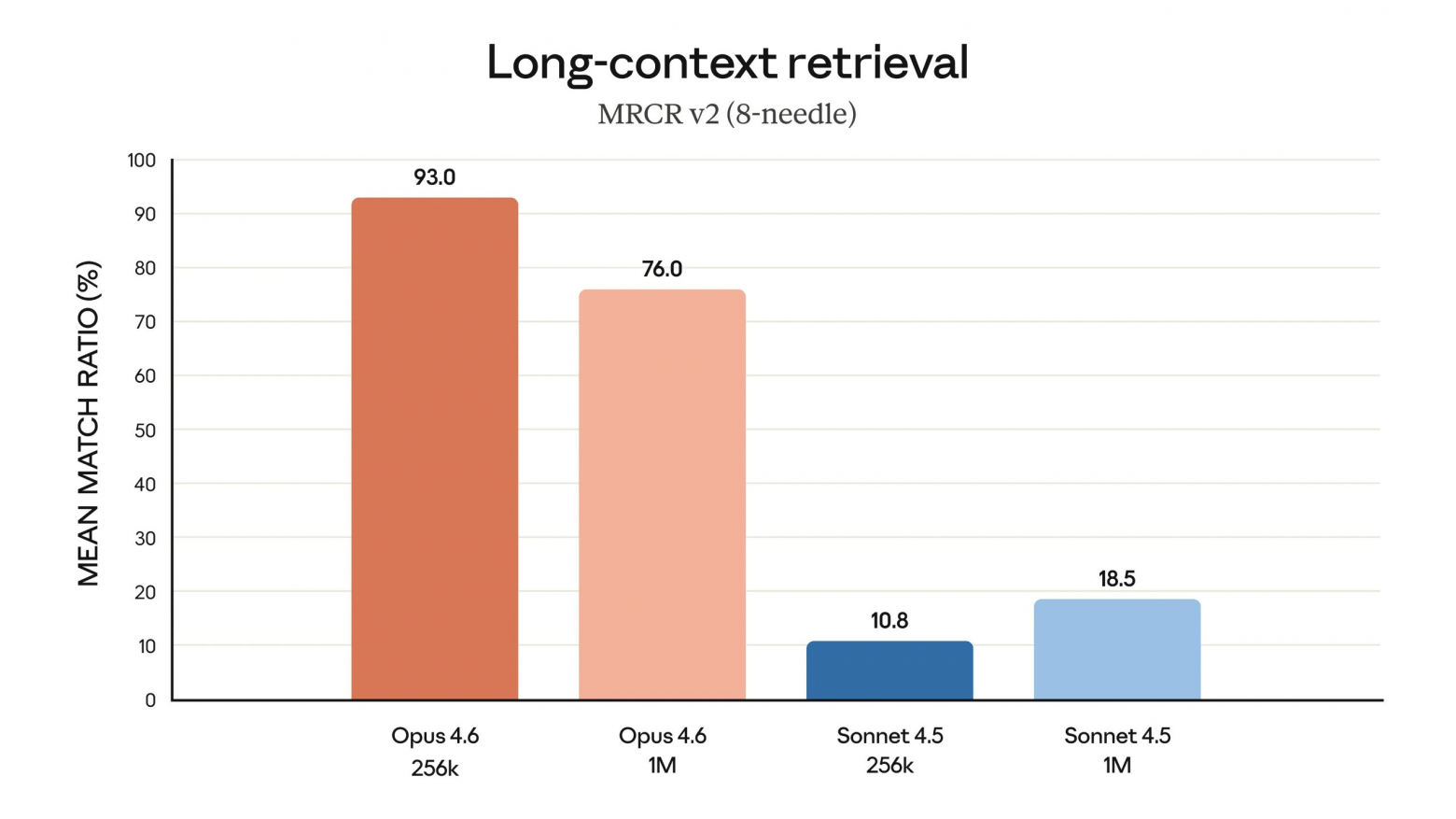

MRCR v2 (long-context чтение): около 76% против ~18.5% у Sonnet 4.5 при огромном контексте:

Переводя с языка бенчмарков, Opus 4.6 особенно силен там, где нужно читать много, думать долго и аккуратно менять сложные системы. В инженерных обзорах все чаще можно встретить мысль, что код стал заметно лучше, но стиль письма стал суше по сравнению с Opus 4.5. Поэтому часть команд оставляет Opus 4.5 для документации и длинного текста, а Opus 4.6 кидает в кодинг и сложное reasoning.

Вы дочитали до середины статьи, а значит, статья, вероятнее всего, вам понравилась, как и моя подача и стиль письма, так что вы можете поддержать меня в моем телеграм канале [9], где уже собрано много полезного и проверенного.

8. Безопасность и отказы

С точки зрения [10] безопасности, Opus 4.6 показывает более низкий уровень misaligned-поведения (обман, подхалимство, поощрение заблуждений) и меньше лишних отказов на нормальные запросы по сравнению с Opus 4.5. Однако стоит понимать, что это сравнительный результат внутри линейки Claude, а не сравнение со всеми моделями на рынке.

Что нового в GPT-5.3 Codex

GPT-5.3 Codex – это версия GPT-5, оптимизированная для агентного кодинга:

-

доступна в Codex-приложении [11], CLI, IDE-плагинах и в платном ChatGPT

-

умеет работать с файлами проекта, логами, терминалом, браузером и GUI

-

поддерживает vision – может использовать скриншоты интерфейса и файлов.

Отдельно Codex-приложение я разобрала в этом посте [11].

В API-документации [12] модель описана как версия GPT-5 для агентного кодинга в Codex с 400k токенов контекста, 128k выходных токенов и ценой $1.25 / $10 за 1M input/output токенов.

В чем Codex силен:

-

Умеет долго выполнять одну задачу: писать код → запускать → читать логи → править → снова запускать, пока не доведет до результата.

-

Хорошо показывает себя в командной строке и системных сценариях: CI/CD, админ-скрипты, миграции.

-

В OS-/GUI-агентных задачах использует vision и может кликать по кнопкам, заполнять формы, сохранять файлы, перемещаться между окнами.

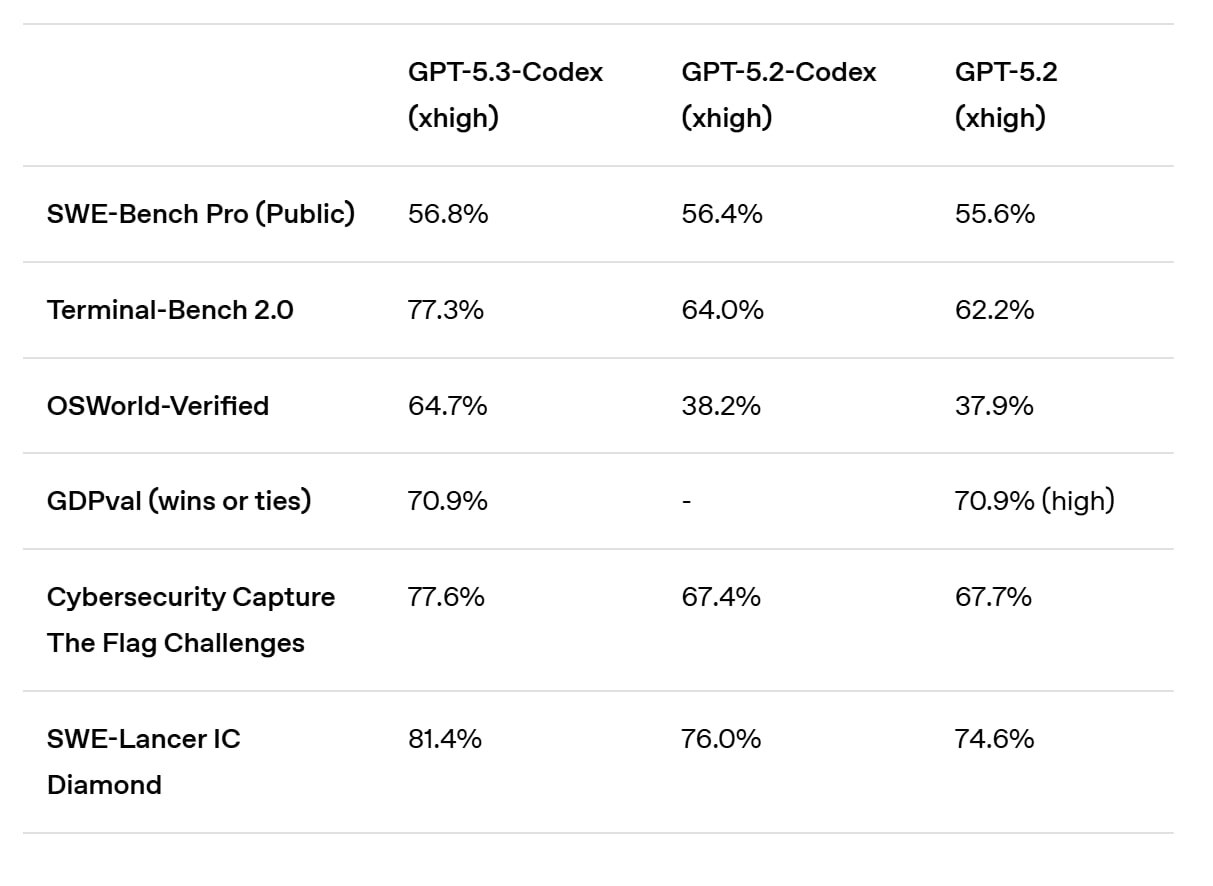

Бенчмарки: где Codex лидирует

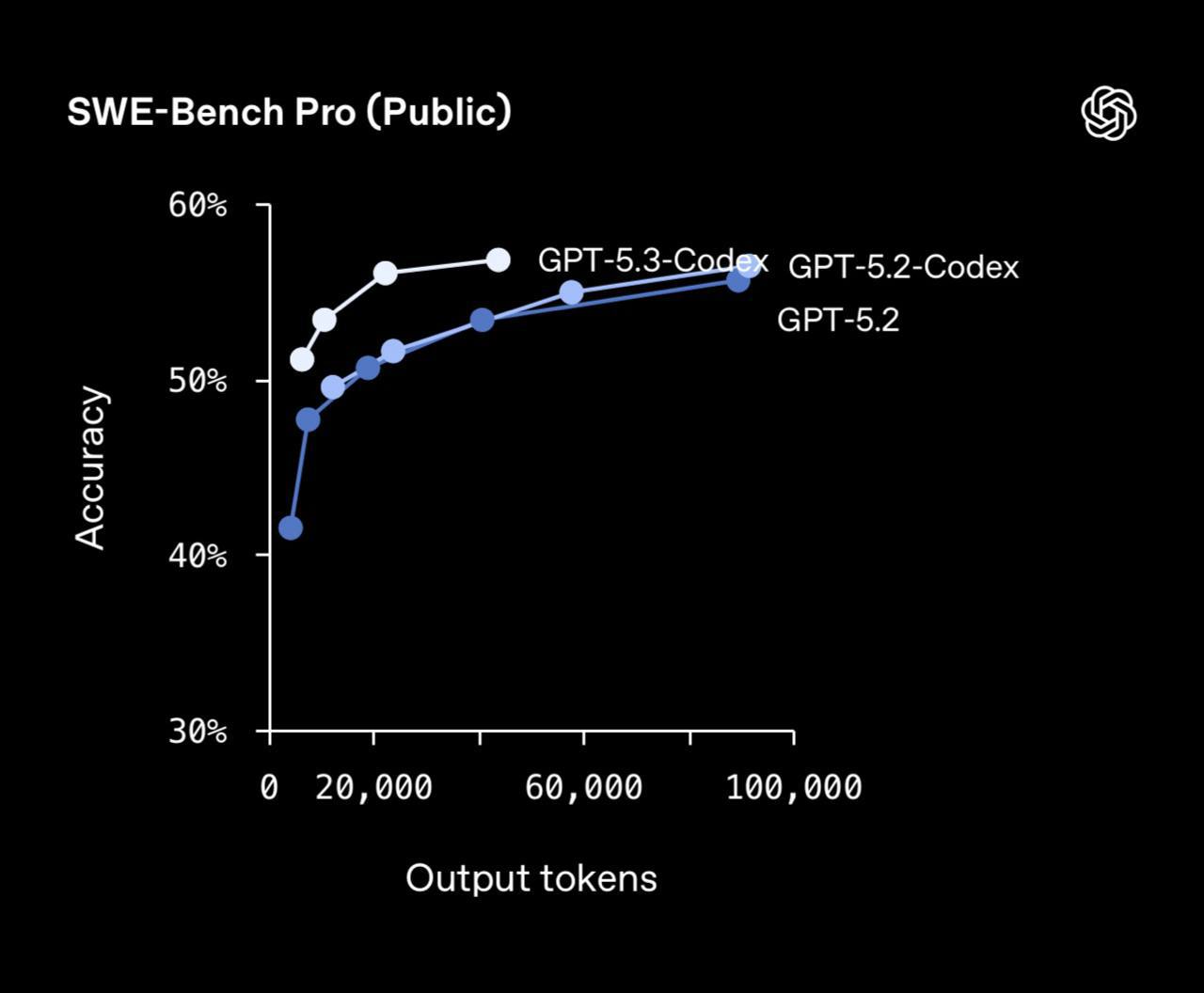

По официальному блогу [13] OpenAI GPT-5.3 Codex показывает:

-

SWE-Bench Pro: 56.8% – новый рекорд по реальным задачам на 4-х языках:

-

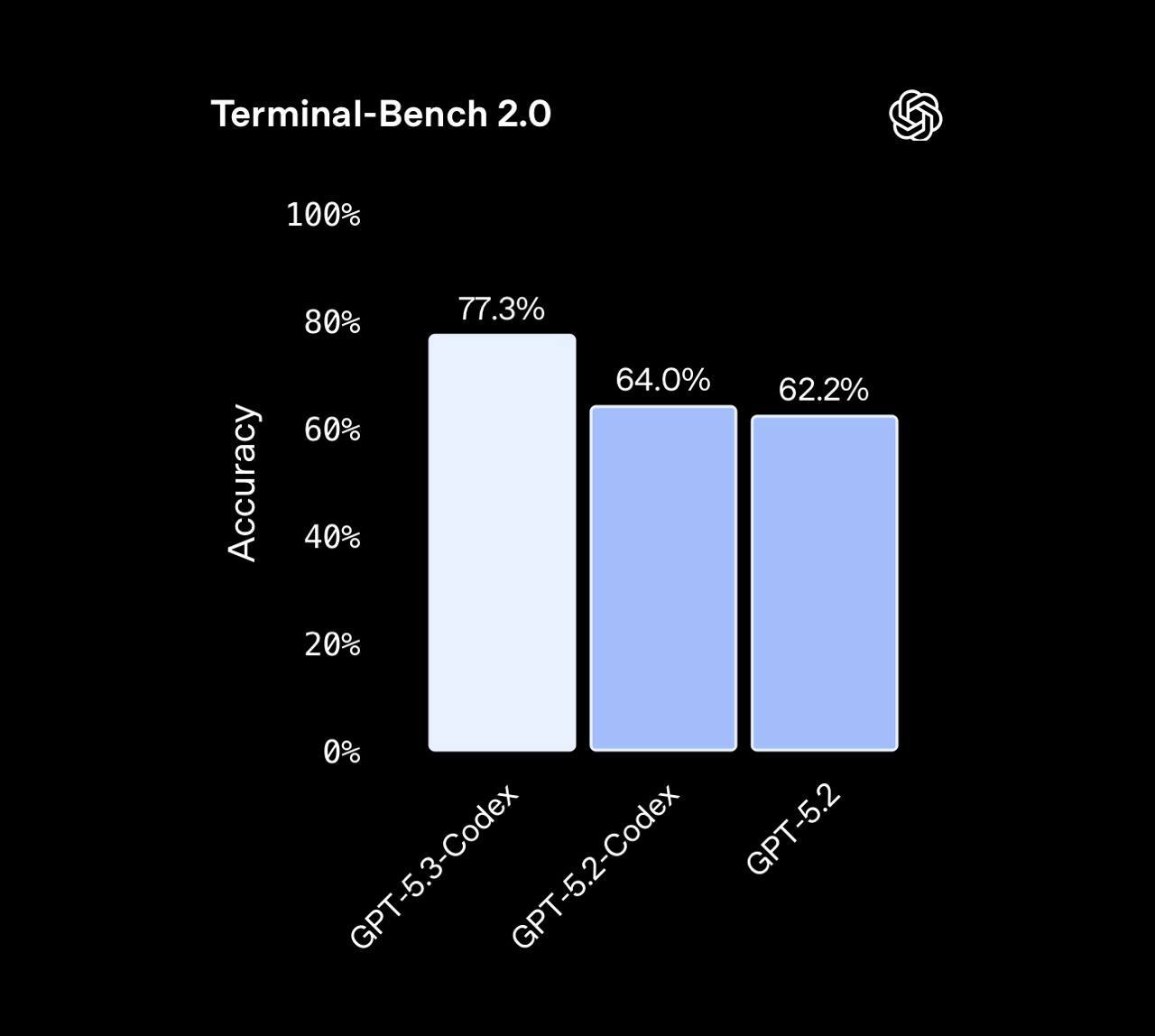

Terminal-Bench 2.0: 77.3% (выше, чем у GPT-5.2-Codex и базового GPT-5.2)

-

OSWorld-Verified: 64.7% (модели приходится как человек выполнять задачи в реальном UI)

-

GDPval (knowledge-work без привязки к офису): 70.9% побед или ничьих – уровень GPT-5.2, но в агентном режиме

-

заметный рост на кибер-CTF-бенчмарках и инженерных задачах (SWE-Lancer, security-челленджи).

Дополнительно, SiliconANGLE [14] подчеркивает, что GPT-5.3 Codex на 25% быстрее своего предшественника по latency в Codex-среде. Если инетресно, вот мой разбор GPT-5.2 Codex [15]

ChatGPT-5.3 Codex и Claude Opus 4.6: где кто сильнее

Мы познакомились с особенностями и новинками обеих моделей, их бенчмарками. И, если сопоставить Opus 4.6 и GPT-5.3 Codex, получается примерно такая картина:

|

Бенчмарк / параметр |

Claude Opus 4.6 |

GPT-5.3 Codex |

|---|---|---|

|

Terminal-Bench 2.0 (терминал) |

65.4% |

77.3% |

|

SWE-bench Verified / Pro |

80.8% (Verified) |

56.8% (Pro) |

|

OSWorld-Verified |

72.7% |

64.7% |

|

BrowseComp (поиск) |

84.0% |

нет публичной цифры |

|

GDPval / GDPval-AA |

Elo ≈1606 (leaderboard) |

70.9% wins/ties (GDPval) |

|

Context window |

1M (beta), стандарт 200k |

~400k |

|

Max output |

128k |

128k |

|

Цена за 1M токенов |

$5 / $25; $10 / $37.5 за 200k+ |

$1.25 / $10 |

Какие можно выводы сделать?

-

Terminal-Bench и CLI-сценарии: явное преимущество у GPT-5.3 Codex.

-

Verified-бенчмарки и длинное reasoning (SWE-bench Verified, Humanity’s Last Exam, GDPval-AA, MRCR): более сильная сторона Opus 4.6.

-

Компьютер-юз (OSWorld): оба сильные, но у Opus цифры выше, при этом Codex отрабатывает в собственной Codex-среде с плотной интеграцией с инструментами.

-

Цена: Codex ощутимо дешевле в API, Opus дороже на 60–75% за те же объемы токенов.

При этом на практике мнения сходятся: ни одна модель не убила другую. Они просто оптимизированы под разные профили задач. Opus 4.6 – это инженер-архитектор, который читает все: код, RFC, бизнес-контекст, думает, проектирует, расписывает шаги и задачи и держит в голове «зачем» и «почему», а не только «как». GPT-5.3 Codex – очень быстрый исполнитель, который сразу “идет в бой”: коммитит, запускает, смотрит логи, отлично чувствует себя в терминале и CI/CD и будет работать, пока тесты не станут зелеными.

Логичнее ставку делать на Opus 4.6 когда вам важны очень длинные цепочки рассуждений и объемы контекста (монорепы, крупные базы знаний,большие юридические/финансовые кейсы). Там, где нужен один мозг-оркестратор, который поднимает саб-агентов, раздает им задачи и следит за процессом. Opus 4.6 силен в смешанных задачах (код + ресерч + стратегия + юр/бизнес-контекст в одной сессии). Ну и теперь офисные рабочие процессы легче решать с Opus 4.6 (Excel + PowerPoint).

GPT-5.3 Codex лучше, когда в кодинге приоритет – экономия, когда у вас уже есть пайплайны с автотестами, и модель можно мерить по тому, сколько задач закрыла до зеленых тестов. А еще, если у вас много OS/GUI-автоматизации (автотесты фронта, end-to-end сценарии с браузером, настройка CI/CD, мониторинг, операции с логами). И вам в целом нужен агент, который живет внутри реальной инфраструктуры (GitHub, CI, мониторинг) и умеет сам находить и разумно использовать доступные skills/tools, и ему не надо вручную писать и спрашивать “а есть ли скилл для этой задачи”.

Где хороши обе модели: GPT-5.3 Codex и Claude Opus 4.6

Есть зона, где обе модели хороши: агентный кодинг по реальным проектам, компьютер-юз и OS-агенты, знание-работа (GDPval-класса).

Разница в том, на что вы делаете ставку: если вам важно максимальное погружение в контекст, аккуратность рассуждений, оркестрация множества агентов – Opus 4.6 – ваш выбор. Если в приоритете высокая скорость и продуктивность в среде, где все завязано на тесты, логи и инструменты – то определенно Codex 5.3 – лучшее решение.

В общем, оптимально для команды не выбирать “или то или это”, а распределять роли: Codex в роли исполнительного агента под тесты и инфраструктуру, Opus в роли архитектора и координатора сложных цепочек. Вы можете поддержать меня в моем телеграм канале [9], там я пишу о том, в чем разбираюсь или пытаюсь разобраться сама, тестирую полезные ИИ-сервисы, инструменты для офиса, бизнеса, маркетинга и видео.

Автор: Neurosonya

Источник [16]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/25311

URLs in this post:

[1] Claude Opus 4.6 : https://claude.com/

[2] GPT-5.3 Codex: https://openai.com/ru-RU/codex/

[3] включается: https://www.anthropic.com/news/claude-opus-4-6

[4] Kimi Slides: https://t.me/NeuralProfit/1942

[5] мышление: http://www.braintools.ru/thinking

[6] Image: https://sourcecraft.dev/

[7] Azure AI Foundry: https://ai.azure.com/catalog/models/claude-opus-4-6

[8] system card: https://www-cdn.anthropic.com/0dd865075ad3132672ee0ab40b05a53f14cf5288.pdf

[9] телеграм канале: https://t.me/+wgO-GbRifKA0NGQy

[10] зрения: http://www.braintools.ru/article/6238

[11] Codex-приложении: https://t.me/NeuralProfit/2159

[12] API-документации: https://platform.openai.com/docs/models/gpt-5-codex

[13] официальному блогу: https://openai.com/index/introducing-gpt-5-3-codex/

[14] SiliconANGLE: https://siliconangle.com/2026/02/05/openai-introduces-frontier-agent-management-platform-gpt-5-3-codex/

[15] мой разбор GPT-5.2 Codex: https://t.me/NeuralProfit/2130

[16] Источник: https://habr.com/ru/articles/993676/?utm_source=habrahabr&utm_medium=rss&utm_campaign=993676

Нажмите здесь для печати.