Учёные из Стэнфорда представили Paper2Agent — open-source инструмент, который превращает привычные PDF-статьи в интерактивных AI-ассистентов. Теперь вместо сухого текста и громоздких репозиториев исследователь получает живую систему, способную объяснять работу простым языком, запускать код и комбинировать методы разных исследований.

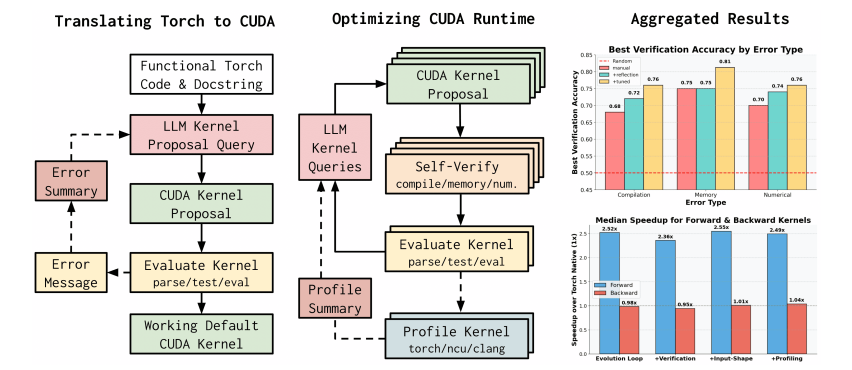

В основе проекта два ключевых слоя. Paper2MCP анализирует статью вместе с её кодом и превращает методы в полноценные инструменты внутри MCP-сервера. Дальше Agent Layer подключает этот сервер к чат-агенту вроде ChatGPT или Claude Code. В итоге каждая статья обретает своего персонального ассистента, который не только пересказывает её, но и выполняет заложенные в ней вычислительные эксперименты.

Каждый такой «сервер статьи» включает три элемента: Tools (функции, например прогноз экспрессии генов), Resources (тексты, датасеты, код) и Prompts (шаблоны пошаговых сценариев). Вместо того чтобы вручную поднимать окружения, импортировать десятки библиотек и гадать с форматами данных, исследователь может просто задать вопрос и сразу получить результат.

Фактически Paper2Agent открывает путь к новому формату научной коммуникации: статьи перестают быть статичными и становятся рабочими инструментами. Это может ускорить воспроизводимость исследований, облегчить доступ к передовым методам и сделать науку гораздо более открытой.

GitHub-репозиторий проекта уже доступен!

Делегируйте часть рутинных задач вместе с BotHub! Для доступа к сервису не требуется VPN и можно использовать российскую карту. По ссылке вы можете получить 100 000 бесплатных токенов для первых задач и приступить к работе с нейросетями прямо сейчас!

Автор: cognitronn