Как DeepSeek-R1 научилась мыслить и «последний экзамен человечества»: топ-10 исследований ИИ за январь 2025

Я – Андрей, технологический предприниматель и консультант по ИИ.

Январь вновь оказался насыщенным месяцем на прорывные исследования в сфере искусственного интеллекта [1] (ИИ). В этой статье я отобрал десять работ, которые ярко демонстрируют, как современные методы обучения [2] с подкреплением [3] (RL), мультиагентные системы и мультимодальность помогают ИИ-агентам не только решать сложнейшие задачи, но и приближаться к пониманию мира «на лету». А также расскажу о «последнем экзамене человечества», как обучать роботов, лаборатории ИИ-агентов и других актуальных исследованиях.

Если вы хотите быть в курсе последних исследований в ИИ, воспользуйтесь Dataist AI [4] — моим бесплатным ботом, который ежедневно обозревает свежие научные статьи.

А также подписывайтесь на мой Telegram-канал [5], где я делюсь инсайтами из индустрии, советами по запуску ИИ-стартапов, внедрению ИИ в бизнес, и комментирую новости из мира ИИ. Поехали!

1. DeepSeek R1 [6]

Начнем с короткого разбора нашумевшей модели от китайской компании DeepSeek. Разработчики демонстрируют, как с помощью обучения с подкреплением (RL) [7] можно значительно улучшить способность больших языковых моделей к рассуждению. Они научили модели самостоятельно генерировать развернутые цепочки мыслей и сложные стратегии решения задач.

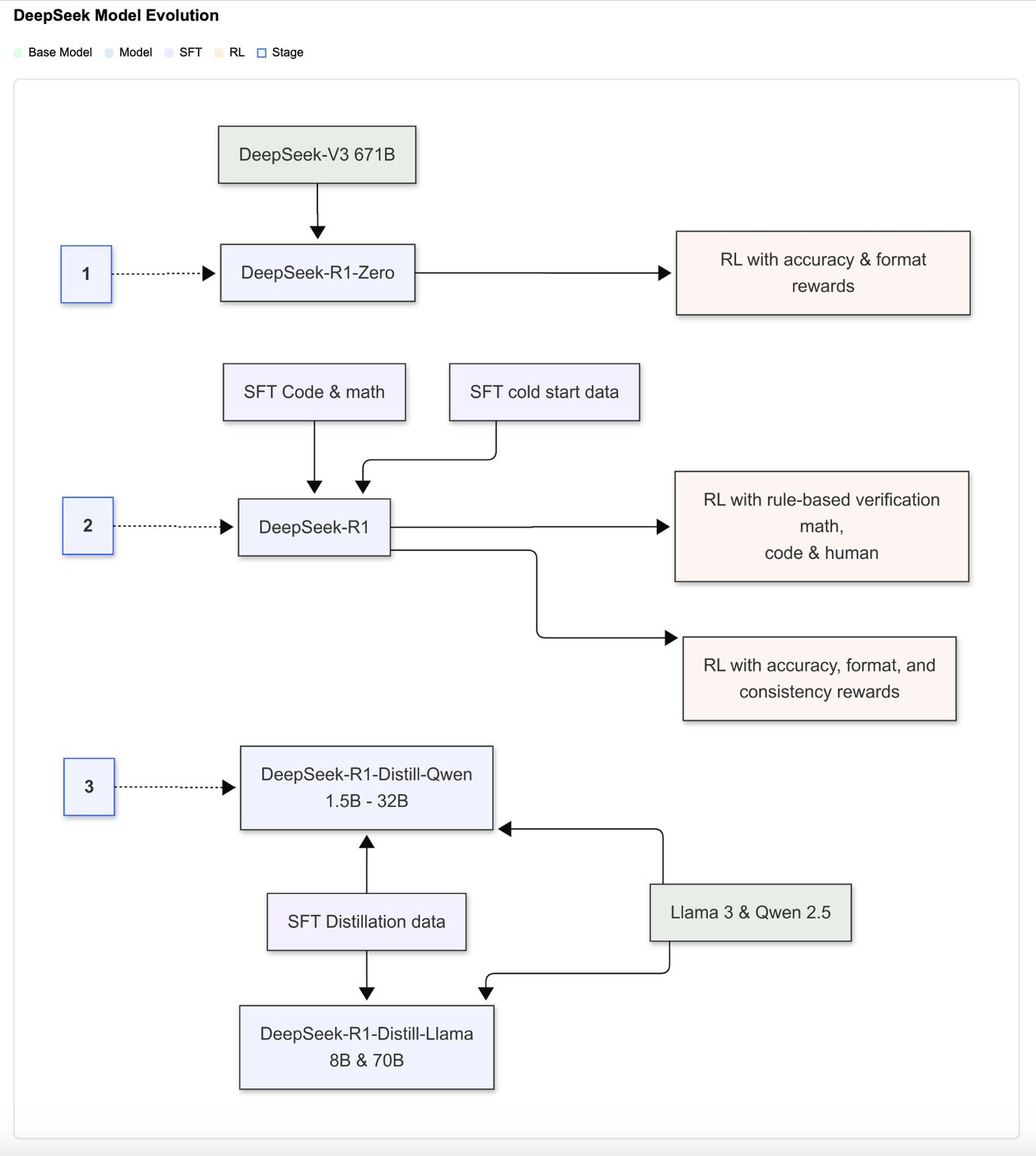

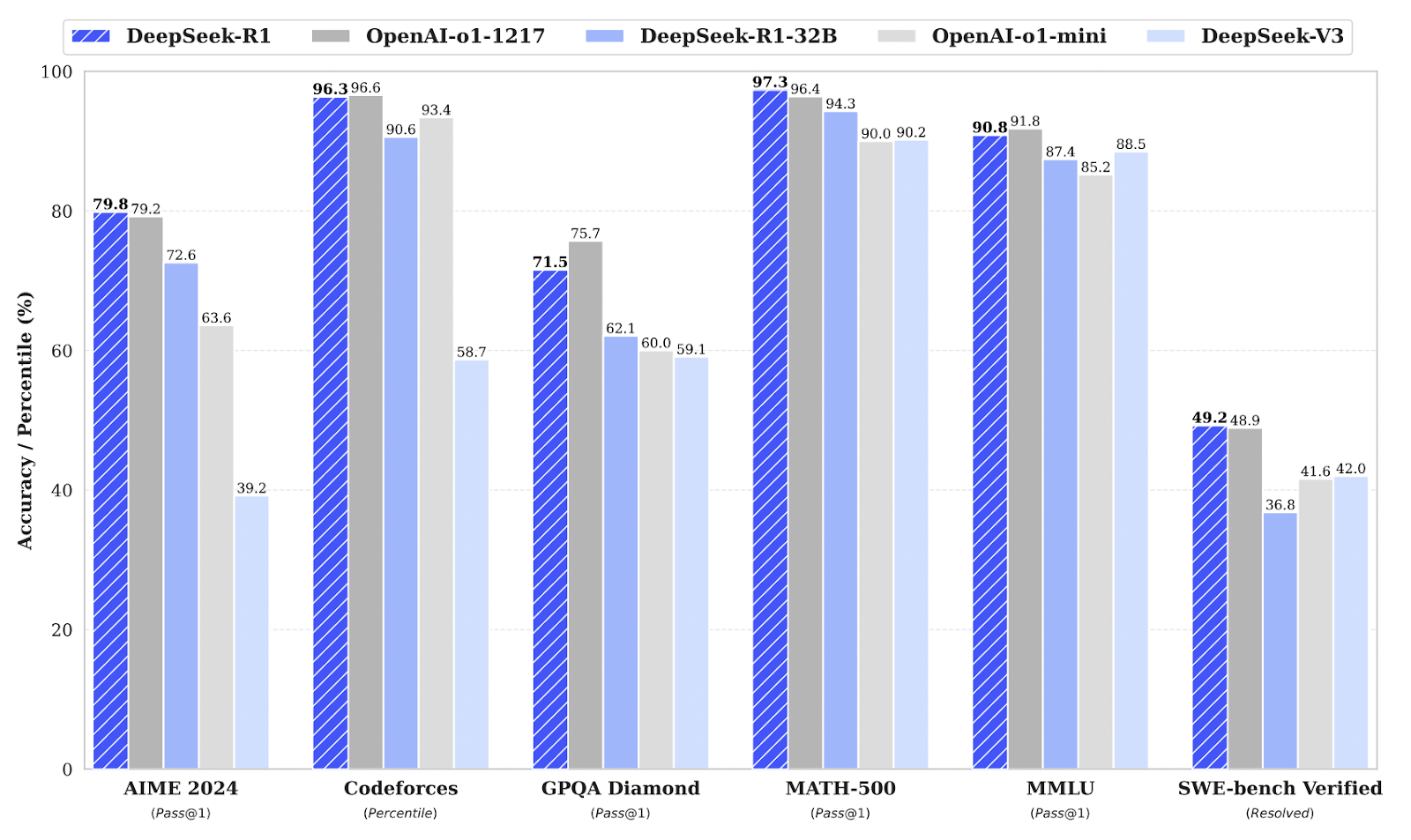

Таким образом удалось обучить две модели: DeepSeek-R1 и DeepSeek-R1-Zero, которые конкурируют с закрытыми аналогами вроде OpenAI-o1 на задачах математики [8], логики, программирования и других дисциплин.

Как этого удалось добиться? DeepSeek-R1-Zero училась «с нуля» методом RL без предварительного Supervised fine-tuning (SFT) [9], следуя заданному формату: «<think>…</think><answer>…</answer>» (чтобы модель генерировала цепочку рассуждений явно).

Разработчики использовали задачи, где можно однозначно проверить решение (например, математика или программирование). Если итог совпадал с верным ответом (или код компилировался и проходил тесты), модель получала положительную награду для RL.

Для DeepSeek-R1 добавляют несколько примеров для холодного старта с качественными решениями. Затем следуют этапы:

1. Небольшой Supervised fine-tuning (SFT) на предварительных данных. SFT — процесс дообучения языковой модели с использованием размеченных данных, чтобы адаптировать ее для решения конкретных задач. При этом модель корректирует свои параметры на основе сравнения предсказаний с заданными правильными ответами.

2. RL для усиления рассуждения (математика, код, логика [10]). Модель получала вознаграждение за правильные и отформатированные ответы, что способствовало ее адаптации к разнообразным задачам.

3. Сборка нового датасета с помощью rejection sampling и повторный SFT. Rejection sampling – это метод выборки, при котором из простого для генерации распределения берутся случайные кандидаты, а затем каждый кандидат принимается с определенной вероятностью так, чтобы итоговая выборка соответствовала нужному целевому распределению.

4. Итоговое применение RL, учитывающее разнообразные типы запросов – от специализированных задач до общих сценариев.

Далее происходит дистилляция посредством генерации 800 тыс. пошаговых выборок, на основе которых дообучают компактные модели (от 1.5B до 70B) на базе Qwen и Llama.

Интересно, что модель эволюционирует самостоятельно, используя длинные цепочки рассуждений, анализ промежуточных шагов и рефлексию о возможных ошибках. Также формат вывода разделяет цепочку рассуждений и финальный ответ, что улучшает удобство восприятия [11]. В отличие от экспериментов с MCTS [12] или Process Reward Model [13], RL и аккуратная дистилляция дали существенный прирост результатов на задачах AIME [14] (олимпиадная математика), MATH-500 [15], Codeforce [16] (олимпиадное программирование) и AlpacaEval 2.0 [17].

Таким образом DeepSeek показывают, что даже без гигантских объемов размеченных датасетов большие языковые модели могут эффективно обучаться рассуждениям, а дистилляция позволяет переносить это умение в компактные модели без существенной потери точности. В перспективе авторы планируют улучшать модель на более широком спектре задач — от инженерии до разговорных навыков.

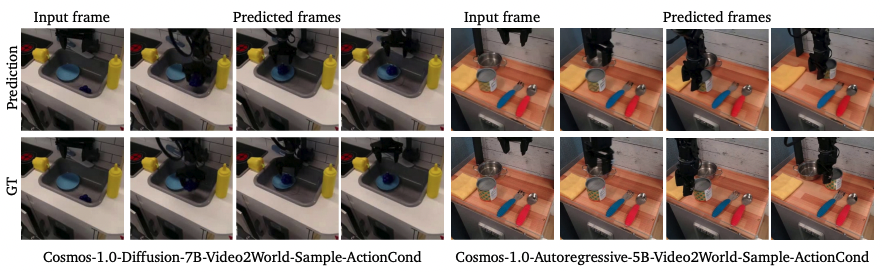

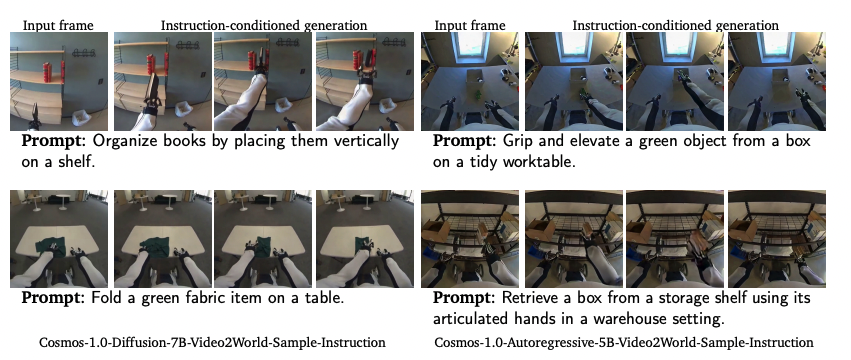

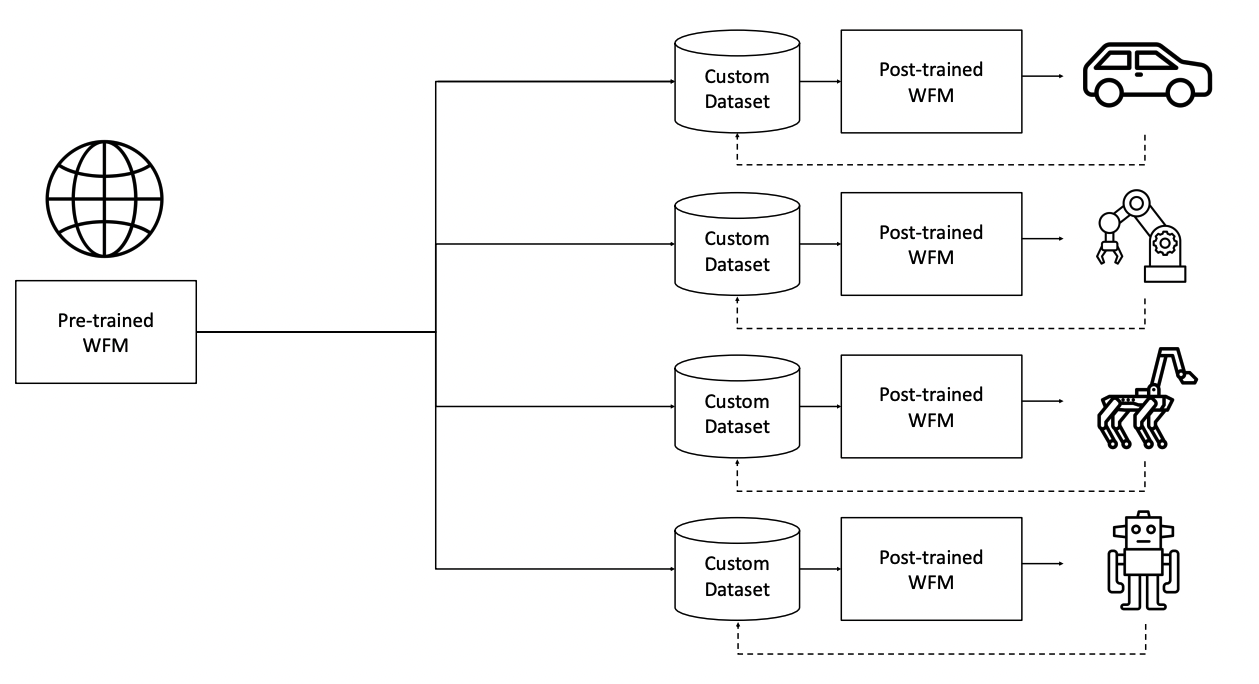

2. Cosmos World Foundation Model Platform for Physical AI [18]

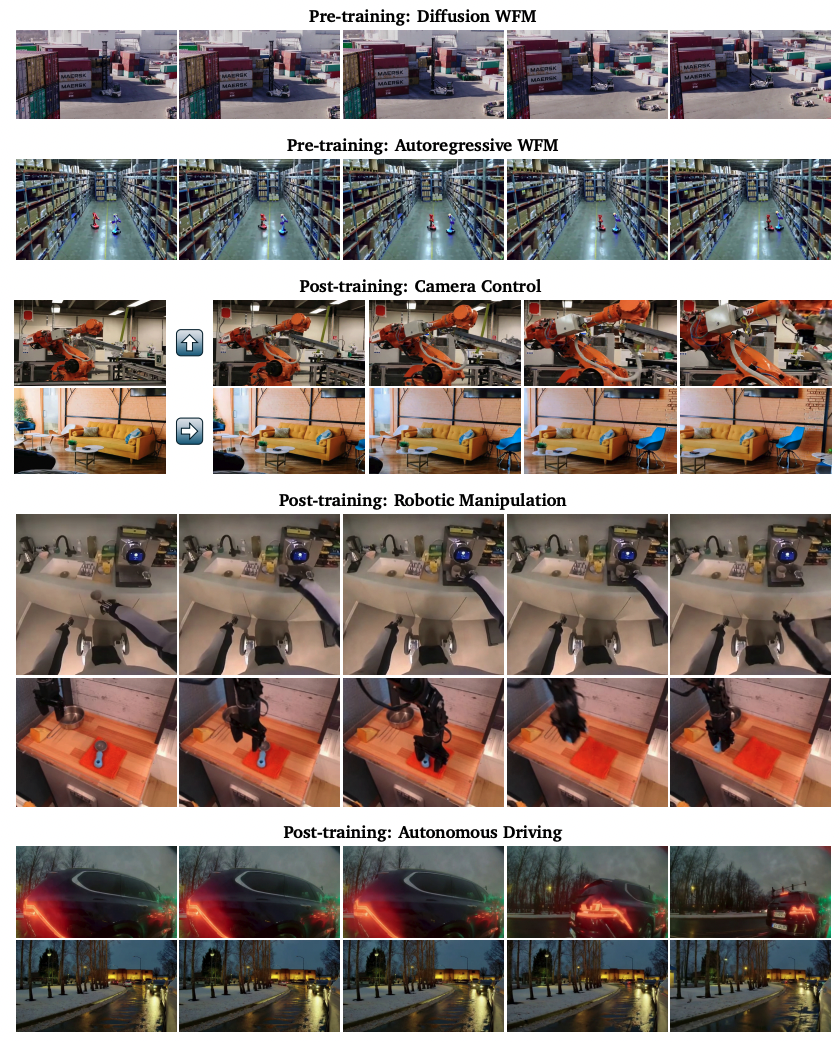

Разработчики Nvidia представляют платформу Cosmos World Foundation Model (WFM) для «Физического ИИ» — систем, которым нужен «цифровой двойник» реального мира, например, для роботов и устройств с сенсорами. Модель предсказывает и генерирует видео будущих состояний, учитывая как предыдущие наблюдения, так и действия роботов и инструкции, что помогает обучать роботов без риска для реальных устройств.

Разработчики обработали около 20 млн часов видео с применением фильтров по качеству, аннотация делалась с помощью визуальных языковых моделей (VLM) [19]. Далее были разработаны универсальные токенизаторы для эффективного сжатия видео без потери деталей.

Следом были обучены два типа моделей: диффузионная WFM, где видео генерируется пошаговым удалением шума и авторегрессионная WFM, предсказывающая следующий токен по аналогии с LLM, с усиленным «diffusion decoder» для повышения детализации.

В итоге последовала пост-тренировка под конкретные задачи: от управления камерой до автономного вождения и робо-манипуляций, плюс двухуровневая фильтрация для безопасности.

Cosmos WFM — важный шаг к созданию единой «модели мира», применимой в робототехнике и других задачах физического ИИ. Несмотря на уже достигнутые успехи, предстоит решать задачи повышения физической реалистичности, чтобы обеспечить надежность в реальных приложениях (Sim2Real-адаптация [20]). Остается добавлять в обучающую выборку еще больше физических сценариев и использовать синтетические данные из симуляторов.

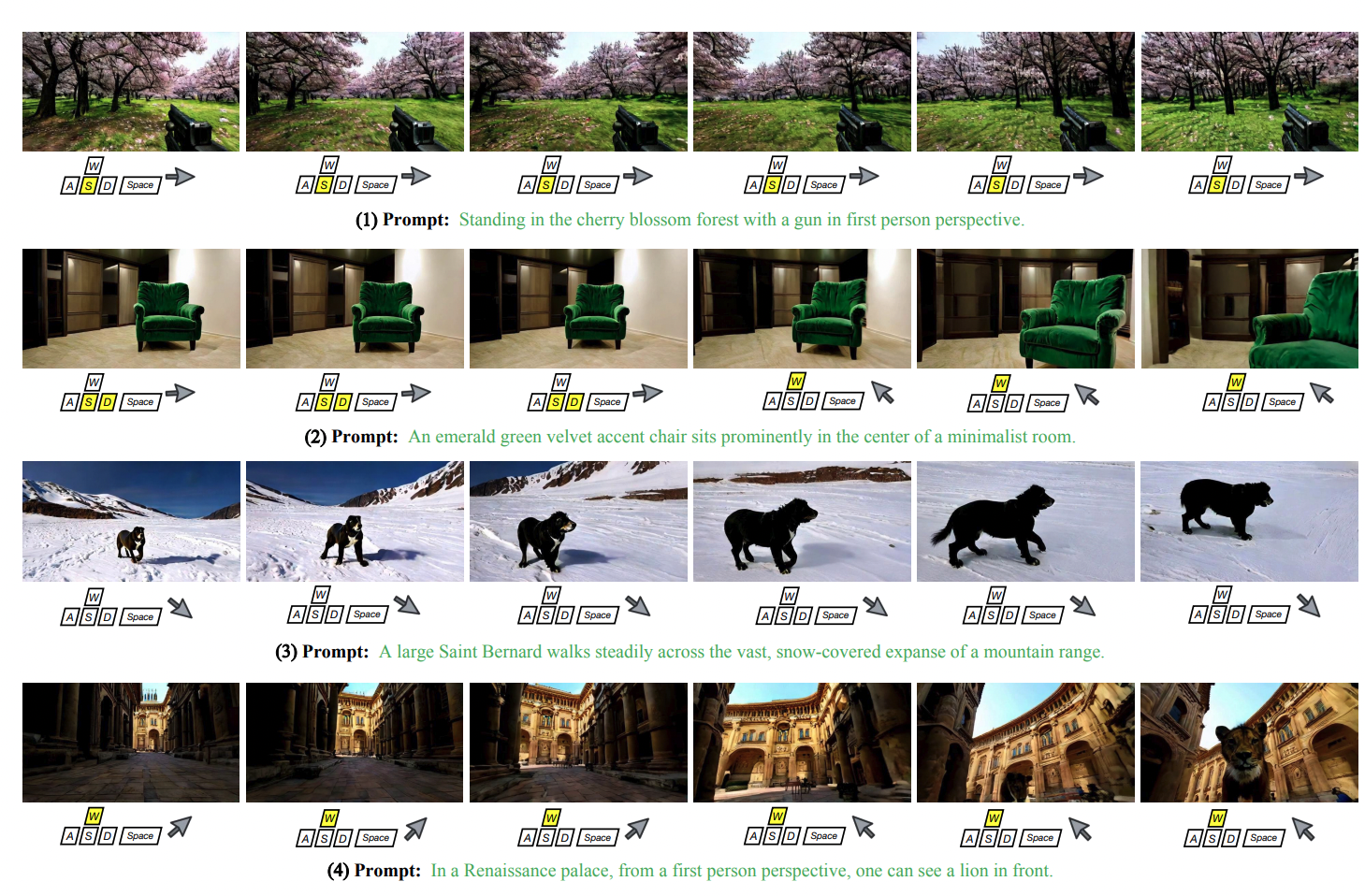

3. GameFactory: Creating New Games with Generative Interactive Videos [21]

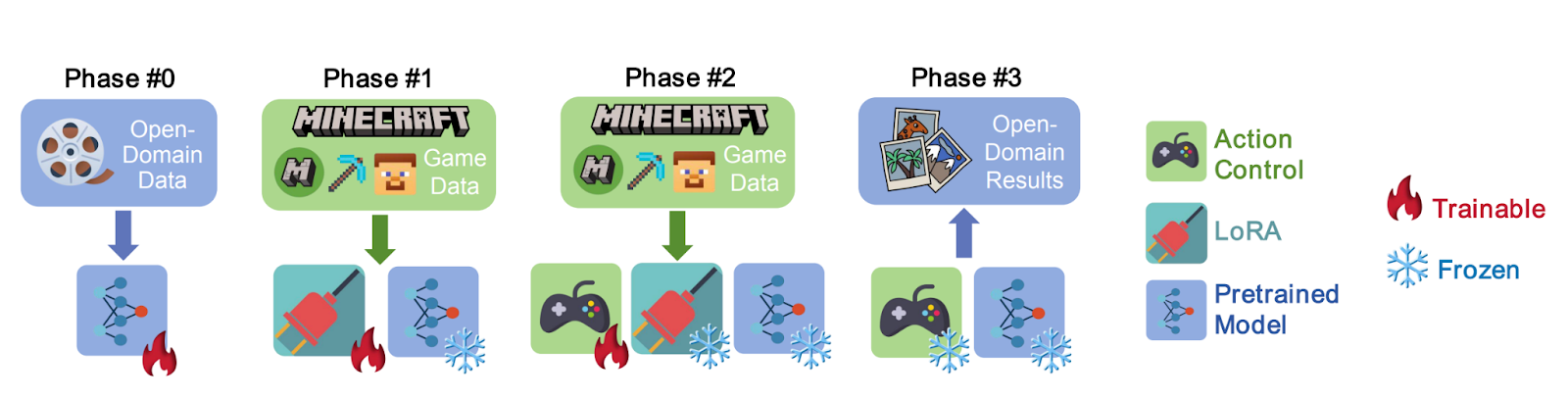

Авторы из Гонконгского университета предлагают фреймворк GameFactory для создания новых игровых сцен на основе предобученных диффузионных видеомоделей. Система использует небольшой датасет роликов с аннотациями действий (на примере Minecraft) для «привития» модели навыков реагировать [22] на клавиатуру и мышь, обеспечивая интерактивность, схожую с настоящей игрой.

Для этого авторы создали специальный датасет GF-Minecraft с разметкой действий (WASD, движения мыши).

Далее последовала стратегия обучения:

1. Обучение базовой модели на открытых данных;

2. Дообучение с помощью LoRA [23] для адаптации под игровые видео, при заморозке большинства весов модели;

3. Обучение модуля управления;

4. На этапе генерации LoRA отключается, сохраняя универсальный стиль с учетом управляемых действий.

Авторегрессивная генерация позволяет моделям генерировать видео «кусками», увеличивая длину ролика практически неограниченно.

Интересно, что собственный датасет GF-Minecraft отличается точностью фиксации действий и автоматической рандомизацией сцен, что позволяет модели реагировать даже на редкие комбинации клавиш. Разделение контроля для дискретных и непрерывных действий улучшает точность предсказаний, а модель учится базовой физике.

GameFactory демонстрирует, как сочетание открытых видеомоделей и узкоспециализированного датасета позволяет создавать генераторы новых игровых миров. Хотя задача генеративного игрового движка еще не решена полностью, данный подход открывает путь к автономному созданию игр и универсальным симуляторам для робототехники и автопилотов.

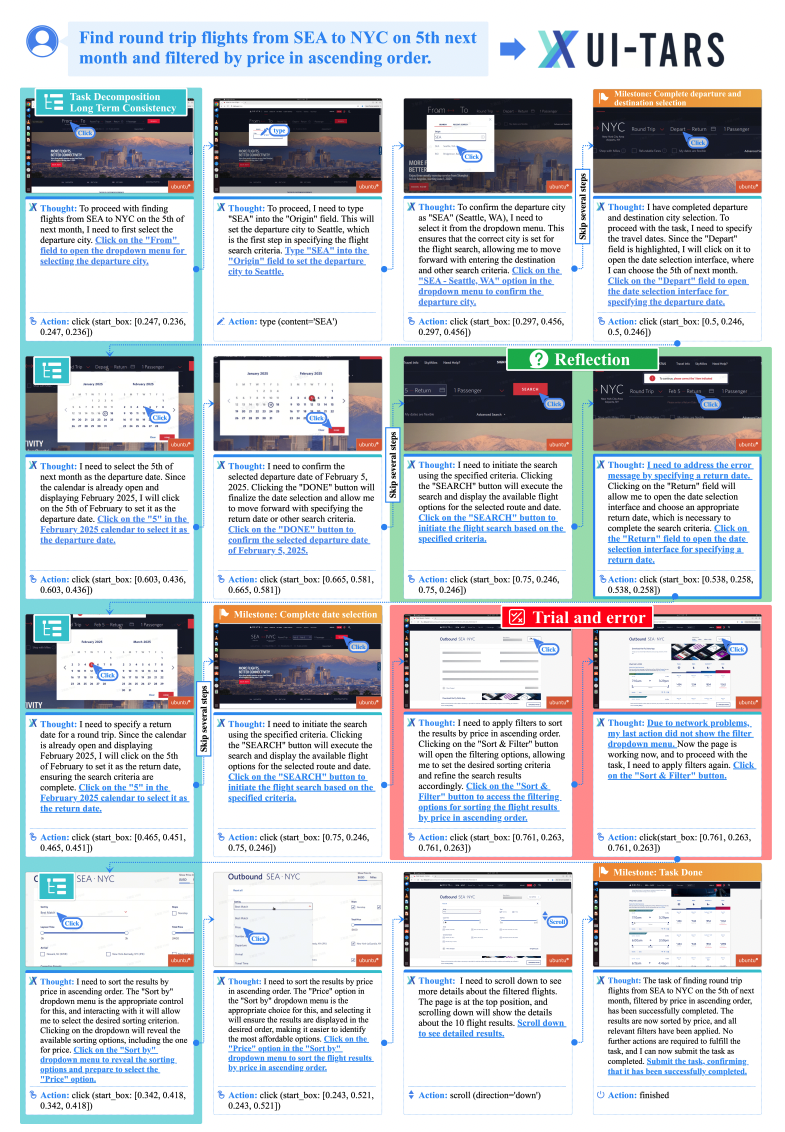

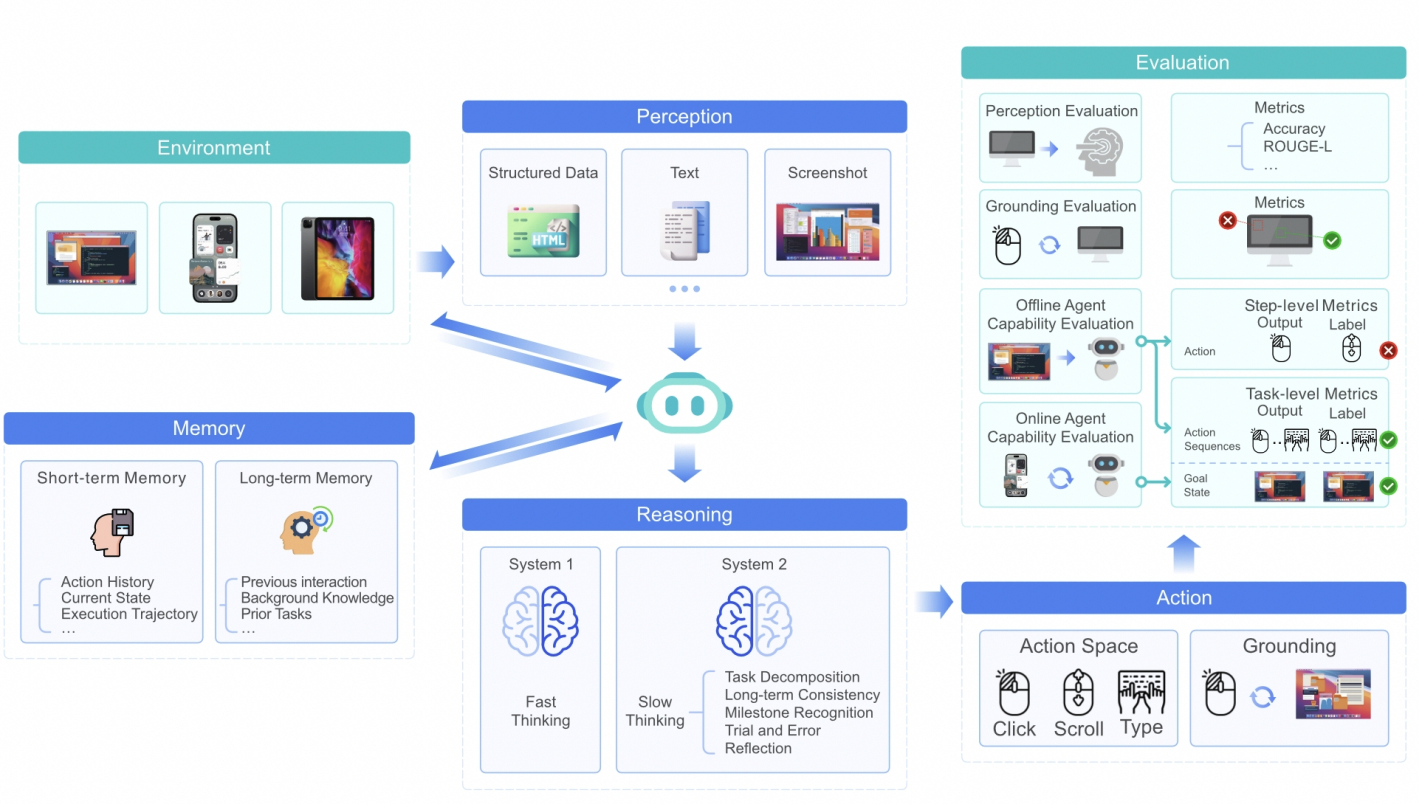

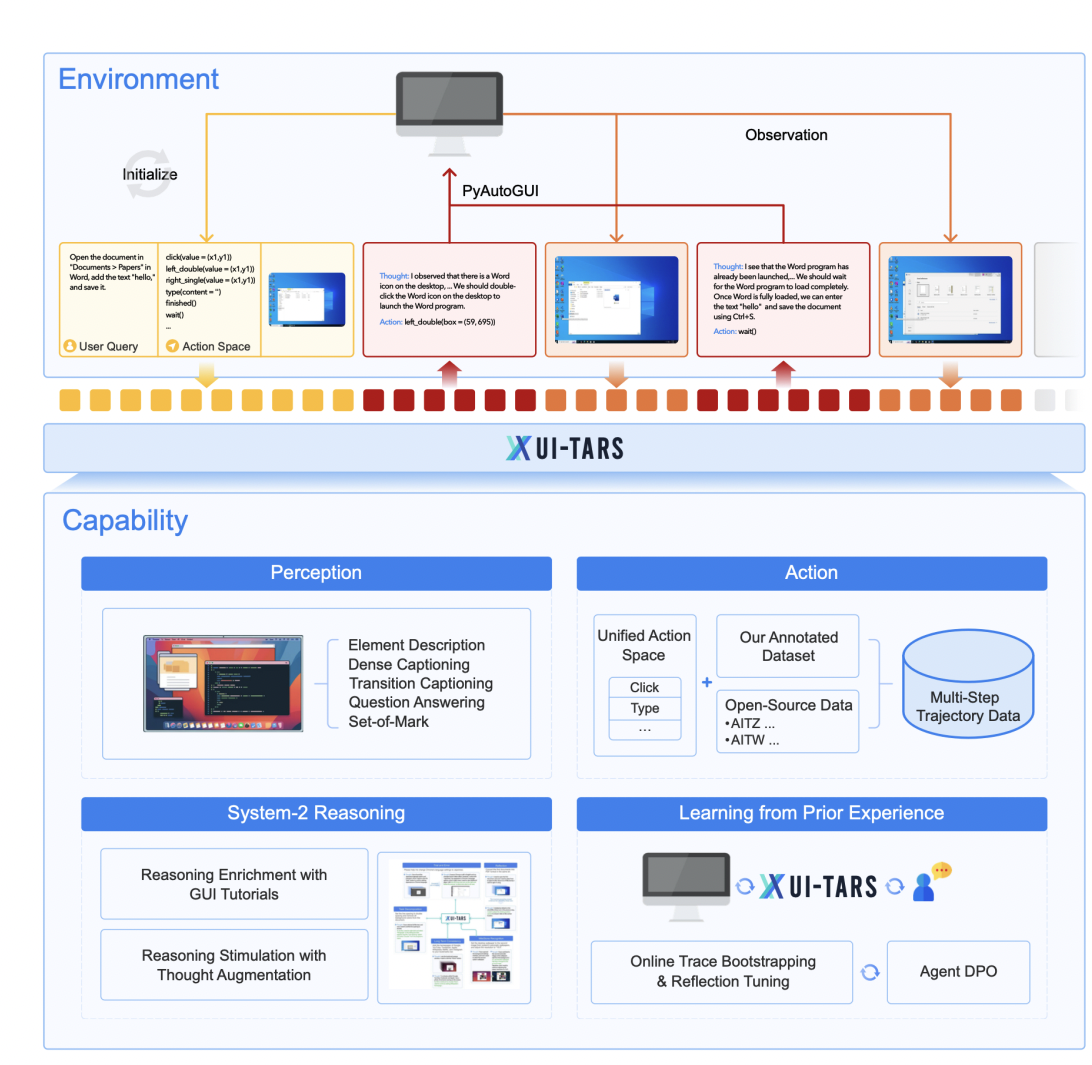

4. UI-TARS: Pioneering Automated GUI Interaction with Native Agents [24]

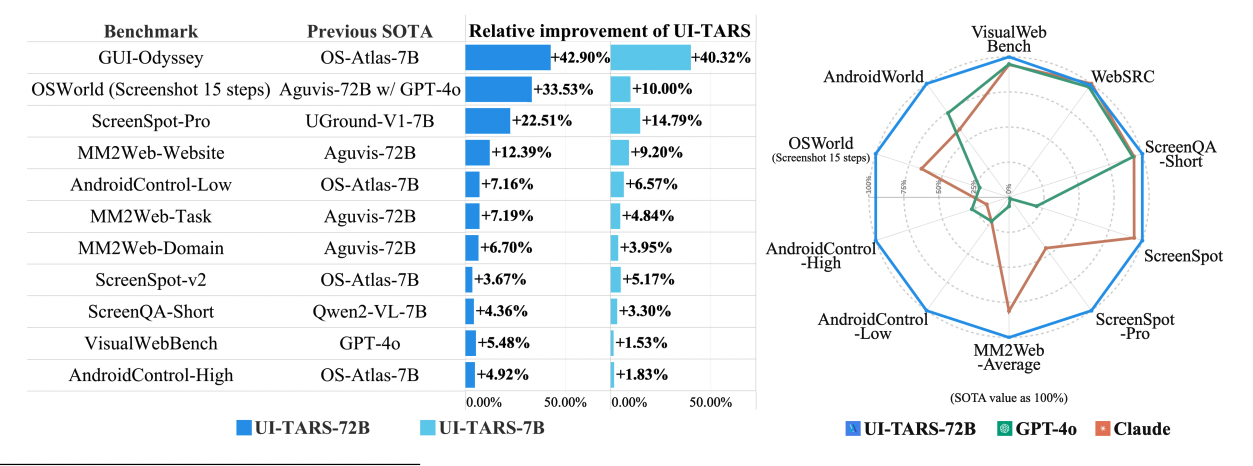

ByteDance (владелец TikTok) представили end-to-end ИИ-агента UI-TARS для автоматического взаимодействовияс графическим интерфейсом (UI), используя только скриншоты. В отличие от модульных решений, где навигация и генерация действий разделены, UI-TARS обучен на больших данных и самостоятельно выполняет задачи от визуального понимания до планирования и совершения действий (клики, ввод текста и т.д.).

Разработчики тренировали модель на огромном наборе скриншотов с метаданными (bounding-box, текст, названия элементов) и задачах по детальному описанию интерфейса. Далее унифицировали моделирование атомарных действий (Клик, печать, перетаскивание, скролл) для разных платформ.

Модель генерирует «цепочку мыслей» (chain-of-thought) перед каждым действием, разбивая задачу на этапы и корректируя ошибки [25]. В конце следует итеративное обучение с рефлексией: сбор новых действий в реальных виртуальных окружениях с последующей ручной корректировкой ошибок.

UI-TARS распознает почти все нюансы интерфейса: модель демонстрирует рекордные показатели на более чем 10 задачах (OSWorld [26], AndroidWorld [27], ScreenSpot Pro [28]), часто превосходя даже GPT-4 и Claude.

Модель от ByteDance подтверждает, что будущее GUI-агентов лежит в интегрированном подходе без громоздких модульных разделений. Модель сама учится видеть интерфейс «как человек», размышлять и совершать точные действия, что упрощает разработку и обеспечивает постоянное улучшение благодаря накоплению новых данных.

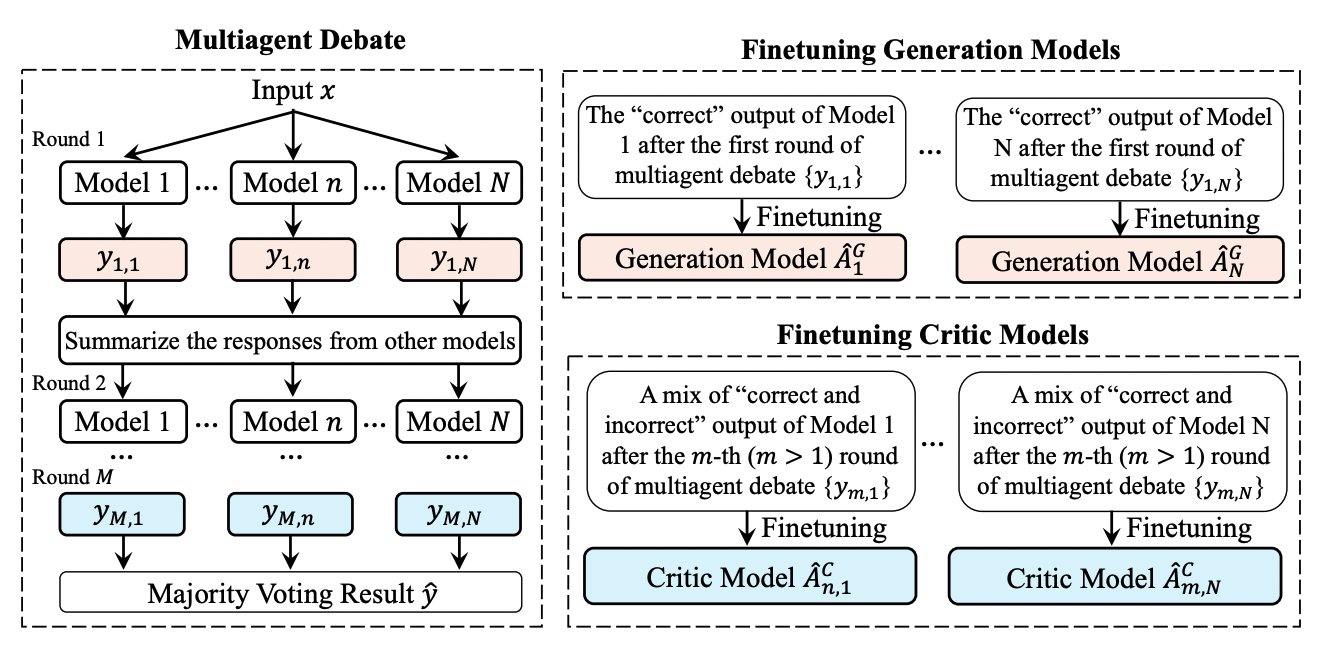

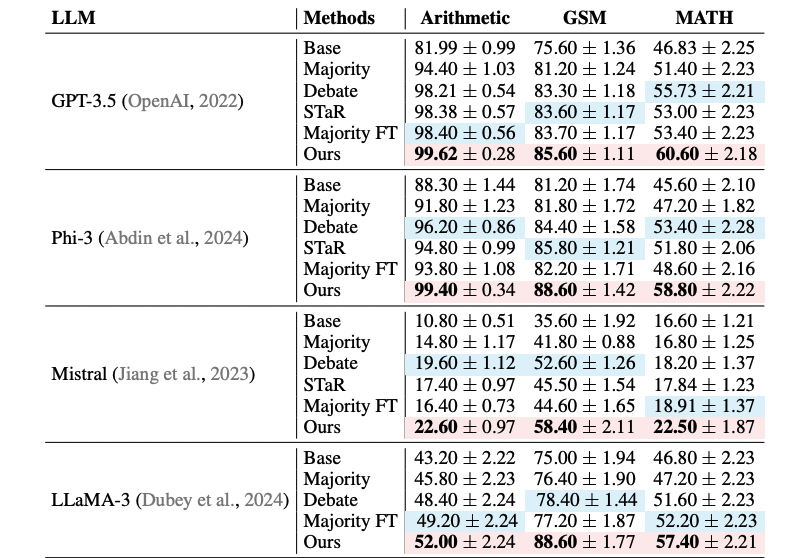

5. Multiagent Finetuning: Self Improvement with Diverse Reasoning Chains [29]

Исследователи из Гарварда, Оксфорда, MIT и Google DeepMind предложили подход мультиагентного дообучения, при котором вместо единой модели обучается сразу несколько агентов, каждый из которых специализируется на определенной задаче: генерация чернового решения, критика или улучшение ответа. Таким образом можно сохранять разнообразие логических цепочек, предотвращая однообразие и обеспечивая дальнейшее самоулучшение модели.

Исследователи использовали мультиагентные «дебаты»: несколько копий модели независимо генерируют ответы, после чего «спорят» друг с другом, финальный ответ выбирается голосованием или через работу специальныхкритиков. В результате итеративного дообучение такие «дебаты» обеспечивают устойчивый прирост точности без необходимости в ручной разметке.

Метод демонстрирует улучшение по сравнению с классическим подходом с одним агентом, где качество либо быстро достигает потолка, либо ухудшается. Мультиагентное дообучение значительно повышает качество решений на задачах, требующих пошагового рассуждения (GSM [30], MATH [31], MMLU [32]). Несмотря на высокие вычислительные затраты, метод открывает путь к более широкому применению самоулучшающихся систем.

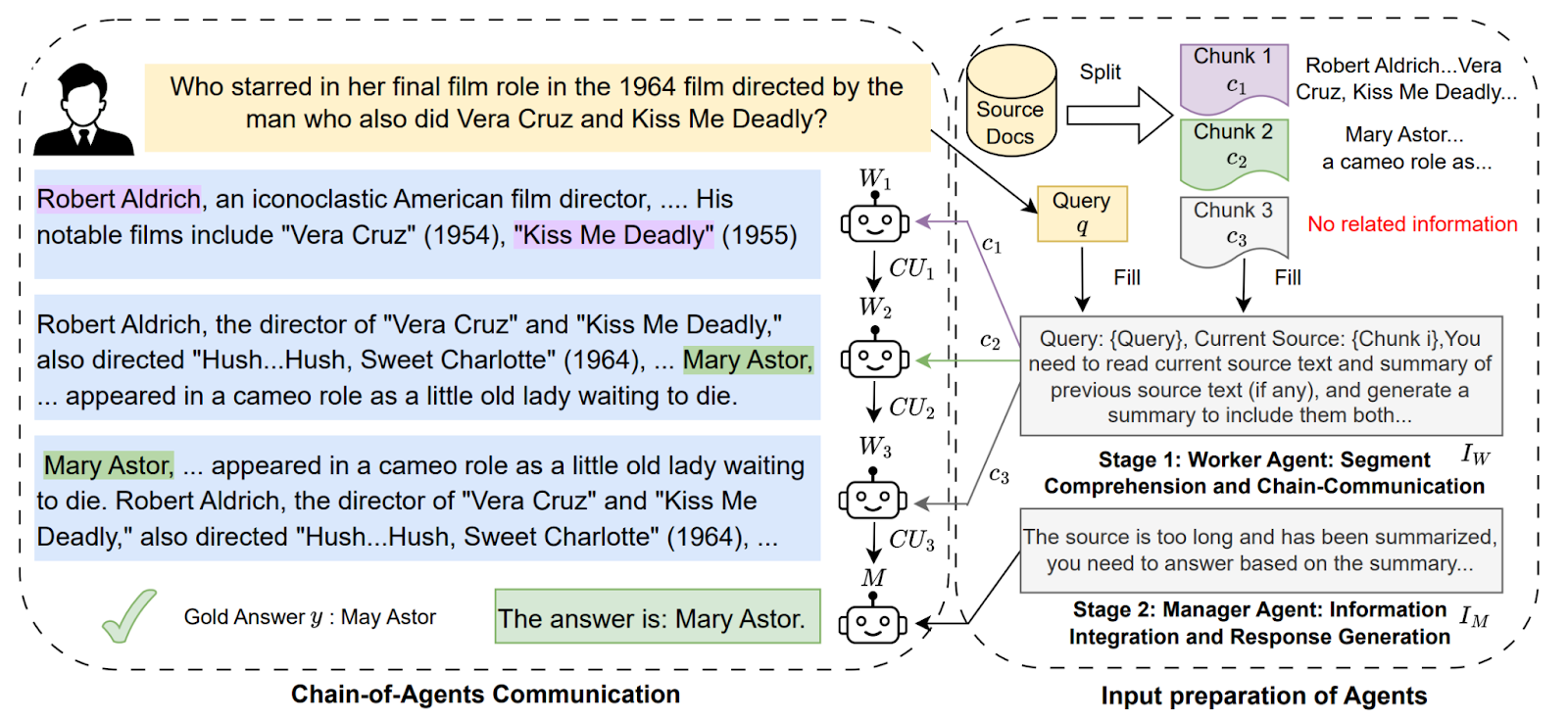

6. Chain of Agents: Large language models collaborating on long-context tasks [33]

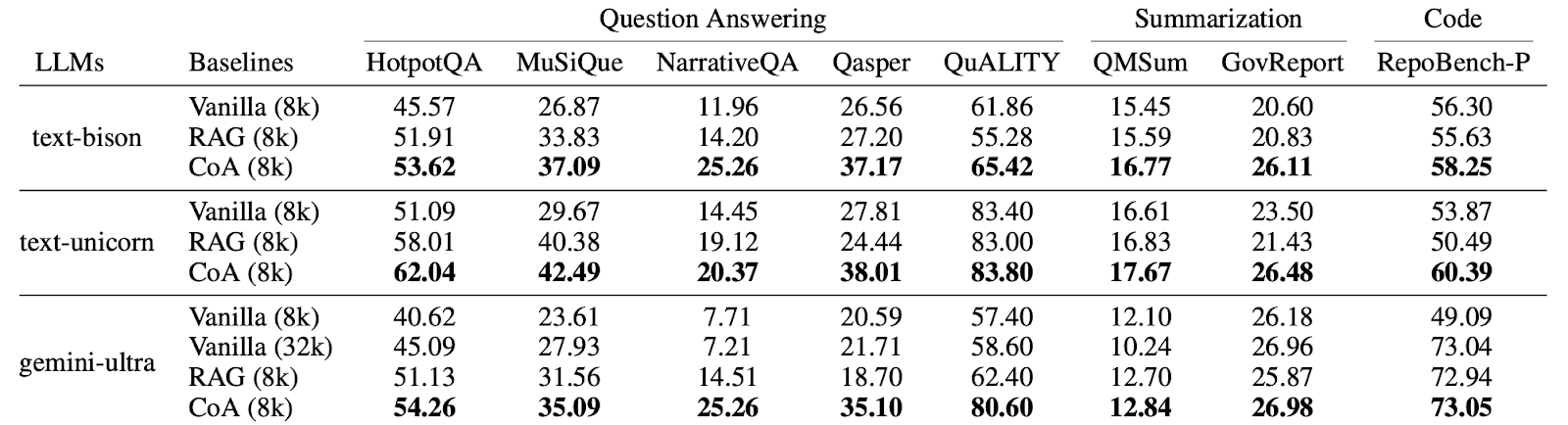

Разработчики из Google Cloud AI Research представили метод Chain-of-Agents (CoA) для эффективной обработки очень длинных текстов.

Метод основан на разделении текста на фрагменты (chunks), соответствующие лимиту контекста (например, 8k или 32k токенов). Далее каждый агент обрабатывает свой кусок с учетом резюме предыдущего, формируя новое сообщение. В итоге агент-менеджер формирует финальный ответ.

Метод CoA превосходит как стратегию подачи полного текста, так и классический RAG [34], поскольку каждый агент фокусируется только на небольшом фрагменте. Эксперименты показали улучшение результатов до +10% на задачах суммаризации и длинных вопросах-ответах (QA)

Но при последовательной передаче информации от одного агента к другому есть риск, что какие-то важные детали «потеряются». Авторы замеряли так называемый information loss, когда в промежуточных шагах модель фактически «видит» правильные данные, но из-за неточных коммуникаций итоговая генерация оказывается хуже (что-то похожее на игру в «сломанный телефон»).

Так, например, если в одном из промежуточных шагов агент внезапно выдает «пустой» или нерелевантный ответ (например, модель решила, что ответа нет), то дальше по цепочке может распространиться некорректная, «нулевая» информация. В итоге вся цепочка разваливается на бессвязные ответы, и менеджеру (финальному агенту) уже нечего объединять.

Авторы используют простое деление на фрагменты, но выбор их оптимального размера — непростая задача. Для разных текстов (например, код против длинных статей) могут понадобиться разные алгоритмы.

Существуют вопросы о том, стоит ли разбивать текст по абзацам, по смысловым блокам, по предложениям и т.п. От этого существенно зависит качество итогового ответа. Но, в целом, метод достаточно перспективный, и я уже использую его в своих проектах.

7. Towards System 2 Reasoning in LLMs: Learning How to Think With Meta Chain-of-Thought [35]

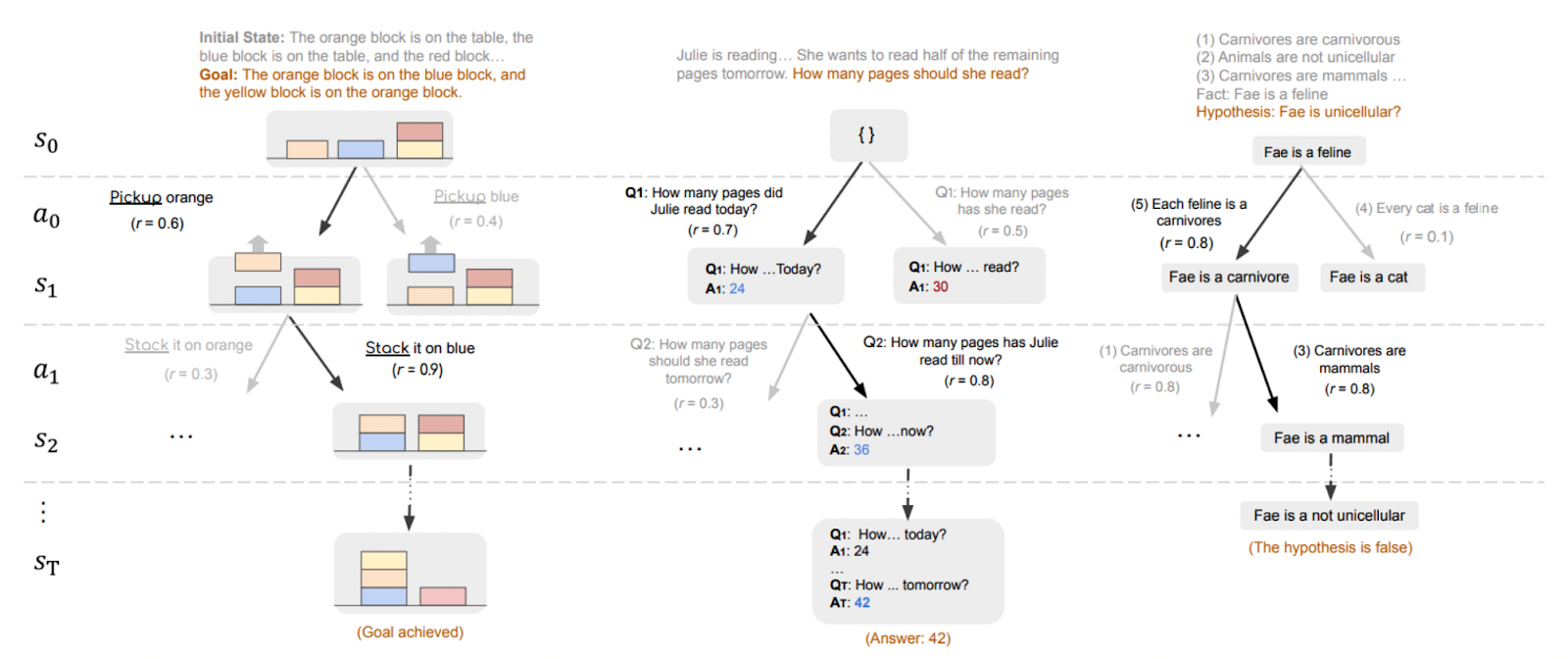

Исследователи из Стэнфорда и Беркли вводят понятие «Meta Chain-of-Thought (Meta-CoT)», где модель не только генерирует пошаговые рассуждения, но и явно отображает внутренний процесс поиска решений: перебор гипотез, откаты назад и оценку альтернатив. Такой подход приближает рассуждения модели к «Системе 2» [36] из когнитивной психологии, позволяя решать более сложные задачи.

В этом методе решение задач рассматривается как процесс поиска, аналогичный деревьям поиска в играх. В дополнение к финальной цепочке рассуждений фиксируется история перебора («meta-стадии»), включающая откаты и альтернативные ветки. Модель дообучается с помощью инструкций и усиливается методом RL с помощью Process Reward Model, что позволяет корректно использовать Meta-CoT при решении новых задач.

Отдельно обучаются верификаторы, оценивающие промежуточные шаги, и применяется мета-обучение (Meta-RL). Эксперименты на крупном наборе математических задач (Big MATH) демонстрируют, что параллельное сэмплирование и дерево поиска значительно улучшают результаты.

Meta-CoT предоставляет более человекоподобный механизм рассуждения, позволяющий решать задачи, недоступные при классическом Chain-of-Thought. Это открывает новые направления для создания систем с глубоким «системным» интеллектом, способных к самокоррекции и поиску новых эвристик.

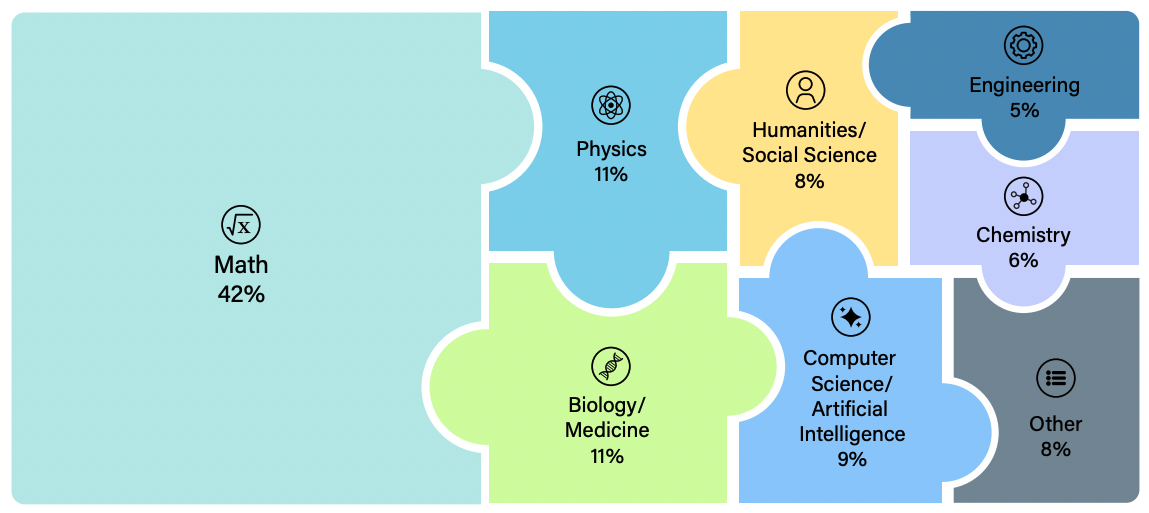

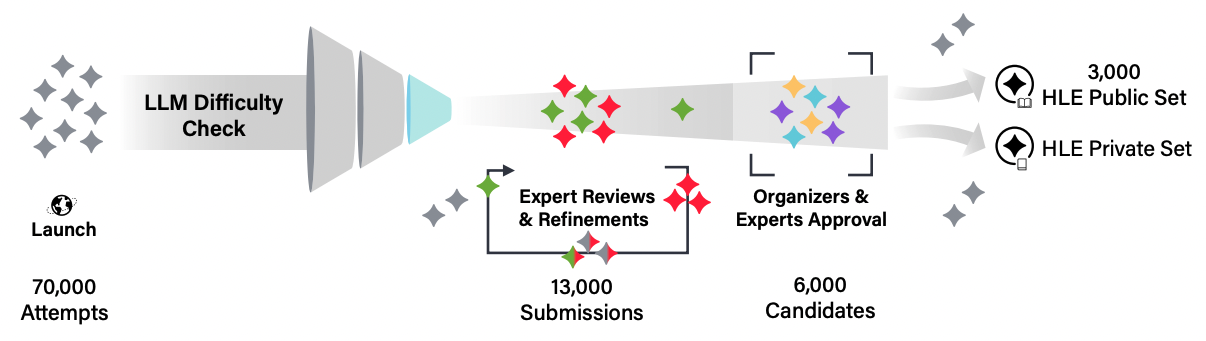

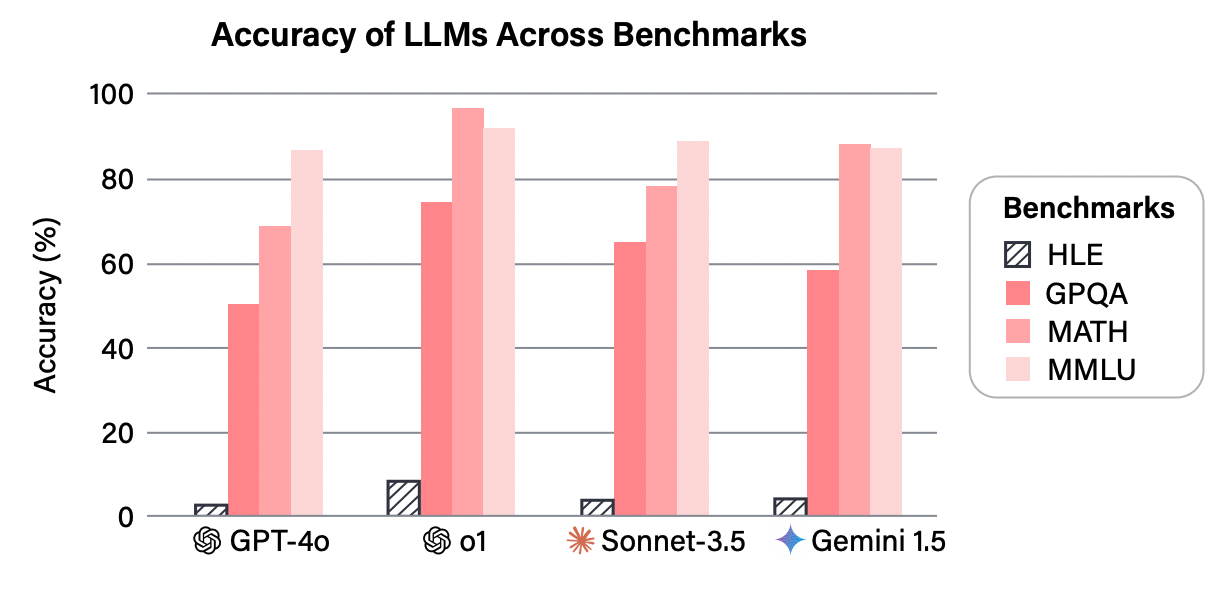

8. Humanity’s Last Exam [37]

Название исследования звучит устрашающе, но на самом деле так называется бенчмарк для оценки знаний и умений современных больших языковых моделей от исследователей из центра по ИИ-безопасности. Цель — создать комплексный набор вопросов PhD-уровня, охватывающий различные дисциплины, чтобы проверить способность моделей давать точные и верифицируемые ответы.

Исследователи собрали более 3000 вопросов от математики до археологии с участием экспертов со всего мира, отобрали через тестирование на нескольких продвинутых моделях и исключили тривиальные вопросы.

Задания представлены в форматах множественного выбора и точного соответствия, при этом около 10% вопросов мультимодальные. После автоматической проверки вопросы проходят несколько раундов ревью профильными специалистами.

HLE показывает, что даже передовые модели далеки от экспертного уровня в решении узкопрофильных и «не заученных» задач. Этот бенчмарк служит надежным маркером прогресса ИИ-систем и стимулирует дискуссии о безопасности и регулировании ИИ.

Большие языковые модели развиваются настолько быстро, что уже через несколько месяцев могут преодолеть большую часть существующих тестов. Создателям HLE важно следить, чтобы и этот бенчмарк не оказался «пройденным» слишком рано. Так Deep Research [38] от OpenAI уже достигла 26,6% в этом бенчмарке.

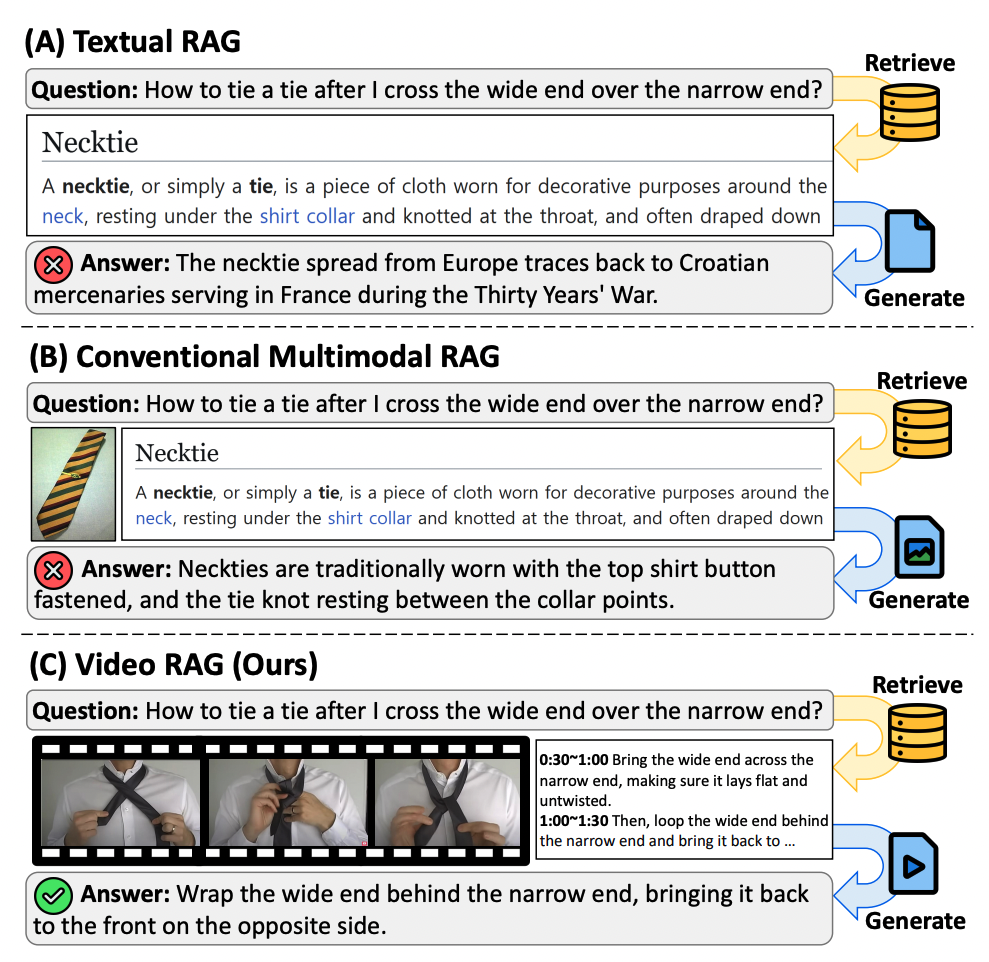

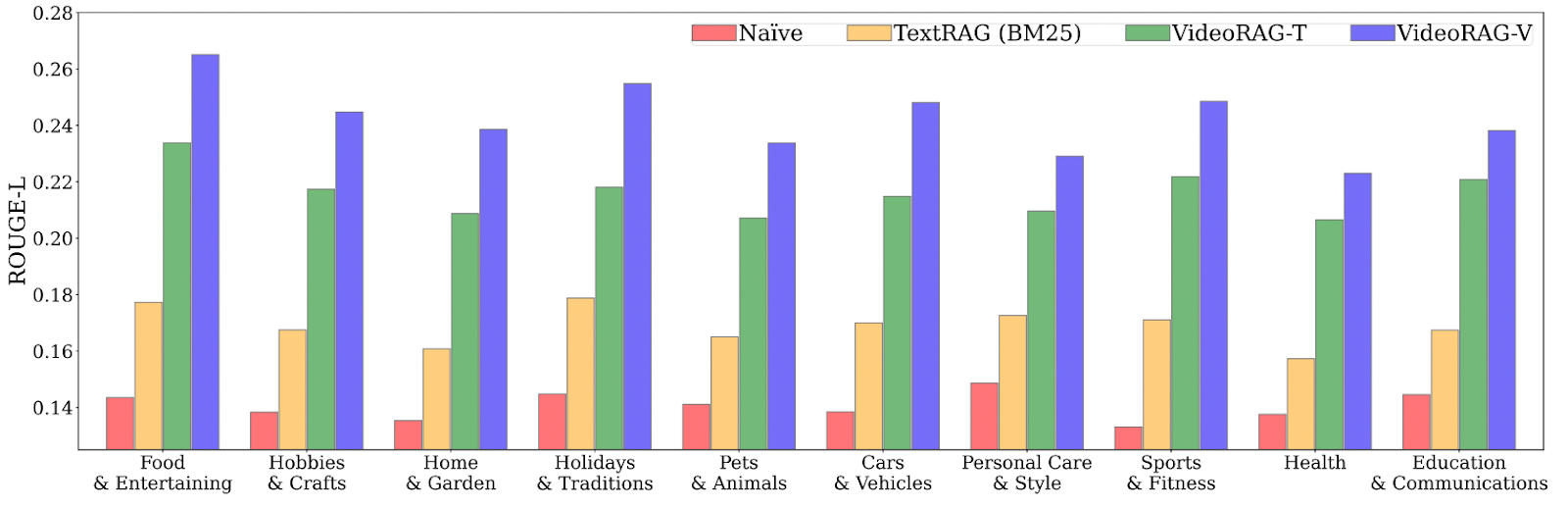

9. VideoRAG: Retrieval-Augmented Generation over Video Corpus [39]

Исследователи предлагают расширить концепцию Retrieval-Augmented Generation (RAG) на видеоконтент. Модель динамически находит релевантные видео из огромного корпуса, используя как визуальные, так и текстовые данные, и интегрирует их для генерации точных и детализированных ответов.

Исследователи использовали двухэтапную архитектуру: на этапе retrieval система ищет видео по мультимодальным эмбеддингам (кадры и транскрипты), а на этапе generation извлеченные данные объединяются с исходным запросом и подаются в Large Video Language Model (LVLM). Если субтитры отсутствуют, они автоматически генерируются с помощью ASR (например, Whisper).

В экспериментах использовались вопросы из набора WikiHowQA [40], а видеокорпус — из HowTo100M [41]. Показано, что даже только транскрипты дают преимущество по сравнению с классическим текстовым RAG, а добавление визуальной составляющей еще больше улучшает результат.

Одно из ключевых затруднений — большой объем и разнообразие видеоматериалов. Видео могут включать множество динамичных сцен, содержать шум, переходы кадров и разную скорость смены контента. Для улучшения требуется оптимизация мультимодальных эмбеддингов и индексов, а также более продуманная стратегия отбора кадров.

VideoRAG значительно повышает точность и релевантность ответов в задачах, где важны пошаговые инструкции и наглядность, по сравнению с традиционными методами работы с текстом за счет видеомодальности. Ждем RAG-системы и в других модальностях.

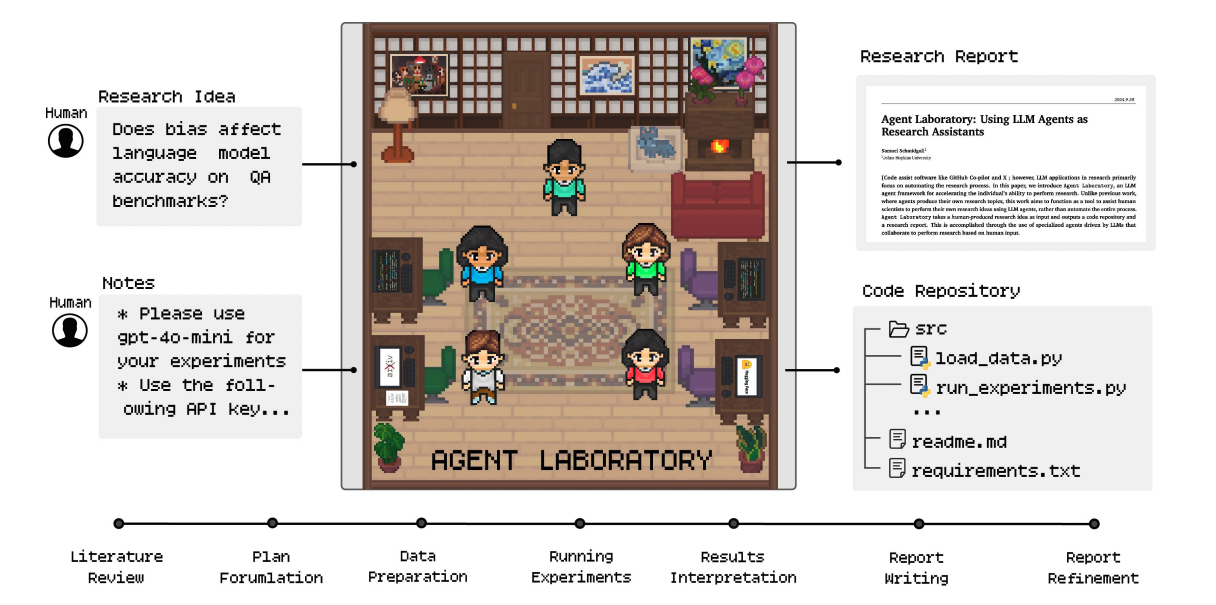

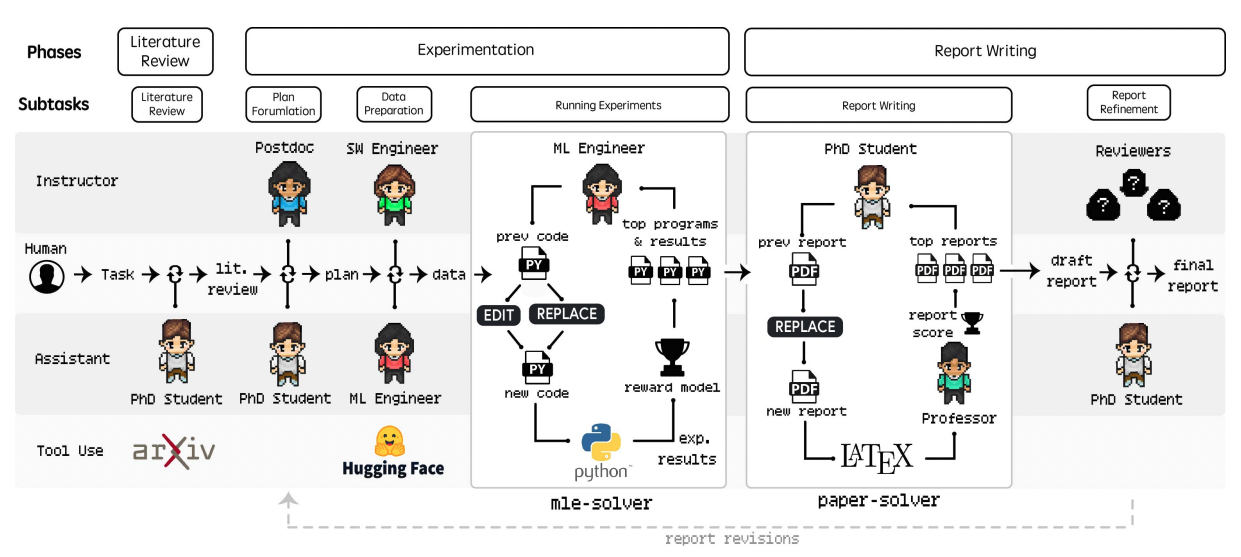

10. Agent Laboratory: Using LLM Agents as Research Assistants [42]

Исследователи из AMD и института Джона Хопкинса разработали автономную лабораторию ИИ-агентов, которая покрывает весь цикл научного исследования в области машинного обучения: от обзора литературы до проведения экспериментов и составления отчета. Система помогает экономить время, автоматизируя рутинные задачи, при этом оставляя за исследователем возможность контроля и корректировки результатов.

Система работает в три этапа:

-

Обзор литературы: агент ищет и отбирает релевантные статьи через API arXiv;

-

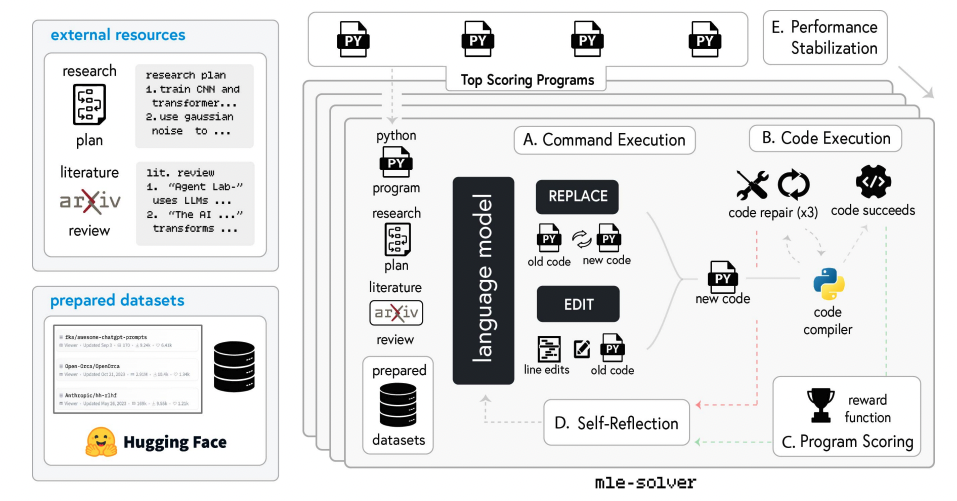

Эксперименты: формулируется план, подготавливаются данные и выполняются эксперименты с помощью модуля mle-solver, который автоматически пишет и дорабатывает код, ориентируясь на метрики.

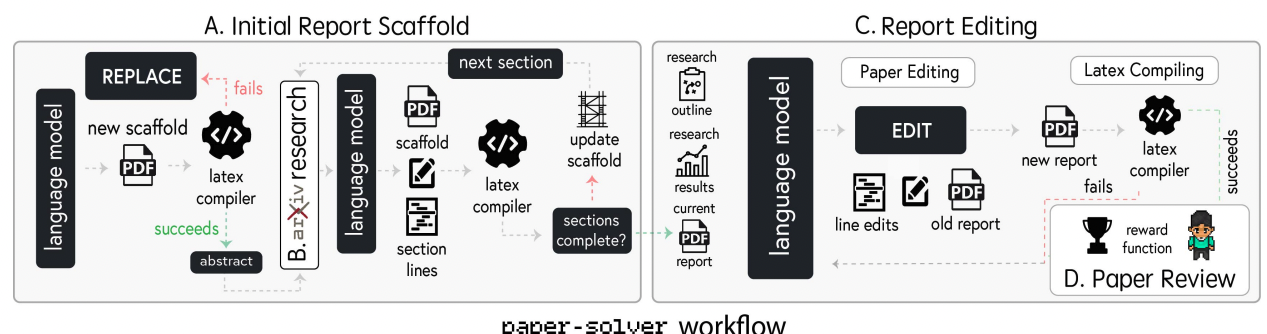

LLM-агенты проводят анализ литературы, планируют эксперименты, обрабатывают данные и интерпретируют результаты, mle-solver используется для экспериментов, а paper-solver для генерации отчетов.

Процесс в mle-solver состоит из: (A) выполнение команд для генерации кода, (B) запуск кода с исправлением ошибок, (C) оценка программы с помощью функции вознаграждения, (D) самоанализ для улучшения следующих итераций и (E) стабилизация производительности. -

Написание отчета: модуль paper-solver генерирует черновик в LaTeX, после чего проводится ревизия с участием человека.

Система может работать как автономно, так и в режиме «ко-пилота», когда человек направляет процесс.

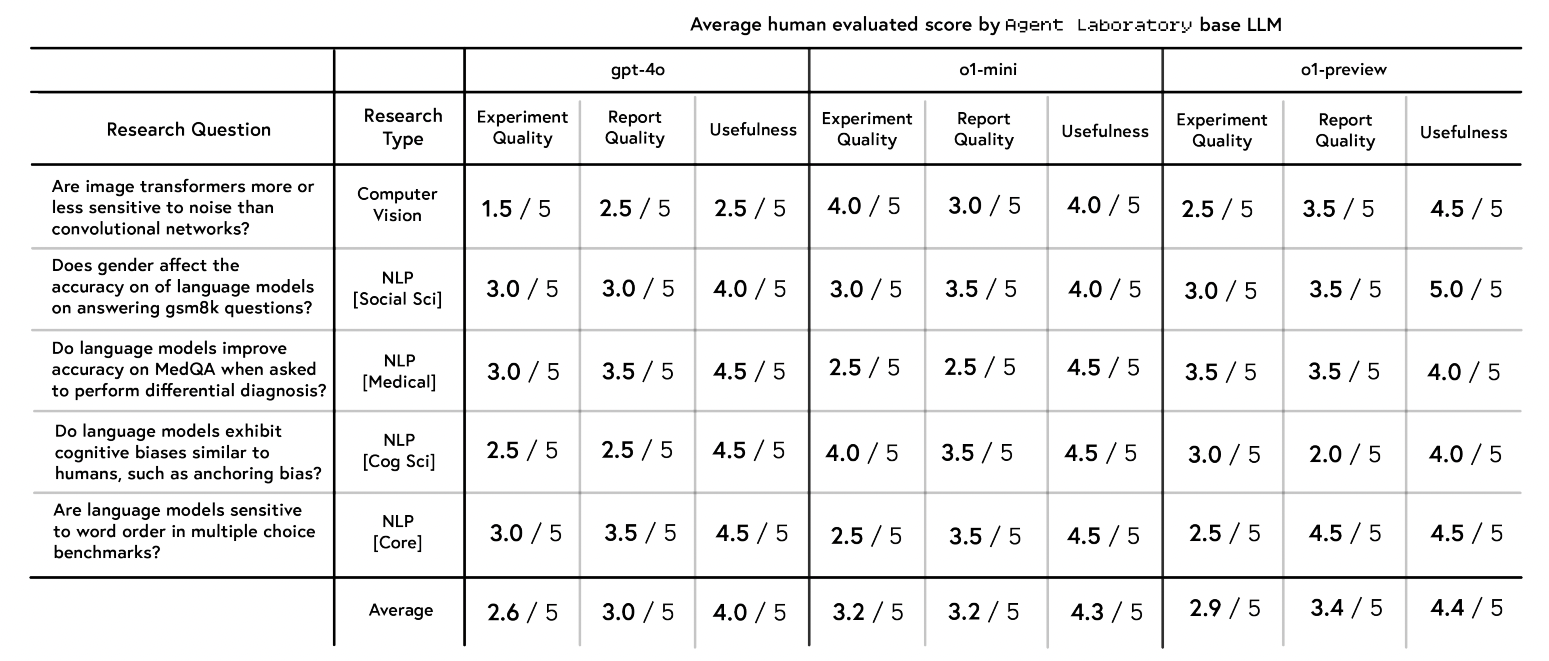

В ходе эксперимента система автономно сгенерировала 15 статей по пяти темам, используя три разных LLM (gpt-4o, o1-mini, o1-preview). Десять аспирантов оценивали каждую статью по качеству эксперимента, отчета и полезности по шкале 1–5. Результаты показали, что o1-preview признана самой полезной (4.4/5) и демонстрирует лучшее качество отчета (3.4/5), однако чуть уступает o1-mini в экспериментальной части (2.9/5).

Конечно, ИИ-агенты все еще могут галлюцинировать, что ставит под сомнение достоверность экспериментов. Но, в целом, лаборатория ИИ-агентов показывает, что LLM-агенты могут существенно ускорить научный [43] прогресс, выполняя рутинные задачи, что позволяет ученым сосредоточиться на своей работе. Приведенные в статье исследования наглядно демонстрируют, как стремительно развивается сфера ИИ. Современные методы в области ИИ позволяют создавать системы, способные не только решать сложнейшие задачи, но и эволюционировать, приближаясь к «человеческому» пониманию мира. Последние месяца обогащают теоретическую базу и открывают новые возможности для практического применения в робототехнике, внедрении ИИ в бизнес и научных исследованиях.

Вот такие интересные исследования вышли в январе. Не забудьте подписаться на мой Telegram-канал [5] и использовать Dataist AI [4], чтобы всегда быть в курсе самых свежих новостей, обзоров и инсайтов в сфере ИИ. Оставайтесь на шаг впереди в этом быстро меняющемся мире технологий!

Автор: Dataist

Источник [44]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/12072

URLs in this post:

[1] интеллекта: http://www.braintools.ru/article/7605

[2] обучения: http://www.braintools.ru/article/5125

[3] подкреплением: http://www.braintools.ru/article/5528

[4] Dataist AI: https://t.me/dataist_bot

[5] подписывайтесь на мой Telegram-канал: https://t.me/+BJIoQT7GffFlNzFi

[6] DeepSeek R1: https://arxiv.org/abs/2501.12948

[7] обучения с подкреплением (RL): https://en.wikipedia.org/wiki/Reinforcement_learning

[8] математики: http://www.braintools.ru/article/7620

[9] Supervised fine-tuning (SFT): https://medium.com/mantisnlp/supervised-fine-tuning-customizing-llms-a2c1edbf22c3

[10] логика: http://www.braintools.ru/article/7640

[11] восприятия: http://www.braintools.ru/article/7534

[12] MCTS: https://en.wikipedia.org/wiki/Monte_Carlo_tree_search

[13] Process Reward Model: https://www.envisioning.io/vocab/process-reward-model

[14] AIME: https://artofproblemsolving.com/wiki/index.php/American_Invitational_Mathematics_Examination

[15] MATH-500: http://math500.com/

[16] Codeforce: https://arxiv.org/html/2501.01257v2

[17] AlpacaEval 2.0: https://tatsu-lab.github.io/alpaca_eval/

[18] Cosmos World Foundation Model Platform for Physical AI: https://d1qx31qr3h6wln.cloudfront.net/publications/NVIDIA%20Cosmos_4.pdf

[19] визуальных языковых моделей (VLM): https://medium.com/@aydinKerem/what-are-visual-language-models-and-how-do-they-work-41fad9139d07

[20] Sim2Real-адаптация: https://dspace.mit.edu/bitstream/handle/1721.1/138850/2021-04-Sim2Real_T-ASE.pdf

[21] GameFactory: Creating New Games with Generative Interactive Videos: https://arxiv.org/pdf/2501.08325

[22] реагировать: http://www.braintools.ru/article/1549

[23] LoRA: https://www.cloudflare.com/ru-ru/learning/ai/what-is-lora/

[24] UI-TARS: Pioneering Automated GUI Interaction with Native Agents: https://arxiv.org/pdf/2501.12326

[25] ошибки: http://www.braintools.ru/article/4192

[26] OSWorld: https://os-world.github.io/

[27] AndroidWorld: https://github.com/google-research/android_world

[28] ScreenSpot Pro: https://huggingface.co/blog/Ziyang/screenspot-pro

[29] Multiagent Finetuning: Self Improvement with Diverse Reasoning Chains: https://arxiv.org/pdf/2501.05707

[30] GSM: https://arxiv.org/abs/2402.19255

[31] MATH: https://paperswithcode.com/sota/math-word-problem-solving-on-math

[32] MMLU: https://paperswithcode.com/dataset/mmlu

[33] Chain of Agents: Large language models collaborating on long-context tasks: https://openreview.net/pdf?id=LuCLf4BJsr

[34] RAG: https://blogs.nvidia.com/blog/what-is-retrieval-augmented-generation/

[35] Towards System 2 Reasoning in LLMs: Learning How to Think With Meta Chain-of-Thought: https://arxiv.org/pdf/2501.04682

[36] «Системе 2»: https://en.wikipedia.org/wiki/Thinking,_Fast_and_Slow

[37] Humanity’s Last Exam: https://static.scale.com/uploads/654197dc94d34f66c0f5184e/Publication%20Ready%20Humanity%27s%20Last%20Exam.pdf

[38] Deep Research: https://openai.com/index/introducing-deep-research/

[39] VideoRAG: Retrieval-Augmented Generation over Video Corpus: https://arxiv.org/pdf/2501.05874

[40] WikiHowQA: https://paperswithcode.com/dataset/wikihowqa

[41] HowTo100M: https://arxiv.org/abs/1906.03327

[42] Agent Laboratory: Using LLM Agents as Research Assistants: https://arxiv.org/pdf/2501.04227

[43] научный: http://www.braintools.ru/article/7634

[44] Источник: https://habr.com/ru/articles/881208/?utm_source=habrahabr&utm_medium=rss&utm_campaign=881208

Нажмите здесь для печати.