Вышел Mercury Coder: первая модель на принципиально новой архитектуре dLLM, в 10 раз быстрее LLM

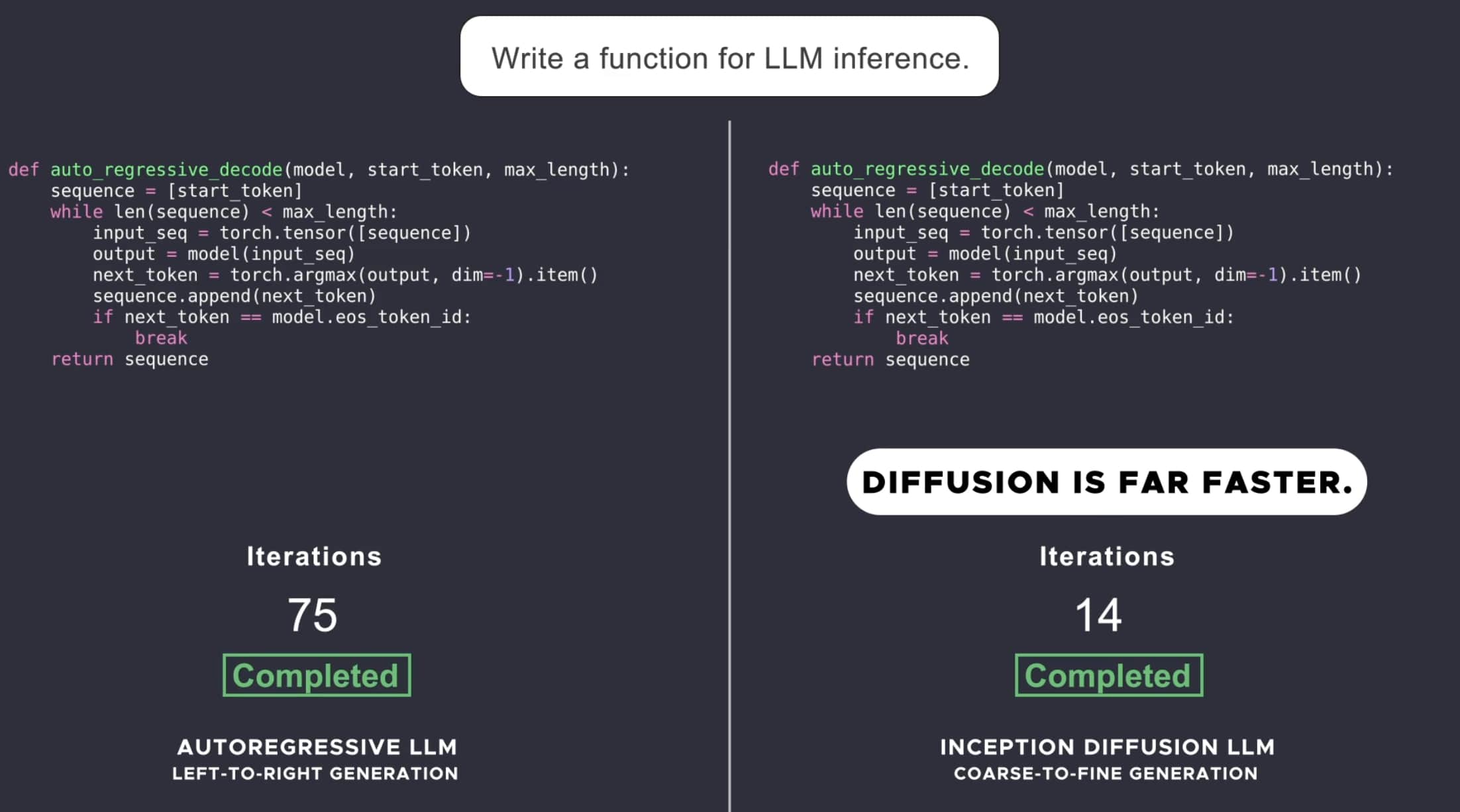

Текущие большие языковые модели (LLM) являются авторегрессивными, то есть генерируют текст слева направо, по одному токену за раз. Этот процесс по своей природе последовательный — новый токен не может быть сгенерирован, пока не сформирован весь предшествующий текст (потому что он поступает в виде контекста на вход нейросети для генерации следующего токена), а генерация каждого токена требует вычислений в модели с миллиардами параметров.

Компании, работающие над передовыми LLM, делают ставку на дополнительную генерации в процессе подготовки ответа для улучшения логических рассуждений (reasoning) и исправления ошибок, но генерация длинных цепочек рассуждений приводит к резкому росту затрат на вычисления и огромной задержке (минуты).

Чтобы сделать высококачественные AI-решения по-настоящему доступными, необходима смена парадигмы.

Что за dLLM?

Диффузионные модели обеспечивают такую смену. Они работают по принципу “от грубого к детальному”, где результат постепенно улучшается из чистого шума за несколько шагов “разшумления”, как показано в видео выше.

Поскольку диффузионные модели не ограничены учётом только предыдущего вывода, они лучше справляются с логическими рассуждениями и структурированием ответов. А благодаря способности к итеративному улучшению результатов, они могут исправлять ошибки [1] и галлюцинации. По этим причинам диффузия лежит в основе ведущих AI-решений для генерации видео, изображений и аудио, таких как Sora, Midjourney и Riffusion. Однако до сих пор применение диффузионных моделей к дискретным данным, таким как текст и код, оставалось неуспешным. До сегодняшнего дня.

Mercury Coder – первая публично-доступная dLLM

Сегодня был представлен Mercury Coder — первая публично доступная диффузионная языковая модель (dLLM), которая значительно расширяет возможности искусственного интеллекта [2]. Она работает в 5–10 раз быстрее по сравнению с текущим поколением LLM, обеспечивая высококачественные ответы при низких затратах. Разработка основана на передовых исследованиях основателей проекта, которые стояли у истоков диффузионных моделей для изображений и соавторствовали в ключевых методах генеративного ИИ, таких как Direct Preference Optimization, Flash Attention и Decision Transformers.

В отличие от авторегрессивных моделей, dLLM генерирует ответы не по одному токену, а сразу крупными блоками, последовательно уточняя их. Это позволяет значительно ускорить процесс генерации, сохраняя высокую точность. В основе Mercury Coder лежит Transformer-модель, обученная на огромных объемах данных и способная модифицировать несколько токенов одновременно, что повышает общее качество ответов.

dLLM полностью совместима с традиционными LLM-сценариями, включая RAG, работу с инструментами и агентские системы.

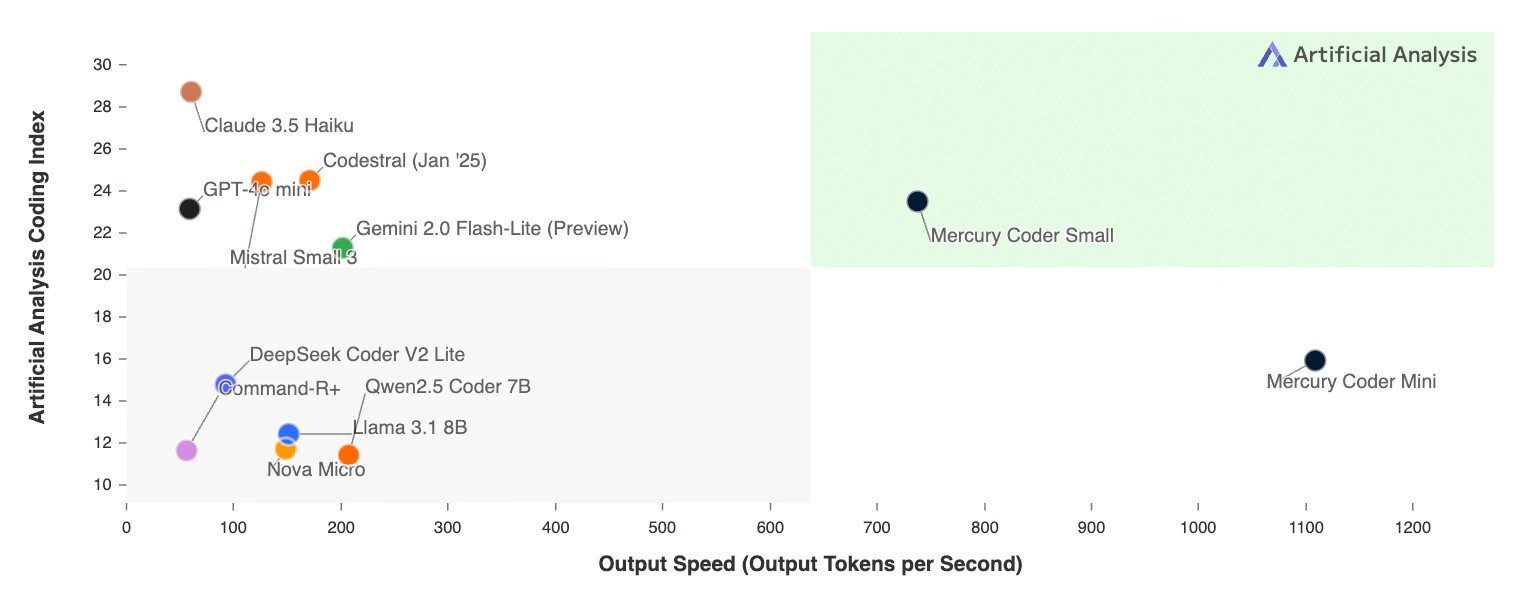

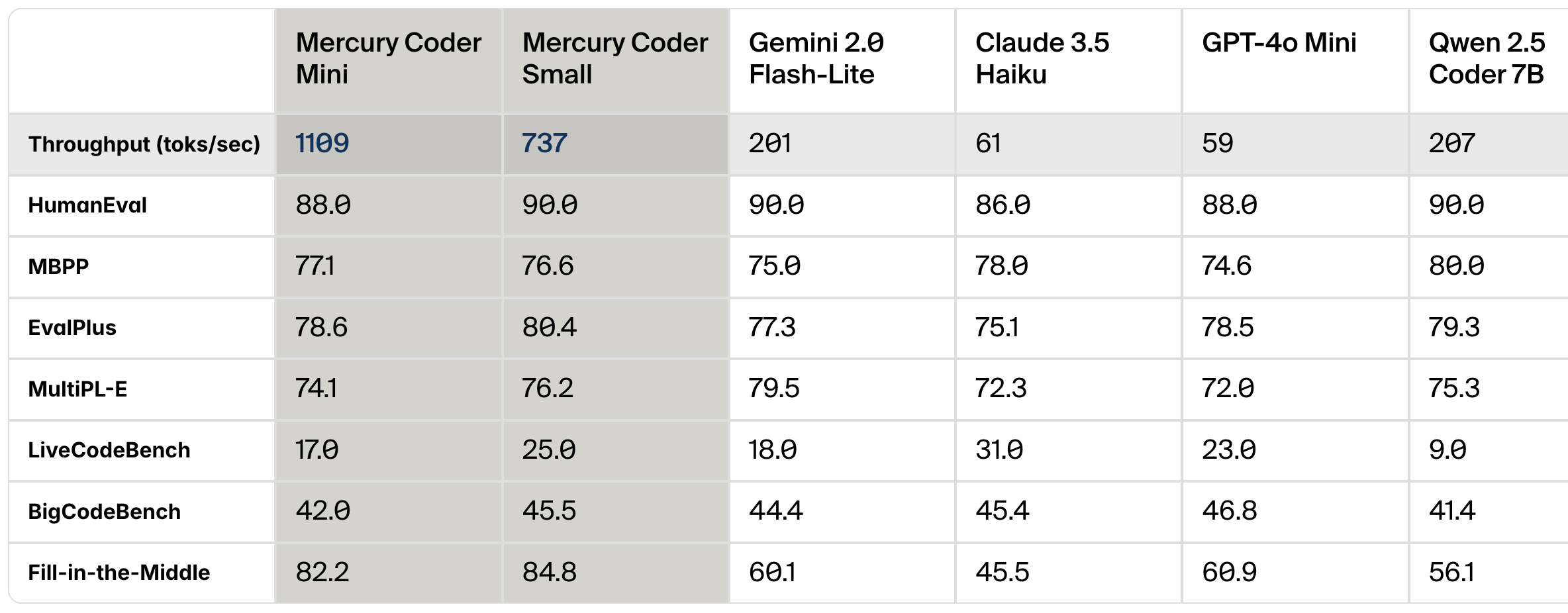

Mercury Coder специально оптимизирован для генерации кода. При тестировании на стандартных бенчмарках он продемонстрировал высокое качество решений, часто превосходя оптимизированные по скорости авторегрессивные модели, такие как GPT-4o Mini и Claude 3.5 Haiku, при этом работая до 10 раз быстрее.

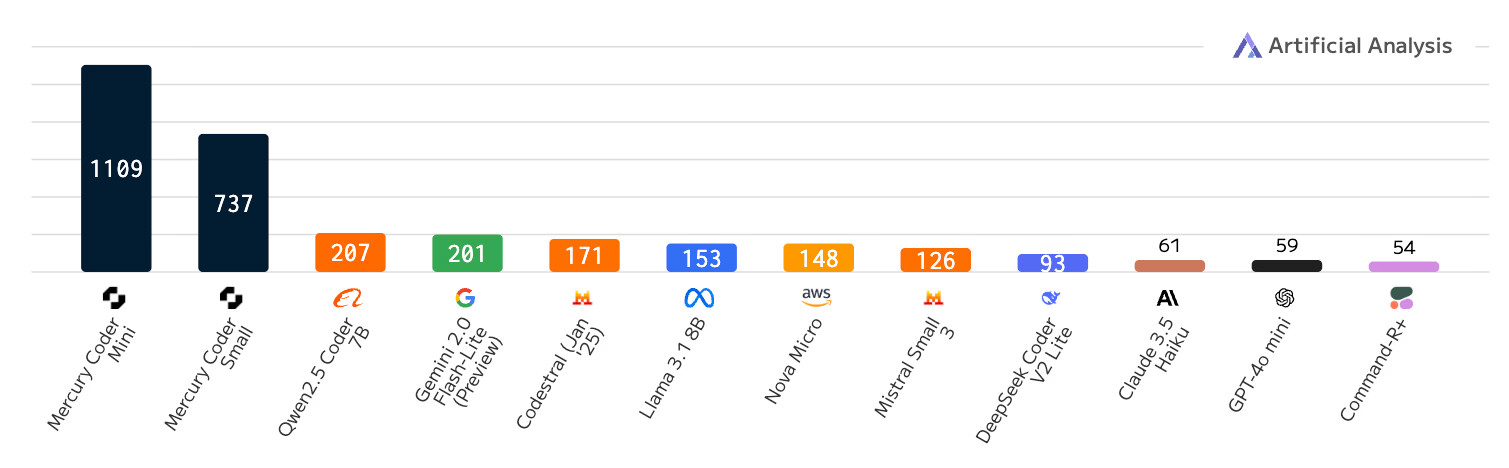

Отличительной особенностью dLLM является скорость. В то время как даже оптимизированные авторегрессивные модели работают максимум со скоростью 200 токенов в секунду, Mercury Coder на стандартных NVIDIA H100 обрабатывает более 1000 токенов в секунду – прирост в 5 раз. По сравнению с некоторыми передовыми моделями, способными выдавать менее 50 токенов в секунду, ускорение достигает более 20-кратного прироста.

Ранее такую пропускную способность LLM могли получить только на специализированном оборудовании, например, Groq, Cerebras [3] и SambaNova. Алгоритмические улучшения независимы от аппаратного ускорения, и на более быстрых чипах эффективность будет ещё выше.

Кроме того, разработчики отдают предпочтение автодополнению кода Mercury по сравнению с существующими моделями. На Copilot Arena Mercury Coder Mini занимает второе место, превосходя по качеству оптимизированные по скорости модели, такие как GPT-4o Mini и Gemini-1.5-Flash, а также более крупные модели вроде GPT-4o, при этом оставаясь самой быстрой – примерно в 4 раза быстрее GPT-4o Mini.

Что это значит для AI-приложений?

В приложениях с жесткими требованиями к задержке компании ранее были вынуждены использовать меньшие и менее мощные модели, чтобы уложиться в ограничения по скорости. Благодаря высокой производительности dLLM, теперь они могут применять более мощные модели, сохраняя исходные требования по скорости и стоимости.

Inception Labs предоставляют доступ к моделям через API, а также поддерживают on-premise развертывание. Новые модели полностью совместимы с существующим оборудованием, датасетами и пайплайнами тонкой настройки (SFT) и RLHF-алайнмента. Поддержка fine-tuning доступна для обоих вариантов развертывания.

Какие следующие планы?

Mercury Coder — это лишь первая модель в серии будущих dLLM от Inception Labs. В настоящее время модель, разработанная для чат-приложений, проходит закрытое бета-тестирование.

Диффузионные языковые модели откроют новые возможности:

-

Улучшенные агентские системы — высокая скорость и эффективность делают их идеальными для автоматизированных приложений, требующих сложного планирования и генерации длинных ответов.

-

Продвинутое логическое мышление [4] — dLLM используют коррекцию ошибок, устраняя галлюцинации и улучшая ответы, при этом генерируя их за секунды, в отличие от авторегрессивных моделей, которым требуются минуты.

-

Контролируемую генерацию — dLLM могут редактировать свой вывод, генерировать токены в любом порядке, что позволяет вставлять текст, адаптировать ответы под безопасность или точно соответствовать заданному формату.

-

Работу на Edge-устройствах — благодаря высокой эффективности, dLLM отлично подходят для ресурсоограниченных сред, таких как смартфоны и ноутбуки.

Заключение

Потестить можно тут [5]. А ещё в твиттере идёт активное обсуждение этой модели, отписались даже Андрей Карпаты и Andrew Ng, почитать полный обзор можно здесь [6].

P.S. В своём телеграм-канале [7] я как раз заставляю ИИ писать мне код (и видимо теперь потестирую для этого Mercury), обозреваю свежие новости технологий, а ещё публикую эти самые новости раньше всех. Регулярно даю глубокую аналитику по отрасли и всем событиям, и рассказываю как создавать собственных ИИ-агентов и приложения с ИИ. И много других интересных непотребств. Велком!

Автор: ElKornacio

Источник [8]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/12639

URLs in this post:

[1] ошибки: http://www.braintools.ru/article/4192

[2] интеллекта: http://www.braintools.ru/article/7605

[3] Cerebras: https://t.me/elkornacio/141

[4] мышление: http://www.braintools.ru/thinking

[5] можно тут: https://chat.inceptionlabs.ai/

[6] почитать полный обзор можно здесь: https://x.com/i/trending/1895098390628737175

[7] своём телеграм-канале: https://t.me/+8kN8W_ygPZ00ODQy

[8] Источник: https://habr.com/ru/news/886432/?utm_source=habrahabr&utm_medium=rss&utm_campaign=886432

Нажмите здесь для печати.