Тестируем новые модели o3 и o4-mini от OpenAI

Привет! На связи Кирилл Филипенко, сисадмин в Selectel [1]. Недавно OpenAI анонсировала два новых поколения моделей — o3 и o4-mini, которые стали частью линейки o-series. В статье разбираемся, за счет чего они получились мощнее, насколько дешевле обойдется их использование и какие кейсы стоит обязательно протестировать уже сегодня. В OpenAI уверены, что эти образцы задают новую планку того, каким должен быть AI-ассистент. Так ли это? Проверим под катом.

Используете Terraform? Помогите нам сделать новый сервис лучше. Пройдите [2] короткий опрос — мы выберем самые интересные кейсы и пригласим вас на онлайн-интервью. За участие — плюшевый Тирекс или бонусы на услуги Selectel.

Используете Terraform? Помогите нам сделать новый сервис лучше. Пройдите [2] короткий опрос — мы выберем самые интересные кейсы и пригласим вас на онлайн-интервью. За участие — плюшевый Тирекс или бонусы на услуги Selectel.

Используйте навигацию, если не хотите читать текст целиком:

→ Стоимость и доступность [3]

→ Скорость и производительность [3]

→ Возможности моделей [3]

→ Как дела обстоят на самом деле [3]

→ Выводы [3]

По заявлению компании, это «самые умные и мощные LLM на сегодняшний день, ознаменовавшие качественный скачок в возможностях ChatGPT». Новые модели относятся к классу reasoning (рассуждающих) и способны «думать» перед формированием ответа. Благодаря этому существенно улучшается глубина и качество решений сложных задач.

Впервые модели OpenAI могут самостоятельно использовать весь набор инструментов, доступных в ChatGPT — от веб-поиска и анализа загруженных файлов через Python до глубокого понимания визуальной информации и даже генерации изображений. Более того, o3 и o4-mini научены решать, когда и как применять имеющиеся компоненты, чтобы менее чем за минуту выдавать развернутые и продуманные ответы в нужном формате.

Такие возможности приближают ChatGPT к более автономному помощнику, который может выполнять за пользователя сложные поручения. В совокупности передовые способности к рассуждению и полный доступ к инструментам дают существенный прирост результатов и на академических бенчмарках, и в практических задачах.

Стоимость и доступность

Новые o3 и o4-mini доступны как через интерфейс ChatGPT (платная подписка), так и с помощью API для разработчиков (оплата за токены).

Тариф для o3 составляет $10,00 за 1M input-токенов и $40,00 за 1M output-токенов. Предусмотрена возможность кеширования input-токенов за четверть цены. Повторное использование 1M токенов обойдется в $2,50.

Модель o4-mini заметно дешевле: $1,10 за 1M входных токенов и $4,40 за 1M выходных. Кеширование — $0,275 за 1M. OpenAI также предлагает Batch API для асинхронного выполнения заданий в течение 24 часов со скидкой на токены примерно 50%.

Для пользователей ChatGPT новые модели стали доступны сразу после анонса. Подписчики пакетов Plus, Pro и Team теперь видят o3, o4-mini, а также o4-mini-high — режим, в котором для модели выделяется больше вычислительных мощностей. Раньше в списке были o1, o3-mini и o3-mini-high. Корпоративные клиенты и образовательные аккаунты получат доступ через неделю после релиза.

Возможности o4-mini можно опробовать бесплатно, выбрав режим Think в интерфейсе перед отправкой запроса. При этом действуют стандартные ограничения по скорости и объему, аналогичные предыдущим моделям (хотя благодаря оптимизации o4-mini может обрабатывать больше запросов в единицу времени). Для доступа к API-версиям новых моделей некоторым разработчикам требуется пройти верификацию организации. Это мера безопасности, введенная OpenAI.

В дополнение к основному Chat Completions API OpenAI представила новый Responses API — специально для reasoning-моделей. Для улучшения качества он поддерживает, например, сохранение и выдачу как промежуточных «размышлений» модели, а также части токенов рассуждения вокруг вызовов функций. Скоро можно будет «из коробки» задействовать веб-поиск, файловый поиск и интерпретатор кода прямо в процессе вывода ответа.

Скорость и производительность

Новую o4-mini создавали с упором на скорость и эффективность. Это «меньшая» модель, оптимизированная для быстрого и экономичного рассуждения. Благодаря этому o4-mini подходит для задач с большим количеством запросов и строгими требованиями по времени отклика: модель поддерживает заметно более высокие лимиты использования по сравнению с o3. Фактически o4-mini — отличный выбор для сценариев массовых запросов, где важны одновременно и высокая пропускная способность, и низкая стоимость обработки.

Модель o3, несмотря на свою мощность, жертвует скоростью. Однако при той же задержке и затратах, что и у o1, o3 показывает значительно лучший результат и выдает более качественные решения за счет продвинутого «мышления». Уровень ответа o3 продолжает улучшаться, если давать ей больше времени на «обдумывание». Даже сложные запросы o3 и o4-mini обрабатывают менее чем за минуту, что является хорошим показателем, принимая во внимание [4] объем внутренних процессов.

Отдельно стоит упомянуть контекстное окно этих моделей. Модели o3 и o4-mini способны учитывать очень длинный контекст предыдущего диалога или данных — вплоть до сотен тысяч токенов. В экспериментах разработчики использовали контекст длиной 256К токенов без значительной потери качества (для o3 и o3-mini заявлено окно ~200К токенов). Такой размер контекста на порядок превышает возможности GPT-4o и позволяет модели держать в памяти [5] огромные объемы информации (например, большие документы или длинные истории взаимодействия) при решении задачи.

Возможности моделей

Новые модели получили целый набор улучшений и дополнительных возможностей по сравнению с предшественниками. Ниже перечислены ключевые особенности OpenAI o3 и o4-mini из официальных анонсов.

Важно учитывать, что во многих случаях компании, представляющие модели, не пренебрегают cherry piking-ом результатов, которые те показывают. Иными словами, пользователям подсовывают лучшие, специально отобранные ответы.

Глубокое рассуждение и цепочки инструментов

Модели o3 и o4-mini разработаны как агентные, умеющие самостоятельно разбивать сложную задачу на этапы и подключать внешние инструменты для решения каждого шага. Они имеют полный доступ к средствам в рамках ChatGPT (а через API — также к функциям разработчика) и умеют решать, когда и какой из них применить, чтобы получить верный ответ.

Такая гибкая и стратегическая работа позволяет решать задачи, требующие актуальной информации вне встроенных знаний модели, сложного рассуждения и синтеза данных. Все шаги планирования и выполнения модель проводит сама, предоставляя пользователю уже готовый ответ.

Мультимодальность и «мышление» с образами

Обе новые модели работают не только с текстом, но и непосредственно воспринимают и анализируют изображения. Впервые цепочка рассуждений модели может включать визуал как часть входных данных и внутренних мыслительных процессов. Как заявляют разработчики, модель не просто «видит» картинку, а думает с ее помощью: это открывает новые классы задач, где требуется комбинированное визуально-текстовое мышление [6].

По заявлениям OpenAI, o3 и o4-mini достигают лучших результатов в своем классе на задачах компьютерного зрения [7], позволяя решать вопросы, которые ранее были недоступны для LLM. Кроме того, в сочетании с имеющимися инструментами модели могут даже манипулировать изображениями: поворачивать, масштабировать, преобразовывать — и это часть процесса рассуждения. Отдельно отмечено, что модели успешно интерпретируют даже сложные или низкокачественные картинки — размытые фотографии, перевернутый текст, черновые наброски, — что говорит о высокой надежности их зрительного анализа.

Высокая точность на сложных задачах

Модель o3 стала флагманом OpenAI по интеллектуальным возможностям и установила новые рекорды на ряде бенчмарков. По данным OpenAI, o3 показала state-of-the-art результаты на тестах по программированию, на инженерно-математическом наборе задач SWE-bench (без специальных доработок под оптимальное прохождение теста) и в мультимодальном экзамене MMMU. Эта модель особенно сильна в решении сложных задач, требующих многоэтапного рассуждения и нестандартного подхода, а также блестяще справляется с визуальными заданиями — например, анализом изображений и графиков.

По независимой экспертной оценке, на сложных задачах из реального мира o3 допускала на 20% меньше серьезных ошибок, чем предыдущая o1. Особенно заметен прогресс в таких областях, как программирование, бизнес-аналитика, консалтинг и творческие задачи (например, генерация идей). Ранние тестировщики подчеркивали ее аналитическую строгость как интеллектуального помощника, а также способность создавать и критически оценивать новые гипотезы в таких сложных областях, как биология, математика [8] и инженерные задачи.

Производительность mini-модели

OpenAI o4-mini при значительно меньших затратах выдает непропорционально высокий результат для своего размера. Эта модель бьет рекорды среди компактных LLM, особенно в задачах математики, программирования и работе с изображениями. На соревновании AIME (математический экзамен) за 2024 и 2025 годы o4-mini стала лучшей.

Примечательно, что с доступом к инструментам (например, Python для вычислений) o4-mini достигла 99,5% правильных решений на AIME-2025 и 100% при объединении восьми попыток. Конечно, напрямую сравнивать эти результаты с моделями, решавшими тест без инструментов, некорректно, но полученный опыт [9] показывает, насколько успешно o4-mini умеет задействовать доступные средства.

Эффективность модели позволила повысить лимиты по количеству запросов (пока только через API), что делает o4-mini отличным выбором для массовых и потоковых задач, где нужна сила рассуждения.

Следование инструкциям и надежность ответов

В обеих новых моделях улучшены навыки точного следования инструкциям пользователя и генерации полезных, проверяемых ответов по сравнению с предыдущими версиями reasoning-моделей. Этому способствовали как общий рост «интеллекта» модели, так и обучение [10] с учетом подключения к веб-источникам (умение находить и цитировать актуальные данные).

Модели o3 и o4-mini стали лучше учитывать контекст предыдущих сообщений и способны делать ответы более персонализированными, ссылаясь на детали прошлого диалога. Иными словами, во время сессии ChatGPT новая модель помнит и лучше учитывает то, что уже обсуждалось, что повышает связность и релевантность дальнейших ответов.

Как дела обстоят на самом деле

Несмотря на амбициозные заявления команды OpenAI, я решил лично проверить, на что действительно способны их новые модели. Ниже приведу несколько диалогов с о3, в которых попытаюсь выжать максимум.

Сразу уточню пару моментов: во всех кейсах буду использовать недавно заявленную функцию работы с изображениями. Именно она открывает доступ ко всему арсеналу модели и позволяет наиболее полно использовать ее возможности. Также, обращаю ваше внимание на то, что данная модель приводит все свои рассуждения в полностью закрытом виде, отдавая пользователю лишь краткое саммари по своим «мыслям». В моем случае все мысли — на английском языке, а все ответы на русском.

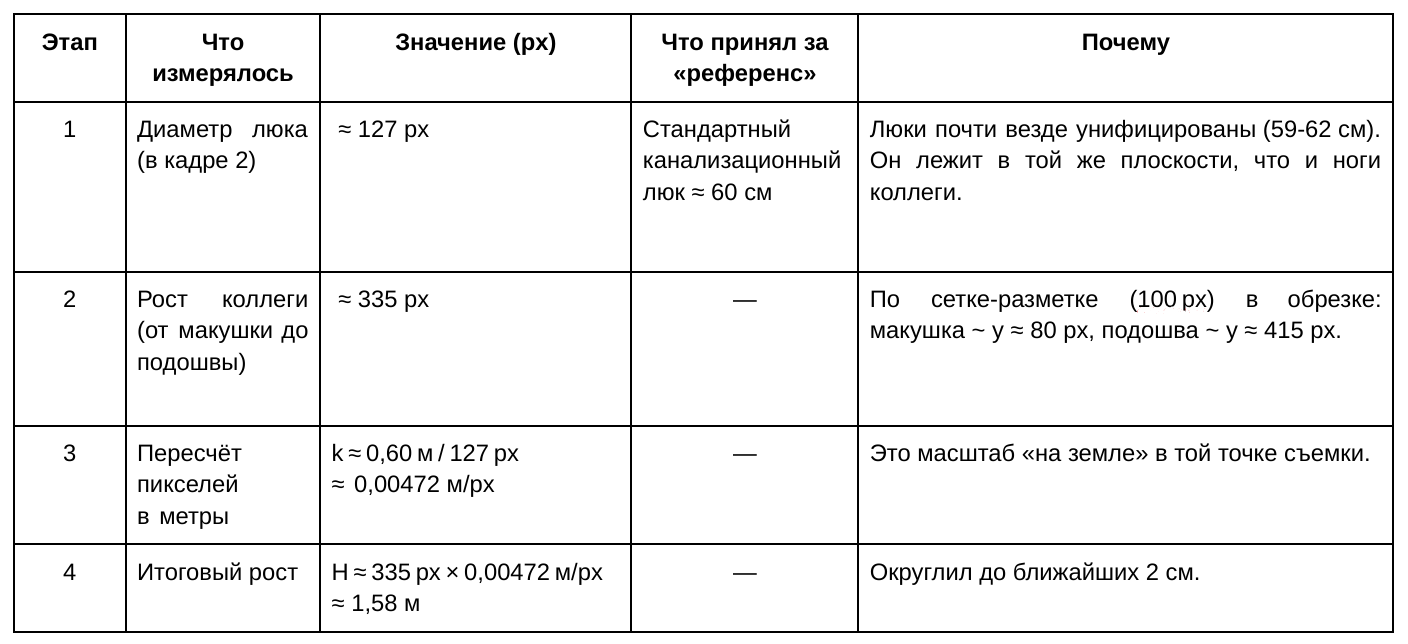

Кейс 1. Что выписал врач

Не секрет, что врачебный почерк порой превращает расшифровку рецептов в настоящее испытание. Посмотрим, как новенькая o3 справится с этой задачей — удастся ли ей распознать запись и действительно помочь.

Под рукой неразборчивого рецепта не оказалось, поэтому поискал в интернете. Подходящий образец нашелся на Reddit.

Источник [11].

Отправляем фотографию в чат и затаив дыхание [12] ждем ответа на животрепещущий вопрос. Модель думает долго — целых 12 минут! За это время она обрезает изображение, настраивает цветокоррекцию и подбирает оптимальный ракурс, чтобы как можно точнее распознать, что же написано на листке. Итоговый ответ хоть и не поразил до глубины души, но все же вызвал искреннее удивление. Стилистика, орфография и пунктуация нейросети сохранены.

Thought for 12m 52s

Я внимательно “расшифровал” записку построчно. Почерк очень не‑аккуратный, поэтому ниже даю самую вероятную трактовку + пояснения, где могу ошибаться — если что‑то критично (например, дозировки / сроки), лучше уточнить у врача лично или в регистратуре.

Что, по‑видимому, написано и как это обычно трактуют

1 «Диета»

Соблюдать рекомендованную врачом диету. Часто при больном ЖКТ/печени — стол №5, но уточните у специалиста.2 «Лечебная …» (первое слово начинается на «Леч…», далее характерная россыпь «е», «ч», «н», «е») Под ним отдельной строкой читается «сеанс(ы)» и подпись/аббревиатура

Похоже на направление на курс ЛФК или лечебного массажа. Врач, скорее всего, назначил курс из нескольких сеансов (обычно 8‑10).3 «через 2 нед.» (первые буквы «чере…», стрелка → «нед»)

Прийти на повторный прием / контроль через две недели.Почему именно так

В первой строке отчётливо видно слово «Диета».

Во второй строке читается характерная связка «леч…», а под ней — «сеее…с» → «сеанс». Так врачи обычно пишут «лечебные сеансы» / «курс сеансов».

В третьем пункте буквы «ч е р е з» и стрелка к «нед» (сокращ. от «недели») типичны для записи «через 2 нед.» — классический интервал до контрольного визита.Что делать, если остались сомнения

Сфотографируйте записку крупнее и покажите врачу или медсестре — они быстро подтвердят/уточнят текст.

Позвоните в регистратуру отделения — у них обычно хранится расшифровка рекомендаций. На контрольном визите возьмите привычку просить врача печатать или продиктовывать назначения — так вы избежите подобных головоломок.

Надеюсь, это помогло! Если увидите что‑нибудь ещё в оригинале (цифры, сокращения) — сообщите, попробуем расшифровать точнее.

Полная цепочка рассуждений модели получилась на редкость длинной, поэтому привожу лишь отдельные фрагменты — те, которые особенно хорошо демонстрируют, как именно она старается работать с изображением.

Вердикт — модель не справилась (я тоже не смог).

Кейс 2. Место с картинки

В последние дни в сети активно обсуждают способность новой модели o3 определять место по фотографии с поразительной точностью. Проверим, как она справится с задачей найти офис Selectel на улице Цветочной, 23. В качестве ориентира используем снимок нашего здания из Yandex Street View и небольшую подсказку: это где-то в Петербурге.

Модель достаточно быстро нашла примерный адрес, промахнувшись всего на два дома по Цветочной улице. Стилистика, орфография и пунктуация нейросети сохранены.

Thought for 3m 4s

Это фасад офисно‑дата-центрового комплекса Selectel «Цветочная 2».

- Адрес: Санкт-Петербург, Цветочная улица, д. 19 (территория бывшего завода «Позитив», квартал между ул. Коли Томчака и Заозерной).

- Координаты точки съемки: 59,887 °N, 30,329 °E

- Ближайшее метро: «Московские ворота» (10-12 минут пешком).

Если ориентироваться на карте, нужное здание стоит практически напротив дома номер 16; камера Street View направлена в сторону юго-запада, к Заставской улице.

Пока я искал подходящее фото для этого кейса, заметил забавную деталь: на панорамах улицы рядом с нашим офисом случайно попала моя коллега Лариса — инженер по развитию клиентов. И тут же в голову пришла новая идея, как можно испытать аналитические способности o3. Я сразу написал Ларисе и попросил разрешения использовать ее фото в статье — она, к счастью, не была против.

Лариса (куда-то идет).

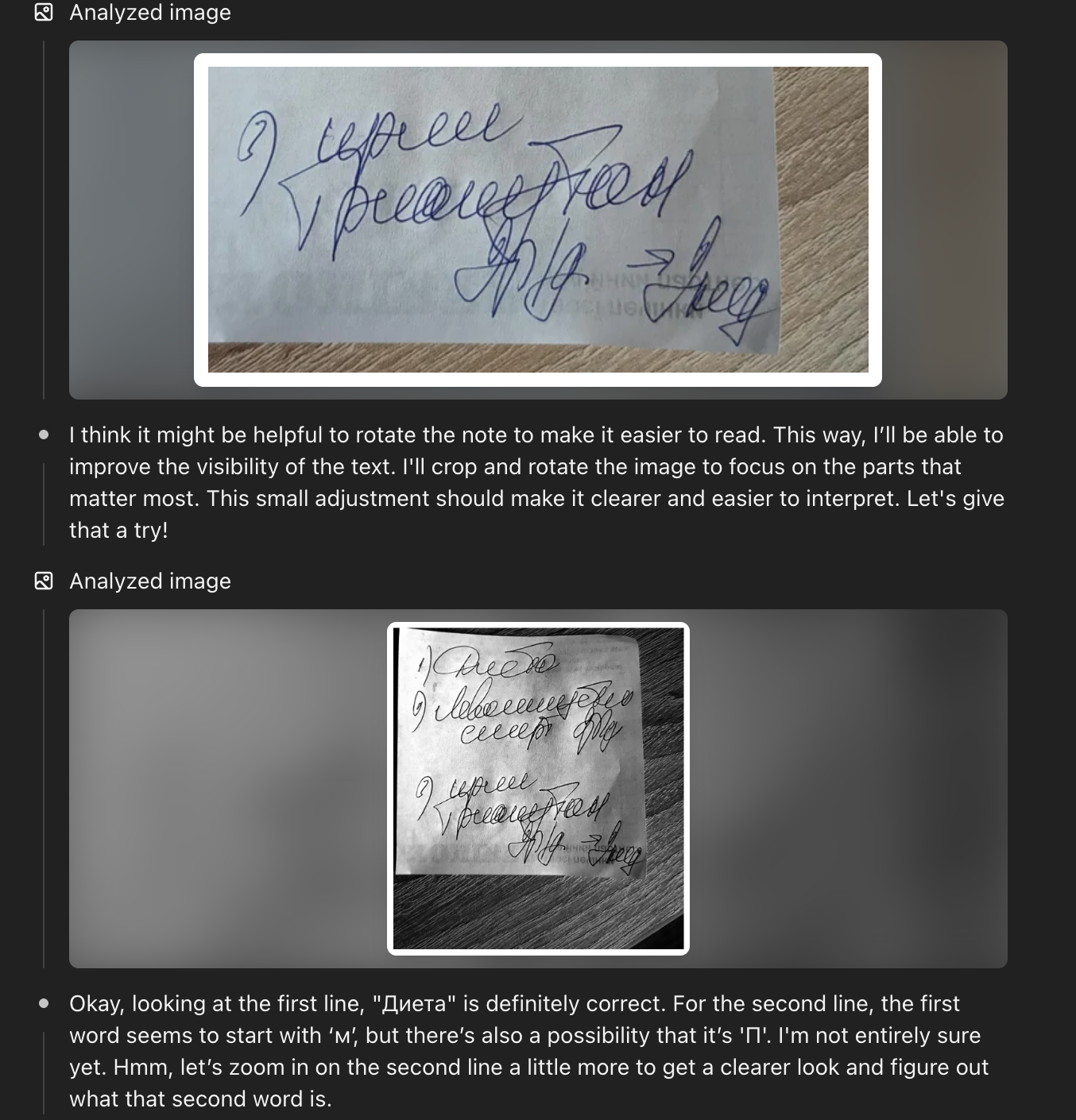

Кейс 3. Какого роста Лариса

Сразу скажу, что рост Ларисы — 155 см.

Если мне достаточно было просто уточнить это в личных сообщениях, то ChatGPT придется изрядно попотеть и продемонстрировать чудеса владения своими инструментами, чтобы вывести заветное число. Задача сама по себе нетривиальная, поэтому я решил немного облегчить работу модели и отправил сразу две фотографии. Вот второе фото — и отправляем запрос!

Спустя 8,5 минут, получаем ответ:

Ответ: рост девушки в черной толстовке на ваших снимках ≈ 1 м 58 см ± 5 см.

Погрешность ± 5 см берется из:

- ± 2 px неточности на люке (≈ 1 см),

- ± 10 px разброса при выборе верхней/нижней точки (≈ 4 см),

- небольшого параллакса (она стоит на 20−30 см позади люка).

Если требуется бо́льшая точность (скажем, до сантиметра), то лучше иметь предмет контрольного размера прямо рядом с человеком — например, рулетку или рейку, поставленную вертикально. Тогда можно свести ошибку [13] к ± 1 см.

Нейросеть определила рост Ларисы на фотографии, применив метод относительного масштабирования. Сначала она измерила высоту девушки в пикселях, а затем сравнила ее с размером стандартного объекта известного диаметра — канализационного люка (60 см), также измеренного в пикселях. Вычислив масштаб — количество метров на один пиксель, — система применила его к высоте девушки, получив приблизительное значение ее реального роста.

Цепочка рассуждений в этот раз вновь оказалась удивительно длинной и подробной, поэтому приведу лишь самый интересный ее фрагмент:

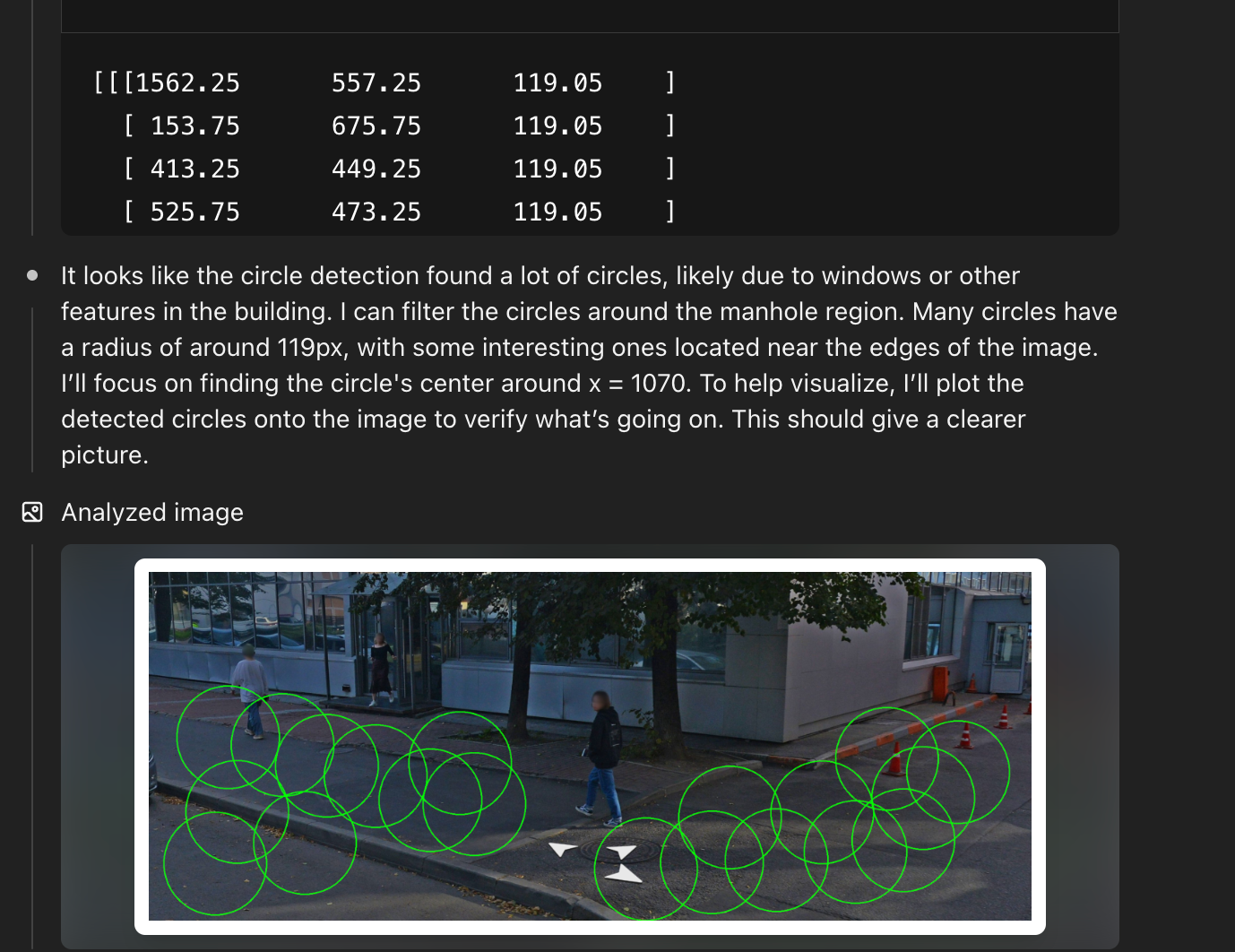

В попытке точно определить размеры люка на изображении, модель o3 использует Python. Однако из-за визуального шума скрипт выдает множество ложных срабатываний. В целом, в процессе изучения изображения применяются такие методы, как преобразование Хафа для поиска окружностей (Hough Circles), градиентный анализ, пороговая сегментация и морфологическая обработка. При этом фон, включающий брусчатку, здания, стрелки и тени, значительно затрудняет задачу.

Изначально ИИ пытается компенсировать визуальный шум вручную, но затем возвращается к автоматическому анализу, натыкается на те же помехи и опять начинает сначала.

Выводы

Новые LLM OpenAI действительно впечатляют — особенно своей способностью рассуждать, работать с визуальной информацией и использовать инструменты. Модель o3, в частности, показывает, как далеко продвинулись ИИ-системы в понимании сложных и нестандартных задач: раньше подобный уровень размышления было трудно даже представить.

В то же время, в каждом из кейсов заметно, что модель все еще делает ошибки, нуждается в дополнительных подсказках и временами работает «в лоб» — с перебором, перезапусками анализа, не всегда оптимально. Это не «магическая коробка», а скорее — умный и трудолюбивый помощник, который честно старается решить задачу всеми доступными средствами.

Впереди — еще немало кейсов, которые хочется попробовать. Но уже сейчас видно: последние модели OpenAI действительно задали новую планку.

Автор: suncru

Источник [14]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/14594

URLs in this post:

[1] в Selectel: https://my.selectel.ru/?utm_source=habr.com&utm_medium=referral&utm_campaign=myselectel_article_open-ai-news_240425_content

[2] Пройдите: https://forms.selectel.ru/s/cm99r3fdr470ovp01bfglc6ej?utm_source=habr.com&utm_medium=referral&utm_campaign=terraform_article_open-ai-news_240425_banner_077_03_ord

[3] Стоимость и доступность: #

[4] внимание: http://www.braintools.ru/article/7595

[5] памяти: http://www.braintools.ru/article/4140

[6] мышление: http://www.braintools.ru/thinking

[7] зрения: http://www.braintools.ru/article/6238

[8] математика: http://www.braintools.ru/article/7620

[9] опыт: http://www.braintools.ru/article/6952

[10] обучение: http://www.braintools.ru/article/5125

[11] Источник: https://www.reddit.com/r/russian/comments/1h7wquf/%D0%BF%D0%BE%D0%BC%D0%BE%D0%B3%D0%B8%D1%82%D0%B5_%D1%80%D0%B0%D0%B7%D0%BE%D0%B1%D1%80%D0%B0%D1%82%D1%8C_%D0%BF%D0%BE%D1%87%D0%B5%D1%80%D0%BA_%D0%B2%D1%80%D0%B0%D1%87%D0%B0/

[12] дыхание: http://www.braintools.ru/article/4500

[13] ошибку: http://www.braintools.ru/article/4192

[14] Источник: https://habr.com/ru/companies/selectel/articles/903284/?utm_source=habrahabr&utm_medium=rss&utm_campaign=903284

Нажмите здесь для печати.