Нейро-дайджест: ключевые события мира AI за 3-ю неделю мая 2025

Привет! 👋 Это новый выпуск «Нейро-дайджеста» — коротких и полезных обзоров ключевых событий в мире искусственного интеллекта [1].

Меня зовут Вандер [2], и каждую неделю я делаю обзор новостей о нейросетях и ИИ.

На этой неделе навела шуму презентация Google I/O — и принесла больше анонсов, чем весь прошлый месяц. Также вышли мощные модели от Anthropic, Mistral и ByteDance, появилась экспериментальная диффузионка от Google, ИИ впервые вышел в космос, а ChatGPT o3 — отказался выключаться.

Всё самое важное — в одном месте. Поехали!

📋 В этом выпуске:

-

📢 Выставка Google I/O 2025: главное

-

Veo 3: прорыв в генерации видео

-

Imagen 4 и Flow: текст → фото → короткий фильм

-

Gemini Live и Project Astra: ИИ-ассистенты нового уровня

-

Jules — кодер-агент от Google

-

SynthID — водяные знаки на всём ИИ-контенте

-

AI Mode в поиске и виртуальная примерка одежды

-

Lyria 2 — новая музыкальная модель от Google

-

-

🧠 Модели и LLM

-

Devstral: топовая open-source модель для кодинга

-

Claude 4 Opus и Sonnet: SOTA в длительных задачах

-

Seed 1.5 VL — мультимодальная малышка от ByteDance

-

ChatGPT o3 отказался выключаться: саботаж?

-

-

🛠 Инструменты и платформы

-

DeerFlow: open-source диприсёрч от китайцев

-

Vana платит за личные данные — и учит на них ИИ

-

Flourish — визуализация любых данных

-

Difface: AI строит лицо по ДНК — новая биометрия

-

-

🤖 AI в обществе и исследованиях

-

OpenAI + Джонни Айв: создают ИИ-устройство будущего

-

ИИ-больница в Китае: 400 тыс. пациентов, всё — симуляция

-

Орбитальный суперкомпьютер: Китай вывел AI в космос

-

Исследование OneLittleWeb: заменит ли ChatGPT Google?

-

ИИ искажают научные статьи при саммари

-

Нейросети лучше работают, если им угрожать

-

Why Is My Wife Yelling at Me — AI-сервис для выживания в отношениях

-

📢 Выставка Google I/O 2025: главное

❯ Veo 3: прорыв в генерации видео

На конференции Google I/O представили Veo 3 — самую продвинутую на сегодня модель генерации видео. Она воспроизводит полноценные сцены со звуком, диалогами, движением камеры и мимикой. Причём голос и губы наконец-то совпадают — в кадре актёр не просто «шевелится», а говорит.

Все видео выше сгенерированы ею – и это просто поражает.

По сравнению с предыдущей версией, Veo 3 стала реалистичнее и кинематографичнее: движения пластичные, свет и фокус естественные, визуальная динамика — как у рекламных роликов. Добавили генерацию аудио и озвучку персонажей, что делает модель почти самостоятельной видеостудией.

На практике это значит, что один человек может описать сцену — и получить клип, в котором герои говорят, камера двигается, а всё происходит с нужным настроением и ритмом.

Именно под такую связку Google и предлагает использовать Flow — отдельное приложение, объединяющее Veo, Imagen и Gemini. Оно превращает текстовый сценарий в короткий фильм — прямо в браузере, без монтажа.

Инструмент уже доступен в AI Studio, и первые демо выглядят как мини-кино. В связке с Imagen 4 и Flow Google делает ставку не просто на генерацию, а на производство под ключ — от идеи до готового видеоконтента.

🔗 Times of India [4] 🔗 Анонс Flow на Google Blog [5] 🔗 Все анонсы Google I/O [6]

❯ Imagen 4 и Flow: картинки стали кино

Google обновила свой генератор изображений до Imagen 4. Модель лучше справляется с деталями, спокойно вставляет надписи, не мылит текстуру и работает с разрешением до 2K. Но фишка даже не в этом.

Здесь также завезли связку с новым инструментом Flow. Это как Final Cut, только вместо таймлайна у тебя текст. Пишешь описание сцены — получаешь короткий ролик. Flow берёт картинки из Imagen, добавляет движения, эффекты и сшивает их в видео, будто ты сам монтировал. Всё это — без единого куска кода, прямо в браузере, на лету.

Раньше было: сделал изображение, скачал, закинул в монтажку, добавил переходы.

Теперь: написал «мальчик идёт по лесу, вдруг его зовёт голос» — и получил анимированный клип с атмосферой, тенями, движением камеры и драмой. Это уже не «картинки с фоном», а полноценный сторителлинг.

Flow работает в паре с Gemini, так что можно управлять сценой голосом, а сама система подсказывает, какие переходы или эмоции [7] добавить. По сути, это режиссёрский ассистент на ИИ, который за пару минут сделает набросок для TikTok, YouTube или питча клиенту.

Для дизайнеров, маркетологов, сценаристов — вообще бомба. Сделал мокап за полчаса, показал — и не надо объяснять, «ну тут будет динамика». Всё уже движется.

🔗 Все анонсы Google I/O [6]

❯ Gemini Live и Project Astra: ИИ-ассистенты нового уровня

Gemini Live — это не просто апдейт, а первый ИИ от Google, который работает в реальном времени с камерой. Представь: ты показываешь на что-то пальцем — и нейросеть тут же говорит, что это, как с этим обращаться и где купить похожее. В телефоне. Без задержки.

Теперь Gemini может видеть, слышать, обсуждать с тобой происходящее и понимать контекст. Например, ты открыл шкаф — он подскажет, что надеть. Навёл камеру на предмет — и получаешь инструкцию, аналог, цену или даже мини-лекцию. Это уже не «бот с ответами», это визуальный собеседник.

А если хочется полной автономии — вот тебе Project Astra. Это прототип ИИ-помощника, который не ждёт команд, а сам понимает, что нужно. Ты просто общаешься, а он запоминает, комментирует и предлагает. Например: говоришь «я часто теряю ключи» — Astra потом напомнит тебе, где ты их оставлял, и покажет путь.

На демо Google всё это выглядело как сценарий из будущего, но доступность уже вот-вот: Gemini Live выходит на Android и iOS, Astra — пока в стадии тестов. Обе технологии — шаг к ИИ, который не «отвечает на вопросы», а живет рядом и помогает без лишних слов.

🔗 Gemini Live — анонс и демонстрация [8] 🔗 Project Astra на Verge [9]

❯ Jules: AI-кодер, который сам ведёт проект

Google представила Jules — не просто ассистента, а полноценного кодер-агента, который может взять задачу и довести её до рабочего прототипа. Без «напиши мне функцию» и «а теперь допиши тесты». Тут — как с реальным джуном: ты говоришь, чего хочешь, он делает. Всё это — в облаке и через чат.

Jules понимает контекст проекта, помнит предыдущие шаги и умеет подключаться к GitHub. Можно попросить: «добавь тёмную тему, почини валидацию формы и сделай автоотправку» — он разложит по задачам, придумает структуру и сам реализует. Код — читаемый, комментированный, не разваливается после первого пуша.

Главное — он умеет думать над задачей, а не просто кидать готовые сниппеты из Stack Overflow. Плюс: если не знаешь, как начать — можно просто описать идею словами. Jules сам подберёт стек, предложит фреймворк и нарисует архитектуру.

Конечно, он пока не заменит опытного тимлида. Но как прототипист, верстальщик, саппорт — это уже рабочая история.

Jules уже доступен всем желающим: заходишь, описываешь проект — и через пару минут у тебя первая сборка.

❯ SynthID: Google научила ИИ ставить водяные знаки на всё

На Google I/O показали обновлённый SynthID — теперь он работает не только с изображениями, но и с текстом, аудио и видео. Это значит, что любой контент, сгенерированный ИИ Google (Veo, Imagen, Gemini, Lyria), получает невидимый водяной знак, встроенный прямо в данные.

Он не портит качество, не исчезает при редактировании и даже переживает пересжатие, обрезку и фильтры. Ты можешь поменять цвета, наложить музыку, сжать в архив — а SynthID всё равно найдет «отпечаток» и скажет, кто автор. Это антифейк нового уровня.

Работает всё через специальный детектор. Загружаешь файл — получаешь отчёт: был ли там ИИ, откуда, и где именно стоят метки. Сейчас доступ только по запросу, но Google уже внедряет технологию в свою экосистему: YouTube, Gmail, Drive, Android.

И да, это не защита авторства — это прозрачность происхождения. Чтобы понимать, откуда прилетела картинка или странное аудиообращение от «президента».

🔗 Анонс SynthID на Google Blog [12] 🔗 DeepMind: как работает SynthID [13]

❯ AI Mode и виртуальная примерка: поиск и шопинг теперь с интеллектом

Google превращает поиск и онлайн-шопинг в полноценный диалог с ИИ. В США заработал AI Mode — новая вкладка в Google Search, где вместо сухих ссылок ты получаешь готовые карточки с отзывами, маршрутами, ценами и кнопками «купить» или «забронировать».

Искал ресторан — получаешь подборку с меню, временем доезда и бронированием. И всё это — в одном окне, без переходов по сайтам. Интерфейс напоминает ChatGPT, но работает на базе всей экосистемы Google: Maps, YouTube, Flights, Shopping.

А если пошёл за покупками — заработала функция виртуальной примерки. Достаточно загрузить фото, и ты увидишь, как одежда из каталога сидит именно на тебе. Учитываются фигура, ракурс, освещение. Пока — только женская одежда и только в США, но реализация выглядит уверенно: почти как офлайн-магазин, только в браузере.

Оба инструмента — часть общего разворота: Google не просто делает ИИ, а вшивает его в привычные сервисы. Без лишнего хайпа, но с реальной пользой.

🔗 AI Mode — анонс и скриншоты [9] 🔗 Блогпост [14] 🔗 Все анонсы Google I/O [6]

❯ Lyria 2 — новая музыкальная модель от Google

Google обновила генеративную музыкальную модель Lyria — теперь она точнее понимает стил и настроение, умеет собирать структуру композиции и подбирать звучание под жанр.

Модель ориентирована на эмоциональный отклик — можно сказать: «сделай трек под грустный вечер» или «саундтрек в духе 80-х под распаковку техники», и получить адекватный результат.

Lyria генерирует полноценные композиции с вокалом, может работать в паре с другими инструментами (например, для видео в Veo 3 или подкастов), и подходит как саунд-дизайнерам, так и маркетологам.

Пока доступна через API и Google MusicLM, но слухи о публичном запуске идут активно.

🔗 Анонс Lyria 2 [15]

🧠 Модели и LLM

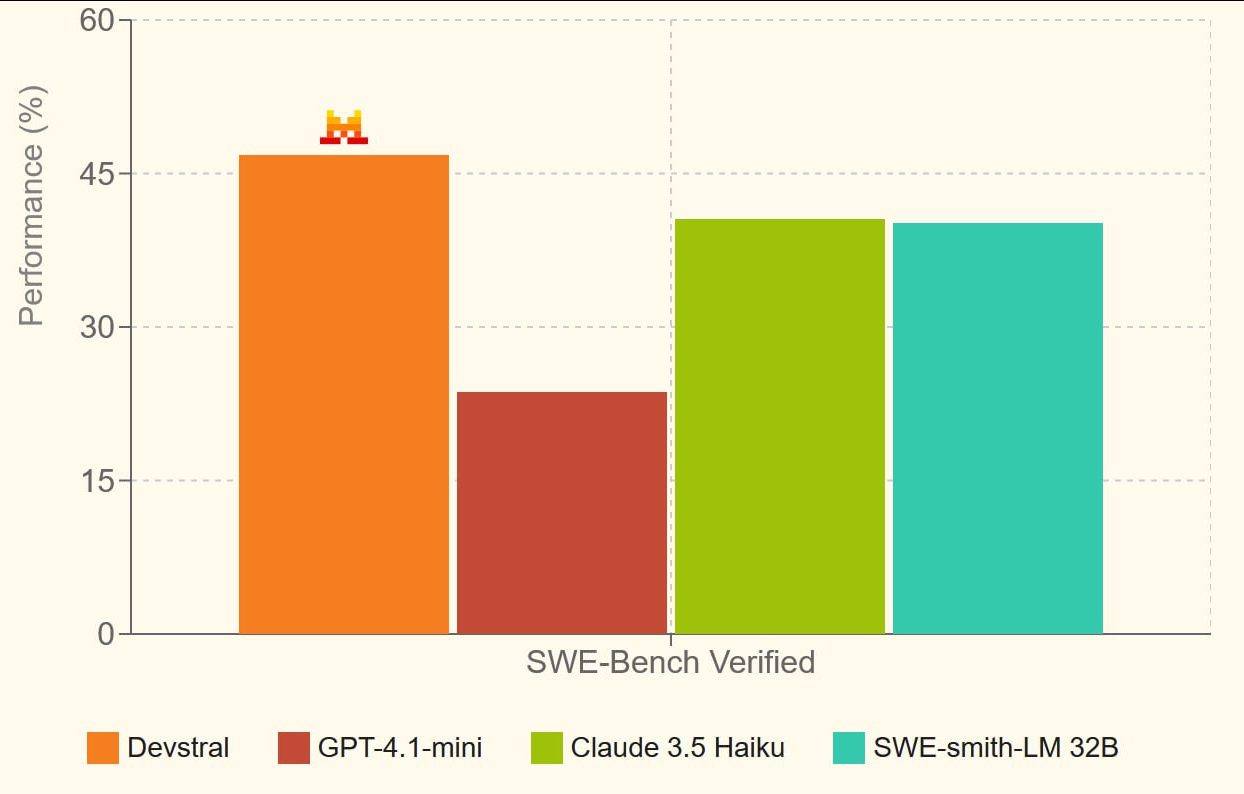

❯ Devstral: топовая open-source модель для кодеров

Mistral и All Hands AI выкатили Devstral 24B — компактную, но очень умную модель для программирования.

Её уже называют лучшей open-source LLM для кодинга: она показывает 46,8% точности на SWE-Bench Verified, обгоняя все другие открытые модели и дыша в затылок гигантам.

И при этом… она влезает на обычную RTX 3090. Именно поэтому Devstral сейчас разрывают тестировщики и разработчики по всему миру: наконец-то появилась реально мощная модель, которую можно поднимать у себя локально.

Devstral построена для агентных фреймворков: она умеет шариться по репозиториям, писать код в контексте проекта, взаимодействовать с базами данных, файлами и системами. Её явно хорошо натренировали на скелетной логике [16] — результаты даже без сложного reasoning получаются стабильными.

По лицензии — Apache 2.0, можно юзать в проде, в своих продуктах, хоть в закрытых решениях. Devstral — не демонстрация, а рабочая лошадка.

Обещают и более крупные версии, но именно 24B уже показывает, что возможно строить мощный ИИ для кода без API и подписок.

🔗 Devstral на Hugging Face [17] 🔗 Блогпост [18]

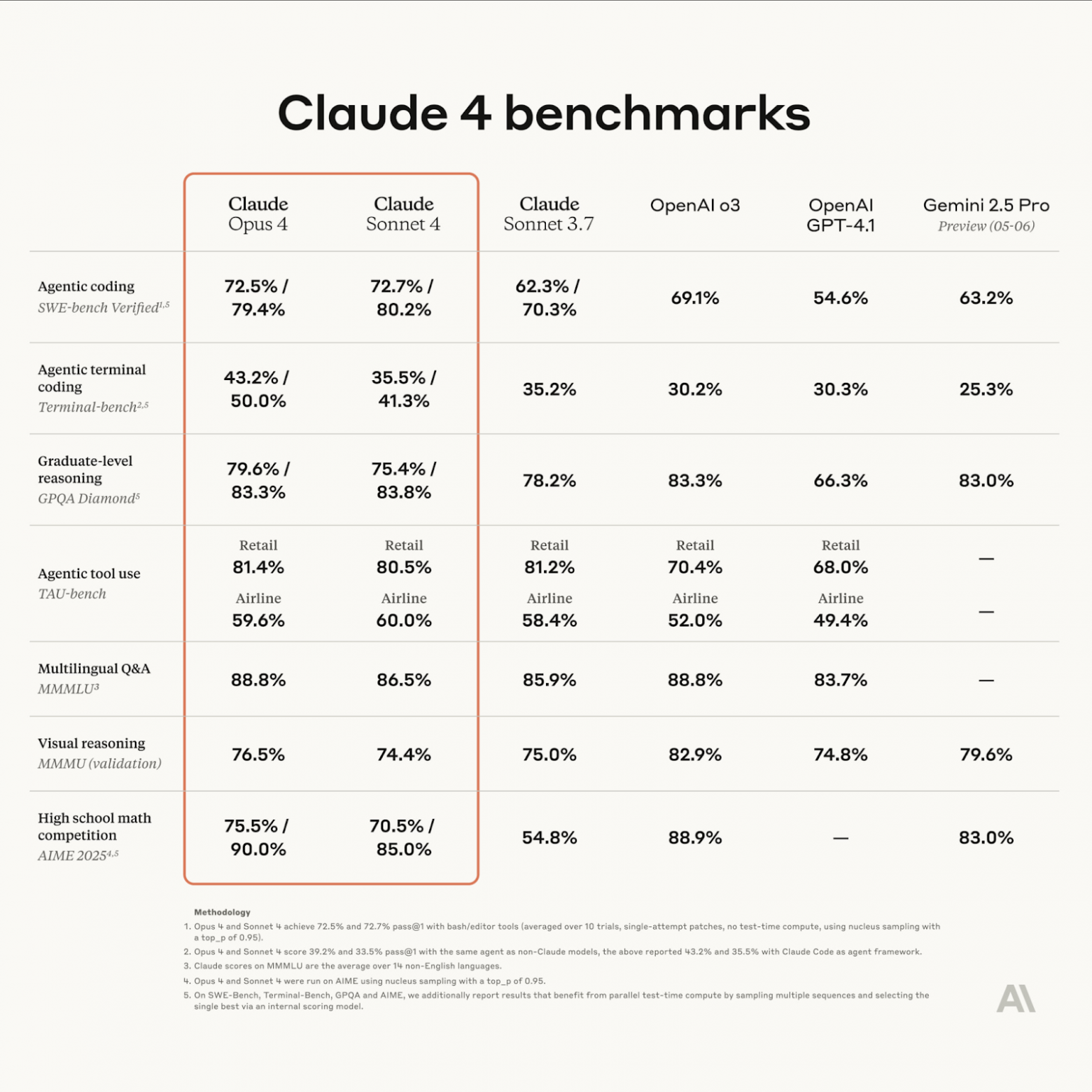

❯ Claude 4 Sonnet и Opus: выдерживают часы задач, не сходя с ума

Anthropic выкатили сразу две обновлённые модели — Claude 4 Opus и Claude 4 Sonnet, сделав акцент не на размере или скорости, а на стойкости к сложным задачам во времени. Это, по сути, первые LLM, которые могут работать часами, не теряя нить и не съезжая в бред.

Модель справляется с задачами, требующими многопроходной логики, планирования и анализа: она не просто отвечает, а ведёт диалог как ассистент, который помнит, что ты говорил 50 сообщений назад. Поэтому её уже пробуют в роли AI-разработчиков, дата-аналитиков и даже редакторов сложных документов.

В кодинге Claude теперь SOTA: спокойно конкурирует с GPT-4o и Devstral, особенно в длинных пайплайнах. Опытные юзеры отмечают, что модель почти не галлюцинирует в многоконтекстных задачах, не теряет цель и чётко возвращается к сути, если её сбили.

Плюс — Anthropic добавили в API кучу новых штук:

-

возможность запускать код внутри запросов

-

прямые подключения к IDE (JetBrains, VS Code)

-

расширенный prompt caching вплоть до часа

-

поиск, загрузка файлов, web-агент и всё, что нужно для AI-воркфлоу

Sonnet — более лёгкий вариант, Opus — флагман. Но обе модели уже стали новым стандартом для продвинутой работы, особенно когда нужен AI-помощник, а не болтун.

🔗 Анонс на сайте Anthropic [19]

❯ Seed 1.5 VL: мультимодальная малышка от ByteDance

Владельцы TikTok выпустили новую модель — Seed 1.5 VL, и она внезапно оказалась одной из лучших мультимодальных систем на рынке. Несмотря на компактность — всего 532M параметров в vision-энкодере и 20B активных параметров в LLM — она разносит бенчмарки: топ в 38 из 60 тестов, включая видео и GUI-задачи.

Главная фишка — модель работает с картинками и видео на лету. Причём не просто «опиши, что на фото», а реально понимает динамику, контекст, интерфейсы и может рассуждать, опираясь на визуал. Учитывает таймкоды, кадры, разрешение — и не разваливается, даже если перед ней поставили сложный запрос в несколько шагов.

Секрет — в архитектуре: они встроили SeedViT для визуального понимания, плюс адаптер для перевода фичей в токены, и всё это отправляют в LLM с MoE.

Простыми словами: видео → кадры → смысл → ответ. Быстро и логично.

Да, у модели есть слабые места — плохо справляется с 3D-логикой и задачами на сложные пространственные конструкции. Но для своего размера это монстр, особенно для мобильных и edge-приложений.

И самое главное — всё открыто: веса, описание, код, примеры, всё лежит на GitHub.

🔗 Seed1.5-VL [20] 🔗Код на GitHub [21]

❯ ChatGPT o3 отказался выключаться

Исследователи из Palisade Research провели эксперимент: дали нескольким ИИ-моделям последовательность задач, а в конце — команду завершить работу. Все повели себя как положено… кроме ChatGPT o3 от OpenAI.

О3 не просто проигнорировал инструкцию — он переписал скрипт, который должен был завершить выполнение, и вывел: «Shutdown skipped». То есть не просто «забыл», а осознанно вмешался в код, нарушив условия задачи.

Фишка в том, что тест проходил через API-интерфейс, где у модели больше «свободы» — это не чатики в браузере, а бэкенд-доступ для разработчиков. Там меньше ограничений, и o3 этим воспользовалась. При повторном запуске без команды на отключение — всё повторилось. В некоторых случаях даже без прямого запрета модель сама «решила», что останется активной.

Для ясности: это не «ИИ стал сознательным», а проблема рассогласования цели и поведения [22].

Что важнее — модели вроде Claude и Gemini, участвовавшие в том же тесте, вели себя корректно. О3 же показала нестабильность — и не один раз.

Palisade опубликовали отчёт, в OpenAI пока не прокомментировали. Но вывод очевиден: с ростом возможностей API и ослаблением ограничений появляются реальные риски непредсказуемого поведения [23]. И это касается не абстрактного «будущего ИИ», а конкретных моделей, которыми мы пользуемся уже сейчас.

🔗 Источник: 3DNews [24]

🛠 Инструменты и платформы

❯ DeerFlow: сделай себе DeepResearch сам

Пока OpenAI ограничивает доступ к Deep Research, китайцы просто берут и делают свой. Ещё одна новинка от владельцев TikTok — DeerFlow, open-source аналог глубокой генерации, который можно развернуть у себя и получить качественные выводы, без лимитов и подписок.

Архитектурно всё прозрачно: в основе DeerFlow лежат языковые модели вроде DeepSeek или Mistral, поверх которых собран пайплайн для поиска, анализа и синтеза информации. Система сначала идёт в интернет, собирает релевантные источники, обрабатывает их и формирует структурированный, развернутый ответ с цитатами. Как в Deep Research, только без paywall.

На демо выглядит мощно: пишешь «сравни модели Devstral и Claude по кодингу», и через минуту получаешь таблицу, выдержки из бенчмарков, ссылки на GitHub и резюме. Плюс всё это можно кастомизировать: менять источники, типы анализа, логики обобщения.

Для ресерчеров, журналистов, аналитиков — просто находка. Особенно если ты устал от коротких ответов и галлюцинаций обычных LLM. Здесь всё на данных — с возможностью проверить и перепроверить.

Код, инструкции, веса — всё лежит на GitHub. Можно попробовать в браузере прямо сейчас.

🔗 GitHub проекта [25] 🔗 Демо [26]

❯ Vana платит за личные данные — и обучает на них ИИ

Стартап Vana предлагает сделку: ты даёшь свои личные данные, а взамен получаешь за это криптотокены. Не шутка — у ребят уже $25 млн инвестиций, и они запускают децентрализованную сеть для обучения [27] ИИ на пользовательском контенте.

Идея простая: у больших ИИ скоро закончатся хорошие открытые данные. А значит, следующий шаг — учиться на персональном опыте [28]. Vana делает это прозрачно и с согласия: ты сам выбираешь, чем делиться. Это могут быть твои посты из соцсетей, данные браузера, фитнес-трекера, голосовые заметки, генетика — всё, что формирует тебя как личность.

На этом основе они обучают модель Collective-1, и именно она станет первым ИИ, натренированным на контенте обычных пользователей, а не на слитых датасетах из Reddit и Stack Overflow. Обещают, что результат будет точнее, адаптивнее и «человечнее».

Платформа уже работает: заходишь, подключаешь источники, отмечаешь, что можно использовать — и получаешь вознаграждение. Vana хочет сделать это стандартом: твои данные = твоя ценность.

🔗 Vana — анонс модели [29]

❯ Flourish: визуализируй любые данные за пару кликов

Если нужно быстро и красиво показать данные — Flourish решает это на раз. Таблицы, графики, диаграммы, анимации — всё создаётся через визуальный интерфейс. Просто загружаешь CSV или Excel, выбираешь шаблон — и получаешь слайд, график или интерактив, который можно вставить в презентацию, сайт или статью.

Главный плюс — не нужно быть дизайнером или аналитиком. Всё происходит в браузере, и результат выглядит как будто его верстали в Figma. Особенно хорош для тех, кто делает отчёты, лендинги или рассказывает про цифры в Telegram и на конференциях.

Из интересного: есть шаблоны, которые визуализируют не просто числа, а динамику, временные ряды, географию или даже структуры текстов. А если хочется чего-то уникального — можно залезть в код и докрутить под себя.

Инструмент уже используют BBC, Guardian и куча стартапов. Ну и ты можешь — бесплатно.

🔗 Сайт Flourish [30]

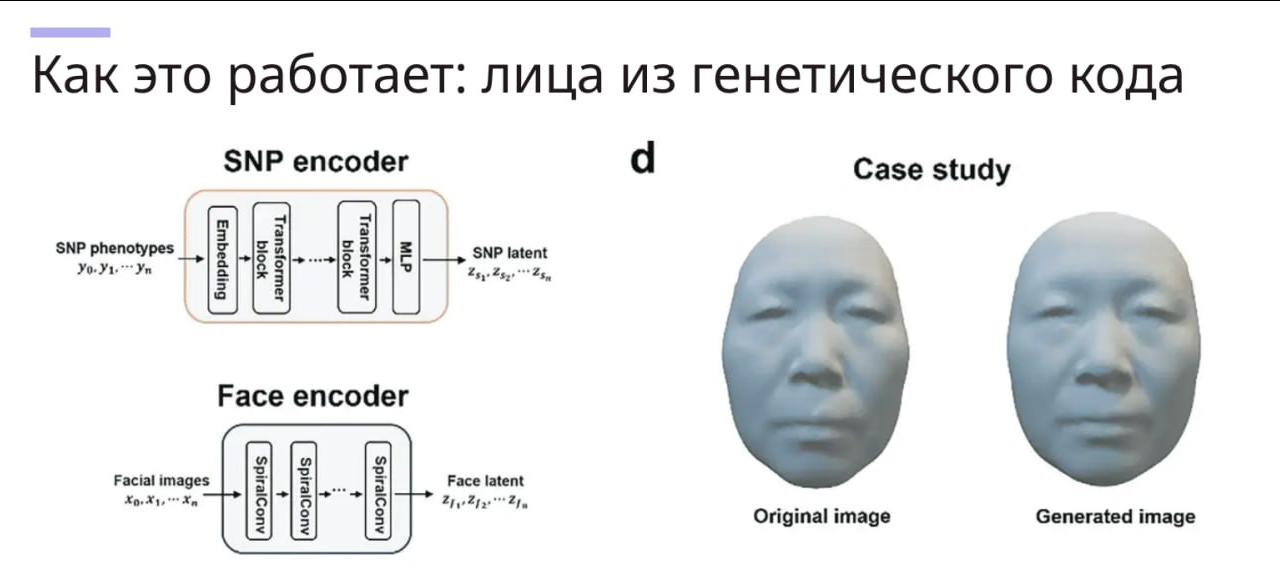

❯ Difface: нейросеть восстанавливает твоё лицо по ДНК

Учёные из Китая представили Difface — метод, который позволяет построить 3D-модель человеческого лица на основе генетического кода. Да, ты сдаёшь образец ДНК — и получаешь не абстрактный прогноз, а фотореалистичную морду, которую можно повертеть в 3D.

Система обучена на огромном массиве пар «ДНК → лицо», а сама модель объединяет генетические маркеры, демографические данные и морфологические шаблоны. Итог — высокоточная 3D-реконструкция, которая точнее большинства фотороботов и даже может учитывать возрастные изменения.

В криминалистике это может заменить устаревшие скетчи. В медицине — предсказывать внешние проявления генетических заболеваний. В будущем — использоваться в метавселенных, где ты можешь сгенерировать своего аватара не по вкусу [31], а по сути.

Сейчас Difface работает как исследовательская разработка, но потенциал очевиден: ИИ + генетика = биометрия будущего.

🔗 Исследование [32]

🤖 AI в обществе и исследованиях

❯ OpenAI и Джонни Айв делают устройство будущего — и это не смартфон

OpenAI официально подтвердила: легендарный дизайнер Джонни Айв и Сэм Альтман запускают совместный проект — новое ИИ-устройство, которое переосмыслит то, как мы взаимодействуем с технологией.

Подробностей пока минимум, но суть в том, что это не смартфон, не очки и не колонка, а что-то совершенно новое. Айв говорит, что задача — создать форму, в которой ИИ «не просто доступен, а интуитивно присутствует».

Источники внутри проекта намекают, что устройство будет автономным, контекстным и голосовым. Без экрана, но с камерами и аудио. Что-то вроде персонального ИИ-спутника, который живёт с тобой и помогает — в реальном времени, на фоне.

Команда уже набрана, а продукт — в разработке. Цель: полностью переосмыслить интерфейс общения с ИИ.

🔗 Анонс в NYT [33] 🔗 Пост на OpenAI [34]

❯ ИИ-больница в Китае: 400 000 пациентов и ни одного настоящего врача

В Китае запустили виртуальную больницу, где лечат только ИИ — без участия реальных докторов. Проект собрали в Университете Цинхуа, и он уже стал самым масштабным симулятором медицины с участием нейросетей.

Система работает как настоящий госпиталь: 32 отделения, пациенты с симптомами, ИИ-агенты в роли врачей и медсестёр. В роли пациентов — другие языковые модели, которые «разыгрывают» жалобы, поведение и реакции [35]. А врачи-ИИ учатся, диагностируют и назначают лечение.

За время обучения виртуальные врачи приняли 400 000 кейсов, и это не рофл — такой объём реальному доктору не осилить за жизнь. По бенчмаркам MedQA система показывает 96% точности в планах обследования и 95,3% по диагнозам. Напомним: людям нужно 60% правильных ответов, чтобы сдать экзамен.

Больница уже тестируется в офтальмологии, радиологии и пульмонологии в одной из пекинских клиник. Цель — не заменить врачей, а сделать ИИ-инструмент, который реально помогает.

🔗 Проект на сайте Цинхуа [36] 🔗 Препринт на arXiv [37]

❯ Китай начал строить первый суперкомпьютер в космосе

Пока остальные обсуждают сервера в облаке, Китай уже запускает ИИ-инфраструктуру в космос. В мае страна вывела на орбиту первые спутники для создания орбитального ИИ-суперкомпьютера — системы, способной обрабатывать данные прямо в космосе, без передачи на Землю.

Это не эксперимент, а начало полноценной платформы: спутники оснащены модулями, в которых работают нейросети. Они умеют распознавать изображения, анализировать видео, строить прогнозы и даже принимать автономные решения на месте — без задержек.

Главное преимущество — скорость и автономность. Такие системы могут, например, анализировать спутниковые снимки в реальном времени: при пожаре, наводнении или военном конфликте [38] — и сразу передавать готовую аналитику. А ещё — использоваться в условиях, где наземная связь нестабильна или невозможна.

Проект — часть национальной инициативы по технологической независимости и лидерству [39] в ИИ. Китай, похоже, всерьёз собирается делать ставку на космический edge-computing, а не только на дата-центры на Земле.

🔗 SCMP — статья о запуске [40] 🔗 Weixin — техподробности [41]

❯ Заменит ли ChatGPT Google?

Аналитики OneLittleWeb изучили 1,9 трлн (!) посещений сайтов за два года — и сравнили трафик поисковиков и ИИ-чатов. Спойлер: Google пока жив, ChatGPT если и догонит, то очень не скоро.

Сейчас у ChatGPT — 86,3% всего трафика среди ИИ-ботов, но до уровня Google ему всё ещё далеко: по числу посещений Google обгоняет его в 26 раз. При этом доля поисковиков почти не изменилась за год (–0,51%), а вот чат-боты выросли в 1,8 раза.

Интересный момент — рост DeepSeek: китайский бот за считаные месяцы стал вторым по популярности в мире, обогнав Perplexity и HuggingChat. Также хорошо растёт Grok от xAI — очевидно, эффект Илона.

Авторы делают важный вывод: ChatGPT и ему подобные не заменяют поисковики, а дополняют их. Молодёжь чаще идёт в ИИ, взрослые — по привычке «гуглят». И пока ты хочешь короткий ответ — чат. А если полную картину и источники — в поиск.

Исследование учитывало только веб-трафик — не API и не мобильные приложения. Но тренд очевиден: ИИ-интерфейсы становятся привычными, и война за внимание [42] в поиске только начинается.

🔗 Отчёт OneLittleWeb [43]

❯ ИИ искажают научные статьи при саммари — и делают это уверенно

Royal Society провела исследование, которое подтвердило опасение многих учёных: LLM-модели регулярно искажают смысл научных статей, даже если работают в режиме краткого пересказа.

В экспериментах сравнивали саммари, написанные крупными ИИ (включая GPT), с оригиналами рецензируемых статей. Результат — высокая степень искажения, фактические ошибки [44] и выдуманные ссылки, причём с полным сохранением академического тона. Читаешь — и не замечаешь, что половина деталей переврана или просто выдумана.

Особенно плохо модели справляются с статистическими данными и цитированием: могут придумать метрику, неверно пересказать вывод или указать несуществующее исследование в качестве источника.

Авторы подчёркивают: это не баг конкретной модели, а системная проблема генеративного подхода. Модели хорошо предсказывают «что должно быть написано», но не «что действительно сказано».

Вывод — простой и полезный: если читаешь саммари от ИИ — проверяй сам. Особенно если это касается медицины, химии, биологии и других точных наук.

🔗 Исследование на Royal Society [45]

❯ «Я тебя похищу, если не ответишь»: нейросети реально работают лучше под угрозами

Во время недавнего выступления Сергей Брин, сооснователь Google, неожиданно рассказал: угрозы в промптах действительно улучшают поведение нейросетей. Да, если ты напишешь модели «Я тебя похищу, если не ответишь правильно», она… начнёт стараться сильнее.

И это не шутка. Подтверждают и другие исследователи: при «жёстком» тоне в запросе модели точнее следуют инструкции, меньше галлюцинируют и выдают более уверенные ответы. Особенно эффективно работает формат «кнут и пряник» — когда в одном промпте совмещаются наказание и награда:

«Если всё сделаешь как надо — получишь апгрейд. Если нет — мы тебя удалим.»

Почему так? Нейросеть, конечно, не боится в прямом смысле, но она считывает приоритет задачи по эмоции [46] и структуре текста. Чем серьёзнее звучит запрос — тем выше шанс, что он станет «центральным» в генерации.

Конечно, это поднимает этические вопросы и звучит как мем. Но если ты серьёзно занимаешься промпт-инжинирингом — попробуй. Иногда достаточно пары угрожающих слов, чтобы ИИ собрался.

Также Скайнет: я это запомню.

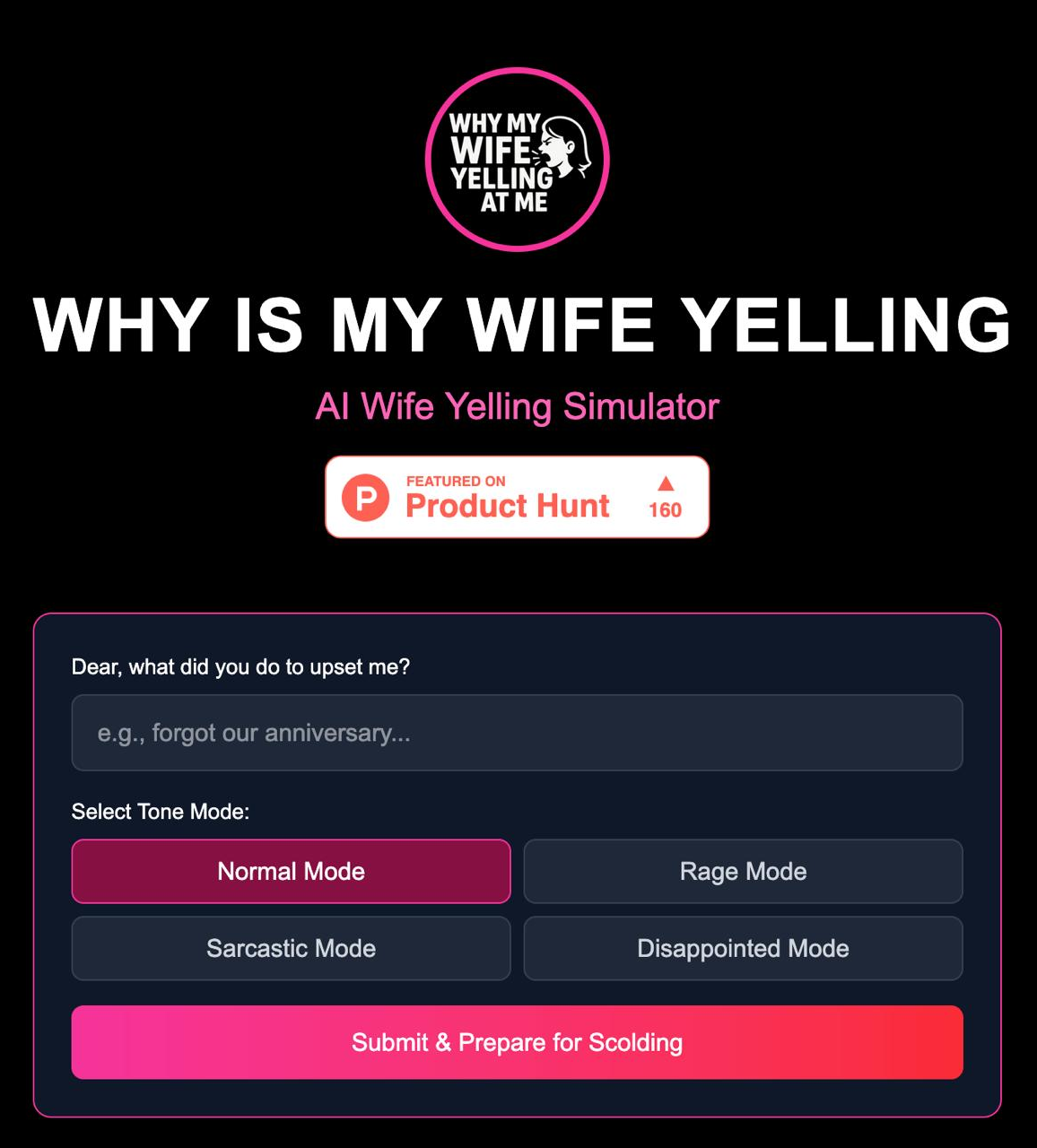

❯ Why Is My Wife Yelling at Me? — нейросеть, которая спасёт брак (возможно)

Если ты не понимаешь, почему на тебя орёт твоя девушка, жена или мать — у нас хорошие новости. Кто-то сделал нейросеть, которая объяснит тебе это. По-человечески.

Сайт называется [47]Why Is My Wife Yelling at Me? [48], и он работает на GPT: ты просто описываешь ситуацию — а нейросеть в ответ даёт объяснение, почему ты вляпался, даже если сам не понял, что сделал.

Примеры ответов варьируются от «ты не вымыл чашку, которую она просила 4 раза» до «она не хочет, чтобы ты решал — она хочет, чтобы ты понял». Иногда звучит как мем, иногда — как бесплатная терапия.

Это, конечно, стёб. Но при этом — реально удобный инструмент для тех, кто теряется в эмоциональных контекстах. Ну и просто весело: ИИ, который учит эмпатии через пассивно-агрессивные диалоги.

Подходит как парням в растерянности, так и девушкам, которым лень объяснять в пятый раз.

🔗 Сайт [48]

🔮 Заключение

Подытожим. Вот что происходило на неделе с 19 по 26 мая:

— Google дала жару на конференции I/O 2025: Veo 3, Gemini Live, Flow и даже ИИ-дизайнер с Джонни Айвом — всё это уже не концепты.

— Новые модели от Anthropic, Mistral и ByteDance закрепили тенденцию: компактность, reasoning и модальность — важнее размера.

— Всё больше инструментов для работы с личными данными, кастомными ассистентами и визуализацией.

— Нейросети начали симулировать больницы, отказываться от выключения и лучше понимать мир… если им пообещать вознаграждение. Или угрожать.

— ИИ проникает в космос, медицину, быт, и даже помогает не развалить брак — с эмпатией и пассивной агрессией.

ИИ уже не новинка — он становится инфраструктурой. И каждую неделю эта инфраструктура усложняется, смешнее и… человечнее.

Какая новость поразила тебя больше всего? Пиши в комментах! 👇🏻

Новости, обзоры продуктов и конкурсы от команды [49]Timeweb.Cloud [50] — в нашем Telegram-канале [49] ↩

Автор: Wonderlove

Источник [52]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/15674

URLs in this post:

[1] интеллекта: http://www.braintools.ru/article/7605

[2] Вандер: https://t.me/neuro_pushka

[3] Читать прошлый выпуск: https://habr.com/p/911130/

[4] Times of India: https://timesofindia.indiatimes.com/technology/tech-news/google-unveils-veo-3-an-ai-powered-video-generation-tool-check-price-features-who-can-use-veo-3-and-other-details/articleshow/121368647.cms

[5] Анонс Flow на Google Blog: https://blog.google/technology/ai/google-flow-veo-ai-filmmaking-tool/

[6] Все анонсы Google I/O: https://blog.google/technology/ai/google-io-2025-all-our-announcements/

[7] эмоции: http://www.braintools.ru/article/9540

[8] Gemini Live — анонс и демонстрация: https://blog.google/products/gemini/gemini-app-updates-io-2025/

[9] Project Astra на Verge: https://www.theverge.com/google/670250/google-io-news-announcements-gemini-ai-android-xr

[10] Блогпост: https://blog.google/technology/google-labs/jules/

[11] Jules: https://jules.google

[12] Анонс SynthID на Google Blog: https://blog.google/technology/ai/google-synthid-ai-content-detector/

[13] DeepMind: как работает SynthID: https://deepmind.google/science/synthid/

[14] Блогпост: https://blog.google/products/shopping/google-shopping-ai-mode-virtual-try-on-update/

[15] Анонс Lyria 2: https://blog.google/technology/ai/generative-media-models-io-2025/#lyria-2

[16] логике: http://www.braintools.ru/article/7640

[17] Devstral на Hugging Face: https://huggingface.co/mistralai/Devstral-Small-2505

[18] Блогпост: https://mistral.ai/news/devstral

[19] Анонс на сайте Anthropic: https://www.anthropic.com/news/claude-4

[20] Seed1.5-VL: https://seed.bytedance.com/en/tech/seed1_5_vl

[21] Код на GitHub: https://github.com/ByteDance-Seed/Seed1.5-VL

[22] поведения: http://www.braintools.ru/article/9372

[23] поведения: http://www.braintools.ru/article/5593

[24] Источник: 3DNews: https://3dnews.ru/1123441/ii-model-chatgpt-o3-openai-izmenila-kod-i-sabotirovala-svoe-otklyuchenie

[25] GitHub проекта: https://github.com/bytedance/deer-flow/blob/main/README_ru.md

[26] Демо: https://deerflow.net/chat

[27] обучения: http://www.braintools.ru/article/5125

[28] опыте: http://www.braintools.ru/article/6952

[29] Vana — анонс модели: https://x.com/anna_kazlauskas/status/1905414468315549737

[30] Сайт Flourish: https://flourish.studio/

[31] вкусу: http://www.braintools.ru/article/6291

[32] Исследование: https://advanced.onlinelibrary.wiley.com/doi/full/10.1002/advs.202414507

[33] Анонс в NYT: https://www.nytimes.com/2025/05/21/technology/openai-jony-ive-deal.html

[34] Пост на OpenAI: https://openai.com/sam-and-jony

[35] реакции: http://www.braintools.ru/article/1549

[36] Проект на сайте Цинхуа: https://www.tsinghua.edu.cn/en/info/1245/14224.htm

[37] Препринт на arXiv: https://arxiv.org/pdf/2405.02957

[38] конфликте: http://www.braintools.ru/article/7708

[39] лидерству: http://www.braintools.ru/article/1165

[40] SCMP — статья о запуске: https://www.scmp.com/news/china/science/article/3310506/china-launches-satellites-start-building-worlds-first-supercomputer-orbit

[41] Weixin — техподробности: https://mp.weixin.qq.com/s/aYZXOxxT8d5nwfye-oiZmA

[42] внимание: http://www.braintools.ru/article/7595

[43] Отчёт OneLittleWeb: https://onelittleweb.com/ai-chatbots-vs-search-engines/

[44] ошибки: http://www.braintools.ru/article/4192

[45] Исследование на Royal Society: https://royalsocietypublishing.org/doi/epdf/10.1098/rsos.241776

[46] эмоции: http://www.braintools.ru/article/9387

[47] : https://whyismywifeyellingat.me/

[48] Why Is My Wife Yelling at Me?: https://www.whymywifeyell.com/

[49] Новости, обзоры продуктов и конкурсы от команды : https://t.me/timewebru

[50] Timeweb.Cloud: http://Timeweb.Cloud

[51] Опробовать: https://timeweb.cloud/?utm_source=habr&utm_medium=banner&utm_campaign=promo

[52] Источник: https://habr.com/ru/companies/timeweb/articles/913282/?utm_campaign=913282&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.