Тест на прочность: LLM против сложных задач

В мире, где условия задач постоянно меняются, способность языковой модели учиться на ходу без перестройки своих параметров становится настоящим вызовом. Недавнее исследование показывает, как простые техники рефлексии, эволюционных эвристик и планирования превращают LLM в гибких агентов, способных адаптироваться к новым ситуациям. От классической игры «камень-ножницы-бумага» до сложных головоломок Ханойской башни — узнайте, какие стратегии работают лучше всего и какие перспективы откроются перед LLM в динамических средах.

Цель исследования

В статье “Towards a Deeper Understanding of Reasoning Capabilities in Large Language Models” [1] основной вопрос звучит так: «Насколько эффективно языковые модели могут самостоятельно обучаться и адаптироваться к новым задачам, используя только специальные промты, без изменения своих параметров?» Авторы сравнивают различные промт-стратегии, изучая их влияние на способности моделей в динамических условиях.

Используемые методы

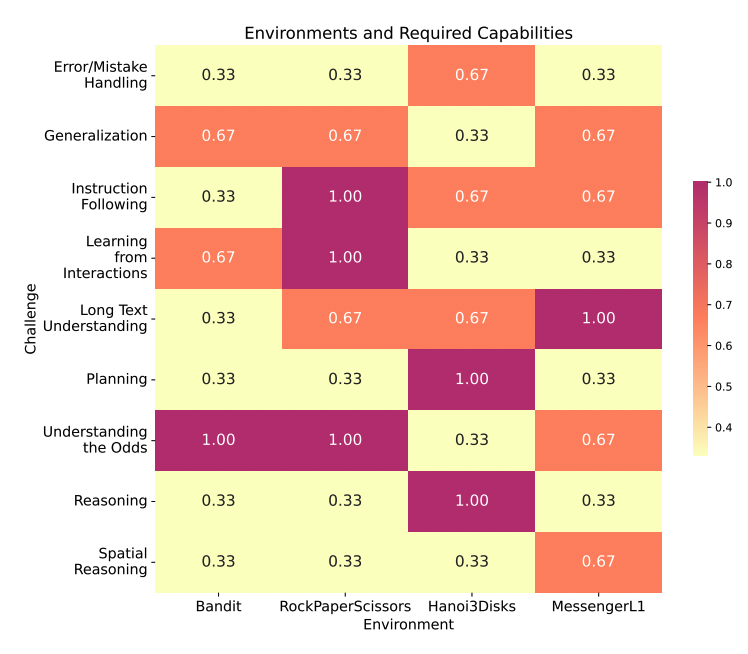

Исследователи тестировали модели на наборе SmartPlay, включающем четыре задачи разного уровня сложности:

-

Bandit (двухрукий бандит): задача на выбор оптимального действия (максимум — 45 баллов).

-

Rock-Paper-Scissors (камень-ножницы-бумага): выигрышные ходы против случайного противника (максимум — 43).

-

Tower of Hanoi (Ханойская башня с тремя дисками): успешно перемещённые диски (максимум — 3).

-

Messenger: доставка сообщений с наградами за успех и штрафами за ошибки [2] (максимум — 1 балл).

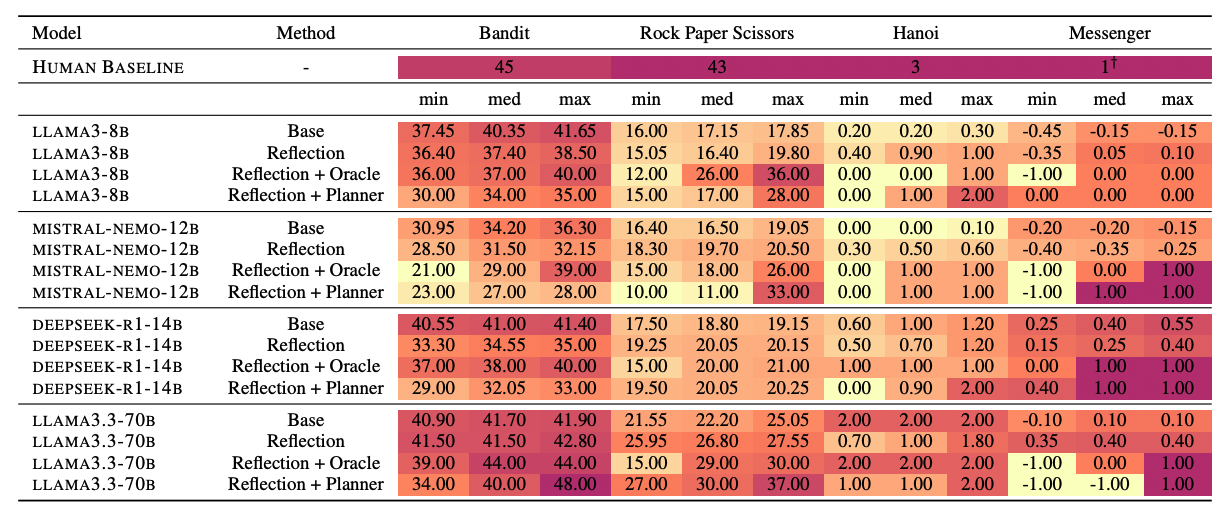

Тестирование проводилось на четырёх разных моделях:

-

LLAMA3-8B (8 млрд параметров)

-

MISTRAL-NEMO-12B (12 млрд параметров)

-

DEEPSEEK-R1-14B (14 млрд параметров)

-

LLAMA3.3-70B (70 млрд параметров)

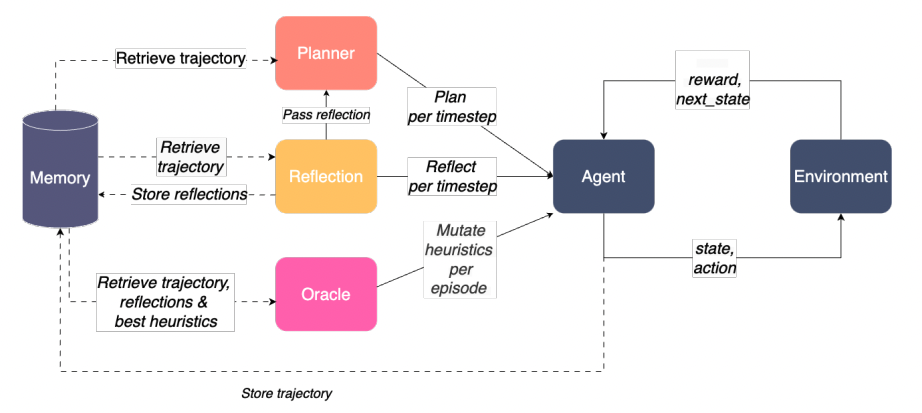

Три основных промтинг-стратегии :

-

Reflection (рефлексия): анализ своих действий и рекомендаций по улучшению.

-

Oracle (оракул/эвристическая эволюция [6]): автоматическая эволюция и сохранение успешных стратегий.

-

Planner (планирование шагов): прогнозирование действий наперёд и выбор оптимального пути.

Ключевые результаты

Самые большие модели (LLAMA3.3-70B) показали лучшие результаты практически во всех тестах. Однако применение дополнительных стратегий prompting позволило даже средним моделям (например, LLAMA3-8B и MISTRAL-NEMO-12B) существенно улучшить результаты:

-

В игре “Камень-ножницы-бумага” LLAMA3-8B с Reflection и Oracle достигла среднего показателя в 26 баллов, значительно сократив отставание от больших моделей.

-

В задаче Messenger модель MISTRAL-NEMO-12B с Reflection и Planner достигла максимальной оценки 1, превосходя даже большие модели, которые показали более низкие результаты.

Тем не менее, наблюдалась и значительная нестабильность. Например, результаты модели MISTRAL-NEMO-12B сильно варьировались от 10 до 33 баллов в игре “Камень-ножницы-бумага”.

Дополнительные эксперименты показали, что упрощение задач и добавление чётких сигналов-наград (reward shaping) существенно улучшает способность моделей решать задачи, которые ранее были недоступны. Например, введение промежуточных наград за правильные ходы в Ханойской башне увеличило успех модели с 0 % до 42 %.

Ограничения и перспективы

Несмотря на перспективность таких подходов, исследование выявило ряд важных ограничений:

-

Нестабильность результатов: даже небольшие изменения условий могли значительно повлиять на эффективность моделей.

-

Перегрузка информацией: слишком длинные и сложные подсказки снижали эффективность небольших моделей.

-

Ограничения в самобучении и рассуждениях: модели часто повторяли ошибки и демонстрировали неспособность к долгосрочному планированию.

-

Проблемы с пространственным пониманием: модели плохо справлялись с задачами, требующими ориентации в пространстве и понимания сложных правил.

Авторы предлагают несколько перспективных направлений для преодоления этих проблем:

-

Использование внешней памяти [7] и символических представлений для улучшения способности к планированию.

-

Введение мультимодального восприятия [8] для лучшего понимания реального мира.

-

Создание гибридных архитектур, совмещающих языковые модели с традиционными алгоритмами искусственного интеллекта [9].Заключение

Заключение

Данное исследование показывает, что большие языковые модели уже способны адаптироваться к новым задачам, используя специальные подсказки, но их способности пока остаются ограниченными. Продолжение работы в этом направлении позволит создать более надёжных и гибких интеллектуальных агентов, способных работать в реальных динамических средах.

***

Если вам интересна тема ИИ, подписывайтесь на мой Telegram-канал [10] – там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

Автор: andre_dataist

Источник [11]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/15684

URLs in this post:

[1] “Towards a Deeper Understanding of Reasoning Capabilities in Large Language Models”: https://arxiv.org/abs/2505.10543

[2] ошибки: http://www.braintools.ru/article/4192

[3] обучение: http://www.braintools.ru/article/5125

[4] поведения: http://www.braintools.ru/article/9372

[5] мышление: http://www.braintools.ru/thinking

[6] эволюция: http://www.braintools.ru/article/7702

[7] памяти: http://www.braintools.ru/article/4140

[8] восприятия: http://www.braintools.ru/article/7534

[9] интеллекта: http://www.braintools.ru/article/7605

[10] подписывайтесь на мой Telegram-канал: https://t.me/+n4N1Tea2loc1MGQy

[11] Источник: https://habr.com/ru/articles/914102/?utm_source=habrahabr&utm_medium=rss&utm_campaign=914102

Нажмите здесь для печати.