Маскирование данных при работе с LLM: защита бизнеса от утечек и штрафов по 152-ФЗ

Введение

Корпоративный сектор всё активнее внедряет решения на базе больших языковых моделей (LLM) — от генерации документов до поддержки пользователей и автоматизации внутренней аналитики. Однако вместе с ростом эффективности растут и риски, особенно когда речь идёт о передаче персональных данных. Для российских компаний эти риски связаны не только с киберугрозами, но и с прямыми нарушениями Федерального закона №152-ФЗ «О персональных данных». Одним из ключевых способов защиты информации в таких сценариях становится маскирование данных — то есть скрытие или замена персональных данных в сообщениях, обрабатываемых LLM.

Почему LLM представляет угрозу для персональных данных

Большие языковые модели (такие как GPT, LLaMA, Claude) работают по принципу предсказания следующего слова на основе контекста. Чтобы модель могла быть полезной, в неё нужно передавать текстовые данные, зачастую содержащие:

-

ФИО клиентов и сотрудников

-

адреса электронной почты и телефоны

-

номера паспортов и ИНН

-

адреса проживания и сведения о здоровье

-

банковские и платёжные данные

Если такие данные случайно попадут в внешний LLM, особенно в облачный сервис, компания рискует:

-

утечкой конфиденциальной информации, если LLM будет использовать данные для обучения [1];

-

штрафами от Роскомнадзора за нарушение законодательства;

-

репутационными потерями из-за возможной огласки инцидента.

Что говорит 152-ФЗ

Федеральный закон №152-ФЗ обязывает оператора персональных данных:

-

получать согласие на обработку;

-

ограничивать доступ к данным;

-

обеспечивать безопасность при передаче данных третьим лицам;

-

обезличивать данные, если они передаются на внешние ресурсы.

Передача необезличенных данных в облачные LLM-сервисы без явного согласия — прямое нарушение закона, даже если речь идёт о техническом эксперименте или интеграции с API.

Маскирование данных как решение

Маскирование — это процесс автоматической подмены персональных данных в тексте перед его отправкой в LLM. Это может быть реализовано на основе:

-

регулярных выражений (для email, ИНН, паспортов и т.д.)

-

NER-моделей (Named Entity Recognition), обученных находить имена, адреса, даты и прочие сущности;

-

LLM, дообученных на задачи маскировки (когда одна модель фильтрует данные перед тем, как они попадут в другую).

Пример:

Вход: "Иван Петров, паспорт 1234 ℞567890, проживает по адресу г. Москва, ул. Ленина, д. 1"

Выход после маскировки: "[NAME], паспорт [DOC_ID], проживает по адресу [ADDRESS]"

Таким образом, модель получает необходимый контекст, но не узнаёт настоящих персональных данных.

Инструмент BitDive как часть решения

Для компаний, стремящихся внедрять LLM безопасно, существует готовое решение — BitDive. Этот продукт позволяет:

-

создавать универсального клиента для общения с любой LLM (в том числе GPT, Claude, Mistral и локальными моделями);

-

интегрировать маскирование и де-маскирование на этапе передачи и получения сообщений;

-

вести журнал всех обращений к LLM и отслеживать потенциальные утечки;

-

подключать внутренние MCP-серверы (Model Control Proxy) для маршрутизации запросов к нужной модели и управления политиками доступа;

-

централизованно управлять всеми взаимодействиями LLM в корпоративной сети, включая разграничение прав доступа, фильтрацию данных и аудит.

Таким образом, BitDive выступает не просто как средство интеграции LLM, но как полноценный уровень безопасности и контроля в корпоративной архитектуре, необходимый для соответствия требованиям 152-ФЗ.

Реализация в корпоративной сети

Маскирование должно быть встроено в инфраструктуру взаимодействия с LLM. Вот возможная архитектура:

-

Прокси-сервис, через который проходят все запросы к LLM (в том числе через API).

-

Блок фильтрации и маскировки, выполняющий обработку текста до отправки и восстановления результата после ответа.

-

Логи и контроль доступа, чтобы отслеживать, какие данные были отправлены и какие сотрудники ими пользовались.

-

Возможность обратной де-маскировки, если это необходимо внутри защищённой инфраструктуры.

Практика: чем рискует бизнес

Кейсы:

-

Банк передал в GPT полную переписку с клиентами, включая номера договоров и телефоны — штраф от Роскомнадзора и запрос на удаление данных от клиента.

-

HR-служба использовала LLM для анализа резюме — без маскировки были отправлены персональные данные кандидатов, включая паспортные данные.

-

Страховая компания обучила внутреннюю модель на письмах пользователей, забыв удалить поле “Полис №” — в результате в выдаче появлялись реальные номера.

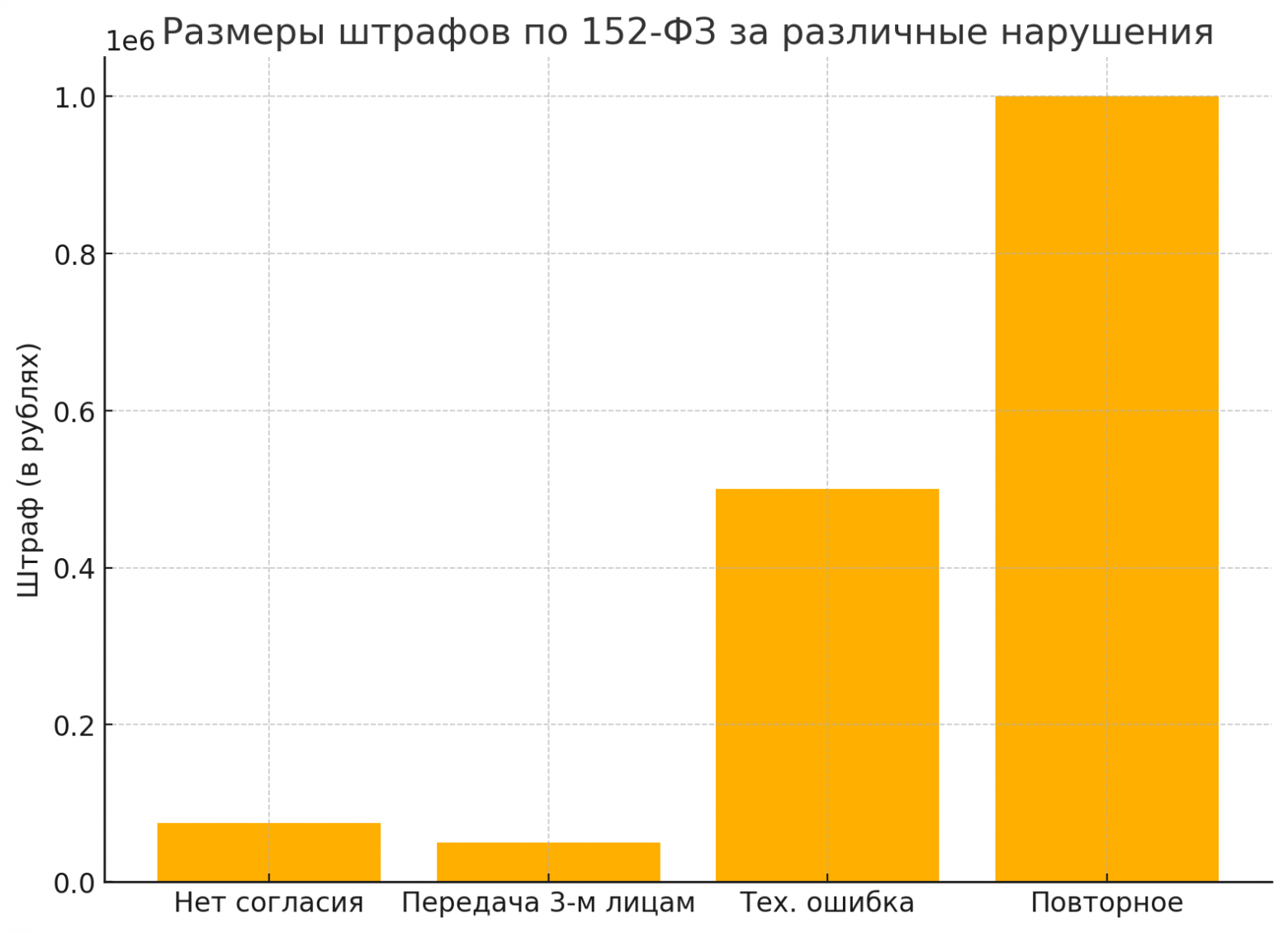

Возможные последствия:

|

Нарушение |

Штраф по 152-ФЗ |

|---|---|

|

Отсутствие согласия |

до 75 000 рублей |

|

Неразрешённая передача 3-й стороне |

до 50 000 рублей |

|

Утечка из-за технической ошибки [2] |

до 500 000 рублей и предписание |

|

Повторное нарушение |

до 1 000 000 рублей и блокировка |

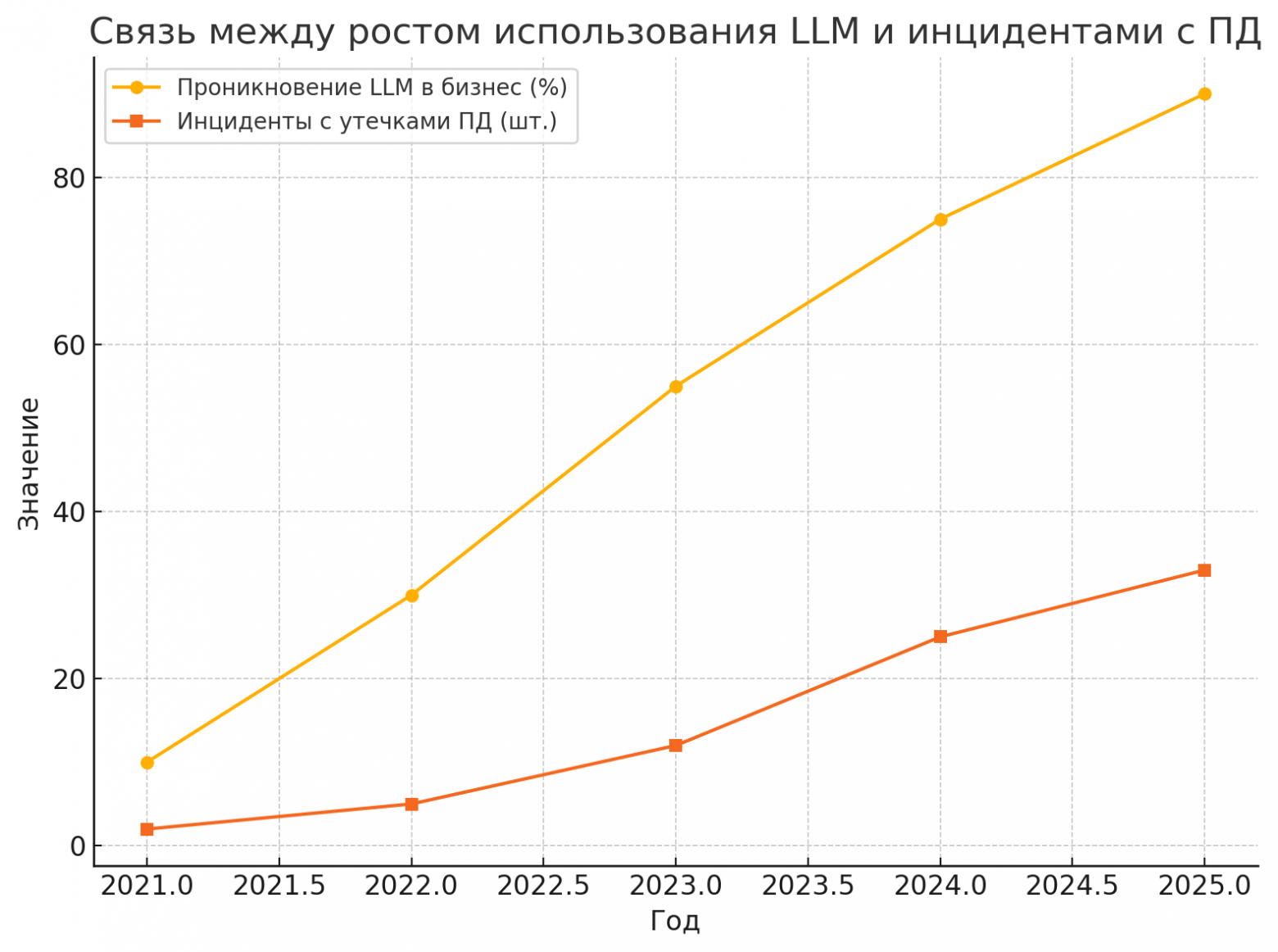

График 1: Рост внедрения LLM и инцидентов с ПД

График 2: Размеры штрафов за различные нарушения

Заключение

Интеграция LLM в бизнес-процессы — это технологический скачок, но он требует осознанного подхода к безопасности данных. Маскирование персональной информации должно стать стандартной практикой для любого взаимодействия с языковыми моделями — как в облаке, так и внутри корпоративной среды. Решения вроде BitDive, поддерживающие маскирование, аудит и MCP-инфраструктуру, становятся важнейшим элементом современной цифровой безопасности. Это не просто вопрос соблюдения закона, но и доверия клиентов, защиты репутации и устойчивости бизнеса в цифровую эпоху.

Автор: Faragon

Источник [3]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/16042

URLs in this post:

[1] обучения: http://www.braintools.ru/article/5125

[2] ошибки: http://www.braintools.ru/article/4192

[3] Источник: https://habr.com/ru/articles/916826/?utm_source=habrahabr&utm_medium=rss&utm_campaign=916826

Нажмите здесь для печати.