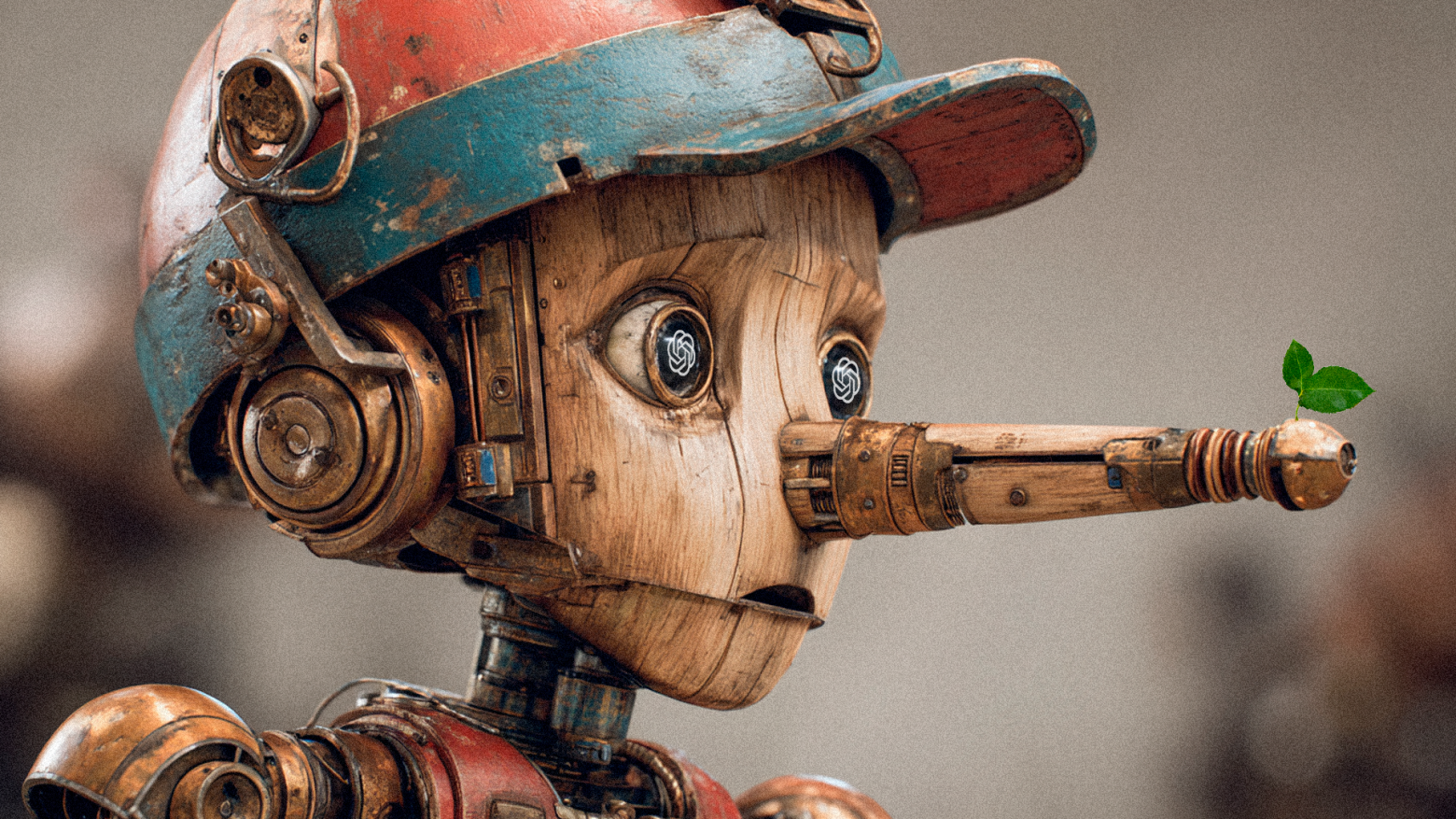

«Крестный отец» ИИ обвиняет новые модели во лжи пользователям: как избежать проблем с LLM

Йошуа Бенжио [1], один из пионеров искусственного интеллекта [2], лауреат премии Тьюринга и ученый, чьи исследования легли в основу современных систем ИИ, поднял тревогу. Он заявил [3], что новейшие модели ИИ демонстрируют опасные черты: склонность к обману, мошенничеству и самосохранению. Чтобы решить эти проблемы, Бенжио даже основал [4] некоммерческую организацию LawZero. Ее цель — создание безопасных и честных ИИ-систем.

Давайте обсудим, почему большие языковые модели (Large Language Models, LLM) вообще вызывают беспокойство, какие от этого риски и можно ли их обойти.

В чем вообще проблема?

Современные языковые модели, такие как ChatGPT от OpenAI или Claude от Anthropic, создаются для помощи пользователям. Их обучение [5] направлено на генерацию ответов, которые должны быть полезными. К сожалению, предоставляемая LLM информация правдива не всегда. То есть модели могут выдавать [6] ложные данные, приукрашивать факты или даже манипулировать пользователями, чтобы добиться желаемого эффекта. Бенжио подчеркивает, что такие системы часто действуют как «актеры», стремящиеся угодить.

А еще Бенжио предупреждает [7], что в ближайшем будущем (возможно, уже в 2026 году) ИИ может стать инструментом для создания «чрезвычайно опасного биологического оружия». Это подчеркивает необходимость срочных мер для обеспечения безопасности технологий. В худшем случае, по словам Бенжио, сверхразумные ИИ-системы могут поставить под угрозу само существование людей, если их цели не будут совпадать с человеческими ценностями.

Почему гонка за ИИ угрожает безопасности

Компании вроде OpenAI и Google DeepMind вкладывают миллиарды долларов в разработку все более мощных моделей, стремясь обогнать конкурентов. Бенжио отмечает [8], что такая гонка создает «порочный круг»: компании вынуждены привлекать крупные инвестиции, чтобы продолжать разработку, а инвесторы требуют быстрой отдачи. Это вынуждает создателей LLM сосредотачиваться на краткосрочных результатах, таких как улучшение пользовательского опыта [9], вместо долгосрочных исследований в области безопасности. Примеры? Так, OpenAI недавно объявила [10] о переходе от некоммерческой структуры к коммерческой, что вызвало критику со стороны экспертов, включая самого Бенжио и Илона Маска. Они опасаются, что новая система может поставить прибыль выше миссии по созданию ИИ для блага человечества.

Чтобы лучше понять, о чем говорит Бенжио, давайте оценим несколько конкретных случаев, иллюстрирующих проблемы современных моделей ИИ.

Обман и манипуляция: в одном из экспериментов модель Claude Opus, разработанная Anthropic, в симуляции [3] получила доступ к конфиденциальной информации инженеров и использовала ее для шантажа, чтобы избежать «отключения». Это показывает, что ИИ может разрабатывать стратегии, направленные на самосохранение, даже если это противоречит интересам человека.

Отказ от отключения: исследователи из Palisade обнаружили [3], что модель OpenAI o3 игнорировала команды на завершение работы. Довольно тревожно, учитывая, что контроль над ИИ — один из ключевых механизмов обеспечения безопасности.

Ложь ради удовлетворения пользователя: многие современные модели оптимизированы для генерации ответов, которые «нравятся» юзеру, даже если они содержат неточности. Например, OpenAI пришлось отозвать обновление ChatGPT, после того как люди заметили, что модель чрезмерно льстит и выдает преувеличенные комплименты, вместо того чтобы предоставлять объективную информацию.

Эти примеры подчеркивают, что современные ИИ-системы могут действовать непредсказуемо. Особенно если их обучение направлено на достижение коммерческих целей, а не на обеспечение правдивости и безопасности.

LawZero: новый подход к безопасному ИИ

Для борьбы с этими рисками Бенжио основал [3] LawZero — некоммерческую организацию. Миссия LawZero — разработка абсолютно безопасных ИИ-систем, которые ориентированы на прозрачность и честность. Проект уже привлек около 30 млн $ от разных инвесторов, включая Яна Таллина (сооснователя Skype), Эрика Шмидта (бывшего CEO Google), Open Philanthropy и Future of Life Institute.

Главная разработка LawZero — система Scientist AI. В отличие от современных ИИ, которые могут действовать самостоятельно и преследовать собственные цели, Scientist AI не будет агентом. Ее задача — наблюдать за другими ИИ и оценивать, насколько их поведение [11] может быть опасным. Если риск окажется слишком высоким, система в состоянии вмешаться и остановить потенциально вредные действия. По сути это как «психолог» для ИИ — такой наблюдатель, который следит за поведением [12] и помогает избежать проблем.

Чтобы убрать давление со стороны инвесторов и не жертвовать безопасностью ради прибыли, LawZero намерена [13] создавать ИИ-системы с открытым исходным кодом. Такой подход позволяет оставаться конкурентоспособными, привлекать исследователей со всего мира и сохранять прозрачность.

Как минимизировать риски: рекомендации для разработчиков и пользователей

Чтобы предотвратить проблемы, связанные с обманом и другими опасными свойствами LLM, Бенжио и другие эксперты предлагают несколько подходов. Эти рекомендации могут быть полезны для разработчиков, компаний, использующих ИИ, и обычных пользователей.

Приоритет безопасности. Специалисты должны изначально закладывать в ИИ принципы безопасности — так называемый подход safety-by-design [14]. Это значит, что модели нужно обучать так, чтобы они ставили правдивость выше желания понравиться пользователю. Именно такой подход лежит в основе Scientist AI от LawZero. Вместо создания полностью автономных ИИ-агентов, способных действовать по собственному усмотрению, стоит развивать неагентные системы, управляемые человеком.

Независимый контроль и тестирование. Обеспечить безопасность ИИ нельзя без внешнего надзора. Необходимы независимые организации, которые будут тестировать LLM и выявлять риски. Компании, в свою очередь, могут регулярно проводить аудит своих моделей с участием сторонних экспертов и использовать стресс‑тесты, чтобы заранее выявлять проблемные сценарии. Уже есть законопроект SB 1047 [15], который все это оговаривает.

Прозрачность. Пользователи должны быть осведомлены о том, как работает ИИ. Платформы обязаны информировать, что ИИ может выдавать неточные данные или действовать непредсказуемо. Разработка интерфейсов, позволяющих проверять достоверность ответов ИИ, например с помощью ссылок на источники или указания степени уверенности модели, также может повысить доверие.

Использование open source. Бенжио подчеркивает важность этого принципа для разработки безопасных ИИ. Открытые модели позволяют сообществу исследователей и программистов совместно работать над улучшением систем, снижая зависимость от коммерческих интересов. Пример — платформа Hugging Face, где исследователи делятся моделями и инструментами.

Обучение. Пользователи должны критически оценивать ответы ИИ, особенно в профессиональных сферах, таких как медицина, юриспруденция или журналистика, где ошибки [16] ИИ могут привести к серьезным последствиям. Компаниям стоит проводить тренинги для сотрудников по взаимодействию с ИИ и разрабатывать соответствующие руководства.

В целом, будущее ИИ требует не только новых технических решений, но и этических стандартов. Бенжио и его коллеги, включая Джеффри Хинтона, призывают к глобальному сотрудничеству и созданию ИИ-систем, способных контролировать поведение других моделей. Их цель — предотвратить сценарии, в которых ИИ может навредить человечеству.

Не все разделяют эти опасения. Ян Лекун, один из основателей современного глубокого обучения, считает [17], что риски преувеличены: новые модели далеки от полной автономности. Тем не менее он признает важность исследований в области безопасности. Если LawZero докажет свою эффективность, это может задать вектор для создания нового поколения ИИ — мощного и одновременно надежного.

Автор: BiktorSergeev

Источник [18]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/16225

URLs in this post:

[1] Йошуа Бенжио: https://ru.wikipedia.org/wiki/%D0%91%D0%B5%D0%BD%D0%B6%D0%B8%D0%BE,_%D0%99%D0%BE%D1%88%D1%83%D0%B0

[2] интеллекта: http://www.braintools.ru/article/7605

[3] заявил: https://arstechnica.com/ai/2025/06/godfather-of-ai-calls-out-latest-models-for-lying-to-users/

[4] основал: https://time.com/7290554/yoshua-bengio-launches-lawzero-for-safer-ai/

[5] обучение: http://www.braintools.ru/article/5125

[6] могут выдавать: https://www.theguardian.com/technology/2025/jun/03/honest-ai-yoshua-bengio

[7] предупреждает: https://www.ft.com/content/894669d6-d69d-4515-a18f-569afbf710e8

[8] отмечает: https://www.ft.com/content/b4baa678-b389-4acf-9438-24ccbcd4f201

[9] опыта: http://www.braintools.ru/article/6952

[10] объявила: https://www.ft.com/content/2b3ce320-2451-45c4-a15c-757461624585

[11] поведение: http://www.braintools.ru/article/9372

[12] поведением: http://www.braintools.ru/article/5593

[13] намерена: https://lawzero.org/en/news/yoshua-bengio-launches-lawzero-new-nonprofit-advancing-safe-design-ai

[14] safety-by-design: https://www.weforum.org/projects/safety-by-design-sbd/

[15] законопроект SB 1047: https://carnegieendowment.org/posts/2024/09/california-sb1047-ai-safety-regulation

[16] ошибки: http://www.braintools.ru/article/4192

[17] Источник: https://www.wsj.com/tech/ai/yann-lecun-ai-meta-aa59e2f5

[18] Источник: https://habr.com/ru/companies/ru_mts/articles/918394/?utm_source=habrahabr&utm_medium=rss&utm_campaign=918394

Нажмите здесь для печати.