Управление ИИ (AI Governance) в 2025: пять главных вызовов и пути их преодоления

По данным глобальных отчетов, уже 30% всех корпоративных решений в 2025 году принимаются с участием искусственного интеллекта [1] (ИИ). Инструменты ИИ активно внедряются во все сферы: они используются для оптимизации операционных и бизнес-процессов, как самостоятельные или вспомогательные продукты, а все чаще – и как системы, принимающие решения. Однако в этой гонке за эффективностью вопросы управления рисками и этические предохранители нередко отходят на второй план. Между

тем, именно сфера регулирования и этики ИИ является ключевым инструментом, позволяющим компаниям обеспечить безопасное использование AI-технологий как с технической точки зрения [2], так и в контексте соответствия требованиям контролирующих органов. Регуляторные и этические фреймворки, закрепленные на уровне законодательства и лучших отраслевых практик, в действительности определяют ландшафт внедрения новых технологий. С какими вызовами AI Governance сталкивается IT-индустрия сегодня? В этой статье мы разберем 5 ключевых проблем регулирования ИИ, алгоритмической предвзятости, безопасности нейросетей, их экологического следа и глобальной стандартизации AI.

Это авторская статья создана специально для сайта habr.com [3] будет полезна IT-специалистам, разработчикам, менеджерам проектов, юристам, а также всем, кто интересуется будущим искусственного интеллекта, его регулированием и этическими аспектами применения технологий.

Содержание:

-

Регуляторный хаос и EU AI Act

-

Проблема «чёрного ящика»: Предвзятость и Объяснимость ИИ

-

Безопасность ИИ: Новые векторы атак и методы защиты

-

«Зелёный» ИИ и глобальная стандартизация

-

Кадровый дефицит и отраслевые решения

-

Выводы

Регуляторный хаос и EU AI Act: навигация в море законов об искусственном интеллекте

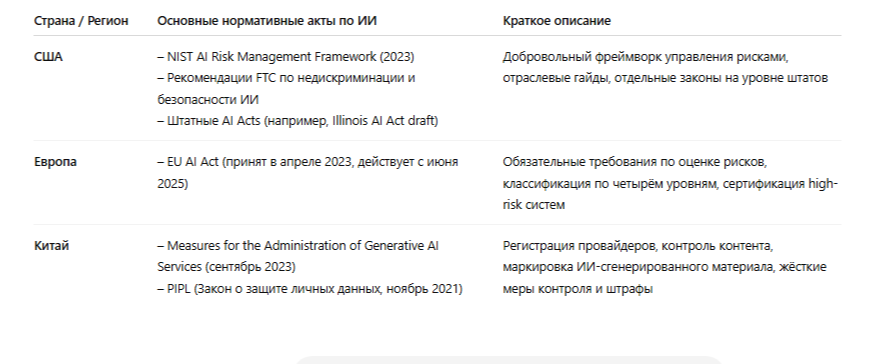

Первое, с чем сталкивается любая организация, стремящаяся внедрить ИИ на международном уровне в 2025 году, – это значительная фрагментация законодательства. Надежды на формирование единых глобальных правил для ИИ пока остаются в значительной степени нереализованными.

Европейский Союз своим AI Act, который уже активно применяется, предпринял попытку установить общие рамки. Предложенный им риск- ориентированный подход классифицирует AI-системы на четыре категории: от полностью запрещенных (например, системы социального скоринга) до тех, где достаточно соблюдения общих принципов. Этот акт, несомненно, стал важной вехой в развитии регуляторной мысли.

Однако США, Китай, Индия и другие страны не спешат слепо копировать европейский опыт [4], разрабатывая собственные подходы, основанные на балансе между стимулированием инноваций, обеспечением контроля и защитой национальных интересов. В результате компании, особенно работающие на глобальном рынке, оказываются в сложном положении: как обеспечить соответствие десяткам различных, порой противоречащих друг другу, требований? “Эффект Брюсселя”, когда европейские стандарты (как в случае с GDPR) становились де-факто глобальными, в сфере ИИ проявляется не столь однозначно. Новые нормы и правила вводятся и изменяются с высокой скоростью под влиянием технологического прогресса и политических решений, при этом устанавливаются высокие уровни ответственности для компаний, нарушающих эти нормы.

Последствия для IT-индустрии:

-

Рост затрат на комплаенс: Адаптация продуктов и бизнес-процессов к различным юрисдикциям требует значительных финансовых и временных ресурсов.

-

Правовая неопределенность: Сложность в построении долгосрочных стратегий в условиях постоянно меняющихся правил игры.

-

Барьеры для стартапов: Небольшим компаниям особенно трудно справиться с объемом юридической работы и финансовой нагрузкой, связанной с комплаенсом.

Пример из финансовой сферы: международные банковские группы вынуждены разрабатывать комплексные системы управления для одновременного соответствия требованиям EU AI Act, американских финансовых регуляторов и стандартов на азиатских рынках.

Как действовать в текущих условиях:

-

Постоянный мониторинг: Анализ изменений законодательства в приоритетных регионах и странах должен стать рутинной задачей для внутренних специалистов или привлеченных консультантов.

-

Гибкая система внутреннего аудита: Внедрение адаптивной системы внутреннего аудита AI-систем компании, основанной на релевантных фреймворках (например, NIST AI RMF, ISO/IEC 42001), становится принципиально важным.

Интеграция экспертизы на ранних этапах: Участие специалиста по регулированию ИИ на всех стадиях разработки продукта и внедрение соответствующих принципов «by design» (проектируемой ответственности) является ключевым условием успешного запуска и

реализации проектов.

Проблема «Чёрного Ящика»: Предвзятость и Объяснимость ИИ (Bias & Explainability)

Проблема «черного ящика» в 2025 году приобрела не только философский или научный [5], но и остро практический характер. Стало очевидно, что ИИ может быть столь же предвзят, как и люди, его создавшие. Это явление известно как “алгоритмическая проблема”.

Источники проблемы:

-

Предвзятость в данных (Data Bias): Если AI‑модель обучалась на данных, отражающих историческую или системную дискриминацию (например, по полу, расе, возрасту), она с высокой вероятностью будет воспроизводить эту предвзятость в своих решениях. Например, система рекрутинга, обученная на данных, где большинство инженеров — мужчины, может систематически игнорировать резюме квалифицированных женщин.

-

Субъективность разработчиков: Выбор архитектуры модели, метрик ее оценки, компромиссов между точностью и другими параметрами — все это решения, принимаемые людьми и несущие определенную долю субъективизма.

-

Неинтерпретируемость («черный ящик»): Многие современные нейросетевые модели функционируют по принципу «черного ящика». Мы видим входные данные и результат, но точный механизм принятия решения часто остается непрозрачным. Это создает серьезные

проблемы с подотчетностью и аудитом.

Влияние на разработку и применение ИИ:

-

Риски дискриминации и юридической ответственности.

-

Снижение доверия пользователей: Непрозрачность и потенциальная несправедливость решений ИИ подрывают доверие к технологии.

-

Сложности с аудитом и комплаенсом: Как продемонстрировать регулятору

корректность работы «черного ящика»?

Это особенно критично в областях, где цена ошибки [6] высока — медицина, финансы (например, кредитный скоринг), правосудие. Ошибки или дискриминационные решения AI‑систем в этих сферах могут иметь крайне серьезные последствия.

Что можно и нужно использовать для решения проблемы:

-

Инструменты интерпретации: Применение библиотек и методов для локальной и глобальной интерпретации моделей (например, LIME, SHAP), позволяющих лучше понять логику [7] их работы.

-

Дашборды для мониторинга справедливости (Fairness Dashboards): Внедрение систем для отслеживания метрик справедливости и выявления потенциальной предвзятости в реальном времени.

-

Тщательное документирование: Фиксация всех ключевых решений, принятых при выборе данных, алгоритмов и конфигурации моделей, для обеспечения прозрачности и возможности последующего аудита.

Безопасность ИИ: новые угрозы и методы защиты от злоупотреблений

С ростом возможностей ИИ увеличиваются и риски его использования в злонамеренных целях, а также появляются новые уязвимости самих AI- систем. Кибербезопасность в 2025 году выходит на новый уровень сложности, требуя адаптации существующих подходов.

Актуальные угрозы:

-

Уязвимости AI-платформ и моделей: Мы уже являемся свидетелями атак (например, prompt injection в AI-ассистентах), в ходе которых злоумышленники обходят защитные механизмы и получают доступ к конфиденциальным данным или возможность манипулировать функциями системы.

-

Состязательные атаки (Adversarial Attacks): Это целенаправленное искажение входных данных таким образом, чтобы человек не заметил изменений, но AI-модель приняла неверное решение. Это может быть “отравление” данных (data poisoning) на этапе обучения [8] модели или манипуляция данными “на лету”. Последствия могут быть критичными,

например, для систем распознавания лиц, беспилотного транспорта или медицинской диагностики. -

ИИ как инструмент для атак: Сам ИИ активно используется для создания более изощренных фишинговых кампаний, генерации дипфейков для дезинформации и мошенничества, а также для автоматизированного поиска уязвимостей в системах.

Задачи для AI Governance в сфере безопасности:

-

Разработка специализированных протоколов защиты ИИ: Требуются новые методики и инструменты, выходящие за рамки традиционной кибербезопасности и учитывающие специфику AI-систем.

-

Обеспечение устойчивости (resilience) и надежности (robustness) AI- моделей к различным видам атак и манипуляций.

-

Внедрение принципов “Security by Design” (проектируемой безопасности) на всех этапах жизненного цикла ИИ.

Финансовый сектор, оперирующий огромными объемами чувствительных данных и являющийся важной частью критической инфраструктуры, представляет собой одну из главных мишеней. Компрометация AI-систем, отвечающих за противодействие мошенничеству или управление рисками, может привести к серьезным финансовым и репутационным потерям.

Практические шаги для усиления безопасности:

-

Внедрение состязательного тестирования (Adversarial Testing): Эмуляция атак на ваши AI-модели для выявления уязвимостей и оценки их устойчивости.

-

Регулярное обновление и патчинг: Своевременное применение обновлений безопасности для используемых AI-платформ и библиотек.

-

Определение ролей и ответственности: Назначение ответственного за безопасность ИИ (AI Security Officer) и разработка плана реагирования [9] на инциденты (Incident Response Plan), специфичного для AI-систем.

«Зелёный» ИИ и поиск глобальных стандартов управления

Два на первый взгляд различных, но тесно взаимосвязанных вызова – это растущее энергопотребление ИИ и дефицит глобальной координации в его стандартизации.

Энергетический аппетит ИИ:

-

Обучение и эксплуатация крупных AI-моделей требуют колоссальных объемов электроэнергии. По оценкам 2025 года, совокупное энергопотребление IT-индустрии, связанное с ИИ, сопоставимо с энергопотреблением целых стран. Это не только вопрос операционных затрат, но и серьезный экологический вызов, учитывая углеродный след

от производства этой энергии. -

Ведущие технологические компании инвестируют миллиарды в собственную энергетическую инфраструктуру, включая проекты в области атомной энергетики, чтобы обеспечить потребности [10] своих AI- инициатив.

-

Системы AI Governance должны теперь включать оценку экологического воздействия и стимулировать [11] разработку так называемого “зеленого ИИ” (Green AI) – более энергоэффективных алгоритмов, аппаратных решений и практик эксплуатации.

Проблема глобальной стандартизации:

-

Несмотря на усилия международных организаций (таких как ООН и ОЭСР), единых общепринятых мировых стандартов для AI Governance до сих пор не существует. Каждая страна и регион стремятся продвигать свои подходы, что усугубляет регуляторную фрагментацию, о которой говорилось в первой части.

-

Это препятствует международному сотрудничеству, обмену данными и технологиями, а также создает риски “гонки ко дну” (race to the bottom), когда компании могут выбирать юрисдикции с наименее строгим регулированием.

-

Необходим поиск компромиссов и создание гибких, но признанных на международном уровне рамок для ответственного развития и применения ИИ.

Эти два аспекта тесно связаны: например, международные стандарты могли бы включать требования к энергоэффективности ИИ и методики оценки его экологического следа. Отсутствие же глобальной координации затрудняет решение этой общемировой проблемы.

Рекомендации по внедрению устойчивых практик:

-

Ориентация на существующие стандарты: Стандарт ISO/IEC 42001 (Системы менеджмента ИИ) предлагает первые рамки для управления ИИ, которые могут включать аспекты устойчивого развития и экологической ответственности.

-

Внедрение метрик “Green AI”: Включение показателей энергоэффективности и экологического воздействия в ключевые показатели эффективности (KPI) AI-проектов.

-

Поддержка открытых инициатив: Участие в инициативах Open Data и Federated Learning, которые могут способствовать снижению дублирования вычислительных затрат на обучение моделей.

Кадровый дефицит и отраслевые решения в регулировании ИИ

Рассмотрев основные глобальные вызовы, важно обратить внимание [12] на практические аспекты реализации AI Governance и перспективы развития этой области.

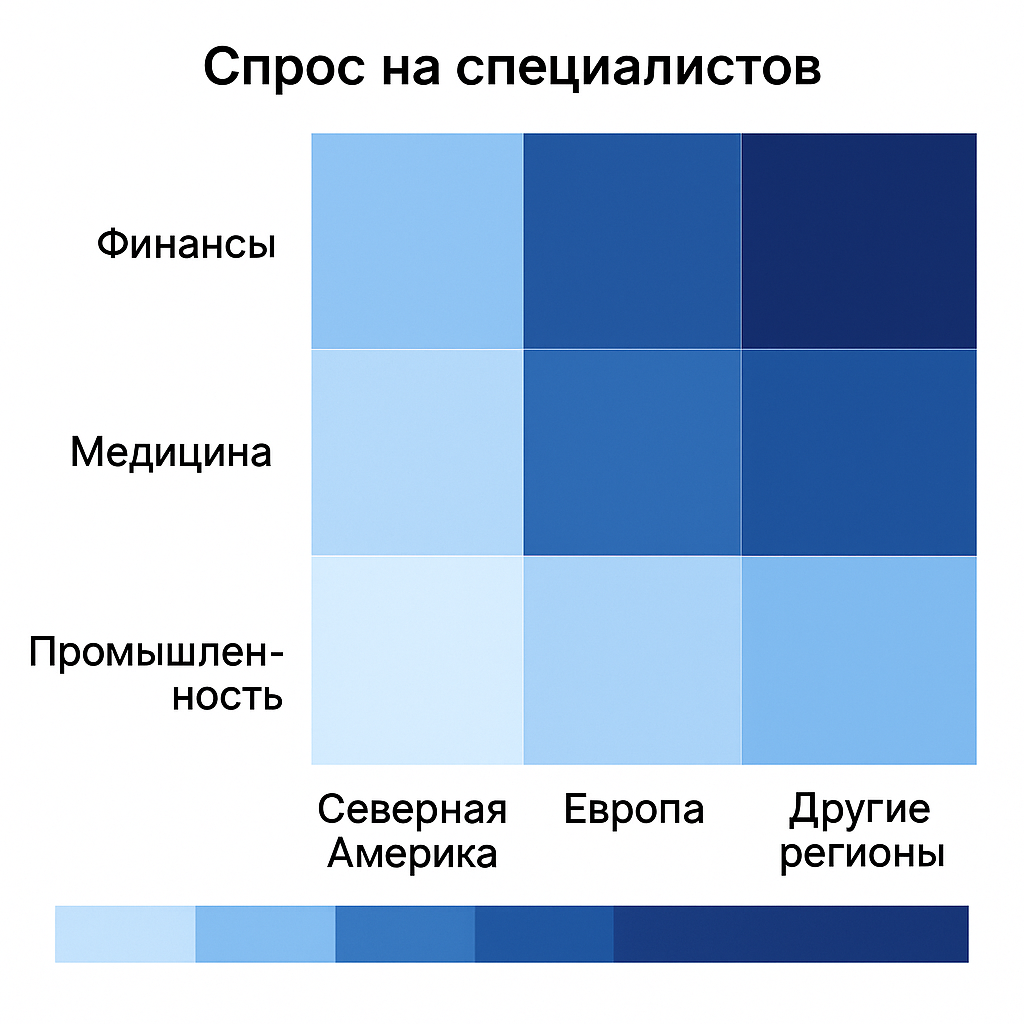

Отраслевая специфика:

Общие принципы AI Governance требуют адаптации к особенностям каждой конкретной отрасли. Например, в финансовом секторе на передний план выходят требования к справедливому кредитованию, противодействию отмыванию денег (AML) и управлению модельными рисками. В здравоохранении – вопросы приватности пациентов, точности диагностики и этики применения ИИ в лечебном процессе. В промышленности – безопасность ИИ на производстве, его влияние на занятость и вопросы интеллектуальной собственности.

Кадровый вопрос:

Одной из главных проблем 2025 года остается дефицит квалифицированных специалистов в области регулирования ИИ. Существует острая нехватка профессионалов, обладающих

междисциплинарными компетенциями на стыке IT, права, этики и управления рисками. Спрос на позиции AI Governance Analyst, AI Ethics Officer, AI Compliance Manager значительно превышает предложение на рынке труда. Это требует активного развития новых образовательных программ и систем профессиональной переподготовки.

Перспективные решения и стратегии

Несмотря на все сложности, индустрия и научное сообщество активно

работают над их преодолением:

-

Разработка технологических инструментов: Создаются и совершенствуются фреймворки для тестирования ИИ на устойчивость, предвзятость и безопасность, инструменты для повышения интерпретируемости моделей, а также комплексные платформы для управления жизненным циклом ИИ с учетом требований governance.

-

Внедрение управленческих подходов: Компании все активнее разрабатывают и внедряют внутренние политики и этические кодексы для ИИ, формируют специализированные комитеты по этике и интегрируют принципы ответственной разработки (Responsible AI) в

свои бизнес-процессы. -

Стандартизация и сертификация: Появляются и получают распространение отраслевые и международные стандарты (например, упомянутый ISO/IEC 42001), которые помогают компаниям структурировать и систематизировать их деятельность в области AI Governance.

-

Развитие образовательных инициатив: Растет число курсов, магистерских программ и профессиональных сертификаций, направленных на подготовку специалистов по управлению искусственным интеллектом.

Заключение: регулирование ИИ – марафон, а не спринт

Ландшафт AI Governance в 2025 году характеризуется высокой сложностью и динамизмом. Мы наблюдаем переплетение регуляторных, технических, этических и кадровых вызовов, требующих комплексных и адаптивных решений.

Однако эти вызовы не должны рассматриваться как непреодолимые препятствия, а скорее как стимул к дальнейшему развитию и совершенствованию подходов к управлению ИИ. Успешное внедрение искусственного интеллекта требует системного мышления [13], междисциплинарных знаний и готовности к постоянному обучению и адаптации. Организации, которые смогут выстроить эффективные и гибкие системы AI Governance, не только минимизируют сопутствующие риски, но и откроют для себя новые возможности для инноваций и достижения лидерских позиций в эпоху цифровой трансформации.

Это непрерывный процесс, и его успех зависит от совместных усилий разработчиков, исследователей, юристов, предпринимателей и всего общества.

Спасибо за внимание! Какие из этих пяти вызовов вы считаете наиболее актуальными для вашей работы или индустрии в целом? Делитесь своим мнением и опытом в комментариях!

Вячеслав Гасюнас

Эксперт по AI Governance и защите данных

Автор: Gasiunas

Источник [14]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/16453

URLs in this post:

[1] интеллекта: http://www.braintools.ru/article/7605

[2] зрения: http://www.braintools.ru/article/6238

[3] habr.com: http://habr.com

[4] опыт: http://www.braintools.ru/article/6952

[5] научный: http://www.braintools.ru/article/7634

[6] ошибки: http://www.braintools.ru/article/4192

[7] логику: http://www.braintools.ru/article/7640

[8] обучения: http://www.braintools.ru/article/5125

[9] реагирования: http://www.braintools.ru/article/1549

[10] потребности: http://www.braintools.ru/article/9534

[11] стимулировать: http://www.braintools.ru/article/5596

[12] внимание: http://www.braintools.ru/article/7595

[13] мышления: http://www.braintools.ru/thinking

[14] Источник: https://habr.com/ru/articles/920386/?utm_source=habrahabr&utm_medium=rss&utm_campaign=920386

Нажмите здесь для печати.