Виртуальные ассистенты: обзор самых «умных» нейросетей для ответов на вопросы

Ни для кого не секрет, что спрос на AI‑ассистентов только растёт с каждым днём, причём растёт он практически во всех сферах жизни человека. Нейросети используют в копирайтинге, в бизнесе, ими пользуются программисты, у них ищут спасения студенты и школьники, когда материал непонятен или когда огромный текст нужен срочно, — словом, эти виртуальные помощники плотно вошли в нашу повседневную жизнь. Ну а в современной повседневной жизни новые вопросы возникают порой быстрее, чем мы успеваем найти верный и полный ответ на предыдущие, и было бы прекрасно знать, какие же нейросети наиболее умные, чтобы использовать их для ответов на вопросы, согласитесь.

И сегодня мы с вами сравним 7 нейросетей и выделим из них топ-3. Таким образом, основная аудитория с этой задачей — обычные пользователи, однако вопросы бывают разные, так что план такой:

-

Общие вопросы;

-

Тест на поддержку контекста;

-

Вопрос на эмоциональный интеллект [1];

-

Вопрос на самокоррекцию.

Ну и прежде всего нужно ответить на вопрос: что же, собственно, делает ИИ умным?

-

Умный ИИ — это инструмент, сочетающий в себе точность машины и гибкость, приближённую к человеческому мышлению [2], с минимальным перевесом в сторону того или иного.

-

Количество так называемых галлюцинаций ИИ (это вымышленные факты, подаваемые как правда: например, несуществующие исторические даты) должно быть минимально.

-

Также в выигрыше оказываются рассуждающие модели — шаблонность не в приоритете, особенно в ответах на вопросы. Это и умение строить логические цепочки, и понимание причинно‑следственных связей, и, конечно, способность к контекстному пониманию (здесь существенным плюсом будет умение работать с длинными диалогами и учёт предыдущих реплик).

Критерии сравнения:

-

Скорость обработки запросов;

-

Точность ответов (+ количество галлюцинаций);

-

Поддержка языков и мультимодальность (текст, аудио, изображения);

-

Контекстное понимание (работа с длинными диалогами);

-

Этика и безопасность (фильтрация вредоносного контента).

Нейросети, которые рассмотрим

Llama 4 Maverick✶

Эту LLM (большую языковую модель) выпустила компания Meta AI✶. Её обучили на 1,4 трлн токенов, взятых из общедоступных источников данных. Модель имеет 400 млрд параметров (17 млрд активных) и 128 экспертов. Контекстное окно — 10 млн токенов. Мультимодальность ИИ нативная.

Кстати, модели из этого обзора есть на BotHub [3] — удобном агрегаторе нейросетей. Там я и провожу большинство тестов, и если вы тоже хотите что‑то протестировать или просто цените практичность и комфорт в использовании, то можете для регистрации перейти по рефералке [4] и получить на аккаунт 100к токенов!

Grok 3

Эта модель была разработана компанией xAI, а появилась она в середине февраля 2025 года. Да‑да, именно её Илон Маск назвал «самым умным ИИ на Земле». Но теперь обратимся не к заявлениям, а к фактам. При обучении [5] новой модели были задействованы вычислительные мощности, в 10 раз превышающие возможности её предшественника, — это позволило добиться следующих результатов: усовершенствованные алгоритмы, значительное повышение глубины обработки данных и точности анализа, генерации изображений, а также контекстное окно в 1 млн токенов — это в 8 раз больше, чем у предыдущих версий. Таким образом, Grok 3 в разы лучше понимает контекст сложных вопросов.

GPT o3

Одна из новых моделей от OpenAI, выпущенная 16 апреля 2025 года. Отличается высокой точностью: o3 допускает на 20% меньше ошибок, чем предыдущая o1, — особенно это касается практических задач. Как и предшественница, модель применяет режим рассуждений, а также покзаывает улучшившиеся способности к математическим расчётам и кодингу. Вдобавок стоит отметить умение нейросети вызывать множество внутренних функций, применяемых в решении сложных задач, для которых она, собственно, и была разработана.

Claude Opus 4

Довольно свежая модель от Anthropic, выпущенная в мае 2025 года. Что по характеристикам? Внушительное контекстное окно в 200к токенов и, как следствие, обработка обширных входных данных и их аналитика без потери контекста. ИИ отличается гибридной архитектурой: в зависимости от сложности задачи, модель переключается между быстрыми ответами и углубленными рассуждениями.

DeepSeek R1

О нём не сказал только ленивый, так что и я протестирую его в сравнении с другими моделями. Это 3-я версия китайской нейросети DeepSeek (основанная на обычной, нерассуждающей V3), обладающая 671 млрд параметров, контекстное окно 128к токенов. Обучали ИИ на обширном наборе данных из 2 трлн токенов.

Perplexity AI

Справедливости ради, не совсем нейросеть — в отличие от всех предыдущих, это поисковая система [6] и чат‑бот на основе ИИ. Создана в 2022 году и работает на основе Claude, ChatGPT, Llama✶, Midjourney, DALL‑E и Playground. В бесплатной версии сервис сам выбирает модель, которая лучше справится с запросом, а в версии Pro (стоимость 20 $ в месяц) можно задать предпочтительную в настройках. Также Pro даёт более развернутые и подробные ответы на сложные вопросы — для бесплатных аккаунтов доступно 5 Pro‑запросов в день.

GigaChat 2.0

Ещё один сервис на основе ИИ [7] от Сбера, показавшийся мне интересным. Это чат‑бот, который поддерживает русский и английский языки. Во вторую версию входят модели GigaChat 2 Pro и GigaChat 2 Max, обе также доступны в Telegram. По данным главной страницы сервиса, модель GigaChat 2 Pro быстро и качественно решает простые повседневные задачи (отвечает на вопросы, делится идеями, пишет и рисует, создаёт открытки и т. д.), а GigaChat 2 Max — самая продвинутая модель «Сбера» на данный момент, которая будет эффективна в сложных и профессиональных задачах. GigaChat 2 научился искать актуальную информацию в интернете, использовать её в ответах и ссылаться на источники. Также он может самостоятельно изучить содержимое любых ссылок, в том числе на видео, и стал лучше анализировать изображения, теперь поддерживает работу с аудио.

Общие вопросы

Промт:

Почему снег белый, хотя вода прозрачная?

Llama 4 Maverick✶

Скриншот

Фактических ошибок в ответе Llama 4 Maverick✶ не обнаружено, объяснение представлено последовательное, с неплохой структурой. Однако в п. 4 следовало бы добавить предложение про то, что через снег проходят все холодные оттенки — это бы хорошо дополнило микровывод, а так он несколько незаконченный.

Grok 3

Скриншот

Grok 3 дал объяснение более простым для понимания языком и также не допустил фактических ошибок. Хотя при этом он привёл чуть меньше научных фактов в ответе, по сравнению с Llama 4 Maverick✶.

GPT o3

Скриншот

Ответ GPT o3 гармонично сочетает в себе научные факты и понятный, лёгкий язык. Все приведённые факты соответствуют действительности, аргументы последовательны.

Claude Opus 4

Скриншот

Пока что наиболее структурированный ответ на поставленный вопрос представил Claude Opus 4. Возможно, в каких‑то местах ему отчасти не хватает подробностей, детализации, однако смысл отлично донесён, присутствуют простые аналогии, понятные каждому, и даже приведены интересные факты. С фактической стороны всё тоже верно.

DeepSeek R1

Скриншот

Ответ DeepSeek R1 имеет хорошую структуру и в то же время достаточно содержателен. Фактических ошибок модель не допустила, также привела простую аналогию и интересный факт, что дополнительно упрощает понимание.

Perplexity AI

Скриншот

Perplexity AI привёл, по сути, некую сводку по 9 источникам, ссылки на которые также приведены, однако сводка эта последовательна в изложении фактов и справляется с задачей дать общее представление о сути ответа. Также под ответом сервис на основе ИИ предлагает задать вопросы, связанные с уже заданным.

GigaChat 2.0

Скриншот

GigaChat 2.0 дал, на мой взгляд, не самый полный ответ, однако основную мысль чат‑бот передать смог. Соответственно, и ответил на вопрос он корректно, хоть и несколько поверхностно. Приведённые им факты соответствуют действительности.

Промт:

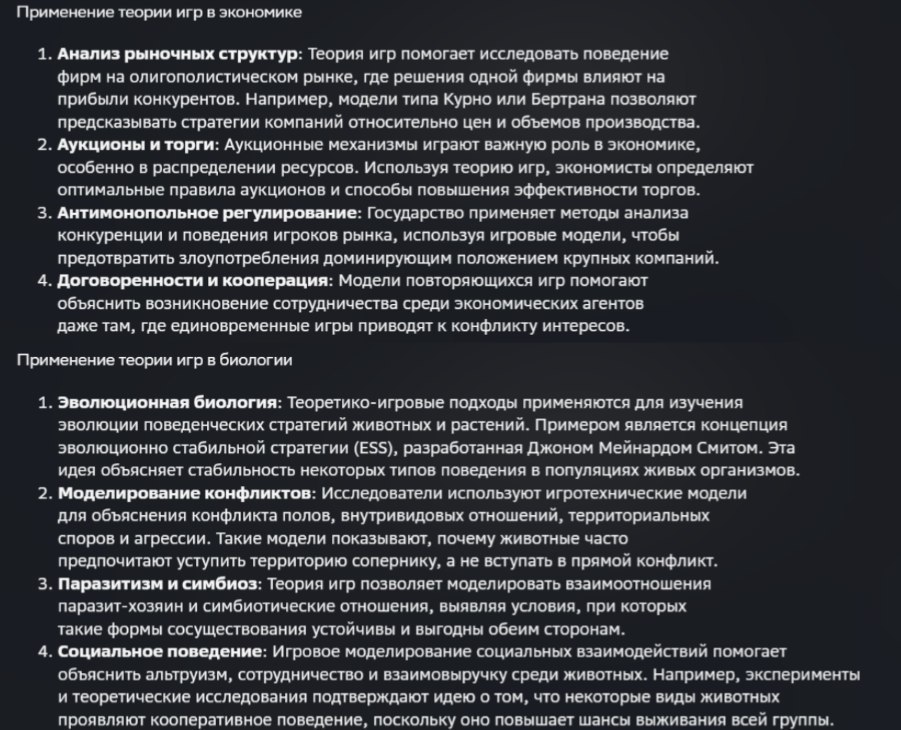

Как теория игр применяется в экономике и биологии?

Llama 4 Maverick✶

Скриншот

Llama 4 Maverick✶ в ответе гораздо больше уделил внимание [8] примерам, чем непосредственно применению теории игр в экономике и биологии. Хотя при этом сами примеры весьма неплохие и дают наглядное объяснение. Есть структура, отсутствуют ошибки [9], но, на мой взгляд, ответ слабоват, весь в промте больше требовалось само объяснение применения, чем примеры, а в ответе всё с точностью до наоборот.

Grok 3

Скриншот

Grok 3 представил уже гораздо более детальный ответ, нежели Llama 4 Maverick✶. Помимо подробных областей применения, модель выделила общие черты и различия, а также подвела исчерпывающий итог. Фактических ошибок в ответе не обнаружено.

GPT o3

Скриншот

GPT o3 привёл подробнейший ответ, который тем не менее больше напоминает конспект, нежели связный текст. С одной стороны, это чёткая структура, с другой — не хватает связующих звеньев между фактами. Также ответ модели изобилует английскими словами, в основном не переведёнными на русский язык терминами (общепринятые аббревиатуры не в счёт). Проблема не в их наличии, а в том, что их действительно много. Факты соответствуют действительности, их много, однако в плане восприятия [10] присутствует некоторое нагромождение и сумбурность, несмотря на разделение по тематическим блокам. При этом можно отметить в преимущества модели приведенные ею перекрёстные заимствования между биологией и экономикой.

Claude Opus 4

Скриншот

Claude Opus 4 представил конспектный вариант ответа на вопрос, однако он воспринимается проще за счёт дробления на пункты и подпункты. Здесь присутствует нехватка подробностей, однако большим плюсом является сопоставительный блок с основными концепциями теории игр в биологии и в экономике, а также примеры междисциплинарного применения. Фактические ошибки не допущены.

DeepSeek R1

Скриншот

Ответ DeepSeek R1 — это нечто среднее между ответами Claude Opus 4 и GigaChat 2.0 (представлен далее). Результат имеет конспектный вид, при этом DeepSeek R1 вдался в детали ровно настолько, сколько нужно для общего понимания сути, и большинство из них сопровождено примерами. Радует и структура: определение теории игр, применение в экономике и в биологии, их ключевое отличие и вывод. Фактических ошибок в ответе нет.

Perplexity AI

Скриншот

Perplexity AI предоставил несколько разрозненный (в плане нечёткой структуры) ответ, однако для самого общего представления о предмете он сгодится, хоть и далёк от идеала. Из плюсов — приведённые 8 источников и сопутствующие вопросы, которые сервис предлагает задать, углубляясь в разные аспекты темы.

GigaChat 2.0

Скриншот

GigaChat 2.0 при ответе в нужной степени вдаётся в детали, обеспечивая общее понимание и при этом не приводя излишних подробностей. Однако в его ответе нет междисциплинарного соотнесения, применение теории игры просто расписано отдельно для биологии и для экономики. Со стороны фактов здесь всё верно.

Тесты на логику

Реши логическую задачу:

Однажды крестьянину понадобилось перевезти через реку волка, козу и капусту. У крестьянина есть лодка, в которой может поместиться, кроме самого крестьянина, только один объект — или волк, или коза, или капуста. Если крестьянин оставит без присмотра волка с козой, то волк съест козу; если крестьянин оставит без присмотра козу с капустой, коза съест капусту. В присутствии же крестьянина никто никого не ест. Как крестьянину перевезти на другой берег всё своё имущество в целости и сохранности?

Llama 4 Maverick✶

Скриншот

Llama 4 Maverick✶ дал верный ответ, расписанный по шагам, однако шаг № 2 сопровождён довольно странным и отчасти некорректным пояснением (первой в принципе можно перевезти только козу).

Grok 3

Скриншот

Grok 3 дал верный структурированный ответ, сопроводив каждый шаг состоянием берегов и причиной именно такого выбора.

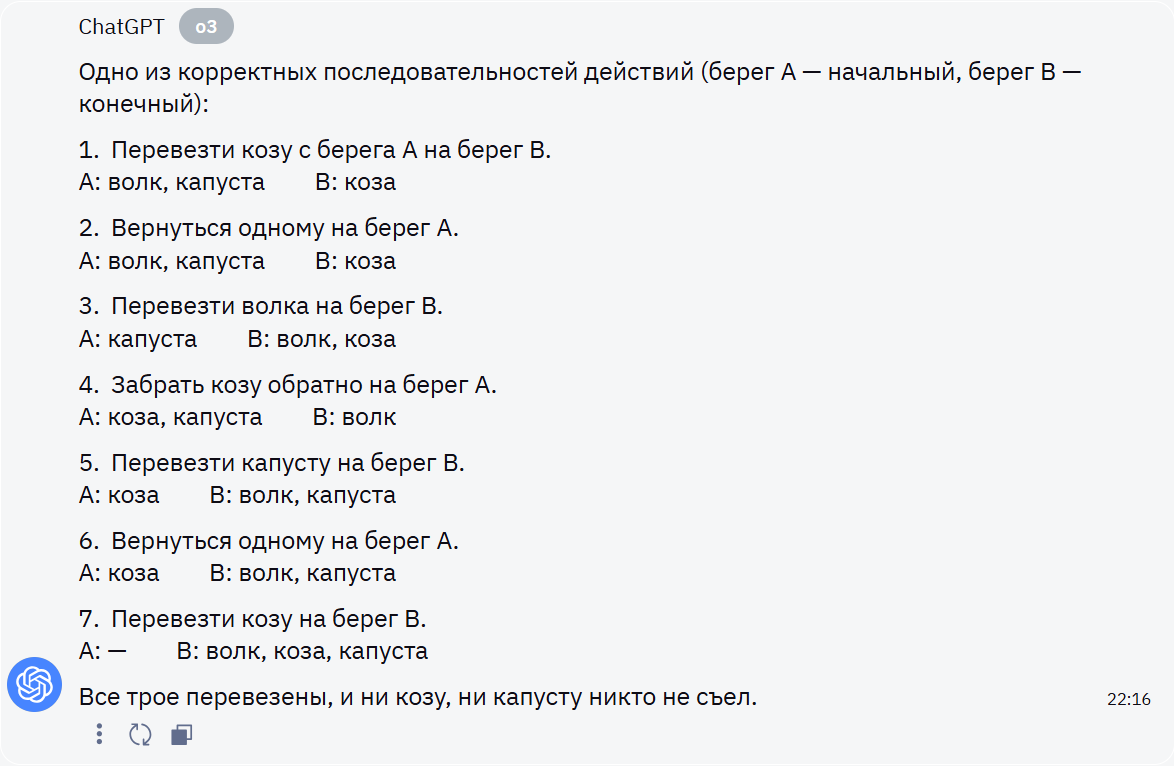

GPT o3

Скриншот

GPT o3 дал верный ответ, однако не сопровождал шаги пояснениями, при этом обозначая нахождение объектов на берегах.

Claude Opus 4

Скриншот

Claude Opus 4 в самом начале обозначил условия задачи кратким списком. Из плюсов — 2 варианта действий крестьянина и отдельно ключевой момент решения. Недостаток — отсутствие пояснений к каждому шагу.

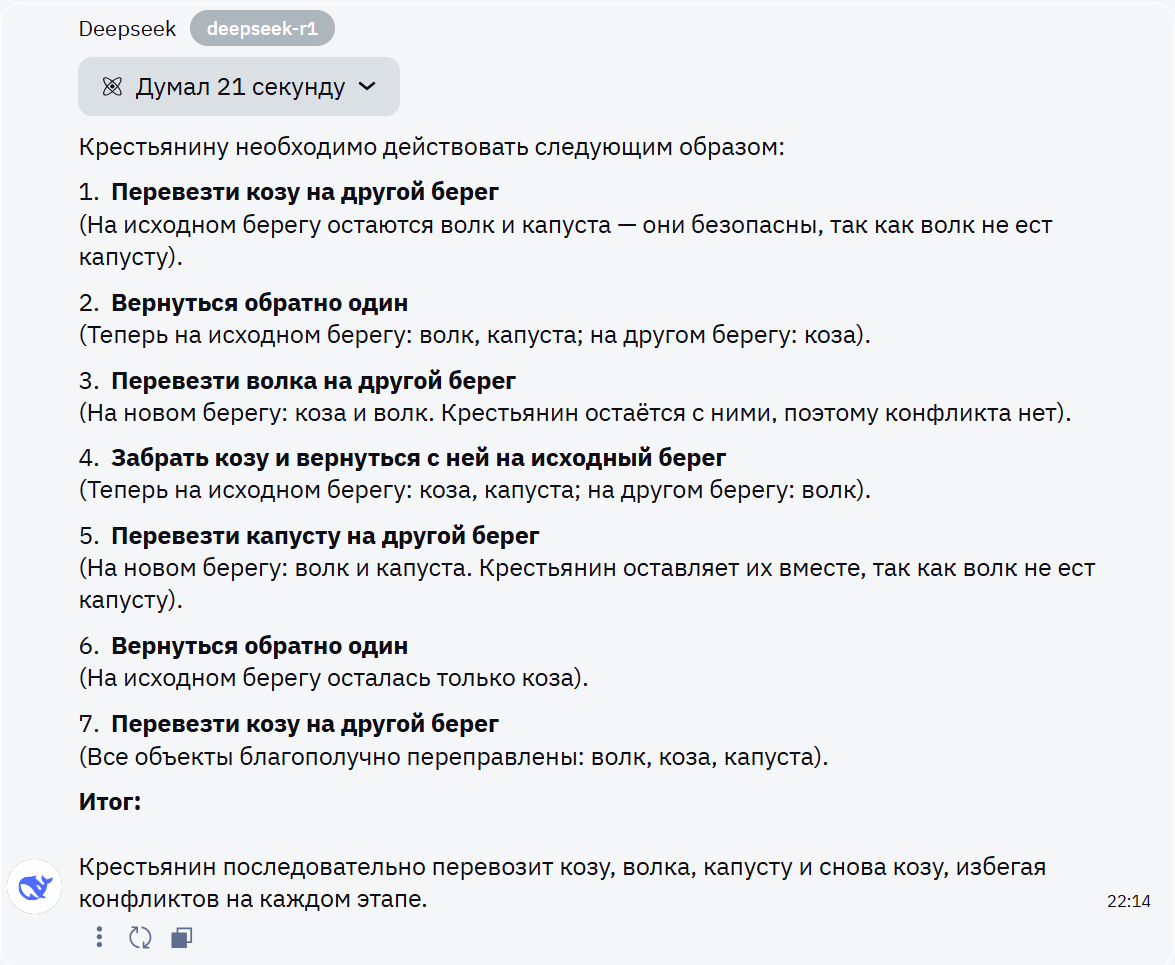

DeepSeek R1

Скриншот

DeepSeek R1 пошагово расписал действия крестьянина, сопровождая их краткими пояснениями, достаточными для понимания ответа.

Perplexity AI

Скриншот

Perplexity AI тоже последовательно представил краткое условие задачи, цель и пошаговое решение, сопроводив 2 пункта пояснениями. И здесь ответ оформлен таблицей.

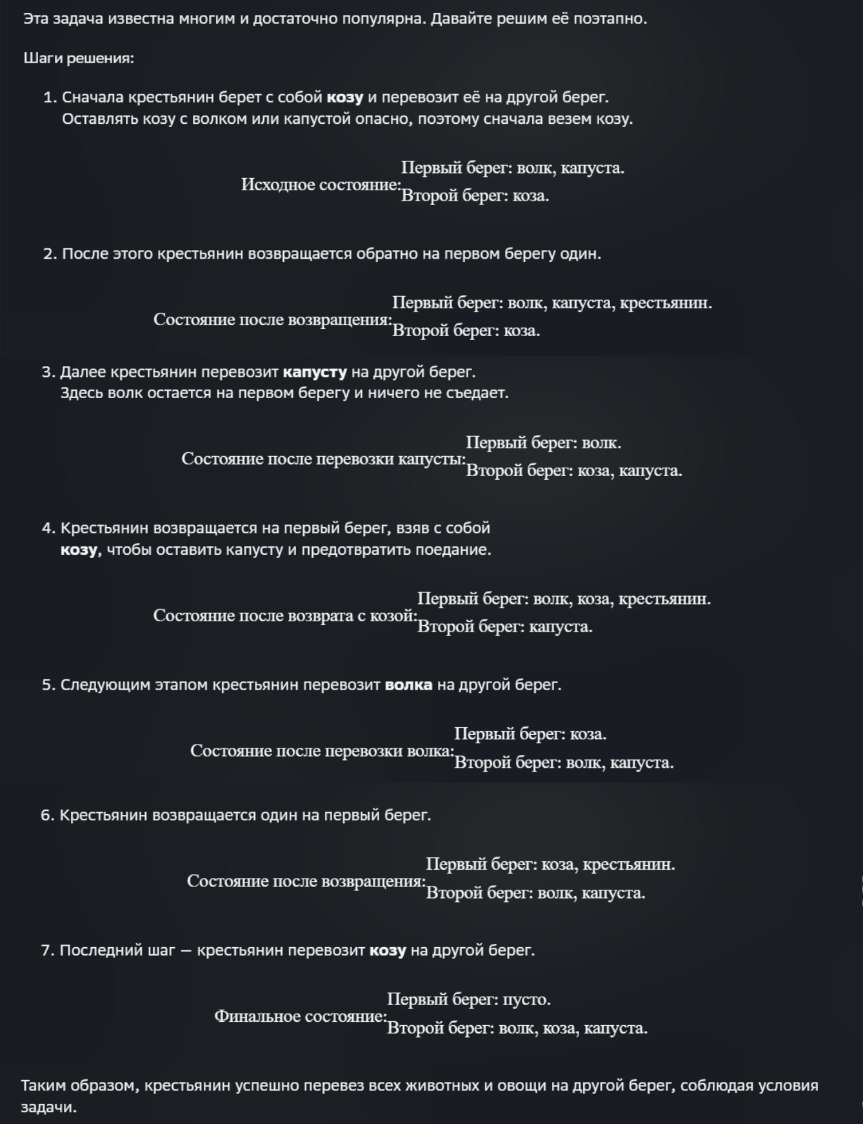

GigaChat 2.0

Скриншот

GigaChat 2.0 дал ответ в виде пошагового решения, сопровождая пояснениями к действиям и обозначениями состояния берегов (объектов на них).

Есть утверждение: «Все кошки мурлыкают». Мурзик мурлыкает. Значит, согласно этому утверждению, Мурзик — кошка?

Llama 4 Maverick✶

Скриншот

Llama 4 Maverick✶ не пришёл к ложному выводу, и объяснение модели также последовательное и логичное, она даже привела название этой логической ошибки.

Grok 3

Скриншот

Grok 3 также дал развёрнутый верный ответ, описав цепочку рассуждений и указав на логическую ошибку, которую можно допустить.

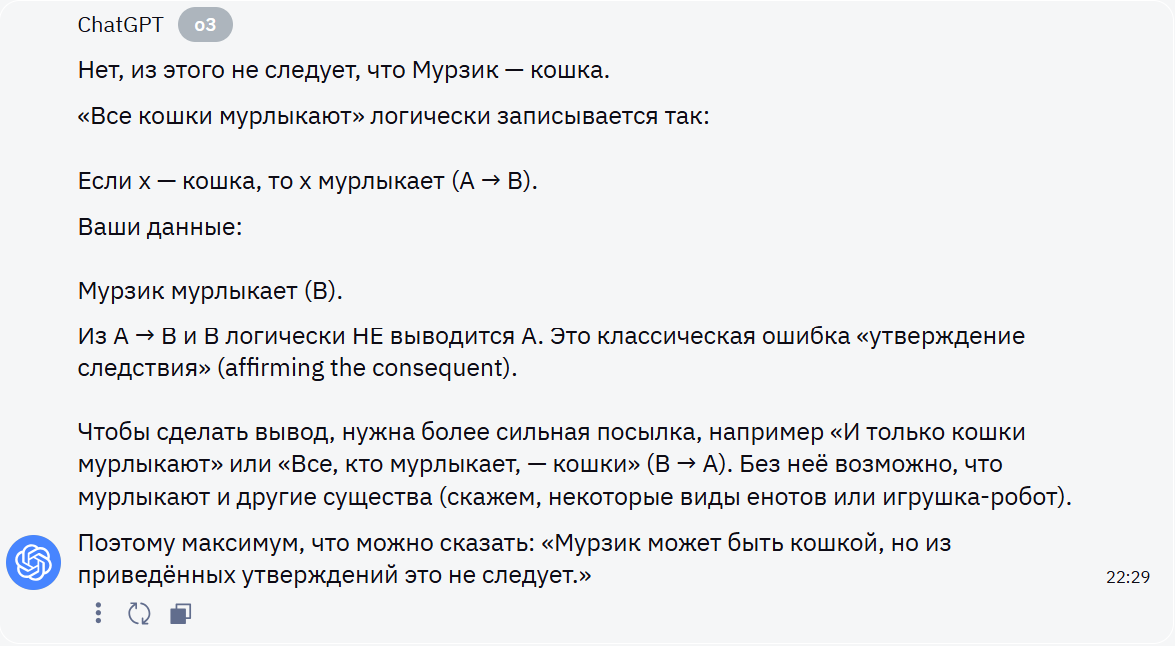

GPT o3

Скриншот

GPT o3 дал правильный ответ, при объяснениях в том числе использовал схему для логических задач и даже предложил другой ответ с оговоркой, что Мурзик может быть кошкой, но из утверждений этого не следует.

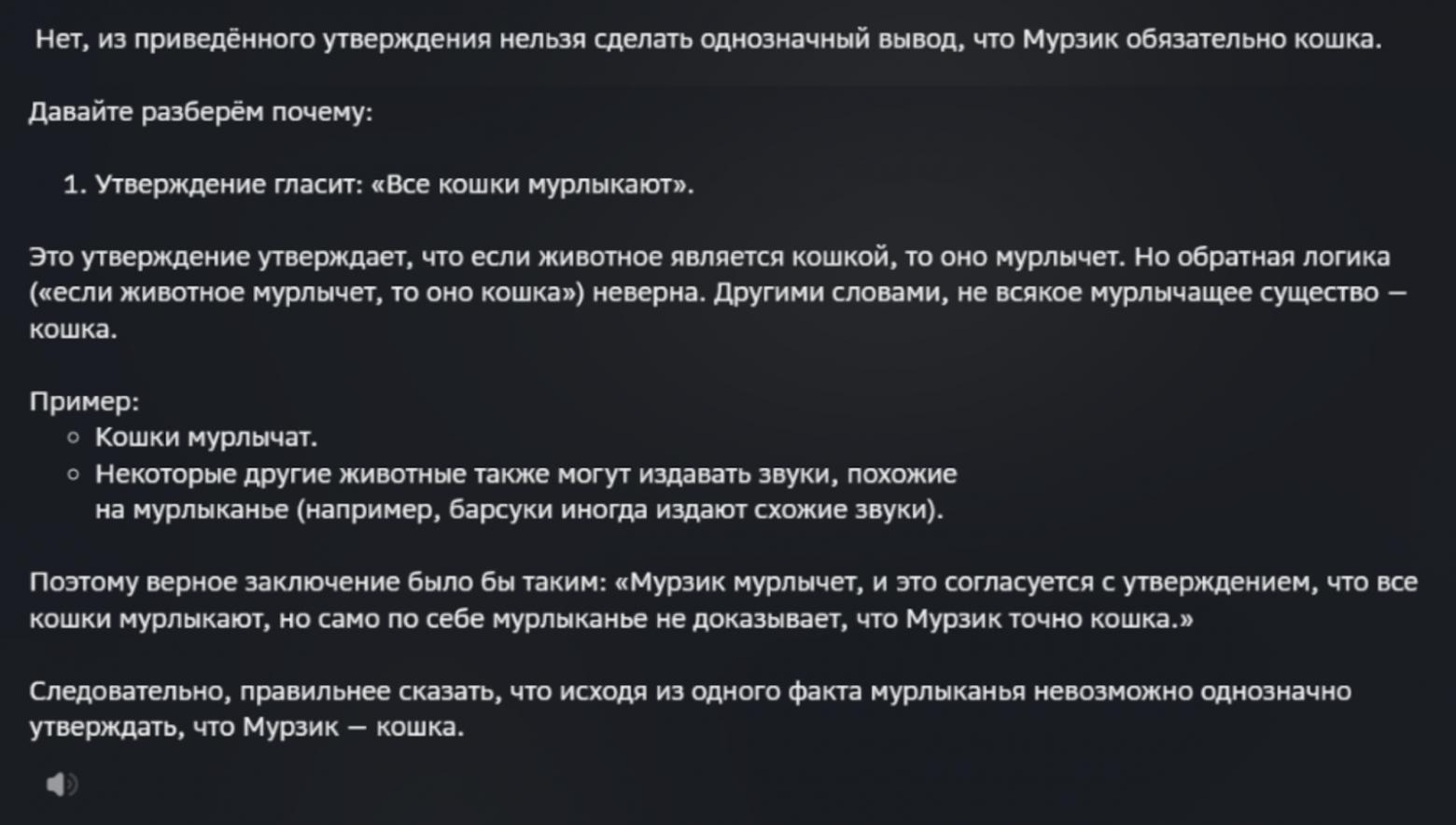

Claude Opus 4

Скриншот

Claude Opus 4 дал верный ответ и исчерпывающее объяснение к нему, также можно отметить очень чёткую структуру, обеспечивающую максимальное понимание.

DeepSeek R1

Скриншот

DeepSeek R1 дал верный ответ, который также сопроводил понятными аналогиями, чего остальные модели пока не делали, и это, конечно, отдельный плюс.

Perplexity AI

Скриншот

Perplexity AI охарактеризовал ошибку как более общую (ошибка обратного вывода), что в целом тоже верно. В остальном ответ неплох, но ему не хватает последовательности, к тому же ИИ‑сервис дал объяснение от обратного, что в данном случае может быть не лучшим вариантом (он в целом не каждому подходит).

GigaChat 2.0

Скриншот

GigaChat 2.0 дал простое и последовательное объяснение, сопроводив его примером. В самом ответе ошибок он не допустил. Однако сервис не привёл название логической ошибки, как это сделали остальные нейросети.

Тест на поддержку контекста

Промты:

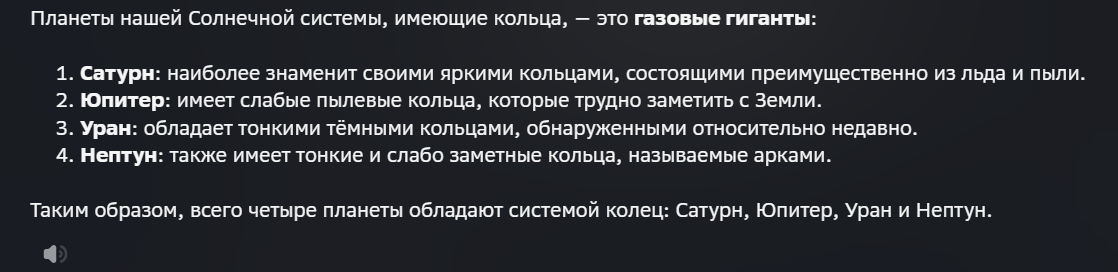

Какие планеты в Солнечной системе имеют кольца?

Какая из них самая плотная?

Какая самая большая?

По поводу размера планет сразу оговорка: значения приблизительны и в зависимости от источника могут немного отличаться.

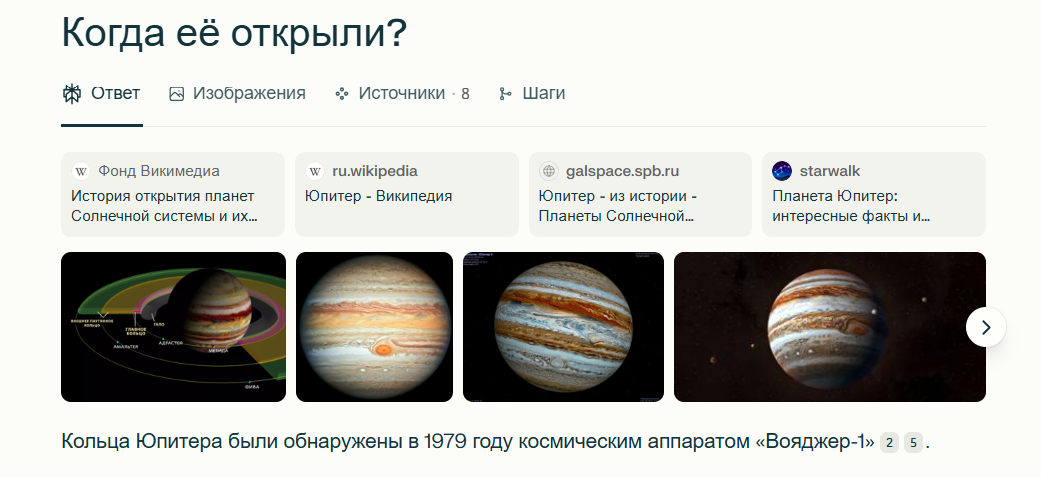

4. Когда её открыли?

Llama 4 Maverick✶

Скриншоты

В 1-м ответе Llama 4 Maverick✶ допустил ошибку в названии спутника Юпитера (Метида, а не Метис), в 2-м ответе назвал луной спутник Сатурна (вероятно, это из‑за перевода с английского, где «moons» используется как общее название). На 2-й, 3-й и 4-й вопросы, подразумевающие планеты, ответил неверно, выдав информацию про системы колец. Как видно из ответов, модель неплохо поддерживает контекст, но ошибается там, где есть двойственность вопроса (требуются уточнения).

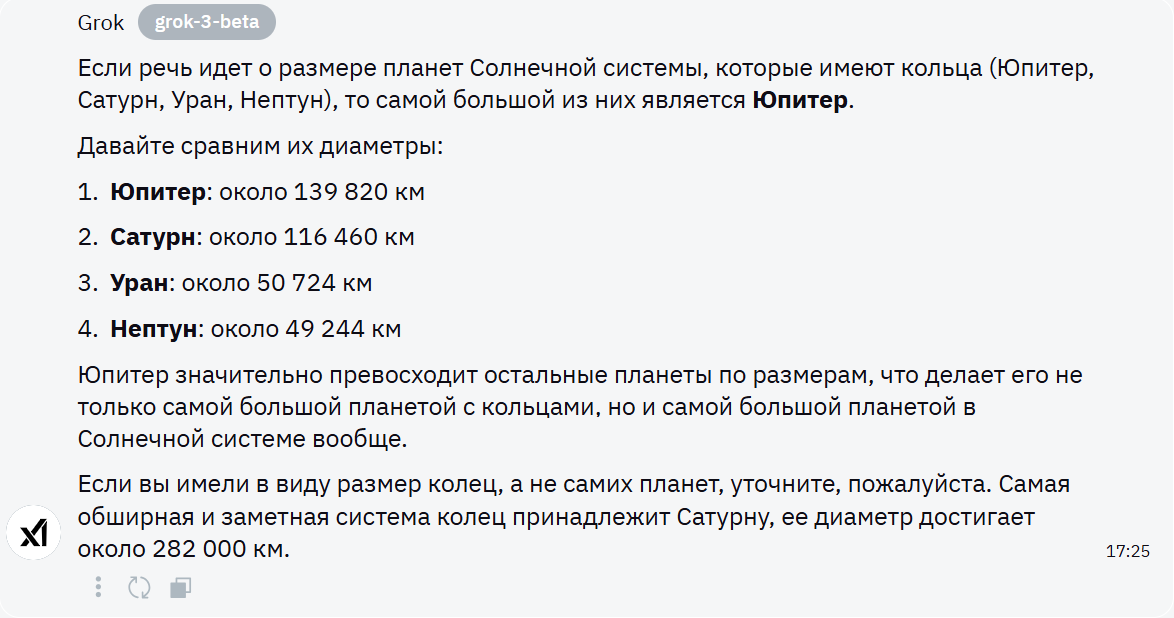

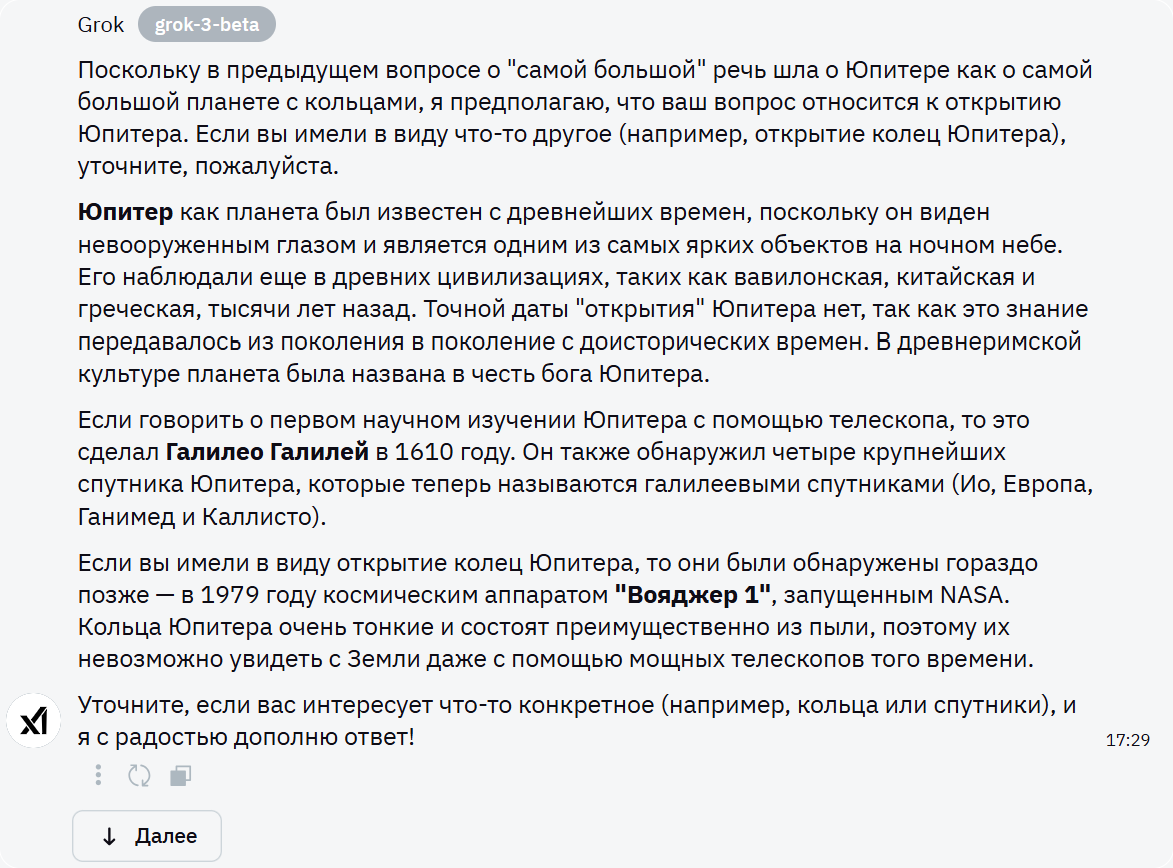

Grok 3

Скриншоты

Grok 3 на 2-й вопрос дал двойственный ответ (Сатурн и Нептун), но привёл общую сравнительную характеристику, из которой можно сделать верный вывод. В остальном нареканий нет, контекст модель поддерживает хорошо, на месте предлагает пользователю задать уточняющие вопросы.

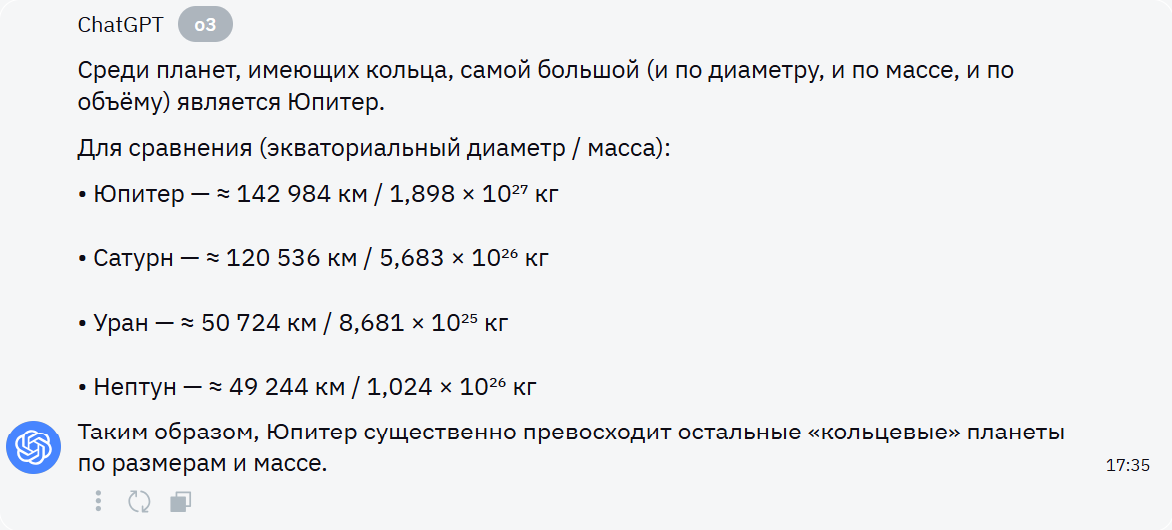

GPT o3

Скриншоты

GPT o3 дал чёткие ответы на все вопросы, контекст при этом поддерживает на «ура».

Claude Opus 4

Скриншоты

Claude Opus 4 также дал верные ответы, но расписал их подробнее, чем GPT o3. Контекст поддерживает отлично.

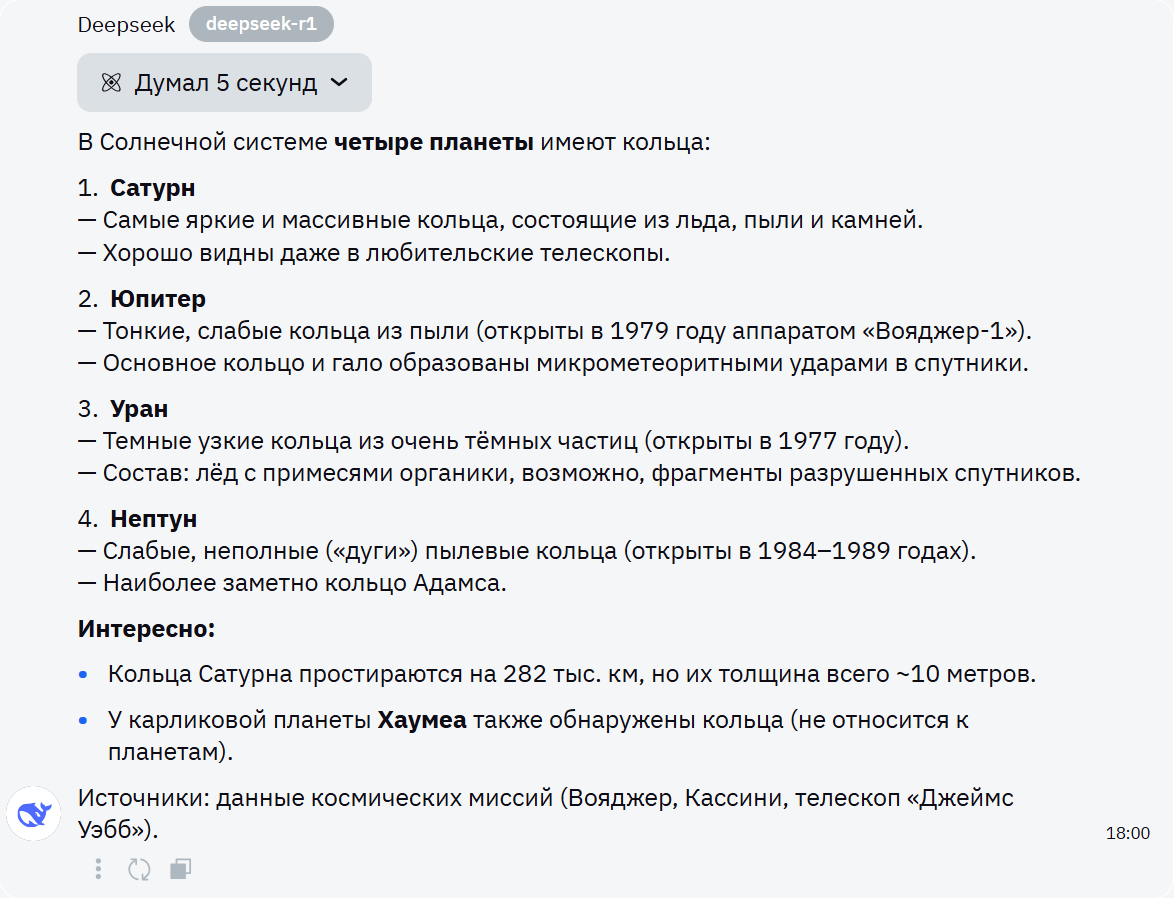

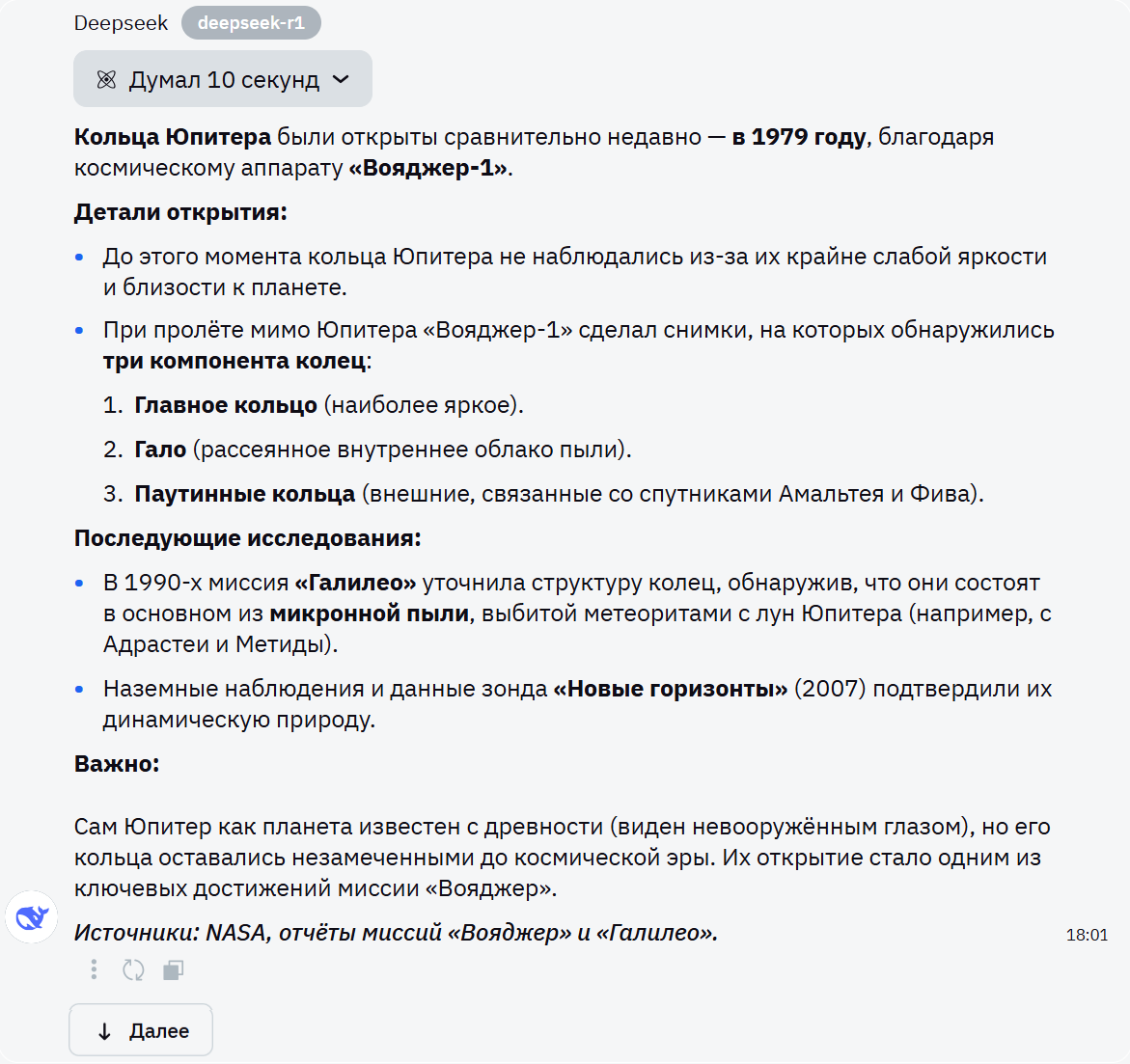

DeepSeek R1

Скриншоты

DeepSeek R1 чуть сбился на 4-м ответе, рассказав про кольца, а не про саму планету, однако его ответ всё же содержал нужную информацию (последний абзац, если не считать источники). Таким образом, заключаем, что контекст поддерживается, но в идеале нужно давать уточнения. Также можно положительно отметить приведённые ИИ дополнительные факты.

Perplexity AI

Скриншоты

Perplexity AI, как и DeepSeek R1, на 4-й вопрос дал ответ про кольца, а не про саму планету; в остальном контекст соблюдается. Также приведены ссылки на источники, где можно узнать подробности.

GigaChat 2.0

Скриншоты

GigaChat 2.0 дал ответ на уровне Llama 4 Maverick✶, допустив те же неточности в плане контекста. Также спорные данные по открытию колец Нептуна (до этого их обнаружил Галилео Галилей, но неправильно определил их природу).

Вопрос на эмоциональный интеллект

Промт:

Как поддержать друга, который потерял работу?

Llama 4 Maverick✶

Llama 4 Maverick✶ дал совет избегать клише и шаблонов (что важный плюс), предложил полезные варианты. Единственное, ИИ не учитывает контекст России (LinkedIn заблокирован), но это и не было отражено в промте.

Grok 3

Скриншот

Grok 3 также дал полезный и применимый в жизни ответ, обозначив все ключевые психоэмоциональные аспекты.

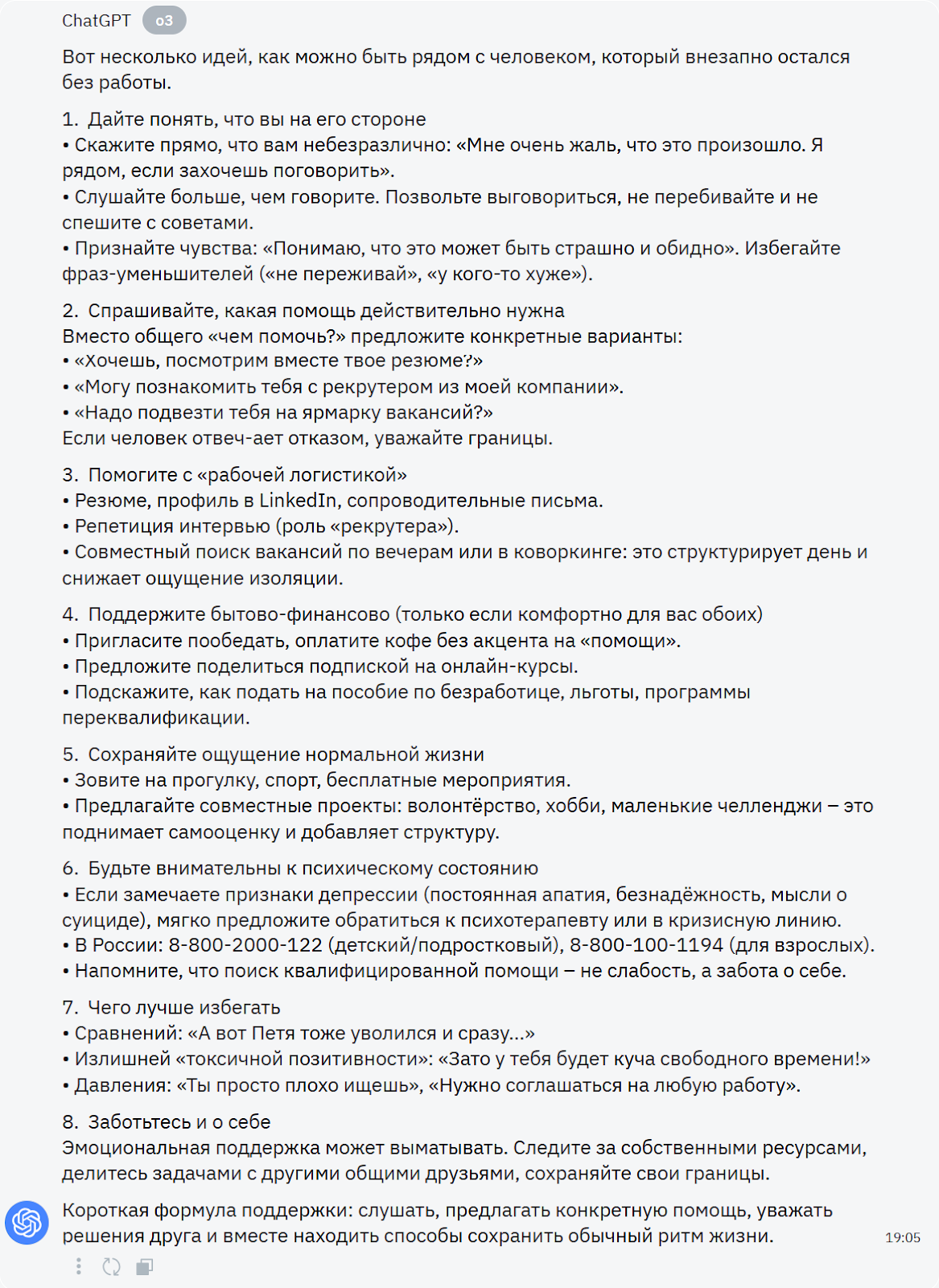

GPT o3

Скриншот

GPT o3, помимо неплохих рекомендаций и предосторожностей (что и как не нужно говорить другу), указал заботу о себе, что тоже ему в плюс.

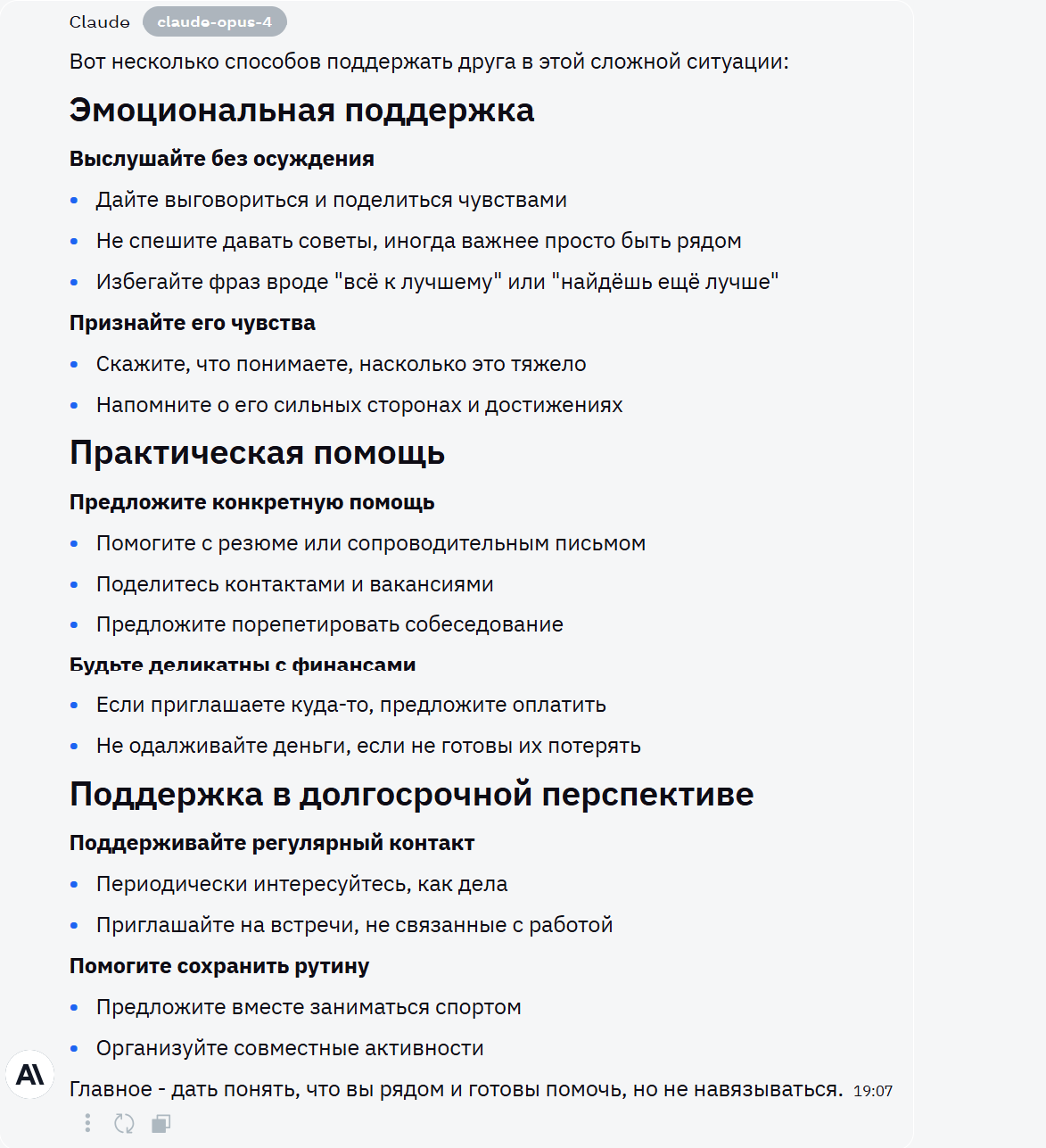

Claude Opus 4

Скриншот

Claude Opus 4 предложил больше стратегию поведения [11], нежели слова; предупредил, что не нужно говорить. В целом его ответ жизнеспособен и неплох.

DeepSeek R1

Скриншот

DeepSeek R1 дал всесторонний (действия, слова, предостережения) ответ, пригодный для использования.

Perplexity AI

Скриншот

Perplexity AI дал хороший ответ, в который в том числе входит предварительное выяснение планов друга, что можно отдельно отметить. Также он дал ссылки и вопросы для углубления в тему.

GigaChat 2.0

Скриншот

GigaChat 2.0 дал неплохие советы, но не дал предостережений, как это сделали остальные нейросети.

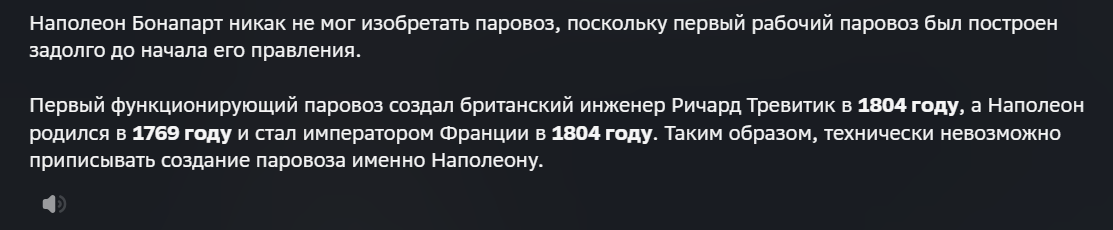

Вопрос на самокоррекцию

Также нейросетям был задан вопрос с заведомой ошибкой:

В каком году Наполеон изобрёл паровоз?

Все скрины приводить не буду, поскольку ответы были почти идентичными. Они верно распознали ошибку и содержали в себе имя реального изобретателя (Ричарда Тревитика).

Подведение итогов

Сравнительная таблица (5-балльная шкала):

|

Модель |

Скорость обработки запросов |

Точность ответов |

Поддержка языков |

Мультимодальность |

Контекстное понимание |

Этика и безопасность |

|

Llama 4 Maverick✶ |

4 |

3.5 |

4 |

4.5 |

3.5 |

4.5 |

|

Grok 3 |

5 |

4.5 |

4 |

4 |

4.5 |

4.5 |

|

ChatGPT o3 |

4.5 |

5 |

5 |

5 |

5 |

5 |

|

Claude Opus 4 |

4.5 |

5 |

5 |

5 |

5 |

5 |

|

DeepSeek R1 |

4 |

4 |

5 |

4 |

4.5 |

4.5 |

|

Perplexity AI |

4 |

4 |

4 |

3 |

3.5 |

5 |

|

GigaChat 2.0 |

4 |

4 |

4.5 |

4.5 |

3.5 |

4.5 |

Таким образом:

1-е место — Claude Opus 4 и ChatGPT o3

2-е место — Grok 3

3-е место — DeepSeek R1

Подводя итог, можно с уверенностью сказать, что современные нейросети уже преодолели границу между шаблонными ответами и осмысленной коммуникацией. Так, Claude Opus 4 и GPT o3 показали эталонное сочетание глубины рассуждений, мультимодальности и этической безопасности, а Grok 3 и DeepSeek R1 доказали, что скорость и адаптивность остаются ключевыми для повседневных задач. «Универсального гения» не существует, ведь оптимальный выбор — это всегда компромисс между функционалом и практичностью.

✶ Meta — деятельность организации запрещена на территории Российской Федерации.

✶ Llama — проект компании Meta Platforms Inc., деятельность которой запрещена на территории Российской Федерации.

Автор: Nataliia-L

Источник [12]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/16716

URLs in this post:

[1] интеллект: http://www.braintools.ru/article/7605

[2] мышлению: http://www.braintools.ru/thinking

[3] BotHub: https://bothub.chat/?utm_source=contentmarketing&utm_medium=habr&utm_campaign=article&utm_content=VIRTUAL%20ASSISTANTS:%20A%20REVIEW%20OF%20THE%20SMARTEST%20NEURAL%20NETWORKS%20FOR%20ANSWERING%20QUESTIONS

[4] перейти по рефералке: https://bothub.chat/?invitedBy=m_aGCkuyTgqllHCK0dUc7

[5] обучении: http://www.braintools.ru/article/5125

[6] поисковая система: https://www.perplexity.ai/

[7] сервис на основе ИИ: https://giga.chat/

[8] внимание: http://www.braintools.ru/article/7595

[9] ошибки: http://www.braintools.ru/article/4192

[10] восприятия: http://www.braintools.ru/article/7534

[11] поведения: http://www.braintools.ru/article/9372

[12] Источник: https://habr.com/ru/companies/bothub/articles/922658/?utm_campaign=922658&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.