LLM и их хрупкая логика: новое исследование ставит под сомнение Chain-of-Thought

Новое исследование [1] учёных из Университета штата Аризона показывает: знаменитое «цепочечное рассуждение» (Chain-of-Thought, CoT) в больших языковых моделях (LLM) скорее похоже на «хрупкий мираж», чем на проявление подлинного интеллекта [2]. Эта работа продолжает традицию критического анализа глубины рассуждений LLM, но в отличие от предыдущих исследований предлагает уникальный взгляд через призму «распределения данных», который позволяет понять, где и почему CoT систематически даёт сбой.

Дисклеймер: это вольная адаптция статьи [3] издания VentureBeat. Перевод подготовила редакция «Технократии». Чтобы не пропустить анонс новых материалов подпишитесь на «Голос Технократии» [4] — мы регулярно рассказываем о новостях про AI, а также делимся полезными мастридами и актуальными событиями.

Для разработчиков приложений особенно важно то, что статья не ограничивается критикой: она содержит ясные и практические рекомендации — от стратегий тестирования до роли дообучения. Авторы показывают, как учитывать выявленные ограничения при создании решений на основе LLM.

Преимущества и ограничения метода CoT

Метод CoT, когда модель просят «думать шаг за шагом», уже продемонстрировал впечатляющие результаты в ряде сложных задач и создал иллюзию, что модели воспроизводят человеческие процессы вывода. Однако при внимательном анализе часто обнаруживаются логические противоречия, которые подрывают это представление.

Множество исследований [5] показывает: LLM нередко опираются не на истинную логику [6], а на поверхностные семантические сигналы. Они производят правдоподобно звучащие рассуждения, комбинируя знакомые последовательности токенов из обучающих данных. Такой подход рушится, как только задача выходит за рамки привычных шаблонов или в неё вводятся лишние условия.

Тем не менее авторы исследования отмечают: «систематического понимания того, когда и почему разрушается CoT, до сих пор не существовало». Именно эту задачу они и попытались решить. Уже известно, что LLM с трудом обобщают свои способности к рассуждению. В статье подчёркивается: «теоретические и эмпирические данные показывают, что CoT работает успешно только тогда, когда тестовые данные содержат скрытые структуры, сходные с обучающими; во всех остальных случаях производительность резко падает».

Новый взгляд на рассуждения LLM

Учёные из ASU предлагают рассматривать CoT не как рассуждение, а как утончённую форму сопоставления шаблонов, жёстко привязанную к статистике обучающих данных. По их словам: «успех CoT объясняется не врождённой способностью модели к мышлению [7], а её умением условно переносить знания на тестовые примеры, структурно схожие с обучающими». Иными словами, LLM способны применять старые схемы к новым данным, если они внешне похожи, но не могут решать принципиально новые задачи.

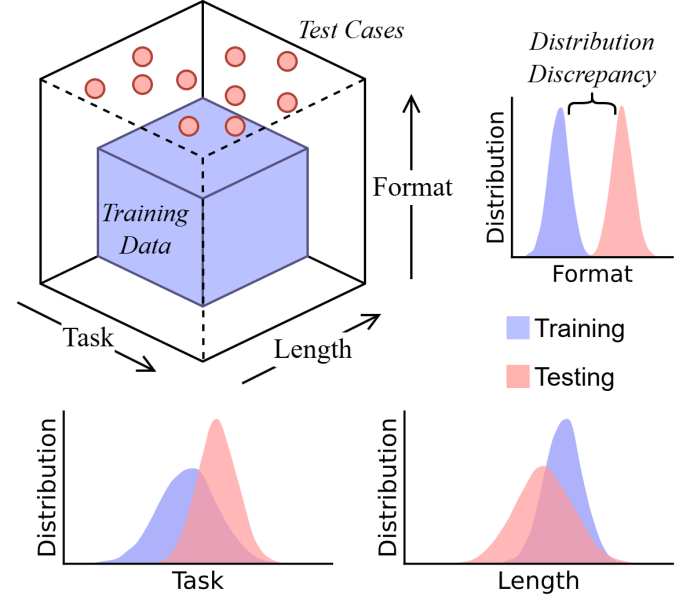

Чтобы проверить гипотезу, исследователи изучили поведение [8] CoT в трёх измерениях «сдвига распределения» — различий между обучающими и тестовыми данными. Во-первых, рассмотрели «обобщение задач»: может ли модель переносить освоенные приёмы рассуждения на новый тип задач. Во-вторых, исследовали «обобщение по длине» — сохраняется ли корректность рассуждений при цепочках, значительно длиннее или короче привычных. В-третьих, проверили «обобщение по формату» — насколько модель чувствительна к малейшим изменениям в формулировке или структуре подсказки.

Для экспериментов они разработали систему [9] DataAlchemy, которая позволяет обучать небольшие LLM с нуля в строго контролируемых условиях и точно измерять, как снижается результативность при выходе за пределы обучающего распределения.

«Линза распределения данных и контролируемая среда были для нас принципиально важны, — отметил Чэншуай Чжао, аспирант ASU и соавтор статьи, в интервью VentureBeat. — Мы стремимся создать пространство, где общественность, исследователи и разработчики смогут свободно изучать природу LLM и расширять горизонты человеческого знания».

Иллюзия интеллекта доказана

Вывод исследования однозначен: CoT — это «утончённое структурное сопоставление шаблонов, жёстко ограниченное обучающими данными». Малейший выход за пределы распределения приводит к полному провалу. То, что кажется логически последовательным рассуждением, на деле оказывается лишь миражом — результатом запоминания [10] или интерполяции уже известных схем, а не настоящим логическим выводом.

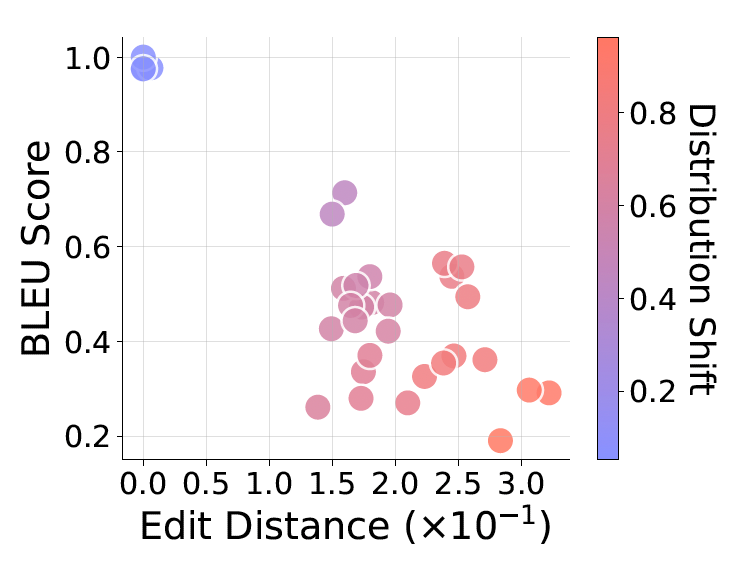

Провалы проявлялись во всех трёх измерениях. На новых задачах модели не обобщали, а воспроизводили ближайшие знакомые паттерны. При изменении длины цепочки они сбивались, часто искусственно добавляя или убирая шаги, чтобы «подогнать» ответ под примеры из обучения [11]. Даже минимальные изменения формулировки подсказки резко снижали точность, особенно если они затрагивали ключевые элементы инструкции.

Любопытно, что эти слабости можно было быстро компенсировать: дообучение на небольшой выборке новых данных при помощи контролируемого fine-tuning (SFT) резко улучшало результативность именно на этой задаче. Однако это лишь подтверждало гипотезу сопоставления шаблонов: модель не училась абстрактным рассуждениям, а просто заучивала новый шаблон для преодоления конкретного изъяна.

Выводы для бизнеса

Учёные напрямую предупреждают практиков: нельзя полагаться на CoT как на универсальное средство рассуждений и уж тем более приравнивать его результаты к человеческому мышлению. Они формулируют три ключевых совета разработчикам:

-

Остерегайтесь избыточной уверенности. В критически важных областях — таких как финансы или юриспруденция — CoT не должен считаться надёжным инструментом. LLM способны производить «гладкую бессмыслицу» — кажущуюся убедительной, но логически порочную, а потому особенно опасную. «Незаменим строгий аудит со стороны экспертов», подчёркивают авторы.

«Прогресс науки должен оставаться человекоцентричным — машины могут помогать, но открытия по-прежнему рождаются из человеческой любознательности и мышления», — отмечает Чжао. -

Ставьте в приоритет OOD-тестирование. Стандартной валидации, когда тест совпадает с обучением, недостаточно. Необходимо систематически проверять устойчивость модели к сбоям на уровне задач, длины и формата.

-

Смотрите на fine-tuning как на костыль, а не как на универсальное решение. Контролируемое дообучение позволяет быстро адаптировать модель к новой выборке, но не обеспечивает настоящего обобщения. Оно лишь слегка расширяет «пузырь обученного распределения». Попытка закрывать каждый OOD-сбой с помощью SFT обречена на провал, так как не решает проблему отсутствия абстрактного мышления.

Авторы отмечают: хотя CoT и не является формой человеческого рассуждения, это ограничение можно учитывать. Большинство корпоративных приложений работает в рамках узкого набора задач. В этом случае надёжная стратегия заключается в создании строгих наборов тестов, проверяющих модель именно на тех вариациях задач, длины и формата, которые встречаются в реальной работе. Это позволяет очертить границы «зоны комфорта» модели и сопоставить их с практическими потребностями [12].

Такое целенаправленное тестирование превращает fine-tuning из реактивного средства в проактивный инструмент настройки. Если выявляется слабое место, разработчики могут собрать небольшой специализированный набор данных и дообучить модель так, чтобы её сопоставление шаблонов было точно согласовано с бизнес-задачами. В итоге исследование предлагает практическую призму: как отказаться от неоправданных надежд и строить системы на основе LLM так, чтобы их поведение [13] было предсказуемым.

Автор: madballer34

Источник [14]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/18539

URLs in this post:

[1] исследование: https://arxiv.org/abs/2508.01191

[2] интеллекта: http://www.braintools.ru/article/7605

[3] статьи: https://venturebeat.com/ai/llms-generate-fluent-nonsense-when-reasoning-outside-their-training-zone/

[4] «Голос Технократии»: https://t.me/+vvm8PwCuv-EyZGY6

[5] исследований: https://venturebeat.com/ai/dont-believe-reasoning-models-chains-of-thought-says-anthropic/

[6] логику: http://www.braintools.ru/article/7640

[7] мышлению: http://www.braintools.ru/thinking

[8] поведение: http://www.braintools.ru/article/9372

[9] систему: https://github.com/ChengshuaiZhao0/DataAlchemy

[10] запоминания: http://www.braintools.ru/article/722

[11] обучения: http://www.braintools.ru/article/5125

[12] потребностями: http://www.braintools.ru/article/9534

[13] поведение: http://www.braintools.ru/article/5593

[14] Источник: https://habr.com/ru/companies/technokratos/articles/939072/?utm_source=habrahabr&utm_medium=rss&utm_campaign=939072

Нажмите здесь для печати.