Нажал — и мир двинулся: как Matrix-Game 2.0 делает видео интерактивным в реальном времени

Интерактивные модели мира — это способ учить ИИ «ощущать» мир, а не только описывать его словами. Но до недавнего времени у таких моделей было три больших препятствия: не хватало качественных данных с точной пометкой действий; классические видеодиффузоры считали слишком долго и «забывали» начало ролика; ошибки [1] накапливались от кадра к кадру. Matrix-Game 2.0 предлагает ясный, практичный ответ: авторегрессивная модель с малым числом шагов, потоковая генерация на лету в 25 FPS и строгий контроль действий мышью и клавиатурой.

Зачем вообще пытаться моделировать мир видео?

-

Чтобы агенты в играх и симуляторах могли планировать не схематично, а «видя» последствия нажатий.

-

Чтобы обучение [2] вождения или навигации шло быстрее и безопаснее.

-

Чтобы LLM и мультиагентные системы получали визуальный «симулятор», где можно проверять гипотезы по промтам без физического мира.

Вместо длинных промтов Matrix-Game 2.0 ориентируется на то, что действительно правит динамикой — на визуальные кадры и реальные действия.

Откуда взялись данные, на которых модель учится

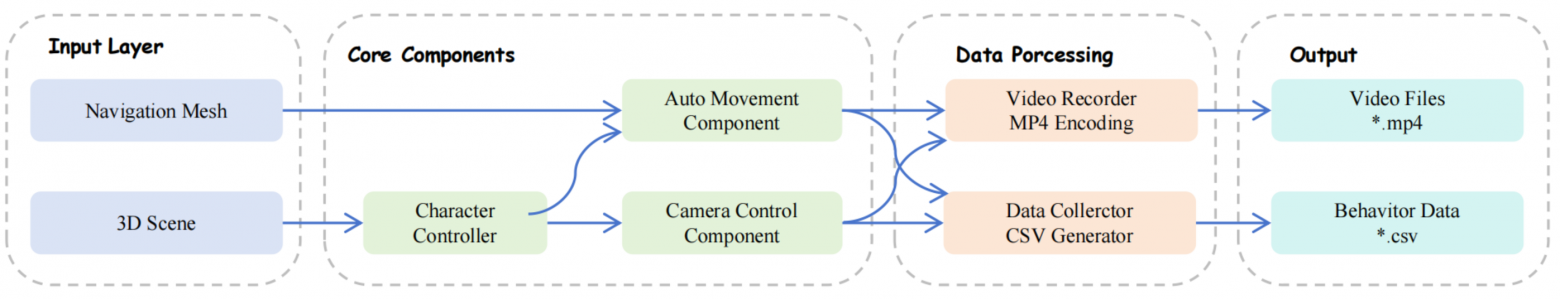

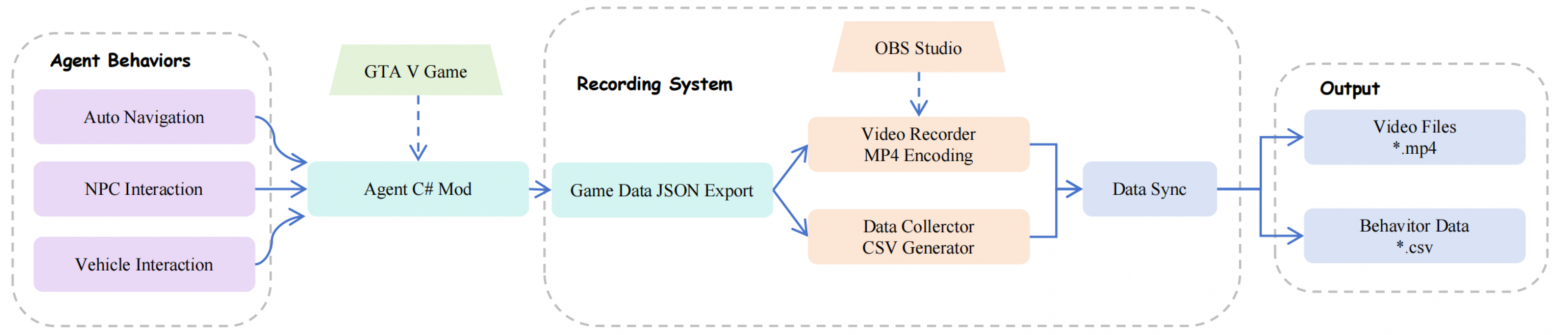

Команда построила два производственных конвейера — в Unreal Engine и GTA5. Оба выдают видео и синхронные логи нажатий, движения камеры и физики с точностью до кадра.

-

Unreal Engine: навигационная сетка задаёт траектории без залипания, агенты обучены PPO с наградами за разнообразие и отсутствие столкновений, а камера управляется с практически нулевой ошибкой вращения. Потоки рендеринга и записи идут параллельно, что повышает пропускную способность даже на одной видеокарте.

-

GTA5: собственный плагин одновременно пишет RGB, мышь/клавиатуру и параметры движения авто. Можно переключать виды камеры, погоду, плотность трафика; помогает удерживать поведение [3] в пределах проходимых зон.

В сумме получилось порядка 1200 часов разнообразных клипов с точной привязкой действий к кадрам.

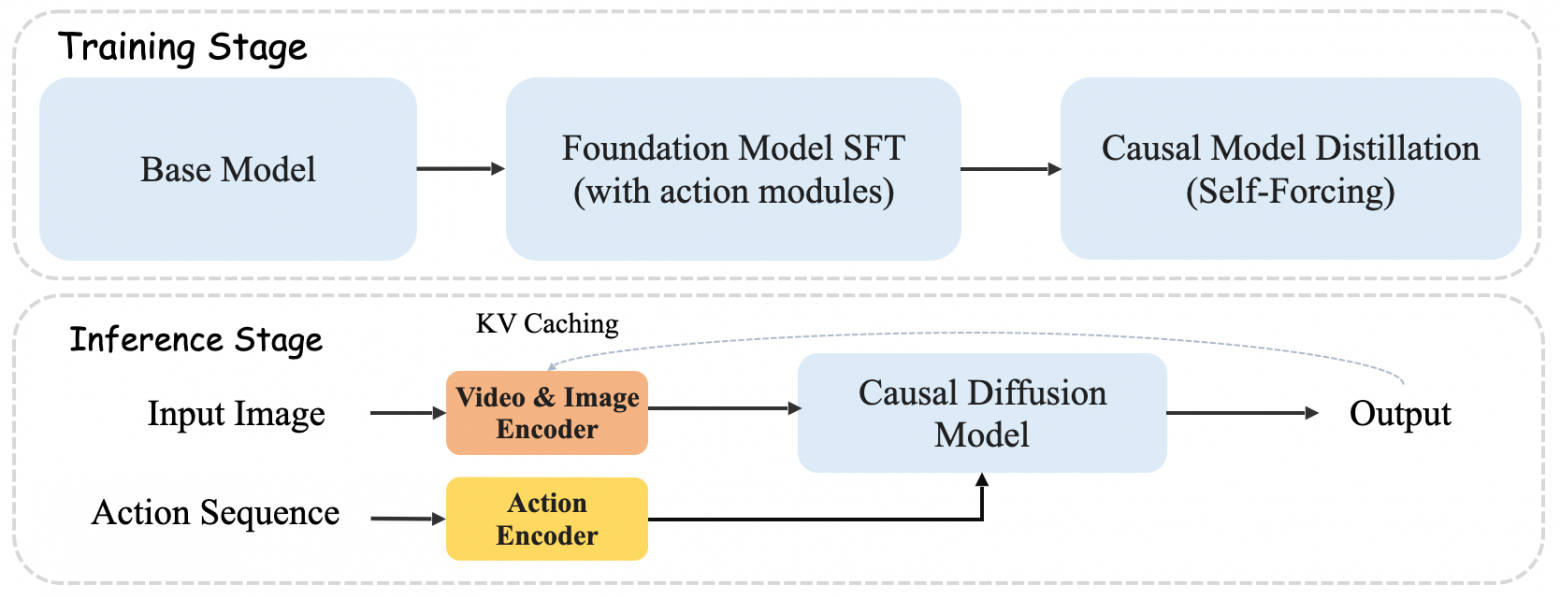

Что у модели внутри

Matrix-Game 2.0 — модель мира без текста: на вход идёт одно референсное изображение и действия; на выходе — видео, подчинённое законам физики сцены. 3D Causal VAE ужимает кадры по пространству и времени, экономя вычисления. Диффузионный трансформер (DiT) получает:

-

непрерывные действия мыши, встроенные через MLP и временное самовнимание;

-

дискретные клавиши, поданные через кросс-внимание с позиционными признаками RoPE, чтобы не «ломать» длинную зависимость.

Ключ к реальному времени — дистилляция из двунаправленного «учителя» в причинную малошаговую «студент-модель» методом Self-Forcing. Она учится предсказывать следующие токены, опираясь на собственный прошлый вывод, а не на идеальную правду. Так снижается накопление ошибок. KV‑кэш хранит последние токены и действия в скользящем окне: это даёт непрерывную потоковую генерацию без квадратичных издержек по длине.

Как это ощущается на практике

-

Скорость: 25 кадров в секунду на одной H100; несколько минут непрерывного видео без «потери памяти» о сцене.

-

Управление: точная реакция [4] на клавиатуру и мышь кадр-в-кадр, что важно для игр и симуляторов.

-

Качество: по бенчмарку GameWorld Score модель заметно превосходит Oasis в Minecraft (лучше изображение, действие и стабильность на длинных отрезках), а в сложных сценах держит стиль и динамику на уровне и выше YUME, но работает быстрее и устойчивее к «залипанию» кадра.

Чтобы выйти на 25 FPS без просадки качества, команда комбинировала три приёма: кэш декодера VAE, облегчение модулей действий и уменьшение шагов диффузии до трёх — метрики при этом остаются стабильными.

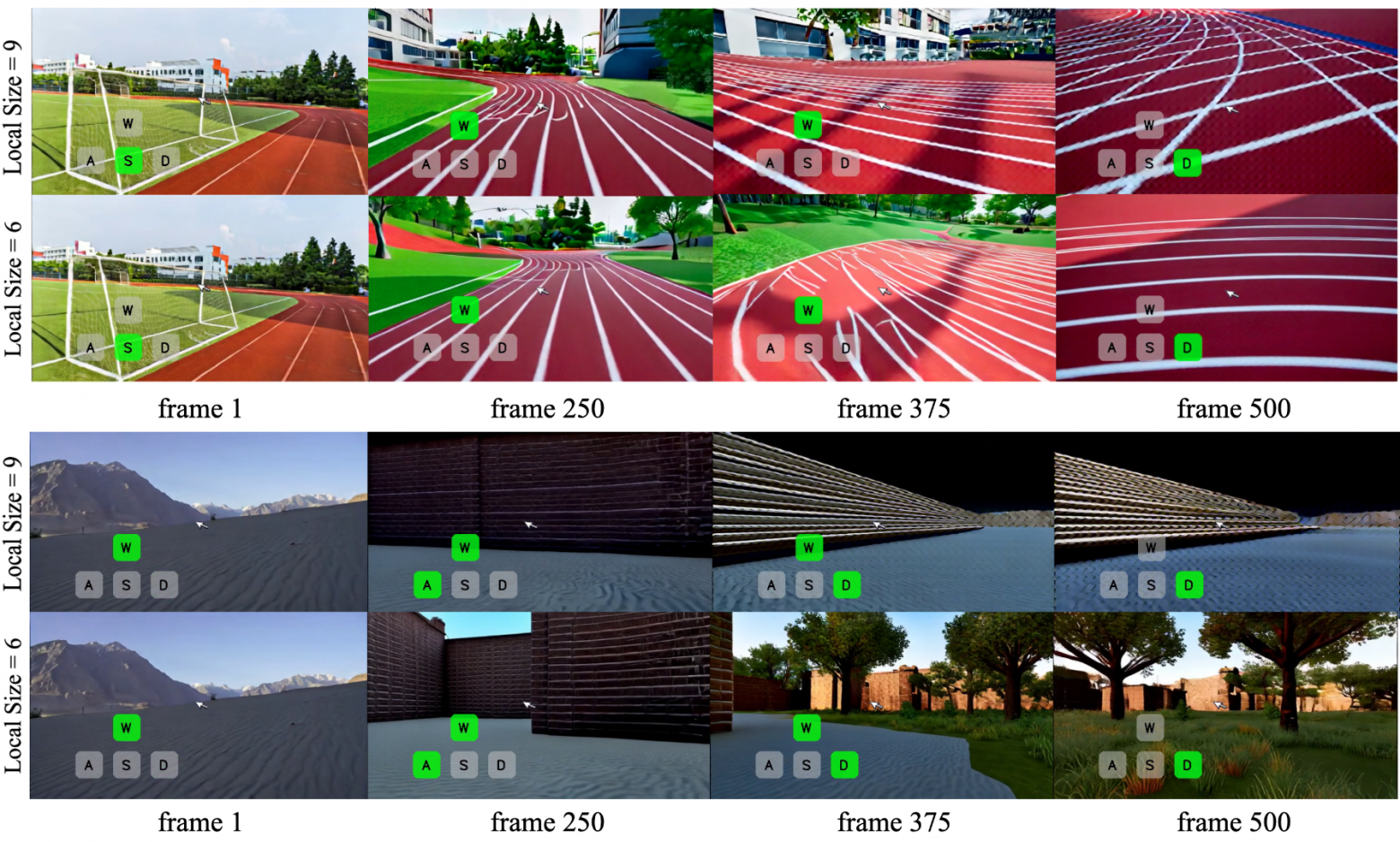

Один неожиданный урок

Слишком большой локальный размер KV‑кэша портит долгую последовательность: копятся артефакты, и модель переучивается на собственные огрехи. Умеренное окно сохраняет контекст и даёт шанс исправляться на ходу.

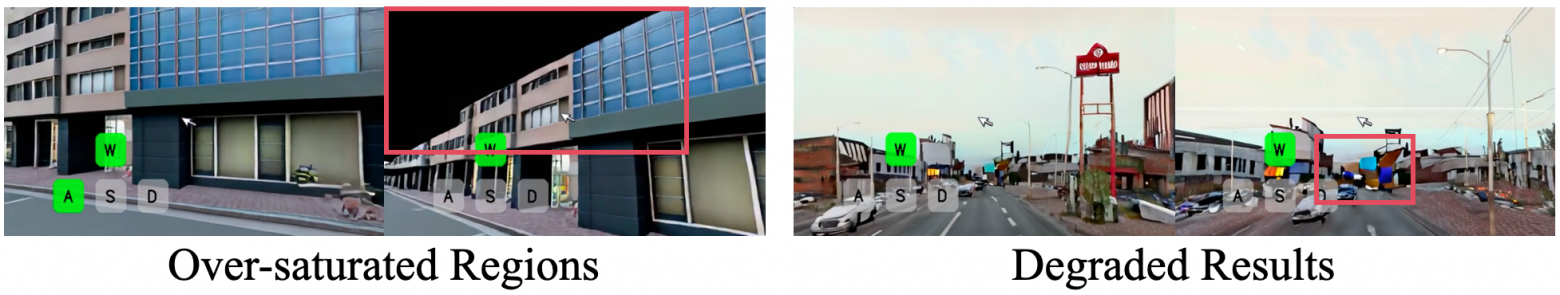

Где границы сегодня

-

Сцены вне домена всё ещё сложны: длительный подъём камеры или очень длинное движение вперёд приводит к деградации.

-

Разрешение 352×640 — не 4K: для некоторых задач хочется побольше разрешения.

-

Долгая память [5] об объектах и событиях на горизонте десятков минут требует лёгких модулей памяти или внешнего поиска без потери скорости.

Почему это важно

Открытые код и веса — это возможность быстро проверять идеи: подключать планировщики для мультиагентных систем, связывать миромодель с LLM по промту, учить новых агентов на богатых интерактивных траекториях. Matrix-Game 2.0 превращает видеодиффузию в рабочий инструмент для реальных систем.

Если коротко, работа показывает, что у мира, который генерирует ИИ, может быть тактильность: нажал — и мир двинулся. Быстро, устойчиво и достаточно точно, чтобы на этом строить следующие поколения интерактивного ИИ. Код и веса будут опубликованы, а значит, главный эксперимент — только начинается.

***

Если вам интересна тема ИИ, подписывайтесь на мой Telegram-канал [7] – там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

Автор: andre_dataist

Источник [8]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/18693

URLs in this post:

[1] ошибки: http://www.braintools.ru/article/4192

[2] обучение: http://www.braintools.ru/article/5125

[3] поведение: http://www.braintools.ru/article/9372

[4] реакция: http://www.braintools.ru/article/1549

[5] память: http://www.braintools.ru/article/4140

[6] 📜 Оригинальная статья: https://arxiv.org/abs/2508.13009

[7] подписывайтесь на мой Telegram-канал: https://t.me/+mP35nQPhgXZmZDYy

[8] Источник: https://habr.com/ru/articles/940322/?utm_campaign=940322&utm_source=habrahabr&utm_medium=rss

Нажмите здесь для печати.