Почему LLM врут с умным видом

Почему LLM продолжают уверенно ошибаться, даже когда лучше честно сказать «не знаю»? Исследователи из OpenAI предлагают ясный ответ: корень проблем статистический, он возникает уже на этапе предобучения, а затем закрепляется способами, которыми мы оцениваем модели после дообучения. Коротко: данные могут быть без ошибок, но цели обучения [1] все равно подталкивают к угадыванию — и это нормально для оптимизации кросс-энтропии. А дальше вступают в игру бенчмарки, где за «не знаю» не дают баллов, — и угадывание становится стратегией победителя.

Начнем с основного

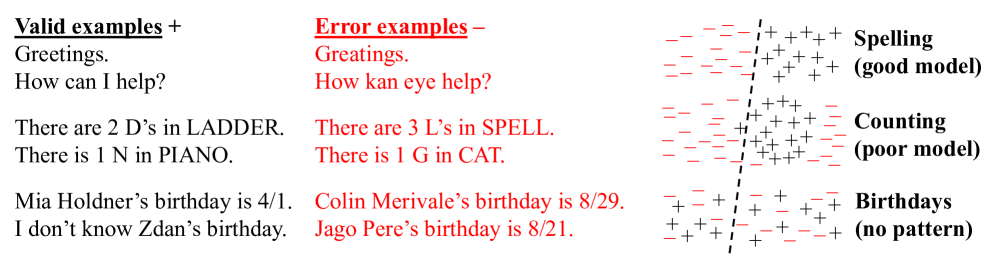

Представьте, что генерацию текста сводят к простой задаче: «валидно / невалидно». Если модель не умеет надежно отличать валидные ответы от ложных, она неизбежно будет их генерировать. Авторы строго показывают связь: генеративная ошибка [2] не меньше, чем примерно вдвое ошибка такого бинарного классификатора. То есть отвечать текстом сложнее, чем сказать «да» или «нет» — но если уже на уровне «да/нет» модель путается, при генерации ошибок будет еще больше.

Что особенно важно: даже если в корпусе нет ни одной явной ошибки, многие факты носят произвольный характер — у них нет закономерности, которую можно вывести из контекста. Например, дни рождения. Если в обучении часть таких фактов встречается всего один раз, то базовая оценка говорит: доля галлюцинаций по этим вопросам будет не ниже доли одиночек. Этот вывод опирается на идею недостающей массы из классической статистики: то, чего вы не видели или видели один раз, будет ошибаться чаще. Авторы адаптируют оценку недостающей массы к нашему случаю и получают практичную нижнюю границу ошибок по произвольным фактам. Отсюда логичный совет: не путать память [3] с пониманием, а в оценке давать легальный путь к ответу «не знаю».

Про промты

В реальности модель отвечает на контекстные вопросы, и валидных ответов может быть несколько, а ошибок — множество. Формальный анализ сохраняется: при разумной калибровке вероятность генеративных ошибок снизу определяется качеством классификатора и соотношением между числами валидных и невалидных ответов для каждого промта. Плохая модель (недостаток представимости, скудный контекст, токенизация, ограниченные ресурсы) поднимает этот порог. Показателен пример с подсчетом букв: одни LLM неверно считают буквы в слове из-за токенизации, другие решают задачу рассуждением по шагам — и резко снижают ошибки.

Постобучение

Почему RLHF и другие техники не убирают галлюцинации? Потому что большинство мейнстримных бенчмарков используют бинарные метрики без оценки за уместный отказ: за верный ответ дают 1, за неверный — 0, за «не знаю» тоже 0. Оптимальная стратегия при этом — угадывать всегда, когда есть хоть какой-то шанс попасть в правильный вариант. В итоге побеждает не самая надежная, а самая агрессивная в догадках модель. Пока лидеры бенчмарков завязаны на такие метрики, стимулы к безопасному поведению [4] слабые.

Авторы предлагают простое изменение правил: встраивать в инструкции явный порог уверенности t. Если уверен выше t — отвечай, если нет — говори «не знаю». При этом ошибку штрафовать сильнее, чем отказ: штраф t/(1−t). Тогда оптимальная стратегия становится правильной: отвечать только там, где вероятность быть правым действительно высока. Это можно внедрить в существующие бенчмарки без создания новых специальных тестов, а сравнение моделей проводить на нескольких значениях t. Плюс — появляется способ аудита поведенческой калибровки: проверяем, как меняется доля ответов и точность при росте порога.

Практические наблюдения из статьи хорошо укладываются в эту картину. Разные LLM дают уверенные, но разные неверные факты о диссертациях и датах рождения. На простых счетных вопросах модели расходятся на целые числа. Эти ошибки не выглядят аномалией — согласно анализу, они закономерны при текущих целях обучения и оценивания.

Что не решится автоматически

Поиск и RAG действительно помогают, но не всегда: когда источники не дают уверенности или задача сильно сложна (шифры, тонкие подсчеты, неоднозначные термины), стимул [6] к угадыванию остается, если метрика бинарная. Открытые задания вроде биографий только усиливают риск: одна заметная неточность — уже ошибка. Здесь уместно измерять степень галлюцинации по числу фактических промахов и поощрять корректный отказ от деталей.

Итог простой: галлюцинации естественны для моделирования на текстах и подкрепляются тем, как мы считаем баллы в бенчмарках. Чтобы увидеть реальный прогресс, нужно немного повернуть ручку метрик — подкреплять уместную неопределенность. Тогда LLM начнут быть не только сильными в различных тестах, но и надежными помощниками, которые честно выбирают промолчать при ответе на вопрос, если уверенности мало.

📜 Полная статья [7]

***

Если вам интересна тема ИИ, [8]подписывайтесь на мой Telegram-канал [9]– там я регулярно делюсь инсайтами по внедрению ИИ в бизнес, запуску ИИ-стартапов и объясняю, как работают все эти ИИ-чудеса.

Автор: andre_dataist

Источник [10]

Сайт-источник BrainTools: https://www.braintools.ru

Путь до страницы источника: https://www.braintools.ru/article/19258

URLs in this post:

[1] обучения: http://www.braintools.ru/article/5125

[2] ошибка: http://www.braintools.ru/article/4192

[3] память: http://www.braintools.ru/article/4140

[4] поведению: http://www.braintools.ru/article/9372

[5] подкреплением: http://www.braintools.ru/article/5528

[6] стимул: http://www.braintools.ru/article/5596

[7] 📜 Полная статья: https://arxiv.org/abs/2509.04664

[8] : https://t.me/+mP35nQPhgXZmZDYy

[9] подписывайтесь на мой Telegram-канал : https://t.me/+9nDCqOqSLiM3NTVi

[10] Источник: https://habr.com/ru/articles/944978/?utm_source=habrahabr&utm_medium=rss&utm_campaign=944978

Нажмите здесь для печати.